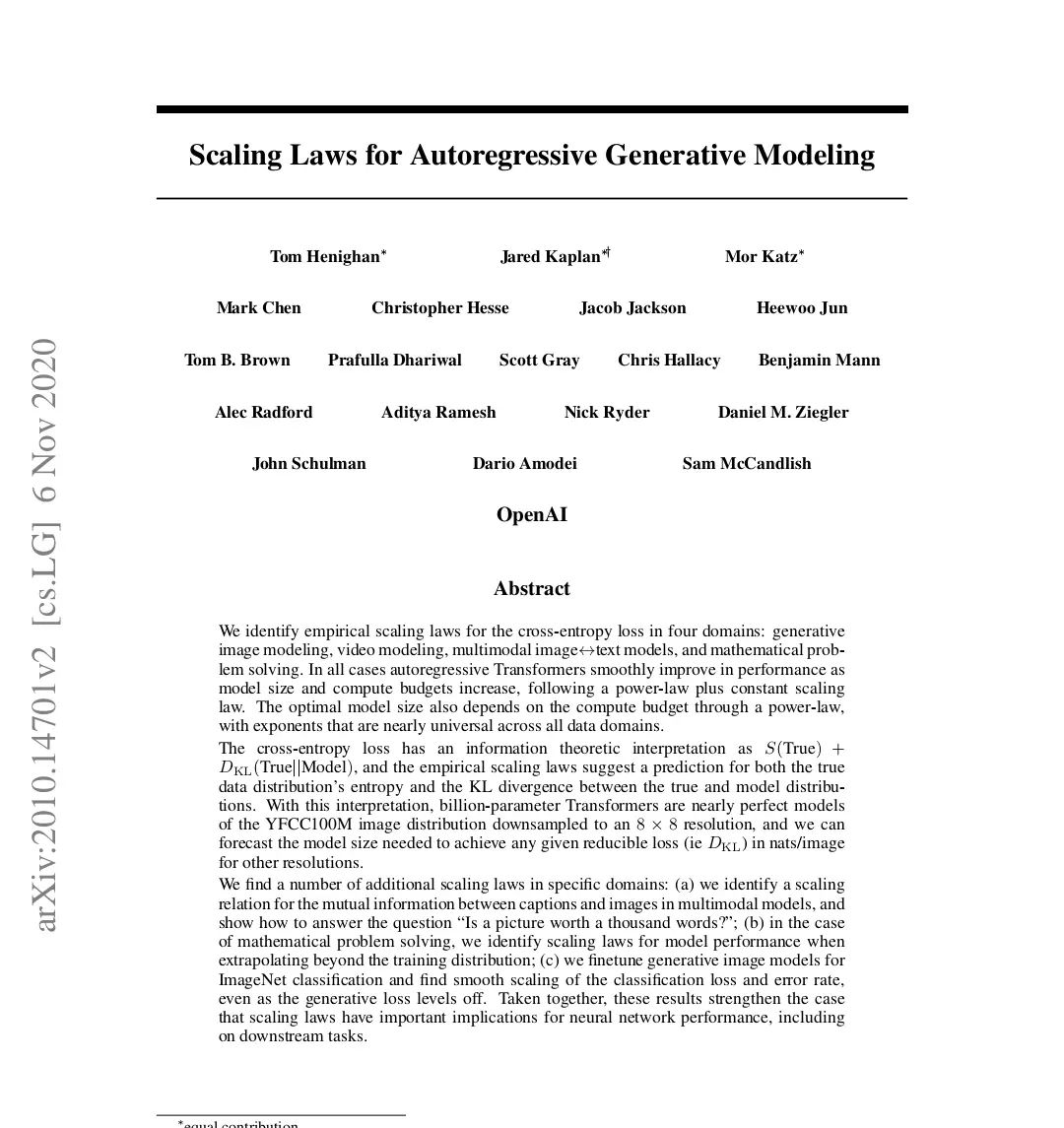

这篇论文《Scaling Laws for Autoregressive Generative Modeling》探讨了自回归生成模型的缩放规律,主要集中在以下几个方面: 1. 缩放规律的识别:研究表明,自回归Transformer模型在生成图像、视频、多模态图像与文本模型以及数学问题解决等多个领域中,随着模型规模和计算预算的增加,性能平滑提升,遵循幂律加常数的缩放规律

2. 信息论解释:交叉熵损失可以被解释为真实数据分布的熵加上真实分布与模型分布之间的KL散度。通过这种解释,研究者预测了在不同分辨率下达到特定可减少损失所需的模型规模。 3. 领域特定的缩放规律: • 在多模态模型中,识别图像与文本之间的互信息,并探讨“图片是否值千言”的问题。 • 在数学问题解决中,识别模型在超出训练分布时的性能缩放规律。 • 在图像分类任务中,发现生成图像模型在ImageNet分类中的性能平滑缩放。 4. 最佳模型规模与计算预算的关系:研究发现,最佳模型规模与计算预算之间的关系可以近似为纯幂律,且在所有领域中,幂律的指数β约为0.7。 5. 模型性能与数据规模的关系:随着模型规模的增加,生成模型在下游任务(如分类)中的性能也平滑提升,表明生成模型的缩放规律对实际能力有重大影响。 6. 未来研究方向:论文提出了对缩放规律的理论解释的需求,并提议未来的研究可以探索如何在更广泛的模型、数据和计算规模层次上理解这些规律。 总之,这篇论文强调了自回归生成模型在多个领域中的普遍性和可预测性,提出了重大的理论和实践意义。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...