2024年AI驱动虚拟协作趋势:架构师必须掌握的5大技术方向

关键词:AI虚拟协作、多模态交互、智能代理、实时协同架构、数据隐私增强、自适应工作流

摘要:2024年,远程工作与跨地域协作已成为企业常态,而AI技术的融入正在重构虚拟协作的底层逻辑。本文以”架构师”为核心视角,拆解了AI驱动虚拟协作的5大关键技术方向——多模态交互入口、智能代理大脑、实时协同血管、数据隐私盾牌、自适应工作流手脚,用”小学生能听懂的故事”类比技术原理,结合代码示例、数学模型与实战项目,帮你理清这些技术的逻辑关系与落地路径。无论你是想设计下一代协作工具,还是优化现有系统,这篇文章都能给你清晰的思考框架。

背景介绍

目的和范围

为什么要聊”AI驱动虚拟协作”?因为传统虚拟协作工具已经”不够用”了:

你有没有过这样的经历?远程会议里,有人发了文本、有人发了语音、有人发了截图,你得来回切换窗口才能看懂上下文;

项目群里几百条消息,想找上周的决策得翻半小时聊天记录;

同步文档时,明明你改了第3页,同事却还在编辑第2页,最后合并出一堆冲突;

担心敏感数据泄露,不敢在协作工具里传核心文件;

固定的工作流跟不上项目变化,比如突然要加一个审批环节,得重新改整个流程。

2024年,这些问题的解决方案不是”优化现有工具”,而是用AI重构协作的”输入-处理-输出”全链路。本文的目的,就是帮架构师搞清楚:AI如何让虚拟协作更”聪明”、更”高效”、更”安全”? 我们会覆盖从”用户怎么和系统交互”到”系统怎么自动调整工作流”的全流程技术,范围聚焦在”架构师必须掌握的核心方向”。

预期读者

企业级协作工具架构师(比如钉钉、飞书、Zoom的研发负责人);

负责远程团队协作系统的技术经理;

想转型AI协作领域的程序员;

对”AI如何改变工作方式”感兴趣的技术爱好者。

文档结构概述

本文像”搭积木”一样拆解AI虚拟协作系统:

地基:用故事引入,讲清楚传统协作的痛点;

砖块:解释5大核心技术概念(多模态、智能代理、实时协同、数据隐私、自适应工作流);

水泥:讲这些技术如何”粘在一起”工作;

房子:用代码示例和实战项目展示如何搭建系统;

装修:聊未来趋势与挑战。

术语表

核心术语定义

虚拟协作:通过网络工具实现的远程团队工作模式(比如远程会议、同步文档、项目管理);

AI驱动:用机器学习、自然语言处理等技术让协作系统自动完成部分任务(比如整理会议记录、协调进度);

多模态交互:同时用文本、语音、图像、手势等多种方式和系统沟通(比如发消息+发截图+语音说明);

智能代理(Agent):系统里的”虚拟助理”,能理解用户需求并自动执行任务(比如帮你整理会议纪要);

实时协同:多个用户同时操作同一个文档/项目时,变化能瞬间同步(比如一起编辑PPT,你改的内容立刻显示在我屏幕上);

数据隐私增强:用技术手段保护协作中的敏感数据(比如加密、差分隐私);

自适应工作流:系统能根据项目进展自动调整任务顺序(比如如果某个任务延迟,自动把后续任务的截止日期往后推)。

相关概念解释

模态:信息的表现形式(比如文本是”文字模态”,语音是”声音模态”,图像是”视觉模态”);

差分隐私:一种数据保护技术,让系统既能分析用户数据,又不会泄露具体某个人的信息(比如统计”团队平均年龄”,但不会告诉你张三的年龄);

BPMN:业务流程建模 notation(一种画工作流的标准语言,比如用矩形表示任务,箭头表示流程方向)。

缩略词列表

AI(Artificial Intelligence,人工智能);

NLP(Natural Language Processing,自然语言处理);

CV(Computer Vision,计算机视觉);

WebRTC(Web Real-Time Communication,网页实时通信);

BPMN(Business Process Model and Notation,业务流程建模符号)。

核心概念与联系:AI虚拟协作的”积木模型”

故事引入:小明的”协作工具痛点日记”

小明是一家互联网公司的架构师,负责设计团队的远程协作系统。最近他写了一篇”痛点日记”:

周一:产品经理在群里发了10条语音+5张截图+3段文本,说”这个需求要改”,我得花20分钟把这些信息整合起来,才明白他要改什么;

周二:研发会议开了2小时,我得手动记笔记,漏了好几个关键决策,结果开发同学做出来的东西不符合要求;

周三:我和前端同学同时编辑同一个文档,他改了第3页的按钮颜色,我改了第3页的文字,最后合并的时候全乱了;

周四:运营同学想传一份用户隐私数据到协作平台,我担心泄露,不敢让他传,结果耽误了项目进度;

周五:项目突然加了一个合规审批环节,我得重新改整个工作流,花了一下午才弄好。

小明的问题,其实是传统虚拟协作系统的”四大缺陷”:

输入方式单一(只能处理文本,不会融合语音、图像);

处理能力弱(不会自动整理信息);

同步效率低(实时性差);

流程不灵活(不能自动调整);

隐私保护不足(不敢传敏感数据)。

2024年,AI技术能帮小明解决这些问题吗?答案是”能”——只要他掌握5大核心技术,就能把传统协作系统变成”聪明的协作伙伴”。

核心概念解释:像给小学生讲”协作工具的魔法”

我们用”小明的魔法协作工具”来解释这5大技术:

核心概念一:多模态交互——让工具”听懂”你的所有表达

比喻:多模态交互就像”和朋友聊天”。你和朋友聊天时,不会只说文字,还会发表情包、语音、截图,朋友能同时理解这些信息。传统协作工具就像”只会听文字的朋友”,你发语音它听不懂,发截图它不会看;而多模态交互工具就像”聪明的朋友”,能同时理解你的文字、语音、图像,甚至手势(比如视频会议里的点头、摇头)。

例子:小明用魔法工具发了一条消息:“这个按钮的颜色要改成#FF0000(文本)+ [截图](图像)+ [语音:“就像这个例子里的红色”](语音)”。工具立刻明白:“他要把按钮改成红色,参考截图里的位置”。

技术原理:多模态交互的核心是”融合多种信息”。比如用自然语言处理(NLP)处理文本和语音,用计算机视觉(CV)处理图像和手势,然后用注意力机制把这些信息整合起来(就像你听朋友说话时,会重点关注他的语气和表情)。

核心概念二:智能代理——工具里的”贴心助理”

比喻:智能代理就像小明的”助理小张”。小张会帮小明做这些事:

会议结束后,自动整理会议纪要(把语音转换成文字,提取关键决策);

提醒小明:“明天下午2点有个项目评审会,需要准备PPT”;

当小明问:“这个需求的截止日期是什么时候?”,小张会立刻从项目群里找到答案。

传统协作工具里没有”小张”,所有这些事都得小明自己做;而智能代理就是工具里的”小张”,能自动完成这些重复性任务。

例子:小明开了一个小时的会议,智能代理自动把语音转换成文字,提取了3个关键决策:“1. 需求截止日期改为下周三;2. 需要加一个用户调研环节;3. 前端同学负责优化登录页面”,然后把这些决策同步到项目管理工具里。

技术原理:智能代理的核心是”理解需求+执行任务”。它用大语言模型(LLM)理解用户的问题(比如”整理会议纪要”),用工具调用(Tool Calling)能力执行具体任务(比如调用语音转文字API、项目管理API),最后用结果生成把任务结果返回给用户(比如生成会议纪要)。

核心概念三:实时协同架构——让大家”同时做一件事”

比喻:实时协同架构就像小明家的”Wi-Fi”。小明和家人一起看同一部电影,用Wi-Fi就能同步播放进度——你快进,我这边也快进;你暂停,我这边也暂停。传统协作工具的同步就像”用U盘传文件”:你改了文档,得保存了再发给我,我才能看到;而实时协同架构就像”Wi-Fi”,你改的内容立刻同步到我屏幕上,我们能同时编辑同一个文档。

例子:小明和前端同学同时编辑同一个PPT,小明改了第3页的标题,前端同学立刻看到了;前端同学改了第3页的按钮位置,小明也立刻看到了。他们不用再来回传文件,也不会有合并冲突。

技术原理:实时协同架构的核心是”低延迟同步”。它用** Operational Transformation(OT)或Conflict-free Replicated Data Types(CRDT)技术处理并发修改(比如两个人同时改同一个单元格),用WebRTC或Socket.io**实现实时数据传输(比如视频、音频、文档变化)。

核心概念四:数据隐私增强——给敏感数据”加把锁”

比喻:数据隐私增强就像小明的”日记锁”。小明有一本日记,里面写了很多秘密,他给日记加了一把锁,只有他能打开。传统协作工具里的敏感数据就像”没锁的日记”,谁都能看;而数据隐私增强工具就像”带锁的日记”,只有授权的人才能看,而且系统不会泄露具体某个人的信息(比如统计团队平均年龄,但不会告诉你张三的年龄)。

例子:运营同学想传一份用户隐私数据到协作平台,小明用数据隐私增强工具处理了这份数据——系统会自动把用户的具体姓名、手机号换成”匿名用户1″“匿名用户2”,然后再上传。这样,团队能分析数据(比如”匿名用户1的购买行为”),但不会泄露用户的真实信息。

技术原理:数据隐私增强的核心是”保护数据的同时不影响使用”。它用**加密技术(比如端到端加密)保护数据传输和存储,用差分隐私(Differential Privacy)保护数据分析(比如给数据加一点”噪音”,让系统无法识别具体某个人),用访问控制(Access Control)**限制谁能访问数据(比如只有项目经理能看敏感文档)。

核心概念五:自适应工作流——让流程”自己调整”

比喻:自适应工作流就像小明的”日程表”。小明的日程表会根据他的工作进度自动调整:如果他早上的会议延迟了,下午的任务会自动往后推;如果他提前完成了某个任务,日程表会提醒他开始下一个任务。传统协作工具的工作流就像”固定的时间表”:不管你有没有完成前面的任务,后面的任务都得按原定时间做;而自适应工作流就像”智能日程表”,能根据实际情况自动调整。

例子:小明的项目有一个工作流:“需求分析→设计→开发→测试→上线”。如果开发环节延迟了2天,自适应工作流会自动把测试环节的截止日期往后推2天,同时提醒测试同学:“开发环节延迟了,你的任务截止日期改为下周五”。

技术原理:自适应工作流的核心是”动态调整”。它用**业务流程管理(BPM)技术建模工作流(比如用BPMN画流程),用AI预测(比如机器学习模型预测任务延迟)分析流程状态,用规则引擎(Rule Engine)**自动调整流程(比如如果任务延迟,就修改后续任务的截止日期)。

核心概念之间的关系:像”人体器官”一样配合

这5大技术不是孤立的,它们像”人体器官”一样配合,构成了AI驱动虚拟协作系统的”完整身体”:

多模态交互:是”眼睛和耳朵”,负责接收用户的所有输入(文本、语音、图像);

智能代理:是”大脑”,负责理解输入、做决策、执行任务(比如整理会议纪要、提醒 deadlines);

实时协同架构:是”血管”,负责把信息快速同步给所有用户(比如你改的文档立刻同步给同事);

数据隐私增强:是”盾牌”,负责保护用户的敏感数据(比如给隐私数据加锁);

自适应工作流:是”手脚”,负责根据大脑的决策调整工作流程(比如自动修改任务截止日期)。

例子:小明用多模态交互发了一条消息:“这个需求要改,参考截图(图像)+ 语音说明(语音)”。多模态交互模块把这些信息传给智能代理,智能代理理解后,调用实时协同架构把修改后的需求同步给所有团队成员,同时用数据隐私增强模块保护截图里的敏感信息,最后自适应工作流模块根据需求修改自动调整项目流程(比如把开发环节的截止日期往后推)。

核心概念原理和架构的文本示意图

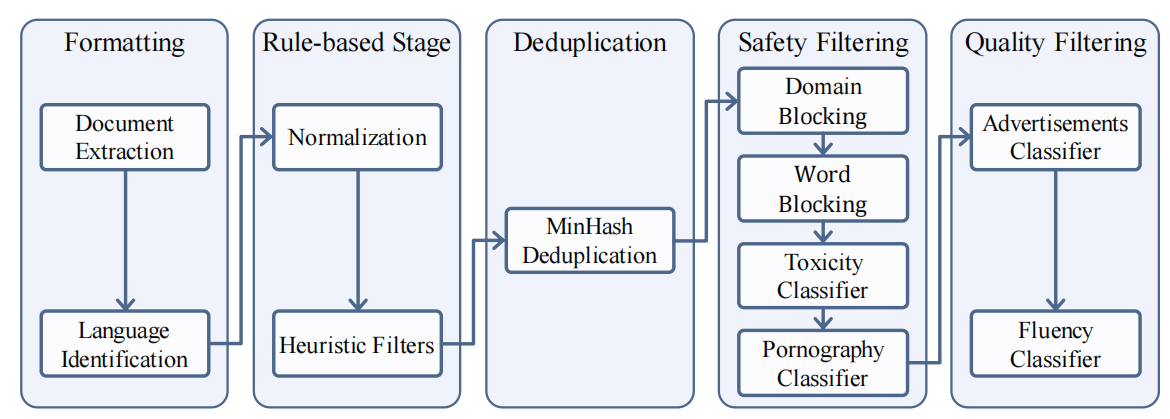

AI驱动虚拟协作系统的架构可以分成5层,从下到上依次是:

基础层:包括网络(5G/边缘计算)、存储(云存储)、计算(GPU/TPU),负责支撑整个系统的运行;

数据隐私层:包括加密、差分隐私、访问控制,负责保护数据安全;

实时协同层:包括OT/CRDT、WebRTC/Socket.io,负责实时同步数据;

智能代理层:包括LLM、工具调用、结果生成,负责处理用户需求;

多模态交互层:包括NLP、CV、手势识别,负责接收用户输入;

自适应工作流层:包括BPM、AI预测、规则引擎,负责调整工作流程。

Mermaid 流程图:AI虚拟协作的”工作流”

graph TD

A[用户输入:文本+语音+图像] --> B[多模态交互层:融合信息]

B --> C[智能代理层:理解需求+执行任务]

C --> D[实时协同层:同步给所有用户]

C --> E[数据隐私层:保护敏感数据]

C --> F[自适应工作流层:调整流程]

D --> G[用户看到同步结果]

E --> G

F --> G

核心技术方向1:多模态交互——让工具”听懂”你的所有表达

算法原理:多模态融合的”注意力魔法”

多模态交互的核心是”把不同模态的信息融合起来”。比如,当用户发了”文本+图像”,系统需要知道:“文本说的是’按钮颜色要改’,图像里的按钮是哪个位置”。

这里用到的关键算法是多模态注意力机制(Multimodal Attention)。它的原理就像”你听朋友说话时,会重点关注他的语气和表情”——系统会计算每个模态的”注意力权重”,然后把它们融合成一个统一的特征。

数学模型:多模态注意力的公式如下(以文本和图像为例):

Attention ( Q t , K i , V i ) = softmax ( Q t K i T d k ) V i ext{Attention}(Q_t, K_i, V_i) = ext{softmax}left(frac{Q_t K_i^T}{sqrt{d_k}}

ight) V_i Attention(Qt,Ki,Vi)=softmax(dk

QtKiT)Vi

其中:

Q t Q_t Qt(Query):文本的特征向量(比如用BERT模型提取的文本特征);

K i K_i Ki(Key):图像的特征向量(比如用CLIP模型提取的图像特征);

V i V_i V

相关文章