AI原生应用领域安全防护:从基础到进阶

关键词:AI原生应用、安全防护、对抗攻击、隐私保护、模型安全、数据投毒、输出可控性

摘要:本文从“AI原生应用”的独特安全需求出发,用“智能蛋糕店”的生活化比喻,逐步拆解数据安全、模型安全、输出安全三大核心防护场景。通过Python代码示例、数学原理解析和真实案例,带领读者从基础概念(如对抗样本、数据投毒)到进阶实践(如模型水印、隐私计算),掌握AI原生应用的安全防护体系。无论你是AI开发者还是安全爱好者,都能在这里找到从“知其然”到“知其所以然”的成长路径。

背景介绍

目的和范围

当ChatGPT能写代码、Midjourney能画海报、DALL·E 3能“脑补”不存在的照片时,我们已进入“AI原生应用”时代——这类应用核心功能完全由AI模型驱动,而非传统代码逻辑(比如用大模型生成客服回复,而非预先写好的规则库)。但硬币的另一面是:AI原生应用的安全风险与传统软件截然不同——数据被“污染”会让模型学坏,模型被“篡改”会输出恶意内容,甚至用户隐私可能被“偷”进模型里。

本文将覆盖AI原生应用从“数据-模型-输出”全链路的安全防护,帮你建立系统化的安全思维。

预期读者

AI开发者(想知道如何让自己训练的模型更安全)

安全工程师(需要理解AI特有的安全风险)

技术爱好者(对“AI也会被攻击”好奇的小白)

文档结构概述

本文采用“基础→进阶→实战”的递进结构:

用“智能蛋糕店”比喻拆解AI原生应用的安全场景;

讲解对抗攻击、数据投毒等基础威胁与防护;

深入模型窃取、隐私泄露等进阶风险与解决方案;

用Python代码演示攻击与防护的真实操作;

总结未来AI安全的挑战与趋势。

术语表

| 术语 | 通俗解释 |

|---|---|

| AI原生应用 | 核心功能由AI模型直接实现的应用(如用大模型写文案,而非用规则引擎) |

| 对抗样本 | 对原图做微小修改(人眼看不出),但能让AI识别错误的“陷阱图片” |

| 数据投毒 | 在训练数据里“下毒”(比如把猫的照片标成狗),让模型学坏 |

| 模型窃取 | 攻击者通过“套问”模型输出,偷偷复制出一个功能类似的模型 |

| 差分隐私 | 给数据加“模糊滤镜”,让单个用户隐私无法被追踪,但整体规律仍保留 |

核心概念与联系:用“智能蛋糕店”理解AI安全

故事引入:小明的智能蛋糕店

小明开了一家“AI蛋糕店”,店里有个“蛋糕脑”(AI模型):

数据间:每天收集顾客的“蛋糕偏好数据”(比如“喜欢巧克力味”“讨厌葡萄干”)来训练“蛋糕脑”;

制作间:“蛋糕脑”根据顾客需求(比如“做一个生日蛋糕”)生成配方(模型输出);

展示柜:最终做好的蛋糕(模型输出结果)卖给顾客。

但最近小明遇到了麻烦:

有人往“数据间”的牛奶里加了“奇怪粉末”(数据投毒),导致“蛋糕脑”认为“所有蛋糕都该放辣椒”;

有黑客给“制作间”的面粉拍了张“特殊照片”(对抗样本),“蛋糕脑”看了这张照片,把面粉认成了毒药,拒绝做蛋糕;

竞争对手派了个“间谍顾客”,每天问“蛋糕脑”100个问题(比如“放50g糖会怎样?放100g呢?”),偷偷复制了一个“蛋糕脑”(模型窃取)。

这些麻烦,就是AI原生应用特有的安全风险。

核心概念解释(像给小学生讲故事)

核心概念一:数据安全——AI的“食材安全”

AI模型要“学习”,就像小朋友学做饭,需要“食材”(训练数据)。如果食材被污染(比如牛奶过期),小朋友学出来的做饭方法肯定有问题。

数据投毒攻击:坏人往食材里加“毒药”(比如把“猫”的照片标成“狗”),AI学完后,看到真猫也会喊“狗”!

数据隐私泄露:食材里可能藏着顾客的秘密(比如“张阿姨每周六买无糖蛋糕”),坏人偷到这些数据,就能知道张阿姨的健康状况。

核心概念二:模型安全——AI的“大脑安全”

AI的“大脑”(模型参数)是最核心的资产,就像蛋糕店的“祖传秘方”。如果秘方被偷,竞争对手就能复制你的蛋糕;如果秘方被篡改,做出来的蛋糕可能有毒。

模型窃取攻击:坏人假装顾客,不断问你的“蛋糕脑”问题(比如“放3个鸡蛋会怎样?”“放4个呢?”),通过回答偷偷算出你的秘方;

对抗攻击:坏人给“蛋糕脑”看一张“奇怪照片”(比如在熊猫照片上画几道几乎看不见的线),“蛋糕脑”会把熊猫认成狗。

核心概念三:输出安全——AI的“产品安全”

AI最终输出的内容(比如生成的文案、推荐的商品)就像蛋糕店卖出的蛋糕。如果蛋糕里有玻璃渣(恶意内容),顾客会受伤;如果蛋糕味道忽好忽坏(输出不稳定),顾客会流失。

恶意内容生成:坏人诱导AI写病毒代码、造谣文章;

输出不可控:AI可能突然生成违反伦理的内容(比如歧视性言论)。

核心概念之间的关系(用蛋糕店打比方)

数据安全是模型安全的基础:如果食材(数据)被下毒,蛋糕脑(模型)肯定学坏(就像用坏牛奶做的蛋糕,烤箱(模型训练)再厉害也救不回来);

模型安全决定输出安全:如果蛋糕脑的秘方被偷(模型窃取),竞争对手能做出一样的蛋糕;如果秘方被篡改(对抗攻击),做出来的蛋糕可能有毒(恶意输出);

输出安全反推数据和模型安全:如果卖出的蛋糕总出问题(比如总加辣椒),可能是食材被下毒(数据投毒),也可能是蛋糕脑被篡改(模型被攻击)。

核心概念原理和架构的文本示意图

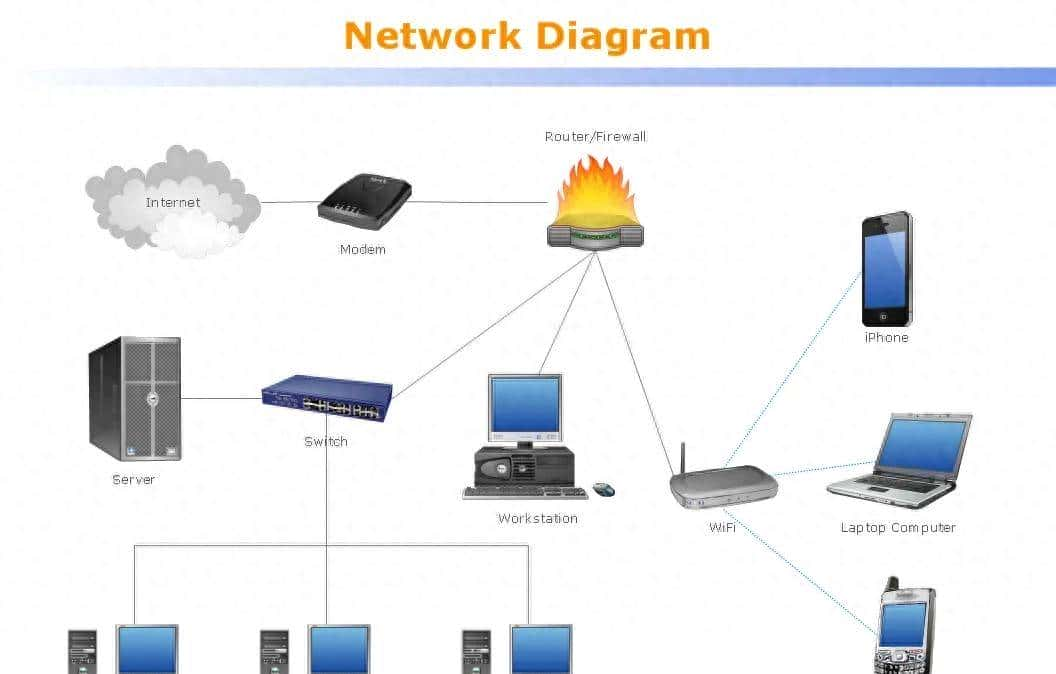

AI原生应用安全防护覆盖“数据-模型-输出”三大环节,形成闭环:

数据采集 → 数据清洗(防投毒) → 模型训练(防窃取) → 模型推理(防对抗攻击) → 输出审核(防恶意内容)

↑ ↓

└───── 隐私保护(贯穿全程) ────┘

Mermaid 流程图

graph TD

A[数据安全] --> B[模型安全]

B --> C[输出安全]

C --> D[用户反馈]

D --> A[数据安全] // 输出问题反推数据或模型风险

E[隐私保护] --> A // 隐私保护贯穿数据环节

E --> B // 隐私保护贯穿模型环节

E --> C // 隐私保护贯穿输出环节

核心算法原理 & 具体操作步骤:从攻击到防护

基础威胁1:对抗攻击(让AI“看错”)

原理:对输入数据(如图像、文本)做微小修改(人眼看不出),但AI模型会因“梯度敏感”而识别错误。

数学上,对抗样本的生成常用FGSM(快速梯度符号法):

x a d v = x + ϵ ⋅ sign ( ∇ x J ( θ , x , y ) ) x_{adv} = x + epsilon cdot ext{sign}(

abla_x J( heta, x, y)) xadv=x+ϵ⋅sign(∇xJ(θ,x,y))

其中:

( x ) 是原始输入(如图像);

( epsilon ) 是扰动强度(比如0.01,保证肉眼不可见);

(

abla_x J( heta, x, y) ) 是模型损失函数对输入的梯度(指示“往哪个方向修改最能让模型犯错”)。

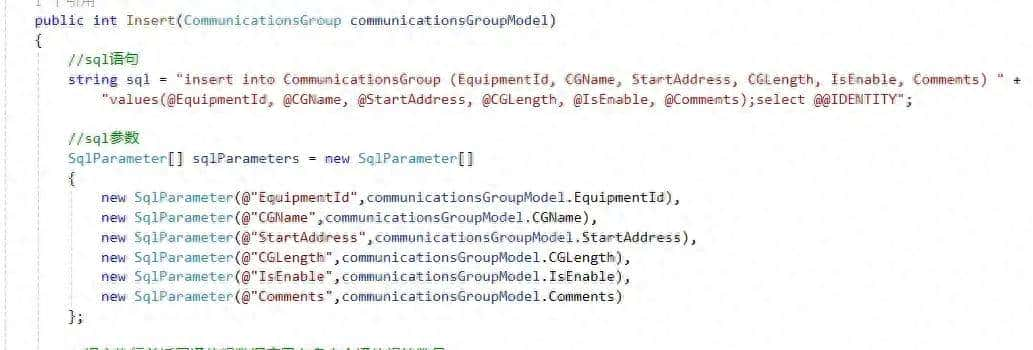

Python代码示例(用PyTorch生成对抗样本)

import torch

import torch.nn.functional as F

from torchvision import models, transforms

from PIL import Image

# 加载预训练的ResNet模型(识别图像)

model = models.resnet18(pretrained=True)

model.eval()

# 加载并预处理图像(猫的照片)

image = Image.open("cat.jpg")

transform = transforms.Compose([

transforms.Resize(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

x = transform(image)相关文章