大数据时代的数据挖掘:技术突破、创新方向与未来展望

关键词

大数据挖掘、深度学习融合、分布式算法、实时流处理、可解释AI、联邦学习、知识图谱、边缘智能

摘要

本文系统分析了大数据背景下数据挖掘领域的技术演进与突破性进展。通过第一性原理分析,揭示了数据规模、速度、多样性对传统挖掘方法的根本性挑战,以及新兴技术如何应对这些挑战。文章构建了”理论-架构-算法-应用”四维分析框架,深入探讨了分布式计算架构革新、深度学习融合、实时流挖掘、隐私保护挖掘等关键突破,并通过具体案例展示了技术创新如何推动各行业价值创造。最后,本文预测了数据挖掘的未来发展方向,包括边缘智能与云边协同、认知推理增强、自主挖掘系统等前沿趋势,为技术研发与产业应用提供战略指导。

1. 概念基础

1.1 领域背景化:数据挖掘的范式转变

数据挖掘作为从数据中提取有效、新颖、潜在有用且可理解知识的过程,其发展历程可追溯至20世纪80年代的知识发现(KDD)概念。随着大数据时代的到来,传统数据挖掘正经历根本性范式转变:

维度扩展:从结构化数据到非结构化、半结构化数据的扩展,包括文本、图像、视频、音频、传感器数据等多模态信息。

规模跃迁:数据量从GB级到PB级乃至EB级的指数级增长,对存储、处理和分析能力提出全新要求。

速度挑战:静态批处理转向动态流处理,实时性需求从小时级降至毫秒级。

价值密度:数据价值密度持续降低,要求挖掘算法具备更高的噪声鲁棒性和特征自动提取能力。

这一转变催生了”大数据挖掘”这一融合多学科的交叉领域,它集成了数据库系统、机器学习、统计学、分布式计算、人工智能等多个学科的理论与方法。

1.2 历史轨迹:从传统挖掘到智能挖掘

数据挖掘技术的演进可划分为四个关键阶段:

第一阶段(1980s-1990s):基础理论构建期

核心技术:统计分析、决策树、关联规则代表算法:ID3/C4.5决策树、Apriori关联规则算法特点:面向小规模结构化数据,以人工特征工程为主

第二阶段(2000s-2010):规模化探索期

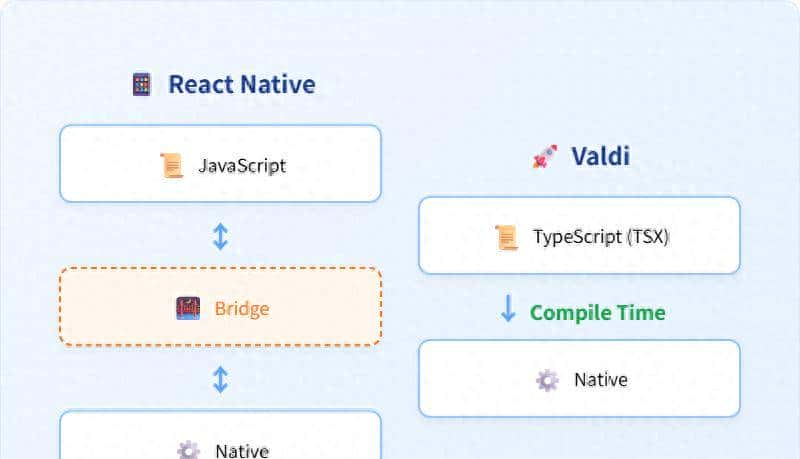

核心技术:分布式计算、流数据挖掘、图挖掘代表系统:MapReduce、Hadoop、Storm特点:应对数据规模挑战,强调并行计算与分布式架构

第三阶段(2010s):深度学习融合期

核心技术:深度神经网络、表示学习、强化学习代表模型:CNN、RNN、Transformer特点:自动特征学习,处理复杂数据类型能力显著提升

第四阶段(2020s-):智能自主挖掘期

核心技术:AutoML、联邦学习、可解释AI、认知推理代表方向:自动化机器学习、隐私保护挖掘、人机协同分析特点:降低技术门槛,强调模型可信度与数据安全

1.3 问题空间定义:大数据挖掘的核心挑战

大数据挖掘面临着独特的问题空间,可概括为”5V+1C”挑战:

Volume(规模)挑战:海量数据存储与处理的计算复杂性

数据量呈指数增长,传统单机算法无法处理存储成本与计算效率的平衡数据生命周期管理(采集、存储、处理、分析、销毁)

Velocity(速度)挑战:实时/近实时处理需求

流数据高速到达(如高频交易、传感器网络)低延迟分析与决策要求动态变化模式的捕捉与适应

Variety(多样性)挑战:多模态与异构数据集成

结构化、半结构化与非结构化数据并存多源数据的语义差异与冲突跨模态数据关联与融合

Veracity(真实性)挑战:数据质量与不确定性

噪声、缺失值、异常值处理数据不一致性与冲突解决不确定性推理与决策

Value(价值)挑战:知识提取与价值转化

从海量数据中提取高价值知识知识的可操作性与决策支持能力ROI(投资回报率)优化

Complexity(复杂性)挑战:系统与问题复杂度

高维数据空间的”维度灾难”非线性关系与复杂模式挖掘模型复杂度与可解释性的平衡

1.4 术语精确性:关键概念界定

为确保讨论的准确性,需要明确以下核心术语:

数据挖掘(Data Mining):从大量数据中提取有效、新颖、潜在有用且可理解的模式的非平凡过程。

知识发现(Knowledge Discovery in Databases, KDD):包括数据选择、预处理、转换、挖掘和解释评估的完整过程。数据挖掘是KDD过程的核心步骤。

大数据挖掘(Big Data Mining):针对具有海量(Volume)、高速(Velocity)、多样(Variety)、真实性(Veracity)和价值(Value)特征的数据进行知识发现的过程。

分布式数据挖掘(Distributed Data Mining):在分布式计算环境中执行数据挖掘任务,数据和/或计算资源分布在多个节点上。

流数据挖掘(Stream Data Mining):对连续、快速到达的数据流进行实时或近实时分析,提取随时间变化的模式。

联邦数据挖掘(Federated Data Mining):在保护数据隐私的前提下,对分布在不同机构的数据源进行协同挖掘,不共享原始数据。

可解释数据挖掘(Explainable Data Mining):不仅关注挖掘模型的预测性能,还强调模型决策过程的可理解性和透明度。

2. 理论框架

2.1 第一性原理推导:大数据挖掘的理论基础

大数据挖掘的理论基础建立在多个学科的第一性原理之上,主要包括:

统计学基础

大数定律的扩展:在大数据背景下,样本接近总体,传统抽样方法的必要性降低,但数据质量问题凸显中心极限定理的边界:当数据具有复杂相关性或非平稳特性时,传统统计推断的理论基础受到挑战维度灾难理论:高维空间中数据稀疏性导致传统密度估计和距离度量失效

计算复杂性理论

P/NP问题在大数据挖掘中的体现:大多数数据挖掘问题本质上是NP难问题,需要在近似解和计算效率间权衡线性与亚线性算法设计原理:为处理海量数据,算法需具备线性或亚线性时间复杂度和空间复杂度分布式计算复杂性:通信开销成为分布式挖掘系统的主要瓶颈,需要优化数据局部性

信息论基础

熵与信息增益的扩展应用:从特征选择到模式评估的统一框架互信息与相关性分析:高维数据中变量间复杂关系的度量数据压缩理论:最小描述长度(MDL)原则在模式选择中的应用

机器学习理论

VC维和泛化边界:大规模模型的 generalization-performance 权衡偏差-方差权衡:在有限数据与过度参数化模型间的平衡表示学习理论:从原始数据中自动学习有效表示的数学基础

2.2 数学形式化:核心理论模型

大数据挖掘的一般数学框架

设D={d1,d2,…,dN}D = {d_1, d_2, …, d_N}D={d1,d2,…,dN}表示包含NNN个样本的大数据集,每个样本did_idi可以表示为一个ddd-维向量或更复杂的结构。数据挖掘的目标是找到一个映射f:D→Pf: D

ightarrow Pf:D→P,其中PPP是模式空间,使得PPP满足:

有效性:PPP能准确反映数据的内在规律,ϵ(f(D),P∗)<δepsilon(f(D), P^*) < deltaϵ(f(D),P∗)<δ,其中P∗P^*P∗是真实模式,ϵepsilonϵ是误差度量新颖性:PPP包含新的、未被发现的知识有用性:PPP能为特定任务提供决策支持可理解性:PPP能用人类可理解的形式表示

分布式数据挖掘的理论模型

在分布式环境中,数据分布在mmm个节点上:D={D1,D2,…,Dm}D = {D_1, D_2, …, D_m}D={D1,D2,…,Dm},其中DiD_iDi是第iii个节点上的局部数据。分布式挖掘需要解决:

一致性问题:∥f(D)−∑i=1mwifi(Di)∥<ϵ|f(D) – sum_{i=1}^{m} w_i f_i(D_i)| < epsilon∥f(D)−∑i=1mwifi(Di)∥<ϵ,其中fif_ifi是局部挖掘函数,wiw_iwi是权重系数通信复杂性:C(m,N)=O(mlogN)C(m, N) = O(m log N)C(m,N)=O(mlogN),通信开销应随节点数和数据量亚线性增长收敛性证明:limm→∞,N→∞∥f(D)−f∗(D)∥=0lim_{m

ightarrow infty, N

ightarrow infty} |f(D) – f^*(D)| = 0limm→∞,N→∞∥f(D)−f∗(D)∥=0,其中f∗f^*f∗是最优集中式解

流数据挖掘的理论模型

数据流可建模为无限序列S={s1,s2,…,st,…}S = {s_1, s_2, …, s_t, …}S={s1,s2,…,st,…},其中sts_tst是ttt时刻到达的数据元素。流挖掘算法需满足:

空间约束:M(S,T)=O(polylogT)M(S, T) = O( ext{poly} log T)M(S,T)=O(polylogT),内存使用与数据总量TTT呈多项式对数关系时间约束:T(st)=O(1)T(s_t) = O(1)T(st)=O(1)或O(logT)O(log T)O(logT),处理每个元素的时间为常数或对数级概念漂移适应:D(t1,t2)=∥P(t1)−P(t2)∥>θD(t_1, t_2) = |P(t_1) – P(t_2)| > hetaD(t1,t2)=∥P(t1)−P(t2)∥>θ时,算法能检测并适应数据分布变化

2.3 理论局限性:当前框架的边界

尽管大数据挖掘理论取得显著进展,仍存在若干根本性局限:

计算复杂性与最优性的权衡

大多数实际数据挖掘问题本质上是NP难的,在大数据背景下,这种复杂性被进一步放大:

精确算法在大数据集上不可行,必须采用近似算法近似解的质量保证难以理论化分布式环境下的全局最优性与局部计算的矛盾

统计推断的可靠性边界

大数据并不等同于好数据,理论上存在”大数据悖论”:

数据量增加可能同时增加噪声和偏差高维稀疏数据中,传统显著性检验失效(多重比较问题)因果推断仍依赖强假设,相关关系难以转化为因果关系

动态与演化模式的理论挑战

现实世界数据具有高度动态性,现有理论框架难以有效应对:

概念漂移的形式化定义与分类仍不完善非平稳数据分布下的模型更新理论基础薄弱长期依赖与短期变化的统一建模缺乏理论指导

可解释性与性能的理论权衡

随着模型复杂度增加,可解释性成为重要挑战:

模型表达能力与可解释性通常呈负相关缺乏可解释性的量化度量标准解释的准确性与简洁性难以同时保证

2.4 竞争范式分析:数据挖掘的理论学派

大数据挖掘领域存在多种理论范式,各有其基础假设和优势:

统计学派

核心思想:基于概率模型和统计推断优势:理论基础坚实,提供置信区间和假设检验局限:对高维数据和复杂非线性关系建模能力有限代表方法:贝叶斯网络、马尔可夫模型、混合模型

机器学习学派

核心思想:专注于预测性能和泛化能力优势:处理复杂模式和高维数据的能力强局限:理论解释性较弱,需要大量数据代表方法:支持向量机、随机森林、神经网络

数据库学派

核心思想:强调高效数据访问和查询优化优势:可扩展性强,适合大规模数据处理局限:算法表达能力有限,难以处理复杂挖掘任务代表方法:频繁模式挖掘、OLAP分析、索引结构优化

人工智能学派

核心思想:模拟人类智能的认知过程优势:处理非结构化数据和复杂推理任务局限:计算复杂度高,可解释性差代表方法:知识图谱、推理系统、强化学习

数据科学融合学派

核心思想:整合多学科方法,强调问题导向优势:综合各学派长处,实用性强局限:理论体系尚不完善,缺乏统一框架代表方法:AutoML、多模态融合、跨学科问题解决

3. 架构设计

3.1 系统分解:大数据挖掘平台的组件架构

现代大数据挖掘系统采用分层架构,各组件协同工作以应对大数据挑战:

数据接入层(Data Ingestion Layer)

功能:接收、验证和初步处理来自多种数据源的数据组件:

连接器(Connectors):与各类数据源接口(数据库、API、文件系统、传感器等)数据验证器(Data Validators):检查数据完整性和一致性格式转换器(Format Converters):标准化数据格式缓冲队列(Buffer Queues):平滑数据流入峰值(如Kafka、RabbitMQ)

数据存储层(Data Storage Layer)

功能:提供高效、可扩展的数据持久化存储组件:

分布式文件系统(如HDFS、Ceph):存储海量原始数据NoSQL数据库(如Cassandra、MongoDB):存储非结构化/半结构化数据关系型数据库(如PostgreSQL、MySQL):存储结构化业务数据时序数据库(如InfluxDB、TimescaleDB):存储时间序列数据内存数据库(如Redis、Memcached):提供高速数据访问

数据处理层(Data Processing Layer)

功能:数据清洗、转换和特征工程组件:

ETL工具(如Apache NiFi、Talend):数据抽取、转换、加载流处理器(如Apache Flink、Kafka Streams):实时数据处理批处理器(如Apache Spark、MapReduce):大规模批处理数据湖处理引擎(如Apache Hive、Presto):数据湖查询与分析特征存储(如Feast、Hopsworks):管理机器学习特征

挖掘分析层(Mining & Analysis Layer)

功能:执行核心数据挖掘算法和模型训练组件:

分布式机器学习框架(如TensorFlow Distributed、PyTorch Distributed)统一分析引擎(如Apache Spark MLlib、H2O.ai)深度学习平台(如TensorFlow、PyTorch、MXNet)自动机器学习工具(如AutoML、TPOT、Auto-sklearn)图挖掘系统(如Neo4j、Apache Giraph)

模型管理层(Model Management Layer)

功能:模型版本控制、部署和监控组件:

模型注册表(Model Registry):存储和版本化模型模型部署引擎(如TensorFlow Serving、TorchServe)A/B测试框架(如Evidently AI、Optimizely)模型监控工具(如Prometheus、Grafana、AWS CloudWatch)模型解释工具(如SHAP、LIME、ELI5)

应用接口层(Application Interface Layer)

功能:提供用户交互和应用集成接口组件:

API网关(如Kong、NGINX):管理API请求可视化工具(如Tableau、Power BI、Superset):数据和结果可视化交互式笔记本(如Jupyter、Zeppelin):探索性分析自定义应用SDK:简化应用开发

3.2 组件交互模型:数据流与控制流

大数据挖掘系统中的组件交互涉及复杂的数据流和控制流:

数据流模型

数据在系统中的流动遵循以下路径:

采集与摄入:

多源异构数据通过连接器进入系统数据验证器进行初步质量检查格式转换器标准化数据格式缓冲队列平衡数据流入速度

存储与组织:

根据数据特性选择合适的存储系统建立数据目录和元数据管理实施数据分区和索引策略配置数据生命周期管理规则

预处理与特征工程:

数据清洗(去噪、填补缺失值)数据转换(标准化、归一化)特征提取与选择特征存储与版本控制

模型训练与评估:

从特征存储获取训练数据分布式训练框架分配计算资源执行挖掘算法和模型训练评估模型性能并优化参数

模型部署与服务:

注册训练好的模型到模型注册表将模型部署到生产环境接收预测请求并返回结果记录预测结果和性能指标

控制流模型

系统控制流负责协调各组件协同工作:

工作流编排:

定义数据处理和挖掘的流程(如Apache Airflow、Prefect)管理任务依赖和执行顺序处理错误恢复和重试逻辑监控工作流执行状态

资源管理:

集群资源调度(如YARN、Kubernetes)计算资源分配与优化存储资源管理与扩展网络资源配置与监控

监控与告警:

系统健康监控性能指标收集与分析异常检测与告警日志聚合与分析

安全控制:

身份认证与授权数据加密(传输中和静态)访问控制与审计合规性检查与报告

3.3 可视化表示:架构模式与数据流图

以下是大数据挖掘系统的关键架构模式及其可视化表示:

分布式数据挖掘系统架构

实时流数据挖掘架构

联邦学习架构

3.4 设计模式应用:大数据挖掘系统的最佳实践

大数据挖掘系统设计采用多种关键设计模式,以应对可扩展性、性能和可靠性挑战:

数据处理模式

MapReduce模式

应用场景:大规模批处理任务,如数据转换、聚合分析实现原理:将任务分解为Map和Reduce阶段,并行处理数据分区优势:简单易用,可扩展性好,容错性强实例:Hadoop MapReduce、Spark RDD

流处理模式

应用场景:实时数据处理,如实时监控、即时推荐实现原理:连续处理无限数据流,采用窗口操作和状态管理优势:低延迟,实时响应,资源高效利用实例:Apache Flink、Kafka Streams

CQRS(命令查询责任分离)模式

应用场景:读写分离的分析系统实现原理:将数据写入操作与查询操作分离,使用不同模型优势:优化读写性能,支持复杂查询,可独立扩展实例:事件溯源系统、实时分析平台

系统架构模式

微服务架构模式

应用场景:大型复杂数据挖掘平台实现原理:将系统分解为松耦合的独立服务,每个服务专注于特定功能优势:模块化,可独立部署和扩展,技术栈灵活挑战:服务间通信复杂,分布式事务处理

数据湖架构模式

应用场景:存储和处理多源异构数据实现原理:集中存储原始数据,无需预先结构化,支持多种分析方式优势:数据灵活性高,支持探索性分析,降低数据准备成本挑战:数据治理复杂,元数据管理困难

Lambda架构模式

应用场景:同时需要批处理和流处理的系统实现原理:结合批处理层(处理完整数据集)和速度层(处理实时数据)优势:同时提供完整和实时的数据分析结果挑战:系统复杂度高,需要维护两套处理系统

Kappa架构模式

应用场景:简化的实时数据处理系统实现原理:统一批处理和流处理为单一的流处理管道优势:架构简单,维护成本低,一致性好挑战:状态管理复杂,历史数据重处理效率

算法设计模式

分治算法模式

应用场景:大规模数据集上的算法设计实现原理:将问题分解为子问题,并行解决,然后合并结果实例:分布式决策树、并行聚类算法

增量学习模式

应用场景:流数据挖掘和动态环境实现原理:基于新数据更新模型,无需重新训练优势:计算效率高,适应概念漂移,资源消耗低实例:在线梯度下降、增量决策树

集成学习模式

应用场景:提高模型准确性和鲁棒性实现原理:组合多个弱模型的预测,形成强模型优势:降低过拟合风险,提高泛化能力,增强稳定性实例:随机森林、梯度提升机、分布式集成方法

4. 实现机制

4.1 算法复杂度分析:大数据挖掘的效率考量

大数据挖掘算法设计必须优先考虑计算复杂度,以应对海量数据挑战:

时间复杂度优化

传统数据挖掘算法在大数据场景下常面临时间复杂度挑战:

线性与亚线性算法:设计O(N)或O(N log N)复杂度的算法,如线性回归、k-means的近似算法随机化算法:通过随机性降低复杂度,如随机采样、随机投影、蒙特卡洛方法增量算法:避免重新处理全部数据,仅基于新数据更新模型,复杂度O(1)或O(log N)

空间复杂度优化

内存限制是大数据挖掘的主要瓶颈:

内存高效数据结构:如稀疏表示、压缩存储、近似数据结构外部内存算法:设计适合磁盘-内存数据交换的算法,如外部分类、外部排序流数据结构:如滑动窗口、计数草图(CountSketch)、布隆过滤器(Bloom Filter)

分布式复杂度模型

分布式环境引入新的复杂度维度:

通信复杂度:节点间数据传输成本,目标是设计通信量为O(N)或更低的算法同步复杂度:分布式算法的协调开销,异步算法通常具有更低的同步复杂度负载均衡:确保计算任务在节点间均匀分布,避免”热点”节点

大数据挖掘算法的复杂度权衡

实际应用中需要在多种复杂度间权衡:

精度-复杂度权衡:许多高效算法通过降低精度换取计算效率

示例:近似最近邻搜索(ANN)对比精确最近邻搜索量化指标:近似比(approximation ratio),误差边界(error bound)

时间-空间权衡:增加存储空间可能减少计算时间

示例:预计算与索引 vs. 实时计算量化指标:时空乘积(space-time product)

通信-计算权衡:增加本地计算可能减少节点间通信

示例:本地聚合 vs. 全局聚合量化指标:通信计算比(communication-computation ratio)

4.2 优化代码实现:高性能大数据挖掘的关键技术

高性能大数据挖掘代码实现需要结合算法优化、并行计算和系统优化:

算法层面优化

向量化实现

原理:利用CPU SIMD指令并行处理数据实现:使用向量化库(如Intel AVX, ARM NEON),避免循环展开示例:

# 非向量化实现

result = [x * 2 + 3 for x in data]

# 向量化实现(使用NumPy)

import numpy as np

result = data * 2 + 3 # 底层使用SIMD指令并行执行

稀疏数据优化

原理:仅存储和处理非零元素数据结构:稀疏矩阵(CSR, CSC格式)、稀疏张量示例:

from scipy.sparse import csr_matrix

# 稀疏矩阵存储与运算

sparse_data = csr_matrix(dense_matrix) # 自动压缩零元素

result = sparse_data.dot(vector) # 高效稀疏矩阵乘法

在线学习优化

原理:增量更新模型参数,避免重新训练实现:随机梯度下降(SGD)及其变体,自适应学习率示例:

# 在线线性回归

class OnlineLinearRegression:

def __init__(self, dim):

self.weights = np.zeros(dim)

self.learning_rate = 0.01

def update(self, x, y):

# 单次样本更新,O(d)复杂度

prediction = np.dot(self.weights, x)

error = y - prediction

self.weights += self.learning_rate * error * x

def predict(self, x):

return np.dot(self.weights, x)

并行计算优化

多线程与多进程

原理:利用多核CPU并行执行任务实现:线程池、进程池,共享内存模型示例:

from concurrent.futures import ThreadPoolExecutor

# 多线程特征提取

def extract_features(data_chunk):

# 特征提取逻辑

return features

# 将数据分成块,并行处理

data_chunks = [data[i:i+chunk_size] for i in range(0, len(data), chunk_size)]

with ThreadPoolExecutor(max_workers=8) as executor:

results = list(executor.map(extract_features, data_chunks))

GPU加速

原理:利用GPU的大规模并行计算能力实现:CUDA, cuDNN, TensorRT等框架示例:

import torch

# GPU加速深度学习模型

model = MyDeepLearningModel().cuda() # 将模型移至GPU

data = torch.tensor(input_data).cuda() # 将数据移至GPU

with torch.no_grad():

result = model(data) # 在GPU上执行计算

分布式计算

原理:跨节点并行处理大规模任务实现:参数服务器架构,AllReduce通信模式示例:

# PyTorch分布式训练

import torch.distributed as dist

# 初始化分布式环境

dist.init_process_group(backend='nccl')

# 创建分布式数据加载器

train_sampler = torch.utils.data.distributed.DistributedSampler(train_dataset)

train_loader = DataLoader(train_dataset, sampler=train_sampler, batch_size=batch_size)

# 分布式模型

model = torch.nn.parallel.DistributedDataParallel(model)

系统层面优化

内存管理

原理:优化内存分配和释放,减少内存碎片技术:内存池、对象重用、内存映射文件示例:

# 使用内存映射文件处理大型数据集

import numpy as np

# 创建内存映射文件(不加载整个文件到内存)

large_array = np.memmap('large_data.npy', dtype='float32', mode='r', shape=(1000000, 100))

# 分块处理数据

for i in range(0, 1000000, 1000):

chunk = large_array[i:i+1000]

process_chunk(chunk)

I/O优化

原理:减少I/O操作次数,提高数据吞吐量技术:批量读写、预取、异步I/O、数据压缩示例:

# 使用Parquet格式进行高效I/O

import pandas as pd

# 写入Parquet文件(压缩、列存储)

df.to_parquet('data.parquet', engine='pyarrow', compression='snappy')

# 读取Parquet文件(只加载需要的列)

df = pd.read_parquet('data.parquet', columns=['col1', 'col2', 'col3'])

缓存策略

原理:利用缓存减少重复计算和I/O技术:多级缓存、缓存预热、智能驱逐策略示例:

# 使用缓存装饰器缓存计算结果

from functools import lru_cache

@lru_cache(maxsize=128)

def expensive_feature_computation(x):

# 耗时的特征计算

return result

4.3 边缘情况处理:大数据挖掘的稳健性保障

大数据挖掘系统必须妥善处理各种边缘情况,以确保稳健性和可靠性:

数据质量问题处理

缺失值处理

检测方法:统计缺失比例、分析缺失模式处理策略:

删除法:适用于缺失比例低且随机分布的情况插补法:均值/中位数插补、KNN插补、MICE多重插补模型法:使用其他特征预测缺失值

实现示例:

from sklearn.impute import KNNImputer

# KNN插补缺失值

imputer = KNNImputer(n_neighbors=5)

imputed_data = imputer.fit_transform(original_data)

异常值处理

检测方法:Z-score、IQR、DBSCAN、孤立森林处理策略:

移除异常值:适用于数据错误导致的异常转换异常值:对数转换、截断处理单独建模:对正常样本和异常样本分别建模

实现示例:

from sklearn.ensemble import IsolationForest

# 使用孤立森林检测异常值

clf = IsolationForest(contamination=0.01) # 假设1%的异常值比例

predictions = clf.fit_predict(data)

normal_data = data[predictions == 1] # 筛选正常样本

数据不一致处理

类型:格式不一致、单位不一致、语义不一致处理策略:

标准化:统一数据格式和单位实体匹配:识别和合并重复实体冲突解决:基于规则或概率模型解决冲突

实现示例:

# 数据标准化

from sklearn.preprocessing import StandardScaler, OneHotEncoder

# 数值特征标准化

scaler = StandardScaler()

numeric_features = scaler.fit_transform(data[numeric_columns])

# 类别特征编码

encoder = OneHotEncoder()

categorical_features = encoder.fit_transform(data[categorical_columns])

算法稳定性处理

类别不平衡处理

问题:少数类样本不足导致模型偏向多数类处理策略:

采样方法:过采样(SMOTE)、欠采样(RandomUnderSampler)集成方法:EasyEnsemble、BalancedRandomForest算法层面:类别权重调整、代价敏感学习

实现示例:

from imblearn.over_sampling import SMOTE

# 使用SMOTE处理类别不平衡

smote = SMOTE(random_state=42)

X_resampled, y_resampled = smote.fit_resample(X, y)

高维稀疏数据处理

挑战:维度灾难、计算复杂度高、过拟合风险处理策略:

特征选择:基于统计、模型或嵌入的特征选择降维:PCA、t-SNE、UMAP等降维方法稀疏表示:利用数据稀疏性优化存储和计算

实现示例:

from sklearn.decomposition import PCA

# 使用PCA降维

pca = PCA(n_components=0.95) # 保留95%的方差

reduced_data = pca.fit_transform(high_dimensional_data)

概念漂移处理

问题:数据分布随时间变化导致模型性能下降处理策略:

检测方法:性能监控、分布比较、漂移指标适应方法:定期重训练、增量学习、集成更新预警机制:设置性能阈值触发警报

实现示例:

# 简单的概念漂移检测

class DriftDetector:

def __init__(self, window_size=1000, threshold=0.1):

self.window_size = window_size

self.threshold = threshold

self.reference_performance = None

self.current_window = []

def update(self, performance):

self.current_window.append(performance)

if len(self.current_window) > self.window_size:

self.current_window.pop(0)

if self.reference_performance is None:

self.reference_performance = np.mean(self.current_window)

return False

current_performance = np.mean(self.current_window)

drift_score = (self.reference_performance - current_performance) / self.reference_performance

if drift_score > self.threshold:

self.reference_performance = current_performance

return True # 检测到漂移

return False

系统健壮性处理

容错与恢复机制

节点故障处理:任务重试、备份节点、故障转移数据冗余:多副本存储、校验和、纠删码断点续算:定期保存中间结果,支持从断点恢复实现示例:

# 简单的断点续算实现

import pickle

import os

def train_model(data, checkpoint_path="checkpoint.pkl", resume=False):

# 检查是否需要从断点恢复

if resume and os.path.exists(checkpoint_path):

with open(checkpoint_path, "rb") as f:

model, epoch = pickle.load(f)

print(f"Resuming training from epoch {epoch}")

else:

model = initialize_model()

epoch = 0

# 训练循环

for i in range(epoch, total_epochs):

# 训练步骤

model.train_batch(data)

# 定期保存检查点

if i % checkpoint_interval == 0:

with open(checkpoint_path, "wb") as f:

pickle.dump((model, i), f)

return model

资源限制处理

内存限制:数据分块、外存算法、稀疏表示计算资源限制:优先级调度、渐进式计算、资源弹性伸缩网络限制:数据本地化、压缩传输、边缘计算实现示例:

# 分块处理大型数据集

def process_large_dataset(file_path, chunk_size=10000):

results = []

# 分块读取数据

for chunk in pd.read_csv(file_path, chunksize=chunk_size):

# 处理当前块

chunk_result = process_chunk(chunk)

results.append(chunk_result)

# 合并结果

final_result = combine_results(results)

return final_result

4.4 性能考量:大数据挖掘系统的评估与优化

大数据挖掘系统性能评估需要综合考虑多个维度:

关键性能指标

吞吐量(Throughput)

定义:单位时间内处理的数据量或完成的任务数度量:记录/秒、查询/秒、模型训练迭代/秒优化策略:并行处理、流水线、批处理优化

延迟(Latency)

定义:从请求到结果返回的时间间隔度量:平均延迟、P95/P99延迟、最大延迟优化策略:减少计算步骤、优化数据访问、使用缓存

资源利用率(Resource Utilization)

定义:CPU、内存、网络、存储等资源的使用效率度量:CPU使用率、内存占用、I/O带宽利用率优化策略:资源调度优化、内存管理、负载均衡

可扩展性(Scalability)

定义:系统性能随资源增加而提升的能力度量:加速比(Speedup)、效率(Efficiency)、规模扩展性优化策略:无状态设计、数据分区、分布式算法

准确性(Accuracy)

定义:挖掘结果的质量和正确性度量:预测准确率、召回率、F1分数、均方误差优化策略:算法改进、特征工程、集成方法

性能评估方法

基准测试(Benchmarking)

方法:使用标准数据集和任务评估系统性能工具:TPC-DS, MLPerf, HiBench实践:定义明确的测试场景,控制变量,多次运行取平均值

性能剖析(Profiling)

方法:识别系统瓶颈和性能热点工具:CPU剖析器、内存剖析器、I/O跟踪器实践:针对关键路径进行深度剖析,量化各组件耗时

负载测试(Load Testing)

方法:评估系统在不同负载下的表现技术:逐步增加数据量或并发用户数实践:确定系统饱和点,评估稳定性和响应能力

A/B测试

方法:对比不同算法或配置的性能差异设计:控制变量,确保公平比较实践:关注统计显著性,考虑长期性能趋势

性能优化策略

硬件优化

CPU优化:选择高核心数处理器,启用超线程内存优化:增加内存容量,使用更高带宽的内存存储优化:使用SSD/NVMe,配置RAID,分布式存储网络优化:提高带宽,减少延迟,优化拓扑结构

软件优化

操作系统优化:调整内核参数,优化I/O调度数据库优化:索引优化,查询优化,分区策略算法优化:选择更高效的算法,优化数据结构代码优化:向量化,循环优化,内存局部性优化

数据优化

数据预处理:清洗,去重,特征选择数据格式:选择高效存储格式(Parquet, ORC)数据压缩:

相关文章