AI质量预测系统容错设计:如何让单组件故障变成“小感冒”?

关键词

AI质量预测、容错设计、组件化架构、故障隔离、降级策略、自愈机制、可靠性工程

摘要

凌晨3点的制造业车间里,一条价值千万的生产线突然停摆——原因是AI质量预测系统的模型推理服务崩溃,导致MES系统收不到缺陷预测结果,生产线被迫紧急停机。每停一分钟,企业损失上万元。

这不是极端案例,而是AI系统部署后的普遍痛点:单组件故障易引发“多米诺骨牌效应”,导致整体宕机。对于AI质量预测这类“业务生命线”系统(比如产品缺陷检测、代码质量评估、电商商品评分),稳定性的重要性甚至超过预测精度。

本文将从架构设计→故障处理→自愈机制的全流程,拆解如何让AI质量预测系统具备“容错能力”——即使单个组件故障,也能像人感冒时“用纸巾代替口罩”一样,保持核心功能可用。我们会用“餐厅运营”的生活化类比、可落地的代码示例、数学模型,帮你从“知其然”到“知其所以然”。

一、背景:为什么AI质量预测系统需要容错?

1.1 AI质量预测的业务价值

AI质量预测是**用数据和模型提前识别“质量风险”**的系统,典型场景包括:

制造业:通过传感器数据预测产品是否有缺陷(比如汽车零件的裂纹、芯片的焊点问题);软件研发:通过代码特征(复杂度、注释率)预测模块是否易出bug;电商零售:通过商品描述、用户评价预测商品是否符合质量标准。

这些场景的共性是:系统输出直接影响业务决策——生产线依赖预测结果调整参数,研发团队依赖结果优先测试高风险模块,电商平台依赖结果拦截劣质商品。一旦系统宕机,业务就会“断腿”。

1.2 核心挑战:组件依赖的“脆弱性”

AI质量预测系统的典型流程是**“数据采集→特征工程→模型推理→结果输出”**,每个环节都是“串联”的:

数据采集依赖传感器/数据库接口;特征工程依赖数据采集的结果;模型推理依赖特征工程的输出;结果输出依赖模型推理的结论。

这种“牵一发而动全身”的结构,导致单组件故障会扩散至整个系统:

比如传感器接口超时→数据采集失败→特征工程无输入→模型推理空跑→结果输出报错→生产线停机。

1.3 目标:从“雪崩”到“局部感冒”

我们的目标是将“系统级故障”降级为“组件级故障”——即使某个组件坏了,其他组件仍能正常工作,核心功能(比如“输出质量预测结果”)不受影响。

举个生活化的类比:把AI系统比作餐厅:

数据采集=采购食材;特征工程=洗菜切菜;模型推理=炒菜;结果输出=上菜。

如果采购的人迟到了(数据采集故障),餐厅不会关门——可以用备用供应商的食材(缓存数据);如果炒菜的锅坏了(模型推理故障),可以用电磁炉应急(fallback模型);如果服务员请假了(结果输出故障),可以让厨师直接上菜(消息队列暂存)。

容错设计的本质,就是给每个“餐厅环节”准备**“Plan B”**,让局部问题不影响整体运营。

二、核心概念:容错设计的“四大基石”

要实现“单组件故障不影响整体”,需要先理解四个核心概念——它们是容错系统的“地基”。

2.1 基石1:组件化架构——把“大系统”拆成“小积木”

定义:将系统拆分为独立、低耦合的组件(比如微服务),每个组件只负责一件事,通过API交互。

类比:把餐厅的“采购、切菜、炒菜、上菜”分成四个独立部门,每个部门有自己的负责人和流程。

为什么重要?

只有拆分组件,才能隔离故障——比如采购部门出问题,不会影响切菜部门的工作。如果是“大锅饭”式的单体系统,一个模块崩溃会导致整个系统宕机。

组件化的关键原则:

单一职责:每个组件只做一件事(比如“数据采集服务”只负责从传感器拉数据);接口清晰:组件间通过REST API或消息队列通信,避免直接依赖内部实现;独立部署:每个组件单独容器化(比如Docker),用Kubernetes管理,故障时可独立重启。

2.2 基石2:故障检测——及时发现“生病的组件”

定义:通过监控指标或心跳检测,实时判断组件是否“健康”。

类比:餐厅经理每天检查采购部门的“食材新鲜度”、厨房的“锅具状态”,提前发现问题。

常见的故障信号:

服务不可达(比如API返回503);响应延迟过高(比如原本100ms的请求变成5s);错误率飙升(比如10%的请求失败);资源耗尽(比如CPU使用率100%、内存不足)。

工具示例:

用Prometheus采集组件的指标(比如请求数、错误率、延迟);用Grafana可视化指标,设置“红色警戒”(比如错误率超过20%时报警);用Alertmanager发送报警通知(邮件、钉钉)。

2.3 基石3:故障隔离——不让“感冒”传染给别人

定义:当组件故障时,通过“熔断器”或“隔离层”,阻止故障扩散到其他组件。

类比:餐厅的采购部门有人感冒了,经理会让他回家隔离,避免传染给切菜和炒菜的人。

核心模式:熔断器(Circuit Breaker)

熔断器是故障隔离的“核心武器”,它的工作原理像家里的电闸:

闭合状态:正常转发请求;打开状态:当错误率超过阈值(比如30%),断开电路,拒绝所有请求;半开状态:断开一段时间后(比如5秒),允许少量请求测试,如果成功则恢复闭合,否则继续打开。

为什么有效?

比如数据采集服务故障,熔断器会断开“特征工程→数据采集”的请求,避免特征工程服务因“等待超时”而耗尽资源,最终崩溃。

2.4 基石4:降级与Fallback——用“低配方案”维持核心功能

定义:当组件故障时,用“低精度但可用”的方案替代,保证核心功能不中断。

类比:餐厅的炒菜锅坏了,厨师可以用电磁炉炒“简餐”(比如蛋炒饭),虽然不如炒菜好吃,但能让顾客吃饱。

常见的降级策略:

数据采集降级:用缓存的历史数据替代实时数据;特征工程降级:用预计算的“特征模板”替代实时特征;模型推理降级:用规则引擎(比如“温度>100℃则标记为缺陷”)替代ML模型;结果输出降级:将结果暂存到消息队列(比如Kafka),待服务恢复后再推送。

2.5 概念关系:容错系统的“工作流”

用Mermaid流程图展示四个基石的关系:

graph TD

A[组件化架构] --> B[故障检测]

B --> C[故障隔离(熔断器)]

C --> D[降级/Fallback]

D --> E[自愈机制]

E --> A

简单来说:

先拆组件(A);再检测故障(B);然后隔离故障(C);接着用低配方案维持功能(D);最后自动修复故障组件(E);修复后回到正常状态(A)。

三、技术原理:从“理论”到“实现”

接下来,我们用制造业产品缺陷预测系统为例,拆解容错设计的具体实现——从架构到代码,一步一步来。

3.1 系统架构:组件化拆分

首先,将“数据采集→特征工程→模型推理→结果输出”拆分为四个独立服务:

| 服务名称 | 职责 | 技术栈 |

|---|---|---|

| 数据采集服务 | 从传感器API拉取实时数据(温度、压力) | FastAPI + Requests |

| 特征工程服务 | 提取时域特征(均值、方差)和频域特征(FFT) | FastAPI + Pandas + NumPy |

| 模型推理服务 | 用XGBoost模型预测产品缺陷 | FastAPI + XGBoost |

| 结果输出服务 | 将预测结果推送到MES系统 | FastAPI + Kafka |

每个服务都容器化(Docker),用Kubernetes部署,确保独立伸缩和故障恢复。

3.2 故障检测:用Prometheus监控“健康状态”

我们需要给每个服务添加健康检查端点(/health)和指标暴露端点(/metrics),让Prometheus采集数据。

代码示例:数据采集服务的健康检查

用FastAPI实现/health端点:

from fastapi import FastAPI

import time

app = FastAPI()

# 模拟内部状态:比如数据库连接是否正常

def is_db_connected():

return True # 实际中需要检查数据库连接

@app.get("/health")

def health_check():

db_status = "healthy" if is_db_connected() else "unhealthy"

return {

"status": "healthy" if db_status == "healthy" else "unhealthy",

"components": {

"database": db_status,

"sensor_api": "healthy" # 实际中需要检查传感器API连通性

},

"timestamp": int(time.time())

}

代码示例:暴露监控指标

用

prometheus-client

from prometheus_client import Counter, Histogram, generate_latest

from fastapi import Response

# 定义指标:请求数

REQUEST_COUNT = Counter(

"request_count",

"Total number of requests",

["method", "endpoint", "status_code"]

)

# 定义指标:请求延迟(直方图)

REQUEST_LATENCY = Histogram(

"request_latency_seconds",

"Request latency in seconds",

["method", "endpoint"]

)

# 中间件:记录每个请求的指标

@app.middleware("http")

async def record_metrics(request, call_next):

start_time = time.time()

response = await call_next(request)

latency = time.time() - start_time

# 记录请求数

REQUEST_COUNT.labels(

method=request.method,

endpoint=request.url.path,

status_code=response.status_code

).inc()

# 记录请求延迟

REQUEST_LATENCY.labels(

method=request.method,

endpoint=request.url.path

).observe(latency)

return response

# 暴露指标端点

@app.get("/metrics")

def metrics():

return Response(generate_latest(), media_type="text/plain")

监控配置:Prometheus + Grafana

在Prometheus的

prometheus.yml

scrape_configs:

- job_name: 'ai-quality-prediction'

kubernetes_sd_configs:

- role: pod

relabel_configs:

- source_labels: [__meta_kubernetes_pod_label_app]

regex: 'data-collection|feature-engineering|model-inference|result-output'

action: keep

- source_labels: [__meta_kubernetes_pod_container_port_number]

regex: '8000'

action: keep

- target_label: __metrics_path__

replacement: /metrics

然后用Grafana创建仪表盘,监控:

每个服务的请求数(

request_count_total

sum by (endpoint) (request_count_total{status_code=~"5.."} / request_count_total)

request_latency_seconds_bucket

3.3 故障隔离:用熔断器阻止“多米诺效应”

我们用Resilience4j(轻量级容错库)实现熔断器,给“特征工程→数据采集”的调用加保护。

代码示例:特征工程服务的熔断器

首先安装Resilience4j的Python绑定:

pip install resilience4py

然后在特征工程服务中,用熔断器包裹数据采集的API调用:

from resilience4py.circuitbreaker import CircuitBreaker, CircuitBreakerConfig

import requests

# 配置熔断器:错误率>30%则打开,5秒后进入半开状态,允许2个请求测试

cb_config = CircuitBreakerConfig(

failure_rate_threshold=30,

wait_duration_in_open_state=5000, # 5秒

permitted_number_of_calls_in_half_open_state=2,

sliding_window_size=10 # 滑动窗口大小:最近10个请求

)

cb = CircuitBreaker("data-collection-cb", cb_config)

# 封装数据采集的API调用

@cb.decorate

def call_data_collection_service(device_id: str):

response = requests.get(

"http://data-collection-service:8000/collect",

params={"device_id": device_id},

timeout=2

)

response.raise_for_status() # 抛出HTTP错误(比如503)

return response.json()

# 特征工程的核心逻辑

@app.get("/process")

def process_features(device_id: str):

try:

# 调用数据采集服务(带熔断器保护)

raw_data = call_data_collection_service(device_id)

# 提取特征(均值、方差、FFT)

features = {

"mean_temperature": sum(raw_data["temperature"]) / len(raw_data["temperature"]),

"var_pressure": np.var(raw_data["pressure"]),

"fft_speed": np.fft.fft(raw_data["speed"]).tolist()

}

return features

except Exception as e:

# 熔断器打开或调用失败时,进入降级流程

return handle_degradation(device_id)

熔断器的效果:

当数据采集服务的错误率超过30%,熔断器会“跳闸”,拒绝所有请求;5秒后,熔断器进入“半开”状态,允许2个请求测试;如果测试成功(请求返回200),熔断器恢复“闭合”;否则继续“打开”。

3.4 降级与Fallback:用“低配方案”维持功能

当熔断器打开或调用失败时,我们需要触发降级逻辑——用备用方案替代故障组件。

降级策略设计:按组件分类

针对四个服务,我们设计不同的降级方案:

| 组件 | 故障场景 | 降级方案 |

|---|---|---|

| 数据采集服务 | 传感器API超时/宕机 | 用最近1小时的缓存数据(Redis存储) |

| 特征工程服务 | 代码bug/资源耗尽 | 用预计算的“特征模板”(比如同类设备的平均特征) |

| 模型推理服务 | 模型崩溃/延迟过高 | 用规则引擎(比如“温度>100℃→缺陷”) |

| 结果输出服务 | MES接口宕机 | 将结果暂存到Kafka,待服务恢复后推送 |

代码示例:数据采集服务的降级逻辑

在特征工程服务中,实现

handle_degradation

import redis

import numpy as np

# 连接Redis缓存

redis_client = redis.Redis(host="redis-service", port=6379, db=0)

def handle_degradation(device_id: str):

# 1. 尝试从Redis获取缓存数据(最近1小时)

cached_data = redis_client.get(f"device:{device_id}:data")

if cached_data:

return {"status": "degraded", "data": eval(cached_data)} # 实际中用json.loads

# 2. 如果缓存没有,用预计算的特征模板

template = get_feature_template(device_id)

if template:

return {"status": "degraded", "data": template}

# 3. 最后防线:返回默认值(比如空特征,但需保证模型能处理)

return {"status": "degraded", "data": {"temperature": [0], "pressure": [0], "speed": [0]}}

def get_feature_template(device_id: str):

# 模拟从数据库获取同类设备的特征模板(比如“设备类型=电机”的平均特征)

device_type = get_device_type(device_id) # 假设返回“电机”

template = {

"temperature": [80], # 电机的平均温度

"pressure": [5], # 电机的平均压力

"speed": [1500] # 电机的平均转速

}

return template

3.5 自愈机制:让故障组件“自动恢复”

降级是“应急措施”,我们需要自动修复故障组件,让系统回到正常状态。

自愈的核心工具:Kubernetes的探针

Kubernetes提供两种探针,帮你自动重启故障的Pod:

Liveness探针:检查容器是否“活着”(比如是否能响应/health请求);Readiness探针:检查容器是否“准备好处理请求”(比如是否完成初始化)。

代码示例:Kubernetes的Deployment配置

给数据采集服务的Deployment添加Liveness和Readiness探针:

apiVersion: apps/v1

kind: Deployment

metadata:

name: data-collection-deployment

spec:

replicas: 3 # 3个副本,保证高可用

selector:

matchLabels:

app: data-collection

template:

metadata:

labels:

app: data-collection

spec:

containers:

- name: data-collection

image: your-registry/data-collection:v1

ports:

- containerPort: 8000

# Liveness探针:如果/health返回非200,重启容器

livenessProbe:

httpGet:

path: /health

port: 8000

initialDelaySeconds: 30 # 启动30秒后开始探测

periodSeconds: 10 # 每10秒探测一次

failureThreshold: 3 # 连续3次失败则重启

# Readiness探针:如果/health返回非200,移除负载均衡

readinessProbe:

httpGet:

path: /health

port: 8000

initialDelaySeconds: 10

periodSeconds: 5

resources:

requests:

cpu: "100m"

memory: "128Mi"

limits:

cpu: "500m"

memory: "512Mi"

自愈的效果:

如果数据采集服务的Pod崩溃(比如内存溢出),Liveness探针会检测到/health返回500,自动重启Pod;如果Pod正在初始化(比如加载模型),Readiness探针会将其从负载均衡中移除,避免接收请求。

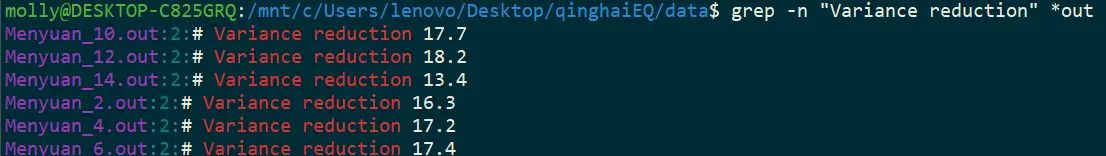

3.6 数学模型:容错系统的“可靠度计算”

容错设计的效果可以用**可靠度(Reliability)**量化——系统在规定时间内正常工作的概率。

基本公式

假设系统由n个组件串联组成,每个组件的可靠度为R_i(比如R1=0.99表示组件1的可靠度是99%),则串联系统的可靠度为:

如果给每个组件添加一个备用组件(并联),则并联后的可靠度为:

案例计算

以我们的制造业系统为例:

原始串联系统的可靠度:R1(数据采集)=0.99,R2(特征工程)=0.98,R3(模型推理)=0.97,R4(结果输出)=0.96。

添加备用组件后的可靠度(每个组件1主1备):

R1并联=1-(1-0.99)^2=0.9999;R2并联=1-(1-0.98)^2=0.9996;R3并联=1-(1-0.97)^2=0.9991;R4并联=1-(1-0.96)^2=0.9984;

四、实际应用:制造业缺陷预测系统的容错落地

现在,我们把前面的技术整合起来,看制造业缺陷预测系统的容错流程:

4.1 场景复现:数据采集服务故障

假设传感器API突然宕机,数据采集服务无法拉取实时数据。

容错流程:

故障检测:Prometheus检测到数据采集服务的错误率飙升至100%,Alertmanager发送报警;故障隔离:特征工程服务的熔断器(data-collection-cb)检测到错误率超过30%,进入“打开”状态,拒绝所有请求;降级处理:特征工程服务触发

handle_degradation

4.2 常见问题及解决方案

在落地过程中,你可能会遇到以下问题:

问题1:缓存数据过期导致降级效果差

原因:缓存的历史数据太旧,无法反映当前设备状态。

解决方案:

设置合理的缓存过期时间(比如1小时),根据设备的变化频率调整;用增量缓存:每次获取实时数据后,更新缓存的部分字段(比如只更新温度,保留压力的历史值)。

问题2:规则引擎的精度不足

原因:规则是“硬编码”的,无法适应复杂场景(比如温度+压力共同影响缺陷)。

解决方案:

定期用历史数据更新规则(比如每星期重新计算“缺陷阈值”);结合轻量级模型(比如逻辑回归)作为规则引擎的补充,平衡精度和速度。

问题3:熔断器误触发

原因:短时间内的突发请求(比如设备启动时的高并发)导致错误率飙升,熔断器误判。

解决方案:

调整熔断器的滑动窗口大小(比如从10个请求增加到20个),减少波动影响;增加半开状态的测试次数(比如从2次增加到5次),避免误判。

4.3 混沌工程:测试容错机制的“抗压能力”

容错设计的效果需要主动测试——用混沌工程工具模拟故障,验证系统的反应。

工具:Chaos Mesh

Chaos Mesh是Kubernetes生态的混沌工程工具,支持模拟:

Pod故障(比如删除Pod、暂停Pod);网络故障(比如延迟、丢包);资源故障(比如CPU满载、内存不足)。

测试案例:模拟数据采集服务宕机

用Chaos Mesh删除数据采集服务的一个Pod:

kubectl apply -f - <<EOF

apiVersion: chaos-mesh.org/v1alpha1

kind: PodChaos

metadata:

name: delete-data-collection-pod

spec:

action: delete

mode: one

selector:

labelSelectors:

app: data-collection

EOF

观察系统反应:

Prometheus监控到数据采集服务的错误率上升;特征工程服务的熔断器打开,触发降级;Kubernetes自动重启被删除的Pod;系统的核心功能(输出缺陷预测结果)未中断。

五、未来展望:容错设计的“进化方向”

AI质量预测系统的容错设计不是“一劳永逸”的,未来会向以下方向进化:

5.1 AI驱动的容错:从“被动应对”到“主动预测”

当前的容错是“故障发生后才处理”,未来会用ML模型预测故障——比如:

用时间序列模型(比如LSTM)预测传感器API的延迟,提前切换到缓存数据;用异常检测模型(比如Isolation Forest)识别模型推理的“漂移”(比如预测精度突然下降),提前更新模型。

5.2 Serverless架构的容错:“无服务器”的高可用

Serverless架构(比如AWS Lambda、阿里云函数计算)的特点是“按需执行、自动扩容”,容错能力更强:

函数故障时,云厂商会自动重试;无需管理服务器,减少“人为操作失误”导致的故障;按调用次数计费,降低容错的成本(比如不需要长期运行备用组件)。

5.3 边缘计算的容错:“本地处理”减少延迟

对于制造业等需要低延迟的场景,边缘计算(Edge Computing)会成为容错的核心:

将数据采集、特征工程、模型推理部署在边缘节点(比如工厂的本地服务器),避免“云-边”网络故障;边缘节点之间互相备份,比如工厂A的边缘节点故障,自动切换到工厂B的边缘节点。

5.4 挑战与机遇

未来的容错设计也会面临挑战:

复杂度上升:组件越多,容错逻辑越复杂,需要用“可观测性平台”(比如Jaeger、Zipkin)跟踪故障流;模型容错:AI模型本身的“漂移”(比如数据分布变化导致精度下降)算不算“故障”?如何将模型漂移纳入容错设计?多云容错:跨云部署组件(比如阿里云+AWS),避免单云故障,但需要解决“数据同步”和“延迟”问题。

这些挑战也是机遇——谁能解决这些问题,谁就能在AI质量预测领域占据领先地位。

六、总结:容错设计的“核心心法”

写了这么多,最后用三句话总结容错设计的核心:

组件化是基础:没有拆分,就没有隔离;降级是底线:即使所有组件都故障,也要保证核心功能可用;自愈是目标:容错不是“救火”,而是“让系统自己灭火”。

思考问题:鼓励你进一步探索

如果你的AI质量预测系统需要处理实时流数据(比如每秒1000条),如何设计容错机制以保证低延迟?AI模型的“漂移”会导致预测错误,这算不算“组件故障”?如何将模型漂移纳入容错设计?跨多云部署组件时,如何解决“数据同步”和“延迟”问题?

参考资源

书籍:《可靠分布式系统:基于容错的设计》(作者:Ken Arnold);论文:《The Circuit Breaker Pattern》(作者:Michael T. Nygard);工具文档:Resilience4j(https://resilience4j.readme.io/)、Kubernetes(https://kubernetes.io/);报告:Gartner《Top Trends in AI Engineering, 2024》。

写在最后:

AI质量预测系统的容错设计,本质上是“对业务负责”——你做的每一个架构决策,都关系到生产线的运转、研发团队的效率、用户的信任。希望这篇文章能帮你从“害怕故障”变成“驾驭故障”,让你的系统像“打不死的小强”一样,永远保持活力。

如果有任何问题,欢迎在评论区留言,我们一起讨论!

—— 一个专注于AI可靠性的架构师

2024年XX月XX日

相关文章