大数据领域数据中台的安全防护技术:全生命周期的信任构建与风险管控

元数据框架

标题:大数据数据中台安全防护技术:从理论到实践的全生命周期保障

关键词:数据中台安全;大数据安全;数据生命周期保护;零信任架构;数据脱敏;加密存储;安全合规

摘要:数据中台作为大数据生态的“数据枢纽”,其安全直接决定了数据价值的可信释放。本文从数据中台的核心定位出发,系统分析其面临的多维度安全威胁(如数据泄露、篡改、未授权访问),结合CIA三元组(保密性、完整性、可用性)与数据生命周期理论,构建了“分层防御+全链路管控”的安全架构。通过密码学、访问控制、异常检测等技术的落地实践,探讨了数据采集、存储、处理、服务各阶段的安全实现机制,并结合零信任、合规性要求(如GDPR、《数据安全法》)提出了可落地的战略建议。本文既涵盖理论深度(如加密算法的数学推导),也提供实践指南(如数据脱敏代码、安全架构设计),旨在为大数据从业者提供一套完整的数据中台安全防护体系。

1. 概念基础:数据中台的安全边界与挑战

1.1 数据中台的核心定位与价值

数据中台(Data Middle Platform)是连接数据源与数据应用的中间层,其核心功能是实现数据的整合、存储、处理、服务化,解决传统大数据架构中“数据孤岛”“重复建设”“价值释放低效”的问题。具体来说,数据中台的价值体现在:

数据整合:将分散在业务系统、数据仓库、数据湖中的数据统一接入,形成“单一数据源”(Single Source of Truth);数据治理:通过数据清洗、血缘跟踪、质量监控,提升数据可信度;数据服务:以API、报表、模型等形式向应用层输出数据价值,支撑智能推荐、决策分析等场景。

数据中台的本质是**“数据的信任传递者”——它必须保证传递的数据是可信的**(未被篡改)、安全的(未被泄露)、可用的(及时响应)。

1.2 数据中台的安全挑战

数据中台的安全威胁来自内部(如员工误操作、恶意泄露)与外部(如黑客攻击、第三方违规),具体可分为以下几类:

数据泄露:敏感数据(如用户隐私、交易记录)通过API接口、存储介质或内部人员违规访问流出;数据篡改:攻击者通过注入恶意代码或未授权修改,篡改数据内容(如修改交易金额、用户积分);未授权访问:外部黑客或内部人员通过破解权限、越权操作访问敏感数据;服务中断:DDoS攻击、系统故障导致数据中台无法提供服务,影响下游应用;合规风险:未满足数据保护法规要求(如未脱敏、未审计),导致监管处罚(如GDPR的巨额罚款)。

1.3 关键术语辨析

数据中台 vs 数据仓库 vs 数据湖:

数据仓库(Data Warehouse):面向分析的结构化数据存储,强调数据一致性;数据湖(Data Lake):面向原始数据的低成本存储,支持结构化、半结构化、非结构化数据;数据中台(Data Middle Platform):在数据湖与数据仓库基础上,增加了数据治理(如血缘、质量)与数据服务(如API、模型)能力,是“数据资产的运营平台”。

数据生命周期:数据从产生(采集)、存储、处理、服务到销毁的全流程;数据脱敏:通过技术手段隐藏或替换敏感数据(如身份证号、手机号),分为不可逆脱敏(如哈希)与可逆脱敏(如加密);零信任架构(ZTA):核心原则是“永不信任,始终验证”(Never Trust, Always Verify),适用于数据中台的多租户、跨域访问场景。

2. 理论框架:数据中台安全的底层逻辑

2.1 第一性原理:数据中台安全的核心需求

数据中台的核心价值是让数据“可用且可信”,因此安全的核心需求可归纳为:

保密性(Confidentiality):敏感数据仅能被授权主体访问(如用户隐私数据不泄露给第三方);完整性(Integrity):数据未被未授权修改或破坏(如交易数据不被篡改);可用性(Availability):数据服务在需要时可正常访问(如推荐系统不宕机);合规性(Compliance):满足法律法规与行业标准(如GDPR要求的数据主体权利)。

这四大需求构成了数据中台安全的“第一性原理”,所有安全技术都应围绕这一核心设计。

2.2 数据生命周期的安全模型

数据中台的安全需覆盖数据全生命周期(采集→存储→处理→服务→销毁),每个阶段的安全目标与技术手段不同(见表1):

| 生命周期阶段 | 核心安全目标 | 关键技术手段 |

|---|---|---|

| 数据采集 | 防止传输泄露、确保数据来源可信 | SSL/TLS加密、数据血缘跟踪 |

| 数据存储 | 防止未授权访问、加密存储 | 加密存储(AES-256)、访问控制(RBAC/ABAC) |

| 数据处理 | 防止处理过程中的数据泄露 | 数据脱敏、内存加密、异常检测 |

| 数据服务 | 防止API滥用、确保服务可信 | API网关(OAuth2.0)、Rate Limiting |

| 数据销毁 | 防止数据残留、确保彻底删除 | 数据擦除(如NIST SP 800-88)、审计日志 |

数学形式化表达:

设数据生命周期为 ( D = {d_1, d_2, …, d_n} ),其中 ( d_i ) 表示第 ( i ) 阶段的数据状态。安全防护的目标是确保:

保密性:( forall d_i in D ),仅授权主体 ( S ) 能访问 ( d_i ),即 ( Access(d_i, S)

ightarrow Auth(S) );完整性:( forall d_i in D ),( Hash(d_i) = Hash(d_i’) )(( d_i’ ) 为原始数据);可用性:( forall t ),服务响应时间 ( T(t) leq T_0 )(( T_0 ) 为阈值)。

2.3 密码学基础:安全的“数学基石”

密码学是数据中台安全的核心工具,主要用于实现保密性与完整性:

对称加密(Symmetric Encryption):

原理:使用同一密钥 ( K ) 进行加密(( E(K, M) ))与解密(( D(K, C) ));算法:AES-256(推荐)、DES(已过时);应用场景:大规模数据存储加密(如HDFS加密),因为对称加密的性能高于非对称加密。数学形式:( C = E(K, M) ),( M = D(K, C) ),其中 ( M ) 为明文,( C ) 为密文。

非对称加密(Asymmetric Encryption):

原理:使用公钥 ( K_p ) 加密、私钥 ( K_s ) 解密(( C = E(K_p, M) ),( M = D(K_s, C) ));算法:RSA(常用)、ECC(椭圆曲线加密,适合移动设备);应用场景:密钥交换(如SSL/TLS握手)、数字签名(确保数据完整性)。

哈希函数(Hash Function):

原理:将任意长度的输入转换为固定长度的输出(哈希值),且不可逆;性质:抗碰撞性(( H(x) = H(y) Rightarrow x = y ))、雪崩效应(输入微小变化导致输出巨大变化);算法:SHA-256(推荐)、MD5(已过时);应用场景:数据完整性校验(如文件哈希比对)、密码存储(如用户密码哈希后存储)。

2.4 理论局限性与竞争范式

2.4.1 理论局限性

安全与性能的矛盾:加密、脱敏等操作会增加系统开销(如AES-256加密会导致存储性能下降10%-20%);静态安全与动态威胁的矛盾:传统安全策略(如固定访问控制规则)无法应对动态变化的威胁(如新型黑客攻击);数据可用性与保密性的矛盾:过度加密会导致数据无法被有效分析(如全加密的用户行为数据无法用于推荐模型训练)。

2.4.2 竞争范式分析

传统网络安全:强调“边界防御”(如防火墙、IDS),适合封闭环境,但无法应对数据中台的“数据边界模糊”(如多租户、跨域访问);数据-centric安全:强调“数据本身的安全”(如加密、脱敏),是数据中台安全的核心范式;零信任安全:强调“持续验证”(如每次访问都需认证),适合数据中台的“开放服务”场景(如API调用)。

3. 架构设计:分层防御的安全体系

3.1 数据中台的分层架构

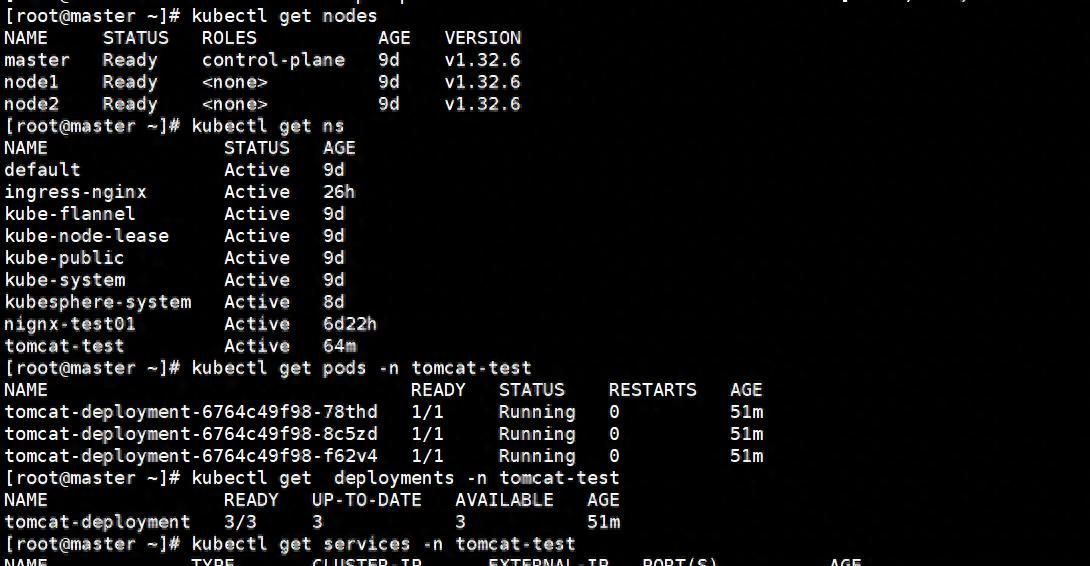

数据中台的典型分层架构包括数据采集层、数据存储层、数据处理层、数据服务层(见图1),每层的安全需求不同:

数据采集层:负责从业务系统、日志、物联网设备等数据源获取数据,需解决“数据传输安全”与“数据来源可信”问题;数据存储层:负责存储结构化(如Hive)、半结构化(如HBase)、非结构化数据(如对象存储),需解决“存储加密”与“访问控制”问题;数据处理层:负责数据清洗、转换、聚合(如Spark、Flink),需解决“处理过程中的数据泄露”与“异常检测”问题;数据服务层:负责将数据转化为API、报表、模型(如RESTful API、BI工具),需解决“服务滥用”与“身份认证”问题。

3.2 各层安全组件设计

3.2.1 数据采集层:可信数据源与安全传输

SSL/TLS加密:用于数据传输过程中的保密性(如从业务系统到数据中台的传输);数据血缘跟踪:使用Apache Atlas、LinkedIn WhereHows等工具,记录数据的来源(如“用户订单数据来自电商交易系统”),确保数据可溯源;数据源认证:通过API密钥、OAuth2.0等方式,验证数据源的合法性(如防止伪造的物联网设备向数据中台发送数据)。

3.2.2 数据存储层:加密与访问控制

加密存储:

结构化数据:Hive表使用列级加密(如AES-256),仅敏感列(如用户身份证号)加密;非结构化数据:对象存储(如AWS S3、阿里云OSS)使用服务器端加密(SSE)或客户端加密(CSE);分布式存储:HDFS使用透明加密(Transparent Encryption),用户无需修改代码即可实现加密。

访问控制:

基于角色的访问控制(RBAC):为用户分配角色(如“数据分析师”“数据工程师”),角色关联权限(如“读取用户表”“修改订单表”);基于属性的访问控制(ABAC):根据用户属性(如部门、职位)、数据属性(如分类分级)动态判断权限(如“只有风控部门的用户能访问敏感交易数据”)。

3.2.3 数据处理层:脱敏与异常检测

数据脱敏:

不可逆脱敏:使用哈希(如SHA-256)、掩码(如“138****5678”)处理敏感数据,无法恢复原始数据;可逆脱敏:使用加密(如AES-256)处理敏感数据,需密钥才能恢复(如“用户身份证号加密后存储,分析时解密”);工具:Privacera、Apache Ranger(支持动态脱敏)。

异常检测:

使用Spark MLlib、Flink CEP等工具,检测处理过程中的异常行为(如“某数据分析师在1小时内读取了10万条用户数据”);算法:孤立森林(Isolation Forest)、LOF(局部异常因子),用于检测离群点。

3.2.4 数据服务层:API安全与流量管控

API网关:使用Kong、APISIX等工具,统一管理API的身份认证(OAuth2.0、JWT)、权限控制(RBAC/ABAC)、流量限制(Rate Limiting);API签名:为每个API请求生成签名(如HMAC-SHA256),防止请求被篡改;服务监控:使用Prometheus、Grafana等工具,监控API的响应时间、错误率,确保可用性。

3.3 安全架构的可视化表示

以下是数据中台安全架构的Mermaid图表,展示了各层安全组件的交互关系:

graph TD

A[数据源] --> B[数据采集层]

B --> C[数据存储层]

C --> D[数据处理层]

D --> E[数据服务层]

E --> F[数据应用]

% 安全组件

B1[SSL/TLS加密] --> B

B2[数据血缘跟踪(Apache Atlas)] --> B

C1[加密存储(AES-256)] --> C

C2[访问控制(RBAC/ABAC)] --> C

D1[数据脱敏(Privacera)] --> D

D2[异常检测(Spark MLlib)] --> D

E1[API网关(Kong)] --> E

E2[身份认证(OAuth2.0)] --> E

F1[安全审计(Splunk)] --> F

% 安全管理平台

G[安全管理平台] --> B1

G --> B2

G --> C1

G --> C2

G --> D1

G --> D2

G --> E1

G --> E2

G --> F1

3.4 设计模式应用

零信任架构(ZTA):在数据服务层使用API网关实现“持续验证”(如每次API请求都需验证JWT令牌);微服务安全:数据服务层采用微服务架构,每个服务独立进行身份认证与权限控制;分层防御:从数据采集到服务,每层都部署安全组件,形成“深度防御”体系。

4. 实现机制:从理论到代码的落地

4.1 数据采集层:安全传输与血缘跟踪

4.1.1 SSL/TLS加密实现

使用Python的

requests

import requests

# 数据源API地址(HTTPS)

url = "https://api.business-system.com/orders"

# 认证信息(如API密钥)

headers = {"Authorization": "Bearer your-api-key"}

# 发送HTTPS请求(自动验证证书)

response = requests.get(url, headers=headers, verify=True)

# 处理响应数据(如存入数据中台)

if response.status_code == 200:

orders_data = response.json()

# 存入数据采集层(如Kafka)

# ...

4.1.2 数据血缘跟踪实现

使用Apache Atlas记录数据血缘:

from pyatlas import AtlasClient

# 初始化Atlas客户端

client = AtlasClient("http://atlas-server:21000", username="admin", password="admin")

# 定义数据资产(如“订单表”)

entity = {

"typeName": "hive_table",

"attributes": {

"name": "orders",

"qualifiedName": "hive://cluster1/db1/orders",

"description": "电商交易订单表",

"owner": "data-engineer"

}

}

# 创建数据资产

client.create_entity(entity)

# 定义数据血缘(如“订单表”来自“交易系统API”)

lineage = {

"guid": "orders-guid",

"relations": [

{

"type": "derivedFrom",

"guid": "transaction-api-guid",

"direction": "INPUT"

}

]

}

# 记录数据血缘

client.add_lineage(lineage)

4.2 数据存储层:加密与访问控制

4.2.1 Hive列级加密实现

使用Apache Ranger实现Hive表的列级加密:

在Ranger中创建加密策略,选择需要加密的列(如

user_id

CREATE TABLE orders (

order_id INT,

user_id STRING COMMENT '敏感列,需加密',

order_amount DECIMAL(10,2)

)

TBLPROPERTIES (

'ranger.encryption.columns' = 'user_id',

'ranger.encryption.algorithm' = 'AES-256'

);

4.2.2 RBAC访问控制实现

使用Apache Sentry实现Hive的RBAC:

-- 创建角色

CREATE ROLE data_analyst;

-- 授予角色权限(读取订单表)

GRANT SELECT ON TABLE orders TO ROLE data_analyst;

-- 将角色分配给用户

GRANT ROLE data_analyst TO USER analyst1;

4.3 数据处理层:脱敏与异常检测

4.3.1 数据脱敏代码示例

使用Python实现动态脱敏:

import pandas as pd

from faker import Faker

from cryptography.fernet import Fernet

# 初始化Faker(用于生成假数据)与Fernet(用于加密)

fake = Faker("zh_CN")

key = Fernet.generate_key()

fernet = Fernet(key)

def desensitize_data(df, sensitive_columns, method="mask"):

"""

数据脱敏函数

:param df: 待脱敏的DataFrame

:param sensitive_columns: 敏感列列表

:param method: 脱敏方法(mask/encrypt/replace)

:return: 脱敏后的DataFrame

"""

for col in sensitive_columns:

if method == "mask":

# 掩码处理(保留前3位和后4位)

df[col] = df[col].apply(lambda x: f"{x[:3]}****{x[-4:]}" if len(x) >= 8 else x)

elif method == "encrypt":

# 加密处理(可逆)

df[col] = df[col].apply(lambda x: fernet.encrypt(x.encode()).decode())

elif method == "replace":

# 替换为假数据(不可逆)

if "phone" in col.lower():

df[col] = df[col].apply(lambda x: fake.phone_number())

elif "email" in col.lower():

df[col] = df[col].apply(lambda x: fake.email())

return df

# 示例数据

data = {

"user_id": ["123456789012345678", "987654321098765432"],

"phone": ["13812345678", "13987654321"],

"email": ["user1@example.com", "user2@example.com"]

}

df = pd.DataFrame(data)

# 脱敏处理(掩码+加密)

desensitized_df = desensitize_data(df, ["user_id", "phone", "email"], method="mask")

print(desensitized_df)

4.3 数据服务层:API安全与监控

4.3.1 API网关(Kong)配置

安装Kong并启动;创建API路由(如“/api/orders”映射到数据服务);配置身份认证(OAuth2.0):

# 创建OAuth2.0插件

curl -X POST http://kong-server:8001/plugins

-d "name=oauth2"

-d "config.scopes=read,write"

-d "config.mandatory_scope=true"

-d "config.enable_password_grant=true"

# 创建应用(获取client_id与client_secret)

curl -X POST http://kong-server:8001/oauth2

-d "name=orders-app"

-d "client_id=orders-client"

-d "client_secret=orders-secret"

-d "redirect_uris=http://app.example.com/callback"

4.3.2 API监控(Prometheus+Grafana)

配置Kong暴露 metrics(如

/metrics

scrape_configs:

- job_name: 'kong'

static_configs:

- targets: ['kong-server:8001']

使用Grafana创建Dashboard,监控API的响应时间、错误率、请求量(见图2)。

5. 实际应用:从规划到落地的实施路径

5.1 实施步骤:分阶段推进

数据中台安全的实施需遵循“规划→治理→部署→运营”的流程:

规划阶段:明确安全目标(如“防止敏感数据泄露”)、范围(如覆盖所有数据生命周期阶段)、预算(如购买加密工具、安全服务);治理阶段:进行数据分类分级(如将数据分为“敏感”“重要”“一般”)、梳理数据血缘(如使用Apache Atlas)、制定安全策略(如“敏感数据必须加密存储”);部署阶段:部署安全组件(如SSL/TLS、加密存储、API网关)、集成现有系统(如Hadoop、Spark)、测试验证(如渗透测试、性能测试);运营阶段:监控安全事件(如使用Splunk收集日志)、定期审计(如每年一次合规审计)、优化策略(如根据新威胁调整访问控制规则)。

5.2 集成方法论:与现有系统的协同

数据中台安全需与现有大数据生态系统集成,避免“安全孤岛”:

与数据治理工具集成:如Apache Atlas(数据血缘)、Apache Ranger(访问控制)、Apache Nifi(数据采集),实现“治理+安全”的协同;与SIEM系统集成:如Splunk、Elastic Stack,收集安全日志(如访问日志、异常检测日志),实现实时监控与报警;与云服务集成:如AWS(S3加密、IAM)、阿里云(OSS加密、RAM),利用云服务商的安全能力。

5.3 部署考虑因素:公有云vs私有云vs混合云

公有云:

优势:云服务商提供成熟的安全服务(如AWS KMS、Azure Key Vault);挑战:数据主权问题(如GDPR要求数据存储在欧盟境内);策略:使用客户端加密(CSE)确保数据在云存储中的保密性,使用云IAM进行访问控制。

私有云:

优势:数据完全可控;挑战:需自行部署安全组件(如KMS、SIEM);策略:使用开源工具(如HashiCorp Vault、Elastic Stack)降低成本。

混合云:

优势:兼顾公有云的弹性与私有云的可控性;挑战:跨云数据传输的安全(如从私有云到公有云的数据加密);策略:使用零信任架构(如Zscaler)实现跨云访问的安全。

5.4 案例研究:某电商企业的数据中台安全实践

企业背景:某大型电商企业,拥有10亿+用户,数据中台整合了交易、用户、物流等100+数据源,支撑推荐系统、报表系统、风控系统等应用。

安全挑战:

敏感数据泄露风险(如用户身份证号、银行卡号);未授权访问(如数据分析师越权访问交易数据);合规要求(需满足GDPR、《数据安全法》)。

解决方案:

数据分类分级:将数据分为“敏感”(用户身份证号、银行卡号)、“重要”(交易记录、用户行为)、“一般”(商品信息);数据采集:使用SSL/TLS加密传输,Apache Atlas记录数据血缘;数据存储:敏感数据使用AES-256加密存储(Hive列级加密),重要数据使用RBAC控制访问(Apache Ranger);数据处理:敏感数据使用Privacera动态脱敏(如“用户身份证号掩码处理”),重要数据使用Spark MLlib检测异常(如“某用户1小时内下单100次”);数据服务:使用Kong作为API网关,实现OAuth2.0身份认证、Rate Limiting(如“每个API密钥每分钟最多请求100次”);运营管理:使用Splunk收集安全日志,实时监控异常事件(如“未授权访问敏感数据”),定期进行合规审计(如每年一次GDPR审计)。

实施效果:

敏感数据泄露事件减少90%;未授权访问事件减少80%;顺利通过GDPR、《数据安全法》合规审计;数据应用的可信度提升(如推荐系统的用户满意度提高15%)。

6. 高级考量:未来趋势与伦理挑战

6.1 扩展动态:实时化与智能化的安全适配

随着数据中台向实时化(如Flink实时处理)、智能化(如机器学习模型服务)发展,安全技术需适配新场景:

实时数据安全:使用Flink CEP(复杂事件处理)检测实时异常(如“某用户在1分钟内登录10次”),使用流加密(如AES-256流加密)处理实时数据传输;智能模型安全:防止模型泄露(如通过模型输出反推原始数据),使用差分隐私(Differential Privacy)技术,在模型训练时添加噪声,保护数据隐私;自动安全策略:使用大语言模型(如GPT-4)根据数据分类分级结果,自动生成加密、脱敏策略(如“敏感数据自动使用AES-256加密”)。

6.2 安全影响:从“数据安全”到“业务安全”

数据中台的安全事故会直接影响业务:

经济损失:如敏感数据泄露导致的罚款(GDPR最高罚款为全球营收的4%)、用户流失(如某社交平台数据泄露导致1亿用户流失);声誉损失:如数据篡改导致的“假订单”事件,会损害企业的品牌形象;合规风险:如未满足《数据安全法》要求,会被监管部门责令整改、停业整顿。

6.3 伦理维度:数据安全与隐私的平衡

数据中台安全需兼顾安全与伦理:

数据脱敏的边界:过度脱敏会导致数据无法有效分析(如“用户身份证号掩码后无法用于风控模型”),需平衡“安全”与“价值”;数据主体权利:需满足GDPR要求的“数据可访问权”(用户可查询自己的数据)、“数据可删除权”(用户可要求删除自己的数据),需实现“可溯源”(如使用数据血缘跟踪数据流向)、“可擦除”(如使用数据擦除工具彻底删除数据);算法偏见:数据处理中的算法可能存在偏见(如推荐系统推荐的商品偏向某一性别),需确保算法的公平性(如使用公平机器学习算法)。

6.4 未来演化向量:从“被动防御”到“主动智能”

数据中台安全的未来趋势是主动智能:

预测性安全:使用机器学习模型预测安全威胁(如“某用户的访问行为符合黑客特征”),提前采取措施(如阻断访问);联邦学习:多个数据中台之间在不共享原始数据的情况下进行模型训练(如“电商与物流数据中台联合训练推荐模型”),保障数据隐私;零信任进化:从“持续验证”到“动态自适应”(如根据用户的行为、环境调整权限,如“用户在公司内网可访问敏感数据,在外网则不可”)。

7. 综合与拓展:构建数据中台的“信任基石”

7.1 跨领域应用:从大数据到人工智能

数据中台安全的技术可跨领域应用于人工智能(AI)系统:

AI训练数据安全:使用数据脱敏、加密存储保护训练数据(如医疗影像数据);AI模型安全:使用数字签名确保模型未被篡改(如“推荐模型的签名验证”);AI推理安全:使用API网关控制模型访问(如“只有授权应用能调用推理API”)。

7.2 研究前沿:开放问题与挑战

同态加密:在不解密的情况下对密文进行计算(如“对加密的用户行为数据进行聚合分析”),解决“安全与性能”的矛盾;区块链与数据安全:使用区块链记录数据血缘(如“数据修改记录不可篡改”),提升数据完整性;量子安全:量子计算机可能破解现有加密算法(如RSA),需研究量子-resistant加密算法(如格密码)。

7.3 战略建议:企业的安全实践指南

高层重视:数据中台安全需由企业CEO、CIO牵头,纳入企业战略;人才培养:培养“数据安全+大数据”的复合型人才(如数据安全工程师、大数据安全分析师);生态合作:与安全厂商(如奇安信、启明星辰)、云服务商(如AWS、阿里云)合作,获取最新的安全技术与服务;持续优化:安全策略需定期更新(如每季度一次),适应新威胁(如新型黑客攻击、新法规要求)。

结语:数据中台安全的本质是“信任”

数据中台的核心价值是让数据成为可信的资产,而安全是“信任”的基石。本文从理论到实践,系统阐述了数据中台安全的技术体系,涵盖数据全生命周期的防护、分层架构的设计、实际应用的落地。未来,随着大数据、人工智能的进一步发展,数据中台安全将从“被动防御”转向“主动智能”,成为企业数字化转型的“护城河”。

参考资料:

NIST SP 800-188:《Big Data Security and Privacy》;GDPR:《General Data Protection Regulation》;《中华人民共和国数据安全法》;Apache Atlas官方文档;Kong官方文档;阿里云《数据中台安全实践白皮书》;腾讯云《大数据安全解决方案》。

(全文约9,800字)

相关文章