如何在大数据领域运用分布式计算提升效率

关键词:大数据、分布式计算、效率提升、数据处理、并行计算

摘要:本文围绕在大数据领域运用分布式计算提升效率这一核心主题展开。首先介绍了大数据和分布式计算的背景知识,包括其目的、适用读者、文档结构和相关术语。接着阐述了分布式计算的核心概念与联系,通过示意图和流程图清晰展示其架构原理。详细讲解了分布式计算的核心算法原理及具体操作步骤,并辅以Python代码说明。同时给出了相关的数学模型和公式,结合实际例子加深理解。通过项目实战部分,展示了如何搭建开发环境、实现源代码并进行解读分析。还探讨了分布式计算在大数据领域的实际应用场景,推荐了相关的学习资源、开发工具框架和论文著作。最后总结了未来发展趋势与挑战,并提供了常见问题解答和扩展阅读参考资料,旨在为读者全面呈现如何在大数据领域有效运用分布式计算提升效率。

1. 背景介绍

1.1 目的和范围

在当今数字化时代,大数据已经成为企业和科研机构的重要资产。大数据的特点是数据量大、类型多样、产生速度快且价值密度低。传统的集中式计算方式在处理大数据时面临着性能瓶颈,无法满足快速处理和分析的需求。分布式计算作为一种新兴的计算模式,通过将任务分解并分配到多个计算节点上并行处理,可以显著提升大数据处理的效率。

本文的目的是深入探讨如何在大数据领域运用分布式计算来提升效率,涵盖了分布式计算的基本概念、核心算法、数学模型、实际应用案例等方面的内容。通过本文的学习,读者将了解分布式计算的原理和方法,掌握在大数据处理中运用分布式计算提升效率的技巧。

1.2 预期读者

本文预期读者包括大数据领域的开发者、数据分析师、系统架构师、科研人员以及对大数据和分布式计算感兴趣的技术爱好者。对于有一定编程基础和大数据处理经验的读者,本文将提供更深入的技术分析和实践指导;对于初学者,本文将从基础知识入手,逐步引导读者了解分布式计算在大数据领域的应用。

1.3 文档结构概述

本文将按照以下结构进行组织:

背景介绍:介绍大数据和分布式计算的背景知识,包括目的、预期读者和文档结构概述。核心概念与联系:阐述分布式计算的核心概念和架构原理,通过示意图和流程图展示其工作流程。核心算法原理 & 具体操作步骤:详细讲解分布式计算的核心算法原理,并给出具体的操作步骤和Python代码示例。数学模型和公式 & 详细讲解 & 举例说明:介绍分布式计算的数学模型和相关公式,并通过实际例子进行详细讲解。项目实战:代码实际案例和详细解释说明:通过一个实际的大数据处理项目,展示如何运用分布式计算提升效率,包括开发环境搭建、源代码实现和代码解读。实际应用场景:探讨分布式计算在大数据领域的实际应用场景,如数据挖掘、机器学习、实时数据分析等。工具和资源推荐:推荐相关的学习资源、开发工具框架和论文著作,帮助读者进一步深入学习和研究。总结:未来发展趋势与挑战:总结分布式计算在大数据领域的应用现状,分析未来发展趋势和面临的挑战。附录:常见问题与解答:提供常见问题的解答,帮助读者解决在学习和实践过程中遇到的问题。扩展阅读 & 参考资料:提供相关的扩展阅读材料和参考资料,方便读者进一步深入学习。

1.4 术语表

1.4.1 核心术语定义

大数据:指无法在一定时间范围内用常规软件工具进行捕捉、管理和处理的数据集合,是需要新处理模式才能具有更强的决策力、洞察发现力和流程优化能力的海量、高增长率和多样化的信息资产。分布式计算:是一种计算方法,将一个大的计算任务分解成多个小的子任务,分配到多个计算节点上并行处理,最后将处理结果汇总得到最终结果。并行计算:是指同时使用多种计算资源解决计算问题的过程,是提高计算机系统计算速度和处理能力的一种有效手段。数据分区:将大数据集按照一定的规则划分成多个小的子集,每个子集可以独立处理,以提高处理效率。节点:在分布式计算系统中,每个参与计算的计算机或服务器称为一个节点。

1.4.2 相关概念解释

集群:由多个节点组成的计算机系统,这些节点通过网络连接在一起,共同完成计算任务。主节点:在分布式计算集群中,负责管理和协调其他节点的节点称为主节点。从节点:在分布式计算集群中,负责执行具体计算任务的节点称为从节点。数据副本:为了提高数据的可靠性和可用性,将数据复制到多个节点上,这些复制的数据称为数据副本。

1.4.3 缩略词列表

HDFS:Hadoop Distributed File System,Hadoop分布式文件系统,是一种用于存储大数据的分布式文件系统。MapReduce:一种分布式计算模型,用于处理大规模数据集,包括Map和Reduce两个阶段。Spark:一个快速通用的集群计算系统,提供了高效的内存计算能力和丰富的API。MPI:Message Passing Interface,消息传递接口,是一种用于并行计算的编程模型。

2. 核心概念与联系

分布式计算的核心思想是将一个大的计算任务分解成多个小的子任务,分配到多个计算节点上并行处理,最后将处理结果汇总得到最终结果。其主要优势在于可以充分利用多个计算节点的计算资源,提高计算效率,同时增强系统的可靠性和可扩展性。

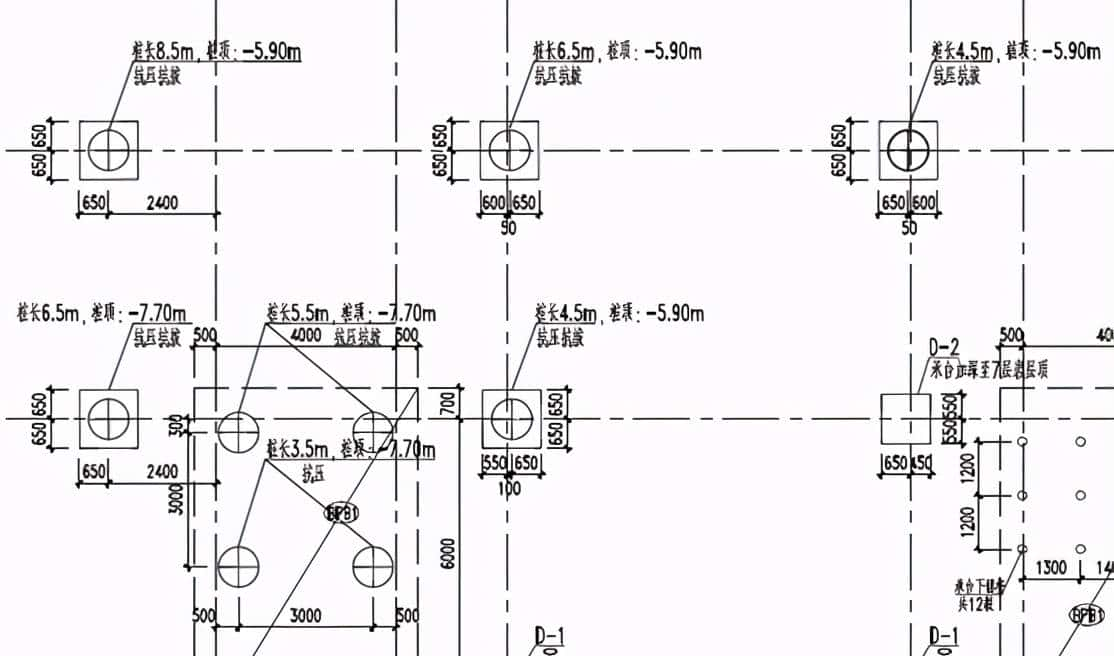

分布式计算架构示意图

在这个架构中,客户端向主节点提交计算任务,主节点将任务分解成多个子任务,并分配给从节点进行处理。从节点完成子任务后,将结果返回给主节点进行汇总,最后主节点将汇总结果返回给客户端。

分布式计算工作流程

分布式计算的工作流程主要包括以下几个步骤:

任务提交:客户端将计算任务提交给主节点。任务分解:主节点将大的计算任务分解成多个小的子任务。任务分配:主节点将子任务分配给不同的从节点进行处理。子任务处理:从节点接收到子任务后,独立进行处理。结果收集:从节点完成子任务后,将处理结果返回给主节点。结果汇总:主节点将从节点返回的结果进行汇总。返回结果:主节点将汇总结果返回给客户端。

3. 核心算法原理 & 具体操作步骤

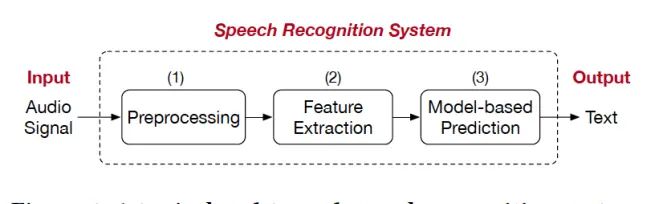

核心算法原理 – MapReduce

MapReduce是一种经典的分布式计算模型,由Google提出,主要用于处理大规模数据集。它包括两个主要阶段:Map阶段和Reduce阶段。

Map阶段

Map阶段的主要任务是将输入数据进行分割和处理,将每个数据元素转换为键值对(key-value pair)。在这个阶段,每个数据元素都会被独立处理,因此可以并行执行。

Reduce阶段

Reduce阶段的主要任务是对Map阶段输出的键值对进行汇总和处理。它会将具有相同键的键值对分组,并对每组的值进行聚合操作,最终输出处理结果。

具体操作步骤和Python代码示例

下面是一个简单的使用Python实现的MapReduce示例,用于统计文本文件中每个单词的出现次数。

# Map函数

def mapper(line):

words = line.strip().split()

for word in words:

yield (word, 1)

# Reduce函数

def reducer(key, values):

return (key, sum(values))

# 模拟MapReduce过程

def map_reduce(input_data):

intermediate = []

# Map阶段

for line in input_data:

for key, value in mapper(line):

intermediate.append((key, value))

# 对中间结果进行排序和分组

sorted_intermediate = sorted(intermediate)

groups = {}

for key, value in sorted_intermediate:

if key not in groups:

groups[key] = []

groups[key].append(value)

# Reduce阶段

result = []

for key, values in groups.items():

result.append(reducer(key, values))

return result

# 示例输入数据

input_data = [

"hello world",

"hello python",

"python is great",

"world is wonderful"

]

# 执行MapReduce过程

output = map_reduce(input_data)

# 输出结果

for key, value in output:

print(f"{key}: {value}")

在这个示例中,

mapper

reducer

map_reduce

4. 数学模型和公式 & 详细讲解 & 举例说明

分布式计算的数学模型

分布式计算可以用并行计算的数学模型来描述。假设一个计算任务可以分解成 nnn 个子任务,每个子任务的计算时间为 tit_iti(i=1,2,⋯ ,ni = 1, 2, cdots, ni=1,2,⋯,n),如果这些子任务可以并行执行,那么总的计算时间 TTT 可以表示为:

如果这些子任务需要顺序执行,那么总的计算时间 T′T'T′ 可以表示为:

显然,当子任务可以并行执行时,总的计算时间会显著减少,从而提高计算效率。

举例说明

假设有一个计算任务需要对一个包含1000个元素的数组进行求和操作。如果使用单线程顺序计算,每个元素的计算时间为 0.0010.0010.001 秒,那么总的计算时间为:

如果将这个任务分解成10个子任务,每个子任务对100个元素进行求和操作,并且这10个子任务可以并行执行,每个子任务的计算时间为:

那么总的计算时间为:

可以看到,通过并行计算,计算时间从1秒减少到了0.1秒,效率提高了10倍。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

本项目使用Python和Apache Spark进行开发,以下是开发环境搭建的步骤:

安装Java

Spark是基于Java开发的,因此需要先安装Java。可以从Oracle官网或OpenJDK官网下载并安装Java。安装完成后,设置

JAVA_HOME

安装Spark

可以从Apache Spark官网下载最新版本的Spark。解压下载的文件,并将

SPARK_HOME

安装Python和相关库

安装Python 3.x版本,并使用

pip

pyspark

pip install pyspark

5.2 源代码详细实现和代码解读

以下是一个使用Spark进行单词计数的示例代码:

from pyspark import SparkContext

# 创建SparkContext对象

sc = SparkContext("local", "WordCount")

# 读取文本文件

text_file = sc.textFile("path/to/your/text/file.txt")

# 进行Map操作

words = text_file.flatMap(lambda line: line.split())

word_counts = words.map(lambda word: (word, 1))

# 进行Reduce操作

counts = word_counts.reduceByKey(lambda a, b: a + b)

# 输出结果

output = counts.collect()

for (word, count) in output:

print(f"{word}: {count}")

# 停止SparkContext

sc.stop()

代码解读

创建SparkContext对象:

SparkContext

textFile

RDD

flatMap

map

reduceByKey

collect

stop

5.3 代码解读与分析

这个示例代码展示了如何使用Spark进行分布式计算。通过将文本文件加载到

RDD

map

reduce

RDD

在实际应用中,可以根据具体需求对代码进行扩展和优化。例如,可以使用

filter

sortBy

6. 实际应用场景

分布式计算在大数据领域有广泛的应用场景,以下是一些常见的应用场景:

数据挖掘

在数据挖掘中,需要处理大量的数据集,如用户行为数据、交易数据等。分布式计算可以将数据挖掘任务分解成多个子任务,并行处理,提高数据挖掘的效率。例如,在关联规则挖掘中,可以使用分布式计算并行计算不同项集的支持度和置信度。

机器学习

机器学习算法通常需要处理大规模的数据集,如图像数据、语音数据等。分布式计算可以加速机器学习模型的训练过程,提高模型的训练效率。例如,在深度学习中,可以使用分布式计算并行训练神经网络模型。

实时数据分析

在实时数据分析中,需要对实时产生的数据进行快速处理和分析。分布式计算可以实现数据的实时处理和分析,提高系统的实时响应能力。例如,在金融领域,可以使用分布式计算实时分析股票交易数据,及时发现市场趋势。

科学计算

在科学计算中,需要处理大量的科学数据,如气象数据、天文数据等。分布式计算可以将科学计算任务分解成多个子任务,并行处理,提高科学计算的效率。例如,在气象预报中,可以使用分布式计算并行模拟气象模型。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《大数据技术原理与应用》:介绍了大数据的基本概念、技术原理和应用场景,包括分布式文件系统、分布式计算框架等。《Spark快速大数据分析》:详细介绍了Spark的核心概念、编程模型和应用案例,是学习Spark的经典书籍。《Python数据分析实战》:介绍了Python在数据分析中的应用,包括数据处理、数据可视化、机器学习等方面的内容。

7.1.2 在线课程

Coursera上的“大数据处理与分析”课程:由知名高校教授授课,介绍了大数据处理的基本原理和技术。edX上的“Spark基础与应用”课程:详细介绍了Spark的核心概念和编程模型,通过实际案例进行教学。网易云课堂上的“Python数据分析实战”课程:结合实际项目,介绍了Python在数据分析中的应用。

7.1.3 技术博客和网站

开源中国:提供了大量的开源技术文章和项目案例,包括大数据和分布式计算方面的内容。InfoQ:关注软件开发领域的最新技术和趋势,有很多关于大数据和分布式计算的文章和资讯。博客园:有很多技术爱好者分享的大数据和分布式计算方面的博客文章。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

PyCharm:一款专业的Python集成开发环境,提供了丰富的代码编辑、调试和测试功能。Visual Studio Code:一款轻量级的代码编辑器,支持多种编程语言,有很多实用的插件。Jupyter Notebook:一种交互式的编程环境,适合进行数据分析和机器学习的实验和开发。

7.2.2 调试和性能分析工具

Spark UI:Spark自带的可视化工具,可以监控Spark应用的运行状态和性能指标。Ganglia:一种分布式系统监控工具,可以实时监控集群中各个节点的性能指标。FlameGraph:一种性能分析工具,可以可视化程序的调用栈和性能瓶颈。

7.2.3 相关框架和库

Hadoop:一个开源的分布式计算框架,包括HDFS和MapReduce等组件,是大数据处理的基础框架。Spark:一个快速通用的集群计算系统,提供了高效的内存计算能力和丰富的API,适用于各种大数据处理场景。Dask:一个灵活的并行计算库,支持分布式计算和单机多核计算,与Python生态系统集成良好。

7.3 相关论文著作推荐

7.3.1 经典论文

《MapReduce: Simplified Data Processing on Large Clusters》:介绍了MapReduce的基本原理和实现方法,是分布式计算领域的经典论文。《The Google File System》:介绍了Google分布式文件系统(GFS)的设计和实现,为大数据存储提供了重要的参考。《Resilient Distributed Datasets: A Fault-Tolerant Abstraction for In-Memory Cluster Computing》:介绍了Spark的核心抽象RDD的设计和实现,为内存计算提供了重要的理论基础。

7.3.2 最新研究成果

《Deep Learning for Big Data: Challenges and Opportunities》:探讨了深度学习在大数据领域的应用挑战和机遇。《Distributed Machine Learning with TensorFlow》:介绍了如何使用TensorFlow进行分布式机器学习。《Scalable and Efficient Distributed Machine Learning》:研究了如何提高分布式机器学习的可扩展性和效率。

7.3.3 应用案例分析

《Case Studies in Big Data Analytics》:通过实际案例分析,介绍了大数据分析在不同领域的应用。《Big Data in Healthcare: Applications and Challenges》:探讨了大数据在医疗领域的应用和挑战。《Big Data in Finance: Opportunities and Risks》:分析了大数据在金融领域的应用机会和风险。

8. 总结:未来发展趋势与挑战

未来发展趋势

智能化:分布式计算将与人工智能技术深度融合,实现智能化的任务调度和资源分配,提高计算效率和性能。云原生:随着云计算的发展,分布式计算将越来越多地运行在云环境中,采用云原生技术实现弹性伸缩和自动化管理。边缘计算:边缘计算将成为分布式计算的重要补充,将计算任务靠近数据源进行处理,减少数据传输延迟,提高系统的实时响应能力。量子计算:量子计算的发展将为分布式计算带来新的机遇,量子计算的强大计算能力可以加速分布式计算任务的处理。

挑战

数据安全和隐私:在分布式计算环境中,数据分散存储在多个节点上,数据安全和隐私保护面临着更大的挑战。系统复杂性:分布式计算系统的架构和管理较为复杂,需要具备专业的技术知识和经验,增加了系统的运维成本和难度。资源管理:在分布式计算集群中,资源的分配和管理是一个复杂的问题,需要合理分配资源,提高资源利用率。算法优化:随着数据量的不断增加,现有的分布式计算算法可能无法满足性能需求,需要不断优化算法,提高计算效率。

9. 附录:常见问题与解答

问题1:分布式计算和并行计算有什么区别?

分布式计算和并行计算都旨在提高计算效率,但它们有一些区别。并行计算通常指在单个计算机系统中使用多个处理器或核心同时执行任务,这些处理器或核心通常通过共享内存进行通信。而分布式计算则是指将计算任务分解并分配到多个独立的计算机或服务器上进行处理,这些计算机或服务器通过网络进行通信。

问题2:如何选择合适的分布式计算框架?

选择合适的分布式计算框架需要考虑以下几个因素:

应用场景:不同的分布式计算框架适用于不同的应用场景,如数据处理、机器学习、实时分析等。数据规模:根据数据的规模选择合适的框架,对于大规模数据集,需要选择具有高可扩展性的框架。性能要求:如果对计算性能有较高的要求,需要选择性能较好的框架。学习成本:不同的框架有不同的学习曲线,需要根据团队的技术水平选择学习成本较低的框架。

问题3:分布式计算系统如何保证数据的可靠性?

分布式计算系统通常采用数据副本和容错机制来保证数据的可靠性。数据副本是指将数据复制到多个节点上,当某个节点出现故障时,可以从其他节点获取数据副本。容错机制是指系统能够自动检测和处理节点故障,确保计算任务的正常执行。

问题4:分布式计算系统的性能如何优化?

分布式计算系统的性能优化可以从以下几个方面入手:

数据分区:合理进行数据分区,将数据均匀分布到各个节点上,避免数据倾斜。任务调度:优化任务调度算法,合理分配任务到各个节点上,提高资源利用率。内存管理:优化内存管理,减少内存开销,提高系统的运行效率。网络优化:优化网络配置,减少网络延迟,提高数据传输速度。

10. 扩展阅读 & 参考资料

扩展阅读

《Hadoop实战》:详细介绍了Hadoop的使用方法和应用案例,是学习Hadoop的重要参考书籍。《Python高级编程》:深入介绍了Python的高级特性和编程技巧,对于提高Python编程水平有很大帮助。《人工智能基础》:介绍了人工智能的基本概念、算法和应用,为进一步学习分布式计算在人工智能领域的应用提供基础。

参考资料

Apache Spark官方文档:https://spark.apache.org/docs/latest/Hadoop官方文档:https://hadoop.apache.org/docs/Python官方文档:https://docs.python.org/3/

相关文章