大数据驱动的社交网络分析:构建全面评估体系的理论与实践

副标题:从指标设计到实时监控,掌握社交网络分析评估的全流程优化

摘要/引言

在当今数字化时代,社交网络已成为信息传播、人际交往和商业活动的核心平台。无论是微博上的热点话题、Twitter上的政治讨论,还是LinkedIn上的职业网络,社交网络都在深刻影响着个人行为和社会动态。社交网络分析(Social Network Analysis, SNA)作为理解这些复杂系统的关键工具,其评估体系的完善与否直接决定了分析结果的可靠性和应用价值。

问题陈述:传统社交网络分析评估体系往往局限于静态、单一维度的指标(如粉丝数、互动率),难以捕捉网络的动态演化、群体行为模式和隐藏的影响力关系。随着社交数据量的爆炸式增长(据Statista预测,2025年全球社交媒体用户将突破50亿),传统方法在处理海量、多源、异构数据时显得力不从心,导致评估结果滞后、片面,甚至误导决策。

核心方案:本文提出一种基于大数据技术的社交网络分析评估体系,通过整合分布式计算、实时流处理、机器学习和图算法,构建”数据-指标-模型-应用”四层评估框架。该体系不仅能够处理PB级社交数据,还能从结构、内容、行为和影响力四个维度提供全面、动态、多尺度的评估结果。

主要成果/价值:通过本文,读者将获得:

设计多维度社交网络评估指标体系的方法论利用大数据技术(Spark、Flink、图计算)处理社交网络数据的实战经验构建实时社交网络监控与评估平台的完整技术路线解决社交网络分析中数据稀疏性、动态性和异构性挑战的具体方案10+可直接复用的核心算法实现代码(包含图神经网络模型、社区发现算法等)

文章导览:本文首先阐述社交网络分析评估的现状与挑战,随后深入讲解核心概念与理论基础,接着通过详细的环境配置和分步实现指南,带领读者构建一个完整的大数据社交网络评估系统。我们还将探讨性能优化策略、常见问题解决方案,并展望该领域的未来发展方向。无论你是数据分析师、社交平台工程师,还是研究人员,本文都将为你提供系统性的知识和实用工具。

目标读者与前置知识

目标读者:

具备1-3年经验的数据分析/数据科学从业者,希望提升社交网络分析能力社交平台或相关企业的产品/运营人员,需要构建数据驱动的评估体系对社交网络分析感兴趣的研究生或研究人员,寻求工程化实现方案负责社交媒体营销或舆情监控的从业者,需要更精准的评估工具

前置知识要求:

基础编程能力:熟悉Python语法,能够阅读和编写中等复杂度代码数据处理基础:了解Pandas、NumPy等数据处理库的基本操作统计学常识:理解基本统计概念(均值、方差、相关性等)社交网络基础:了解社交网络的基本概念(节点、边、度、中心性等)大数据概念:对分布式计算、并行处理有初步了解(无需深入经验)机器学习基础:了解常见机器学习算法的基本原理(如分类、聚类)

如果你不完全满足上述要求,不必担心。本文会尽量解释关键概念,并提供补充学习资源链接。对于涉及的复杂算法,我们会侧重其应用而非理论推导,确保不同背景的读者都能有所收获。

文章目录

引言与基础

引人注目的标题摘要/引言目标读者与前置知识文章目录

核心内容

问题背景与动机核心概念与理论基础环境准备分步实现关键代码解析与深度剖析

验证与扩展

结果展示与验证性能优化与最佳实践常见问题与解决方案未来展望与扩展方向

总结与附录

总结参考资料附录

一、问题背景与动机

1.1 社交网络分析的重要性与挑战

社交网络分析已经从学术研究走向产业应用的前沿阵地。根据Gartner 2023年报告,全球85%的大型企业正在使用或计划使用社交网络分析来支持商业决策。这些应用场景广泛且深入:

市场营销:识别意见领袖,评估营销活动影响力,预测产品传播路径舆情监控:实时追踪公众对品牌、事件或政策的态度变化公共安全:识别潜在的极端主义传播网络,预测和防范群体性事件社交平台优化:提升用户体验,优化内容推荐,减少信息茧房效应学术研究:理解信息传播机制,探索社会网络结构对人类行为的影响

然而,社交网络的快速发展也带来了前所未有的分析挑战:

规模爆炸:单个主流社交平台的日活用户可达数亿,产生海量交互数据动态演化:社交关系和用户行为具有高度动态性,网络结构不断变化数据异构:文本、图像、视频、地理位置等多模态数据并存噪声干扰:机器人账号、虚假信息、恶意营销等噪声数据充斥网络隐私保护:日益严格的数据隐私法规限制了数据收集和使用范围

1.2 传统社交网络评估体系的局限性

传统社交网络评估方法在面对上述挑战时,暴露出明显的局限性:

1.2.1 指标维度单一,难以全面刻画网络特性

传统评估过度依赖少数几个简单指标:

粉丝数/关注数:仅反映节点规模,无法衡量互动质量和影响力互动率:评论、点赞等表面互动数据易被操纵(如购买水军)中心性指标:度中心性、介数中心性等静态指标难以捕捉动态变化

案例:某品牌社交媒体账号拥有100万粉丝,但互动率仅为0.1%,远低于行业平均水平。传统评估会认为这是一个有影响力的账号,而实际上可能存在大量僵尸粉或不活跃粉丝。

1.2.2 数据处理能力有限,难以应对大规模数据

传统方法通常基于单机处理,面对以下数据规模时力不从心:

数据量:单日内Twitter产生约5亿条推文,Facebook处理约10亿条消息数据速率:热门事件发生时,相关数据可能以每秒数十万条的速度涌现数据多样性:文本、图像、视频、音频等多模态数据需要不同处理方法

1.2.3 静态分析为主,缺乏实时性和预测能力

大多数传统分析是事后分析,无法满足实时决策需求:

延迟响应:从数据收集到分析结果产出可能需要数小时甚至数天被动应对:只能对已发生的事件进行分析,无法主动预测趋势变化固定周期:通常按日或周生成报告,难以捕捉突发的网络舆情变化

1.2.4 评估模型简单,难以挖掘深层网络结构

传统方法多采用简单统计或规则引擎:

缺乏上下文理解:难以理解文本内容的语义和情感倾向忽略网络动态:将网络视为静态结构,忽视节点和边的演化过程同质化处理:对不同类型的节点和关系采用相同的分析方法

1.3 大数据技术带来的变革机遇

大数据技术的成熟为解决上述挑战提供了新的可能:

1.3.1 海量数据处理能力

分布式存储:Hadoop HDFS等分布式文件系统可存储PB级数据并行计算框架:Spark、Flink等可实现数千节点的并行数据处理列式存储:HBase、Cassandra等NoSQL数据库优化了大规模数据查询

1.3.2 实时流处理能力

流处理引擎:Flink、Spark Streaming支持毫秒级到秒级的实时数据处理复杂事件处理:可实时检测社交网络中的异常模式和重要事件实时分析仪表盘:支持决策者实时掌握社交网络动态

1.3.3 高级分析算法

机器学习:可从海量数据中自动发现模式,预测用户行为深度学习:特别是图神经网络(GNN),能有效处理网络结构数据自然语言处理:理解文本内容,提取情感、主题和实体关系

1.3.4 多源数据融合

数据集成技术:可整合来自不同社交平台、不同类型的异构数据关联分析:发现原本孤立数据之间的隐藏联系知识图谱:构建实体和关系网络,增强语义理解能力

1.4 完善社交网络分析评估体系的必要性

在大数据时代,完善社交网络分析评估体系已成为必然需求:

商业竞争需求:精准的社交网络评估能带来竞争优势,指导产品优化和营销策略风险管理需求:实时准确的评估有助于及时发现和应对舆情危机用户体验需求:深入理解社交网络结构有助于提供更个性化的用户体验科学研究需求:更全面的评估体系推动社交网络科学理论的发展

本文将系统阐述如何利用大数据技术构建一个全面、动态、实时的社交网络分析评估体系,克服传统方法的局限性,为社交网络分析提供新的思路和工具。

二、核心概念与理论基础

2.1 社交网络分析基础

2.1.1 社交网络的定义与表示

社交网络(Social Network) 是由个体(或组织)及其之间的社会关系构成的结构。在数学上,社交网络通常表示为图(Graph):

节点(Node):代表网络中的个体、组织或实体边(Edge):代表节点之间的关系或交互属性(Attribute):节点或边所携带的信息(如用户资料、交互时间)

图的类型:

有向图(Directed Graph):边具有方向,表示单向关系(如Twitter的关注关系)无向图(Undirected Graph):边无方向,表示双向关系(如Facebook的好友关系)加权图(Weighted Graph):边具有权重,表示关系强度(如互动频率)动态图(Dynamic Graph):节点或边随时间变化的图(如随时间变化的社交关系)

数学表示:图G可以表示为G=(V,E),其中V是节点集合,E是边集合。对于加权有向图,可以用邻接矩阵(Adjacency Matrix) A表示,其中A[i][j]表示从节点i到节点j的边的权重。

2.1.2 基本网络拓扑结构

社交网络常见的拓扑结构特征:

小世界现象(Small World Phenomenon):大多数节点之间可以通过短路径连接(六度分离理论)无标度特性(Scale-Free Property):节点度分布遵循幂律分布,存在少量高连接度节点社区结构(Community Structure):网络中存在节点密集连接的子群体,群体间连接相对稀疏核心-边缘结构(Core-Periphery Structure):核心节点高度互联,边缘节点主要与核心节点连接

理解这些结构特征对于设计有效的评估指标至关重要,因为它们反映了社交网络的内在组织规律。

2.2 社交网络评估的核心维度

一个全面的社交网络评估体系应包含以下核心维度:

2.2.1 结构维度(Structural Dimension)

关注网络的拓扑结构特征和节点在结构中的位置:

节点中心性(Node Centrality):

度中心性(Degree Centrality):节点直接连接的数量介数中心性(Betweenness Centrality):节点作为其他节点间最短路径桥梁的程度接近中心性(Closeness Centrality):节点到其他所有节点的平均距离特征向量中心性(Eigenvector Centrality):考虑连接节点的重要性(如PageRank算法)

网络凝聚性(Network Cohesion):

密度(Density):实际边数与可能边数的比例聚类系数(Clustering Coefficient):节点邻居之间实际连接的比例连通分量(Connected Components):网络中相互连接的子图

社区结构(Community Structure):

模块度(Modularity):衡量社区划分质量的指标社区规模分布:不同大小社区的分布情况社区间连接:社区之间的连接密度和强度

2.2.2 内容维度(Content Dimension)

关注社交网络中传播的信息内容特征:

主题分布(Topic Distribution):内容主题的种类和比例情感倾向(Sentiment Orientation):内容表达的情感极性(积极、消极、中性)信息新颖性(Information Novelty):内容的原创性和新颖程度内容质量(Content Quality):内容的专业性、准确性和可信度语义相似度(Semantic Similarity):不同内容之间的语义关联程度

2.2.3 行为维度(Behavioral Dimension)

关注用户在社交网络中的活动模式:

活跃度(Activity Level):用户参与社交互动的频率和强度互动模式(Interaction Pattern):用户之间互动的类型和频率分布行为一致性(Behavioral Consistency):用户行为随时间的稳定性信息传播行为(Information Diffusion Behavior):用户转发、分享信息的模式响应时间(Response Time):用户对社交刺激的平均响应速度

2.2.4 影响力维度(Influence Dimension)

关注节点影响其他节点的能力:

影响力范围(Influence Scope):能够影响的节点数量影响力深度(Influence Depth):影响的强度和持久性信息扩散能力(Information Diffusion Capacity):发起信息传播的能力观点领导力(Opinion Leadership):引领群体观点的能力行为改变能力(Behavioral Change Capacity):影响他人行为的能力

2.2.5 演化维度(Evolutionary Dimension)

关注社交网络随时间的动态变化:

网络增长速度(Network Growth Rate):节点和边的增加速率结构稳定性(Structural Stability):网络结构随时间的变化程度趋势形成与消退(Trend Formation and Decline):热门话题的生命周期关系演化(Relationship Evolution):社交关系的形成、强化和消失影响力转移(Influence Shift):节点影响力的动态变化

2.3 大数据技术在社交网络分析中的应用框架

2.3.1 数据层(Data Layer)

数据采集:

API接入:社交平台开放API(如Twitter API、Facebook Graph API)网络爬虫:针对无API或API限制严格的平台传感器数据:移动端或可穿戴设备收集的地理位置等数据日志收集:服务器日志、应用日志等

数据存储:

关系型数据库:MySQL、PostgreSQL等,存储结构化数据NoSQL数据库:MongoDB、Cassandra等,存储非结构化/半结构化数据分布式文件系统:HDFS、S3等,存储海量原始数据图数据库:Neo4j、JanusGraph等,优化图结构数据存储和查询

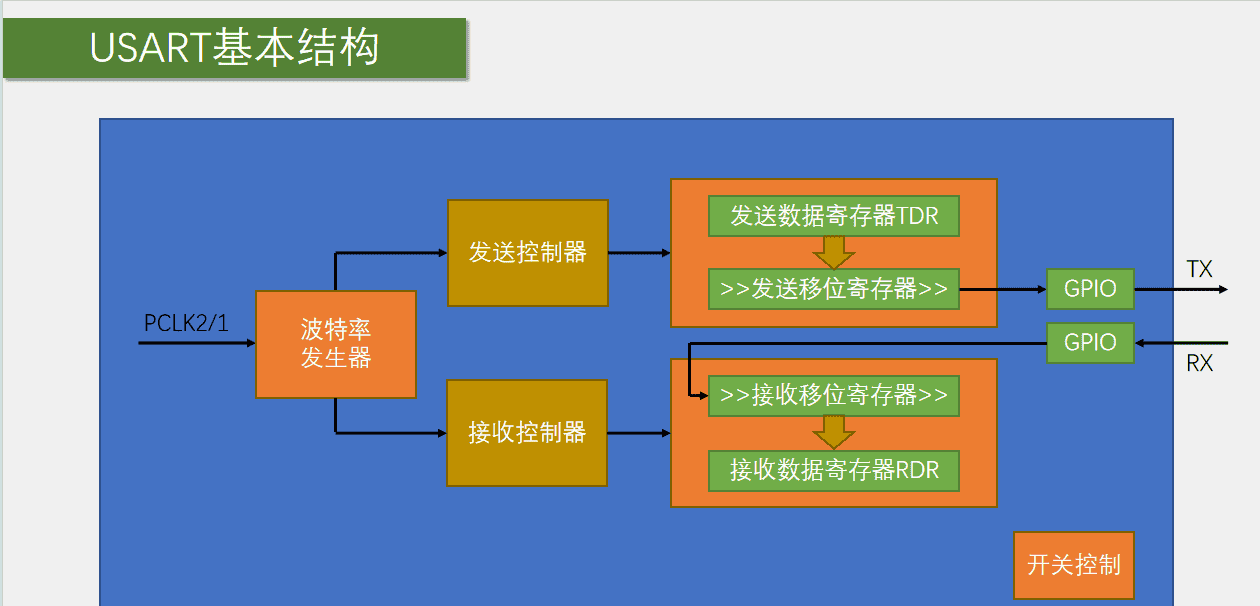

2.3.2 处理层(Processing Layer)

批处理:

Apache Hadoop MapReduce:传统分布式批处理框架Apache Spark:内存计算框架,提供更高性能Apache Flink Batch:支持批处理的流处理框架

流处理:

Apache Flink:低延迟、高吞吐的流处理框架Apache Kafka Streams:基于Kafka的流处理库Apache Spark Streaming:微批处理流处理框架

图处理:

Apache Giraph:基于MapReduce的图处理框架Apache GraphX:Spark生态系统中的图处理APINeo4j:兼具存储和处理能力的图数据库

2.3.3 分析层(Analytics Layer)

描述性分析(Descriptive Analytics):

统计分析:均值、方差、分布等基本统计量数据聚合:按时间、类别等维度聚合数据基本可视化:图表展示网络结构和指标

诊断性分析(Diagnostic Analytics):

相关性分析:变量间关系分析异常检测:识别异常节点、边或行为根因分析:探究现象背后的原因

预测性分析(Predictive Analytics):

分类与回归:预测节点属性或边的形成时间序列预测:预测网络指标的未来趋势推荐系统:预测潜在的社交连接

处方性分析(Prescriptive Analytics):

优化算法:优化网络结构或资源分配A/B测试:评估不同干预策略的效果模拟与决策支持:提供最佳行动建议

2.3.4 应用层(Application Layer)

可视化仪表盘:实时展示关键评估指标告警系统:异常情况自动告警决策支持系统:提供基于数据的决策建议API服务:将分析能力以API形式提供给其他系统

2.4 评估体系构建的理论基础

2.4.1 复杂网络理论(Complex Networks Theory)

复杂网络理论为理解社交网络的结构特性提供了理论框架:

随机图理论(Random Graph Theory):Erdős-Rényi模型等,解释网络的基本统计特性小世界模型(Small-World Model):Watts-Strogatz模型,解释网络的高聚类性和短路径特性无标度网络模型(Scale-Free Network Model):Barabási-Albert模型,解释幂律度分布的形成机制渗流理论(Percolation Theory):研究网络连通性的相变特性

2.4.2 社会资本理论(Social Capital Theory)

社会资本理论关注网络资源的获取和利用:

结构型社会资本:网络的结构特征,如密度、中心性等关系型社会资本:基于信任、规范等关系特征的资源认知型社会资本:共享的价值观、语言和理解

2.4.3 传播理论(Diffusion Theory)

传播理论解释信息和影响力在网络中的传播机制:

创新扩散理论(Diffusion of Innovations):创新从产生到普及的过程阈值模型(Threshold Models):个体采纳新观点或行为的阈值传染病模型(Epidemic Models):SIR、SIS等模型,模拟信息像疾病一样传播复杂传播模型(Complex Contagion Models):考虑社会强化效应的传播模型

2.4.4 计量经济学与统计学(Econometrics & Statistics)

提供评估指标的统计推断和因果分析方法:

回归分析:探究变量间的关系因果推断:区分相关性和因果关系面板数据分析:处理时间序列和截面数据结合的面板数据结构方程模型:同时分析多个依赖关系

理解这些理论基础有助于我们设计更科学、更有效的评估指标和模型,避免仅凭经验或直觉做出评估决策。

三、环境准备

3.1 开发环境配置

为了确保你能够顺利复现本文的所有实验和代码,我们需要搭建一个统一的开发环境。以下是详细的环境配置步骤:

3.1.1 操作系统要求

推荐使用以下操作系统:

Linux:Ubuntu 20.04 LTS 或更高版本(推荐)macOS:macOS 10.15 (Catalina) 或更高版本Windows:Windows 10/11,建议配合WSL2使用

Linux系统在大数据工具支持方面最为完善,本文将以Ubuntu 20.04为例进行演示。如果你使用其他操作系统,大部分步骤仍然适用,但可能需要调整部分命令。

3.1.2 硬件要求

进行社交网络分析,尤其是处理大规模图数据时,对硬件有一定要求:

CPU:至少4核,推荐8核或更高内存:至少16GB RAM,推荐32GB或更高(处理大规模图数据时尤为重要)硬盘:至少100GB可用空间,推荐SSD(加快数据读写速度)网络:稳定的互联网连接(用于下载依赖包和示例数据)

3.1.3 Python环境配置

我们将使用Python作为主要编程语言,推荐使用Python 3.8或更高版本。

使用Anaconda创建虚拟环境(推荐)

Anaconda可以方便地管理Python环境和依赖包:

# 下载并安装Anaconda(如果尚未安装)

wget https://repo.anaconda.com/archive/Anaconda3-2023.03-Linux-x86_64.sh

bash Anaconda3-2023.03-Linux-x86_64.sh

# 创建并激活虚拟环境

conda create -n sna-bigdata python=3.9 -y

conda activate sna-bigdata

或使用venv创建虚拟环境

如果你偏好使用Python内置的venv:

# 确保已安装Python 3.8+和venv

sudo apt update

sudo apt install python3 python3-venv python3-pip -y

# 创建并激活虚拟环境

python3 -m venv sna-bigdata

source sna-bigdata/bin/activate # Linux/macOS

# sna-bigdataScriptsactivate # Windows

3.1.4 核心依赖包安装

使用以下命令安装本文所需的核心Python依赖包:

# 基础数据处理库

pip install numpy==1.23.5 pandas==1.5.3 matplotlib==3.7.1 seaborn==0.12.2

# 网络分析库

pip install networkx==3.0 scipy==1.10.1 python-louvain==0.16

# 图计算库

pip install igraph==0.10.4 leidenalg==0.9.1

# 机器学习库

pip install scikit-learn==1.2.2 xgboost==1.7.5 lightgbm==3.3.5

# 深度学习库(用于图神经网络)

pip install torch==1.13.1 torch-geometric==2.3.0

# 大数据处理库

pip install pyspark==3.3.2 findspark==2.0.1

# 数据可视化库

pip install plotly==5.13.1 pyvis==0.3.1 kaleido==0.2.1

# 网络爬虫库(用于数据采集示例)

pip install requests==2.28.2 beautifulsoup4==4.12.2 scrapy==2.9.0

# 其他工具

pip install tqdm==4.65.0 python-dotenv==1.0.0 jupyterlab==3.6.3

3.1.5 大数据工具安装

为了处理大规模社交网络数据,我们需要安装以下大数据工具:

Apache Spark安装

Spark是我们进行大规模数据处理的核心框架:

# 下载并解压Spark

wget https://dlcdn.apache.org/spark/spark-3.3.2/spark-3.3.2-bin-hadoop3.tgz

tar xzf spark-3.3.2-bin-hadoop3.tgz

sudo mv spark-3.3.2-bin-hadoop3 /opt/spark

# 设置环境变量

echo "export SPARK_HOME=/opt/spark" >> ~/.bashrc

echo "export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin" >> ~/.bashrc

echo "export PYSPARK_PYTHON=$(which python)" >> ~/.bashrc

source ~/.bashrc

# 启动Spark Shell测试安装

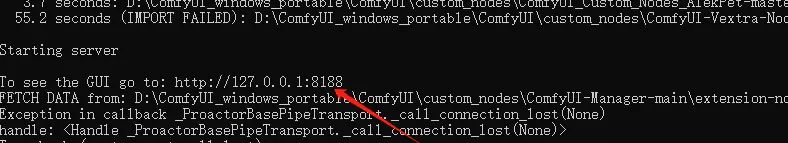

pyspark

成功启动后,你应该能看到Spark的Logo和Python交互式界面。输入

exit()

Apache Kafka安装(用于流数据处理)

Kafka用于处理社交网络实时数据流:

# 安装Java(Kafka依赖Java)

sudo apt install openjdk-11-jdk -y

echo "export JAVA_HOME=/usr/lib/jvm/java-11-openjdk-amd64" >> ~/.bashrc

source ~/.bashrc

# 下载并安装Kafka

wget https://dlcdn.apache.org/kafka/3.4.0/kafka_2.13-3.4.0.tgz

tar xzf kafka_2.13-3.4.0.tgz

sudo mv kafka_2.13-3.4.0 /opt/kafka

# 设置环境变量

echo "export KAFKA_HOME=/opt/kafka" >> ~/.bashrc

echo "export PATH=$PATH:$KAFKA_HOME/bin" >> ~/.bashrc

source ~/.bashrc

3.2 开发工具推荐

3.2.1 代码编辑器/IDE

推荐使用以下工具之一进行代码开发:

Visual Studio Code:轻量级但功能强大的编辑器,配合Python插件效果出色

# Ubuntu安装VS Code

wget -qO- https://packages.microsoft.com/keys/microsoft.asc | gpg --dearmor > packages.microsoft.gpg

sudo install -D -o root -g root -m 644 packages.microsoft.gpg /etc/apt/keyrings/packages.microsoft.gpg

echo "deb [arch=amd64,arm64,armhf signed-by=/etc/apt/keyrings/packages.microsoft.gpg] https://packages.microsoft.com/repos/code stable main" | sudo tee /etc/apt/sources.list.d/vscode.list > /dev/null

rm -f packages.microsoft.gpg

sudo apt update

sudo apt install code -y

PyCharm:专业的Python IDE,提供强大的数据分析支持

社区版(免费):功能足够完成本文大部分任务专业版(付费):提供更多高级功能

3.2.2 Jupyter Notebook/Lab

Jupyter是数据分析的强大工具,我们已经通过pip安装了Jupyter Lab:

# 启动Jupyter Lab

jupyter lab

3.2.3 版本控制工具

使用Git进行版本控制:

# 安装Git

sudo apt install git -y

# 配置Git

git config --global user.name "Your Name"

git config --global user.email "your.email@example.com"

3.3 示例数据集准备

为了方便实践,我们将使用几个公开的社交网络数据集:

3.3.1 下载示例数据集

# 创建数据目录

mkdir -p data/social_networks

cd data/social_networks

# 下载Facebook社交网络数据集

wget https://snap.stanford.edu/data/facebook_combined.txt.gz

gunzip facebook_combined.txt.gz

# 下载Twitter社交网络数据集(较小规模)

wget https://snap.stanford.edu/data/ego-Twitter.txt.gz

gunzip ego-Twitter.txt.gz

# 下载网络论坛用户交互数据集

wget https://snap.stanford.edu/data/soc-sign-bitcoinotc.csv.gz

gunzip soc-sign-bitcoinotc.csv.gz

# 返回项目根目录

cd ../..

3.3.2 数据集介绍

Facebook社交网络数据集 (

facebook_combined.txt

描述:Facebook用户之间的友谊网络规模:4,039个节点,88,234条边格式:无向无权图,每行两个整数表示一条边

Twitter社交网络数据集 (

ego-Twitter.txt

描述:Twitter用户关注网络规模:81,306个节点,1,768,149条边格式:有向无权图,每行两个整数表示一条有向边

比特币OTC交易信任网络 (

soc-sign-bitcoinotc.csv

描述:比特币OTC交易平台用户之间的信任评分网络规模:5,881个节点,35,592条边格式:有向加权图,每行包含源节点、目标节点、权重和时间戳

这些数据集来自斯坦福大学网络分析项目(SNAP),是社交网络分析领域的常用基准数据集。

3.3.3 数据目录结构

建议按照以下目录结构组织项目文件:

social-network-analysis/

├── data/ # 数据目录

│ ├── raw/ # 原始数据

│ ├── processed/ # 处理后的数据

│ └── social_networks/ # 下载的社交网络数据集

├── notebooks/ # Jupyter notebooks

│ ├── 01_data_exploration.ipynb

│ ├── 02_network_analysis.ipynb

│ └── 03_evaluation_system.ipynb

├── src/ # 源代码

│ ├── data/ # 数据处理脚本

│ ├── features/ # 特征工程脚本

│ ├── models/ # 模型训练和评估脚本

│ └── visualization/ # 可视化脚本

├── tests/ # 测试代码

├── requirements.txt # 项目依赖

└── README.md # 项目说明

创建上述目录结构:

mkdir -p social-network-analysis/{data/{raw,processed,social_networks},notebooks,src/{data,features,models,visualization},tests}

cd social-network-analysis

# 将之前下载的数据集移动到相应目录

mv ../data/social_networks/* data/social_networks/

3.4 环境验证

为确保环境配置正确,让我们运行一个简单的验证脚本:

创建

src/validation/validate_environment.py

import numpy as np

import pandas as pd

import networkx as nx

import matplotlib.pyplot as plt

import torch

import torch_geometric

import pyspark

from pyspark.sql import SparkSession

def validate_basic_libraries():

"""验证基础库是否安装正确"""

print("验证基础库...")

# 验证NumPy

try:

arr = np.array([1, 2, 3])

assert arr.sum() == 6, "NumPy测试失败"

except Exception as e:

print(f"NumPy错误: {e}")

return False

# 验证Pandas

try:

df = pd.DataFrame({"a": [1, 2, 3], "b": [4, 5, 6]})

assert df["a"].sum() == 6, "Pandas测试失败"

except Exception as e:

print(f"Pandas错误: {e}")

return False

print("基础库验证通过!")

return True

def validate_network_libraries():

"""验证网络分析库是否安装正确"""

print("

验证网络分析库...")

# 验证NetworkX

try:

G = nx.Graph()

G.add_edges_from([(1, 2), (2, 3), (3, 1)])

assert nx.number_of_nodes(G) == 3, "NetworkX测试失败"

except Exception as e:

print(f"NetworkX错误: {e}")

return False

# 验证igraph

try:

import igraph as ig

g = ig.Graph.Full(3)

assert g.vcount() == 3, "igraph测试失败"

except Exception as e:

print(f"igraph错误: {e}")

return False

print("网络分析库验证通过!")

return True

def validate_ml_libraries():

"""验证机器学习库是否安装正确"""

print("

验证机器学习库...")

# 验证Scikit-learn

try:

from sklearn.linear_model import LinearRegression

X = np.array([[1], [2], [3]])

y = np.array([2, 4, 6])

model = LinearRegression().fit(X, y)

assert round(model.predict([[4]])[0]) == 8, "Scikit-learn测试失败"

except Exception as e:

print(f"Scikit-learn错误: {e}")

return False

# 验证PyTorch和PyTorch Geometric

try:

from torch_geometric.data import Data

edge_index = torch.tensor([[0, 1, 1, 2], [1, 0, 2, 1]], dtype=torch.long)

x = torch.tensor([[-1], [0], [1]], dtype=torch.float)

data = Data(x=x, edge_index=edge_index)

assert data.num_nodes == 3, "PyTorch Geometric测试失败"

except Exception as e:

print(f"PyTorch/PyTorch Geometric错误: {e}")

return False

print("机器学习库验证通过!")

return True

def validate_spark():

"""验证Spark是否安装正确"""

print("

验证Spark...")

try:

spark = SparkSession.builder

.master("local[2]")

.appName("SNA-Validation")

.getOrCreate()

# 创建测试DataFrame

data = [("Alice", 25), ("Bob", 30), ("Charlie", 35)]

df = spark.createDataFrame(data, ["Name", "Age"])

assert df.count() == 3, "Spark测试失败"

spark.stop()

except Exception as e:

print(f"Spark错误: {e}")

return False

print("Spark验证通过!")

return True

def validate_datasets():

"""验证数据集是否准备正确"""

print("

验证数据集...")

import os

required_files = [

"data/social_networks/facebook_combined.txt",

"data/social_networks/ego-Twitter.txt",

"data/social_networks/soc-sign-bitcoinotc.csv"

]

for file_path in required_files:

if not os.path.exists(file_path):

print(f"数据集缺失: {file_path}")

return False

print("数据集验证通过!")

return True

def main():

"""主函数,运行所有验证"""

print("=== 社交网络分析环境验证 ===")

# 依次运行所有验证

all_passed = True

validators = [

validate_basic_libraries,

validate_network_libraries,

validate_ml_libraries,

validate_spark,

validate_datasets

]

for validator in validators:

if not validator():

all_passed = False

# 可以选择在这里中断,或继续运行其他验证

# break

if all_passed:

print("

=== 环境验证成功! 您已准备好开始社交网络分析之旅 ===")

else:

print("

=== 环境验证发现问题,请根据错误信息修复后重试 ===")

if __name__ == "__main__":

main()

运行验证脚本:

python src/validation/validate_environment.py

如果所有验证都通过,你将看到”环境验证成功”的消息。如果有任何验证失败,请根据错误信息检查你的安装步骤。

3.5 Docker环境(可选)

如果你希望使用Docker进行环境隔离,可以使用以下Dockerfile:

创建

Dockerfile

FROM python:3.9-slim

WORKDIR /app

# 安装系统依赖

RUN apt-get update && apt-get install -y --no-install-recommends

build-essential

libopenblas-dev

graphviz

wget

git

openjdk-11-jdk

&& rm -rf /var/lib/apt/lists/*

# 设置Java环境变量

ENV JAVA_HOME=/usr/lib/jvm/java-11-openjdk-amd64

# 安装Spark

RUN wget https://dlcdn.apache.org/spark/spark-3.3.2/spark-3.3.2-bin-hadoop3.tgz

&& tar -xzf spark-3.3.2-bin-hadoop3.tgz

&& mv spark-3.3.2-bin-hadoop3 /opt/spark

&& rm spark-3.3.2-bin-hadoop3.tgz

# 设置Spark环境变量

ENV SPARK_HOME=/opt/spark

ENV PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

# 复制依赖文件并安装

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txt

# 复制项目文件

COPY . .

# 下载示例数据集

RUN mkdir -p data/social_networks &&

cd data/social_networks &&

wget https://snap.stanford.edu/data/facebook_combined.txt.gz &&

gunzip facebook_combined.txt.gz &&

wget https://snap.stanford.edu/data/ego-Twitter.txt.gz &&

gunzip ego-Twitter.txt.gz &&

wget https://snap.stanford.edu/data/soc-sign-bitcoinotc.csv.gz &&

gunzip soc-sign-bitcoinotc.csv.gz &&

cd ../../

# 暴露Jupyter端口

EXPOSE 8888

# 启动命令

CMD ["jupyter", "lab", "--ip=0.0.0.0", "--port=8888", "--no-browser", "--allow-root"]

创建

requirements.txt

numpy==1.23.5

pandas==1.5.3

matplotlib==3.7.1

seaborn==0.12.2

networkx==3.0

scipy==1.10.1

python-louvain==0.16

igraph==0.10.4

leidenalg==0.9.1

scikit-learn==1.2.2

xgboost==1.7.5

lightgbm==3.3.5

torch==1.13.1

torch-geometric==2.3.0

pyspark==3.3.2

findspark==2.0.1

plotly==5.13.1

pyvis==0.3.1

kaleido==0.2.1

requests==2.28.2

beautifulsoup4==4.12.2

scrapy==2.9.0

tqdm==4.65.0

python-dotenv==1.0.0

jupyterlab==3.6.3

构建并运行Docker容器:

# 构建Docker镜像

docker build -t sna-bigdata .

# 运行Docker容器

docker run -it -p 8888:8888 -v $(pwd):/app sna-bigdata

然后通过浏览器访问显示的Jupyter Lab链接即可开始工作。

至此,我们已经完成了所有环境准备工作。在下一章中,我们将开始构建社交网络分析评估体系的各个组件。

四、分步实现

在本章中,我们将逐步构建一个完整的社交网络分析评估系统。我们将从数据加载与探索开始,逐步实现多维度指标计算、高级分析模型构建,最终实现一个实时评估系统。

4.1 数据加载与探索性分析

4.1.1 数据加载与基础处理

首先,让我们创建一个数据加载模块,用于读取不同格式的社交网络数据:

# src/data/data_loader.py

import os

import numpy as np

import pandas as pd

import networkx as nx

from igraph import Graph

import logging

# 设置日志

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)

class SocialNetworkDataLoader:

"""社交网络数据加载器"""

def __init__(self, data_dir="data/social_networks"):

"""

初始化数据加载器

参数:

data_dir: 数据目录路径

"""

self.data_dir = data_dir

self.graphs = {} # 存储加载的图

def load_undirected_unweighted(self, filename, name=None):

"""

加载无向无权图

参数:

filename: 文件名

name: 图的名称,默认为文件名

返回:

NetworkX图对象

"""

if name is None:

name = os.path.splitext(filename)[0]

file_path = os.path.join(self.data_dir, filename)

logger.info(f"加载无向无权图: {file_path}")

# 使用NetworkX加载

G = nx.read_edgelist(

file_path,

create_using=nx.Graph(),

nodetype=int

)

self.graphs[name] = G

logger.info(f"成功加载图 {name}: {G.number_of_nodes()}个节点, {G.number_of_edges()}条边")

return G

def load_directed_unweighted(self, filename, name=None):

"""加载有向无权图"""

if name is None:

name = os.path.splitext(filename)[0]

file_path = os.path.join(self.data_dir, filename)

logger.info(f"加载有向无权图: {file_path}")

G = nx.read_edgelist(

file_path,

create_using=nx.DiGraph(),

nodetype=int

)

self.graphs[name] = G

logger.info(f"成功加载图 {name}: {G.number_of_nodes()}个节点, {G.number_of_edges()}条边")

return G

def load_weighted_graph(self, filename, delimiter=',',

src_col=0, dst_col=1, weight_col=2,

directed=True, name=None):

"""

加载加权图

参数:

filename: 文件名

delimiter: 分隔符

src_col: 源节点列索引

dst_col: 目标节点列索引

weight_col: 权重列索引

directed: 是否为有向图

name: 图的名称

"""

if name is None:

name = os.path.splitext(filename)[0]

file_path = os.path.join(self.data_dir, filename)

logger.info(f"加载加权图: {file_path}")

# 读取CSV数据

df = pd.read_csv(

file_path,

delimiter=delimiter,

header=None,

usecols=[src_col, dst_col, weight_col]

)

# 创建图

graph_type = nx.DiGraph if directed else nx.Graph

G = graph_type()

# 添加边

edges = [

(row[src_col], row[dst_col], {"weight": row[weight_col]})

for _, row in df.iterrows()

]

G.add_edges_from(edges)

self.graphs[name] = G

logger.info(f"成功加载图 {name}: {G.number_of_nodes()}个节点, {G.number_of_edges()}条边")

return G

def get_graph(self, name):

"""获取已加载的图"""

if name not in self.graphs:

raise ValueError(f"图 {name} 未加载")

return self.graphs[name]

def convert_to_igraph(self, nx_graph):

"""将NetworkX图转换为igraph图,以利用更多高级算法"""

logger.info("将NetworkX图转换为igraph图")

# 创建节点列表

nodes = list(nx_graph.nodes())

node_id_mapping = {node: i for i, node in enumerate(nodes)}

# 创建边列表(转换为整数ID)

edges = []

edge_attrs = {}

相关文章