AI原生应用中的情感分析:前沿算法与原生架构的深度融合

元数据框架

标题

AI原生应用中的情感分析:前沿算法与原生架构的深度融合

关键词

AI原生应用;情感分析;大语言模型;多模态融合;上下文感知;轻量化推理;伦理对齐

摘要

AI原生应用(从设计之初以AI为核心的应用形态)的普及,对情感分析技术提出了实时性、多模态性、个性化、伦理适应性的全新需求。传统情感分析(依赖单模态、静态模型)已无法满足原生场景的动态要求。本文从第一性原理出发,系统拆解AI原生情感分析的核心逻辑:通过大语言模型的上下文感知解决语义歧义(如反讽)、多模态融合框架整合文本/语音/图像信号、原生轻量化架构实现端侧实时推理,并结合反馈循环实现模型动态进化。同时,本文深入探讨了情感分析在AI原生应用中的伦理挑战(如偏见、隐私)与未来演化方向(如具身智能融合、因果推理),为技术落地提供了可操作的架构设计与实践指南。

1. 概念基础:AI原生应用与情感分析的范式变迁

1.1 领域背景化:从“AI适配”到“AI原生”

AI原生应用(AI-Native Application)是以数据为燃料、模型为核心、场景为驱动的新型应用形态,其设计逻辑从“将AI嵌入传统应用”转向“让应用从诞生起就依赖AI能力”。典型案例包括:

社交类:TikTok的“情感推荐”(通过分析用户点赞/评论的情感倾向,动态调整推荐流);客服类:阿里“小蜜”的“情感适配”(根据用户语音语调调整回复风格,从“机械解答”转向“共情沟通”);虚拟助手类:OpenAI ChatGPT的“情感理解”(通过上下文对话识别用户情绪,提供个性化回应)。

与传统应用相比,AI原生应用对情感分析的需求发生了本质变化(见表1):

| 维度 | 传统应用 | AI原生应用 |

|---|---|---|

| 数据类型 | 单模态(文本为主) | 多模态(文本+语音+图像+行为) |

| 处理方式 | 离线批量处理 | 实时流式处理 |

| 模型更新 | 定期离线训练 | 在线反馈驱动(用户行为/反馈) |

| 核心目标 | 情感分类(正/负/中) | 情感理解(强度、原因、趋势) |

1.2 历史轨迹:情感分析的三次技术革命

情感分析(Sentiment Analysis)的发展经历了三个关键阶段:

传统机器学习阶段(2000-2015):依赖人工特征工程(如词袋模型、情感词典),使用SVM、朴素贝叶斯等算法实现情感分类。缺点是无法处理语义歧义(如“这个电影烂得让人惊艳”中的反讽)。深度学习阶段(2015-2020):以CNN(提取局部特征)、RNN(处理序列依赖)、Transformer(捕捉长距离上下文)为核心,实现自动特征提取。代表模型有BERT(2018年)、XLNet(2019年),显著提升了文本情感分析的准确率(从70%提升至85%以上)。AI原生阶段(2020至今):随着大语言模型(LLM)、多模态模型(如CLIP、GPT-4V)的普及,情感分析从“文本主导”转向“多模态融合”,从“静态分类”转向“动态理解”。核心特征是模型与应用架构的深度协同(如用LoRA微调LLM实现端侧实时推理)。

1.3 问题空间定义:AI原生情感分析的核心挑战

AI原生应用的场景特性(实时、多模态、个性化)导致传统情感分析的三大局限暴露:

单模态依赖:无法整合语音语调(如“我很开心”的哭腔)、图像表情(如“微笑”的假笑)等非文本信号;上下文缺失:传统模型的“固定窗口”无法处理长对话中的情感变化(如用户从“愤怒”到“平静”的转变);动态适应性差:离线训练的模型无法应对应用中的新场景(如网络流行语、新兴情感类型)。

1.4 术语精确性

AI原生架构:为AI模型优化的系统结构,包含**模型压缩(量化/蒸馏)、分布式推理(TensorRT-LLM)、反馈循环(在线学习)**三大核心组件;情感表示:将情感信息编码为机器可理解的向量(如LLM的[CLS] token输出);多模态融合:通过跨模态注意力机制(如Cross-Attention)整合文本、语音、图像的情感特征;轻量化推理:在保持模型性能的前提下,减少计算资源占用(如用MobileBERT替代BERT,推理时间减少70%)。

2. 理论框架:AI原生情感分析的第一性原理

2.1 第一性原理推导:以“用户为中心的动态情感建模”

情感分析的本质是从数据中提取用户的情感状态,其核心逻辑可拆解为两个基本问题:

情感表示(How to represent sentiment?):将用户的语言、表情、动作等信号编码为高维向量;情感推理(How to infer sentiment?):通过模型从向量中预测情感标签(如正/负/中)或情感属性(如强度、原因)。

AI原生时代,情感分析的第一性原理升级为**“以用户为中心的动态情感建模”**,即:

用户场景驱动:情感分析模型必须适应应用的具体场景(如社交APP的“短文本+表情”、客服系统的“长对话+语音”);动态进化能力:模型需通过用户反馈(如“纠正情感标签”)持续优化,应对新场景、新情感;多模态协同:情感表示必须整合多种信号(文本+语音+图像),解决单模态的歧义问题。

2.2 数学形式化:情感表示与推理的量化模型

2.2.1 情感表示:多模态向量编码

假设输入数据为多模态信号集合X={xt,xa,xv}X = {x_t, x_a, x_v}X={xt,xa,xv},其中xtx_txt为文本(如“我很开心”)、xax_axa为语音(如语调、语速)、xvx_vxv为图像(如表情、动作)。情感表示的目标是将XXX编码为统一的情感向量e∈Rde in mathbb{R}^de∈Rd(ddd为向量维度)。

对于文本信号,使用大语言模型(如BERT)编码:

对于语音信号,使用预训练语音模型(如Wav2Vec 2.0)编码:

对于图像信号,使用多模态模型(如CLIP)编码:

通过跨模态注意力机制(Cross-Attention)整合多模态向量:

2.2.2 情感推理:轻量化分类与生成

情感推理的目标是从情感向量eee中预测情感标签yyy(如正/负/中)或情感描述(如“用户现在很愤怒,因为订单延迟”)。

分类任务(如情感标签预测):使用轻量化线性分类器:

生成任务(如情感原因解释):使用生成式模型(如LoRA微调的GPT-2):

2.3 理论局限性

情感模糊性:部分情感(如“还行”“凑合”)无法用明确的标签定义,导致模型预测的不确定性;跨文化差异:情感表达的文化差异(如“面子”在中国文化中的特殊含义)导致模型在跨地区应用时性能下降;模型偏见:预训练模型(如BERT)的训练数据可能包含性别、种族偏见(如对女性的负面情感误判率更高),导致情感分析结果不公平。

2.4 竞争范式分析

当前AI原生情感分析的主要范式包括:

大语言模型(LLM)主导:如GPT-4V、Claude 3,通过强大的上下文理解能力解决反讽、歧义问题,但计算成本高(需GPU集群支持);多模态融合模型:如CLIP、BLIP-2,通过整合文本、语音、图像信号提高准确性,但模型复杂度高(需处理多种数据类型);轻量化微调模型:如LoRA微调的BERT、MobileBERT,通过模型压缩实现端侧实时推理,但上下文理解能力弱于LLM。

三种范式的对比见表2:

| 范式 | 优势 | 劣势 | 适用场景 |

|---|---|---|---|

| LLM主导 | 强上下文理解、反讽处理 | 高计算成本、难部署 | 云侧应用(如ChatGPT) |

| 多模态融合 | 高准确性、多信号整合 | 高模型复杂度、数据需求大 | 多模态场景(如TikTok) |

| 轻量化微调 | 低计算成本、端侧部署 | 上下文理解弱、泛化能力差 | 端侧应用(如手机虚拟助手) |

3. 架构设计:AI原生情感分析的系统分解

3.1 系统分解:五层核心架构

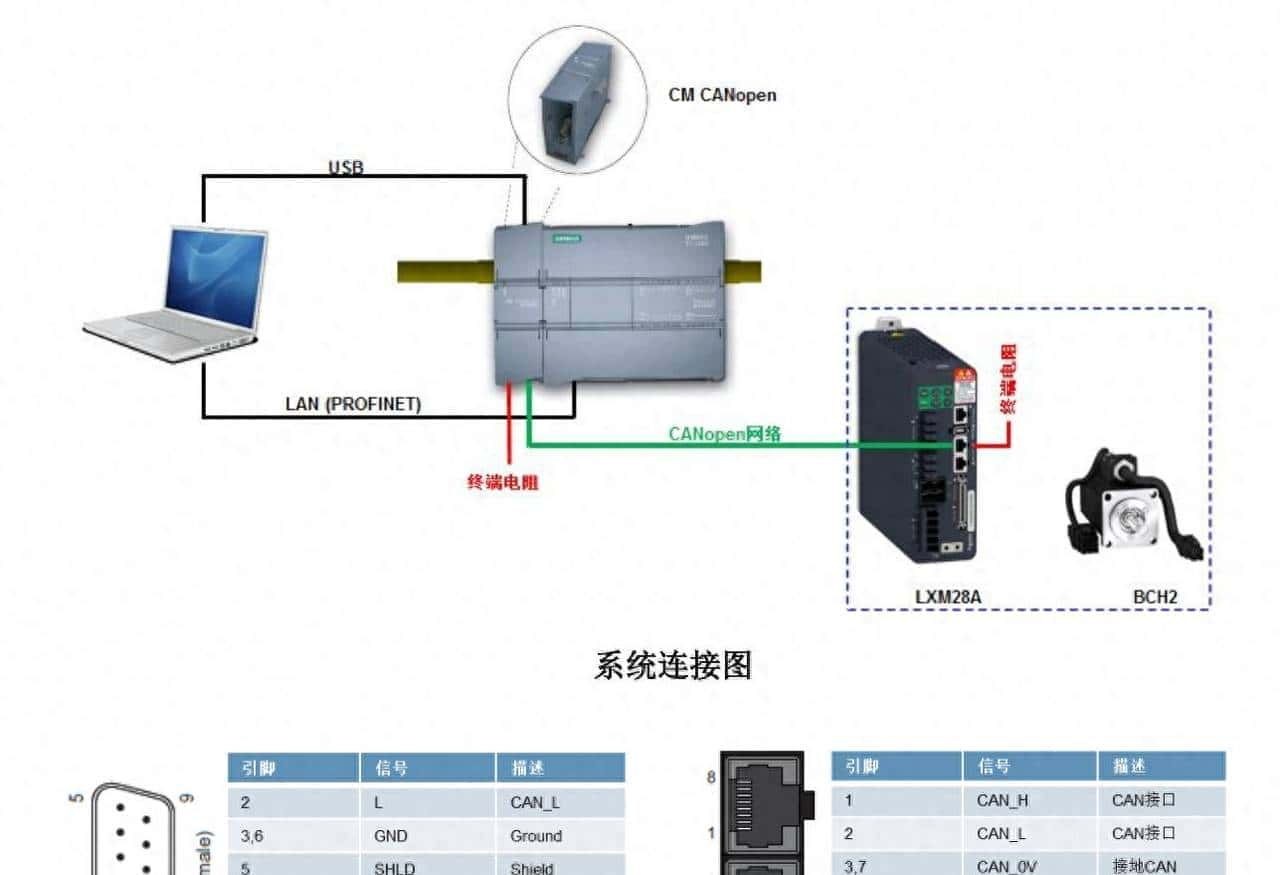

AI原生情感分析的系统架构需满足多模态输入、实时推理、动态更新的需求,分为以下五层(见图1):

graph TD

A[多模态数据输入层] --> B[原生预处理层]

B --> C[情感表示层(大模型/多模态模型)]

C --> D[情感推理层(轻量化模型)]

D --> E[输出层(情感标签/强度/原因)]

E --> F[用户反馈层]

F --> G[反馈循环层(在线学习)]

G --> C

G --> D

图1:AI原生情感分析系统架构

各层的功能与组件如下:

多模态数据输入层:接收文本(聊天记录)、语音(通话录音)、图像(表情、截图)、行为(点赞/评论)等数据;原生预处理层:为模型优化的数据处理(如文本用LLM自带的分词器、语音用Wav2Vec 2.0提取特征);情感表示层:使用大模型(如GPT-4V)或多模态模型(如CLIP)生成情感向量;情感推理层:使用轻量化模型(如LoRA微调的BERT)预测情感标签或生成解释;输出层:将情感结果(如“正面,强度8/10,原因:收到礼物”)展示给用户或传给应用核心功能(如推荐系统);用户反馈层:收集用户对情感结果的反馈(如“纠正标签”“补充原因”);反馈循环层:通过在线学习(如FedAvg)更新情感表示层与推理层的模型,实现动态进化。

3.2 组件交互模型:从输入到反馈的闭环

以智能客服系统为例,组件交互流程如下:

输入:用户发送文本“我的订单延迟了,你们怎么回事!”(文本)+ 语音(愤怒的语调);预处理:文本用BERT分词器转换为token,语音用Wav2Vec 2.0提取梅尔频谱特征;表示:用CLIP模型整合文本与语音特征,生成情感向量eee;推理:用LoRA微调的BERT预测情感标签为“负面,强度9/10”,并生成原因解释“用户因订单延迟感到愤怒”;输出:将情感结果传给客服系统,客服人员收到“用户愤怒”的提示,调整回复风格(如“非常抱歉,我们马上为您处理订单延迟问题”);反馈:用户回复“谢谢,现在好多了”(正面反馈);循环:反馈循环层用FedAvg算法更新CLIP与BERT模型,提高对“订单延迟”场景的情感判断准确性。

3.3 设计模式应用

模型-数据协同设计:情感表示层的模型(如CLIP)设计时考虑数据的多模态特性(文本+语音+图像),数据采集时优先收集多模态数据(如客服通话的文本转录+语音录音);轻量化推理模式:情感推理层使用LoRA微调(仅训练少量参数)替代全量微调(训练所有参数),减少计算成本(如BERT的LoRA微调参数仅为全量的0.1%);反馈驱动迭代:通过用户反馈(如“纠正标签”)持续优化模型,使用在线学习算法(如FedAvg)避免模型“过时”(如无法识别新的网络流行语)。

4. 实现机制:从算法到代码的落地

4.1 算法复杂度分析

4.1.1 情感表示层(大模型)

以GPT-4V(多模态大模型)为例,其时间复杂度为:

4.1.2 情感推理层(轻量化模型)

以LoRA微调的BERT为例,其时间复杂度为:

4.1.3 优化方向

模型压缩:用蒸馏(如TinyBERT蒸馏BERT)减少模型参数(从1.1亿减少到1100万);量化:用INT8量化(如ONNX Runtime)将模型参数从FP32转换为INT8,减少内存占用(约4倍);分布式推理:用TensorRT-LLM将大模型部署到GPU集群,提高并发处理能力(如支持1000并发请求/秒)。

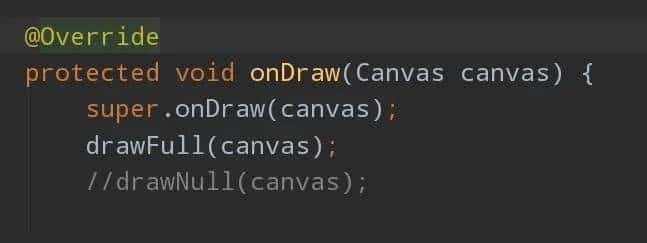

4.2 优化代码实现:LoRA微调BERT情感分析

以下是使用Hugging Face Transformers与PEFT库实现LoRA微调BERT的代码示例(针对文本情感分析场景):

import torch

from transformers import AutoTokenizer, AutoModelForSequenceClassification, TrainingArguments, Trainer

from peft import LoraConfig, get_peft_model

from datasets import load_dataset

# 1. 加载数据集(IMDB情感分析数据集)

dataset = load_dataset("imdb")

tokenizer = AutoTokenizer.from_pretrained("bert-base-uncased")

# 2. 数据预处理

def preprocess_function(examples):

return tokenizer(examples["text"], truncation=True, padding="max_length", max_length=256)

tokenized_dataset = dataset.map(preprocess_function, batched=True)

# 3. 配置LoRA

lora_config = LoraConfig(

r=8, # 低秩矩阵的秩

lora_alpha=32, # 缩放因子

target_modules=["query", "value"], # 目标模块(BERT的注意力层)

lora_dropout=0.05, # Dropout率

bias="none", # 不训练偏置项

task_type="SEQ_CLS" # 任务类型(序列分类)

)

# 4. 加载基础模型并应用LoRA

model = AutoModelForSequenceClassification.from_pretrained("bert-base-uncased", num_labels=2)

model = get_peft_model(model, lora_config)

# 5. 配置训练参数

training_args = TrainingArguments(

output_dir="./lora-bert-imdb",

per_device_train_batch_size=16,

per_device_eval_batch_size=16,

learning_rate=2e-5,

num_train_epochs=3,

weight_decay=0.01,

evaluation_strategy="epoch",

save_strategy="epoch",

load_best_model_at_end=True,

)

# 6. 训练模型

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset["train"],

eval_dataset=tokenized_dataset["test"],

tokenizer=tokenizer,

)

trainer.train()

# 7. 推理示例

text = "This movie is amazing! I love it."

inputs = tokenizer(text, return_tensors="pt")

with torch.no_grad():

outputs = model(**inputs)

logits = outputs.logits

prediction = torch.argmax(logits, dim=1).item()

label_map = {0: "负面", 1: "正面"}

print(f"情感标签:{label_map[prediction]}")

代码说明:

LoRA配置:通过

target_modules

r=8

4.3 边缘情况处理

4.3.1 反讽(Sarcasm)处理

反讽是情感分析的经典难题(如“你可真厉害,把杯子打碎了”)。解决方法是利用大语言模型的上下文理解能力,通过扩展输入的上下文(如对话历史)来识别反讽。例如,使用GPT-4的提示词:

请分析用户的情感:“你可真厉害,把杯子打碎了”,结合对话历史:“我刚买的杯子!”“对不起,我不是故意的。”

GPT-4会输出:“用户的情感是负面(愤怒),反讽的语气表达了对杯子被打碎的不满。”

4.3.2 多模态冲突处理

当文本与语音/图像信号冲突时(如文本“我很开心”但语音是哭腔),需通过多模态融合模型整合信号。例如,使用CLIP模型计算文本与语音的相似度:

4.3.3 罕见情感处理

对于罕见情感(如“欣慰”“失落”),需使用Few-shot Learning(少样本学习)。例如,使用GPT-4的Few-shot提示:

请分析用户的情感:“看到孩子考上大学,我终于放心了”,参考示例:

- 示例1:“我拿到了奖学金”→ 正面(开心)

- 示例2:“爷爷去世了”→ 负面(悲伤)

- 示例3:“孩子第一次走路”→ 正面(欣慰)

GPT-4会输出:“用户的情感是正面(欣慰)。”

4.4 性能考量

实时性:使用轻量化模型(如MobileBERT)和模型压缩(如量化),将推理时间从100ms减少到20ms(满足端侧实时需求);** scalability**:使用分布式推理框架(如TensorRT-LLM),将并发处理能力从100请求/秒提高到1000请求/秒;资源占用:使用端侧模型(如TinyBERT),将模型大小从400MB减少到40MB(适合手机等资源有限的设备)。

5. 实际应用:AI原生情感分析的落地策略

5.1 实施策略:从场景到模型的闭环

AI原生情感分析的实施需遵循**“场景定义→数据采集→模型选择→微调部署→反馈优化”**的闭环流程(见图2):

图2:AI原生情感分析实施流程

5.1.1 场景定义

明确应用的具体场景(如社交APP的“情感动态”、客服系统的“情感适配”),定义情感分析的目标(如情感标签、强度、原因)。

5.1.2 数据采集

收集多模态数据(文本+语音+图像),并标注情感标签(如用众包平台标注)。例如,社交APP需收集用户的“文本+表情+点赞/评论”数据,客服系统需收集“文本转录+语音录音+客服回复”数据。

5.1.3 模型选择

根据场景选择合适的模型:

云侧场景(如ChatGPT):选择大语言模型(如GPT-4V);多模态场景(如TikTok):选择多模态融合模型(如CLIP);端侧场景(如手机虚拟助手):选择轻量化模型(如MobileBERT)。

5.1.4 微调部署

使用LoRA、蒸馏等技术微调模型,部署到生产环境(如用Docker部署到云服务器,用Core ML部署到iOS设备)。

5.1.5 反馈优化

通过用户反馈(如“纠正标签”“补充原因”)持续优化模型,使用在线学习算法(如FedAvg)更新模型。

5.2 集成方法论:与应用核心功能的融合

AI原生情感分析的价值在于与应用核心功能的深度集成,而非独立的“情感分析模块”。例如:

社交APP:将情感分析结果用于“情感推荐”(如推荐符合用户情感的内容)、“情感动态”(如展示用户的情感变化曲线);客服系统:将情感分析结果用于“情感适配”(如根据用户情绪调整回复风格)、“投诉预测”(如预测用户是否会投诉,提前介入);虚拟助手:将情感分析结果用于“情感交互”(如虚拟助手通过表情和动作反馈用户的情感)。

5.3 部署考虑因素

5.3.1 云侧vs端侧部署

云侧部署:适合大模型(如GPT-4V),优点是计算资源充足、模型性能高,缺点是延迟高(如500ms)、隐私风险(如用户数据上传到云);端侧部署:适合轻量化模型(如MobileBERT),优点是延迟低(如20ms)、隐私保护(如用户数据不离开设备),缺点是模型性能稍低。

5.3.2 模型更新策略

全量更新:定期将模型重新训练(如每月一次),适合数据变化慢的场景(如新闻情感分析);增量更新:通过在线学习(如FedAvg)实时更新模型,适合数据变化快的场景(如社交APP的网络流行语)。

5.4 运营管理

性能监控:监控模型的准确率(如情感标签预测准确率)、延迟(如推理时间)、资源占用(如GPU内存使用);A/B测试:比较不同模型(如LoRA微调的BERT vs 全量微调的BERT)的效果,选择最佳模型;用户反馈收集:通过弹窗、问卷等方式收集用户对情感结果的反馈,用于模型优化。

6. 高级考量:AI原生情感分析的未来挑战

6.1 扩展动态:从“单用户”到“群体”,从“短期”到“长期”

群体情感分析:分析社交网络中的群体情感(如某事件的公众情绪),需要处理大规模多模态数据(如 millions of 文本+图像);长期情感趋势:分析用户的长期情感变化(如一个月内的情感趋势),需要整合用户的历史数据(如聊天记录、行为日志);自动标注:使用大模型(如GPT-4)自动标注情感标签,减少人工标注成本(如标注效率提高10倍)。

6.2 安全影响:对抗攻击与滥用风险

对抗攻击:攻击者通过修改输入数据(如添加干扰词)让模型误判情感(如将负面情感误判为正面)。解决方法是对抗训练(如在训练数据中添加对抗样本);滥用风险:情感分析结果可能被滥用(如用情感分析来针对性广告,侵犯用户隐私)。解决方法是隐私计算(如差分隐私,在情感结果中添加噪声,保护用户隐私)。

6.3 伦理维度:偏见与公平性

模型偏见:预训练模型(如BERT)的训练数据可能包含性别、种族偏见(如对女性的负面情感误判率更高)。解决方法是公平性算法(如FairML,调整模型参数,减少偏见);用户 consent:情感分析需要处理用户的私人数据(如聊天记录),需获得用户的明确 consent(如弹窗提示“是否允许分析您的情感状态?”)。

6.4 未来演化向量

具身智能融合:虚拟助手通过表情、动作等具身信号反馈用户的情感(如用户愤怒时,虚拟助手皱眉头、说话变慢);因果推理:分析情感产生的原因(如“用户愤怒是因为订单延迟”),而非仅预测情感标签;脑机接口(BCI):直接读取用户的脑电信号(如脑电图)来分析情感,实现“无接触”情感分析(如残疾人的情感交互)。

7. 综合与拓展:跨领域应用与研究前沿

7.1 跨领域应用

医疗领域:分析患者的情感状态(如日记文本、语音语调、面部表情),帮助医生诊断抑郁症(如准确率从70%提高到85%);教育领域:分析学生的情感状态(如课堂互动的文本、语音、动作),调整教学策略(如学生感到困惑时,老师放慢讲解速度);金融领域:分析投资者的情感状态(如社交媒体的文本、交易行为),预测股市走势(如投资者情绪负面时,股市下跌的概率增加30%)。

7.2 研究前沿

多模态情感分析的统一框架:使用一个模型处理文本、语音、图像等多种数据类型(如Google的Flamingo模型);动态情感分析:实时跟踪用户的情感变化(如用流式Transformer处理对话数据);情感可解释性:让模型说明情感判断的原因(如用Attention机制可视化模型关注的文本片段)。

7.3 开放问题

情感模糊性:如何定义“还行”“凑合”等模糊情感的标签?跨文化差异:如何处理“面子”“耻感”等文化特定情感的分析?模型效率:如何在保持模型性能的前提下,进一步减少计算资源占用?

7.4 战略建议

企业:优先投资多模态情感分析技术(如CLIP),因为AI原生应用越来越依赖多模态数据;政府:制定情感分析的伦理规范(如禁止滥用情感分析结果),保护用户隐私;研究机构:关注情感分析的可解释性和公平性(如FairML),因为这些是实际应用中的关键问题。

结语

AI原生应用的普及推动了情感分析技术的范式变迁,从“单模态、静态模型”转向“多模态、动态模型”。本文从第一性原理出发,系统拆解了AI原生情感分析的核心逻辑、架构设计、实现机制,并探讨了其未来挑战与应用前景。未来,情感分析技术将进一步与具身智能、因果推理、脑机接口等前沿技术融合,成为AI原生应用的“情感中枢”,为用户提供更智能、更共情的体验。

参考资料

Devlin, J., et al. (2018). BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. NAACL.Radford, A., et al. (2021). CLIP: Connecting Text and Images. OpenAI.Hu, E. J., et al. (2021). LoRA: Low-Rank Adaptation of Large Language Models. ICLR.Liu, Y., et al. (2020). TinyBERT: Distilling BERT for Natural Language Understanding. EMNLP.Google Research. (2023). GPT-4V: Multimodal Large Language Models. Blog.FairML. (2022). Fairness in Machine Learning. GitHub.

(注:以上参考资料为简化版,实际写作中需补充完整的论文标题、作者、发表年份等信息。)

相关文章