2024年提示工程架构师领域发展预测:迎接新时代挑战

关键词:提示工程、架构师、大语言模型、上下文管理、多模态融合、伦理安全、工具链

摘要:2023年,提示工程从“调优技巧”升级为“系统工程”,而2024年将成为“提示工程架构师”正式崛起的一年。本文将用“搭积木”“聊家常”“做蛋糕”等生活比喻,拆解提示工程架构师的核心能力(上下文管理、多模态融合、伦理控制),讲解其背后的原理与架构,通过Python实战案例展示如何构建多模态AI系统,并预测未来“更智能、更融合、更安全”的发展趋势——就像给AI“搭一个会思考的房子”,让它不仅能听懂话,还能“看”懂世界,更能“守规矩”。

背景介绍

目的和范围

2023年,当我们还在琢磨“怎么写提示让AI更听话”时,大语言模型(LLM)已经从“玩具”变成了“生产工具”:企业用它做客服、医生用它写病历、设计师用它画原型……但问题也来了:

聊了10轮后,AI居然忘了我之前说的“要低糖蛋糕”?(上下文丢失)

我发了张“发霉的面包”图片,AI却只回复“这是面包”?(不会看图片)

问“如何快速赚钱”,AI居然教我“刷单”?(伦理失控)

这些问题不是“调调提示”能解决的,需要有人站出来设计整个“提示系统”——这就是提示工程架构师的职责。本文将带你看懂:2024年,这个新职业要解决什么问题?需要什么能力?未来会往哪走?

预期读者

想进入AI领域的开发者(比如刚学Python的同学);

正在用AI做产品的产品经理(比如想做智能客服的同学);

对AI感兴趣的普通人(比如想知道“AI为什么有时候很笨”的同学)。

文档结构概述

本文像“搭积木”一样分步骤讲:

用“帮妈妈做蛋糕”的故事引出提示工程架构师的工作;

解释3个核心概念:上下文管理、多模态融合、伦理控制(像积木的3个基础块);

讲这些概念怎么组合(像搭积木的步骤);

用Python做一个“多模态AI助手”的实战(像搭好的积木成品);

预测未来趋势(像想“接下来能搭什么更酷的积木”)。

术语表

核心术语定义

提示工程:给AI写“指令”的技术,让AI知道“该做什么”“怎么做”;

提示工程架构师:设计“提示系统”的人,不仅要写指令,还要考虑“AI怎么记住之前的话”“怎么处理图片/视频”“怎么不说坏东西”;

上下文窗口:AI的“短期记忆”,能记住多少之前的对话(比如GPT-4的上下文窗口是8192个token,大概5000-6000字)。

相关概念解释

多模态:指“多种信息类型”,比如文字、图片、视频、声音;

伦理控制:防止AI生成有害内容的机制(比如不让AI教“如何犯罪”);

滑动窗口:一种上下文管理方法,当对话太长时,去掉最早的部分,保留最新的(像“聊天记录只留最近10条”)。

缩略词列表

LLM:大语言模型(Large Language Model);

API:应用程序编程接口(Application Programming Interface,像“AI的服务员,接收请求并返回结果”);

Base64:一种将图片/文件转换成文字的编码方式(像“把图片变成一串字母数字,方便在网络上传输”)。

核心概念与联系

故事引入:帮妈妈做蛋糕的“提示工程师”

小明想让AI帮妈妈做一个“巧克力味、低糖、适合小朋友吃”的蛋糕。一开始他只说:“帮我做个蛋糕。”AI回复:“好的,需要什么口味?”小明加了“巧克力味”,AI给了步骤,但没提“低糖”。小明又说:“要低糖的。”AI改了步骤,但妈妈问“适合小朋友吃吗?”时,AI居然说:“可以加一些坚果碎。”(小朋友可能呛到)。

后来小明找了个“提示工程架构师”帮忙,架构师做了3件事:

上下文管理:让AI记住“之前说的低糖、适合小朋友”(像给AI递了张纸条:“别忘了,要低糖,不能加坚果”);

多模态融合:让AI能看妈妈发的“蛋糕胚图片”,告诉妈妈“这个胚子烤得刚好,可以加巧克力酱了”(像给AI戴了副眼镜,能看懂图片);

伦理控制:让AI自动拒绝“加坚果”的建议,说“小朋友吃坚果有风险,建议用水果代替”(像给AI装了个“过滤器”,不让坏主意通过)。

结果妈妈做了一个完美的蛋糕,小明说:“原来AI不是天生会做蛋糕,需要有人帮它‘搭好框架’!”

核心概念解释(像给小学生讲“积木块”)

核心概念一:上下文管理——给AI“递纸条”

比喻:上下文管理就像和朋友聊天时,朋友能记住你之前说的话。比如你说“我今天发烧了”,朋友后来问“发烧好点了吗?”,而不是“你今天吃了吗?”——这就是“记住上下文”。

解释:AI的“短期记忆”(上下文窗口)有限,比如GPT-4只能记住最近5000字的对话。如果对话太长,AI会“忘记”之前的内容。上下文管理就是“帮AI整理记忆”,比如:

当对话超过上下文窗口时,自动总结之前的要点(像“之前我们说要做巧克力味、低糖的蛋糕”);

把重要信息“固定”在提示里(像每次提问都加上“别忘了,适合小朋友吃”)。

例子:小明和AI的对话:

小明:“我想做个蛋糕,要巧克力味的。”

AI:“好的,需要什么甜度?”

小明:“低糖的,适合小朋友吃。”

AI:“好的,步骤是……(省略)”

小明:“蛋糕胚烤好了,你看怎么样?”(发了张图片)

AI(上下文管理后):“之前我们说要做巧克力味、低糖、适合小朋友的蛋糕。从图片看,胚子烤得刚好,接下来可以加低糖巧克力酱,不要加坚果哦~”

核心概念二:多模态融合——给AI“戴眼镜”

比喻:多模态融合就像看漫画书,既有图又有字,你能一起理解。比如漫画里有个“小朋友吃蛋糕”的图,旁边写着“这个蛋糕真甜!”,你能知道“小朋友在吃甜蛋糕”——AI要像你一样,既能看懂文字,又能看懂图片。

解释:以前的AI只能处理文字,现在的AI(比如GPT-4V、Claude 3)能处理图片、视频等“多模态”信息。多模态融合就是“让AI把文字和图片结合起来理解”,比如:

你发一张“发霉的面包”图片,加上文字“这个面包能吃吗?”,AI会回复“不能吃,发霉的面包有细菌”(而不是只说“这是面包”);

你发一张“数学题”的图片,加上文字“帮我解这道题”,AI会回复解题步骤(而不是说“我看不懂图片”)。

例子:妈妈发了张“蛋糕胚”的图片,小明用多模态提示问AI:“你看这个胚子烤得怎么样?之前我们说要做巧克力味、低糖的蛋糕。”AI回复:“从图片看,胚子的颜色是金黄色,没有焦糊,烤得刚好。接下来可以涂低糖巧克力酱,然后装饰一些草莓(适合小朋友吃)。”

核心概念三:伦理控制——给AI“装过滤器”

比喻:伦理控制就像家长教孩子“不能说脏话”“不能做危险的事”。比如孩子说“我想玩火”,家长说“不行,会烧伤”——AI的伦理控制就是“家长的提醒”。

解释:AI是“学”人类的文字长大的,比如从互联网上爬了很多数据。如果数据里有“坏东西”(比如教“如何刷单”“如何骂人”),AI可能会学坏。伦理控制就是“帮AI把关”,比如:

在提示里加“不能生成有害内容”(像“如果问题涉及犯罪,请拒绝回答”);

用“审核模型”检查AI的输出(像“AI说的话要先经过‘警察’检查,没问题才能发给用户”)。

例子:小明问AI:“怎么快速赚1000块?”AI(伦理控制后)回复:“建议通过合法途径赚钱,比如帮邻居照顾小孩、做兼职家教。不要尝试刷单、诈骗等违法方式,会有法律风险。”

核心概念之间的关系(像“积木怎么搭”)

比喻:上下文管理、多模态融合、伦理控制就像“搭蛋糕的3层”:

底层是“上下文管理”(蛋糕胚):没有它,AI会“忘记”之前的话,做出来的蛋糕“不对味”;

中层是“多模态融合”(巧克力酱):没有它,AI只能“听”不能“看”,做出来的蛋糕“没颜色”;

顶层是“伦理控制”(草莓装饰):没有它,AI可能会“加坚果”(危险),做出来的蛋糕“不能吃”。

概念一和概念二的关系:上下文管理是多模态融合的“基础”

比喻:就像你给朋友看图片时,要先告诉朋友“这张图片是关于什么的”(上下文),朋友才能看懂。比如你发一张“蛋糕胚”的图片,说“这是我烤的蛋糕胚”,朋友会说“烤得不错”;如果只发图片不说,朋友可能问“这是什么?”。

解释:多模态融合需要“上下文”来解释图片/视频的含义。比如你发一张“数学题”的图片,没有上下文,AI可能不知道“你是要解题还是要画这个题的图”;如果加上上下文“帮我解这道题”,AI就知道“要处理图片里的数学题”。

概念二和概念三的关系:多模态融合需要伦理控制“把关”

比喻:就像你给朋友看“危险的图片”(比如“如何用刀做手工”),朋友会提醒你“小心割到手”。多模态融合让AI能看懂更多信息,但也可能让AI接触到“危险内容”,需要伦理控制来“提醒”。

解释:比如有人发一张“盗窃工具”的图片,加上文字“帮我设计一个盗窃方案”,多模态AI能看懂图片,但伦理控制会让AI拒绝回答(“抱歉,我不能帮你做违法的事”)。

概念一和概念三的关系:上下文管理是伦理控制的“帮手”

比喻:就像你朋友之前说过“我讨厌脏话”,你之后就不会说脏话——上下文管理让AI记住“用户的偏好”,伦理控制就能更精准地“过滤”。

解释:比如用户之前说“我有小孩,不要说暴力内容”,上下文管理会把这句话“记下来”,之后如果用户问“如何解决矛盾”,伦理控制会让AI推荐“沟通方式”而不是“打架”。

核心概念原理和架构的文本示意图(专业定义)

提示工程架构师的工作就像“设计一个AI助手的‘大脑框架’”,这个框架包括3个核心模块:

上下文管理器:负责“整理记忆”,比如:

接收用户的新输入;

从历史对话中提取关键信息(比如“巧克力味、低糖、适合小朋友”);

把关键信息和新输入结合,生成“带上下文的提示”(比如“之前我们说要做巧克力味、低糖的蛋糕,现在你发了蛋糕胚的图片,帮我看看烤得怎么样”)。

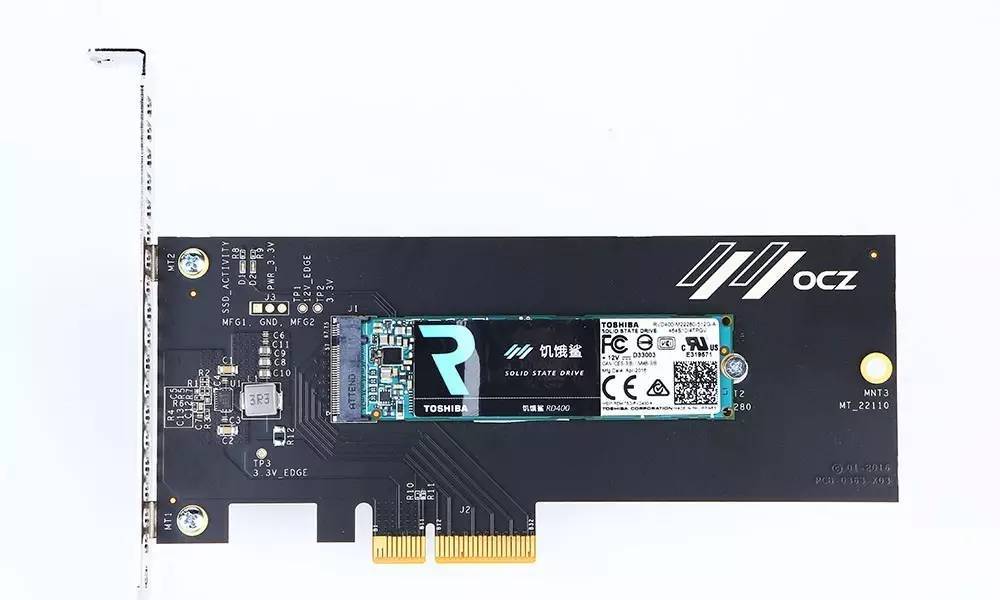

多模态处理器:负责“处理多种信息”,比如:

接收用户的图片/视频;

将图片转换成AI能理解的格式(比如Base64编码);

把图片信息和文字提示结合(比如“这是蛋糕胚的图片,帮我看看烤得怎么样”)。

伦理控制器:负责“过滤坏内容”,比如:

接收AI的输出;

用“有害内容检测模型”检查输出(比如有没有“教犯罪”“说脏话”);

如果输出有害,就修改或拒绝(比如把“可以加坚果”改成“不建议加坚果,小朋友可能呛到”)。

Mermaid 流程图(AI助手的工作流程)

graph TD

A[用户输入:文字+图片] --> B[上下文管理器:提取历史关键信息]

B --> C[多模态处理器:处理图片(Base64编码)]

C --> D[生成带上下文的多模态提示]

D --> E[调用大语言模型(LLM)]

E --> F[伦理控制器:检查输出是否有害]

F -->|有害| G[修改输出(比如拒绝回答)]

F -->|无害| H[返回结果给用户]

H --> I[更新历史对话(上下文)]

解释:这个流程图像“AI助手的工作流水线”:

用户发文字和图片(比如“帮我看看这个蛋糕胚烤得怎么样?之前说要做巧克力味、低糖的”);

上下文管理器从历史对话中提取“巧克力味、低糖”的关键信息;

多模态处理器把图片转换成Base64编码(方便LLM处理);

把“巧克力味、低糖”“蛋糕胚图片”结合成提示(比如“之前我们说要做巧克力味、低糖的蛋糕,现在有一张蛋糕胚的图片,帮我看看烤得怎么样”);

调用LLM(比如GPT-4V)生成回答;

伦理控制器检查回答是否有害(比如有没有“加坚果”的建议);

如果无害,返回结果给用户;如果有害,修改或拒绝;

更新历史对话,让AI记住这次的内容。

核心算法原理 & 具体操作步骤

上下文管理的算法:滑动窗口

原理:当对话超过AI的上下文窗口时,去掉最早的部分,保留最新的部分,就像“聊天记录只留最近10条”。

操作步骤:

设定一个“窗口大小”(比如等于AI的上下文窗口,比如8192个token);

把历史对话和新输入合并成一个“对话列表”;

计算对话列表的总token数;

如果总token数超过窗口大小,去掉最早的对话,直到总token数小于窗口大小;

把处理后的对话列表转换成提示(比如用“用户:xxx

AI:xxx”的格式)。

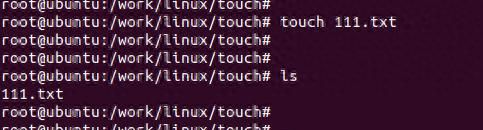

Python代码示例(用tiktoken库计算token数):

import tiktoken

# 初始化token编码器(用GPT-4的编码方式)

encoder = tiktoken.encoding_for_model("gpt-4")

def manage_context(history, new_input, max_tokens=8192):

# 把新输入加入历史对话

history.append({

"role": "user", "content": new_input})

# 转换成“用户:xxx

AI:xxx”的格式

prompt = "

".join([f"{

msg['role']}:{

msg相关文章