掌握 Hadoop,开启大数据领域的高效数据处理之旅

关键词:Hadoop、大数据、分布式系统、HDFS、MapReduce、YARN、数据处理架构

摘要:在数据爆炸的时代,“大数据”已从概念变为日常。当你的手机相册存满10万张照片、电商平台每天产生10亿条交易记录时,单台电脑就像用小勺子舀大海——根本忙不过来。Hadoop正是为解决这个”大海舀水”问题而生的分布式数据处理框架,它能让成百上千台普通电脑像一支军队一样协同工作,高效存储和处理海量数据。本文将用生活化的比喻和 step-by-step 的拆解,带你从”什么是Hadoop”到”如何动手搭建Hadoop系统”,最终掌握大数据处理的核心思维,为你的技术之旅插上翅膀。

背景介绍

目的和范围

想象一下:你经营着一家网红奶茶店,每天有10万顾客扫码点单,产生包括订单时间、购买口味、支付方式、用户位置在内的500万条数据。你想分析”哪些口味在周末下午最受欢迎”,但用Excel打开数据文件时直接卡死——这就是”大数据问题”:数据量超过了单台设备的处理能力。

本文的目的,就是带你彻底搞懂”Hadoop如何让100台普通电脑变成超级计算机”,具体包括:

Hadoop解决什么核心问题?它的”三大件”(HDFS、MapReduce、YARN)如何协同工作?如何亲手搭建Hadoop环境并运行第一个数据处理任务?Hadoop在实际业务中如何创造价值?

范围覆盖Hadoop的核心原理、架构设计、实战操作和应用场景,不涉及过于底层的源码细节(比如HDFS的C++通信模块),重点是”理解本质+动手实践”。

预期读者

无论你是:

刚接触大数据的程序员,想搞懂Hadoop到底是什么;数据分析岗同学,需要知道海量数据如何处理;产品经理/运营,想理解技术团队口中的”Hadoop集群”为何重要;甚至是对技术好奇的学生,想入门大数据领域;

只要你会用电脑、能看懂简单的逻辑(比如”如果…就…“),就能读懂本文。我们会把所有复杂概念都转化为生活中的例子,确保你”看完就能用”。

文档结构概述

本文就像一本”大数据烹饪指南”,章节安排如下:

背景介绍:为什么需要Hadoop(就像为什么需要微波炉而不是柴火灶);核心概念与联系:Hadoop的”三大件”是什么,如何配合(就像厨房的冰箱、灶台、抽油烟机);核心算法原理:MapReduce如何把复杂任务拆解(就像包饺子时”分工擀皮、包馅、煮饺子”);数学模型:分布式存储的副本策略如何保证数据安全(就像重要文件存U盘+云盘+邮箱);项目实战:从零搭建Hadoop环境并统计奶茶订单数据(手把手教你”开火做饭”);应用场景:Hadoop在电商、物流、科研中的真实案例(看看别人怎么”用Hadoop做大餐”);未来趋势:Hadoop的进化方向(就像微波炉升级为空气炸锅);总结与思考题:回顾核心知识并启发你进一步探索(学会了就自己”创新菜谱”)。

术语表

核心术语定义

| 术语 | 通俗解释 | 生活类比 |

|---|---|---|

| Hadoop | 分布式数据处理框架,能让多台电脑协同存储和处理海量数据 | 外卖平台的”配送调度系统”,协调多个骑手完成全城订单 |

| 分布式系统 | 多台独立电脑通过网络连接,像一台”虚拟超级电脑”工作 | 拔河比赛:单个人拉不动绳子,但20个人排成一队就能拉动 |

| HDFS | Hadoop分布式文件系统,负责存储海量数据 | 学校的”分布式图书馆”:一本书有3个副本,分别放在3个校区的图书馆,丢了一本还有两本 |

| MapReduce | 分布式数据处理算法框架,负责拆分和计算数据 | 班级分糖果:先按小组分(Map),再统计每个同学有多少颗(Reduce) |

| YARN | 资源管理器,负责分配电脑的CPU、内存给任务 | 公司的”行政主管”:根据各部门需求分配办公室、电脑等资源 |

| 集群 | 多台安装了Hadoop的电脑组成的”团队” | 篮球队:5个队员(5台电脑)各司其职,配合完成比赛(数据处理任务) |

相关概念解释

块(Block):HDFS存储数据的基本单位,默认128MB(可配置)。就像把一本1000页的书拆成10本100页的小册子,方便携带和分发。副本(Replica):HDFS为每个数据块存储多个备份(默认3个)。就像你拍了一张重要照片,同时存手机相册、云盘和电脑硬盘,防止丢失。NameNode:HDFS的”总管”,记录所有文件的存储位置(类似图书馆的”图书目录系统”)。DataNode:HDFS的”仓库管理员”,实际存储数据块(类似图书馆的”书架”,存放具体的书)。

缩略词列表

HDFS:Hadoop Distributed File System(Hadoop分布式文件系统)MR:MapReduce(分布式计算框架)YARN:Yet Another Resource Negotiator(资源管理器)HDP:Hortonworks Data Platform(Hadoop发行版之一)CDH:Cloudera Distribution Including Apache Hadoop(Hadoop发行版之一)

核心概念与联系

故事引入:从”奶茶店数据危机”到Hadoop

王小明的奶茶店火了。从每天100单到10万单,订单数据从”一个Excel文件”变成了”装满硬盘的文件夹”。他想分析”草莓奶茶在哪个区域卖得最好”,结果:

用Excel打开文件?程序直接崩溃(文件太大);换高配电脑?8核CPU+32G内存也卡到死机(数据量超过单机处理能力);找IT朋友帮忙?朋友说:“你需要Hadoop——让10台普通电脑一起干活。”

小明听不懂:“10台电脑怎么一起干活?它们怎么知道谁处理哪部分数据?数据丢了怎么办?”

这正是Hadoop解决的问题:把海量数据拆分成小块,分给多台电脑存储和计算,同时保证数据安全和任务有序执行。就像小明雇了10个兼职员工:有人负责整理订单数据(存储),有人负责统计每个区域的草莓奶茶销量(计算),还有人负责协调大家的分工(资源管理)。

核心概念解释(像给小学生讲故事一样)

核心概念一:HDFS(分布式文件系统)—— 数据的”超级仓库”

问题:单台电脑硬盘最多存20TB数据,100TB数据怎么存?

HDFS的解决方案:把数据拆成”小积木”(块),分给多台电脑存,每块还存多个”备份积木”(副本)。

生活例子:

想象你有1000个乐高积木(数据),要分给10个小朋友(电脑)保管:

拆分:把1000个积木分成100堆(每堆10个,即”块”);分配:每个小朋友拿10堆(共100个积木);备份:每堆积木再复制2份,分给另外两个小朋友(共3个备份);记录:找一个”记账本”(NameNode)记录”哪堆积木在哪个小朋友手里”。

这样,即使2个小朋友弄丢了积木(电脑故障),第3个小朋友还有备份;想玩某个积木时,查记账本就能找到在哪。

关键特性:

分块存储:默认每块128MB(为什么是128MB?后面数学模型部分解释);副本机制:默认存3个副本,提高安全性;主从架构:NameNode(总管)+ DataNode(仓库管理员)。

核心概念二:MapReduce(分布式计算框架)—— 数据的”流水线工厂”

问题:100TB订单数据,怎么统计”每个区域的草莓奶茶销量”?

MapReduce的解决方案:把计算任务拆成”分活儿”(Map)和”汇总”(Reduce)两步,多台电脑并行处理。

生活例子:

学校要统计全校1000个学生的”数学平均分”,老师的做法:

Map阶段(分活儿):

把学生按班级分成10组(10个班),每个班主任(Map任务)统计自己班的”总分”和”人数”;Reduce阶段(汇总):

教导主任(Reduce任务)收集10个班的”总分”和”人数”,计算全校总分÷总人数=平均分。

MapReduce就是这样:先”拆分任务到多台电脑并行计算”,再”汇总结果得到最终答案”。

关键特性:

分而治之:大任务拆成小任务,并行处理;无状态:每个Map/Reduce任务独立运行,互不干扰;适合批处理:处理大量历史数据(比如”昨天的所有订单”)。

核心概念三:YARN(资源管理器)—— 集群的”交通警察”

问题:10台电脑的CPU、内存有限,同时跑3个任务(统计销量、分析用户画像、生成报表),怎么分配资源?

YARN的解决方案:统一管理集群资源,根据任务需求分配CPU和内存,避免”抢资源打架”。

生活例子:

学校组织活动,有3个需求:

一年级要开运动会(需要操场、10个老师);二年级要考试(需要5间教室、5个老师);三年级要大扫除(需要清洁工具、3个老师);

教务处(YARN)的工作:

接收申请:各年级提交资源需求;分配资源:检查操场、教室、老师是否空闲,分配可用资源;监控执行:确保运动会、考试、大扫除不冲突,结束后回收资源。

YARN就是集群的”教务处”,确保每个任务(MapReduce、Spark等)都能公平、高效地使用资源。

关键组件:

ResourceManager:集群资源总管理者(教务处主任);NodeManager:单台电脑的资源管理者(各班班主任);ApplicationMaster:单个任务的资源协调者(活动负责人)。

核心概念之间的关系(用小学生能理解的比喻)

HDFS、MapReduce、YARN就像一个”大数据工厂”,三者分工明确、协同工作:

HDFS与MapReduce的关系:仓库与生产线

HDFS是”原材料仓库”:存储海量数据(比如奶茶订单的原始数据);MapReduce是”生产线”:从仓库取数据(原材料),加工成结果(比如”区域销量统计”);协作方式:MapReduce会就近读取HDFS中的数据(比如处理北京的订单,就优先读存储在北京DataNode的数据),减少数据传输(就像工厂把仓库建在生产线旁边,取料更快)。

MapReduce与YARN的关系:工人与调度员

MapReduce是”工人团队”:负责具体的计算任务(Map和Reduce);YARN是”调度员”:给工人分配”工具”(CPU、内存)和”工作区域”(节点);协作方式:MapReduce启动时,先向YARN申请资源(“我需要5个Map工人,每个2G内存”),YARN分配资源后,MapReduce才开始工作(就像工人先向调度员领工具,再开工)。

HDFS、MapReduce、YARN的整体关系:奶茶店的完整运营

| 角色 | HDFS | MapReduce | YARN |

|---|---|---|---|

| 奶茶店类比 | 仓库(存原料:牛奶、茶叶、糖) | 后厨(加工原料:煮茶、调奶茶) | 店长(安排谁煮茶、谁调饮、用哪个灶台) |

| 协作流程 | 1. 原料(数据)存入仓库(HDFS); | 2. 后厨(MapReduce)向店长(YARN)申请灶台(资源); | 3. 店长分配灶台,后厨从仓库取原料加工; |

核心概念原理和架构的文本示意图(专业定义)

HDFS架构

HDFS采用主从(Master-Slave)架构,包含两类节点:

NameNode(主节点):1个(或2个,用于高可用),负责:

管理文件系统元数据(文件名、路径、块信息、副本位置);处理客户端的文件读写请求(比如”告诉我文件A的块存在哪些DataNode上”);不存储实际数据,只存目录(类似图书馆的”索引卡片柜”)。

DataNode(从节点):多个(集群中的所有其他节点),负责:

存储实际数据块(Block);定期向NameNode汇报”心跳”(告诉总管”我还活着,存了这些块”);执行数据块的创建、删除、复制(根据NameNode的指令)。

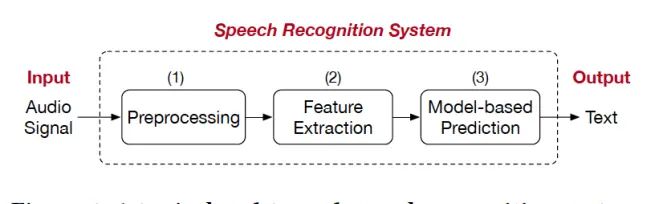

MapReduce架构(基于YARN)

MapReduce任务在YARN上运行,流程分为:

提交任务:客户端向YARN提交MapReduce程序;申请资源:YARN的ResourceManager分配一个容器(Container)启动ApplicationMaster;分配任务:ApplicationMaster向ResourceManager申请Map/Reduce任务所需的容器;执行任务:NodeManager在分配的容器中启动Map/Reduce进程,读取HDFS数据进行计算;汇总结果:Reduce任务汇总Map结果,输出最终答案到HDFS。

YARN架构

YARN的核心组件包括:

ResourceManager(RM):运行在主节点,负责集群资源的全局管理和分配;NodeManager(NM):运行在每个从节点,负责单节点的资源管理(CPU、内存)和任务监控;ApplicationMaster(AM):每个任务(如MapReduce作业)对应一个AM,负责向RM申请资源、协调任务执行;Container:资源分配的基本单位,包含CPU核心数、内存大小等(如”2核4G”的Container)。

Mermaid 流程图

图1:HDFS写文件流程

图2:MapReduce处理流程(以统计单词数量为例)

graph TD

A[输入数据:"hello world hello hadoop"] -->|拆分| B[分块1:"hello world"]

A -->|拆分| C[分块2:"hello hadoop"]

B -->|Map任务1| D[("hello:1", "world:1")]

C -->|Map任务2| E[("hello:1", "hadoop:1")]

D -->|洗牌Shuffle| F[按key分组:hello:1,1 | world:1 | hadoop:1]

E -->|洗牌Shuffle| F

F -->|Reduce任务| G[hello:2, world:1, hadoop:1]

G -->|输出结果| H[写入HDFS]

图3:YARN资源调度流程

核心算法原理 & 具体操作步骤

MapReduce核心算法:分而治之的艺术

MapReduce的核心思想可以用一句话概括:“把复杂问题拆分成多个简单问题,并行解决后汇总答案”。就像你要数清楚一袋大米有多少粒:直接数太难,不如分成10小堆,每堆数完后相加。

Map阶段:拆分任务,局部计算

目标:把输入数据拆分成”键值对”(Key-Value),进行初步处理。

操作步骤:

数据分片(Split):HDFS将输入文件拆分成多个Split(通常1个Split对应1个Block);映射(Map):每个Map任务处理1个Split,输出一系列键值对(如统计单词时,输出<单词, 1>)。

例子:统计句子”hello world hello hadoop”中每个单词的出现次数

Split:假设句子是1个Split(因为很短);Map函数:遍历每个单词,输出<单词, 1>,结果为(“hello”,1), (“world”,1), (“hello”,1), (“hadoop”,1)。

Shuffle阶段:数据整理,按Key分组

目标:把Map输出的键值对按Key分组,相同Key的Value放到一起(为Reduce阶段做准备)。

操作步骤:

排序(Sort):Map输出先按Key排序(如按字母顺序排列单词);分组(Group):相同Key的Value合并成列表(如”hello”的Value合并为[1,1])。

例子:

排序后:(“hadoop”,1), (“hello”,1), (“hello”,1), (“world”,1);分组后:(“hadoop”, [1]), (“hello”, [1,1]), (“world”, [1])。

Reduce阶段:汇总计算,输出结果

目标:对分组后的Value列表进行计算,得到最终结果。

操作步骤:

归约(Reduce):对每个Key对应的Value列表做聚合操作(如求和、计数);输出(Output):将最终键值对写入HDFS。

例子:

Reduce函数对每个Key的Value列表求和:

“hadoop”: 1 → (“hadoop”, 1)

“hello”: 1+1=2 → (“hello”, 2)

“world”: 1 → (“world”, 1)

用Python实现简易MapReduce(WordCount)

Hadoop原生用Java开发,但我们可以用Python的

mrjob

步骤1:安装mrjob

pip install mrjob # 安装MapReduce简化库

步骤2:编写WordCount代码(wordcount.py)

from mrjob.job import MRJob

class MRWordCount(MRJob):

# Map阶段:输入每行文本,输出(单词, 1)

def mapper(self, _, line):

# 分割单词(简单处理:按空格分割,忽略标点)

words = line.strip().split()

for word in words:

# 输出键值对:(单词, 1)

yield word.lower(), 1 # lower()确保大小写不敏感(如"Hello"和"hello"算同一个单词)

# Reduce阶段:输入(单词, [1,1,...]),输出(单词, 总数)

def reducer(self, word, counts):

# 对counts列表求和(counts是生成器,需要累加)

total = sum(counts)

yield word, total

if __name__ == '__main__':

MRWordCount.run() # 启动任务

步骤3:运行代码并查看结果

准备输入文件(input.txt):

hello world

hello hadoop

hadoop is big data

本地运行(模拟MapReduce):

python wordcount.py input.txt # 本地模式运行

输出结果:

"big" 1

"data" 1

"hadoop" 2

"hello" 2

"is" 1

"world" 1

代码解读:

mapper

line

(单词, 1)

reducer

1

counts

(单词, 总数)

mrjob

Hadoop集群上运行MapReduce任务

当你有了Hadoop集群,运行WordCount的步骤如下(以伪分布式为例):

将输入文件上传到HDFS:

hdfs dfs -mkdir /input # 在HDFS创建/input目录

hdfs dfs -put input.txt /input # 上传本地文件到HDFS

运行Hadoop自带的WordCount示例:

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.4.jar wordcount /input /output

(

$HADOOP_HOME

/output

查看结果:

hdfs dfs -cat /output/part-r-00000 # 查看结果文件

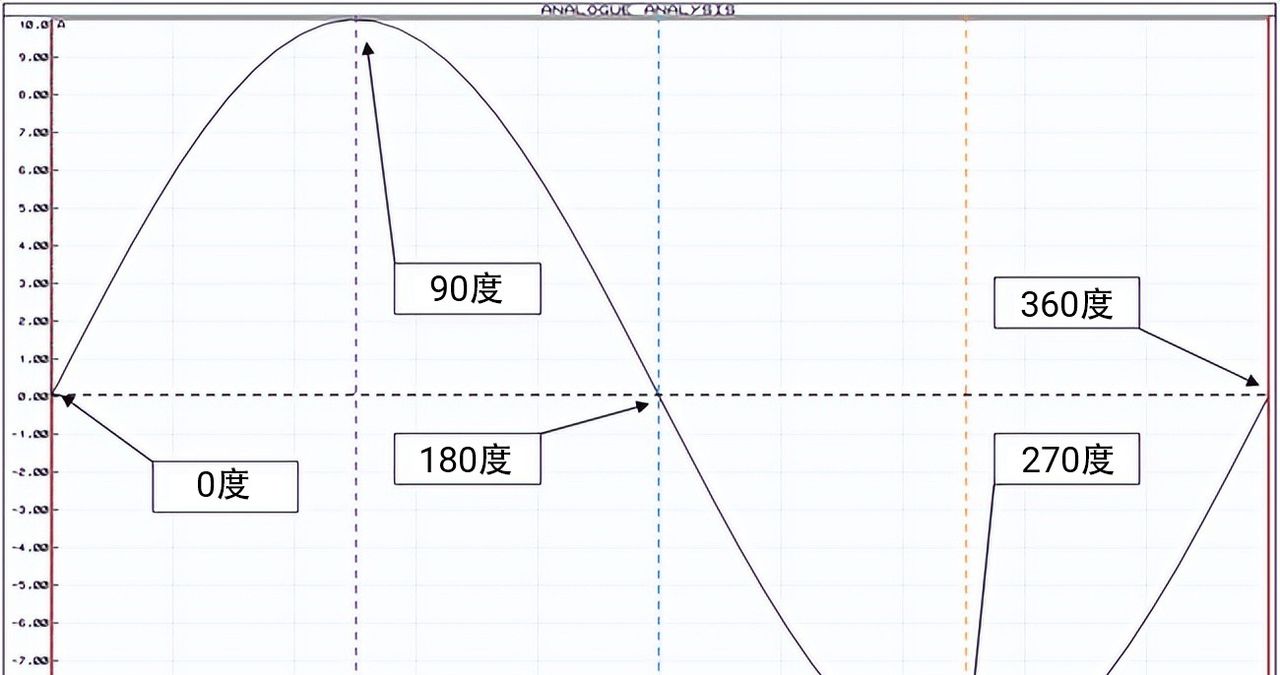

数学模型和公式 & 详细讲解 & 举例说明

HDFS块大小的数学依据:为什么默认是128MB?

HDFS把文件拆分成块(Block)存储,默认块大小是128MB(Hadoop 2.x及以上,之前是64MB)。这个数值不是随便定的,而是基于**“数据传输时间 vs 寻址时间”**的权衡。

核心公式:传输效率 = 数据传输时间 / (寻址时间 + 数据传输时间)

寻址时间(Seek Time):找到数据在硬盘上的位置所需时间,约为10ms(机械硬盘的物理磁头移动时间);数据传输时间(Transfer Time):传输数据的时间,取决于硬盘传输速度(假设100MB/s)。

假设块大小为

B

传输时间 =

B / 100

10B

效率 =

10B / (10 + 10B)

B / (1 + B)

目标:效率达到99%以上

当效率≥99%时:

B / (1 + B) ≥ 0.99

→

B ≥ 99

Hadoop选择128MB(略大于99MB),既保证效率(128/(1+128)≈99.2%),又避免块过大导致的”小文件问题”(块太小会增加NameNode的元数据负担)。

副本放置策略:如何保证数据安全又高效?

HDFS默认存储3个副本,放置策略如下(基于”机架感知”):

副本1:存放在客户端所在节点(如果客户端不在集群内,随机选一个节点);副本2:存放在与副本1不同机架的随机节点(跨机架,防止单个机架故障);副本3:存放在与副本2相同机架的不同节点(同机架,减少跨机架带宽消耗);更多副本:随机分配(通常不需要)。

数学依据:容错性与成本的平衡

假设单个节点故障概率为

p

q

q << p

3副本的丢失概率 =

p^3 + q^2

p^2 + q

因此,3副本是”安全性-成本”的最优平衡点。

MapReduce任务并行度计算:多少个Map/Reduce任务最合适?

Map任务数量

Map任务数量由输入数据的Split数决定,公式:

Map数 = 输入数据总大小 / Split大小

(Split大小默认等于Block大小,即128MB)

例子:输入数据1GB(1024MB),Split大小128MB → Map数=1024/128=8个。

Reduce任务数量

Reduce任务数量可手动设置(通过

mapreduce.job.reduces

Reduce数 = min(集群节点数 * 2, 输入数据总大小 / 1GB)

例子:10节点集群,输入数据5GB → Reduce数=min(20,5)=5个(每个Reduce处理约1GB数据)。

为什么不设太多Reduce?

Reduce之间需要Shuffle数据(跨节点传输),数量过多会导致网络拥堵;每个Reduce会生成1个输出文件,过多文件不利于后续处理。

项目实战:代码实际案例和详细解释说明

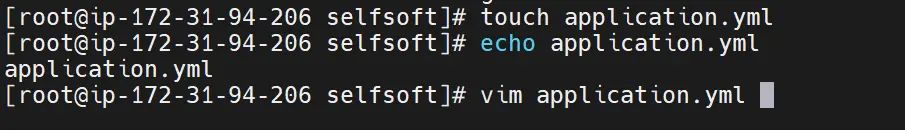

开发环境搭建:3步搞定Hadoop伪分布式环境

伪分布式是在单台电脑上模拟Hadoop集群(1个NameNode+1个DataNode+1个NodeManager),适合学习和开发。

准备工作

操作系统:Linux(推荐Ubuntu 20.04)或macOS;软件:Java 8(Hadoop 3.x需要Java 8/11)、SSH(用于免密登录)。

步骤1:安装Java和SSH

# 安装Java 8

sudo apt update && sudo apt install openjdk-8-jdk -y

java -version # 验证安装,输出"openjdk version 1.8.0_xxx"

# 安装SSH并配置免密登录(Hadoop节点间通信需要)

sudo apt install openssh-server -y

ssh-keygen -t rsa -P "" -f ~/.ssh/id_rsa # 生成密钥对(一路回车)

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys # 授权本机登录

ssh localhost # 测试免密登录,无需密码即可登录

步骤2:下载并配置Hadoop

# 下载Hadoop 3.3.4(稳定版)

wget https://dlcdn.apache.org/hadoop/common/hadoop-3.3.4/hadoop-3.3.4.tar.gz

tar -zxvf hadoop-3.3.4.tar.gz && mv hadoop-3.3.4 ~/hadoop # 解压到用户目录

# 配置环境变量(~/.bashrc)

echo 'export HADOOP_HOME=~/hadoop' >> ~/.bashrc

echo 'export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin' >> ~/.bashrc

source ~/.bashrc # 生效配置

hadoop version # 验证安装,输出Hadoop版本信息

# 配置Hadoop(修改~/hadoop/etc/hadoop下的文件)

# 1. hadoop-env.sh:设置Java路径

echo 'export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64' >> ~/hadoop/etc/hadoop/hadoop-env.sh

# 2. core-site.xml:配置HDFS地址和临时目录

cat > ~/hadoop/etc/hadoop/core-site.xml << EOF

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value> <!-- HDFS地址:本机9000端口 -->

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/tmp/hadoop</value> <!-- 临时文件目录 -->

</property>

</configuration>

EOF

# 3. hdfs-site.xml:配置副本数量和NameNode/DataNode目录

cat > ~/hadoop/etc/hadoop/hdfs-site.xml << EOF

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value> <!-- 伪分布式只有1个DataNode,副本数设为1 -->

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///home/$USER/hadoop/data/namenode</value> <!-- NameNode数据目录 -->

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///home/$USER/hadoop/data/datanode</value> <!-- DataNode数据目录 -->

</property>

</configuration>

EOF

# 4. mapred-site.xml:配置MapReduce使用YARN

cat > ~/hadoop/etc/hadoop/mapred-site.xml << EOF

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value> <!-- 使用YARN作为资源管理器 -->

</property>

</configuration>

EOF

# 5. yarn-site.xml:配置YARN节点和资源

cat > ~/hadoop/etc/hadoop/yarn-site.xml << EOF

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value> <!-- 启用MapReduce洗牌服务 -->

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>localhost</value> <!-- YARN资源管理器地址 -->

</property>

</configuration>

EOF

步骤3:启动Hadoop集群

# 格式化NameNode(首次启动时执行,仅一次)

hdfs namenode -format

# 启动HDFS和YARN

start-dfs.sh # 启动HDFS(NameNode+DataNode)

start-yarn.sh # 启动YARN(ResourceManager+NodeManager)

# 检查进程是否启动成功(应看到6个进程)

jps

# 输出示例:

# 1234 NameNode

# 5678 DataNode

# 9012 SecondaryNameNode

# 3456 ResourceManager

# 7890 NodeManager

# 2345 Jps

# 访问Web界面(验证集群状态)

# HDFS界面:http://localhost:9870 (可查看文件系统、DataNode状态)

# YARN界面:http://localhost:8088 (可查看任务运行状态)

源代码详细实现和代码解读:奶茶订单数据分析

假设我们有奶茶店的订单数据(order_data.csv),格式如下:

订单ID,用户ID,购买时间,口味,地区,价格

1001,user01,2023-10-01 14:30,草莓奶茶,北京,18

1002,user02,2023-10-01 15:10,珍珠奶茶,上海,15

1003,user03,2023-10-01 16:20,草莓奶茶,北京,18

...

我们要分析”各地区的草莓奶茶销量和总销售额”,用MapReduce实现。

步骤1:编写Java MapReduce程序(StrawberrySalesAnalyzer.java)

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import java.io.IOException;

import java.util.StringTokenizer;

public class StrawberrySalesAnalyzer {

// Map阶段:过滤草莓奶茶订单,输出(地区, "销量:1,金额:价格")

public static class SalesMapper extends Mapper<LongWritable, Text, Text, Text> {

private Text region = new Text(); // 输出Key:地区

private Text salesInfo = new Text(); // 输出Value:"销量:1,金额:价格"

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 跳过表头(第一行)

if (key.get() == 0) {

return;

}

// 解析CSV行(简单分割,实际场景建议用CSV解析库)

String line = value.toString();

String[] fields = line.split(","); // 按逗号分割字段

// 检查字段数是否正确(6个字段)

if (fields.length != 6) {

return; // 跳过格式错误的数据

}

String flavor = fields[3].trim(); // 口味(第4列)

String area = fields[4].trim(); // 地区(第5列)

String priceStr = fields[5].trim();// 价格(第6列)

// 只处理"草莓奶茶"订单

if ("草莓奶茶".equals(flavor)) {

try {

double price = Double.parseDouble(priceStr); // 价格转数字

region.set(area); // 设置Key为地区

salesInfo.set("1," + price); // Value格式:"销量,金额"

context.write(region, salesInfo); // 输出键值对

} catch (NumberFormatException e) {

// 价格格式错误,跳过该条数据

return;

}

}

}

}

// Reduce阶段:汇总各地区的销量和金额

public static class SalesReducer extends Reducer<Text, Text, Text, Text> {

private Text result = new Text(); // 输出结果:"总销量,总金额"

@Override

protected void reduce(Text key, Iterable<Text> values, Context context) throws IOException, InterruptedException {

int totalSales = 0; // 总销量

double totalAmount = 0.0; // 总金额

// 遍历该地区的所有订单数据

for (Text val : values) {

String[] parts = val.toString().split(","); // 分割"销量,金额"

int sales = Integer.parseInt(parts[0]);

double amount = Double.parseDouble(parts[1]);

totalSales += sales;

totalAmount += amount;

}

// 格式化结果(保留2位小数)

result.set(totalSales + "," + String.format("%.2f", totalAmount));

context.write(key, result); // 输出:(地区, "总销量,总金额")

}

}

// 主函数:配置并启动MapReduce任务

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "草莓奶茶地区销售分析"); // 任务名称

job.setJarByClass(StrawberrySalesAnalyzer.class);

job.setMapperClass(SalesMapper.class); // 设置Mapper类

job.setReducerClass(SalesReducer.class); // 设置Reducer类

job.setOutputKeyClass(Text.class); // 输出Key类型:Text(地区)

job.setOutputValueClass(Text.class); // 输出Value类型:Text(销量,金额)

FileInputFormat.addInputPath(job, new Path(args[0])); // 输入路径(HDFS)

FileOutputFormat.setOutputPath(job, new Path(args[1])); // 输出路径(HDFS,必须不存在)

// 等待任务完成并退出

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

步骤2:编译和打包程序

# 创建工作目录

mkdir -p ~/hadoop-projects/sales-analysis/src/main/java

cd ~/hadoop-projects/sales-analysis

# 将Java代码保存到上述目录

# ...(省略保存代码步骤,假设已保存为StrawberrySalesAnalyzer.java)

# 编译代码(需要Hadoop依赖包,使用hadoop classpath获取依赖)

javac -classpath $(hadoop classpath) src/main/java/StrawberrySalesAnalyzer.java -d target/classes

# 打包成JAR文件

jar -cvf sales-analyzer.jar -C target/classes/ .

步骤3:运行任务并查看结果

上传输入数据到HDFS:

# 本地创建测试数据(order_data.csv)

cat > order_data.csv << EOF

订单ID,用户ID,购买时间,口味,地区,价格

1001,user01,2023-10-01 14:30,草莓奶茶,北京,18

1002,user02,2023-10-01 15:10,珍珠奶茶,上海,15

1003,user03,2023-10-01 16:20,草莓奶茶,北京,18

1004,user04,2023-10-01 17:00,草莓奶茶,上海,18

1005,user05,2023-10-01 18:30,草莓奶茶,北京,18

EOF

# 上传到HDFS

hdfs dfs -mkdir /sales-input

hdfs dfs -put order_data.csv /sales-input

运行MapReduce任务:

hadoop jar sales-analyzer.jar StrawberrySalesAnalyzer /sales-input /sales-output

查看结果:

hdfs dfs -cat /sales-output/part-r-00000

输出结果:

北京 3,54.00

上海 1,18.00

(解释:北京销售3杯草莓奶茶,总金额54元;上海销售1杯,总金额18元)

代码解读

Mapper类:

过滤非草莓奶茶订单,只处理目标数据;输出键值对:

(地区, "1,价格")

Reducer类:

对同一地区的所有

"1,价格"

主函数:

配置任务名称、Mapper/Reducer类、输入输出路径等;提交任务到YARN集群运行。

实际应用场景

Hadoop已成为大数据处理的”基础设施”,在各行各业发挥着重要作用,以下是几个典型场景:

1. 电商平台:用户行为分析与推荐系统

业务需求:淘宝、京东等平台每天产生数亿条用户行为数据(浏览、点击、加购、购买),需要分析”用户喜欢什么商品”,从而推送个性化推荐。

Hadoop解决方案:

HDFS:存储用户行为日志(如点击流数据,每天TB级);MapReduce/Hive:分析用户偏好(如”25-30岁女性用户最近7天点击最多的5类商品”);结果应用:将分析结果输入推荐算法(如协同过滤),生成”猜你喜欢”列表。

案例:亚马逊通过Hadoop分析用户购买历史和浏览记录,推荐商品的点击率提升了35%。

2. 金融行业:风控与欺诈检测

业务需求:银行需要实时监控信用卡交易,识别异常交易(如”异地大额消费+频繁小额转账”可能是盗刷)。

Hadoop解决方案:

HDFS:存储历史交易数据(结构化数据+非结构化日志);Spark on YARN:实时处理流数据(Spark Streaming),结合历史数据训练欺诈检测模型;HBase:存储高频访问的交易特征(如用户最近10笔交易记录),支持毫秒级查询。

案例:美国运通使用Hadoop集群处理每天50TB交易数据,欺诈交易识别率提升了20%,每年减少损失数亿美元。

3. 物流行业:路径优化与配送效率提升

业务需求:顺丰、菜鸟物流每天有千万级快递单,需要优化配送路径(如”同区域快递合并配送”、“避开交通拥堵路线”)。

Hadoop解决方案:

HDFS:存储快递单数据(收件地址、重量、时效要求)和地理数据(道路、小区位置);MapReduce:批量计算区域快递密度(如”北京朝阳区每平方公里快递数量”);Hive:分析历史配送数据,找出最优配送路线模板(如”上午送写字楼,下午送居民区”)。

案例:菜鸟网络通过Hadoop分析物流数据,将全国快递平均配送时效从48小时缩短到36小时。

4. 科研领域:基因数据分析

业务需求:人类基因组约30亿个碱基对,单个样本数据量达100GB,需要分析基因序列中的突变(如癌症相关基因突变)。

Hadoop解决方案:

HDFS:存储海量基因数据(多个样本的DNA测序文件);MapReduce:并行比对基因序列(将样本序列与参考基因组比对,寻找差异);HBase:存储比对结果,支持科研人员快速查询特定基因区域的突变情况。

案例:美国国立卫生研究院(NIH)使用Hadoop集群处理10万份癌症患者基因数据,加速了癌症致病基因的发现。

工具和资源推荐

Hadoop生态系统工具

Hadoop本身

相关文章