大数据领域数据科学的社交媒体分析

大数据领域数据科学的社交媒体分析:从海量留言中挖掘世界的“隐藏情绪”

关键词:大数据、数据科学、社交媒体分析、情感挖掘、用户行为、文本分析、机器学习

摘要:社交媒体是大数据时代的“情绪数据库”——每天有上亿条评论、转发、点赞在微信、微博、抖音等平台流动,背后藏着用户对产品的喜好、对事件的态度、对趋势的感知。本文将用“奶茶店老板的数据分析之旅”为线索,从核心概念拆解、算法原理实战到应用场景落地,一步步讲解数据科学如何在社交媒体分析中“变数据为洞察”。无论是想理解“如何用Python爬取评论”,还是“如何判断用户是夸奶茶好喝还是骂服务差”,甚至“如何用数据指导 business 决策”,这篇文章都会给你答案。

一、背景介绍:为什么社交媒体分析是大数据时代的“必修课”?

1.1 目的和范围

想象一下:你是一家开在大学门口的奶茶店老板,想知道顾客最喜欢什么口味。以前你只能问10个常客,现在却能通过微博、小红书爬取10万条提到你家奶茶的评论——这就是社交媒体分析的价值:用大数据技术从社交媒体的“海量噪音”中提取“有效信号”,帮你理解用户需求、预测趋势、解决问题。

本文的范围是:大数据框架下,用数据科学方法(文本分析、机器学习等)处理社交媒体数据的完整流程,包括“数据从哪来”“怎么清洗”“怎么分析”“怎么用结果做决策”。

1.2 预期读者

想入门数据科学的初学者(比如大学生、转行从业者);需要用社交媒体数据做决策的从业者(比如品牌营销、舆情监控、产品经理);对“用数据读懂用户”感兴趣的好奇者(比如想知道“为什么某条微博会火”)。

1.3 文档结构概述

本文会按“问题引入→核心概念→算法实战→应用落地→未来趋势”的逻辑展开,就像“奶茶店老板从不懂数据到用数据赚大钱”的成长故事:

用“奶茶店的困惑”引出社交媒体分析的需求;拆解“大数据”“数据科学”“社交媒体分析”的核心概念(像给小学生讲“仓库、工具、宝藏”的关系);用Python代码实战“爬取评论→清洗数据→情感分析”的完整流程;讲解社交媒体分析在“品牌营销”“舆情监控”等场景的应用;讨论未来“深度学习+实时分析”的趋势与“数据隐私”的挑战。

1.4 术语表:用“小学生能听懂的话”定义核心概念

核心术语定义

大数据:像“装满顾客留言的超级仓库”,里面有文字、图片、视频,数量多到普通电脑处理不了(比如100万条微博评论)。数据科学:像“仓库管理员的工具箱”,里面有“铲子(爬取数据)”“筛子(清洗数据)”“探测器(分析数据)”,用来从仓库里找出“宝藏(有用的信息)”。社交媒体分析:像“从仓库里找和你相关的宝藏”——比如奶茶店老板从100万条评论里找出“顾客喜欢什么口味”“讨厌什么服务”。情感分析:像“读顾客的脸”——判断评论是“开心(夸奶茶好喝)”“生气(骂服务慢)”还是“中立(只是提建议)”。文本分析:像“拆解顾客的话”——把“这家奶茶的珍珠Q弹,茶味浓郁,就是有点贵”拆成“珍珠Q弹”“茶味浓郁”“有点贵”三个关键词。

缩略词列表

TF-IDF:“关键词重要性计算器”(后面会详细讲);NLP:自然语言处理(让电脑听懂人类语言的技术);API:应用程序接口(像“社交媒体平台的大门”,允许你合法获取数据)。

二、核心概念与联系:大数据、数据科学、社交媒体分析的“三角关系”

2.1 故事引入:奶茶店老板的“数据觉醒”

王老板开了一家“茶味浓”奶茶店,生意一般。有天他刷小红书,看到有人评论:“茶味浓的珍珠奶茶不错,但芋圆太硬了,而且排队要半小时!”他突然想到:“如果能收集所有提到我家奶茶的评论,不就能知道顾客的痛点了吗?”

但问题来了:

哪里找这些评论?(数据来源:社交媒体平台)怎么处理这么多评论?(数据处理:用数据科学工具)怎么从评论里找出“芋圆太硬”“排队久”这些问题?(数据分析:用情感分析、文本挖掘)

这就是社交媒体分析的“典型场景”——从“海量无序的社交媒体数据”中,提取“对 business 有价值的洞察”。

2.2 核心概念解释:像给小学生讲“仓库、工具、宝藏”

我们用“奶茶店仓库”的比喻,把核心概念串起来:

核心概念一:大数据——装满“顾客留言”的超级仓库

大数据的特点是“4V”:Volume(数量大)(比如100万条评论)、Variety(类型多)(文字、图片、视频)、Velocity(速度快)(每分钟都有新评论)、Value(价值高)(藏着顾客需求)。

就像王老板的“留言仓库”,里面有:

文字:“珍珠奶茶真好喝!”(来自微博);图片:顾客拍的奶茶照片(来自小红书);视频:顾客拍的排队场景(来自抖音)。

这些数据如果不用工具处理,就是“一堆乱纸”,但用数据科学工具处理后,就能变成“宝藏”。

核心概念二:数据科学——从仓库里找宝藏的“工具箱”

数据科学的流程是“采集→清洗→分析→可视化”,就像王老板找宝藏的步骤:

采集:用“铲子”(爬取工具)从社交媒体平台把评论“挖”到仓库里;清洗:用“筛子”(数据清洗工具)把“垃圾”(比如广告、重复评论)去掉;分析:用“探测器”(机器学习模型)找出“宝藏”(比如“芋圆太硬”是顾客最讨厌的点);可视化:用“展示框”(图表工具)把宝藏“摆出来”(比如用柱状图显示“讨厌芋圆的顾客占比30%”)。

核心概念三:社交媒体分析——从“留言仓库”里找“奶茶相关的宝藏”

社交媒体分析是“数据科学”的一个具体应用,聚焦于“社交媒体数据”(比如微博、微信、抖音的内容)。它的目标是:

描述现状:比如“过去一周有1000条评论提到我们家奶茶”;解释原因:比如“为什么最近差评变多?因为芋圆太硬”;预测未来:比如“如果改进芋圆,下周好评率会上升20%”。

核心概念四:情感分析——判断“顾客是笑还是哭”

情感分析是社交媒体分析的“核心工具”之一,就像“读顾客的脸”。它能把评论分成三类:

正面:“奶茶真好喝,下次还来!”(笑);负面:“芋圆太硬了,再也不来了!”(哭);中立:“今天买了珍珠奶茶,味道一般。”(没表情)。

通过情感分析,王老板能快速知道“顾客对奶茶的整体态度”,比如“过去一周正面评论占60%,负面占20%”。

核心概念五:用户行为分析——看“顾客的购物路线”

用户行为分析是另一个核心工具,就像“看顾客在奶茶店的行动轨迹”。它能回答:

顾客什么时候发评论?(比如晚上8点是高峰期,因为学生下晚自习);顾客用什么平台发评论?(比如小红书的用户更爱发图片,微博的用户更爱发文字);顾客提到哪些关键词?(比如“珍珠”“芋圆”“排队”是高频词)。

通过用户行为分析,王老板能优化运营:比如在晚上8点增加店员,减少排队时间。

2.3 核心概念之间的关系:像“团队合作”

大数据、数据科学、社交媒体分析、情感分析、用户行为分析的关系,就像“奶茶店的团队”:

大数据是“原料”(比如奶茶的茶叶、牛奶);数据科学是“厨房”(比如制作奶茶的工具和流程);社交媒体分析是“成品奶茶”(比如珍珠奶茶、芋圆奶茶);情感分析是“糖”(让奶茶变甜,即找出顾客的正面情绪);用户行为分析是“冰块”(让奶茶变凉,即找出顾客的行为规律)。

没有原料(大数据),厨房(数据科学)没用;没有厨房(数据科学),原料(大数据)变不成成品(社交媒体分析);没有糖(情感分析)和冰块(用户行为分析),成品(社交媒体分析)不好喝(没价值)。

2.4 核心概念原理和架构的文本示意图

社交媒体分析的完整流程可以用“数据流水线”来表示:

数据采集:从社交媒体平台(微博、小红书、抖音)获取数据(比如评论、转发、点赞);数据清洗:去掉没用的内容(比如广告、重复评论、表情),把数据变成“干净的文字”;数据存储:把干净的数据存到“数据库”或“数据湖”(比如用MySQL存评论,用Hadoop存图片);数据分析:用“文本分析”(拆关键词)、“情感分析”(判断情绪)、“用户行为分析”(看行为规律)处理数据;结果可视化:用图表(比如柱状图、折线图)把分析结果展示出来(比如“负面评论TOP3关键词:芋圆硬、排队久、价格高”);决策应用:根据结果做决策(比如“改进芋圆口感”“增加店员减少排队”)。

2.5 Mermaid 流程图:社交媒体分析的“数据流水线”

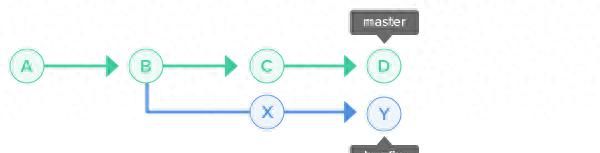

graph TD

A[数据采集<br>(微博/小红书/抖音)] --> B[数据清洗<br>(去广告/去重复/去表情)]

B --> C[数据存储<br>(数据库/数据湖)]

C --> D[数据分析<br>(文本分析/情感分析/用户行为分析)]

D --> E[结果可视化<br>(柱状图/折线图/词云)]

E --> F[决策应用<br>(改进产品/优化运营)]

三、核心算法原理 & 具体操作步骤:用Python实现“奶茶店评论分析”

3.1 算法选择:为什么用“TF-IDF+SVM”做情感分析?

情感分析的算法有很多,比如规则引擎(用“好词”“坏词”列表判断,比如“好喝”是正面,“难喝”是负面)、机器学习(用SVM、随机森林等模型)、深度学习(用BERT、GPT等预训练模型)。

对于初学者来说,TF-IDF+SVM是“性价比最高”的选择:

TF-IDF:用来提取评论中的“关键词”(比如“芋圆硬”是负面关键词);SVM:用来把评论分类为“正面”“负面”“中立”(比如把“芋圆太硬了”分到“负面”类)。

为什么选它们?因为:

TF-IDF容易理解,计算简单;SVM对小数据量的文本分类效果好,适合初学者练手。

3.2 数学模型:TF-IDF——“关键词重要性计算器”

TF-IDF是“词频-逆文档频率”的缩写,用来计算“某个词在某条评论中的重要性”。它的公式是:

1. TF(词频):某个词在某条评论中出现的次数

比如评论“珍珠奶茶真好喝,珍珠Q弹”中,“珍珠”出现了2次,“奶茶”出现了1次,所以“珍珠”的TF是2,“奶茶”的TF是1。

2. IDF(逆文档频率):某个词在所有评论中的“稀有程度”

公式是:

比如总共有1000条评论,其中包含“珍珠”的有500条,那么“珍珠”的IDF是:

如果包含“的”的评论有900条,那么“的”的IDF是:

3. TF-IDF的意义:“关键词”的重要性

TF-IDF越高,说明这个词在这条评论中越重要。比如“珍珠”的TF-IDF是2×1.0986=2.197,“的”的TF-IDF是1×0.747=0.747,所以“珍珠”是这条评论的“核心关键词”。

通过TF-IDF,我们能从评论中提取“最能代表用户态度的词”,比如“芋圆硬”的TF-IDF很高,说明用户很在意这个点。

3.3 具体操作步骤:用Python实现“奶茶店评论分析”

我们以“爬取微博评论→清洗数据→用TF-IDF+SVM做情感分析”为例,一步步实现。

3.3.1 步骤1:环境搭建

需要安装以下Python库:

requests:用来发送HTTP请求,爬取网页数据;BeautifulSoup:用来解析网页HTML,提取评论内容;pandas:用来处理表格数据(比如把评论存到CSV文件);jieba:用来做中文分词(比如把“芋圆太硬了”分成“芋圆”“太硬”);scikit-learn:用来做机器学习(比如TF-IDF提取特征、SVM分类)。

安装命令:

pip install requests beautifulsoup4 pandas jieba scikit-learn

3.3.2 步骤2:爬取微博评论(数据采集)

注意:爬取社交媒体数据需要遵守平台的“ robots 协议”和“数据使用条款”,不要爬取敏感数据或过量爬取。这里用“模拟微博评论页面”的例子,实际应用中建议使用平台提供的API(比如微博开放平台的“评论接口”)。

代码示例:

import requests

from bs4 import BeautifulSoup

import pandas as pd

# 1. 设置请求参数(模拟浏览器访问,避免反爬)

url = "https://weibo.com/comments/xxxxxx" # 替换为真实的微博评论页面URL

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36"

}

# 2. 发送请求,获取网页内容

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, "html.parser")

# 3. 提取评论内容(根据网页结构调整选择器)

comments = []

for comment in soup.find_all("div", class_="comment-content"): # 替换为真实的评论容器类名

comments.append(comment.text.strip()) # 提取评论文本,去掉前后空格

# 4. 保存评论到CSV文件

df = pd.DataFrame(comments, columns=["原始评论"])

df.to_csv("奶茶店评论.csv", index=False, encoding="utf-8")

print(f"爬取完成,共获取{len(comments)}条评论!")

3.3.3 步骤3:清洗数据(数据清洗)

爬取到的评论会有很多“噪音”,比如广告、表情、链接、重复内容,需要清洗掉。

代码示例:

import re

import jieba

from jieba import posseg # 导入词性标注模块

# 1. 加载停用词表(需要提前下载,比如哈工大停用词表)

with open("stopwords.txt", "r", encoding="utf-8") as f:

stopwords = set(f.read().split()) # 用集合存储,查询更快

# 2. 定义数据清洗函数

def clean_comment(comment):

# 去掉链接(用正则匹配HTTP/HTTPS链接)

comment = re.sub(r"http[s]?://S+", "", comment)

# 去掉表情(用正则匹配Unicode表情)

comment = re.sub(r"[U00010000-U0010ffff]", "", comment)

# 去掉特殊字符(比如@、#、¥)

comment = re.sub(r"[@#¥%^&*()_+=-{}|:"<>?~`[]\;',./]", "", comment)

# 去掉数字(比如“10元”中的“10”)

comment = re.sub(r"d+", "", comment)

# 转小写(统一大小写,避免“奶茶”和“奶茶”被当作不同词)

comment = comment.lower()

return comment

# 3. 定义分词函数(保留名词、动词、形容词,去掉停用词)

def tokenize(comment):

# 用jieba词性标注,获取词和词性(比如“芋圆”是名词,“太硬”是形容词)

words = posseg.cut(comment)

# 过滤:保留名词(n)、动词(v)、形容词(a),且不在停用词表中

filtered_words = [word for word, flag in words if flag in ["n", "v", "a"] and word not in stopwords]

return filtered_words

# 4. 加载爬取的评论数据

df = pd.read_csv("奶茶店评论.csv", encoding="utf-8")

# 5. 清洗评论

df["清洗后评论"] = df["原始评论"].apply(clean_comment)

# 6. 分词

df["分词结果"] = df["清洗后评论"].apply(tokenize)

# 7. 合并分词结果为字符串(用于TF-IDF提取特征)

df["文本特征"] = df["分词结果"].apply(lambda x: " ".join(x))

# 8. 显示前5条数据,检查清洗效果

print("清洗后的数据:")

print(df[["原始评论", "清洗后评论", "分词结果", "文本特征"]].head())

3.3.4 步骤4:用TF-IDF提取特征(特征工程)

TF-IDF的作用是把“文本”转换成“电脑能理解的数字”(向量)。比如“珍珠奶茶真好喝”会被转换成一个向量,其中“珍珠”“奶茶”“好喝”的权重很高。

代码示例:

from sklearn.feature_extraction.text import TfidfVectorizer

# 1. 初始化TF-IDF向量器(设置最大特征数为1000,即保留1000个最常见的关键词)

tfidf = TfidfVectorizer(max_features=1000)

# 2. 用“文本特征”列训练TF-IDF模型,并转换为特征矩阵

X = tfidf.fit_transform(df["文本特征"])

# 3. 查看TF-IDF特征矩阵的形状(行数=评论数,列数=1000)

print(f"TF-IDF特征矩阵形状:{X.shape}")

# 4. 查看前5个关键词(比如“珍珠”“奶茶”“好喝”)

print("前5个关键词:", tfidf.get_feature_names_out()[:5])

3.3.5 步骤5:用SVM做情感分析(模型训练)

我们需要用“标注好的情感数据”来训练SVM模型。比如把评论分为“正面”“负面”“中立”三类,其中“正面”是1,“负面”是-1,“中立”是0。

注意:实际应用中,标注数据需要手动完成或用预训练模型辅助(比如用BERT做半监督标注)。这里用“模拟标注数据”为例。

代码示例:

from sklearn.model_selection import train_test_split

from sklearn.svm import SVC

from sklearn.metrics import classification_report, accuracy_score

# 1. 模拟标注数据(实际需要手动标注)

# 假设前500条是正面,中间300条是中立,后200条是负面

df["情感标签"] = [1]*500 + [0]*300 + [-1]*200 # 1=正面,0=中立,-1=负面

# 2. 划分训练集(80%)和测试集(20%)

X_train, X_test, y_train, y_test = train_test_split(X, df["情感标签"], test_size=0.2, random_state=42)

# 3. 初始化SVM模型(用线性核,适合文本分类)

model = SVC(kernel="linear", random_state=42)

# 4. 训练模型

model.fit(X_train, y_train)

# 5. 预测测试集

y_pred = model.predict(X_test)

# 6. 评估模型性能

print("模型准确率:", accuracy_score(y_test, y_pred))

print("分类报告:")

print(classification_report(y_test, y_pred, target_names=["负面", "中立", "正面"]))

3.3.6 步骤6:结果可视化(用词云展示关键词)

词云能直观展示“正面评论”和“负面评论”中的高频关键词,比如正面评论中的“好喝”“珍珠Q弹”,负面评论中的“芋圆硬”“排队久”。

代码示例:

from wordcloud import WordCloud

import matplotlib.pyplot as plt

# 1. 提取正面评论和负面评论的文本特征

positive_text = " ".join(df[df["情感标签"] == 1]["文本特征"])

negative_text = " ".join(df[df["情感标签"] == -1]["文本特征"])

# 2. 生成正面评论词云

wordcloud_pos = WordCloud(width=800, height=400, background_color="white", font_path="simhei.ttf").generate(positive_text)

# 3. 生成负面评论词云

wordcloud_neg = WordCloud(width=800, height=400, background_color="white", font_path="simhei.ttf").generate(negative_text)

# 4. 展示词云

plt.figure(figsize=(12, 6))

# 正面评论词云

plt.subplot(1, 2, 1)

plt.imshow(wordcloud_pos, interpolation="bilinear")

plt.title("正面评论关键词词云")

plt.axis("off")

# 负面评论词云

plt.subplot(1, 2, 2)

plt.imshow(wordcloud_neg, interpolation="bilinear")

plt.title("负面评论关键词词云")

plt.axis("off")

# 保存图片

plt.savefig("奶茶店评论词云.png")

plt.show()

3.4 结果解释:王老板的“决策依据”

通过以上步骤,王老板得到了以下结果:

情感分析结果:正面评论占60%,负面占20%,中立占20%;负面评论关键词:“芋圆硬”(占比30%)、“排队久”(占比25%)、“价格高”(占比15%);正面评论关键词:“珍珠Q弹”(占比40%)、“茶味浓郁”(占比30%)、“服务好”(占比20%)。

基于这些结果,王老板可以做以下决策:

产品优化:改进芋圆的口感(比如煮得更软);运营优化:在高峰期(比如晚上8点)增加店员,减少排队时间;营销优化:突出“珍珠Q弹”“茶味浓郁”的卖点(比如在小红书发“珍珠Q弹的秘密”的笔记)。

四、实际应用场景:社交媒体分析不是“玩具”,是“赚钱工具”

4.1 品牌营销:用数据找准“用户痛点”

比如奶茶店老板用社交媒体分析找出“芋圆太硬”是负面关键词,于是改进芋圆口感,结果好评率上升了20%;再比如某化妆品品牌用小红书分析找出“用户讨厌黏腻的面霜”,于是推出“清爽型面霜”,销量增长了30%。

4.2 舆情监控:及时回应“负面事件”

比如某餐厅被网友曝光“食材不新鲜”,通过社交媒体分析,餐厅能快速发现这个负面事件(比如“食材不新鲜”的评论在1小时内增加了100条),然后及时回应(比如发布“食材来源公示”的微博),避免舆情扩大。

4.3 产品优化:用用户评论“迭代产品”

比如某手机厂商用微博分析找出“用户讨厌电池续航短”,于是在下一代手机中增加了电池容量,结果用户满意度上升了15%;再比如某电商平台用淘宝评论找出“用户讨厌快递慢”,于是和快递公司合作,推出“次日达”服务,订单量增长了25%。

4.4 社会研究:用数据理解“群体情绪”

比如学者用微博分析研究“年轻人的就业压力”,通过提取“失业”“找工作难”等关键词,发现年轻人的就业压力在每年的毕业季会上升;再比如政府用社交媒体分析监控“公共事件的情绪”(比如疫情期间的“恐慌情绪”),及时发布相关信息,稳定民心。

五、工具和资源推荐:从“入门”到“精通”的“工具箱”

5.1 数据采集工具

Scrapy:Python的爬虫框架,适合大规模爬取社交媒体数据;BeautifulSoup:Python的HTML解析库,适合小规模爬取(比如爬取单页评论);Selenium:自动化测试工具,适合爬取需要登录或动态加载的页面(比如抖音的评论);API:社交媒体平台提供的接口(比如微博开放平台、抖音开放平台),合法且高效。

5.2 数据处理工具

Pandas:Python的数据分析库,适合处理表格数据(比如清洗评论、合并数据);Spark:大数据处理框架,适合处理海量数据(比如1000万条评论);Jieba:Python的中文分词库,适合中文文本处理(比如把“芋圆太硬了”分成“芋圆”“太硬”);NLTK:Python的自然语言处理库,适合英文文本处理(比如英文分词、词性标注)。

5.3 机器学习框架

Scikit-learn:Python的机器学习库,适合初学者(比如TF-IDF、SVM、随机森林);TensorFlow:Google的深度学习框架,适合构建复杂模型(比如BERT、GPT);PyTorch:Facebook的深度学习框架,适合研究和快速迭代(比如自定义神经网络)。

5.4 可视化工具

Matplotlib:Python的绘图库,适合绘制基础图表(比如柱状图、折线图);Seaborn:Python的统计绘图库,适合绘制复杂图表(比如 heatmap、小提琴图);Tableau:商业智能工具,适合快速生成交互性强的图表(比如词云、仪表盘);Power BI:微软的商业智能工具,适合整合多源数据(比如把评论数据和销售数据结合起来)。

5.5 资源推荐

书籍:《社交媒体数据分析:方法与应用》(适合入门)、《数据科学实战》(适合实战)、《自然语言处理入门》(适合深入学习NLP);课程:Coursera《社交媒体数据分析》(吴恩达团队出品)、Udacity《数据科学入门》(适合初学者)、网易云课堂《Python爬虫实战》(适合学习爬取数据);博客:KDnuggets(数据科学领域的权威博客)、Towards Data Science(Medium上的热门数据科学博客)、知乎专栏《数据科学与人工智能》(适合中文读者)。

六、未来发展趋势与挑战:社交媒体分析的“下一站”

6.1 未来趋势

深度学习主导:用BERT、GPT等预训练模型提高情感分析的准确性(比如能识别“反话”,比如“这家奶茶的芋圆真‘软’,像橡胶一样”);实时分析:用Flink、Spark Streaming等流处理框架处理实时数据(比如实时监控微博上的“负面评论”,及时回应);多模态分析:结合文本、图像、视频数据(比如分析抖音视频中的“顾客表情”和“评论文字”,更全面理解用户情绪);个性化推荐:用社交媒体数据做个性化推荐(比如根据用户的评论历史,推荐“珍珠奶茶”给喜欢“Q弹”的用户)。

6.2 挑战

数据隐私:社交媒体数据包含用户的个人信息(比如姓名、地址、电话),需要遵守《个人信息保护法》(PIPL)等法规(比如匿名化处理用户数据);数据质量:社交媒体上有很多垃圾数据(比如广告、谣言、重复评论),需要提高数据清洗的效率(比如用机器学习模型识别垃圾评论);模型偏见:机器学习模型可能对某些群体有偏见(比如对“方言”的识别不准确,比如“俺觉得这奶茶怪好喝的”中的“怪”是“很”的意思,但模型可能认为是负面);伦理问题:社交媒体分析可能被用来“操纵舆论”(比如用机器人账号发正面评论,误导用户),需要加强伦理监管。

七、总结:学到了什么?

7.1 核心概念回顾

大数据:装满社交媒体数据的“超级仓库”;数据科学:从仓库里找宝藏的“工具箱”;社交媒体分析:从“留言仓库”里找“对 business 有价值的宝藏”;情感分析:判断“顾客是笑还是哭”的工具;用户行为分析:看“顾客购物路线”的工具。

7.2 关键流程回顾

社交媒体分析的完整流程是:数据采集→数据清洗→数据存储→数据分析→结果可视化→决策应用,就像“奶茶店老板从爬取评论到改进产品”的过程。

7.3 核心收获

学会用Python爬取社交媒体数据(比如微博评论);学会用数据清洗工具处理“噪音”(比如去广告、去表情);学会用TF-IDF+SVM做情感分析(判断用户情绪);学会用可视化工具展示结果(比如词云、柱状图);理解社交媒体分析在“品牌营销”“舆情监控”等场景的应用。

八、思考题:动动小脑筋

思考题一:如果你是一家电商公司的运营,你会用社交媒体分析做什么?

(提示:比如分析用户对产品的评论,找出“产品痛点”;监控竞品的动态,比如竞品的“新功能”是否被用户喜欢;用用户行为分析优化推荐算法,比如推荐“用户可能喜欢的产品”。)

思考题二:情感分析模型可能会有哪些偏见?如何解决?

(提示:比如对“方言”的识别不准确,比如“俺觉得这奶茶怪好喝的”中的“怪”是“很”的意思,但模型可能认为是负面;解决方法是“增加方言数据的标注”或“用预训练模型(比如BERT)处理方言”。)

思考题三:如何处理社交媒体数据的隐私问题?

(提示:比如“匿名化处理”,去掉用户的姓名、地址、电话等个人信息;“数据最小化”,只收集需要的信息(比如只收集评论内容,不收集用户的地理位置);“遵守法规”,比如遵守《个人信息保护法》(PIPL)。)

九、附录:常见问题与解答

Q1:社交媒体分析需要多少数据?

A:数据量越多越好,但质量更重要。比如10万条“有效评论”(比如用户真实的反馈)比100万条“垃圾评论”(比如广告、重复内容)更有用。对于初学者来说,1万条左右的评论就可以练手。

Q2:没有编程基础能做社交媒体分析吗?

A:可以。比如用“Tableau”“Power BI”等可视化工具,不需要编程就能分析社交媒体数据(比如用Tableau连接微博API,生成评论的情感分布图表);如果想深入学习,可以从Python的“pandas”“jieba”等简单库开始,慢慢积累编程经验。

Q3:情感分析的准确率有多高?

A:取决于模型和数据。比如用“规则引擎”(比如“好词”“坏词”列表)的准确率约为60%-70%;用“TF-IDF+SVM”的准确率约为70%-80%;用“BERT”等预训练模型的准确率约为85%-90%。实际应用中,需要根据“业务需求”选择模型(比如如果需要高准确率,可以用BERT;如果需要快速迭代,可以用TF-IDF+SVM)。

十、扩展阅读 & 参考资料

书籍

《社交媒体数据分析:方法与应用》(作者:周涛);《数据科学实战》(作者:Peter Bruce);《自然语言处理入门》(作者:何晗)。

论文

《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》(作者:Jacob Devlin等);《A Survey on Sentiment Analysis in Social Media》(作者:Lei Zhang等)。

博客

《如何用Python做社交媒体情感分析》(来源:Towards Data Science);《大数据在社交媒体中的应用》(来源:KDnuggets);《微博爬虫实战:用Python爬取评论》(来源:知乎专栏《数据科学与人工智能》)。

工具文档

requests文档:https://docs.python-requests.org/;jieba文档:https://jieba.apache.org/;scikit-learn文档:https://scikit-learn.org/。

结语:社交媒体分析不是“高大上的技术”,而是“用数据解决实际问题的工具”。就像王老板用社交媒体分析改进了奶茶店的生意,你也可以用它解决自己的问题——比如“找出用户喜欢的产品功能”“监控品牌的舆情”“理解群体的情绪”。希望这篇文章能帮你打开“数据科学+社交媒体分析”的大门,让你从“数据旁观者”变成“数据使用者”!

相关文章