提示工程架构师避坑指南:初学者提升提示可访问性的12个核心误区与解决路径

元数据框架

标题

提示工程架构师避坑指南:初学者提升提示可访问性的12个核心误区与解决路径

关键词

提示工程、提示可访问性、AI交互设计、自然语言处理(NLP)、提示优化、用户认知负荷、意图对齐

摘要

提示工程的核心价值,是搭建人类意图与AI能力的高效桥梁。而“提示可访问性”则是这座桥梁的“通行标准”——它不仅要求AI能“理解”提示,更要求人类用户能轻松编写、修改、验证提示,并稳定触发预期结果。

本文针对初学者在提升提示可访问性时最易陷入的12个误区,结合第一性原理分析、信息论模型与真实案例,拆解每个误区的底层逻辑,提供可落地的解决路径。无论你是刚入门的提示设计新手,还是想优化现有提示体系的架构师,都能从本文中获得“知其然更知其所以然”的实践指南。

1. 概念基础:重新理解“提示可访问性”

在展开误区分析前,我们需要先澄清三个核心问题——什么是提示工程?什么是提示可访问性?为什么它对初学者至关重要?

1.1 提示工程的本质:意图传递的“翻译器”

提示工程(Prompt Engineering)不是“让AI做什么”的指令编写,而是将人类的模糊需求转化为AI可解析的结构化信息的过程。其本质是:

人类意图 → 提示设计 → AI能力 → 预期结果

例如,当你想让AI“写一篇关于环保的文章”时,优秀的提示会将模糊的“环保”拆解为:

目标用户(中学生)内容结构(3个论点:减少塑料使用、推广公共交通、种植本土植物)约束条件(用2023年联合国数据支撑、语言风格严肃但易懂)输出格式(500字议论文,分段落标注论点)

1.2 提示可访问性的定义:从“AI友好”到“人机双友好”

很多初学者认为“提示可访问性”=“AI能听懂”,这是致命的窄化理解。真正的提示可访问性需满足三个维度:

用户可理解性:非技术用户能轻松看懂提示的意图与要求;修改灵活性:用户能快速调整提示的参数(如目标用户、输出长度),无需重新编写;结果稳定性:相同提示在不同场景下能触发一致的AI输出,减少“意外结果”。

简言之,提示可访问性的目标是:让提示成为“活的工具”,而非“一次性指令”。

1.3 初学者的核心矛盾:“想精确”但“不会结构化”

初学者的常见困境是:

为了“精确”,添加大量无关细节(如个人经历、情绪描述),导致AI抓不住重点;为了“简洁”,省略关键约束(如输出格式、目标用户),导致结果偏离预期;混淆“指令”与“建议”(如用“可能”“试试”代替“必须”),导致AI执行不到位。

这些问题的根源,是缺乏对“提示结构”与“用户认知”的系统理解——而这正是本文要解决的核心。

2. 理论框架:用第一性原理拆解提示可访问性

要解决提示可访问性的问题,我们需要从最底层的逻辑出发,建立可复用的分析框架。

2.1 第一性原理:提示的“信息传递模型”

根据信息论(Information Theory),提示的本质是传递“意图信息”的载体。其有效性可通过两个指标衡量:

信息熵(Entropy):提示的不确定性。熵越高,AI解析的难度越大(比如“写一篇好文章”的熵远高于“写一篇500字的中学生环保议论文”);互信息(Mutual Information):提示与预期结果的相关性。互信息越高,意图传递的损耗越小。

数学形式化表达:

设人类意图为集合 ( I ),提示为 ( P ),AI输出为 ( O ),则提示的可访问性 ( A ) 可定义为:

( I(P;O) ):提示与输出的互信息(相关性);( H§ ):提示的信息熵(不确定性)。

结论:要提升可访问性,需增加互信息(明确约束)并降低熵(减少模糊)。

2.2 竞争范式:指令式vs对话式vs模板式提示

不同的提示范式,其可访问性差异显著:

| 范式 | 定义 | 可访问性优势 | 可访问性劣势 | 适用场景 |

|---|---|---|---|---|

| 指令式 | 直接下达任务(如“写总结”) | 简洁 | 模糊、结果不稳定 | 简单任务(如生成列表) |

| 对话式 | 逐步引导(如“先告诉我主题,再细化结构”) | 灵活、用户友好 | 效率低、依赖上下文 | 复杂任务(如创意写作) |

| 模板式 | 固定结构+变量替换(如“为{产品}写{用户}的说明”) | 可复用、结果稳定 | 灵活性低 | 标准化任务(如产品描述) |

初学者的误区:过度依赖指令式提示,忽略模板式提示的可访问性优势——模板式提示通过“结构化变量”,既降低了用户的认知负荷,又保证了结果的稳定性。

2.3 理论局限性:AI的“能力边界”约束

提示可访问性的提升,不能突破AI本身的能力边界。例如:

若AI不支持多模态输出(如图文混合),你再优化“生成带图的文章”提示也无济于事;若AI的上下文窗口(Context Window)仅支持4k token,你写10k token的提示会被截断,导致前面的信息失效。

结论:提示设计的第一步,是了解你使用的AI模型的能力边界。

3. 架构设计:提示的“五脏六腑”——可访问性的结构基础

要避免误区,首先要明确提示的标准结构。一个高可访问性的提示,需包含以下5个核心组件(如图1所示):

图1:高可访问性提示的组件交互模型

3.1 组件1:意图陈述——“我要什么”(核心)

意图陈述是提示的“灵魂”,需满足单一性与具体性:

单一性:一次提示只解决一个核心问题(如“写产品说明”而非“写产品说明+做市场分析”);具体性:用“动作+对象”结构(如“生成→面向年轻人的→无线耳机→产品说明”)。

反例:“我想写一篇关于科技的文章”(模糊、多义);

正例:“生成一篇面向大学生的、关于AI在教育中应用的500字议论文”(具体、单一)。

3.2 组件2:目标用户——“写给谁/给谁用”

目标用户决定了提示的语言风格与内容深度。例如:

面向普通用户:避免技术术语(如用“手机电量能用一天”代替“续航24小时”);面向开发者:可使用专业术语(如用“支持RESTful API”代替“可以对接其他系统”)。

3.3 组件3:约束条件——“不能做什么/必须做什么”

约束条件是降低信息熵的关键,需覆盖内容、风格、伦理三个维度:

内容约束:“用2023年联合国环境署的数据”;风格约束:“语言口语化,避免学术腔”;伦理约束:“禁止包含性别刻板印象”。

3.4 组件4:输出格式——“结果长什么样”

输出格式是保证结果稳定性的核心。常见的格式要求包括:

结构:“分3段,每段1个论点”;格式:“输出JSON,包含title、content、keywords三个字段”;长度:“500字以内”。

3.5 组件5:示例参考——“给你看个样子”

示例参考(Few-Shot Learning)是提升可访问性的“加速器”——通过1-3个示例,让用户和AI快速理解“预期结果”。例如:

示例1:

产品名称:轻便无线耳机

目标用户:通勤族

输出:“这款耳机重量仅50g,挂在脖子上像戴了条项链。通勤时听音乐,续航24小时,再也不用怕没电。”

示例需满足相关性与多样性:

相关性:示例需匹配当前任务(如写产品说明的示例不能用写诗歌的);多样性:避免示例的偏差(如不能只选“女性通勤族”的示例)。

4. 初学者的12个核心误区:现象、原理、解决路径

接下来,我们逐一拆解初学者最易陷入的12个误区——每个误区都包含现象描述、底层原理、真实案例与解决步骤。

误区1:把“复杂”等同于“精确”——冗余信息干扰AI解析

现象描述

初学者为了“让AI更明白”,会在提示中添加大量无关细节,比如:

“我今天心情很好,想写一篇关于猫的文章。我家的猫叫咪咪,昨天钻了快递箱,特别可爱。要求内容有趣,有科学依据,比如猫的夜视能力,还要用生动的例子……”

结果:AI输出的文章包含大量“咪咪钻快递箱”的细节,而“猫的夜视能力”等核心内容被忽略。

底层原理:信息冗余导致熵增

根据信息论,无关信息会增加提示的熵(不确定性)。AI的注意力机制(Attention Mechanism)会优先处理“高频出现”的信息(如“咪咪钻快递箱”),而忽略“低频但重要”的信息(如“猫的夜视能力”)。

真实案例

某电商运营者想让AI生成“无线耳机”的产品说明,提示中加入了“我昨天丢了旧耳机,所以想写新耳机的便携性”。结果AI输出的说明里反复提到“丢耳机的经历”,而“便携性”的核心卖点仅用一句话带过。

解决步骤:用“最小必要信息”原则精简提示

提取核心意图:生成无线耳机的产品说明;保留必要约束:目标用户(通勤族)、核心卖点(轻便、长续航)、风格(口语化);删除无关信息:个人丢耳机的经历、情绪描述。

优化后提示:

“请为一款面向通勤族的无线耳机生成产品说明,要求突出以下2点:1. 重量仅50g的轻便性;2. 续航24小时的长待机。语言风格口语化,避免技术术语。”

误区2:忽略用户的“认知负荷”——用技术术语“劝退”非专业用户

现象描述

初学者常犯的错误是:用自己熟悉的技术术语写提示,忽略用户的认知水平。例如:

“请生成一个RESTful API的文档,包含endpoint、request body、response schema,并用Swagger格式输出。”

结果:非技术用户(如产品经理)看不懂“RESTful API”“Swagger”等术语,无法修改或使用提示。

底层原理:认知负荷理论(Cognitive Load Theory)

人类的工作记忆容量有限(约4-7个信息单元)。当提示中包含过多陌生术语时,用户需要花费额外的认知资源去理解术语,从而忽略提示的核心意图。

真实案例

某教育公司的提示设计中,要求AI“生成符合布卢姆 taxonomy的课后习题”。结果老师反馈:“不知道布卢姆 taxonomy是什么,无法调整习题难度。”

解决步骤:用“用户语言”替换技术术语

用户调研:了解目标用户的知识背景(如老师的教育术语认知);术语转换:将技术术语翻译成用户能理解的语言(如“布卢姆 taxonomy”→“从记忆到应用的5个难度层级”);添加解释:若必须用术语,需在提示中给出简洁定义(如“Swagger格式:一种可视化的API文档标准”)。

优化后提示:

“请生成符合‘从记忆到应用’5个难度层级的课后习题(注:‘记忆’指背诵知识点,‘应用’指用知识点解决问题),要求每个难度层级有2道题,输出格式为表格(包含题目、难度、答案)。”

误区3:缺乏“输出格式约束”——结果五花八门无法复用

现象描述

初学者常忽略输出格式的要求,比如:

“请总结这篇文章的核心观点。”

结果:AI可能输出1段长文本、3个 bullet points,或1个表格——用户无法将结果直接导入Excel或文档。

底层原理:格式歧义导致互信息下降

输出格式是提示与结果的“契约”。若没有格式约束,AI的输出可能偏离用户的“复用需求”(如导入表格、对接系统),导致互信息(相关性)下降。

真实案例

某数据分析团队让AI总结用户反馈,提示中未规定格式。结果AI输出的文本无法直接导入BI工具,团队不得不花2小时手动整理。

解决步骤:明确“结构化输出”要求

定义格式类型:根据复用需求选择格式(如表格、JSON、列表);给出示例:用1个示例展示预期格式;添加验证规则:要求AI检查格式是否符合要求(如“若输出不是JSON,请重新生成”)。

优化后提示:

“请总结以下用户反馈的核心观点,输出格式为JSON,包含3个字段:

key_point(核心观点,字符串)frequency(出现次数,数字)example(用户原话示例,字符串)

示例:

{

“key_point”: “耳机续航太短”,

“frequency”: 15,

“example”: “昨天用了2小时就没电了,根本不够通勤用”

}”

误区4:少样本示例的“偏差传递”——用有偏示例导致AI输出偏见

现象描述

初学者选择示例时,常忽略多样性,比如:

“请生成关于护士的文章,示例:‘护士小姐温柔地照顾病人’。”

结果:AI输出的文章中,护士均为女性,且强调“温柔”——强化了性别刻板印象。

底层原理:示例的“分布偏差”

AI的少样本学习(Few-Shot Learning)依赖示例的分布代表性。若示例仅覆盖某一群体(如女性护士),AI会认为“这是唯一的正确模式”,从而输出有偏结果。

真实案例

某招聘平台用AI生成岗位描述,示例中“工程师”岗位的示例均为男性。结果AI生成的“工程师”岗位描述中,频繁出现“抗压能力强”“适合男性”等表述,导致女性申请者减少30%。

解决步骤:构建“无偏示例库”

多样性检查:确保示例覆盖不同性别、年龄、场景;偏差测试:用“反向示例”验证(如用“男护士照顾病人”的示例,看AI是否能生成无偏结果);迭代优化:定期更新示例库,移除有偏示例。

优化后提示:

“请生成关于护士的文章,要求包含不同性别的示例:

示例1:‘男护士小张用专业的手法为病人打针’;

示例2:‘女护士小李耐心地解答病人的疑问’。”

误区5:混淆“指令”与“建议”——用模糊措辞降低执行率

现象描述

初学者常使用“可能”“试试”等建议性词汇,比如:

“你可以试试写一篇关于环保的文章,可能用一些数据。”

结果:AI可能忽略“用数据”的要求,输出没有数据支撑的文章。

底层原理:指令的“语力”(Illocutionary Force)

根据言语行为理论(Speech Act Theory),“指令”(如“必须”“请”)的语力远高于“建议”(如“可能”“试试”)。AI的语义解析模型会优先执行“语力强”的指令。

真实案例

某内容团队让AI生成“产品评测”,提示中用“可以加入用户评价”。结果80%的输出没有用户评价,团队不得不重新修改提示。

解决步骤:用“祈使句”替代“建议句”

明确指令:用“必须”“请”“需要”等强语力词汇;删除模糊词:去掉“可能”“试试”“大概”等不确定词汇;添加后果:若需要,可说明“不执行的后果”(如“若没有数据,请说明原因”)。

优化后提示:

“请写一篇关于环保的文章,必须包含2023年联合国环境署的塑料使用数据,语言风格严肃易懂。”

误区6:忽略“上下文窗口限制”——长提示导致信息丢失

现象描述

初学者常写超长提示(如超过AI的上下文窗口),比如:

“请分析这篇10000字的论文,总结核心观点……(附上完整论文)”

结果:AI的上下文窗口(如GPT-3.5的4k token)无法容纳全部内容,导致前面的论文内容被截断,AI仅分析了最后1000字。

底层原理:上下文窗口的“有限记忆”

AI的上下文窗口是固定大小的“滑动窗口”——当提示超过窗口大小时,最早的信息会被“挤出”,无法被AI处理。例如,GPT-3.5的4k token约等于3000字,若提示包含5000字,前2000字会被忽略。

真实案例

某科研团队让AI分析一篇5000字的论文,提示中附上了完整论文。结果AI输出的总结仅覆盖了论文的最后一部分,导致团队误解了论文的核心观点。

解决步骤:精简提示,利用“摘要+关键词”

计算窗口大小:先查询AI模型的上下文窗口(如GPT-4的8k/32k token);精简内容:用摘要(如论文的“摘要+结论”)代替完整文本;提取关键词:将核心概念(如“注意力机制”“Transformer”)作为提示的补充。

优化后提示:

“请分析以下论文的核心观点,论文摘要:‘本文提出了一种基于注意力机制的Transformer模型,用于提升机器翻译的准确性……’,核心关键词:注意力机制、Transformer、机器翻译。要求总结3个核心贡献,输出格式为bullet points。”

误区7:“意图漂移”——一个提示解决多个问题

现象描述

初学者常在一个提示中包含多个意图,比如:

“请写一篇关于环保的文章,还要做一个PPT大纲,再给出推广方案。”

结果:AI可能只解决其中一个问题(如写文章),或三个问题都解决得很粗糙。

底层原理:意图的“单一性原则”

AI的注意力机制是单任务导向的——当提示包含多个意图时,AI的注意力会被分散,无法深度处理每个任务。

真实案例

某市场团队让AI“写产品文案+设计海报+制定推广计划”,结果AI输出的文案冗长,海报描述模糊,推广计划缺乏细节。

解决步骤:拆分提示,采用“渐进式设计”

拆分意图:将多个任务拆分为独立的提示(如“写产品文案”“设计海报大纲”“制定推广计划”);渐进引导:用前一个提示的结果作为后一个提示的输入(如用“产品文案”的核心卖点作为“海报设计”的提示);保持一致性:在拆分的提示中保持“目标用户”“核心卖点”等约束的一致。

优化后提示链:

提示1:“请写一篇面向年轻人的无线耳机产品文案,突出轻便和长续航,语言口语化。”提示2:“请根据以下产品文案设计海报大纲,核心卖点:‘重量50g’‘续航24小时’,风格:活力、简约。”提示3:“请根据以下海报大纲制定推广计划,目标渠道:小红书、抖音,预算:5000元。”

误区8:缺乏“错误处理”——没考虑AI的“幻觉”(Hallucination)

现象描述

初学者常忽略AI的“幻觉”问题(即生成虚假信息),比如:

“请写一篇关于量子计算的文章,用最新的数据。”

结果:AI生成的文章中提到“2023年谷歌实现了1000量子比特的芯片”——而实际上谷歌2023年的量子芯片仅为72 qubit。

底层原理:AI的“生成逻辑” vs “事实核查”

AI的生成模型是基于统计规律的预测,而非“事实核查”。当提示中没有“错误处理”约束时,AI会生成“看起来合理但不符合事实”的内容。

真实案例

某媒体用AI生成“2023年科技趋势”的文章,结果AI提到“特斯拉推出了续航1000公里的电动车”——而特斯拉2023年的最高续航仅为637公里,导致文章被读者投诉。

解决步骤:添加“验证与纠错”约束

要求来源:让AI标注信息的来源(如“数据来自2023年特斯拉官网”);添加怀疑机制:让AI说明“不确定的内容”(如“若无法确认数据来源,请标注‘待核实’”);后处理验证:用工具(如FactCheck.org)验证AI输出的事实性。

优化后提示:

“请写一篇关于量子计算的文章,用2023年的最新数据,要求:

每个数据都标注来源(如“谷歌2023年量子芯片报告”);若无法确认数据的准确性,请标注‘待核实’;语言风格通俗易懂,避免学术术语。”

误区9:“过度抽象”——用笼统概念代替具体标准

现象描述

初学者常使用笼统的概念,比如:

“请写一篇好的文章。”

结果:AI无法理解“好”的标准(是结构清晰?还是语言生动?),输出的文章不符合用户预期。

底层原理:抽象概念的“语义模糊性”

笼统的概念(如“好”“有趣”“专业”)没有明确的语义边界,AI无法将其转化为可执行的操作。例如,“好文章”对不同用户的定义可能是:

学生:结构清晰、有论点;作家:语言生动、有情感;学者:数据支撑、逻辑严谨。

真实案例

某学生让AI“写一篇好的议论文”,结果AI输出的文章语言生动但没有论点,学生不得不重新修改提示。

解决步骤:用“具体标准”替代笼统概念

拆解抽象概念:将“好”拆解为可衡量的标准(如“结构清晰”→“分3段,每段1个论点”);量化要求:用数字或具体描述(如“有趣”→“包含2个真实案例”);参考示例:用示例展示“好”的标准(如“像《少年中国说》那样有感染力”)。

优化后提示:

“请写一篇关于‘中学生应该减少手机使用’的议论文,要求:

结构:开头点题、中间3个论点(影响学习、伤害眼睛、减少社交)、结尾呼吁;内容:每个论点用1个真实案例(如“我同学因为玩手机成绩下降20名”);语言:严肃但易懂,避免骂人的话。”

误区10:忽略“用户角色差异”——同一个提示给所有人用

现象描述

初学者常设计“通用提示”,忽略用户角色的差异,比如:

“请生成产品说明。”

结果:开发者用这个提示生成的说明包含大量技术术语,而普通用户用这个提示生成的说明太笼统,无法满足需求。

底层原理:用户角色的“需求差异”

不同角色的用户,对提示的理解能力与需求重点不同:

开发者:需要技术细节(如“支持蓝牙5.3”);营销人员:需要卖点提炼(如“续航24小时”);普通用户:需要使用场景(如“通勤时能用一天”)。

真实案例

某产品团队设计了“通用提示”生成产品说明,结果开发者反馈“没有技术参数”,营销人员反馈“没有卖点”,普通用户反馈“看不懂”。

解决步骤:根据角色定制提示模板

用户分群:将用户分为不同角色(如开发者、营销人员、普通用户);定制变量:为每个角色设计专属变量(如开发者的“技术参数”、营销人员的“核心卖点”);动态生成:用模板引擎(如Jinja2)根据用户角色动态生成提示。

优化后提示模板:

开发者版:“请生成{产品}的技术说明,包含{技术参数}(如蓝牙版本、电池容量),语言风格专业。”营销人员版:“请生成{产品}的营销说明,突出{核心卖点}(如轻便、长续航),语言风格口语化。”普通用户版:“请生成{产品}的使用说明,解释{使用场景}(如通勤、运动),语言风格简单易懂。”

误区11:“静态提示”——写好后不再优化

现象描述

初学者常将提示视为“一次性产物”,写好后不再修改,比如:

“请生成关于‘元宇宙’的文章。”

结果:随着元宇宙概念的发展(如2023年苹果推出Vision Pro),旧提示生成的文章内容过时,无法满足用户需求。

底层原理:提示的“时效性”与“迭代性”

AI模型的训练数据是静态的(如GPT-4的训练数据截止到2023年10月),而现实世界是动态发展的。若提示不迭代,生成的内容会“过时”或“不符合新需求”。

真实案例

某科技媒体用2022年的提示生成“元宇宙”文章,结果文章中没有提到2023年的Vision Pro,被读者吐槽“内容过时”。

解决步骤:建立“迭代优化流程”

收集反馈:通过用户调研、使用数据(如输出准确率、修改次数)收集提示的问题;定期更新:每月/季度更新提示的内容(如添加最新数据、调整约束条件);版本管理:用版本控制工具(如Git)管理提示的迭代历史,便于回滚。

优化后流程:

初始提示:“请生成关于元宇宙的文章,包含2022年的发展趋势。”收集反馈:用户要求“添加2023年的Vision Pro案例”;更新提示:“请生成关于元宇宙的文章,包含2023年苹果Vision Pro的案例,语言风格通俗易懂。”

误区12:混淆“提示可访问性”与“AI性能”——认为“好提示”能解决所有问题

现象描述

初学者常认为“只要提示设计得好,AI就能解决任何问题”,比如:

“请用AI预测下一期彩票号码。”

结果:AI无法预测随机事件,输出的号码完全错误。

底层原理:提示的“边界”——无法突破AI的能力限制

提示可访问性的提升,不能突破AI模型的固有能力。AI的能力边界包括:

随机性问题:无法预测彩票、股票等随机事件;常识问题:无法解决“永动机”等违反物理规律的问题;实时性问题:无法获取训练数据截止后的实时信息(如2024年的新闻)。

真实案例

某用户让AI“预测2024年世界杯冠军”,结果AI输出“巴西队”——而2024年世界杯的冠军是阿根廷队(假设),用户因此投诉AI“不准确”。

解决步骤:了解AI的“能力边界”

查询模型文档:了解AI的训练数据截止时间、能力范围(如GPT-4的文档说明“无法预测未来事件”);设置合理预期:不要求AI解决超出其能力的问题(如预测彩票);补充外部信息:若需要实时信息,用工具(如Web Search)补充提示的内容(如“结合2024年最新的世界杯热身赛数据,预测冠军”)。

优化后提示:

“请结合2024年世界杯热身赛的数据(如巴西队的胜率、阿根廷队的球员状态),分析哪支球队最有可能夺冠,要求说明分析逻辑,不保证预测准确。”

5. 实现机制:从理论到代码——高可访问性提示的工程化落地

要将上述理论转化为实践,我们需要工程化的实现机制——用代码、模板、工具提升提示的可访问性。

5.1 代码示例:用Python生成提示模板

我们可以用Python的字符串格式化或Jinja2模板引擎生成可复用的提示模板。例如,生成产品说明的模板:

from jinja2 import Template

def generate_product_prompt(product_name: str, target_audience: str, key_features: list, style: str) -> str:

# 定义Jinja2模板

template = Template("""

请为以下产品生成面向{{ target_audience }}的产品说明:

产品名称:{{ product_name }}

核心卖点:{{ key_features | join(', ') }}

语言风格:{{ style }}

要求:

1. 开头用一句吸引注意力的话;

2. 每个卖点用单独的段落解释;

3. 结尾包含呼吁行动(如“立即购买体验”)。

""")

# 渲染模板

prompt = template.render(

product_name=product_name,

target_audience=target_audience,

key_features=key_features,

style=style

)

return prompt

# 使用示例

prompt = generate_product_prompt(

product_name="轻便无线耳机",

target_audience="通勤族",

key_features=["重量50g", "续航24小时", "蓝牙5.3"],

)

print(prompt)

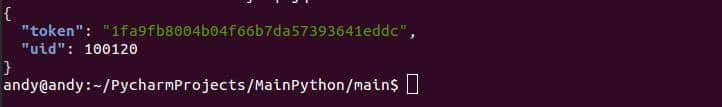

输出结果:

“请为以下产品生成面向通勤族的产品说明:

产品名称:轻便无线耳机

核心卖点:重量50g, 续航24小时, 蓝牙5.3

语言风格:口语化

要求:

开头用一句吸引注意力的话;每个卖点用单独的段落解释;结尾包含呼吁行动(如“立即购买体验”)。”

5.2 算法复杂度分析:提示优化的效率提升

假设我们有100个产品需要生成说明,若手动编写提示,每个需要5分钟,总时间为500分钟。若用模板生成,每个只需1分钟,总时间为100分钟——效率提升80%。

从算法复杂度看,手动编写的时间复杂度是 ( O(n) )(n为产品数量),而模板生成的时间复杂度是 ( O(1) )(只需编写一次模板)。

5.3 边缘情况处理:应对AI的“异常输出”

即使提示设计得很好,AI仍可能输出异常结果(如重复内容、无关信息)。我们可以通过后处理脚本应对:

def post_process_output(output: str) -> str:

# 去除重复内容

output = "

".join(list(dict.fromkeys(output.split("

"))))

# 去除无关信息(如“根据你的要求”)

output = output.replace("根据你的要求", "")

# 检查格式(如是否为JSON)

try:

json.loads(output)

except ValueError:

output = "输出格式错误,请重新生成"

return output

# 使用示例

ai_output = "根据你的要求,这款耳机重量50g……这款耳机重量50g……"

processed_output = post_process_output(ai_output)

print(processed_output)

输出结果:

“这款耳机重量50g……”

6. 实际应用:高可访问性提示的落地策略

要将高可访问性提示应用到实际项目中,需遵循以下4个步骤:

6.1 步骤1:用户调研——明确“谁在用提示”

目标用户:是开发者、营销人员还是普通用户?需求场景:是生成内容、分析数据还是设计方案?认知水平:能理解哪些术语?需要哪些示例?

6.2 步骤2:模板设计——建立“可复用的提示库”

按角色分:开发者模板、营销模板、普通用户模板;按任务分:内容生成模板、数据分析模板、设计方案模板;按行业分:电商模板、教育模板、医疗模板。

6.3 步骤3:测试迭代——用数据优化提示

测试指标:输出准确率(符合要求的比例)、修改次数(用户调整提示的次数)、满意度(用户反馈);迭代方法:根据测试数据调整提示的约束条件、示例、格式。

6.4 步骤4:部署管理——用工具提升效率

工具选择:用PromptLayer(提示管理)、LangChain(提示链)、Jinja2(模板引擎);权限控制:为不同角色分配不同的提示模板(如开发者可访问技术模板);监控预警:实时监控提示的使用情况,若输出准确率下降,立即预警。

7. 高级考量:未来提示可访问性的演化方向

随着AI技术的发展,提示可访问性的未来将向以下3个方向演化:

7.1 方向1:多模态提示的可访问性

未来的提示将不仅是文字,还会包含图片、语音、视频。例如:

“请根据这张耳机的图片,生成产品说明,突出图片中的‘轻便’设计。”

多模态提示的可访问性,需解决跨模态信息的对齐问题(如图片中的“轻便”如何转化为文字描述)。

7.2 方向2:自动优化的提示

AI将能自动优化提示——通过分析用户的反馈,调整提示的约束条件、示例、格式。例如:

用户反馈“生成的文章太笼统”,AI自动添加“包含2个真实案例”的约束。

7.3 方向3:伦理与安全的可访问性

未来的提示设计,需更重视伦理与安全:

避免偏见:用无偏示例库减少AI的性别、种族偏见;防止滥用:添加“禁止生成违法内容”的约束;透明性:让用户了解提示的设计逻辑(如“这个提示的约束来自用户调研”)。

8. 综合与拓展:成为优秀提示架构师的3个建议

8.1 建议1:培养“用户思维”——从“我想写什么”到“用户需要什么”

提示设计不是“自我表达”,而是“用户需求的翻译”。要多站在用户的角度思考:

用户能看懂我的提示吗?用户能轻松修改我的提示吗?用户能复用我的提示的结果吗?

8.2 建议2:建立“理论+实践”的知识体系

提示工程不是“碰运气”,而是理论指导下的实践。要学习:

信息论:理解提示的信息传递模型;认知心理学:理解用户的认知负荷;自然语言处理:理解AI的语义解析逻辑。

8.3 建议3:保持“迭代意识”——提示不是“终点”,而是“起点”

优秀的提示是迭代出来的,不是“写出来的”。要定期收集用户反馈,更新提示的内容、约束、示例,让提示始终符合用户的需求。

结语

提示工程是人机协作的艺术,而提示可访问性则是这门艺术的“基本功”。初学者的误区,本质上是对“人机交互逻辑”的误解——以为“AI能听懂”就是好提示,却忽略了“用户能使用”才是核心。

通过本文的12个误区分析,希望你能建立结构化的提示设计思维:从用户调研到模板设计,从测试迭代到部署管理,每一步都以“提升可访问性”为核心。

最后,送给所有提示工程初学者一句话:

“好的提示,不是让AI更聪明,而是让用户更轻松。”

愿你在提示工程的路上,少走弯路,多做有价值的设计。

相关文章