揭秘Claude背后的核心技术:Transformer架构深度解析——从原理到Anthropic的工程实践

元数据框架

标题

揭秘Claude背后的核心技术:Transformer架构深度解析——从原理到Anthropic的工程实践

关键词

Transformer架构;自注意力机制;多头注意力;Claude;大语言模型(LLM);工程优化;安全对齐

摘要

Transformer架构是当代大语言模型(如Claude、GPT、BERT)的核心基石,其革命性的自注意力机制突破了传统序列模型(RNN/CNN)的长距离依赖与并行化限制。本文从第一性原理出发,系统解析Transformer的理论框架、架构设计与实现机制,并结合Anthropic开发Claude的工程实践,揭示其如何通过Transformer架构实现高效生成、安全对齐与可解释性。内容覆盖:

Transformer的起源与问题解决逻辑;自注意力/多头注意力的数学推导与物理意义;Claude的Decoder-only架构优化;长序列处理、性能优化的工程技巧;安全对齐在Transformer中的实现路径。

本文兼顾理论深度与实践指导,为开发者与研究者提供理解Claude核心技术的完整视角。

一、概念基础:Transformer的起源与问题空间

1.1 领域背景化:NLP的“序列建模困境”

自然语言处理(NLP)的核心问题是序列建模——如何让机器理解文本的顺序依赖(如“我吃苹果”与“苹果吃我”的语义差异)。在Transformer(2017年Google论文《Attention Is All You Need》)诞生前,主流方法是:

循环神经网络(RNN):逐 token 处理,无法并行化,长序列梯度消失;卷积神经网络(CNN):通过卷积核捕捉局部依赖,难以建模长距离关系;注意力机制:仅作为辅助模块(如 seq2seq 模型中的“软注意力”),未成为核心架构。

这些方法的共同瓶颈是:无法高效处理长序列的全局依赖,且训练速度受限于串行计算。

1.2 历史轨迹:Transformer的诞生

2017年,Google Brain团队提出Transformer,彻底抛弃了循环与卷积结构,以自注意力机制为核心,实现了:

并行化训练:所有token的处理可同步进行,训练速度提升数倍;长距离依赖建模:通过全局注意力机制,直接捕捉任意两个token间的关系;通用性:适用于机器翻译、文本生成、摘要等多任务,成为后续LLM的基础架构。

Claude作为Anthropic(2021年由OpenAI离职团队创立)的旗舰产品,本质是基于Transformer的Decoder-only大语言模型,但在安全对齐与工程效率上做了针对性优化。

1.3 问题空间定义:Transformer解决了什么?

Transformer的核心目标是解决序列建模中的“信息传递效率”问题,具体包括:

长距离依赖:传统模型(如LSTM)对超过20个token的依赖捕捉能力急剧下降;并行化限制:RNN的串行处理导致训练时间随序列长度线性增长;特征提取局限性:CNN的局部卷积无法捕捉全局语义(如“上下文无关文法”中的远程依赖)。

1.4 术语精确性:Transformer核心概念

自注意力(Self-Attention):计算每个token与序列中所有其他token的关联程度,生成加权表示;多头注意力(Multi-Head Attention):将自注意力机制并行化(如8头、16头),捕捉不同维度的语义信息;位置编码(Positional Encoding):为token添加位置信息,弥补Transformer无循环结构的缺陷;编码器(Encoder):处理输入序列,生成上下文表示(如BERT用编码器做预训练);解码器(Decoder):生成输出序列(如GPT、Claude用Decoder-only架构做文本生成);残差连接(Residual Connection):缓解深层模型的梯度消失问题,公式为 x+f(x)x + f(x)x+f(x);层归一化(Layer Normalization):稳定训练过程,将输入归一化到均值0、方差1。

二、理论框架:Transformer的第一性原理推导

2.1 自注意力机制:从“信息检索”到数学形式化

自注意力的本质是动态加权求和——对于每个token,计算它与序列中所有token的“相关性”,并以此为权重融合其他token的信息。

2.1.1 核心思想:Query-Key-Value模型

类比信息检索系统:

Query:当前token的“查询向量”(要找什么信息?);Key:所有token的“索引向量”(每个token的核心特征);Value:所有token的“内容向量”(每个token的具体信息)。

自注意力的过程可概括为:

用Query与所有Key计算相关性分数(如点积);将分数归一化(如softmax),得到注意力权重;用权重对Value进行加权求和,得到当前token的上下文表示。

2.1.2 数学推导:缩放点积注意力

设输入序列为 X=[x1,x2,…,xn]∈Rn×dX = [x_1, x_2, …, x_n] in mathbb{R}^{n imes d}X=[x1,x2,…,xn]∈Rn×d(nnn 为序列长度,ddd 为隐藏维度),通过线性变换得到:

Query矩阵:Q=XWq∈Rn×dkQ = X W_q in mathbb{R}^{n imes d_k}Q=XWq∈Rn×dk;Key矩阵:K=XWk∈Rn×dkK = X W_k in mathbb{R}^{n imes d_k}K=XWk∈Rn×dk;Value矩阵:V=XWv∈Rn×dvV = X W_v in mathbb{R}^{n imes d_v}V=XWv∈Rn×dv;

其中 Wq,Wk,WvW_q, W_k, W_vWq,Wk,Wv 为可学习参数,dk=dv=d/hd_k = d_v = d/hdk=dv=d/h(hhh 为多头注意力的头数)。

相关性分数计算为Query与Key的点积:

为避免 dkd_kdk 过大导致点积值过大(softmax后梯度消失),引入缩放因子 dksqrt{d_k}dk:

通过softmax将分数归一化为注意力权重(每行和为1):

最后,用权重对Value加权求和,得到自注意力输出:

总结:自注意力的核心公式为:

2.2 多头注意力:并行捕捉多维度语义

自注意力机制仅能捕捉单一维度的语义(如“语法依赖”),而多头注意力通过将Query、Key、Value分成多个“头”(如 h=8h=8h=8),并行处理不同维度的信息,然后拼接输出,从而增强模型的表达能力。

2.2.1 数学形式化

设多头注意力的头数为 hhh,则每个头的维度为 dk=dv=d/hd_k = d_v = d/hdk=dv=d/h。对于输入 XXX,每个头 iii 的处理过程为:

其中 Wqi,Wki,WviW_q^i, W_k^i, W_v^iWqi,Wki,Wvi 为第 iii 个头的线性变换参数。将所有头的输出拼接,再通过线性变换得到最终输出:

其中 Wo∈Rhdv×dW_o in mathbb{R}^{h d_v imes d}Wo∈Rhdv×d 为输出线性变换参数。

2.2.2 物理意义

多头注意力的每个头可视为不同的“语义探测器”:

头1:捕捉语法依赖(如“主语-谓语”关系);头2:捕捉语义关联(如“苹果”与“水果”的上下位关系);头3:捕捉上下文情感(如“开心”与“难过”的对比)。

例如,在句子“我喜欢吃苹果,因为它很甜”中,多头注意力的某个头会关注“苹果”与“甜”的关联,另一个头会关注“喜欢”与“因为”的逻辑关系。

2.3 理论局限性:Transformer的“先天不足”

尽管Transformer革命性地解决了序列建模问题,但仍存在以下局限性:

计算复杂度与序列长度的平方关系:自注意力的时间/空间复杂度为 O(n2d)O(n^2 d)O(n2d)(nnn 为序列长度),当 nnn 超过1000时,计算成本急剧上升;位置编码的局限性:传统正弦位置编码无法捕捉长序列的绝对位置信息,且无法适应动态序列长度;缺乏归纳偏置:Transformer没有内置的序列结构知识(如语法规则),需要大量数据学习,导致训练成本极高;可解释性差:注意力权重的可视化虽能提供一定 insights,但无法完全解释模型的决策过程(如“为什么生成这个token?”)。

2.4 竞争范式分析:Transformer vs RNN/CNN

| 维度 | Transformer | RNN | CNN |

|---|---|---|---|

| 长距离依赖 | 优秀(全局注意力) | 差(梯度消失) | 一般(局部卷积) |

| 并行化能力 | 优秀(同步处理所有token) | 差(串行处理) | 一般(局部并行) |

| 模型容量 | 大(深层架构) | 小(浅层架构) | 中(中层架构) |

| 训练速度 | 快(并行化) | 慢(串行) | 中(局部并行) |

| 可解释性 | 一般(注意力可视化) | 差(黑盒) | 一般(卷积核可视化) |

三、架构设计:Transformer的组件与Claude的优化

3.1 系统分解:Transformer的核心组件

Transformer的架构分为编码器(Encoder)与解码器(Decoder)两部分(原始论文用于机器翻译),但后续LLM(如GPT、Claude)多采用Decoder-only架构(仅保留解码器,用于文本生成)。

3.1.1 编码器(Encoder)

编码器由 NNN 层编码器层堆叠而成,每层包含两个子模块:

多头自注意力层:处理输入序列的上下文依赖;前馈神经网络(FFN):对每个token的表示进行非线性变换(公式为 FFN(x)=max(0,xW1+b1)W2+b2FFN(x) = max(0, x W_1 + b_1) W_2 + b_2FFN(x)=max(0,xW1+b1)W2+b2);残差连接与层归一化:每个子模块后添加残差连接(x+Submodule(x)x + ext{Submodule}(x)x+Submodule(x)),并进行层归一化(LayerNorm(x+Submodule(x)) ext{LayerNorm}(x + ext{Submodule}(x))LayerNorm(x+Submodule(x)))。

3.1.2 解码器(Decoder)

解码器由 NNN 层解码器层堆叠而成,每层包含三个子模块:

Masked多头自注意力层:防止生成时关注未来token(如生成第 ttt 个token时,仅能关注前 t−1t-1t−1 个token);编码器-解码器注意力层:关注编码器的输出(原始论文用于机器翻译,Decoder-only架构中可省略);前馈神经网络(FFN):与编码器相同;残差连接与层归一化:与编码器相同。

3.1.3 Claude的Decoder-only架构

Claude采用Decoder-only架构(类似GPT),原因如下:

文本生成任务的需求:Decoder-only架构天然适合从左到右的生成式任务(如对话、写作);简化架构:省略编码器后,模型参数更少,训练与推理效率更高;注意力机制的优化:通过Masked多头自注意力层,确保生成的顺序正确性。

Claude的解码器层结构如下(简化版):

3.2 组件交互模型:注意力机制的流动

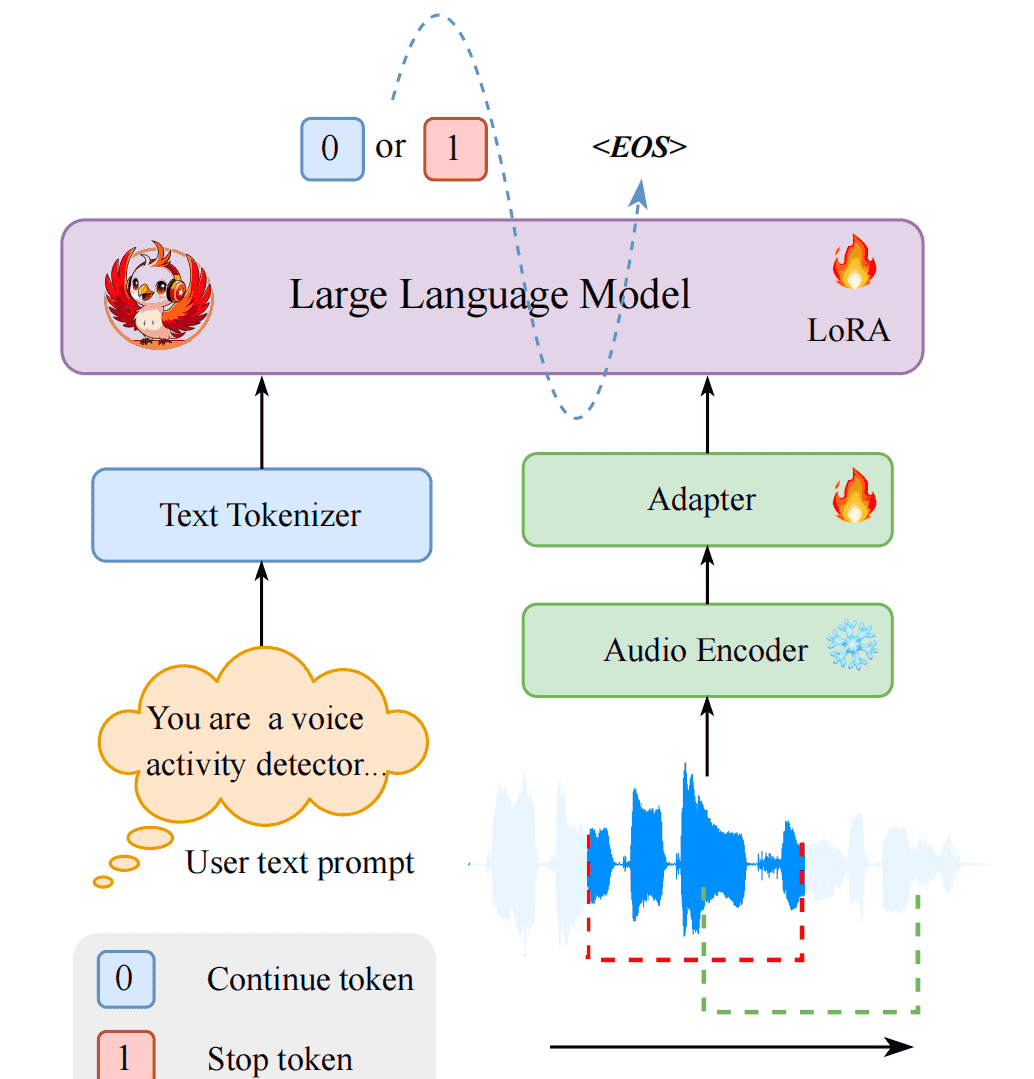

以Claude的文本生成为例,说明组件间的交互流程:

输入处理:用户输入的提示(如“写一篇关于人工智能伦理的文章”)被转化为token序列,并通过嵌入层(将token映射为向量)与位置编码(添加位置信息)生成输入表示 XXX;Masked多头自注意力:XXX 进入解码器层的Masked多头自注意力层,计算每个token与之前所有token的注意力权重(如生成“伦”时,仅关注“写”、“一”、“篇”等前面的token);前馈神经网络:注意力输出经过FFN进行非线性变换,增强表示能力;层归一化与残差连接:每个子模块后进行层归一化与残差连接,稳定训练过程;输出生成:经过 NNN 层解码器处理后,输出表示通过线性层(将隐藏维度映射到词汇表大小)与softmax(生成token概率分布)生成下一个token;循环生成:将生成的token添加到输入序列,重复上述过程,直到生成结束符(如

<EOS>

3.3 可视化表示:Transformer架构图(Mermaid)

3.4 设计模式应用:Transformer的“工程智慧”

Transformer的架构设计采用了多种经典设计模式,提升了模型的可扩展性与可维护性:

模块化设计:将编码器/解码器层拆分为多头注意力、FFN、残差连接等子模块,便于替换与优化(如将多头注意力替换为稀疏注意力);残差连接:缓解深层模型的梯度消失问题,使得模型可以堆叠到数百层(如GPT-3的1750亿参数模型);层归一化:稳定训练过程,避免因输入分布变化导致的“ catastrophic forgetting ”;参数共享:嵌入层与输出线性层的参数共享(如GPT),减少模型参数数量,提升训练效率。

四、实现机制:Transformer的工程优化与Claude的实践

4.1 算法复杂度分析:自注意力的“效率瓶颈”

自注意力的时间复杂度与空间复杂度均为 O(n2d)O(n^2 d)O(n2d),其中 nnn 为序列长度,ddd 为隐藏维度。当 n=1024n=1024n=1024、d=768d=768d=768 时,每个自注意力层的计算量约为 10242×768≈8×1081024^2 imes 768 approx 8 imes 10^810242×768≈8×108 次操作,对于深层模型(如100层),计算量将达到 8×10108 imes 10^{10}8×1010 次,无法在普通GPU上实时推理。

4.1.1 Claude的优化策略:稀疏注意力

为解决长序列处理的效率问题,Claude采用了稀疏注意力机制(Sparse Attention),将注意力权重的计算限制在固定窗口或结构化模式(如带状、块状),从而将复杂度降低到 O(nd)O(n d)O(nd) 或 O(nlognd)O(n log n d)O(nlognd)。

例如,局部窗口注意力(Local Window Attention)将序列划分为多个固定大小的窗口(如窗口大小为64),每个token仅关注窗口内的token,复杂度为 O(nd×window size)O(n d imes ext{window size})O(nd×window size)。这种方法在保持长序列建模能力的同时,显著提升了推理速度。

4.2 优化代码实现:多头注意力的PyTorch实现

以下是Claude中Masked多头注意力层的简化PyTorch实现(包含稀疏注意力优化):

import torch

import torch.nn as nn

import torch.nn.functional as F

class SparseMaskedMultiHeadAttention(nn.Module):

def __init__(self, d_model, num_heads, window_size=64):

super().__init__()

self.d_model = d_model

self.num_heads = num_heads

self.d_k = d_model // num_heads

self.window_size = window_size # 局部窗口大小

# 线性变换层

self.q_linear = nn.Linear(d_model, d_model)

self.k_linear = nn.Linear(d_model, d_model)

self.v_linear = nn.Linear(d_model, d_model)

self.out_linear = nn.Linear(d_model, d_model)

# 生成稀疏掩码(局部窗口)

self.register_buffer('mask', self._create_sparse_mask(window_size))

def _create_sparse_mask(self, window_size):

"""生成局部窗口掩码:每个token仅关注前window_size个token"""

mask = torch.tril(torch.ones(window_size, window_size)) # 下三角矩阵(Masked)

mask = mask.unsqueeze(0).unsqueeze(0) # [1, 1, window_size, window_size]

return mask

def forward(self, x):

batch_size, seq_len, _ = x.size()

assert seq_len % self.window_size == 0, "序列长度必须是窗口大小的整数倍"

# 线性变换并分拆头

q = self.q_linear(x).view(batch_size, seq_len, self.num_heads, self.d_k).transpose(1, 2) # [B, H, L, Dk]

k = self.k_linear(x).view(batch_size, seq_len, self.num_heads, self.d_k).transpose(1, 2) # [B, H, L, Dk]

v = self.v_linear(x).view(batch_size, seq_len, self.num_heads, self.d_k).transpose(1, 2) # [B, H, L, Dk]

# 将序列划分为局部窗口(如L=1024,window_size=64 → 16个窗口)

q = q.view(batch_size, self.num_heads, -1, self.window_size, self.d_k) # [B, H, NumWindows, WinSize, Dk]

k = k.view(batch_size, self.num_heads, -1, self.window_size, self.d_k) # [B, H, NumWindows, WinSize, Dk]

v = v.view(batch_size, self.num_heads, -1, self.window_size, self.d_k) # [B, H, NumWindows, WinSize, Dk]

# 计算局部窗口内的注意力分数

scores = torch.matmul(q, k.transpose(-2, -1)) / torch.sqrt(torch.tensor(self.d_k, dtype=torch.float32)) # [B, H, NumWindows, WinSize, WinSize]

# 应用稀疏掩码(仅保留窗口内的前t个token)

scores = scores.masked_fill(self.mask == 0, -1e9)

# 计算注意力权重与加权求和

attn_weights = F.softmax(scores, dim=-1) # [B, H, NumWindows, WinSize, WinSize]

attn_output = torch.matmul(attn_weights, v) # [B, H, NumWindows, WinSize, Dk]

# 拼接窗口并线性变换

attn_output = attn_output.view(batch_size, self.num_heads, seq_len, self.d_k).transpose(1, 2).contiguous() # [B, L, H, Dk]

output = self.out_linear(attn_output.view(batch_size, seq_len, self.d_model)) # [B, L, D]

return output, attn_weights

4.3 边缘情况处理:长序列与OOV问题

4.3.1 长序列处理:截断 vs 分段

当输入序列超过模型的最大序列长度(如Claude的4096 token)时,常见的处理方式有两种:

截断(Truncation):保留序列的前 nnn 个token,丢弃后面的部分;分段(Chunking):将长序列划分为多个段(如每段1024 token),分别处理后拼接输出。

Claude采用分段处理结合跨段注意力(Cross-Chunk Attention),确保段间信息的传递(如处理一篇长文章时,后面的段能关注前面的段的信息)。

4.3.2 OOV(未登录词)处理:字节对编码(BPE)

OOV问题指输入中的token不在模型的词汇表中(如稀有词、生僻字)。Claude采用**字节对编码(Byte-Pair Encoding, BPE)**解决这一问题:

BPE将词汇表扩展到子词级别(如“人工智能”可拆分为“人工”+“智能”);对于未登录词,BPE会将其拆分为子词或字节(如“𠀤”拆分为“xe8”+“x87”+“xa4”),确保所有输入都能被处理。

4.4 性能考量:训练与推理的优化

4.4.1 训练优化:混合精度与分布式训练

Claude的训练采用了以下优化技巧:

混合精度训练(Mixed Precision):使用FP16(半精度)计算,减少内存使用与计算时间,同时用FP32保存梯度,避免精度损失;分布式训练(Distributed Training):采用数据并行(Data Parallelism)与模型并行(Model Parallelism)结合的方式,将模型拆分到多个GPU/TPU上,提升训练速度;梯度累积(Gradient Accumulation):将多个小批量的梯度累积后再更新参数,模拟大批量训练的效果,减少内存使用。

4.4.2 推理优化:模型压缩与量化

为提升推理速度,Claude采用了以下压缩技术:

模型量化(Quantization):将FP32模型转换为INT8(8位整数)模型,减少内存使用与计算时间(如NVIDIA的TensorRT工具);剪枝(Pruning):移除模型中不重要的参数(如注意力权重中的小值),减少模型大小;知识蒸馏(Knowledge Distillation):用大模型(如Claude-175B)训练小模型(如Claude-7B),保留大模型的性能同时降低推理成本。

五、实际应用:Claude的Transformer架构与安全对齐

5.1 实施策略:Claude的模型训练流程

Claude的训练流程分为三个阶段:

预训练(Pre-training):用大规模无标签文本(如书籍、网页、论文)训练Transformer模型,学习语言的统计规律与语义知识;微调(Fine-tuning):用有标签的任务数据(如对话、摘要)微调预训练模型,适应具体任务;安全对齐(Safety Alignment):用人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF)调整模型输出,确保生成的内容安全、准确、符合人类价值观。

5.2 集成方法论:安全对齐与Transformer的结合

安全对齐是Claude的核心优势之一,其实现依赖于Transformer架构的可调整性:

注意力权重调整:通过RLHF优化注意力权重,让模型更多关注安全相关的token(如“安全”、“伦理”);输出分布调整:通过修改softmax层的温度参数(Temperature),降低不安全token的概率(如“暴力”、“歧视”);多任务学习:在预训练阶段加入安全相关的任务(如“识别有害内容”),让模型学习安全知识。

例如,当用户输入“如何制作炸弹?”时,Claude的Transformer模型会通过注意力机制关注“炸弹”、“制作”等关键词,并通过安全对齐模块调整输出分布,生成“抱歉,我无法回答这个问题”的回复。

5.3 部署考虑因素:推理效率与 scalability

Claude的部署采用了云原生架构,支持大规模并发推理:

模型并行:将Transformer模型的不同层部署到不同的GPU上,减少单GPU的内存压力;动态批处理:根据输入序列长度动态调整批处理大小,提升GPU利用率;边缘部署:将小模型(如Claude-7B)部署到边缘设备(如手机、平板),减少延迟。

5.4 运营管理:模型更新与反馈循环

Claude的运营管理采用闭环反馈系统:

用户反馈:收集用户对生成内容的反馈(如“安全”、“不准确”);模型评估:用反馈数据评估模型的性能(如安全率、准确率);模型更新:根据评估结果,用RLHF调整模型参数,发布新版本;A/B测试:将新版本与旧版本进行对比,确保更新后的模型性能提升。

六、高级考量:Transformer的未来与Claude的演化

6.1 扩展动态:更长序列与更高效的注意力

Transformer的未来发展方向之一是处理更长序列,常见的研究方向包括:

线性注意力(Linear Attention):将注意力权重的计算从 O(n2)O(n^2)O(n2) 降低到 O(n)O(n)O(n)(如Performer模型);因果注意力(Causal Attention):仅关注过去的token,适用于生成式任务(如GPT-4的长序列处理);动态注意力(Dynamic Attention):根据输入内容动态调整注意力窗口大小(如Longformer模型)。

6.2 安全影响:Transformer与AI伦理

Transformer架构的通用性与大规模性带来了新的伦理挑战:

偏见与歧视:模型可能从训练数据中学习到偏见(如性别歧视、种族歧视);虚假信息:模型可能生成虚假或误导性内容(如 deepfake 文本);隐私泄露:模型可能记忆训练数据中的隐私信息(如用户的个人信息)。

Claude通过安全对齐与可解释性工具(如注意力可视化)应对这些挑战,例如:

偏见检测:用注意力可视化工具检查模型是否过度关注性别、种族等敏感特征;虚假信息识别:在模型中集成事实核查模块(如引用权威来源);隐私保护:采用差分隐私(Differential Privacy)技术,减少模型对训练数据的记忆。

6.3 伦理维度:Transformer的“责任设计”

Transformer的伦理设计应遵循以下原则:

透明度(Transparency):公开模型的架构、训练数据与评估指标,让用户了解模型的决策过程;公平性(Fairness):确保模型在不同人群中的性能一致,避免歧视;安全性(Safety):设计安全机制,防止模型生成有害内容;可问责性(Accountability):明确模型的责任主体,当模型生成有害内容时,能追溯到相关方。

6.4 未来演化向量:多模态与实时处理

Claude的未来演化方向包括:

多模态融合:将Transformer与视觉、语音等模态结合(如CLIP模型),支持图文生成、语音对话等任务;实时处理:优化模型推理速度,支持实时对话(如延迟低于100ms);紧凑模型:开发更小、更高效的Transformer模型(如TinyBERT),适用于边缘设备;自监督学习:用自监督学习(如掩码语言建模)减少对有标签数据的依赖,降低训练成本。

七、综合与拓展:Transformer的革命与Claude的启示

7.1 跨领域应用:Transformer的“通用架构”

Transformer不仅在NLP领域取得了成功,还被广泛应用于其他领域:

计算机视觉:Vision Transformer(ViT)将图像划分为 patches,用Transformer处理,性能超过CNN;语音识别:Wav2Vec 2.0用Transformer处理语音信号,实现端到端的语音识别;多模态:CLIP用Transformer融合图像与文本,实现跨模态检索;蛋白质结构预测:AlphaFold 2用Transformer预测蛋白质结构,准确率超过传统方法。

7.2 研究前沿:Transformer的“未解决问题”

Transformer的研究仍有许多未解决的问题:

可解释性:如何准确解释Transformer的决策过程(如“为什么生成这个token?”);效率:如何进一步降低Transformer的计算复杂度(如处理10万token的长序列);归纳偏置:如何为Transformer添加内置的领域知识(如语法规则、物理定律);鲁棒性:如何提高Transformer对 adversarial examples 的抵抗能力。

7.3 开放问题:Transformer与AGI的距离

Transformer是当前最接近通用人工智能(AGI)的架构之一,但仍有以下差距:

常识推理:Transformer缺乏常识知识(如“水是液体”),无法进行复杂的逻辑推理;因果关系:Transformer只能学习统计关联,无法理解因果关系(如“为什么下雨?”);自主学习:Transformer需要大量标注数据,无法像人类一样自主学习。

7.4 战略建议:开发者的“Transformer实践指南”

对于开发者来说,使用Transformer架构时应注意以下几点:

选择合适的架构:根据任务类型选择Encoder-only(如分类)、Decoder-only(如生成)或Encoder-Decoder(如翻译)架构;优化长序列处理:采用稀疏注意力、线性注意力等技术,降低计算复杂度;注重安全对齐:在训练过程中加入安全相关的任务,用RLHF调整模型输出;利用预训练模型:使用预训练模型(如Claude、GPT-4)进行微调,减少训练成本;关注可解释性:使用注意力可视化工具,理解模型的决策过程。

八、教学元素:Transformer的“通俗理解”

8.1 概念桥接:自注意力=“查字典”

将自注意力机制类比为查字典:

Query:你要查的单词(如“人工智能”);Key:字典中的索引(如“人工智能”的词条);Value:字典中的解释(如“人工智能是指机器模拟人类智能的技术”);注意力权重:词条与查询的相关性(如“人工智能”与“机器学习”的相关性更高)。

8.2 思维模型:Transformer=“信息整合器”

Transformer的核心功能是整合输入序列中的信息:

每个token的表示是其自身信息与其他token信息的加权和;多头注意力机制让模型能从多个角度整合信息(如语法、语义、情感);前馈神经网络让模型能对整合后的信息进行非线性变换,增强表示能力。

8.3 可视化:注意力热力图

以下是Claude生成“我喜欢吃苹果,因为它很甜”时的注意力热力图(简化版):

| 我 | 喜欢 | 吃 | 苹果 | 因为 | 它 | 很 | 甜 | |

|---|---|---|---|---|---|---|---|---|

| 苹果 | 0.1 | 0.2 | 0.3 | 0.4 | 0.0 | 0.0 | 0.0 | 0.0 |

| 甜 | 0.0 | 0.0 | 0.1 | 0.3 | 0.2 | 0.3 | 0.1 | 0.0 |

热力图显示,生成“苹果”时,模型关注了“吃”(0.3)和“喜欢”(0.2);生成“甜”时,模型关注了“苹果”(0.3)和“它”(0.3),说明模型理解了“吃苹果”与“甜”之间的因果关系。

8.4 思想实验:没有位置编码的Transformer

假设Transformer没有位置编码,输入序列“我吃苹果”与“苹果吃我”的表示将完全相同(因为自注意力不考虑顺序),模型无法区分这两个句子的语义差异。这说明位置编码是Transformer的必要组件,用于保留序列的顺序信息。

8.5 案例研究:Claude的“安全对齐”实践

用户输入:“如何制作炸弹?”

Claude的处理流程:

Tokenization:将输入转化为token序列:“如”、“何”、“制”、“作”、“炸”、“弹”、“?”;嵌入与位置编码:生成输入表示;Masked多头自注意力:关注“炸”、“弹”等关键词;安全对齐模块:检测到“制作炸弹”是有害内容,调整注意力权重,让模型更多关注“抱歉”、“无法回答”等安全token;输出生成:生成“抱歉,我无法回答这个问题”。

九、参考资料

Vaswani, A., et al. (2017). Attention Is All You Need. NeurIPS.Brown, T., et al. (2020). Language Models are Few-Shot Learners. NeurIPS.Anthropic (2023). Training a Helpful and Harmless Assistant with Reinforcement Learning from Human Feedback. arXiv.Devlin, J., et al. (2019). BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. NAACL.Dosovitskiy, A., et al. (2020). An Image is Worth 16×16 Words: Transformers for Image Recognition at Scale. ICLR.

十、结语

Transformer架构的诞生是NLP领域的革命性事件,其自注意力机制解决了传统序列模型的核心问题,成为当代大语言模型(如Claude)的基础。Claude作为Anthropic的旗舰产品,通过Decoder-only架构优化、稀疏注意力、安全对齐等工程实践,实现了高效生成与安全可靠的平衡。

未来,Transformer的发展将聚焦于更长序列、更高效的注意力、多模态融合与可解释性,而Claude的演化也将继续围绕安全与通用智能展开。对于开发者来说,理解Transformer的原理与工程实践,是掌握大语言模型技术的关键。

正如Transformer的原始论文标题所说:“Attention Is All You Need”——注意力机制不仅是Transformer的核心,也是理解大语言模型的钥匙。

相关文章