在Kubernetes(简称K8s)的生态体系中,存储系统是衔接容器动态调度与数据持久化需求的核心纽带。容器的“临时性”本质与业务数据“持久性”需求之间的矛盾,催生了K8s存储系统的复杂架构与丰富特性。本文将从核心需求出发,逐层拆解K8s存储的组件架构、关键技术、实践模式及发展趋势,助力读者建立对K8s存储系统的系统性认知。

一、K8s存储系统的核心命题:解决“动态与持久”的矛盾

容器技术的核心优势在于轻量、可移植与快速调度,但容器的生命周期与数据存储存在天然冲突:容器销毁时其内部文件系统数据会彻底丢失,而数据库、消息队列等有状态服务则要求数据长期稳定存储。同时,K8s集群的节点动态扩展、Pod跨节点迁移等特性,进一步要求数据存储具备“脱离单个节点束缚”的集群级能力。

基于此,K8s存储系统的核心命题可概括为三点:一是数据持久化,确保容器销毁或重启后数据不丢失;二是存储弹性调度,支持数据随Pod在集群内自由迁移;三是存储服务标准化,屏蔽底层存储设备(本地磁盘、SAN、云存储等)的差异,为上层应用提供统一的存储访问接口。

二、核心组件架构:从“资源抽象”到“服务交付”的分层设计

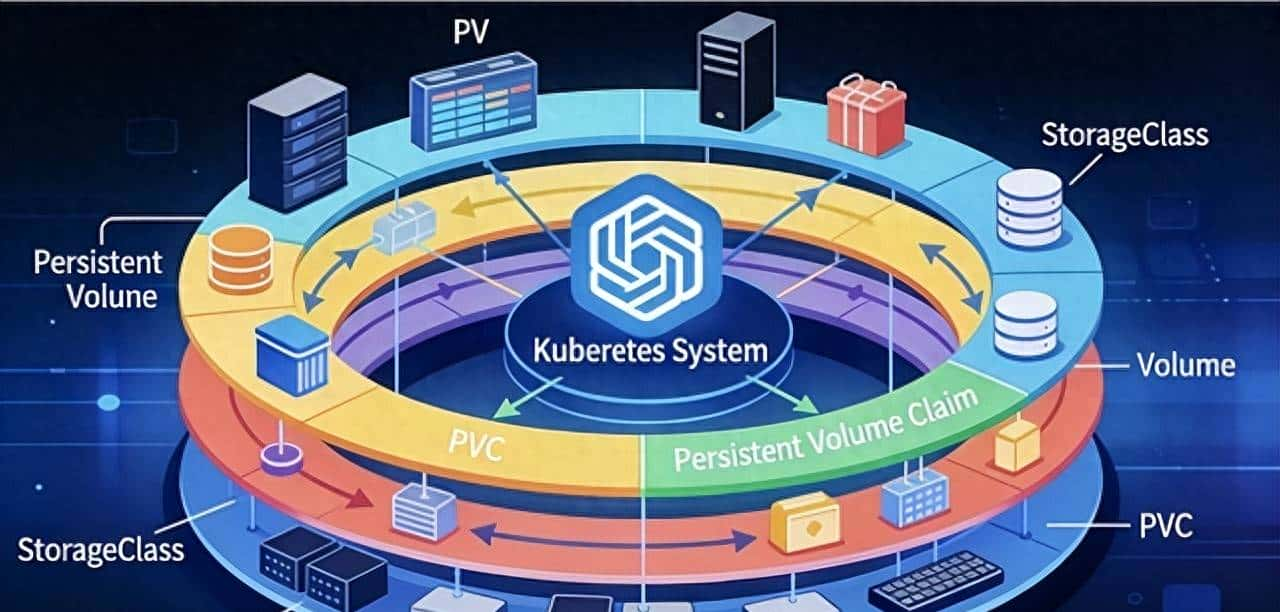

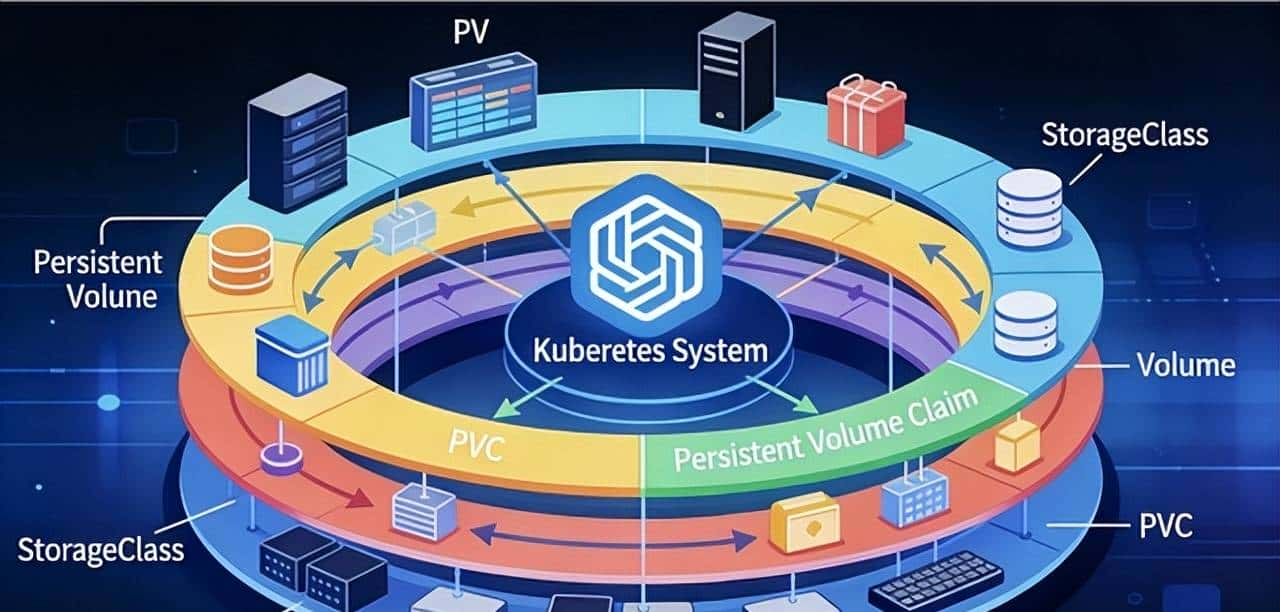

K8s存储系统采用分层架构设计,通过“资源抽象-调度适配-底层驱动”三级组件,实现存储服务的标准化交付与弹性管理。各层组件分工明确,既解耦了应用与底层存储,又保障了系统的扩展性。

1. 核心抽象层:PV、PVC与StorageClass的“三角关系”

为解决应用与存储的耦合问题,K8s定义了三个核心资源对象,构建起“存储资源供给-应用需求申请-服务质量分级”的闭环:

持久卷(PersistentVolume, PV):集群级别的存储资源抽象,由管理员手动创建或存储插件动态生成,本质是对底层存储设备(如本地磁盘、NFS、云硬盘)的“封装”。PV包含存储容量、访问模式(RWO/ROX/RWX)、存储类型等核心属性,独立于Pod生命周期,即使绑定的Pod销毁,PV仍可保留数据。

持久卷声明(PersistentVolumeClaim, PVC):应用层面的存储需求声明,由开发人员创建,用于向集群“申请”符合需求的存储资源(如“100GB容量、支持读写的SSD存储”)。PVC不直接关联底层存储,而是通过匹配PV的属性实现“动态绑定”,使开发人员无需关注存储设备细节。

存储类(StorageClass, SC):实现PV“动态供给”的核心组件,用于对存储资源进行“分类分级”。管理员可通过SC定义存储类型(如“高性能SSD”“低成本机械盘”)、后端存储插件(如CSI插件)及参数(如云硬盘的IOPS),当PVC关联SC时,K8s会自动调用对应的存储插件创建PV并完成绑定,彻底替代手动创建PV的繁琐操作。

三者的协同逻辑为:SC定义“存储服务模板”→ PVC提交“存储需求订单”→ K8s依据SC动态生成PV并与PVC绑定→ Pod通过PVC挂载存储资源。这种分层抽象使存储资源的管理与应用需求解耦,极大提升了集群存储的灵活性。

2. 调度适配层:Volume插件与存储控制器

抽象层定义了“供需关系”,而调度适配层则负责将抽象的存储需求转化为实际的存储服务,核心组件包括Volume插件与存储控制器:

Volume插件:K8s连接底层存储的“适配器”,负责将PV对应的存储资源挂载到Pod所在节点,并提供文件系统或块设备访问能力。根据功能差异,Volume插件可分为原生插件(如emptyDir、hostPath、nfs)与扩展插件(如CSI、FlexVolume)。其中,CSI(Container Storage Interface)作为K8s官方推荐的扩展标准,通过标准化接口支持第三方存储厂商(如AWS EBS、阿里云OSS、华为云SFS)快速接入,是当前K8s存储生态的核心扩展方式。

存储控制器:保障存储资源与Pod协同调度的“大脑”,核心包括PV控制器与PVC控制器。PV控制器负责监控PV与PVC的绑定状态,当出现未绑定的PVC时,自动匹配符合条件的PV或调用SC动态创建PV;PVC控制器则负责关联Pod与PVC,确保Pod调度时,其关联的PVC对应的PV已在目标节点可用,同时处理Pod销毁时的存储资源释放逻辑。此外,针对有状态服务(StatefulSet),K8s还提供了专属的存储调度策略,确保Pod重新调度后仍能挂载到原有的PVC与PV,保障数据一致性。

3. 底层驱动层:多样化存储设备的统一接入

底层驱动层是K8s存储系统的“基础设施”,涵盖本地存储(本地磁盘、LVM)、网络存储(NFS、Ceph、GlusterFS)、云存储(AWS EBS、Azure Disk、阿里云云盘)等多种存储类型。不同存储设备通过对应的Volume插件(尤其是CSI插件)实现统一接入,K8s通过抽象层屏蔽了各类存储的技术差异,使上层应用可通过标准化的PVC接口访问不同类型的存储资源。例如,对于需要低延迟的数据库服务,可通过PVC申请本地SSD存储;对于需要高可用的文件共享服务,可申请Ceph或NFS存储。

三、关键技术特性:支撑企业级存储需求的核心能力

K8s存储系统通过一系列关键技术特性,满足企业级应用对存储的高可用、高可靠、弹性扩展等需求,核心包括动态供给、存储访问模式、数据备份与恢复、存储QoS等。

1. 动态供给(Dynamic Provisioning):存储资源的“按需生成”

动态供给是K8s存储系统的核心效率提升特性,基于StorageClass与CSI插件实现。在传统模式下,管理员需手动创建大量PV以满足应用需求,效率低下且难以适配动态变化的业务场景。而通过动态供给,管理员仅需预先定义SC(如“sc-ssd”对应阿里云ESSD云盘),开发人员创建PVC时指定该SC,K8s会自动调用阿里云CSI插件创建对应的云盘及PV,并完成PVC与PV的绑定。这种“按需创建、用完释放”的模式,极大降低了存储管理成本,尤其适用于云原生环境下的弹性业务场景。

2. 存储访问模式:适配不同业务场景的访问策略

K8s定义了三种核心存储访问模式,用于规范多个Pod对同一PV的访问权限,适配不同业务场景:

ReadWriteOnce(RWO):仅允许单个节点上的Pod以读写方式挂载,适用于数据库等“独占式”存储场景(如MySQL主库);

ReadOnlyMany(ROX):允许多个节点上的Pod以只读方式挂载,适用于配置文件共享、静态资源存储等场景;

ReadWriteMany(RWX):允许多个节点上的Pod以读写方式挂载,适用于分布式文件系统(如NFS、CephFS)场景,如日志收集、共享数据存储等。

开发人员需根据业务特性选择合适的访问模式,例如,对于分布式计算任务,RWX模式可实现多Pod共享输入输出数据;对于有状态服务的主节点,RWO模式可保障数据写入的独占性与一致性。

3. 数据备份与恢复:保障存储数据的可靠性

数据可靠性是企业级存储的核心需求,K8s存储系统通过“PV快照(Snapshot)”与“数据迁移”技术实现数据的备份与恢复。基于CSI插件的快照能力,管理员可对PV创建快照(相当于数据的“时间点副本”),当数据丢失或损坏时,可通过快照快速恢复PV数据。此外,K8s还支持PV的跨集群迁移,通过导出PV快照并在目标集群导入,实现数据的跨环境迁移,适配灾备、集群升级等场景。目前,主流的备份工具如Velero,已深度集成K8s存储系统,支持PVC、PV及快照的全生命周期管理。

4. 存储QoS:实现存储资源的精细化管控

为保障核心业务的存储性能,K8s通过存储QoS(Quality of Service)实现资源的精细化管控。管理员可通过StorageClass定义存储的性能参数,例如,为“sc-high-performance”类型的SC配置高IOPS(如10000 IOPS)与低延迟(如1ms)的参数,绑定该SC的PVC将自动获得高性能存储资源;而“sc-low-cost”类型的SC则可配置低IOPS参数,适用于非核心业务。此外,K8s还支持通过资源限制(如在PVC中设置storage属性)控制存储容量,避免单个应用过度占用存储资源,保障集群存储的整体稳定性。

四、实践场景与常见问题:从理论到落地的关键考量

K8s存储系统的落地需结合业务场景选择合适的架构,同时规避常见的技术陷阱。以下是典型实践场景与问题解析:

1. 典型实践场景

无状态服务存储:无状态服务(如Web应用、API服务)对数据持久化需求低,可使用emptyDir(临时存储,Pod销毁时数据丢失)或configMap/secret(存储配置文件与敏感信息),无需挂载PV;若需存储日志等临时数据,可结合hostPath或共享存储(如NFS)实现日志聚焦收集。

有状态服务存储:数据库(MySQL、PostgreSQL)、消息队列(Kafka、RabbitMQ)等有状态服务是K8s存储的核心应用场景,需采用“StatefulSet + PVC + SC”的架构。通过StatefulSet的“固定网络标识”与“有序调度”特性,确保Pod重新调度后仍能挂载到原PVC;通过SC动态供给PV,保障存储资源的弹性扩展;对于分布式数据库(如MySQL主从),可通过RWO模式为每个节点分配独立PV,通过共享存储(如Ceph)实现数据同步。

云原生存储场景:在云环境中,K8s可通过云厂商的CSI插件直接调用云存储服务,例如,阿里云ACK集群通过CSI插件接入云盘、OSS、NAS等存储服务,无需手动管理底层存储设备;同时,结合云厂商的快照、灾备服务,可实现存储数据的高可靠保障。

2. 常见问题与解决方案

PVC绑定失败(Pending状态):核心缘由包括无匹配的PV、SC配置错误、存储插件异常。解决方案:检查PVC的资源需求(容量、访问模式)是否与PV匹配;验证SC的provisioner是否正确(如CSI插件是否正常运行);通过kubectl describe pvc <pvc-name>查看绑定失败详情。

Pod挂载PV后无法读写:可能是存储访问权限错误、文件系统损坏或PV对应的存储设备异常。解决方案:检查PV的访问模式是否与Pod需求匹配;通过节点登录验证存储设备是否正常挂载(如lsblk查看块设备);检查存储设备的权限配置(如NFS的exports配置)。

数据备份恢复效率低:传统的PV数据拷贝方式效率低,可通过CSI快照实现“秒级快照”,结合Velero工具实现PVC与快照的自动化备份;对于大规模集群,可采用存储后端的原生备份能力(如Ceph的RBD快照)提升效率。

五、发展趋势:云原生存储的未来方向

随着K8s生态的不断成熟,存储系统正朝着“更智能、更高效、更贴合云原生场景”的方向发展,核心趋势包括:

存储与调度深度融合:未来K8s将进一步优化存储与Pod的协同调度策略,结合存储资源的位置信息(如本地磁盘所在节点)、性能数据(如IOPS、延迟)实现“存储感知调度”,确保Pod调度到存储性能最优的节点,提升应用响应速度。

智能化存储管理:结合AI与监控技术,实现存储资源的智能调度与故障预测。例如,通过监控PV的IO负载,自动将高负载PV迁移到性能更优的存储设备;通过AI算法预测存储设备故障,提前触发快照与数据迁移,提升系统可靠性。

Serverless存储普及:随着Serverless Kubernetes(如AWS EKS Anywhere、阿里云ACK Serverless)的兴起,Serverless存储将成为趋势。用户无需关注PV、SC等底层资源,直接通过“存储服务接口”申请存储能力,由云厂商或集群自动完成存储资源的创建、调度与释放,进一步降低存储管理成本。

安全与合规强化:针对金融、医疗等合规性要求高的行业,K8s存储系统将进一步强化数据安全能力,包括存储加密(静态数据加密、传输加密)、访问控制(基于RBAC的PVC权限管理)、审计日志(存储操作全链路日志)等,满足行业合规标准。

六、总结

Kubernetes存储系统通过“PV-PVC-SC”的分层抽象、CSI插件的标准化扩展、动态供给与快照等核心技术,构建了一套适配容器化场景的弹性存储架构,解决了容器临时性与数据持久性的核心矛盾。从无状态服务的临时存储到有状态服务的高可用存储,从本地磁盘到云存储,K8s存储系统通过统一的接口实现了多样化存储资源的高效管理。

在实际落地过程中,需结合业务场景选择合适的存储架构(如StatefulSet+PVC适配有状态服务),关注PVC绑定、存储权限等常见问题,同时借助Velero等工具实现数据备份与恢复。未来,随着存储与调度的深度融合、智能化管理的普及,K8s存储系统将进一步释放云原生的价值,为企业级应用提供更可靠、高效的存储支撑。

很强,学习了🤙

这个厉害了👏

收藏了,感谢分享