控制台只输出了两个单词。

这就是整个操作的“结尾画面”。看着这两词,你可以把它当成一次完整的数据抓取流程的回执:请求发出,页面拿到,内容解析,结果打印。过程看似简单,但每一步都有讲究。

那一刻是在我本地的 VS Code 里发生的。打开终端,建了个文件,名字叫 spider.py,把代码粘进去后,直接运行 python spider.py,就得到了那两个单词。目标网站选的是专门给爬虫练习用的模拟书店:

http://books.toscrape.com/。它的页面结构规整,适合用来练手,不会像真实网站那样各种反爬措施。

代码很短,算上 import 刚好 5 行。就是那种入门级的示例,用来说明抓取逻辑一步步怎么走。内容大致是:发请求拿页面,交给解析器处理,从页面里找到第一本书的标题,取前两个词,打印出来。这五行能跑通,说明流程没问题。别看只打印了两个词,底层逻辑和抓一百万条记录没区别——只是数据规模不同,复杂度按比例放大罢了。

不过,现实里许多网站没这么友善。像豆瓣、知乎这类,会有门槛。如果你直接用脚本去访问,服务器会判定这是非浏览器请求,然后回 403 Forbidden。这种情况很常见,处理办法也很常见:在请求里加上伪装的用户代理。简单说,就是告知服务器“我是一台正常的浏览器”。把那行伪装头加上之后,脚本就更像真实用户的行为,能通过一些低门槛的检测。把这行算作第六行代码——大多数博主都会强调这一点。加了之后,示例脚本可以直接用来抓一些简单的博客或新闻站。

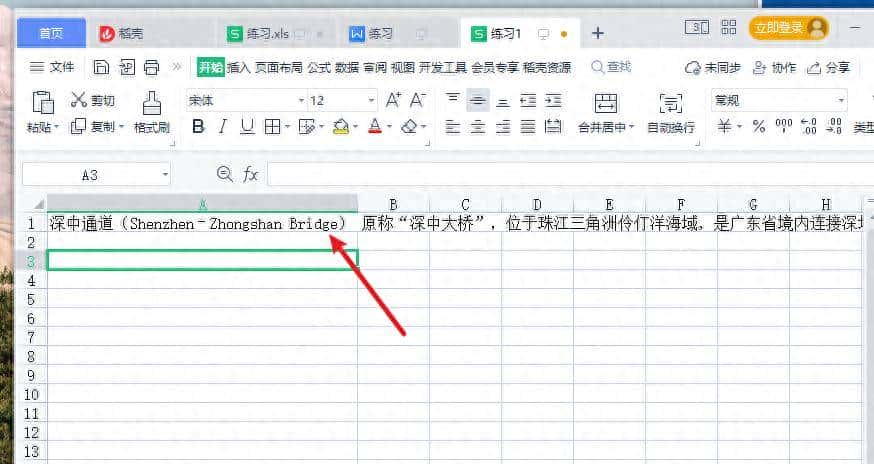

再回溯一步,操作环境和具体步骤是这样的:在 VS Code 的 Terminal 里,新建 spider.py,把代码写进去,然后运行。代码里第一行是导入需要的库,后面几行分别完成发起请求、解析 HTML、定位目标元素和打印结果。解析用到的选择器要根据页面结构来写,细节决定能不能正确取到标题。举个细节:页面里书名一般藏在 article.product_pod 之类的结构里,标题可能在 h3 a 的 title 属性上,这些都得在调试时在浏览器里查清楚,再写到脚本里。

许多新手能把代码跑通,却不理解为什么这三步缺一不可。把它们简单列出来,能协助你理解流程的本质:发起请求得到响应;把响应交给解析工具抽取所需字段;对抽取到的数据做处理或保存。掌握了这三件事,哪怕是换目标网站,改动也只是选择器或者保存格式的调整,不会影响整体逻辑。换句话说,先把这些流程搞清楚,再去琢磨 fancy 的并发、分布式或者反爬对策会顺得多。

在实践中会碰到不少小坑。列如请求超时、页面编码不对、元素定位不到、数据里夹着换行和多余空格、某些字段是通过 JavaScript 动态加载的而你用的请求库拿不到。这些都需要一步步排查:检查响应状态码,看是不是 200;打印响应头和前几百个字符确认编码和页面主体;在浏览器开发者工具里确认目标元素的确在初始 HTML 中,而不是等脚本跑完再渲染出来。细节多了,问题也就好定位。

提到工具生态,不得不说 Python 的生态优势。requests、BeautifulSoup、lxml、Selenium、Scrapy 这些库把常见问题都覆盖了。我们是站在巨人的肩膀上,用这些成熟工具去做抓取,效率高、出错率低。起手可以用最简单的五行代码把思路跑通,确认能拿到数据后,再按需引入更复杂的组件。

说点原则性的东西。作为技术博主,我有责任提醒你:技术无罪,但使用技术的人有界限。别去抓那些敏感数据、别去恶意刷接口、别违反网站的使用条款。爬虫界有句流行的话:爬虫写得好,牢饭吃得饱。别把技术当作可以随意突破规则的工具,守规矩也是对自己负责任。

那五行代码只是个起点。你可以把它拿来爬你喜爱的博客的文章标题,也可以去抓天气预报的简要信息,练练手。把 spider.py 拷贝到本地,改个目标 URL,定位到你要的元素,打印出来。一步步调试,遇到问题再去查错误信息,慢慢你就能把流程熟练掌握。

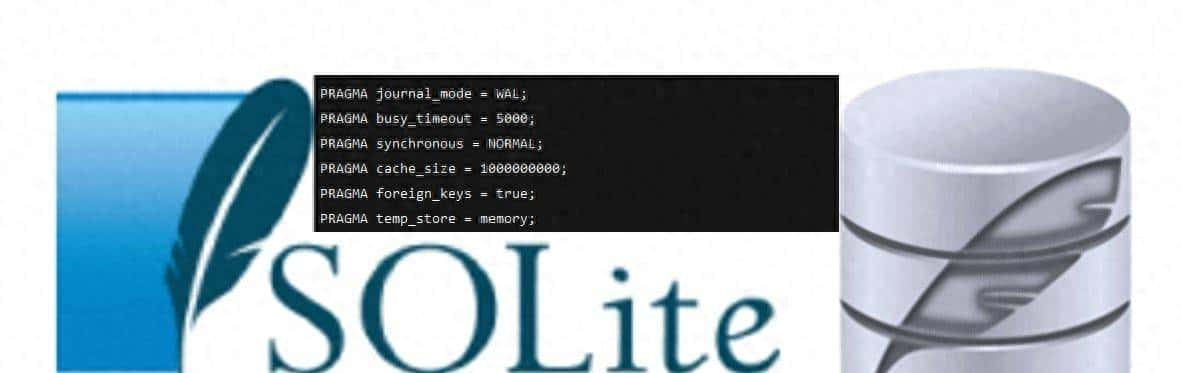

操作上面临的抉择不少。是直接用 requests 抓静态页面,还是用 Selenium 去渲染 JS?是把数据存成 CSV 还是入库?这些都得根据目标和规模来定。小规模练手,直接打印或存文件足够;要长期稳定抓取,得思考异常处理、重试策略、速率限制和数据去重。现实工作里,这些“工程化”的细节占了不少时间,也决定了项目能否稳定运行。

回到那两个单词:它们既是终点,也是起点。终点由于脚本跑完并返回了可用结果;起点由于接下来可以在这个基础上做扩展。先把这几行代码放到 spider.py 里,去爬一个你感兴趣的页面,当你能稳定拿到想要的字段,下一步就是把流程自动化、容错化、可扩展化。去试试吧,别光看着两词发呆。

相关文章