开发具有视觉 – 语言多模态生成能力的AI Agent

关键词:视觉 – 语言多模态,AI Agent,多模态生成,深度学习,计算机视觉,自然语言处理,多模态融合

摘要:本文围绕开发具有视觉 – 语言多模态生成能力的AI Agent展开。首先介绍了该领域的背景,包括目的、预期读者等信息。接着详细阐述了核心概念、算法原理、数学模型,通过Python代码进行算法原理的讲解。在项目实战部分,给出了开发环境搭建、源代码实现及解读。探讨了实际应用场景,推荐了相关的学习资源、开发工具框架和论文著作。最后总结了未来发展趋势与挑战,并提供了常见问题解答和扩展阅读参考资料,旨在为开发者和研究者全面深入地了解和开发此类AI Agent提供指导。

1. 背景介绍

1.1 目的和范围

随着人工智能技术的不断发展,单一模态的信息处理已经难以满足复杂场景下的需求。具有视觉 – 语言多模态生成能力的AI Agent能够同时处理图像和文本信息,并生成有意义的输出,这在智能客服、智能驾驶、智能家居等多个领域具有广泛的应用前景。本文的目的在于系统地介绍开发此类AI Agent的技术原理、算法实现和实际应用,范围涵盖从核心概念的阐述到项目实战的完整过程。

1.2 预期读者

本文预期读者包括人工智能领域的研究者、开发者,计算机科学相关专业的学生,以及对多模态人工智能技术感兴趣的技术爱好者。对于有一定深度学习和编程基础的读者,本文将帮助他们深入理解视觉 – 语言多模态生成的技术细节;对于初学者,本文可以作为入门指南,引导他们进入这个充满挑战和机遇的领域。

1.3 文档结构概述

本文将按照以下结构进行组织:首先介绍背景信息,为读者提供必要的上下文;接着阐述核心概念和它们之间的联系,通过文本示意图和Mermaid流程图进行直观展示;然后详细讲解核心算法原理,并给出Python源代码实现;之后介绍相关的数学模型和公式,并通过举例说明其应用;在项目实战部分,提供开发环境搭建、源代码实现和代码解读;探讨实际应用场景;推荐学习资源、开发工具框架和相关论文著作;最后总结未来发展趋势与挑战,提供常见问题解答和扩展阅读参考资料。

1.4 术语表

1.4.1 核心术语定义

视觉 – 语言多模态:指同时涉及视觉(如图像、视频)和语言(如文本)两种不同模态信息的处理和交互。AI Agent:人工智能代理,是一种能够感知环境、做出决策并采取行动以实现特定目标的软件实体。多模态生成:在多模态信息的基础上,生成包含多种模态信息的输出,例如根据图像生成描述性文本,或根据文本生成相关图像。多模态融合:将不同模态的信息进行整合,以获取更全面、准确的信息表示。

1.4.2 相关概念解释

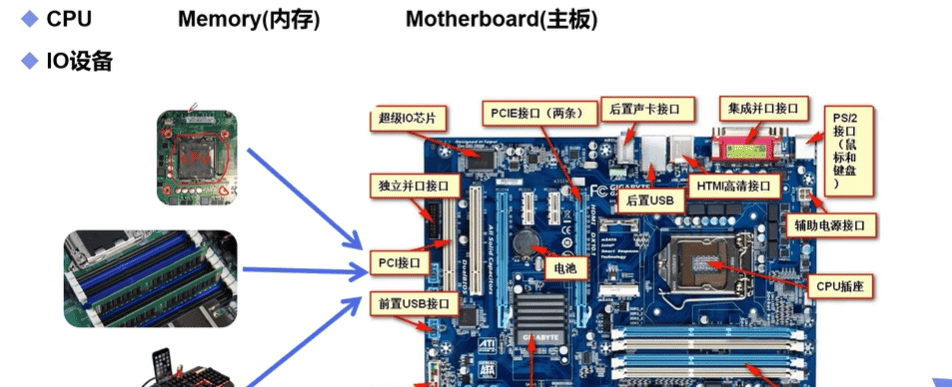

深度学习:一种基于人工神经网络的机器学习方法,通过多层神经网络自动学习数据的特征表示,在图像识别、自然语言处理等领域取得了巨大成功。计算机视觉:研究如何使计算机从图像或视频中获取有意义的信息,如图像分类、目标检测、图像生成等。自然语言处理:研究如何使计算机理解和处理人类语言,包括文本分类、机器翻译、问答系统等。

1.4.3 缩略词列表

CNN:Convolutional Neural Network,卷积神经网络,常用于图像特征提取。RNN:Recurrent Neural Network,循环神经网络,常用于处理序列数据,如文本。Transformer:一种基于注意力机制的神经网络架构,在自然语言处理和计算机视觉领域都有广泛应用。GAN:Generative Adversarial Network,生成对抗网络,用于生成数据,如图像、文本等。

2. 核心概念与联系

核心概念原理

视觉 – 语言多模态生成的核心在于将视觉信息和语言信息进行有效的融合和交互,以实现根据一种模态的输入生成另一种模态的输出。具体来说,它涉及以下几个关键步骤:

视觉特征提取:使用卷积神经网络(CNN)等模型从图像中提取特征。CNN通过卷积层、池化层等操作,自动学习图像的局部和全局特征。语言特征提取:使用循环神经网络(RNN)或Transformer等模型从文本中提取特征。RNN可以处理序列数据,而Transformer则通过注意力机制更好地捕捉序列中的长距离依赖关系。多模态融合:将视觉特征和语言特征进行融合,常见的方法包括拼接、元素级相乘等。融合后的特征可以表示图像和文本之间的关联信息。生成模型:使用生成对抗网络(GAN)、变分自编码器(VAE)等模型根据融合后的特征生成目标模态的输出。例如,根据图像特征生成描述性文本,或根据文本特征生成相关图像。

架构的文本示意图

+----------------+ +----------------+

| 图像输入 | | 文本输入 |

+----------------+ +----------------+

| |

v v

+----------------+ +----------------+

| 视觉特征提取器 | | 语言特征提取器 |

| (如CNN) | | (如Transformer)|

+----------------+ +----------------+

| |

v v

+------------------------------+

| 多模态融合层 |

| (如拼接、元素级相乘等) |

+------------------------------+

|

v

+----------------+

| 生成模型 |

| (如GAN、VAE等) |

+----------------+

|

v

+----------------+

| 输出结果 |

| (图像或文本) |

+----------------+

Mermaid流程图

3. 核心算法原理 & 具体操作步骤

视觉特征提取(以ResNet为例)

ResNet是一种经典的卷积神经网络,通过引入残差块解决了深度神经网络中的梯度消失问题。以下是使用PyTorch实现ResNet进行视觉特征提取的代码:

import torch

import torch.nn as nn

import torchvision.models as models

# 加载预训练的ResNet模型

resnet = models.resnet18(pretrained=True)

# 移除最后一层全连接层,用于特征提取

feature_extractor = nn.Sequential(*list(resnet.children())[:-1])

# 示例输入

image = torch.randn(1, 3, 224, 224) # 假设输入图像为1张3通道224x224的图像

# 提取特征

features = feature_extractor(image)

features = features.view(features.size(0), -1) # 展平特征

print("视觉特征形状:", features.shape)

语言特征提取(以Transformer为例)

Transformer由编码器和解码器组成,编码器用于对输入序列进行编码,解码器用于生成输出序列。以下是使用Hugging Face的Transformers库实现语言特征提取的代码:

from transformers import AutoTokenizer, AutoModel

# 加载预训练的Transformer模型和分词器

tokenizer = AutoTokenizer.from_pretrained('bert-base-uncased')

model = AutoModel.from_pretrained('bert-base-uncased')

# 示例输入

text = "This is an example sentence."

# 分词

inputs = tokenizer(text, return_tensors='pt')

# 提取特征

outputs = model(**inputs)

features = outputs.last_hidden_state.mean(dim=1) # 取平均作为句子特征

print("语言特征形状:", features.shape)

多模态融合(以拼接为例)

将视觉特征和语言特征进行拼接,形成融合后的特征。以下是拼接的代码实现:

# 假设视觉特征和语言特征已经提取

visual_features = torch.randn(1, 512)

language_features = torch.randn(1, 768)

# 拼接特征

fused_features = torch.cat((visual_features, language_features), dim=1)

print("融合特征形状:", fused_features.shape)

生成模型(以简单的全连接网络为例)

以下是一个简单的全连接网络作为生成模型的代码实现:

class Generator(nn.Module):

def __init__(self, input_dim, output_dim):

super(Generator, self).__init__()

self.fc = nn.Sequential(

nn.Linear(input_dim, 256),

nn.ReLU(),

nn.Linear(256, output_dim)

)

def forward(self, x):

return self.fc(x)

# 初始化生成模型

input_dim = fused_features.shape[1]

output_dim = 100 # 假设输出维度为100

generator = Generator(input_dim, output_dim)

# 生成输出

output = generator(fused_features)

print("生成输出形状:", output.shape)

4. 数学模型和公式 & 详细讲解 & 举例说明

卷积神经网络(CNN)

卷积操作

卷积操作是CNN的核心,它通过卷积核在输入图像上滑动,进行元素级相乘并求和,得到输出特征图。数学公式如下:

举例说明

假设输入图像 xxx 是一个 3×33 imes33×3 的矩阵,卷积核 kkk 是一个 2×22 imes22×2 的矩阵,偏置 b=0b = 0b=0。具体数值如下:

注意力机制

缩放点积注意力

缩放点积注意力是Transformer中使用的一种注意力机制,其数学公式如下:

举例说明

假设 QQQ、KKK 和 VVV 都是 3×23 imes23×2 的矩阵,具体数值如下:

生成对抗网络(GAN)

生成器和判别器

GAN由生成器 GGG 和判别器 DDD 组成,生成器的目标是生成逼真的数据,判别器的目标是区分真实数据和生成数据。其损失函数定义如下:

举例说明

假设真实数据是从一个正态分布中采样得到的,生成器 GGG 是一个简单的全连接网络,判别器 DDD 也是一个全连接网络。在训练过程中,生成器不断调整参数,使得生成的数据越来越接近真实数据,判别器不断调整参数,使得能够更好地区分真实数据和生成数据。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

安装Python

首先,确保你已经安装了Python 3.7或以上版本。可以从Python官方网站(https://www.python.org/downloads/)下载并安装。

创建虚拟环境

为了避免不同项目之间的依赖冲突,建议使用虚拟环境。可以使用

venv

conda

venv

python -m venv myenv

source myenv/bin/activate # 在Windows上使用 myenvScriptsactivate

安装依赖库

安装项目所需的依赖库,包括PyTorch、torchvision、transformers等。可以使用

pip

pip install torch torchvision

pip install transformers

5.2 源代码详细实现和代码解读

以下是一个完整的具有视觉 – 语言多模态生成能力的AI Agent的实现代码:

import torch

import torch.nn as nn

import torchvision.models as models

from transformers import AutoTokenizer, AutoModel

# 视觉特征提取器

class VisualFeatureExtractor(nn.Module):

def __init__(self):

super(VisualFeatureExtractor, self).__init__()

resnet = models.resnet18(pretrained=True)

self.feature_extractor = nn.Sequential(*list(resnet.children())[:-1])

def forward(self, image):

features = self.feature_extractor(image)

features = features.view(features.size(0), -1)

return features

# 语言特征提取器

class LanguageFeatureExtractor(nn.Module):

def __init__(self):

super(LanguageFeatureExtractor, self).__init__()

self.tokenizer = AutoTokenizer.from_pretrained('bert-base-uncased')

self.model = AutoModel.from_pretrained('bert-base-uncased')

def forward(self, text):

inputs = self.tokenizer(text, return_tensors='pt')

outputs = self.model(**inputs)

features = outputs.last_hidden_state.mean(dim=1)

return features

# 多模态融合器

class MultimodalFuser(nn.Module):

def __init__(self):

super(MultimodalFuser, self).__init__()

def forward(self, visual_features, language_features):

fused_features = torch.cat((visual_features, language_features), dim=1)

return fused_features

# 生成器

class Generator(nn.Module):

def __init__(self, input_dim, output_dim):

super(Generator, self).__init__()

self.fc = nn.Sequential(

nn.Linear(input_dim, 256),

nn.ReLU(),

nn.Linear(256, output_dim)

)

def forward(self, x):

return self.fc(x)

# 主类

class VisualLanguageAgent(nn.Module):

def __init__(self, output_dim):

super(VisualLanguageAgent, self).__init__()

self.visual_extractor = VisualFeatureExtractor()

self.language_extractor = LanguageFeatureExtractor()

self.fuser = MultimodalFuser()

visual_dim = 512 # ResNet18最后一层特征维度

language_dim = 768 # BERT特征维度

input_dim = visual_dim + language_dim

self.generator = Generator(input_dim, output_dim)

def forward(self, image, text):

visual_features = self.visual_extractor(image)

language_features = self.language_extractor(text)

fused_features = self.fuser(visual_features, language_features)

output = self.generator(fused_features)

return output

# 示例使用

if __name__ == "__main__":

image = torch.randn(1, 3, 224, 224)

text = "This is an example sentence."

output_dim = 100

agent = VisualLanguageAgent(output_dim)

output = agent(image, text)

print("输出形状:", output.shape)

5.3 代码解读与分析

VisualFeatureExtractor类:继承自

nn.Module

forward

6. 实际应用场景

智能客服

在智能客服场景中,具有视觉 – 语言多模态生成能力的AI Agent可以同时处理用户上传的图片和输入的文本信息。例如,用户在咨询电子产品问题时,上传产品外观图片并描述问题,AI Agent可以根据图片和文本信息生成准确的解决方案和建议,提高客服的效率和质量。

智能驾驶

在智能驾驶领域,AI Agent可以结合摄像头拍摄的道路图像和语音指令,进行更准确的决策。例如,当驾驶员发出语音指令“在前方路口右转”时,AI Agent可以根据图像识别前方路口的位置和交通状况,生成相应的驾驶策略。

智能家居

在智能家居场景中,AI Agent可以根据用户拍摄的家居环境图片和语音需求,生成个性化的家居布置方案。例如,用户拍摄客厅照片并说“我想让客厅更温馨”,AI Agent可以根据图片和需求推荐合适的家具、装饰品等。

教育领域

在教育领域,AI Agent可以根据教材中的图片和文字描述,生成生动的讲解视频或动画。例如,在学习生物课程时,AI Agent可以根据细胞结构图片和文字说明,生成详细的细胞结构讲解视频,帮助学生更好地理解知识。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《深度学习》(Deep Learning):由Ian Goodfellow、Yoshua Bengio和Aaron Courville撰写,是深度学习领域的经典教材,涵盖了神经网络、卷积神经网络、循环神经网络等多个方面的内容。《计算机视觉:算法与应用》(Computer Vision: Algorithms and Applications):Richard Szeliski所著,详细介绍了计算机视觉的各种算法和应用,包括图像特征提取、目标检测、图像分割等。《自然语言处理入门》(Natural Language Processing in Action):由Masato Hagiwara等人编写,适合初学者学习自然语言处理的基本概念和方法。

7.1.2 在线课程

Coursera上的“深度学习专项课程”(Deep Learning Specialization):由Andrew Ng教授授课,包括神经网络和深度学习、改善深层神经网络、结构化机器学习项目等多个课程,是学习深度学习的优质课程。edX上的“计算机视觉:从基础到前沿”(Computer Vision: From Basics to Frontiers):介绍了计算机视觉的基本原理和最新进展,包括图像分类、目标检测、图像生成等内容。百度AI Studio上的“自然语言处理入门课程”:提供了自然语言处理的基础知识和实践案例,适合初学者入门。

7.1.3 技术博客和网站

Medium:有许多人工智能领域的技术博客,如Towards Data Science、AI in Plain English等,提供了最新的技术文章和研究成果。arXiv:是一个预印本服务器,收录了大量的计算机科学、物理学等领域的研究论文,可以及时了解最新的研究动态。机器之心:专注于人工智能领域的资讯和技术解读,提供了丰富的行业新闻和技术文章。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

PyCharm:是一款专业的Python集成开发环境,提供了代码编辑、调试、版本控制等功能,适合开发Python项目。Jupyter Notebook:是一个交互式的开发环境,可以将代码、文本、图表等内容整合在一起,方便进行数据分析和模型实验。Visual Studio Code:是一款轻量级的代码编辑器,支持多种编程语言,有丰富的插件可以扩展功能。

7.2.2 调试和性能分析工具

PyTorch Profiler:是PyTorch自带的性能分析工具,可以分析模型的运行时间、内存使用等情况,帮助优化模型性能。TensorBoard:是TensorFlow的可视化工具,也可以与PyTorch结合使用,用于可视化模型的训练过程、损失曲线等。cProfile:是Python的内置性能分析工具,可以分析Python代码的运行时间和函数调用情况。

7.2.3 相关框架和库

PyTorch:是一个开源的深度学习框架,提供了丰富的神经网络模块和优化算法,支持GPU加速,广泛应用于计算机视觉、自然语言处理等领域。TensorFlow:是另一个流行的深度学习框架,具有强大的分布式训练能力和可视化工具,在工业界有广泛的应用。Hugging Face Transformers:是一个用于自然语言处理的开源库,提供了大量的预训练模型和工具,方便进行文本分类、机器翻译等任务。

7.3 相关论文著作推荐

7.3.1 经典论文

“Attention Is All You Need”:提出了Transformer架构,是自然语言处理领域的重要突破,为后续的研究奠定了基础。“Generative Adversarial Nets”:首次提出了生成对抗网络(GAN)的概念,开创了生成模型的新方向。“Deep Residual Learning for Image Recognition”:提出了残差网络(ResNet),解决了深度神经网络中的梯度消失问题,在图像识别领域取得了巨大成功。

7.3.2 最新研究成果

关注arXiv上的最新论文,如关于视觉 – 语言多模态预训练模型的研究,如CLIP、ALBEF等。参加国际顶级学术会议,如CVPR(计算机视觉与模式识别会议)、ICLR(国际学习表征会议)、ACL(计算语言学协会年会)等,了解最新的研究成果和趋势。

7.3.3 应用案例分析

可以参考一些知名公司的技术博客,如Google AI Blog、Facebook AI Research等,了解他们在多模态人工智能领域的应用案例和实践经验。分析开源项目中的应用案例,如GitHub上的一些视觉 – 语言多模态生成项目,学习他们的实现思路和技术细节。

8. 总结:未来发展趋势与挑战

未来发展趋势

更强的多模态融合能力:未来的AI Agent将能够更有效地融合视觉、语言、音频等多种模态的信息,实现更复杂的任务,如多模态对话、跨模态检索等。大规模预训练模型的应用:类似于GPT系列的大规模预训练模型将在视觉 – 语言多模态领域得到更广泛的应用,通过在大规模多模态数据上进行预训练,提高模型的泛化能力和生成质量。与现实世界的交互:AI Agent将不仅局限于处理静态的图像和文本,还将能够与现实世界进行交互,如控制机器人、操作智能家居设备等。

挑战

数据标注和获取:多模态数据的标注和获取是一个难题,需要耗费大量的人力和物力。如何高效地获取和标注多模态数据是未来需要解决的问题。计算资源需求:多模态生成模型通常需要大量的计算资源进行训练和推理,如何降低计算成本,提高模型的效率是一个挑战。语义理解和对齐:不同模态之间的语义理解和对齐是一个复杂的问题,如何准确地捕捉不同模态之间的语义关联,提高多模态生成的质量是未来的研究方向。

9. 附录:常见问题与解答

问题1:如何选择合适的视觉特征提取模型和语言特征提取模型?

解答:选择视觉特征提取模型可以考虑模型的性能、复杂度和应用场景。对于一般的图像分类任务,ResNet、VGG等经典模型是不错的选择;对于更复杂的任务,如目标检测、图像分割,可以选择Faster R – CNN、Mask R – CNN等模型。选择语言特征提取模型可以根据任务的需求和数据的特点,如对于文本分类任务,可以选择BERT、RoBERTa等预训练模型;对于序列生成任务,可以选择GPT、T5等模型。

问题2:多模态融合的方法有哪些?

解答:常见的多模态融合方法包括拼接、元素级相乘、注意力机制等。拼接是将不同模态的特征直接拼接在一起;元素级相乘是将不同模态的特征对应元素相乘;注意力机制可以根据不同模态的重要性动态地分配权重,实现更灵活的融合。

问题3:如何训练具有视觉 – 语言多模态生成能力的AI Agent?

解答:训练过程通常包括数据准备、模型定义、损失函数定义和优化器选择等步骤。首先,收集和标注多模态数据,将其划分为训练集、验证集和测试集。然后,定义视觉特征提取器、语言特征提取器、多模态融合器和生成模型。选择合适的损失函数,如交叉熵损失、均方误差损失等。最后,使用优化器(如Adam、SGD等)对模型进行训练,不断调整模型的参数,使得损失函数最小化。

问题4:多模态生成模型的评估指标有哪些?

解答:对于视觉生成任务,可以使用峰值信噪比(PSNR)、结构相似性指数(SSIM)等指标评估生成图像的质量;对于语言生成任务,可以使用困惑度(Perplexity)、BLEU分数等指标评估生成文本的质量。此外,还可以通过人工评估的方式,让人类评估生成结果的合理性和可读性。

10. 扩展阅读 & 参考资料

扩展阅读

《多模态机器学习:基础与应用》:深入介绍了多模态机器学习的理论和方法,包括多模态数据的表示、融合和生成等方面的内容。《人工智能:一种现代的方法》:全面介绍了人工智能的各个领域,包括搜索算法、机器学习、自然语言处理、计算机视觉等,是学习人工智能的经典教材。关注一些知名的技术社区和论坛,如Stack Overflow、Reddit的人工智能板块等,参与讨论和交流,了解最新的技术问题和解决方案。

参考资料

Goodfellow, I. J., Bengio, Y., & Courville, A. (2016). Deep Learning. MIT Press.Szeliski, R. (2010). Computer Vision: Algorithms and Applications. Springer.Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., … & Polosukhin, I. (2017). Attention is all you need. Advances in neural information processing systems, 30.Radford, A., Kim, J. W., Hallacy, C., Ramesh, A., Goh, G., Agarwal, S., … & Sutskever, I. (2021). Learning transferable visual models from natural language supervision. International Conference on Machine Learning.

相关文章

![[ICLR’24] MGIE](https://www.dunling.com/jietu/home/20250908/mllm-iegithubio-ico.jpg)