CUDA编程入门:写给AI程序员的GPU加速指南

理解GPU与CPU的架构差异

当你在训练一个包含数百万参数的神经网络时,是否曾因CPU计算速度过慢而感到沮丧?这正是GPU(图形处理器)大显身手的时刻。GPU与CPU在硬件架构上有着本质区别:CPU一般拥有4-16个强劲的核心,擅长处理复杂的串行任务;而GPU则配备了数千个小型计算核心,专为并行计算设计。以NVIDIA最新的A100 GPU为例,它拥有多达108个流式多处理器(SM),每个SM包含64个CUDA核心,总计7008个核心,这种架构使其在并行任务处理上远超CPU。

GPU与CPU的协同工作方式类似于工厂的生产线:CPU扮演着”管理层”的角色,负责任务分配和复杂逻辑决策;GPU则像”生产线工人”,高效执行大量重复计算。在AI训练中,这种分工体现为:CPU负责数据预处理、模型定义和训练流程控制,而GPU则承担核心的矩阵乘法、卷积运算等并行计算任务。

CUDA核心概念解析

CUDA(Compute Unified Device Architecture)是NVIDIA推出的并行计算平台和编程模型,它允许开发者利用GPU的强劲计算能力。理解CUDA编程,需要掌握三个核心概念:

线程层次结构

CUDA采用了一种层次化的线程组织方式:线程(Thread)→线程块(Block)→网格(Grid)。每个线程对应一个计算任务,多个线程组成线程块(最多1024个线程),多个线程块构成网格。这种结构允许开发者将大型并行任务分解为可管理的小任务。

例如,在处理1024×1024的矩阵乘法时,我们可以创建1024个线程块,每个线程块包含1024个线程,每个线程负责计算结果矩阵中的一个元素。

内存模型

CUDA设备内存分为多种类型,各有不同的用途和性能特征:

- 全局内存(Global Memory):最大的内存池,可被所有线程访问,但访问延迟最高。在深度学习中,模型权重和输入数据一般存储在这里。

- 共享内存(Shared Memory):由线程块内的线程共享,访问速度接近寄存器,适合存储中间计算结果。在卷积操作中,共享内存常被用来缓存输入特征图的局部区域,减少全局内存访问。

- 常量内存(Constant Memory):用于存储只读数据,被所有线程共享,具有缓存机制,适合存储神经网络中的偏置项或其他固定参数。

核函数

核函数(Kernel)是在GPU上执行的函数,通过__global__关键字声明。调用核函数时,需要指定线程块和网格的维度。例如:

// 声明核函数

__global__ void matrixMultiply(float *A, float *B, float *C, int N) {

// 计算线程索引

int row = blockIdx.y * blockDim.y + threadIdx.y;

int col = blockIdx.x * blockDim.x + threadIdx.x;

// 执行矩阵乘法

if (row < N && col < N) {

float sum = 0.0f;

for (int k = 0; k < N; k++) {

sum += A[row * N + k] * B[k * N + col];

}

C[row * N + col] = sum;

}

}

// 调用核函数,每个线程块包含16x16个线程

dim3 blockSize(16, 16);

dim3 gridSize((N + blockSize.x - 1) / blockSize.x, (N + blockSize.y - 1) / blockSize.y);

matrixMultiply<<<gridSize, blockSize>>>(d_A, d_B, d_C, N);

开发环境搭建

CUDA Toolkit安装步骤

Windows系统

- 访问NVIDIA官方网站下载CUDA Toolkit(https://developer.nvidia.com/cuda-downloads)

- 选择对应的Windows版本和安装方式(网络安装或本地安装)

- 运行安装程序,选择”自定义安装”,确保勾选”CUDA”、”CUDA Toolkit”、”CUDA Samples”等组件

- 安装完成后,验证环境变量是否配置正确(系统应自动添加CUDA_PATH)

- 打开命令提示符,输入nvcc -V,若显示CUDA编译器版本信息,则安装成功

Linux系统(以Ubuntu为例)

- 打开终端,更新系统包:sudo apt update && sudo apt upgrade

- 添加NVIDIA官方仓库:

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2004/x86_64/cuda-ubuntu2004.pin

sudo mv cuda-ubuntu2004.pin /etc/apt/preferences.d/cuda-repository-pin-600

sudo apt-key adv --fetch-keys https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2004/x86_64/7fa2af80.pub

sudo add-apt-repository "deb https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2004/x86_64/ /"

- 安装CUDA Toolkit:sudo apt install cuda

- 添加环境变量:在~/.bashrc文件末尾添加

export PATH=/usr/local/cuda/bin:$PATH

export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH

- 使环境变量生效:source ~/.bashrc

- 验证安装:nvcc -V

macOS系统

注意:自CUDA 10.2起,NVIDIA停止支持macOS。如果需要在Mac上开发,可以使用较早版本的CUDA Toolkit,或思考使用云GPU服务。

推荐IDE及调试工具

- Visual Studio Code:配合NVIDIA CUDA插件,提供语法高亮、代码补全和调试功能。

- NVIDIA Nsight Eclipse Edition:专为CUDA开发设计的IDE,集成了性能分析工具。

- PyCharm/IntelliJ IDEA:通过CUDA插件支持CUDA C++开发,适合同时进行Python和CUDA开发的AI程序员。

调试工具:

- cuda-gdb:命令行调试工具,支持GPU代码调试。

- Nsight Debugger:图形化调试工具,可在Visual Studio或Eclipse中集成使用。

“Hello CUDA”程序示例

下面是一个简单的CUDA程序,它在GPU上执行并行计算,并将结果返回给CPU:

#include <iostream>

#include <cuda_runtime.h>

// 核函数:在GPU上执行,每个线程将自己的索引写入数组

__global__ void helloCUDA(int *c, int N) {

int idx = blockIdx.x * blockDim.x + threadIdx.x;

if (idx < N) {

c[idx] = idx;

}

}

int main() {

const int N = 512;

int *h_c = new int[N]; // 主机内存

int *d_c; // 设备内存指针

// 1. 分配设备内存

cudaMalloc((void**)&d_c, N * sizeof(int));

// 2. 启动核函数,使用2个线程块,每个线程块256个线程

int blockSize = 256;

int gridSize = (N + blockSize - 1) / blockSize;

helloCUDA<<<gridSize, blockSize>>>(d_c, N);

// 3. 将结果从设备内存复制到主机内存

cudaMemcpy(h_c, d_c, N * sizeof(int), cudaMemcpyDeviceToHost);

// 4. 验证结果

bool success = true;

for (int i = 0; i < N; i++) {

if (h_c[i] != i) {

std::cout << "Error at index " << i << ": " << h_c[i] << " != " << i << std::endl;

success = false;

break;

}

}

if (success) {

std::cout << "Hello CUDA! All " << N << " elements computed correctly." << std::endl;

}

// 5. 释放内存

delete[] h_c;

cudaFree(d_c);

return 0;

}

编译和运行步骤:

- 将代码保存为hello_cuda.cu

- 使用nvcc编译:nvcc hello_cuda.cu -o hello_cuda

- 运行可执行文件:./hello_cuda(Linux/Mac)或hello_cuda.exe(Windows)

预期输出:Hello CUDA! All 512 elements computed correctly.

核心编程模型详解

CPU与GPU实现矩阵乘法的代码差异

矩阵乘法是深度学习中的核心运算,让我们对比CPU和GPU实现的差异。

CPU实现(串行计算):

void matrixMultiplyCPU(float *A, float *B, float *C, int N) {

for (int i = 0; i < N; i++) {

for (int j = 0; j < N; j++) {

float sum = 0.0f;

for (int k = 0; k < N; k++) {

sum += A[i * N + k] * B[k * N + j];

}

C[i * N + j] = sum;

}

}

}

GPU实现(并行计算):

__global__ void matrixMultiplyGPU(float *A, float *B, float *C, int N) {

// 计算当前线程的行和列

int row = blockIdx.y * blockDim.y + threadIdx.y;

int col = blockIdx.x * blockDim.x + threadIdx.x;

// 每个线程计算结果矩阵中的一个元素

if (row < N && col < N) {

float sum = 0.0f;

for (int k = 0; k < N; k++) {

sum += A[row * N + k] * B[k * N + col];

}

C[row * N + col] = sum;

}

}

调用GPU核函数:

// 设置线程块大小为16x16

dim3 blockSize(16, 16);

// 根据矩阵大小计算网格大小

dim3 gridSize((N + blockSize.x - 1) / blockSize.x, (N + blockSize.y - 1) / blockSize.y);

// 启动核函数

matrixMultiplyGPU<<<gridSize, blockSize>>>(d_A, d_B, d_C, N);

性能对比:对于1024×1024的单精度矩阵乘法,在Intel i7-10700K CPU上需要约1.2秒,而在NVIDIA RTX 3080 GPU上仅需约0.8毫秒,GPU实现速度提升了约1500倍!

线程块与线程的组织方式

CUDA线程组织采用二维结构,超级适合处理图像、矩阵等二维数据。以16×16的线程块为例,线程索引的计算方式如下:

int row = blockIdx.y * blockDim.y + threadIdx.y;

int col = blockIdx.x * blockDim.x + threadIdx.x;

这种组织方式使得每个线程可以自然地对应到矩阵中的一个元素。线程块的大小一般选择为32的倍数(如16×16=256,32×32=1024),以充分利用GPU的 warp 调度机制(一个warp包含32个线程,是GPU的基本调度单位)。

内存类型使用策略

全局内存优化策略:

- 使用合并访问:确保线程访问的内存地址连续,以提高内存带宽利用率。

- 使用内存对齐:将数据结构对齐到32字节边界,可提高访问效率。

- 减少全局内存访问:通过共享内存缓存重复访问的数据。

共享内存使用示例(矩阵乘法优化):

__global__ void matrixMultiplyShared(float *A, float *B, float *C, int N) {

// 声明共享内存

__shared__ float s_A[16][16];

__shared__ float s_B[16][16];

// 计算线程索引

int row = blockIdx.y * blockDim.y + threadIdx.y;

int col = blockIdx.x * blockDim.x + threadIdx.x;

float sum = 0.0f;

// 分块计算矩阵乘法

for (int m = 0; m < (N + 15) / 16; m++) {

// 加载A矩阵的块到共享内存

if (row < N && (m * 16 + threadIdx.x) < N) {

s_A[threadIdx.y][threadIdx.x] = A[row * N + m * 16 + threadIdx.x];

} else {

s_A[threadIdx.y][threadIdx.x] = 0.0f;

}

// 加载B矩阵的块到共享内存

if (col < N && (m * 16 + threadIdx.y) < N) {

s_B[threadIdx.y][threadIdx.x] = B[(m * 16 + threadIdx.y) * N + col];

} else {

s_B[threadIdx.y][threadIdx.x] = 0.0f;

}

// 等待所有线程加载完成

__syncthreads();

// 计算块内乘法

for (int k = 0; k < 16; k++) {

sum += s_A[threadIdx.y][k] * s_B[k][threadIdx.x];

}

// 等待所有线程完成当前块计算

__syncthreads();

}

// 存储结果

if (row < N && col < N) {

C[row * N + col] = sum;

}

}

通过使用共享内存,这个优化版本的矩阵乘法比基本实现快约4-5倍,由于共享内存访问速度远快于全局内存,且减少了全局内存的访问次数。

常量内存使用策略:

- 用于存储神经网络中的权重或偏置等只读参数。

- 利用常量内存的广播机制,多个线程可以同时访问同一个常量内存地址。

__constant__ float d_weights[1024]; // 声明常量内存

// 在主机端复制数据到常量内存

cudaMemcpyToSymbol(d_weights, h_weights, sizeof(float) * 1024);

性能优化入门

影响CUDA程序性能的关键因素

- 内存访问模式:全局内存的访问效率很大程度上取决于访问模式。合并访问(coalesced access)可以最大限度地利用内存带宽。

- 线程占用率:指活跃warp数与GPU最大warp数的比值。高线程占用率有助于隐藏内存访问延迟。一般提议每个SM至少有6-8个活跃warp(256-384个线程)。

- 指令吞吐量:GPU的计算能力,一般以单精度浮点运算(FLOPS)衡量。现代GPU如NVIDIA A100的FP32吞吐量可达19.5 TFLOPS。

- 数据传输开销:主机与设备之间的数据传输是常见的性能瓶颈。应尽量减少数据传输次数,使用异步传输 overlap 计算和数据传输。

nvprof性能分析工具使用

nvprof是CUDA自带的命令行性能分析工具,可以协助定位性能瓶颈:

# 基本使用

nvprof ./your_cuda_program

# 生成详细的性能报告

nvprof --analysis-metrics -o profile.nvvp ./your_cuda_program

# 可视化分析(需要NVIDIA Visual Profiler)

nvvp profile.nvvp

常用指标:

- gld_throughput:全局内存加载吞吐量

- gst_throughput:全局内存存储吞吐量

- shared_load_throughput:共享内存加载吞吐量

- shared_store_throughput:共享内存存储吞吐量

- flop_count_sp:单精度浮点运算次数

- achieved_occupancy:实际线程占用率

实用优化技巧及代码示例

技巧1:使用内存合并访问

优化前(非合并访问):

// 列优先访问会导致非合并访问

__global__ void nonCoalescedAccess(float *data, float *result, int N) {

int idx = blockIdx.x * blockDim.x + threadIdx.x;

if (idx < N) {

result[idx] = data[idx * N]; // 步长为N的访问,非合并

}

}

优化后(合并访问):

// 重排数据,使访问模式合并

__global__ void coalescedAccess(float *data, float *result, int N) {

int idx = blockIdx.x * blockDim.x + threadIdx.x;

if (idx < N) {

result[idx] = data[idx]; // 连续访问,合并访问

}

}

通过调整数据布局,使线程访问连续的内存地址,可以将全局内存吞吐量提高3-4倍。

技巧2:使用异步数据传输

利用CUDA流(Stream)实现计算和数据传输的并行:

cudaStream_t stream;

cudaStreamCreate(&stream);

// 异步内存复制(主机到设备)

cudaMemcpyAsync(d_input, h_input, size, cudaMemcpyHostToDevice, stream);

// 在流中启动核函数

kernel<<<gridSize, blockSize, 0, stream>>>(d_input, d_output);

// 异步内存复制(设备到主机)

cudaMemcpyAsync(h_output, d_output, size, cudaMemcpyDeviceToHost, stream);

// 等待流完成

cudaStreamSynchronize(stream);

cudaStreamDestroy(stream);

异步传输可以 overlap 数据传输和计算,对于需要频繁进行主机-设备数据交换的应用(如实时深度学习推理),可提升性能10-20%。

技巧3:使用CUDA数学库

CUDA提供了高度优化的数学库,如cuBLAS(线性代数)、cuFFT(傅里叶变换)、cuDNN(深度学习原语)等。直接使用这些库比手动实现更高效:

#include <cublas_v2.h>

// 使用cuBLAS进行矩阵乘法(C = alpha*A*B + beta*C)

cublasHandle_t handle;

cublasCreate(&handle);

float alpha = 1.0f, beta = 0.0f;

cublasSgemm(handle, CUBLAS_OP_N, CUBLAS_OP_N, N, N, N, &alpha,

d_A, N, d_B, N, &beta, d_C, N);

cublasDestroy(handle);

cuBLAS实现的矩阵乘法一般比手动优化的CUDA代码快20-30%,由于它包含了针对特定GPU架构的深度优化。

CUDA在AI领域的应用案例

CUDA在深度学习框架中的应用

主流深度学习框架如TensorFlow和PyTorch都深度集成了CUDA,通过CUDA加速各种神经网络操作:

PyTorch中的CUDA使用:

import torch

# 检查CUDA是否可用

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

print(f"Using device: {device}")

# 创建张量并移动到GPU

x = torch.randn(1024, 1024, device=device)

y = torch.randn(1024, 1024, device=device)

# 在GPU上执行矩阵乘法

z = torch.matmul(x, y)

# 将结果移回CPU

z_cpu = z.cpu()

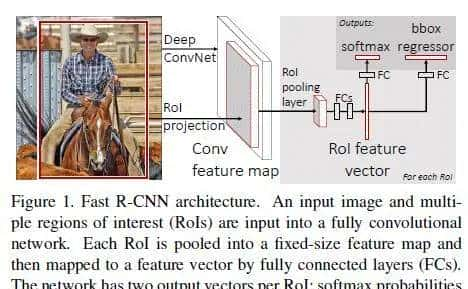

PyTorch的nn.Conv2d层在CUDA上的实现使用了cuDNN库,该库针对卷积操作进行了极致优化,包括Winograd算法、FFT卷积等高级优化技术。

TensorRT加速工具工作原理

TensorRT是NVIDIA开发的深度学习推理优化器和运行时引擎,它通过以下技术提高推理性能:

- 网络优化:

- 层融合(Layer Fusion):将多个层合并为单个核函数,减少内核启动开销和内存访问。

- 常量折叠(Constant Folding):预计算常量表达式,减少运行时计算量。

- 水平层融合(Horizontal Fusion):合并具有一样输入的多个层。

- 精度优化:

- 支持FP32、FP16、INT8等多种精度,在精度损失可接受的情况下降低计算量和内存带宽需求。

- INT8量化可将模型大小减少75%,推理速度提升2-4倍。

- 运行时优化:

- 动态张量内存(Dynamic Tensor Memory):根据需要动态分配张量内存,减少内存占用。

- 多流执行(Multi-stream Execution):利用CUDA流并行处理多个推理请求。

TensorRT使用示例:

import tensorrt as trt

import torch

# 将PyTorch模型转换为ONNX格式

model = torch.hub.load('pytorch/vision:v0.10.0', 'resnet18', pretrained=True).eval()

input_tensor = torch.randn(1, 3, 224, 224)

torch.onnx.export(model, input_tensor, "resnet18.onnx", opset_version=12)

# 使用TensorRT优化ONNX模型

TRT_LOGGER = trt.Logger(trt.Logger.WARNING)

builder = trt.Builder(TRT_LOGGER)

network = builder.create_network(1 << int(trt.NetworkDefinitionCreationFlag.EXPLICIT_BATCH))

parser = trt.OnnxParser(network, TRT_LOGGER)

with open("resnet18.onnx", "rb") as f:

parser.parse(f.read())

config = builder.create_builder_config()

config.max_workspace_size = 1 << 30 # 1GB工作空间

serialized_engine = builder.build_serialized_network(network, config)

# 创建推理引擎并执行推理

runtime = trt.Runtime(TRT_LOGGER)

engine = runtime.deserialize_cuda_engine(serialized_engine)

context = engine.create_execution_context()

# 分配输入输出内存

inputs, outputs, bindings, stream = allocate_buffers(engine)

inputs[0].host = input_tensor.numpy()

# 执行推理

trt_outputs = do_inference_v2(context, bindings=bindings, inputs=inputs, outputs=outputs, stream=stream)

CUDA在AI模型训练与推理中的性能提升潜力

CUDA技术的不断发展为AI模型训练和推理带来了持续的性能提升:

- 训练性能提升:

- 多GPU训练:通过NVIDIA的NVLink技术,可实现多个GPU之间的高速通信,支持大规模模型并行和数据并行训练。

- 自动混合精度训练:结合FP16和FP32精度,在保持训练稳定性的同时,将训练速度提升2倍。

- 分布式训练:通过NVIDIA Collective Communication Library (NCCL) 实现多节点、多GPU集群的高效通信。

- 推理性能提升:

- 实时推理:对于图像分类等任务,现代GPU可实现每秒数千甚至数万张图像的处理速度,支持实时应用。

- 边缘设备推理:NVIDIA Jetson系列嵌入式平台将CUDA加速带到边缘设备,支持AI在边缘的部署。

- 未来展望:

- NVIDIA Hopper架构引入了新的Tensor Core,支持更灵活的张量操作,进一步提升AI计算效率。

- 量子计算与AI的结合:NVIDIA正在探索使用CUDA加速量子机器学习算法。

根据NVIDIA官方数据,从2012年到2022年,GPU的AI性能提升了超过10000倍,这种指数级增长极大地推动了深度学习和AI技术的发展。

总结

CUDA编程是AI程序员必备的技能之一,它能协助你充分利用GPU的强劲计算能力,显著提高AI模型的训练和推理速度。本文介绍了CUDA的基础概念、开发环境搭建、核心编程模型、性能优化技巧以及在AI领域的应用案例。

作为AI程序员,掌握CUDA不仅能让你更好地理解深度学习框架的底层实现,还能协助你开发自定义的高性能算子,解决特定领域的性能挑战。随着AI模型规模的不断增长(如GPT-3拥有1750亿参数),高效利用GPU计算资源变得越来越重大。

希望本文能为你打开CUDA编程的大门,鼓励你进一步探索GPU加速的世界。记住,最好的学习方法是实践——尝试修改本文中的代码示例,实现自己的CUDA加速算子,或优化现有的AI模型。祝你在CUDA编程的旅程中取得成功!

相关文章