开发具有自然语言生成能力的AI Agent

开发具有自然语言生成能力的AI Agent

关键词:自然语言生成、AI Agent、深度学习、Transformer、语言模型、项目实战、应用场景

摘要:本文围绕开发具有自然语言生成能力的AI Agent展开,详细阐述了相关核心概念、算法原理、数学模型等内容。首先介绍了开发的背景,包括目的、预期读者等。接着深入讲解了自然语言生成和AI Agent的核心概念及联系,给出了原理和架构的示意图与流程图。通过Python代码详细阐述了核心算法原理和具体操作步骤,并对数学模型和公式进行了详细讲解与举例。在项目实战部分,从开发环境搭建到源代码实现及解读都进行了细致说明。同时探讨了实际应用场景,推荐了相关的学习资源、开发工具框架和论文著作。最后总结了未来发展趋势与挑战,并提供了常见问题解答和扩展阅读参考资料。

1. 背景介绍

1.1 目的和范围

随着人工智能技术的飞速发展,自然语言处理领域取得了显著的进展。开发具有自然语言生成能力的AI Agent旨在创建能够理解和生成人类语言的智能体,以实现与人类的自然交互。这种AI Agent可以应用于多个领域,如智能客服、智能写作、智能对话系统等。本文的范围将涵盖从核心概念的介绍到实际项目开发的整个过程,包括算法原理、数学模型、代码实现等方面。

1.2 预期读者

本文的预期读者包括对人工智能、自然语言处理感兴趣的技术爱好者,从事相关领域研究和开发的专业人员,以及希望了解如何开发具有自然语言生成能力的AI Agent的初学者。

1.3 文档结构概述

本文将按照以下结构进行组织:首先介绍相关背景知识,包括目的、预期读者和文档结构。接着深入探讨核心概念与联系,包括自然语言生成和AI Agent的原理和架构。然后详细讲解核心算法原理和具体操作步骤,并用Python代码进行说明。之后介绍数学模型和公式,并举例说明。在项目实战部分,将详细介绍开发环境搭建、源代码实现和代码解读。随后探讨实际应用场景,推荐相关的工具和资源。最后总结未来发展趋势与挑战,提供常见问题解答和扩展阅读参考资料。

1.4 术语表

1.4.1 核心术语定义

自然语言生成(Natural Language Generation, NLG):是指将非自然语言形式的数据或信息转换为自然语言文本的过程。AI Agent:是一种能够感知环境、进行决策并采取行动的智能实体,在自然语言处理中,AI Agent可以根据输入的信息生成自然语言响应。Transformer:是一种基于注意力机制的深度学习模型架构,在自然语言处理领域取得了巨大成功。语言模型:是一种用于计算语言序列概率的模型,通过学习大量的文本数据来预测下一个词的概率。

1.4.2 相关概念解释

注意力机制(Attention Mechanism):是一种能够让模型在处理序列数据时,自动关注序列中不同部分的机制,从而提高模型的性能。预训练模型(Pretrained Model):是指在大规模数据集上进行无监督学习得到的模型,这些模型可以在特定任务上进行微调,以提高性能。微调(Fine-tuning):是指在预训练模型的基础上,使用特定任务的数据集对模型进行进一步训练,以适应具体任务的需求。

1.4.3 缩略词列表

NLG:Natural Language GenerationRNN:Recurrent Neural NetworkLSTM:Long Short-Term MemoryGRU:Gated Recurrent UnitGPT:Generative Pretrained TransformerBERT:Bidirectional Encoder Representations from Transformers

2. 核心概念与联系

自然语言生成的原理

自然语言生成的核心目标是将结构化或半结构化的数据转换为自然流畅的文本。其过程通常包括以下几个步骤:

内容确定:从输入的数据中选择需要表达的信息。文本规划:组织选定的信息,确定文本的结构和布局。语句生成:根据文本规划的结果,生成具体的语句。语言实现:对生成的语句进行语法和词汇的调整,使其符合自然语言的表达习惯。

AI Agent的原理

AI Agent是一种能够自主感知环境、进行决策并采取行动的智能实体。在自然语言处理中,AI Agent通常包括以下几个部分:

感知模块:负责接收外界的输入信息,如用户的问题或指令。决策模块:根据感知模块接收到的信息,进行推理和决策,确定应该采取的行动。行动模块:根据决策模块的结果,生成相应的自然语言响应或执行其他操作。

核心概念的联系

自然语言生成是AI Agent实现自然语言交互的重要手段。AI Agent通过感知模块接收用户的输入信息,决策模块根据这些信息进行推理和决策,然后使用自然语言生成技术生成相应的响应。同时,自然语言生成的结果也可以作为AI Agent感知环境的一部分,用于进一步的决策和行动。

核心概念原理和架构的文本示意图

+---------------------+

| AI Agent |

+---------------------+

| 感知模块 |

| 接收用户输入信息 |

+---------------------+

| 决策模块 |

| 根据输入信息推理决策|

+---------------------+

| 行动模块 |

| 使用NLG生成响应 |

+---------------------+

| 自然语言生成(NLG) |

| 内容确定 -> 文本规划|

| -> 语句生成 -> 语言实现|

+---------------------+

Mermaid流程图

3. 核心算法原理 & 具体操作步骤

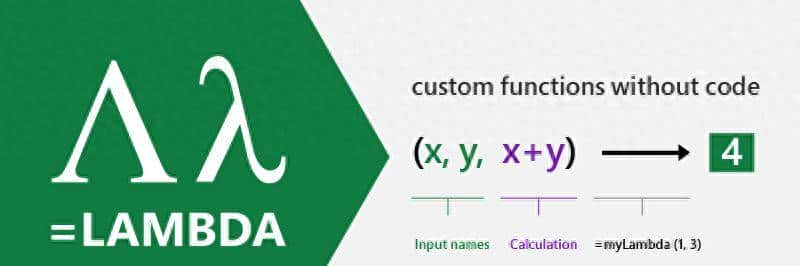

核心算法:Transformer

Transformer是一种基于注意力机制的深度学习模型架构,它在自然语言处理领域取得了巨大成功。Transformer的核心组件包括多头注意力机制(Multi-Head Attention)和前馈神经网络(Feed-Forward Network)。

多头注意力机制

多头注意力机制允许模型在不同的表示子空间中同时关注输入序列的不同部分。其计算公式如下:

多头注意力机制将输入的查询、键和值分别投影到多个低维子空间中,然后在每个子空间中计算注意力分数,最后将这些分数拼接起来并进行线性变换。

前馈神经网络

前馈神经网络是一个两层的全连接神经网络,用于对多头注意力机制的输出进行非线性变换。其计算公式如下:

Python代码实现

import torch

import torch.nn as nn

import torch.nn.functional as F

# 多头注意力机制

class MultiHeadAttention(nn.Module):

def __init__(self, d_model, num_heads):

super(MultiHeadAttention, self).__init__()

assert d_model % num_heads == 0, "d_model must be divisible by num_heads"

self.d_model = d_model

self.num_heads = num_heads

self.d_k = d_model // num_heads

self.W_q = nn.Linear(d_model, d_model)

self.W_k = nn.Linear(d_model, d_model)

self.W_v = nn.Linear(d_model, d_model)

self.W_o = nn.Linear(d_model, d_model)

def scaled_dot_product_attention(self, Q, K, V, mask=None):

attn_scores = torch.matmul(Q, K.transpose(-2, -1)) / torch.sqrt(torch.tensor(self.d_k, dtype=torch.float32))

if mask is not None:

attn_scores = attn_scores.masked_fill(mask == 0, -1e9)

attn_probs = F.softmax(attn_scores, dim=-1)

output = torch.matmul(attn_probs, V)

return output

def split_heads(self, x):

batch_size, seq_length, d_model = x.size()

return x.view(batch_size, seq_length, self.num_heads, self.d_k).transpose(1, 2)

def combine_heads(self, x):

batch_size, num_heads, seq_length, d_k = x.size()

return x.transpose(1, 2).contiguous().view(batch_size, seq_length, self.d_model)

def forward(self, Q, K, V, mask=None):

Q = self.split_heads(self.W_q(Q))

K = self.split_heads(self.W_k(K))

V = self.split_heads(self.W_v(V))

attn_output = self.scaled_dot_product_attention(Q, K, V, mask)

output = self.W_o(self.combine_heads(attn_output))

return output

# 前馈神经网络

class FeedForwardNetwork(nn.Module):

def __init__(self, d_model, d_ff):

super(FeedForwardNetwork, self).__init__()

self.fc1 = nn.Linear(d_model, d_ff)

self.fc2 = nn.Linear(d_ff, d_model)

def forward(self, x):

return self.fc2(F.relu(self.fc1(x)))

# Transformer编码器层

class EncoderLayer(nn.Module):

def __init__(self, d_model, num_heads, d_ff, dropout):

super(EncoderLayer, self).__init__()

self.self_attn = MultiHeadAttention(d_model, num_heads)

self.feed_forward = FeedForwardNetwork(d_model, d_ff)

self.norm1 = nn.LayerNorm(d_model)

self.norm2 = nn.LayerNorm(d_model)

self.dropout = nn.Dropout(dropout)

def forward(self, x, mask):

attn_output = self.self_attn(x, x, x, mask)

x = self.norm1(x + self.dropout(attn_output))

ff_output = self.feed_forward(x)

x = self.norm2(x + self.dropout(ff_output))

return x

具体操作步骤

数据预处理:将输入的文本数据进行分词、编码等处理,转换为模型可以接受的输入格式。模型构建:使用上述代码构建Transformer模型。模型训练:使用大规模的文本数据集对模型进行训练,优化模型的参数。模型评估:使用测试数据集对训练好的模型进行评估,评估指标可以包括准确率、召回率、F1值等。模型应用:将训练好的模型应用于实际任务中,如自然语言生成、文本分类等。

4. 数学模型和公式 & 详细讲解 & 举例说明

语言模型的数学定义

语言模型是一种用于计算语言序列概率的模型。给定一个词序列 w1,w2,⋯ ,wnw_1, w_2, cdots, w_nw1,w2,⋯,wn,语言模型的目标是计算该序列的概率 P(w1,w2,⋯ ,wn)P(w_1, w_2, cdots, w_n)P(w1,w2,⋯,wn)。根据链式法则,该概率可以表示为:

n-gram语言模型

n-gram语言模型是一种简单的语言模型,它假设每个词的概率只依赖于前面的 n−1n-1n−1 个词。因此,n-gram语言模型可以将上述概率公式简化为:

例如,对于一个2-gram(即bigram)语言模型,计算 P(wi∣wi−1)P(w_i | w_{i-1})P(wi∣wi−1) 的概率。假设我们有一个文本数据集:[“I”, “love”, “natural”, “language”, “processing”],我们可以统计每个bigram出现的频率,然后计算相应的概率。

Transformer模型的数学原理

Transformer模型的核心是多头注意力机制和前馈神经网络。下面我们详细讲解多头注意力机制的数学原理。

多头注意力机制的详细公式

多头注意力机制将输入的查询 QQQ、键 KKK 和值 VVV 分别投影到多个低维子空间中,然后在每个子空间中计算注意力分数。具体步骤如下:

投影:

投影:

对于第1个头,我们有:

pip install torch

pip install transformers

pip install datasets

选择开发环境

可以使用Jupyter Notebook、PyCharm等开发环境进行项目开发。

5.2 源代码详细实现和代码解读

数据准备

我们使用Hugging Face的

datasets

from datasets import load_dataset

# 加载数据集

dataset = load_dataset("wikitext", "wikitext-2-raw-v1")

# 分词器

from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("gpt2")

# 数据预处理

def preprocess_function(examples):

return tokenizer(examples["text"], truncation=True)

tokenized_dataset = dataset.map(preprocess_function, batched=True)

模型构建

我们使用Hugging Face的

transformers

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("gpt2")

训练配置

我们使用

transformers

TrainingArguments

Trainer

from transformers import TrainingArguments, Trainer

training_args = TrainingArguments(

output_dir="./results",

num_train_epochs=3,

per_device_train_batch_size=4,

per_device_eval_batch_size=4,

warmup_steps=500,

weight_decay=0.01,

logging_dir="./logs",

logging_steps=10,

evaluation_strategy="steps",

eval_steps=500,

save_steps=500

)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset["train"],

eval_dataset=tokenized_dataset["validation"]

)

模型训练

trainer.train()

模型推理

input_text = "Once upon a time"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids, max_length=100, num_beams=5, no_repeat_ngram_size=2)

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(generated_text)

5.3 代码解读与分析

数据准备

使用

datasets

wikitext-2-raw-v1

AutoTokenizer

map

模型构建

使用

AutoModelForCausalLM

训练配置

使用

TrainingArguments

Trainer

模型训练

调用

trainer.train()

模型推理

输入一个文本序列,使用分词器将其编码为输入ID。调用

model.generate()

6. 实际应用场景

智能客服

具有自然语言生成能力的AI Agent可以应用于智能客服系统中,自动回答用户的问题。它可以根据用户的问题,从知识库中提取相关信息,并生成自然流畅的回答。例如,在电商平台的客服系统中,AI Agent可以回答用户关于商品信息、订单状态、售后服务等方面的问题。

智能写作

AI Agent可以帮助用户进行写作,如生成文章、故事、诗歌等。它可以根据用户提供的主题和关键词,生成相应的文本内容。例如,在新闻媒体领域,AI Agent可以根据新闻事件的相关信息,生成新闻报道。

智能对话系统

智能对话系统是AI Agent的一个重要应用场景。它可以与用户进行自然流畅的对话,理解用户的意图,并提供相应的响应。例如,在智能家居系统中,用户可以通过语音与AI Agent进行对话,控制家电设备、查询天气信息等。

机器翻译

AI Agent可以用于机器翻译任务,将一种语言的文本翻译成另一种语言。它可以学习大量的双语语料库,掌握语言之间的对应关系,从而实现准确的翻译。例如,谷歌翻译等翻译工具就使用了类似的技术。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《深度学习》(Deep Learning):由Ian Goodfellow、Yoshua Bengio和Aaron Courville撰写,是深度学习领域的经典教材,涵盖了神经网络、卷积神经网络、循环神经网络等内容。《自然语言处理入门》(Natural Language Processing in Action):由Jakub Adamczyk和Delip Rao撰写,介绍了自然语言处理的基本概念和技术,包括分词、词性标注、命名实体识别等。《Transformer神经网络:注意力机制的自然语言处理》(Transformers for Natural Language Processing):由Denis Rothman撰写,深入讲解了Transformer模型的原理和应用。

7.1.2 在线课程

Coursera上的“深度学习专项课程”(Deep Learning Specialization):由Andrew Ng教授授课,包括神经网络、卷积神经网络、循环神经网络等多个课程,是学习深度学习的优质资源。edX上的“自然语言处理”(Natural Language Processing):由Columbia University提供,介绍了自然语言处理的基本概念和技术,包括语言模型、机器翻译、文本分类等。Hugging Face的“自然语言处理课程”(Natural Language Processing Course):提供了丰富的自然语言处理教程和实践项目,适合初学者和有一定基础的开发者。

7.1.3 技术博客和网站

Hugging Face的博客(https://huggingface.co/blog):提供了关于自然语言处理、深度学习等领域的最新技术和研究成果。Towards Data Science(https://towardsdatascience.com/):是一个数据科学和机器学习领域的技术博客,有很多关于自然语言处理的文章和教程。arXiv(https://arxiv.org/):是一个学术论文预印本平台,提供了大量关于自然语言处理、深度学习等领域的最新研究论文。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

PyCharm:是一款专门为Python开发设计的集成开发环境,提供了代码编辑、调试、版本控制等功能。Jupyter Notebook:是一个交互式的开发环境,适合进行数据探索、模型训练和可视化等工作。Visual Studio Code:是一款轻量级的代码编辑器,支持多种编程语言,并且有丰富的插件可以扩展功能。

7.2.2 调试和性能分析工具

PyTorch Profiler:是PyTorch提供的性能分析工具,可以帮助开发者分析模型的运行时间、内存使用等情况。TensorBoard:是TensorFlow提供的可视化工具,可以用于可视化模型的训练过程、性能指标等。NVIDIA Nsight Systems:是NVIDIA提供的性能分析工具,可以帮助开发者分析GPU的使用情况和性能瓶颈。

7.2.3 相关框架和库

PyTorch:是一个开源的深度学习框架,提供了丰富的神经网络模块和优化算法,广泛应用于自然语言处理、计算机视觉等领域。TensorFlow:是另一个流行的深度学习框架,具有强大的分布式训练和部署能力。Hugging Face Transformers:是一个专门用于自然语言处理的库,提供了大量的预训练模型和工具,方便开发者进行模型的训练和推理。

7.3 相关论文著作推荐

7.3.1 经典论文

“Attention Is All You Need”:介绍了Transformer模型的原理和架构,是自然语言处理领域的经典论文。“BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding”:提出了BERT模型,开创了预训练模型在自然语言处理中的应用。“Generative Pretrained Transformer 2: Language Models are Unsupervised Multitask Learners”:介绍了GPT-2模型,展示了生成式预训练模型的强大能力。

7.3.2 最新研究成果

关注arXiv上关于自然语言生成、AI Agent等领域的最新研究论文,了解最新的技术和方法。参加自然语言处理领域的学术会议,如ACL、EMNLP等,获取最新的研究成果和行业动态。

7.3.3 应用案例分析

研究一些实际应用案例,如智能客服系统、智能写作工具等,了解如何将自然语言生成和AI Agent技术应用到实际项目中。参考一些开源项目,如ChatterBot、AllenNLP等,学习它们的实现思路和代码结构。

8. 总结:未来发展趋势与挑战

未来发展趋势

多模态融合:未来的AI Agent将不仅仅局限于处理文本数据,还将融合图像、音频、视频等多种模态的数据,实现更加自然和丰富的交互。个性化服务:AI Agent将能够根据用户的个性化需求和偏好,提供更加个性化的服务和响应。例如,智能客服系统可以根据用户的历史记录和行为习惯,提供更加精准的解决方案。强化学习的应用:强化学习可以帮助AI Agent在与环境的交互中不断学习和优化,提高其决策能力和性能。未来,强化学习将在AI Agent的开发中得到更广泛的应用。跨语言和跨文化交流:随着全球化的发展,AI Agent需要具备跨语言和跨文化交流的能力,能够理解和生成不同语言和文化背景下的自然语言。

挑战

数据质量和隐私问题:自然语言生成和AI Agent的训练需要大量的高质量数据,但数据的收集和标注过程可能存在质量问题和隐私风险。如何解决数据质量和隐私问题是一个重要的挑战。语义理解和推理能力:虽然现有的语言模型在自然语言生成方面取得了很大的进展,但在语义理解和推理能力方面仍然存在不足。如何提高AI Agent的语义理解和推理能力是一个亟待解决的问题。可解释性和可信度:由于深度学习模型的复杂性,其决策过程往往难以解释,这给AI Agent的应用带来了一定的风险。如何提高AI Agent的可解释性和可信度是一个重要的研究方向。计算资源和效率问题:训练和运行具有自然语言生成能力的AI Agent需要大量的计算资源和时间。如何提高计算效率,降低计算成本是一个实际应用中需要解决的问题。

9. 附录:常见问题与解答

问题1:自然语言生成和自然语言理解有什么区别?

自然语言生成是将非自然语言形式的数据或信息转换为自然语言文本的过程,而自然语言理解是将自然语言文本转换为计算机能够理解的表示形式的过程。简单来说,自然语言生成是输出自然语言,而自然语言理解是输入自然语言。

问题2:如何选择合适的预训练模型?

选择合适的预训练模型需要考虑以下几个因素:

任务类型:不同的预训练模型适用于不同的任务,如文本分类、自然语言生成、机器翻译等。数据集大小:如果数据集较小,可以选择较小的预训练模型;如果数据集较大,可以选择较大的预训练模型。计算资源:较大的预训练模型需要更多的计算资源和时间,因此需要根据自己的计算资源来选择合适的模型。

问题3:如何提高自然语言生成的质量?

可以从以下几个方面提高自然语言生成的质量:

使用高质量的训练数据:训练数据的质量直接影响模型的性能,因此需要使用高质量的训练数据。调整模型参数:可以通过调整模型的参数,如学习率、批次大小等,来提高模型的性能。使用后处理技术:可以使用后处理技术,如语法检查、文本纠错等,来提高生成文本的质量。

问题4:AI Agent可以应用于哪些领域?

AI Agent可以应用于多个领域,如智能客服、智能写作、智能对话系统、机器翻译、智能家居、智能医疗等。

10. 扩展阅读 & 参考资料

扩展阅读

《人工智能:现代方法》(Artificial Intelligence: A Modern Approach):全面介绍了人工智能的基本概念、技术和应用。《动手学深度学习》(Dive into Deep Learning):通过实际代码示例,介绍了深度学习的基本概念和技术。《自然语言处理综论》(Speech and Language Processing):是自然语言处理领域的经典教材,涵盖了自然语言处理的各个方面。

参考资料

Hugging Face官方文档(https://huggingface.co/docs):提供了关于Hugging Face Transformers库的详细文档和教程。PyTorch官方文档(https://pytorch.org/docs/stable/index.html):提供了关于PyTorch框架的详细文档和教程。TensorFlow官方文档(https://www.tensorflow.org/api_docs):提供了关于TensorFlow框架的详细文档和教程。

相关文章