一、本地环境准备

安装Ollama

访问Ollama官网,根据操作系统下载对应版本(Windows/Mac/Linux)。

安装完成后,打开终端输入ollama -v验证是否成功(显示版本号如0.5.7即正常)。

注意:若提示“ollama不是命令”,需检查环境变量PATH是否包含安装路径,或重启系统。

部署DeepSeek模型

根据硬件配置选择模型:

无独立显卡:推荐1.5B(需8G内存)

4G-8G显存:选择7B/8B(如笔记本4070显卡选8B)

高性能显卡:可选14B/32B(需16G以上显存)

终端执行命令下载模型:

bash

ollama run deepseek-r1:8b # 以8B模型为例

测试模型:输入简单问题(如“9.9比9.11谁大”),观察是否返回逻辑推理结果。

二、AnythingLLM安装与配置

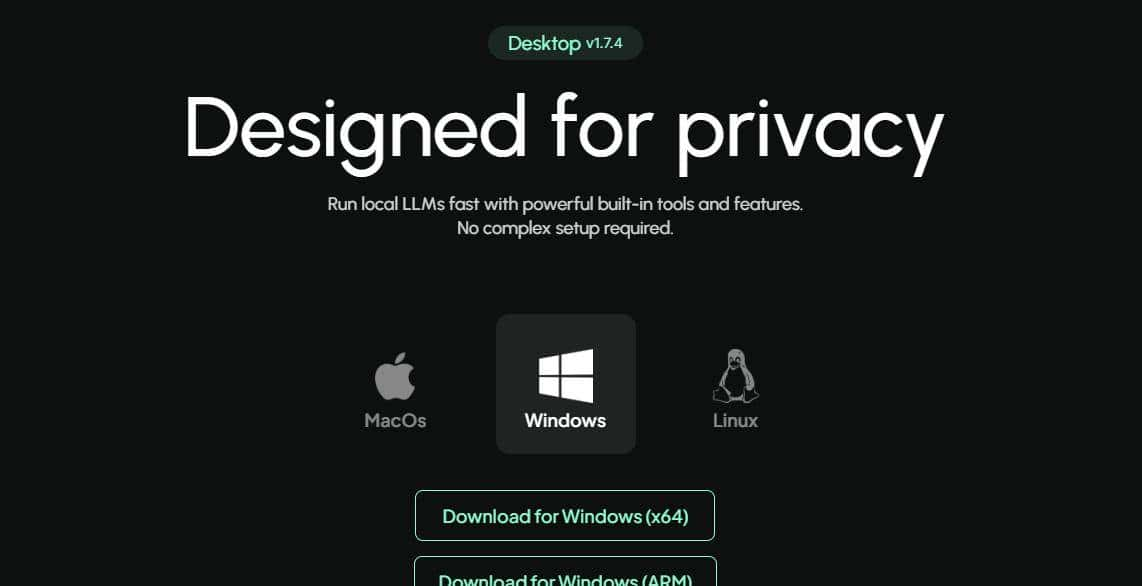

下载与安装

官网下载:https://anythingllm.com(支持Windows/Mac/Linux)

备选方案:通过百度云盘获取安装包(提取码ajk4),避免网络限制。

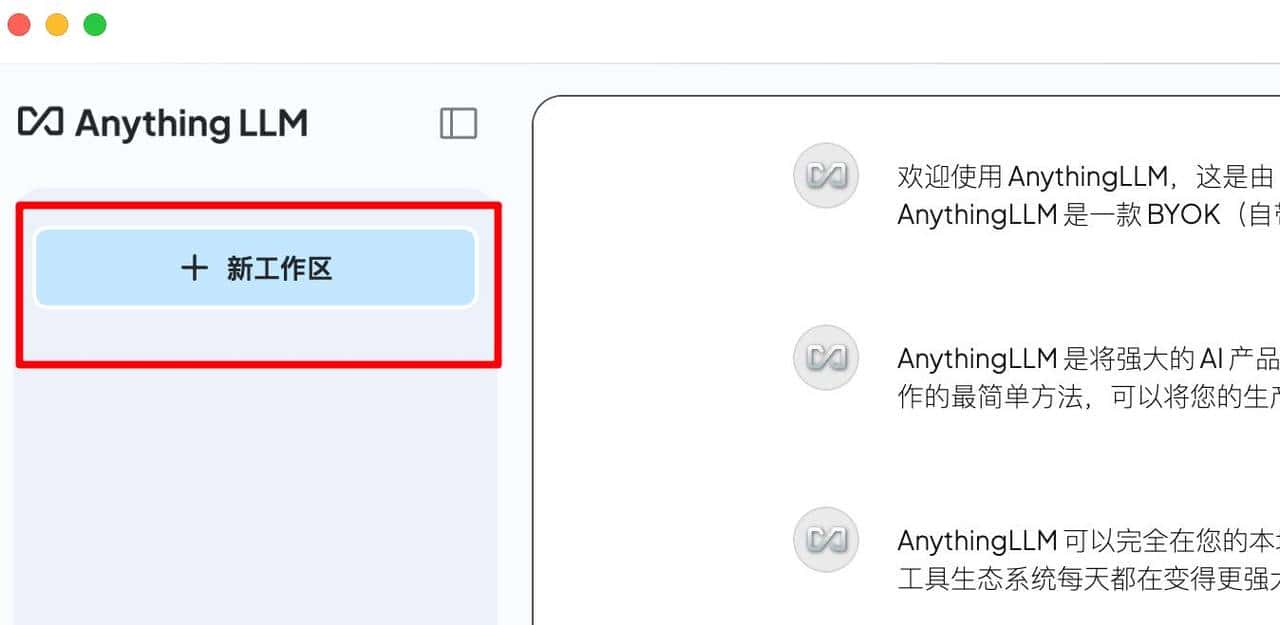

工作区创建

打开AnythingLLM → 新建工作区(如“My Knowledge Base”)→ 保存设置。

关键配置:

LLM提供商:选择Ollama

模型名称:填入deepseek-r1:8b(与本地部署模型一致)

上下文Token数:提议8960(平衡性能与内容长度)

向量模型接入

安装nomic向量模型(终端执行):

bash

ollama pull nomic-embed-text

在AnythingLLM设置页:

嵌入引擎 → 选择Ollama

向量模型 → 选择nomic-embed-text:latest

类似度阈值:设为75%(提高回答精准度)

三、知识库构建与优化

文件上传规范

支持格式:TXT/PDF/Word/CSV/网页链接/音频(需转录)

预处理提议:

删除重复内容

按主题分类(如“技术文档”、“会议纪要”)

拆分大文件(单文件提议不超过10MB)

上传与嵌入

点击工作区“上传”按钮 → 选择文件 → 移动至工作区 → 点击Save and Embed。

进度查看:底部状态栏显示“Workspace updated successfully”即完成向量化。

对话测试与调优

提问示例:

plaintext

根据《2025Q1产品规划文档》,下季度重点功能有哪些?

优化参数:

温度值(Temperature):技术文档设为0.3(严谨),创意内容设为0.5

分块大小:提议1000字符(平衡细节与连贯性)

在AnythingLLM安装目录里面

不会,上传的文件解析后会存储解析后的内容,源文件不被保留

上传的文件会保存在哪里?