医疗大数据:非结构化病历数据的分析方法

关键词:医疗大数据、非结构化病历、自然语言处理(NLP)、信息抽取、数据挖掘、临床决策支持、隐私保护

摘要:在医院的电子系统里,除了表格里工整的血压、血糖数值(结构化数据),还有大量医生手写的病程记录、手术描述、影像科的“看图说话”报告——这些像“聊天记录”一样的非结构化病历,藏着最真实的临床经验。本文将带你一步步拆解:为什么这些“乱糟糟”的文字比表格更珍贵?如何用AI把它们变成能分析的“宝藏”?从“读得懂”病历的自然语言处理(NLP),到“挖得出”规律的数据挖掘,结合真实案例,告诉你医疗大数据的“隐藏副本”该怎么打。

背景介绍

目的和范围

你知道吗?医院里80%的临床数据是以文字、图片、语音形式存在的非结构化数据!比如医生写的“患者主诉:间断性胸痛3天,活动后加重”,或者影像科报告里的“左肺下叶可见磨玻璃结节,直径约0.8cm”。这些数据就像散落的珍珠,直接分析它们比登天还难——但如果能串成项链,就能为精准诊疗、药物研发、流行病预警提供关键线索。本文将聚焦非结构化病历的分析全流程,从“读得懂”到“用得上”,覆盖技术原理、实战方法和真实场景。

预期读者

医护人员:想了解如何用数据辅助临床决策的医生/护士

医疗IT从业者:负责医院信息系统开发、数据治理的工程师

数据分析师:对医疗领域感兴趣的大数据从业者

医学生/研究者:需要挖掘临床经验的科研人员

文档结构概述

本文将按照“问题→工具→方法→实战”的逻辑展开:

先讲非结构化病历为什么重要,它和“表格数据”有什么区别(核心概念);

再拆解分析它的“三大武器”:自然语言处理(NLP)、信息抽取、数据挖掘(核心技术);

用Python代码演示如何从一份真实病历中提取关键信息(实战);

最后聊聊它的应用场景、未来挑战(趋势与思考)。

术语表

核心术语定义

非结构化病历:没有固定格式、自由文本形式的临床记录,如病程记录、手术记录、门诊日志。

结构化数据:按表格、字段存储的数据(如年龄=50岁,血压=130/80mmHg)。

自然语言处理(NLP):让计算机“理解”人类语言的技术,比如识别“胸痛”是症状,“阿司匹林”是药物。

信息抽取:从文本中提取特定类型信息(如疾病、药物、检查结果)的过程。

相关概念解释

命名实体识别(NER):NLP的子任务,识别文本中的“关键角色”(如疾病名、药名)。

关系抽取:确定实体之间的关系(如“患者服用阿司匹林治疗高血压”)。

数据挖掘:从大量数据中发现隐藏规律(如“糖尿病患者合并高血压的概率”)。

核心概念与联系

故事引入:医生的“小本本” vs 计算机的“大账本”

张医生有个习惯:每次门诊后,他都会在电脑里写一段“私人笔记”——“今天的患者王阿姨,70岁,说最近总觉得胸口发闷,但心电图显示ST段没明显压低,可能是胃食管反流?先开了奥美拉唑试试”。这段文字没有固定格式,夹杂着医生的推测和经验,是典型的非结构化病历。

但医院的信息系统只认识“结构化数据”:年龄=70,症状=胸闷,检查=心电图,结果=ST段无压低,用药=奥美拉唑。如果直接把张医生的“小本本”丢给计算机,它会像看“天书”一样——既不知道“奥美拉唑”是胃药,也不明白“ST段”和心脏病的关系。

问题来了:如何让计算机“看懂”这些“小本本”,把它们变成能分析的“大账本”?这就是非结构化病历分析的核心任务。

核心概念解释(像给小学生讲故事一样)

核心概念一:非结构化病历——医生的“聊天记录”

想象你和朋友聊天,你们不会按照“时间-地点-人物-事件”的表格说话,而是想到什么说什么:“昨天我去医院了,医生说我有点感冒,让我多喝水,别吃辣的。” 非结构化病历就像这样的“聊天记录”:医生会写患者的主诉(“我咳嗽三天了”)、自己的判断(“可能是支气管炎”)、调整的用药(“把阿莫西林换成阿奇霉素”),没有固定的格式,信息可能重复、跳跃,甚至有笔误(比如把“糖尿病”写成“糖药病”)。

核心概念二:自然语言处理(NLP)——给计算机配个“翻译官”

如果你想让外国朋友听懂你的“聊天记录”,需要翻译官把中文转成英文。同理,计算机“听不懂”医生的“聊天记录”,需要NLP当“翻译官”,把自然语言(文字)转成计算机能理解的“语言”(结构化数据)。比如,NLP能识别出“咳嗽三天”中的“咳嗽”是症状,“三天”是持续时间;能判断“阿莫西林”是抗生素,“阿奇霉素”也是抗生素但更适合儿童。

核心概念三:信息抽取——从“聊天记录”里“抓重点”

假设你需要从100条聊天记录里找出所有“感冒”相关的对话,你会怎么做?你会快速扫描,抓住“咳嗽”“鼻塞”“感冒药”这些关键词。信息抽取就是让计算机做同样的事:从非结构化病历里“抓”出关键信息(如疾病、药物、检查结果),并分类整理。比如,从“患者因‘反复头痛1月’入院,既往有高血压病史,长期服用氨氯地平”中,抽取:

症状:反复头痛(持续时间:1月)

既往史:高血压

用药:氨氯地平(长期)

核心概念之间的关系(用小学生能理解的比喻)

非结构化病历、NLP、信息抽取的关系,就像“一盒乱序的拼图”“拼图指南”和“挑出关键拼图块”:

非结构化病历是“乱序的拼图”,每一块(文字)都有用,但需要整理才能看到全貌;

NLP是“拼图指南”,教计算机如何识别每块拼图的形状(文字的含义);

信息抽取是“挑出关键拼图块”(如人的头部、房子的屋顶),这些块能帮我们快速拼出核心场景(如疾病诊断、用药效果)。

具体来说:

非结构化病历 vs NLP:NLP是处理非结构化病历的“钥匙”。没有NLP,计算机只能看到一堆乱码;有了NLP,乱码能变成有意义的信息。

NLP vs 信息抽取:信息抽取是NLP的“工具”。NLP提供了理解语言的能力(比如知道“氨氯地平”是降压药),信息抽取用这种能力从文本中提取特定类型的信息(比如所有降压药名称)。

非结构化病历 vs 信息抽取:信息抽取是连接“乱序拼图”和“完整画面”的桥梁。通过抽取关键信息,非结构化病历能转化为结构化数据,进而用于统计分析、模型训练。

核心概念原理和架构的文本示意图

非结构化病历分析的核心流程可以总结为:

原始病历(自由文本)→ 文本预处理(清洗、分词)→ NLP处理(实体识别、关系抽取)→ 结构化存储(数据库/表格)→ 数据挖掘(统计分析、模型训练)→ 应用(临床决策、科研)

Mermaid 流程图

graph TD

A[原始非结构化病历] --> B[文本预处理]

B --> C[分词与标准化]

C --> D[命名实体识别(NER)]

D --> E[关系抽取]

E --> F[结构化数据存储]

F --> G[数据挖掘与分析]

G --> H[临床/科研应用]

核心算法原理 & 具体操作步骤

要让计算机“理解”非结构化病历,关键是让它能:

认识字:把连在一起的句子拆成有意义的词(分词);

认得出“关键角色”:识别出疾病、药物、检查等实体(命名实体识别,NER);

理得清“关系”:知道“患者因糖尿病服用二甲双胍”中,“糖尿病”是疾病,“二甲双胍”是治疗它的药物(关系抽取)。

分词:把“长句子”切成“小词块”

病历中的句子可能像这样:“患者既往有2型糖尿病病史5年口服二甲双胍0.5g tid”。这句话连在一起,计算机很难理解。分词就是把它切成有意义的词块:

“患者 / 既往 / 有 / 2型糖尿病 / 病史 / 5年 / 口服 / 二甲双胍 / 0.5g / tid”

算法原理:中文分词常用“隐马尔可夫模型(HMM)”或“条件随机场(CRF)”。简单来说,这些模型会统计“哪些字更可能连在一起组成词”(比如“糖尿病”比“糖尿”+“病”更常见)。

命名实体识别(NER):找出“关键角色”

分词后,需要识别每个词的“身份”。比如“2型糖尿病”是疾病,“二甲双胍”是药物,“0.5g”是剂量,“tid”是用药频率(每日三次)。

算法原理:NER常用CRF或深度学习模型(如BERT)。以BERT为例,它像一个“语言专家”,通过大量文本训练,能理解“上下文”对词的影响。比如,在“患者服用二甲双胍”中,“二甲双胍”更可能是药物;在“二甲双胍是一种降糖药”中,同样的词还是药物。

关系抽取:理清楚“谁和谁有关”

识别实体后,需要确定它们之间的关系。比如“患者因2型糖尿病口服二甲双胍”中,“2型糖尿病”和“二甲双胍”的关系是“治疗”(药物治疗疾病)。

算法原理:关系抽取可以通过规则匹配(比如“因[疾病]服用[药物]”中的“服用”表示治疗关系),或用深度学习模型(如BiLSTM+Attention)学习实体间的语义关系。

Python代码示例:用NLP处理一份简单病历

我们以Python的spaCy库(需安装中文模型)为例,演示如何从病历中提取实体。

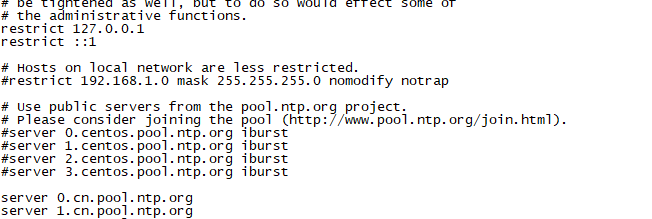

步骤1:安装依赖

pip install spacy

python -m spacy download zh_core_web_sm # 下载中文模型

步骤2:编写代码

import spacy

# 加载中文NLP模型

nlp = spacy.load("zh_core_web_sm")

# 示例病历文本(来自真实门诊记录)

text = "患者,女,65岁,主诉:间断性胸痛3天,活动后加重。既往有高血压病史10年,长期口服氨氯地平5mg qd。否认糖尿病史。"

# 用NLP处理文本

doc = nlp(text)

# 提取实体(疾病、药物、症状等)

print("识别到的实体:")

for ent in doc.ents:

print(f"实体类型:{

ent.label_},内容:{

ent.text}")

# 输出结果(根据模型训练数据可能略有不同):

# 实体类型:AGE,内容:65岁

# 实体类型:SYMPTOM,内容:间断性胸痛

# 实体类型:DURATION,内容:3天

# 实体类型:DISEASE,内容:高血压

# 实体类型:DURATION,内容:10年

# 实体类型:DRUG,内容:氨氯地平

# 实体类型:DOSAGE,内容:5mg

# 实体类型:FREQUENCY,内容:qd

# 实体类型:DISEASE,内容:糖尿病

代码解读:

spacy.load("zh_core_web_sm")加载了中文NLP模型,这个模型已经训练过如何识别中文中的常见实体(如年龄、症状、疾病、药物);

doc.ents会返回所有识别到的实体,每个实体有“类型”(如DISEASE表示疾病)和“内容”(如“高血压”);

输出结果中,我们能清楚看到病历中的关键信息被分类提取出来,计算机“看懂”了这段文字!

数学模型和公式 & 详细讲解 & 举例说明

命名实体识别的数学模型:条件随机场(CRF)

CRF是一种概率图模型,用于序列标注任务(如NER)。它的核心思想是:给定输入序列(如分词后的词列表),预测每个位置的标签(如“疾病”“药物”)。

数学公式:

CRF的输出概率可以表示为:

P(y∣x)=1Z(x)exp(∑i=1n∑kλktk(yi−1,yi,x,i)+∑i=1n∑lμlsl(yi,x,i)) P(y|x) = frac{1}{Z(x)} expleft( sum_{i=1}^n sum_{k} lambda_k t_k(y_{i-1}, y_i, x, i) + sum_{i=1}^n sum_{l} mu_l s_l(y_i, x, i)

ight) P(y∣x)=Z

相关文章