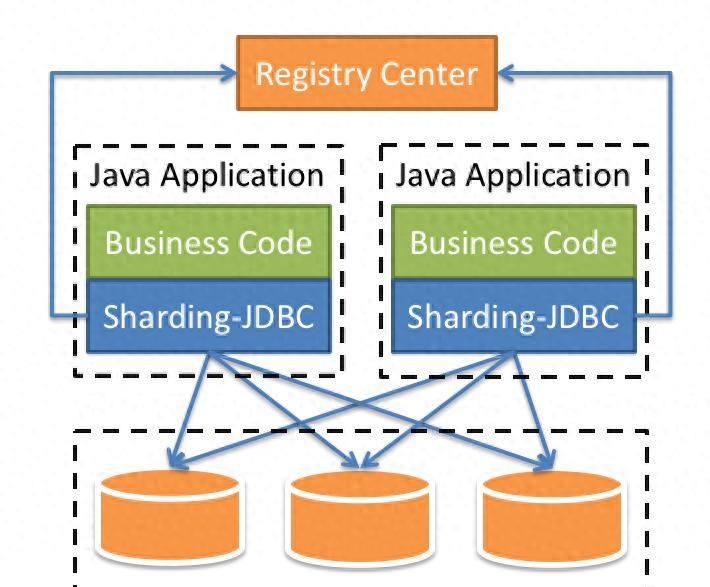

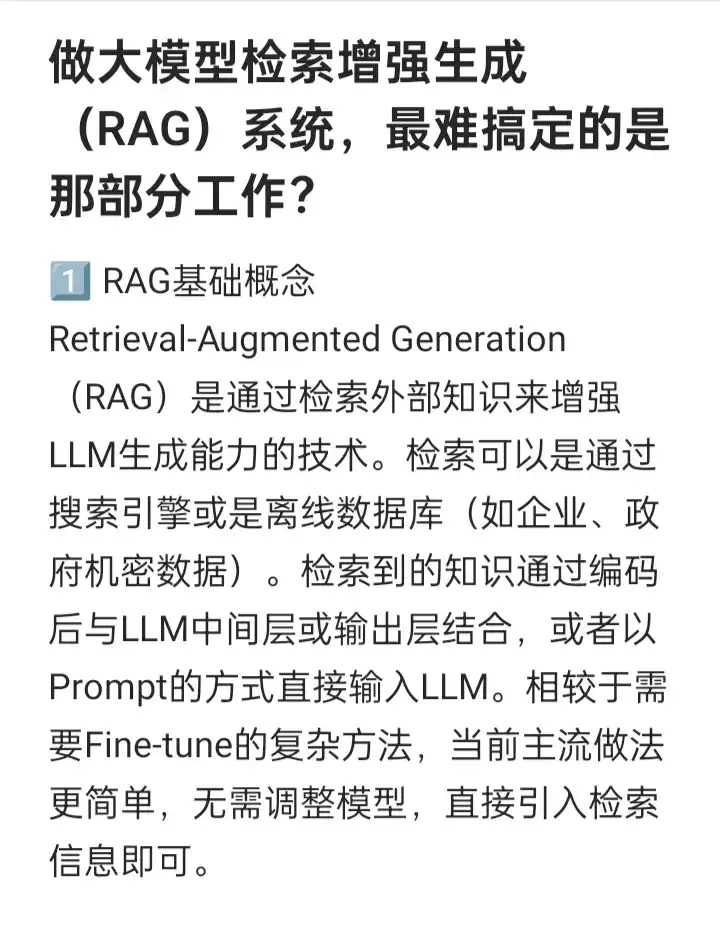

RAG基础概念Retrieval-Augmented Generation(RAG)是通过检索外部知识来增强LLM生成能力的技术。检索可以是通过搜索引擎或是离线数据库(如企业、政府机密数据)。检索到的知识通过编码后与LLM中间层或输出层结合,或者以Prompt的方式直接输入LLM。相较于需要Fine-tune的复杂方法,当前主流做法更简单,无需调整模型,直接引入检索信息即可。 为什么要用RAG?LLM需要不断引入新知识,无论是某个小领域的更新,还是实时信息的补充。通过检索外部知识可以避免模型产生“幻觉”现象。相比于微调模型,RAG能够有效提高生成内容的可解释性和可靠性,尤其是在无法通过内建知识回答时,能通过检索外部信息提高输出质量。 RAG vs 长上下文在长上下文能力强的情况下,RAG依旧有其独特价值。虽然长上下文LLM能处理更多信息,但RAG能更加细致地检索与问题相关的内容。RAG通过文档的召回和筛选,更关注相关上下文的“噪声”去除,而长上下文则通过直接将更多信息输入模型。 检索时机与如何使用检索结果如何平衡LLM的内部知识与外部检索知识是关键。理想的情况是,当内部知识正确时使用内建知识,外部知识正确时使用外部资源。不过,模型和检索源都可能出错,如何处理冲突是挑战之一。例如,在一些简单场景下,检索外部信息反而可能导致错误。 内外部知识冲突的解决方法一些研究探讨了如何平衡内外部知识,当两者冲突时,模型该如何选择。具体来说,有时外部知识对模型有益,有时反而可能引入错误,因此如何判断并融合内外部知识是当前RAG面临的重大课题。 自适应RAG的前景自适应RAG通过动态控制是否进行检索,能够有效判断何时依赖外部知识,何时依赖内部知识。这种方法的核心目标是找出模型的“知识边界”,在模型确信某个答案时,直接生成答案;若不确信,则通过检索获取正确的外部信息。这一思路的挑战在于如何准确判断模型是否知道答案。 有其他深度学习方面的问题厚台滴滴我!

相关文章