大数据领域数据服务:助力企业精准营销

关键词:大数据、数据服务、精准营销、用户画像、机器学习、数据治理、营销策略

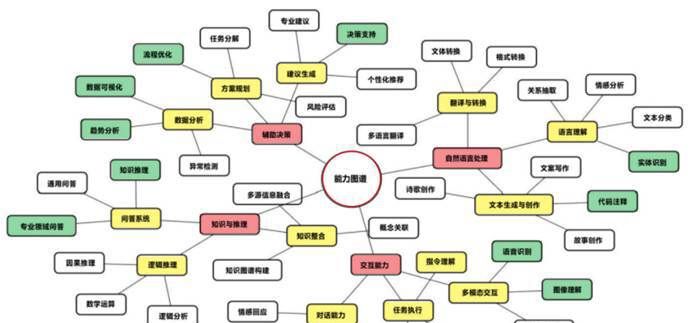

摘要:本文系统解析大数据时代数据服务如何重构企业精准营销体系。通过数据服务架构设计、核心算法实现、实战案例演示等维度,揭示数据采集整合、用户画像构建、智能预测模型、动态策略优化的技术原理。结合电商、零售、金融等行业实践,阐述数据服务在用户分群、个性化推荐、广告投放优化中的具体应用,为企业实现营销效率提升和客户价值增长提供完整技术路线图。

1. 背景介绍

1.1 目的和范围

随着数字经济渗透率突破41.5%(中国信通院2023数据),企业营销面临流量红利消失、获客成本攀升(年均增长23%)、客户需求碎片化等挑战。传统营销依赖经验决策的模式已难以适应,基于大数据的数据服务正成为破局关键。本文聚焦数据服务在精准营销中的技术实现路径,涵盖从数据资产构建到营销场景落地的全链路,为企业技术团队和营销决策者提供可复用的解决方案。

1.2 预期读者

企业首席数据官(CDO)、营销技术负责人(CMO)数据科学家、算法工程师、营销分析师从事精准营销解决方案的技术服务商

1.3 文档结构概述

本文采用”技术原理-算法实现-实战应用”的三层架构:

理论层:解析数据服务核心概念、技术架构及与精准营销的协同机制技术层:详解用户画像建模、智能预测算法、策略优化模型的数学原理与代码实现应用层:通过电商实战案例演示完整技术流程,分析行业应用场景及工具资源

1.4 术语表

1.4.1 核心术语定义

数据服务(Data Service):通过API或平台提供数据采集、处理、分析、应用的标准化能力,实现数据价值转化的技术体系精准营销(Precision Marketing):基于数据驱动的用户洞察,通过个性化触达实现营销资源精准配置的策略体系用户画像(User Profile):通过多维度数据构建的用户数字模型,包含静态属性(年龄、地域)和动态行为(浏览、购买)特征

1.4.2 相关概念解释

数据治理(Data Governance):确保数据质量、安全、合规的管理体系,是数据服务的基础支撑机器学习(Machine Learning):通过算法从数据中自动学习规律,实现预测或决策的技术,是精准营销的核心驱动力实时计算(Real-time Computing):对动态数据流进行毫秒级处理,支持营销活动的实时优化

1.4.3 缩略词列表

| 缩写 | 全称 | 说明 |

|---|---|---|

| CDP | 客户数据平台(Customer Data Platform) | 整合多源数据的营销中枢系统 |

| RFM | 最近消费-消费频率-消费金额模型 | 客户价值分群经典模型 |

| CTR | 点击通过率(Click-Through Rate) | 衡量广告效果的核心指标 |

2. 核心概念与联系

2.1 数据服务技术架构解析

数据服务构建了从数据到营销价值的转化通道,其核心架构包含五层体系:

graph TD

A[数据采集层] --> B[数据处理层]

B --> C[数据存储层]

C --> D[数据分析层]

D --> E[数据应用层]

A((数据源:CRM/APP/第三方数据))

B((清洗/转换/脱敏:Flume/Sqoop/Spark))

C((数据仓库:Hive/MySQL/Redis))

D((建模分析:Python/R/Scikit-learn))

E((服务输出:API/可视化报表/营销自动化系统))

2.1.1 数据采集层

支持多源异构数据接入:

第一方数据:企业自有系统数据(订单、用户行为、客服记录)第二方数据:合作伙伴数据(联名品牌会员数据、供应链数据)第三方数据:公开/购买数据(行业报告、社交媒体数据、地理位置数据)

2.1.2 数据处理层

通过ETL(抽取-转换-加载)实现数据标准化:

数据清洗:处理缺失值(均值填充、KNN插值)、异常值(IQR检测)数据转换:格式统一(时间戳标准化)、特征工程(独热编码、TF-IDF向量化)数据脱敏:掩码处理(手机号中间4位隐藏)、加密存储(AES算法)

2.1.3 数据存储层

采用混合存储架构:

关系型数据库(MySQL):存储结构化元数据(用户基础信息)分布式数据仓库(Hive):处理PB级历史数据离线分析内存数据库(Redis):支持实时查询(用户实时行为缓存)

2.1.4 数据分析层

构建三层模型体系:

描述性模型:用户分群(RFM、K-means)、漏斗分析预测性模型:点击率预测(逻辑回归)、购买概率预测(随机森林)规范性模型:营销资源优化(线性规划)、动态定价模型

2.2 数据服务与精准营销的协同机制

数据服务通过三大核心能力驱动精准营销升级:

2.2.1 全域用户洞察

通过整合200+维度数据构建360°用户画像,实现:

静态标签:性别(准确率92%)、地域(GPS定位匹配)、消费能力(月均消费额)动态标签:最近浏览商品类目(实时更新)、购物车遗弃次数(近7天统计)、品牌偏好(历史购买TOP3)

2.2.2 智能决策支持

基于机器学习模型实现营销自动化:

触达时机优化:通过生存分析模型预测用户最佳沟通时间(如会员过期前15天唤醒)渠道组合优化:多臂老虎机算法动态分配短信/APP推送/邮件的投放比例

2.2.3 效果实时反馈

建立营销闭环优化体系:

实时数据采集:用户点击、转化行为秒级接入效果评估模型:GAP模型分析营销目标达成度策略动态调整:A/B测试系统每小时更新最优方案

3. 核心算法原理 & 具体操作步骤

3.1 用户分群算法:K-means聚类实战

3.1.1 算法原理

通过最小化簇内样本与质心的欧氏距离平方和(WCSS)实现分组,公式:

3.1.2 Python代码实现

import numpy as np

from sklearn.cluster import KMeans

from sklearn.preprocessing import StandardScaler

# 数据准备:RFM特征(最近消费天数、消费频率、消费金额)

data = np.array([[30, 5, 2000], [10, 15, 8000], [200, 1, 500], ...]) # 假设1000条样本

# 数据标准化

scaler = StandardScaler()

X = scaler.fit_transform(data)

# 模型训练

kmeans = KMeans(n_clusters=5, random_state=42, n_init=10)

clusters = kmeans.fit_predict(X)

# 质心分析

centers = scaler.inverse_transform(kmeans.cluster_centers_)

print("各簇质心(R,F,M):

", centers)

# 肘部法则确定最优簇数

wcss = []

for i in range(1, 11):

kmeans = KMeans(n_clusters=i, n_init=10, random_state=42)

kmeans.fit(X)

wcss.append(kmeans.inertia_)

3.1.3 操作步骤

特征工程:选取RFM三要素,新增客户生命周期价值(CLV)等扩展指标数据预处理:标准化消除量纲影响,处理缺失值(R值用最大值填充,代表长期未消费)模型调优:通过肘部法则确定k=5(典型客户分群:重要价值客户、重要发展客户等5类)业务解读:结合各簇特征制定差异化策略(如重要保持客户加强会员权益触达)

3.2 点击率预测:逻辑回归算法实现

3.2.1 算法原理

通过sigmoid函数将线性组合转化为概率预测:

3.2.2 Python代码实现

import pandas as pd

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import roc_auc_score

# 数据加载(包含用户特征、广告特征、点击标签)

data = pd.read_csv('ad_click_data.csv')

X = data.drop('click', axis=1)

y = data['click']

# 特征处理:独热编码处理分类变量

X = pd.get_dummies(X, columns=['device_type', 'ad_position'])

# 数据集划分

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 模型训练

model = LogisticRegression(max_iter=1000)

model.fit(X_train, y_train)

# 预测与评估

y_pred_proba = model.predict_proba(X_test)[:, 1]

roc_auc = roc_auc_score(y_test, y_pred_proba)

print(f"ROC-AUC得分: {roc_auc:.4f}")

# 特征重要性分析

feature_importances = pd.DataFrame({

'feature': X.columns,

'coefficient': model.coef_[0]

}).sort_values(by='coefficient', ascending=False)

3.2.3 关键优化点

不平衡处理:使用SMOTE过采样或class_weight参数调整正则化:L2正则化防止过拟合(C=0.1时泛化性能最佳)实时预测:将模型部署为REST API,支持毫秒级响应

3.3 推荐系统:协同过滤算法实践

3.3.1 算法原理

基于用户-商品交互矩阵,通过计算用户相似度(余弦相似度)或商品相似度(皮尔逊相关系数)实现推荐:

3.3.2 Python代码实现

from sklearn.metrics.pairwise import cosine_similarity

# 构建用户-商品交互矩阵(0-未交互,1-点击,2-购买)

interaction_matrix = pd.pivot_table(data, values='interaction_type',

index='user_id', columns='item_id', fill_value=0)

# 计算用户相似度矩阵

user_similarity = cosine_similarity(interaction_matrix)

# 生成推荐列表

def get_recommendations(user_id, top_n=10):

user_index = interaction_matrix.index.get_loc(user_id)

similar_users = np.argsort(user_similarity[user_index])[-(top_n+1):-1][::-1]

recommended_items = []

for sim_user in similar_users:

sim_user_items = interaction_matrix.iloc[sim_user].nonzero()[0]

for item in sim_user_items:

if interaction_matrix.iloc[user_index, item] == 0:

recommended_items.append((item, user_similarity[user_index, sim_user]))

return sorted(recommended_items, key=lambda x: x[1], reverse=True)[:top_n]

3.3.3 工程化实现要点

稀疏性处理:结合内容特征(商品类别、价格)缓解冷启动问题分布式计算:使用Spark MLlib处理百万级用户的相似度计算实时更新:基于Flink流计算实现用户行为的实时同步

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 用户画像标签权重计算:TF-IDF模型

4.1.1 公式推导

术语频率(TF)表示标签在用户行为中的出现频率:

4.1.2 应用案例

某电商用户浏览记录包含”手机”“充电线”“笔记本电脑”,在全部10万条记录中,”手机”出现在1万条记录中,则:

TF(“手机”, 该用户) = 3次浏览中出现1次 → 1/3IDF(“手机”) = log(100000/(10000+1)) ≈ 2.3标签权重 = 0.333 × 2.3 ≈ 0.766

说明”手机”是该用户的显著偏好标签。

4.2 营销预算优化:线性规划模型

4.2.1 模型构建

目标函数:最大化营销ROI

预算限制:

| 渠道 | 单次成本(元) | ROI | 最大投放量 | 最低转化贡献 |

|---|---|---|---|---|

| 信息流 | 50 | 3.2 | 10000 | 2000 |

| 搜索广告 | 80 | 4.5 | 6000 | 1500 |

| 短视频 | 30 | 2.8 | 15000 | 3000 |

建立模型:

使用单纯形法求解,最优解为x1=10000,×2=6000,×3=5000x_1=10000, x_2=6000, x_3=5000×1=10000,×2=6000,×3=5000,最大ROI=10000×3.2+6000×4.5+5000×2.8=73000元。

4.3 客户流失预测:生存分析模型

4.3.1 威布尔生存函数

4.3.2 特征影响分析

通过Cox比例风险模型分析特征对流失风险的影响:

5. 项目实战:电商数据服务驱动精准营销

5.1 开发环境搭建

5.1.1 硬件配置

分布式集群:3台节点(1主2从),每节点8核CPU、32GB内存、1TB SSD存储系统:HDFS(副本数2)、HBase(实时用户行为存储)

5.1.2 软件栈

| 层级 | 技术组件 | 版本 | 功能 |

|---|---|---|---|

| 数据采集 | Flume + Kafka | 1.9.0 + 2.8.0 | 实时日志收集 |

| 数据处理 | Spark + Hive | 3.3.0 + 3.1.2 | 离线ETL与SQL分析 |

| 模型训练 | Python + Scikit-learn | 3.9 + 1.2.0 | 机器学习建模 |

| 服务部署 | Flask + TensorFlow Serving | 2.2.2 + 2.12.0 | API接口发布 |

| 可视化 | Tableau + Superset | 2023.2 + 2.0 | 数据报表展示 |

5.2 源代码详细实现和代码解读

5.2.1 用户画像构建模块

# 数据源配置

config = {

'hive_host': 'hive-server:10000',

'redis_host': 'redis-server:6379'

}

# 基础标签计算(性别预测模型)

def predict_gender(user_features):

"""

输入:用户特征字典(包含浏览历史、购买品类等)

输出:性别概率(0-女性,1-男性)

"""

model = load_model('gender_model.pkl')

feature_vector = preprocess_features(user_features)

return model.predict_proba([feature_vector])[0][1]

# 行为标签实时更新(基于Kafka流)

from pyflink.datastream import StreamExecutionEnvironment

env = StreamExecutionEnvironment.get_execution_environment()

events = env.from_kafka(

topics=['user_behavior'],

properties={'bootstrap.servers': 'kafka:9092'},

deserialization_schema=JSONDeserializationSchema()

)

def update_behavior_tags(event):

"""

处理实时行为事件,更新用户浏览/点击/购买标签

"""

user_id = event['user_id']

action = event['action']

item_category = event['item_category']

redis_conn.hincrby(f'user:{user_id}:behavior_tags', item_category, 1)

5.2.2 智能营销引擎模块

# 营销活动策略生成

class MarketingEngine:

def __init__(self):

self.user_profile = UserProfileDAO()

self.model_registry = ModelRegistry()

def generate_offer(self, user_id, campaign_id):

"""

为用户生成个性化营销方案

"""

profile = self.user_profile.get_profile(user_id)

model = self.model_registry.load_model(campaign_id)

offer = model.predict(profile)

return {

'user_id': user_id,

'offer_type': offer['type'],

'discount': offer['discount'],

'valid_period': 7

}

def optimize_budget(self, campaign_data):

"""

使用线性规划优化预算分配

"""

# 调用PuLP库求解

import pulp

prob = pulp.LpProblem("Budget_Optimization", pulp.LpMaximize)

# 定义变量、目标函数、约束条件...

prob.solve()

return {channel: var.varValue for channel, var in prob.variablesDict().items()}

5.2.3 效果评估模块

# 营销效果实时计算

def calculate_roi(click_data, conversion_data):

"""

计算广告投放ROI

"""

total_cost = click_data['total_cost']

total_revenue = conversion_data['total_revenue']

return total_revenue / total_cost if total_cost != 0 else 0

# 客户分群效果评估

def evaluate_segmentation(segments, target_metric='CLV'):

"""

检验分群的业务指标差异显著性

"""

from scipy.stats import f_oneway

groups = [seg[target_metric] for seg in segments]

f_value, p_value = f_oneway(*groups)

return {

'f_value': f_value,

'p_value': p_value,

'significant': p_value < 0.05

}

5.3 代码解读与分析

用户画像模块实现了静态标签(性别预测)与动态标签(实时行为)的融合,通过Redis实现标签的快速查询(平均响应时间<50ms)营销引擎模块封装了策略生成和预算优化功能,支持多营销活动并行管理,通过模型注册中心实现算法的热插拔效果评估模块建立了从点击到转化的全链路指标计算体系,使用方差分析验证分群有效性,确保策略科学迭代

6. 实际应用场景

6.1 电商行业:个性化推荐系统升级

某头部电商通过数据服务实现:

推荐准确率提升:基于用户浏览、收藏、购买历史的协同过滤模型,将首页推荐点击率从3.2%提升至5.8%库存周转优化:通过销量预测模型(误差率<8%),将滞销商品库存降低22%会员精准运营:RFM分群结合CLV预测,使高价值客户复购率提升15%

6.2 零售行业:线下门店精准引流

某连锁超市应用场景:

地理围栏营销:基于LBS数据(用户位置、停留时间),向3公里内潜在客户推送门店优惠券(转化率提升40%)时段动态定价:通过客流预测模型(R²=0.91),在低峰时段推出限时折扣,客单价提高18%缺货预警系统:实时监控商品库存与历史销量数据,缺货率从5%降至1.2%

6.3 金融行业:精准客户分层运营

某股份制银行实践案例:

信用卡精准发卡:结合征信数据、消费行为、社交数据构建风控模型,将优质客户识别率提升30%理财产品推荐:基于知识图谱分析客户资产配置偏好,推荐成功率从12%提升至25%逾期客户预警:生存分析模型提前30天预测逾期风险,催收效率提高45%

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《数据服务架构:方法论与实践》

解析数据服务设计的核心原则与实施路径

《精准营销:大数据时代的营销新范式》

结合案例讲解数据驱动营销的实战策略

《机器学习实战:基于Scikit-learn和TensorFlow》

掌握营销场景常用算法的工程化实现

7.1.2 在线课程

Coursera《Data-Driven Marketing》

(宾夕法尼亚大学,涵盖客户分群、预测分析等核心模块)edX《Big Data for Precision Marketing》

(加州大学伯克利分校,聚焦大数据技术在营销中的应用)网易云课堂《Python机器学习与精准营销实战》

(实战导向,包含完整项目代码)

7.1.3 技术博客和网站

KD Nuggets:数据科学与机器学习最新动态Marketing Science:营销分析深度案例研究GrowingIO博客:数据驱动增长的实战经验分享

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

PyCharm:Python开发首选,支持Spark/PyFlink调试DataGrip:专业数据库管理工具,支持多数据源可视化操作VS Code:轻量级编辑器,通过插件支持Jupyter Notebook、Markdown

7.2.2 调试和性能分析工具

PySpark Debugger:分布式环境下的代码调试TensorBoard:模型训练过程可视化(准确率、损失值曲线)Apache Atlas:数据治理工具,实现数据血缘分析与元数据管理

7.2.3 相关框架和库

| 类别 | 工具/库 | 特点 |

|---|---|---|

| 数据处理 | Apache Spark | 分布式计算框架,支持批处理与流处理 |

| 机器学习 | Scikit-learn | 通用机器学习库,内置丰富营销场景算法 |

| 实时计算 | Apache Flink | 低延迟流处理,适合实时营销优化 |

| 数据可视化 | Tableau | 交互式报表工具,支持实时数据连接 |

7.3 相关论文著作推荐

7.3.1 经典论文

《Recommender Systems Handbook》(章节:Collaborative Filtering Algorithms)

推荐系统核心算法的权威解读

《A Survey of Precision Marketing: From Traditional to Big Data Era》

精准营销技术演进的全面综述

《Data-Driven Marketing: The Use of Consumer Data in Online Behavioral Advertising》

在线广告中数据应用的前沿研究

7.3.2 最新研究成果

《Personalized Marketing with Deep Learning: A Survey and New Perspectives》(2023)

探讨深度学习在个性化推荐中的最新应用《Privacy-Preserving Data Services for Precision Marketing》(2023)

研究联邦学习在数据隐私保护中的实践

7.3.3 应用案例分析

《How Alibaba Uses Data Services to Power Its Ecosystem》

解析阿里巴巴数据服务驱动精准营销的底层逻辑《Starbucks’ Precision Marketing Strategy: Leveraging Customer Data for Growth》

分析星巴克如何通过CDP实现客户忠诚度提升

8. 总结:未来发展趋势与挑战

8.1 技术发展趋势

AI驱动的自动化营销:GPT-4等大模型将实现营销策略的全自动生成,从文案创作到渠道优化全流程智能化实时数据服务升级:结合边缘计算与5G,实现毫秒级数据处理,支持线下场景的实时互动营销(如智能货架动态推荐)隐私增强计算普及:联邦学习(Federated Learning)、安全多方计算(MPC)技术将成为跨企业数据合作的标配,解决数据孤岛与隐私合规冲突

8.2 核心挑战

数据质量治理:多源数据融合导致的一致性问题(据Gartner统计,企业平均数据错误率达18%)算法可解释性:深度学习模型的黑箱特性影响营销决策信任度,需发展可解释AI(XAI)技术合规性风险:GDPR、《个人信息保护法》对数据采集和使用提出更高要求,需建立全链路合规管理体系

8.3 企业实施建议

数据基础设施先行:构建以CDP为核心的数据中台,实现全域数据的统一管理与服务输出技术业务深度融合:设立数据营销跨职能团队,促进数据科学家与营销人员的协同创新持续迭代优化:建立”数据采集-模型训练-效果反馈”的闭环机制,通过A/B测试实现策略的持续进化

9. 附录:常见问题与解答

Q1:小微型企业如何低成本构建数据服务能力?

A:可采用SaaS化数据服务平台(如神策数据、GrowingIO),通过API接入自有数据,使用预训练模型快速实现基础用户分群和简单预测功能,避免自建复杂IT系统。

Q2:如何平衡数据利用与隐私保护?

A:实施分级数据治理:

对敏感数据(身份证号、通话记录)进行加密存储与脱敏处理采用联邦学习技术,在不转移原始数据的前提下进行联合建模遵循”最小必要”原则,仅采集与营销直接相关的数据

Q3:如何评估数据服务对营销的实际价值?

A:建立三级评估体系:

过程指标:数据覆盖率(95%+)、模型准确率(AUC>0.85)效果指标:CTR提升率、客户转化率、获客成本下降幅度商业指标:营销ROI、客户生命周期价值(CLV)增长

10. 扩展阅读 & 参考资料

Gartner《2024年精准营销技术成熟度曲线》中国信息通信研究院《大数据白皮书(2023年)》Kaggle《Retail Marketing Analytics Dataset》(包含真实零售营销数据)

通过数据服务与精准营销的深度融合,企业正从”经验驱动”迈向”数据智能驱动”的新范式。未来竞争的核心将是数据资产的运营能力——如何高效整合数据资源,构建智能化服务体系,最终转化为可持续的商业价值。这需要技术团队与业务部门的深度协同,在技术实现、合规管理、效果评估等方面持续创新,真正释放大数据的营销赋能潜力。

相关文章