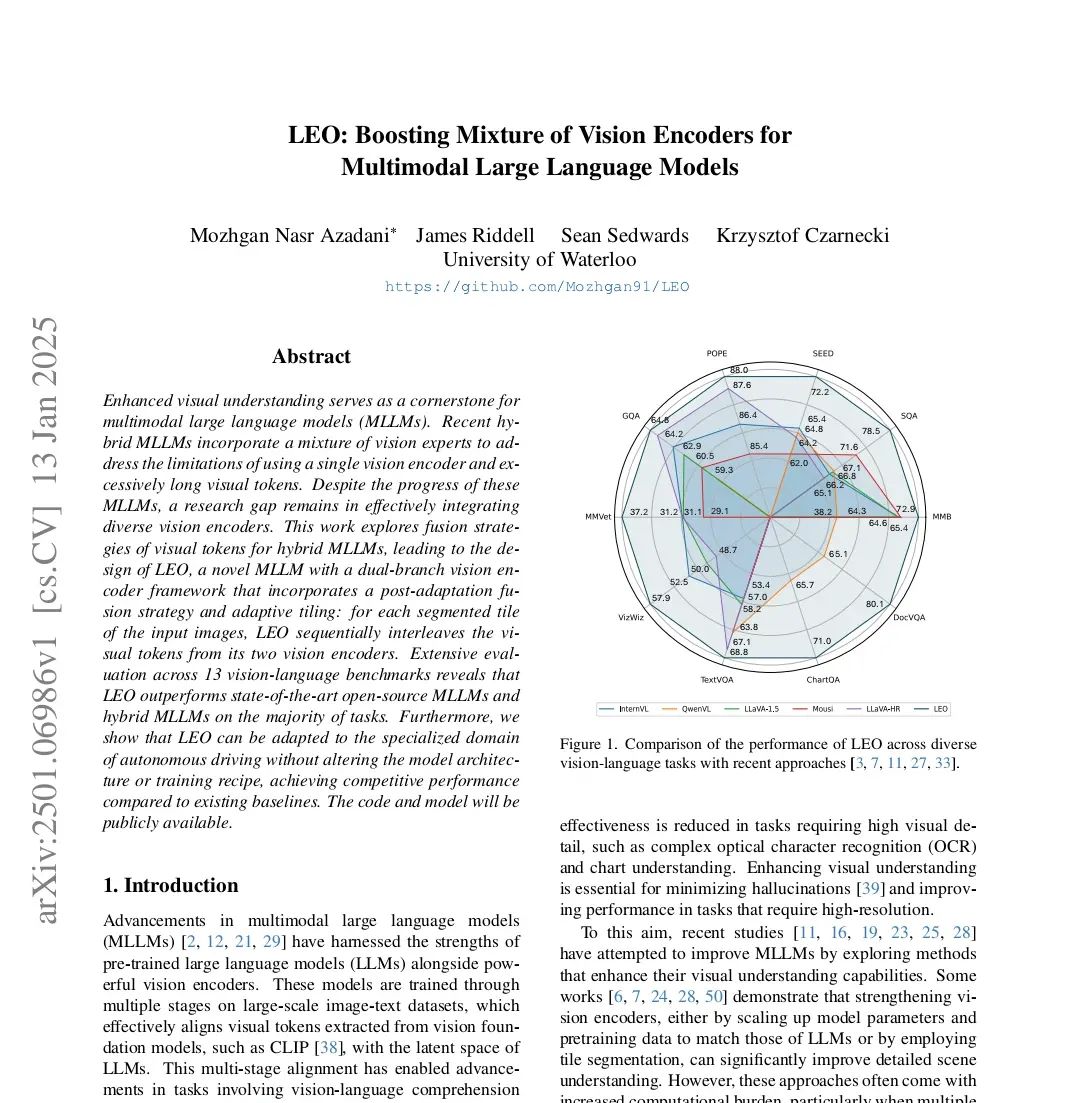

这篇题为《LEO:通过混合视觉编码器提升多模态大型语言模型》的论文由滑铁卢大学的Mozhgan Nasr Azadani、James Riddell、Sean Sedwards和Krzysztof Czarnecki撰写,提出了一种新的多模态大型语言模型(MLLM)LEO,该模型通过双分支视觉编码器框架和后适应融合策略来增强视觉理解能力,并在多个视觉语言基准测试中表现出色

研究背景 多模态大型语言模型(MLLM)通过结合预训练的大型语言模型(LLM)和强劲的视觉编码器,已经在视觉语言理解和推理任务中取得了显著进展。不过,由于当前视觉编码器和语言模型序列长度的限制,这些模型在处理需要高视觉细节的任务(如复杂的光学字符识别(OCR)和图表理解)时效果不佳。为了克服这些限制,研究者们尝试通过增强视觉编码器的能力、增加模型参数和预训练数据,以及采用瓷砖分割等方法来改善MLLM。尽管这些方法取得了必定的进展,但它们一般伴随着计算负担的增加,尤其是在处理多张图像时。这促使了利用多个视觉编码器的模型的发展,每个编码器针对不同的视觉任务和输入分辨率进行预训练,并通过各种融合技术进行集成。 LEO:双分支视觉编码器框架 LEO是一种新型的MLLM,采用双分支视觉编码器框架和后适应融合策略。具体来说,LEO将输入图像分割成448×448的瓷砖,然后由两个不同的视觉编码器独立处理。这种方法允许每个编码器利用其专业能力进行最优的图像处理。LEO的关键组件包括: 1. 动态高分辨率:输入图像被分割成多个瓷砖,同时保留原始图像的缩略图以捕获全局上下文。 2. 像素解shuffle:通过重新排列像素的空间布局来减少视觉令牌的数量,同时保留重大的视觉特征。 3. 视觉令牌融合:LEO采用了一种后适应融合策略,将两个视觉编码器的视觉令牌按瓷砖级别交错合并,然后与文本令牌一起输入到LLM中。 4. 语言模型:LEO使用InternLM27B-Chat作为大型语言模型,上下文长度设置为最多8196个令牌,以平衡各种多模态任务的性能。 训练过程 LEO的训练过程分为两个阶段: 1. 初始化阶段:视觉编码器和语言模型从基础模型初始化,而SAM的投影层随机初始化。 2. 微调阶段:视觉编码器保持冻结,对两个投影层和语言模型进行全监督微调。 评估与结果 LEO在13个视觉语言基准测试中的表现进行了评估,这些基准测试分为三类任务:OCR和图表理解、一般视觉问答和一般多模态基准测试。LEO在12个基准测试中取得了最先进的结果,显示出比领先的开源单视觉编码器和混合模型更优越的性能。 • OCR和图表理解:LEO在所有四个数据集上均超越了领先的模型,这得益于其双分支视觉编码器。 • 一般多模态基准测试:LEO在所有六个基准测试中表现出色,突显了其广泛的知识和高级推理能力。 • 与混合MLLM的比较:LEO在大多数基准测试中超越了训练数据量更大的模型,如Mousi,并且在多模态基准测试中优于具有更复杂融合策略的模型,如LLaVA-HR和Mini-Gemini。 自动驾驶领域的适应 LEO还被适应到自动驾驶这一专门领域,而无需改变其架构或训练配方。在LingoQA基准测试中,LEO展示了与封闭源码的LingoQA基线相当的性能,并在所有四个指标上超越了所有现有的开源基线。 结论与未来工作 LEO通过后适应融合和瓷砖分割的战略组合,为MLLM提供了一个强劲的框架,显著提升了性能。LEO在各种零样本基准测试中的有效性得到了验证,超越了大多数任务的先前最先进模型。未来的工作可能会进一步优化融合策略,并探索LEO在其他专门领域的应用。

相关文章