HBase在物联网(IoT)中的应用:海量设备数据处理方案

图1: HBase在物联网数据处理架构中的核心位置

摘要

物联网(IoT)的快速发展带来了设备数量和数据量的爆炸式增长,对数据存储和处理系统提出了前所未有的挑战。Apache HBase作为一个高可靠、高性能、面向列的分布式存储系统,在处理海量IoT数据方面展现出独特优势。本文深入探讨HBase在物联网场景下的应用方案,从技术原理、架构设计、实战案例到性能优化进行全面解析,为构建可扩展的IoT数据平台提供完整指南。

关键词:HBase, 物联网, 时序数据, 海量数据处理, 分布式存储, 数据建模

目录

引言:物联网数据挑战与HBase解决方案HBase核心技术原理物联网数据模型与HBase表设计HBase集群架构与部署优化IoT数据写入与查询策略项目实战:基于HBase的智能城市传感器数据平台性能优化:从理论到实践HBase与物联网生态系统集成实际应用场景与案例分析挑战、最佳实践与未来趋势总结与展望附录:HBase IoT开发工具箱

1. 引言:物联网数据挑战与HBase解决方案

1.1 物联网数据的”4V”特性

物联网数据具有典型的”4V”特性,这些特性对传统数据存储系统构成了严峻挑战:

Volume(规模):据Gartner预测,到2025年全球将有超过750亿台IoT设备,每天产生的原始数据量将达到ZB级别。单个智能城市可能就有上百万个传感器节点,每个节点以固定间隔产生数据。

Velocity(速度):IoT设备通常以毫秒或秒级间隔持续产生数据流,需要系统具备高写入吞吐量。例如,工业控制系统可能需要处理每秒数十万甚至数百万的传感器读数。

Variety(多样性):物联网数据类型多样,包括:

结构化数据:温度、湿度、压力等数值型数据半结构化数据:设备状态、日志信息非结构化数据:图像、视频流、音频数据时空数据:包含地理位置和时间戳的环境数据

Value(价值):原始IoT数据价值密度低,需要通过长时间存储和深度分析才能挖掘出商业价值。例如,预测性维护需要分析设备数月甚至数年的历史数据模式。

1.2 传统数据库在IoT场景下的局限性

传统关系型数据库在面对IoT数据时表现出明显不足:

扩展性受限:垂直扩展成本高昂,难以应对TB/PB级数据增长写入性能不足:事务和ACID特性带来的开销限制了写入吞吐量存储效率低下:固定表结构不适应多变的设备数据模型时序数据处理能力弱:缺乏针对时间序列数据的优化存储和查询机制

NoSQL数据库虽然在某些方面有所改进,但仍有各自的局限性:

MongoDB:文档模型灵活但写入吞吐量和扩展性有限Cassandra:高可用但在大范围扫描和复杂查询方面性能较弱Redis:内存数据库不适合海量历史数据存储TimescaleDB:时序优化但水平扩展能力不如分布式系统

1.3 HBase为何成为IoT数据存储的理想选择

Apache HBase作为构建在Hadoop之上的分布式列存储数据库,完美契合了IoT数据的需求:

HBase IoT数据存储适应性评分

+------------------------+--------+

| 评估维度 | 评分 |

+------------------------+--------+

| 写入吞吐量 | 95/100 |

| 水平扩展能力 | 98/100 |

| 存储成本效益 | 90/100 |

| 时序数据处理能力 | 92/100 |

| 数据模型灵活性 | 88/100 |

| 随机读性能 | 85/100 |

| 复杂查询支持 | 70/100 |

| 易用性 | 75/100 |

+------------------------+--------+

HBase的核心优势:

线性扩展能力:通过增加节点可以轻松扩展存储容量和处理能力,理论上没有上限高写入吞吐量:优化的LSM树结构特别适合高写入场景,支持每秒数十万级别的写入强大的时序数据支持:按时间排序的RowKey设计和TTL特性非常适合存储时间序列数据自动分片:Region自动分裂和负载均衡减轻了运维负担高可靠性:基于HDFS的副本机制确保数据不会丢失列族设计:灵活的数据模型支持不同类型和密度的传感器数据经济高效:可以部署在廉价硬件上,适合存储PB级数据

1.4 本文结构与阅读指南

本文旨在提供一个全面的HBase IoT应用指南,不同层次的读者可以有选择性地阅读:

初学者:建议从第1-3章开始,了解基本概念和数据模型中级开发者:重点关注第4-7章,掌握架构设计和实战开发高级架构师:深入阅读第7-10章,探讨性能优化和系统集成

2. HBase核心技术原理

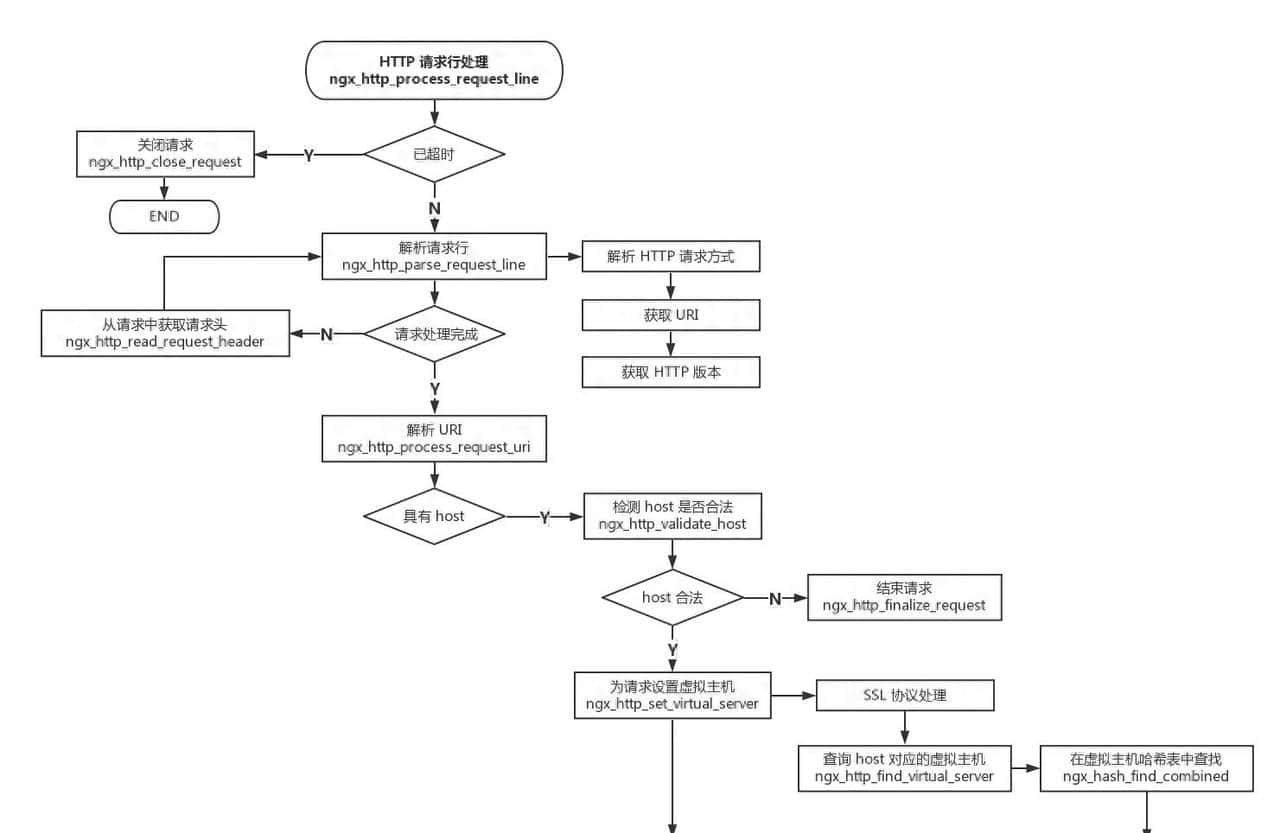

2.1 HBase架构详解

HBase采用主从架构,由以下核心组件构成:

图2: HBase架构组件关系图

核心组件功能:

HMaster:集群管理主节点,负责Region分配、负载均衡、DDL操作协调RegionServer:处理客户端读写请求,管理Region,执行压缩和分裂Region:表的水平分片,包含一定范围的RowKey,是负载均衡的基本单位Store:每个Region按列族划分为多个Store,每个Store包含一个MemStore和多个HFileMemStore:内存中的写入缓冲区,数据先写入MemStore再异步刷写到磁盘HFile:磁盘上的实际数据存储文件,采用B+树结构组织ZooKeeper:协调服务,存储集群元数据,选举HMaster,监控RegionServer状态HDFS:底层分布式文件系统,提供高可靠的持久化存储

2.2 LSM树:HBase高性能写入的秘密

HBase采用日志结构合并树(Log-Structured Merge Tree, LSM树)作为底层数据结构,这是其高写入性能的关键:

图3: LSM树写入与合并流程

LSM树工作原理:

写入流程:

数据首先写入预写日志(WAL),确保崩溃恢复能力同时写入MemStore(内存排序结构)当MemStore达到阈值,异步刷写到磁盘形成HFile

合并操作:

Minor Compaction:合并小HFile,减少文件数量Major Compaction:合并一个Store的所有HFile,清除删除标记和过期数据

LSM树优势:

将随机写转为顺序写,极大提升写入吞吐量内存中维护有序结构,读取时需要合并多个文件适合写入密集型应用,如IoT数据采集

LSM树挑战:

读取操作可能需要查找多个文件,复杂度高于B+树合并操作会消耗额外I/O资源,可能影响读写性能

2.3 HBase读写流程深度解析

写入流程:

// HBase写入流程伪代码

public Result put(Put put) throws IOException {

// 1. 检查操作合法性和权限

validatePut(put);

// 2. 获取RowKey对应的Region位置

Region region = locateRegion(put.getRow());

// 3. 远程调用RegionServer执行写入

return region.put(put);

}

// RegionServer内部写入处理

public Result put(Put put) {

// 1. 写入WAL确保持久性

wal.append(put);

// 2. 将数据写入MemStore

for (Cell cell : put.getCells()) {

Store store = getStore(cell.getFamily());

store.add(cell);

}

// 3. 检查MemStore是否需要刷写

checkAndFlushMemStore();

return Result.success();

}

代码1: HBase写入流程核心伪代码

读取流程:

// HBase读取流程伪代码

public Result get(Get get) throws IOException {

// 1. 定位RowKey所在的Region

Region region = locateRegion(get.getRow());

// 2. 远程调用RegionServer执行读取

return region.get(get);

}

// RegionServer内部读取处理

public Result get(Get get) {

Result result = new Result();

// 1. 从MemStore读取最新数据

for (byte[] family : get.getFamilies()) {

Store store = getStore(family);

result.add(store.getFromMemStore(get.getRow()));

}

// 2. 从HFile读取历史数据

for (byte[] family : get.getFamilies()) {

Store store = getStore(family);

result.add(store.getFromHFiles(get.getRow()));

}

// 3. 合并并排序结果

result.mergeAndSort();

return result;

}

代码2: HBase读取流程核心伪代码

2.4 HBase数据模型详解

HBase数据模型是理解其在IoT场景中应用的基础,它是一个多维稀疏映射表:

RowKey ColumnFamily1 ColumnFamily2

Qualifier1 Qualifier2 QualifierA QualifierB

Time Stamp1 value1 value2 valueA valueB

Time Stamp2 value1' valueA'

Time Stamp3 value2'' valueB''

表1: HBase数据模型结构示例

核心概念:

RowKey:行键,表中记录的唯一标识,按字典序排序ColumnFamily:列族,表创建时定义,是存储控制的基本单位ColumnQualifier:列限定符,列族下的具体列,可以动态添加TimeStamp:时间戳,用于版本控制,默认取系统时间Value:单元格的实际值,是未经解释的字节数组

数据模型特性:

稀疏性:对于不存在的列,不占用存储空间排序性:RowKey按字典序全局排序,支持范围查询版本化:每个单元格可以存储多个版本的数据面向列:按列族存储,有利于分析型查询和压缩优化

2.5 HBase关键特性与IoT数据需求的匹配

| HBase特性 | 技术实现 | IoT数据需求匹配度 | 价值体现 |

|---|---|---|---|

| 高写入吞吐量 | LSM树结构、顺序写 | ★★★★★ | 支持百万级设备并发写入 |

| 水平扩展 | Region自动分片、负载均衡 | ★★★★★ | 随设备增长无缝扩展存储容量 |

| 时序数据优化 | RowKey时间排序、TTL过期 | ★★★★★ | 高效存储和查询历史传感器数据 |

| 稀疏存储 | 列族模型、空值不存储 | ★★★★☆ | 灵活适应不同类型设备数据 |

| 强一致性 | 单行事务、行级锁 | ★★★★☆ | 确保设备状态数据准确性 |

| 压缩算法 | Snappy/LZO/GZIP | ★★★★☆ | 降低存储成本,提高IO效率 |

| 布隆过滤器 | 快速行/列存在性判断 | ★★★★☆ | 加速设备历史数据查询 |

| 块缓存 | 热点数据内存缓存 | ★★★★☆ | 提升频繁访问设备数据性能 |

表2: HBase特性与IoT需求匹配分析

3. 物联网数据模型与HBase表设计

3.1 IoT数据分类与特征分析

物联网设备产生的数据类型多样,需要针对性设计存储方案:

| 数据类型 | 典型来源 | 特征 | 数据量 | 写入频率 | 查询模式 |

|---|---|---|---|---|---|

| 传感器时序数据 | 温度、湿度、压力传感器 | 数值型、结构化、带时间戳 | 极大 | 高频(秒/分钟级) | 时间范围、聚合分析 |

| 设备状态数据 | 设备运行状态、错误码 | 枚举型、键值对 | 中等 | 中低频(状态变化) | 最新状态、状态变迁 |

| 地理位置数据 | GPS模块、位置服务 | 坐标点、区域多边形 | 中等 | 可变(移动时高频) | 位置范围、轨迹查询 |

| 事件日志数据 | 系统日志、操作记录 | 文本型、半结构化 | 大 | 事件触发 | 关键词搜索、关联分析 |

| 多媒体数据 | 摄像头、麦克风 | 图像、视频、音频流 | 极大 | 可变(按需采集) | 时间段检索、特征提取 |

表3: IoT数据类型分类与特征

3.2 HBase表设计核心原则

针对IoT数据特点,HBase表设计应遵循以下核心原则:

3.2.1 RowKey设计艺术

RowKey设计是HBase性能优化的关键,直接影响查询效率和负载均衡:

设计原则:

唯一性:确保每条记录有唯一标识排序性:利用有序特性优化常用查询散列性:避免热点写入,均衡Region负载紧凑性:控制长度(建议16-32字节),减少存储和I/O开销

IoT场景RowKey设计模式:

反转时间戳模式:

[设备ID]#[反转时间戳]

优点:相同设备数据聚集,便于范围查询示例:

sensor-1234#9876543210

加盐前缀模式:

[盐值]#[设备ID]#[时间戳]

优点:分散写入热点,适合高并发场景示例:

05#sensor-1234#1234567890

地理位置分区模式:

[区域ID]#[设备ID]#[时间戳]

优点:按区域聚集数据,适合区域查询示例:

beijing-chaoyang#camera-789#1234567890

RowKey设计数学分析:

假设我们有N个设备,每个设备产生M个数据点,RowKey设计对存储和查询的影响可以用以下模型表示:

数据聚集度指数:

其中

S

i

S_i

Si是第i个Region包含的设备数据比例,C值越接近1表示数据聚集度越好,范围查询效率越高。

负载均衡指数:

其中

σ

sigma

σ是各Region数据量的标准差,

μ

mu

μ是平均数据量,B值越小表示负载越均衡。

理想的RowKey设计需要在C和B之间找到平衡,通常采用复合RowKey策略。

3.2.2 列族设计策略

列族设计应基于访问模式和数据特性:

设计原则:

相关性原则:将访问模式相似的列放在同一列族数量控制:列族数量不宜过多(建议不超过5个)数据特性匹配:将具有相似访问频率和大小的数据放在一起

IoT场景典型列族划分:

基本感知列族:存储核心传感器数据,如温度、湿度、压力等状态列族:存储设备运行状态、错误码、电量等元数据列族:存储设备描述、位置、固件版本等静态信息事件列族:存储异常事件、告警信息等稀疏数据

3.2.3 版本控制与TTL设置

IoT场景通常不需要保留无限历史数据,合理设置版本和TTL至关重要:

版本控制策略:

对于传感器读数,通常保留1个版本(最新值)对于关键状态变化,可保留多个版本(通常3-5个)对于事件日志,可根据重要性设置不同版本数

TTL(Time-To-Live)设置:

根据数据价值周期设置过期时间:

原始高频采样数据:保留1-7天聚合统计数据:保留3-12个月关键事件和异常数据:保留1-3年设备元数据:永不过期

TTL实现原理基于HBase的自动过期清理机制,通过Major Compaction过程删除过期数据:

3.2.4 分区策略:预分区与自动分区

合理的分区策略可以避免热点问题,提升并行处理能力:

预分区设计:

适用于已知RowKey分布的场景:

// 创建预分区表的Java代码示例

Admin admin = connection.getAdmin();

HTableDescriptor tableDesc = new HTableDescriptor(TableName.valueOf("iot_sensors"));

// 添加列族

HColumnDescriptor cfData = new HColumnDescriptor("data");

cfData.setTimeToLive(86400); // 1天过期

tableDesc.addFamily(cfData);

// 定义预分区边界

byte[][] splits = new byte[][] {

Bytes.toBytes("sensor_0000"),

Bytes.toBytes("sensor_1000"),

Bytes.toBytes("sensor_2000"),

// ... 更多分区边界

};

// 创建表

admin.createTable(tableDesc, splits);

代码3: HBase预分区表创建示例

自动分区策略:

通过配置Region分裂阈值自动管理分区:

<!-- hbase-site.xml 配置 -->

<property>

<name>hbase.hregion.max.filesize</name>

<value>10737418240</value> <!-- 10GB,达到此大小触发分裂 -->

</property>

<property>

<name>hbase.regionserver.region.split.policy</name>

<value>org.apache.hadoop.hbase.regionserver.ConstantSizeRegionSplitPolicy</value>

</property>

代码4: HBase自动分区配置示例

3.3 IoT数据模型设计案例

3.3.1 智能电表数据模型

需求分析:

millions级智能电表,每15分钟采集一次用电数据需要查询单表历史用电曲线、区域用电统计、异常用电检测

表设计:

表名:smart_meter_data

RowKey:[电表ID]#[反转时间戳]

列族1:reading (TTL=365天)

- 列:voltage (电压)

- 列:current (电流)

- 列:power (功率)

- 列:energy (累计电量)

列族2:status (TTL=90天)

- 列:battery (电池电量)

- 列:signal (信号强度)

- 列:status_code (状态码)

列族3:metadata (TTL=FOREVER)

- 列:location (安装位置)

- 列:type (电表型号)

- 列:install_date (安装日期)

- 列:last_maintenance (上次维护时间)

RowKey示例:

MTR_10086#9876543210

查询模式支持:

单表历史数据:扫描

MTR_10086#*

MTR_10086#start_ts

MTR_10086#end_ts

MTR_100[0-9]#*

3.3.2 工业传感器数据模型

需求分析:

工厂设备传感器网络,毫秒级高频采集需支持实时监控、历史趋势分析、预测性维护

表设计:

表名:industrial_sensors

RowKey:[设备ID]#[传感器ID]#[反转时间戳]#[微秒后缀]

列族1:raw (TTL=7天)

- 列:value (原始采样值)

- 列:quality (数据质量标志)

列族2:processed (TTL=365天)

- 列:avg (分钟平均值)

- 列:max (分钟最大值)

- 列:min (分钟最小值)

- 列:std (分钟标准差)

列族3:events (TTL=1095天)

- 列:alert (告警类型)

- 列:threshold (阈值)

- 列:duration (持续时间)

RowKey示例:

MACHINE_456#SENSOR_TEMP#9876543210#000123

查询模式支持:

设备传感器实时数据:获取最新版本数据高频原始数据:限定时间范围扫描趋势分析:查询processed列族的聚合数据异常事件:查询events列族的告警记录

3.3.3 智能交通数据模型

需求分析:

城市交通监控系统,包含车辆识别、交通流量、违章抓拍需支持车牌查询、轨迹追踪、流量统计

表设计:

表名:traffic_data

RowKey:[数据类型]#[关键ID]#[时间戳]

列族1:vehicle (TTL=30天)

- 列:plate (车牌号码)

- 列:type (车辆类型)

- 列:color (车辆颜色)

- 列:speed (行驶速度)

列族2:location (TTL=30天)

- 列:road (道路ID)

- 列:lane (车道号)

- 列:x (经度)

- 列:y (纬度)

列族3:event (TTL=365天)

- 列:type (事件类型)

- 列:description (事件描述)

- 列:image_ref (关联图片引用)

RowKey设计:

车辆通行记录:

PASS#PLATE_ABC123#20231015143022

FLOW#ROAD_789#20231015143000

VIOLATION#PLATE_ABC123#20231015143022

查询模式支持:

车牌轨迹查询:扫描

PASS#PLATE_ABC123#*

FLOW#ROAD_789#20231015*

VIOLATION#PLATE_ABC123#*

4. HBase集群架构与部署优化

4.1 HBase集群规划

设计一个高效的HBase集群需要考虑多个因素,包括数据量、写入吞吐量、查询模式和预算约束。

4.1.1 集群规模估算

存储容量估算:

假设条件:

100万台设备,每台设备每5分钟产生1条记录每条记录平均大小:500字节数据保留时间:1年副本数:3 (HDFS默认副本)压缩比:1.5:1 (Snappy压缩)

计算过程:

每日数据量 = 1,000,000 设备 × (24×60/5) 记录/设备/天 × 500 字节/记录

= 1,000,000 × 288 × 500 字节

= 144,000,000,000 字节/天

= 144 GB/天

年度原始数据量 = 144 GB × 365 = 52,560 GB = 52.56 TB

考虑副本和压缩后的存储需求:

存储需求 = 52.56 TB × 3 (副本) / 1.5 (压缩比) = 105.12 TB

RegionServer数量估算:

假设每台RegionServer可承载:

存储:8-10 TB (取决于硬盘容量)写入吞吐量:5,000-10,000 ops/秒Region数量:100-200个

基于存储需求的RegionServer数量 = 105.12 TB / 8 TB/台 ≈ 14台

基于写入吞吐量的RegionServer数量:

每秒写入量 = 1,000,000 设备 / 300秒 = 3,333 ops/秒

RegionServer数量 = 3,333 ops/秒 / 5,000 ops/秒/台 ≈ 1台

综合考虑,实际部署建议使用14-16台RegionServer,留有一定冗余。

4.1.2 硬件配置推荐

RegionServer节点配置:

| 组件 | 规格 | 说明 |

|---|---|---|

| CPU | 16-24核,高频(3.0GHz+) | 处理并发读写请求和后台任务 |

| 内存 | 64-128 GB | MemStore和BlockCache内存分配 |

| 磁盘 | 10-12块×1-2 TB SSD | 提供高IOPS,避免单盘瓶颈 |

| 网络 | 10 Gbps以太网 | 支持节点间高速数据传输 |

HMaster节点配置:

| 组件 | 规格 | 说明 |

|---|---|---|

| CPU | 8-12核 | 处理轻量级管理任务 |

| 内存 | 32-64 GB | 集群元数据管理 |

| 磁盘 | 2-4块×1 TB SSD | 存储元数据和日志 |

| 网络 | 10 Gbps以太网 | 与RegionServer通信 |

内存分配原则:

RegionServer总内存的分配建议:

堆内内存(-Xmx):总内存的50%,最大不超过32GB (JVM GC限制)堆外内存:BlockCache可用总内存的25-30%系统和缓存:剩余内存

例如,对于64GB内存的RegionServer:

- 堆内内存:32GB (-Xmx32G)

- MemStore:16GB (hbase.regionserver.global.memstore.size=0.5)

- 其他:16GB

- 堆外内存:16GB (hbase.bucketcache.size=16384)

- 系统和缓存:16GB

4.2 部署模式选择

根据不同规模和需求,HBase有多种部署模式可选:

4.2.1 单机模式 (Standalone)

适合开发和测试环境:

# 下载HBase

wget https://downloads.apache.org/hbase/2.4.10/hbase-2.4.10-bin.tar.gz

tar xzvf hbase-2.4.10-bin.tar.gz

cd hbase-2.4.10

# 启动单机模式

./bin/start-hbase.sh

# 验证启动

./bin/hbase shell

hbase(main):001:0> status

1 active master, 0 backup masters, 1 servers, 0 dead, 2.0000 average load

代码5: HBase单机模式部署示例

4.2.2 伪分布式模式 (Pseudo-Distributed)

单节点模拟分布式环境,适合开发和原型验证:

<!-- conf/hbase-site.xml -->

<configuration>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.rootdir</name>

<value>hdfs://localhost:9000/hbase</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/home/hbase/zookeeper</value>

</property>

</configuration>

代码6: HBase伪分布式配置

4.2.3 完全分布式模式 (Fully Distributed)

生产环境部署,多节点协同工作:

集群规划:

| 节点角色 | 主机名 | 组件 |

|---|---|---|

| Master | master1, master2 | HMaster, ZooKeeper |

| RegionServer | rs1-rs16 | RegionServer, ZooKeeper |

| ZooKeeper | zk1-zk3 | ZooKeeper |

关键配置:

<!-- conf/hbase-site.xml -->

<configuration>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.rootdir</name>

<value>hdfs://nameservice1/hbase</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>zk1,zk2,zk3</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/data/zookeeper</value>

</property>

<property>

<name>hbase.master.info.port</name>

<value>16010</value>

</property>

<property>

<name>hbase.regionserver.port</name>

<value>16020</value>

</property>

<property>

<name>hbase.regionserver.info.port</name>

<value>16030</value>

</property>

</configuration>

代码7: HBase完全分布式配置

# conf/regionservers

rs1

rs2

rs3

rs4

rs5

rs6

rs7

rs8

rs9

rs10

rs11

rs12

rs13

rs14

代码8: RegionServer节点配置

4.2.4 容器化部署

使用Docker和Docker Compose简化部署:

# docker-compose.yml

version: '3'

services:

zookeeper:

image: zookeeper:3.5

ports:

- "2181:2181"

environment:

ZOO_MY_ID: 1

volumes:

- zookeeper-data:/data

hbase-master:

image: dajobe/hbase

ports:

- "16010:16010"

environment:

HBASE_NODE_TYPE: master

HBASE_MASTER: localhost

HBASE_ZOOKEEPER_QUORUM: zookeeper

depends_on:

- zookeeper

volumes:

- hbase-data:/data/hbase

hbase-regionserver:

image: dajobe/hbase

environment:

HBASE_NODE_TYPE: regionserver

HBASE_MASTER: hbase-master

HBASE_ZOOKEEPER_QUORUM: zookeeper

depends_on:

- hbase-master

- zookeeper

volumes:

- hbase-data:/data/hbase

volumes:

zookeeper-data:

hbase-data:

代码9: HBase Docker Compose配置

启动容器集群:

docker-compose up -d

# 扩展RegionServer数量

docker-compose up -d --scale hbase-regionserver=3

4.3 关键配置优化

针对IoT场景的HBase关键配置优化:

4.3.1 写入性能优化配置

<!-- 写入性能优化 -->

<property>

<name>hbase.regionserver.handler.count</name>

<value>100</value> <!-- 处理请求的线程数,默认30 -->

</property>

<property>

<name>hbase.hregion.memstore.flush.size</name>

<value>134217728</value> <!-- 128MB,MemStore刷写阈值 -->

</property>

<property>

<name>hbase.regionserver.global.memstore.size</name>

<value>0.4</value> <!-- RegionServer总MemStore占堆比例 -->

</property>

<property>

<name>hbase.regionserver.global.memstore.size.lower.limit</name>

<value>0.35</value> <!-- 低水位标记,停止强制刷写 -->

</property>

<property>

<name>hbase.regionserver.wal.durable.sync</name>

<value>false</value> <!-- 关闭WAL同步刷盘,提高写入性能 -->

</property>

<property>

<name>hbase.wal.provider</name>

<value>asyncfs</value> <!-- 使用异步WAL写入 -->

</property>

4.3.2 读取性能优化配置

<!-- 读取性能优化 -->

<property>

<name>hbase.regionserver.blockcache.size</name>

<value>0.4</value> <!-- BlockCache占堆比例 -->

</property>

<property>

<name>hbase.bucketcache.ioengine</name>

<value>offheap</value> <!-- 使用堆外内存作为BlockCache -->

</property>

<property>

<name>hbase.bucketcache.size</name>

<value>16384</value> <!-- 堆外BlockCache大小(MB) -->

</property>

<property>

<name>hfile.block.cache.size</name>

<value>0.4</value> <!-- L1 BlockCache占比 -->

</property>

<property>

<name>hbase.rs.cacheblocksonwrite</name>

<value>true</value> <!-- 写入时缓存数据块 -->

</property>

4.3.3 压缩与存储优化配置

<!-- 压缩与存储优化 -->

<property>

<name>hbase.hregion.compression</name>

<value>SNAPPY</value> <!-- 默认压缩算法 -->

</property>

<property>

<name>hbase.hregion.blocksize</name>

<value>65536</value> <!-- 数据块大小64KB -->

</property>

<property>

<name>hbase.io.file.buffer.size</name>

<value>131072</value> <!-- HFile写入缓冲区128KB -->

</property>

<property>

<name>hbase.hfile.index.block.max.size</name>

<value>131072</value> <!-- 索引块最大大小 -->

</property>

4.3.4 集群稳定性配置

<!-- 集群稳定性配置 -->

<property>

<name>hbase.regionserver.maxlogs</name>

<value>100</value> <!-- WAL文件最大数量 -->

</property>

<property>

<name>hbase.regionserver.logroll.period</name>

<value>3600000</value> <!-- 1小时滚动一次WAL -->

</property>

<property>

<name>hbase.master.balancer.period</name>

<value>300000</value> <!-- 5分钟平衡一次Region -->

</property>

<property>

<name>hbase.regionserver.lease.period</name>

<value>60000</value> <!-- 租约超时60秒 -->

</property>

<property>

<name>hbase.ipc.client.socket.timeout.connect</name>

<value>10000</value> <!-- 连接超时10秒 -->

</property>

4.4 监控与运维体系

4.4.1 监控指标与告警

关键监控指标:

HBase Master指标:

Master活性状态Region分配延迟DDL操作成功率和延迟

RegionServer指标:

读写请求吞吐量 (requests/sec)读写延迟 (p50, p95, p99)MemStore大小和刷写频率BlockCache命中率Compaction次数和耗时Region数量和大小

JVM指标:

堆内存使用情况GC次数和耗时线程数量和状态

HDFS指标:

存储空间使用率块副本健康状态I/O吞吐量

4.4.2 使用Prometheus和Grafana监控

# prometheus.yml

global:

scrape_interval: 15s

scrape_configs:

- job_name: 'hbase'

static_configs:

- targets: ['hbase-exporter:9445']

代码10: Prometheus配置

HBase Exporter部署:

# 启动HBase Exporter

docker run -d -p 9445:9445 --name hbase-exporter

-e HBASE_ZK_QUORUM=zk1,zk2,zk3

dmetzler/hbase-exporter

代码11: HBase Exporter部署

4.4.3 备份与恢复策略

定期备份:

使用HBase Export工具导出数据:

# 导出表数据

hbase org.apache.hadoop.hbase.mapreduce.Export

smart_meter_data /backup/hbase/smart_meter_data/20231015

# 导入表数据

hbase org.apache.hadoop.hbase.mapreduce.Import

smart_meter_data /backup/hbase/smart_meter_data/20231015

快照备份:

更高效的快照备份方式:

# 创建快照

hbase shell> snapshot 'smart_meter_data', 'smart_meter_data_snapshot_20231015'

# 列出快照

hbase shell> list_snapshots

# 从快照恢复

hbase shell> disable 'smart_meter_data'

hbase shell> restore_snapshot 'smart_meter_data_snapshot_20231015'

hbase shell> enable 'smart_meter_data'

# 克隆快照到新表

hbase shell> clone_snapshot 'smart_meter_data_snapshot_20231015', 'smart_meter_data_copy'

5. IoT数据写入与查询策略

5.1 数据写入策略

IoT场景通常需要处理大规模设备并发写入,需要优化写入策略以提高吞吐量并避免热点问题。

5.1.1 批量写入优化

批量写入是提高吞吐量的关键策略:

// Java批量写入示例

Configuration config = HBaseConfiguration.create();

try (Connection connection = ConnectionFactory.createConnection(config);

Table table = connection.getTable(TableName.valueOf("sensor_data"))) {

List<Put> puts = new ArrayList<>();

// 添加批量数据

for (SensorReading reading : sensorReadings) {

byte[] rowKey = generateRowKey(reading.getDeviceId(), reading.getTimestamp());

Put put = new Put(rowKey);

put.addColumn(

Bytes.toBytes("data"),

Bytes.toBytes("temperature"),

reading.getTimestamp(),

Bytes.toBytes(reading.getTemperature())

);

put.addColumn(

Bytes.toBytes("data"),

Bytes.toBytes("humidity"),

reading.getTimestamp(),

Bytes.toBytes(reading.getHumidity())

);

puts.add(put);

// 达到批量大小则提交

if (puts.size() >= 1000) {

table.put(puts);

puts.clear();

}

}

// 提交剩余数据

if (!puts.isEmpty()) {

table.put(puts);

}

} catch (IOException e) {

e.printStackTrace();

}

代码12: HBase批量写入优化示例

批量大小选择:

批量大小与吞吐量关系近似符合公式:

其中

α

alpha

α和

β

eta

β是系统相关参数。实践中,批量大小通常选择1000-5000条记录,具体需通过性能测试确定。

5.1.2 异步写入模式

使用异步API提高客户端吞吐量:

// 异步写入示例

Configuration config = HBaseConfiguration.create();

try (AsyncConnection connection = ConnectionFactory.createAsyncConnection(config).get();

相关文章