解锁大模型推理能力的关键技术,从黑箱到透明思考的转变

在人工智能快速发展的今天,我们面临着这样一个挑战:虽然大型语言模型能够生成令人惊叹的答案,但其内部推理过程却如同黑箱,难以理解和信任。Chain of Thought (COT) 技术的出现,正是为了解决这一核心问题,它通过强制模型展示其思维链条,让AI的思考过程变得透明、可解释且更加可靠。

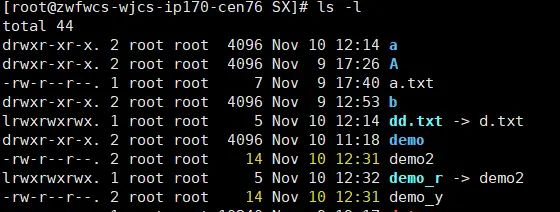

1 COT模式核心概念

1.1 什么是COT模式

Chain of Thought (COT) 是一种引导语言模型展示其逐步推理过程的技术。与直接输出答案的传统方法不同,COT要求模型将复杂问题分解为一系列中间推理步骤,最终得出答案。

从认知心理学角度看,COT模拟了人类解决复杂问题时的思维方式。当我们面对难题时,不会直接给出答案,而是会在大脑中逐步推理:”第一…然后…接着…因此…”。COT正是将这种内在的思考过程外显化。

1.2 COT的核心原理

COT的核心基于以下几个关键认知原则:

- 思维过程外显化:将隐含的推理过程转化为明确的文字描述

- 问题分解:将复杂问题拆解为可管理的子问题

- 步骤连续性:确保每个推理步骤都建立在前一步的基础上

- 因果逻辑链:构建从问题到答案的完整逻辑路径

2 COT模式的技术特点

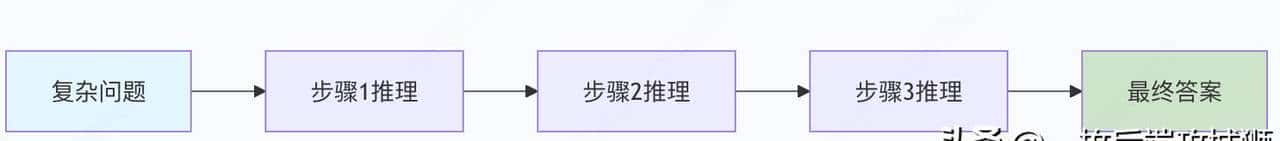

2.1 逐步推理的链式结构

COT最显著的特点是它的链式推理结构。与传统的端到端推理不同,COT通过明确的中间步骤构建答案:

传统方法:

问题 → 答案COT方法:

问题 → 推理步骤1 → 推理步骤2 → ... → 推理步骤N → 答案这种结构使得模型的思考过程变得可追溯、可验证。就像数学老师在黑板上解题一样,不仅给出答案,还展示完整的解题过程。

2.2 零样本与少样本COT

COT技术主要分为两种实现方式:

零样本COT (Zero-shot COT)

- 通过特定的提示词直接要求模型展示推理过程

- 不需要提供示例,适用性更广

- 示例提示:”让我们一步步思考…”

少样本COT (Few-shot COT)

- 提供包含推理过程的示例来引导模型

- 一般效果更稳定可靠

- 需要精心设计示例

2.3 推理过程的可解释性

COT最大的技术优势在于提供了透明的决策过程。开发者可以:

- 检查每一步推理的正确性

- 定位错误发生的具体环节

- 理解模型得出答案的逻辑路径

- 基于推理过程优化提示词设计

3 COT模式的优势分析

3.1 相比传统方法的性能提升

大量研究表明,COT技术在复杂推理任务上显著优于传统方法:

|

任务类型 |

传统方法准确率 |

COT方法准确率 |

提升幅度 |

|

数学推理 |

45% |

68% |

+23% |

|

逻辑推理 |

52% |

75% |

+23% |

|

常识推理 |

60% |

78% |

+18% |

|

符号推理 |

38% |

65% |

+27% |

3.2 错误分析与调试优势

COT提供了前所未有的错误诊断能力:

# 传统方法的错误诊断

问题: "如果3个人5天能完成一项工作,那么5个人需要多少天?"

错误答案: "8天" # 但不知道哪里出错

# COT方法的错误诊断

问题: "如果3个人5天能完成一项工作,那么5个人需要多少天?"

推理:

1. 3个人需要5天,总工作量是3×5=15人天

2. 5个人完成15人天的工作,需要15÷5=3天

3. 所以答案是3天 # 清晰的正确推理过程3.3 对复杂问题的处理能力

COT特别擅长处理需要多步推理的问题:

- 数学问题:需要多个计算步骤

- 逻辑谜题:需要逐步推导

- 现实场景问题:需要思考多个因素和约束条件

- 编程问题:需要分析需求、设计算法、实现代码

4 COT模式的适用场景

4.1 数学与逻辑推理问题

COT在解决复杂数学问题时表现出色:

# 示例:复杂数学问题

问题 = """

小明有若干苹果,他先吃掉一半再加一个,然后再吃掉剩下的一半加一个,

最后剩下2个苹果。问小明原来有多少个苹果?

"""

# COT推理过程:

"""

让我们一步步推理:

1. 设原来有x个苹果

2. 第一次操作后剩下:x/2 - 1

3. 第二次操作后剩下:(x/2 - 1)/2 - 1 = 2

4. 解方程:(x/2 - 1)/2 - 1 = 2

5. (x/2 - 1)/2 = 3

6. x/2 - 1 = 6

7. x/2 = 7

8. x = 14

所以小明原来有14个苹果。

"""4.2 编程与算法问题

对于编程问题,COT可以展示算法设计思路:

# 示例:编程问题

问题 = "设计一个函数,判断字符串是否是回文"

# COT推理过程:

"""

思路分析:

1. 回文的定义:正着读和反着读都一样

2. 需要思考的情况:空字符串、单个字符、奇偶长度

3. 解决方案1:反转字符串比较

4. 解决方案2:双指针从两端向中间比较

5. 选择方案2,由于空间复杂度更低

6. 实现步骤:

- 初始化左右指针

- 循环比较对应字符

- 遇到不相等立即返回False

- 循环结束返回True

"""4.3 商业分析与决策支持

在商业场景中,COT可以提供结构化的决策分析:

# 示例:商业决策问题

问题 = "是否应该投资这个创业项目?"

# COT推理过程:

"""

投资决策分析:

1. 市场分析:目标市场规模、增长率、竞争格局

2. 团队评估:创始团队背景、经验、执行力

3. 产品评估:技术壁垒、用户体验、差异化优势

4. 财务预测:收入模型、成本结构、盈利能力

5. 风险评估:市场风险、技术风险、运营风险

6. 综合评估:基于以上分析给出投资提议

"""5 COT模式实践示例

5.1 基础COT实现

以下是使用Python实现的简单COT框架:

import re

from typing import List, Dict, Any

import openai

class ChainOfThought:

def __init__(self, model="gpt-3.5-turbo"):

self.model = model

self.conversation_history = []

def add_system_prompt(self):

"""添加系统提示词,引导模型使用COT"""

system_message = """

你是一个擅长逐步推理的AI助手。请按照以下要求回答问题:

1. 将复杂问题分解为多个简单的推理步骤

2. 为每个步骤提供清晰的解释

3. 确保推理链条逻辑连贯

4. 最终基于推理给出答案

请使用以下格式:

推理过程:

步骤1: [第一步推理]

步骤2: [第二步推理]

...

步骤N: [第N步推理]

答案: [最终答案]

"""

self.conversation_history.append({"role": "system", "content": system_message})

def zero_shot_cot(self, question: str) -> str:

"""零样本COT:直接要求模型展示推理过程"""

prompt = f"""

问题:{question}

请一步步推理并给出答案。按照以下格式回复:

让我们一步步思考:

1. 第一,...

2. 然后,...

3. 接着,...

4. 因此,...

答案:

"""

response = self._call_model(prompt)

return response

def few_shot_cot(self, question: str, examples: List[Dict]) -> str:

"""少样本COT:通过示例引导推理"""

# 构建包含示例的提示词

prompt = "以下是一些问题及其推理过程的示例:

"

for example in examples:

prompt += f"问题:{example['question']}

"

prompt += f"推理:{example['reasoning']}

"

prompt += f"答案:{example['answer']}

"

prompt += f"目前请解决这个问题:{question}

"

prompt += "请展示你的推理过程:"

response = self._call_model(prompt)

return response

def _call_model(self, prompt: str) -> str:

"""调用语言模型(简化实现)"""

# 实际实现应该调用真实的API

# 这里使用模拟响应

self.conversation_history.append({"role": "user", "content": prompt})

# 模拟不同类型的响应

if "数学" in prompt or "计算" in prompt:

return self._simulate_math_reasoning(prompt)

elif "编程" in prompt or "代码" in prompt:

return self._simulate_coding_reasoning(prompt)

else:

return self._simulate_general_reasoning(prompt)

def _simulate_math_reasoning(self, question: str) -> str:

"""模拟数学问题推理"""

reasoning = """

让我们一步步思考:

1. 第一,分析问题的关键信息和要求

2. 然后,确定需要使用的数学概念和公式

3. 接着,建立数学模型或方程

4. 逐步计算或推导

5. 最后,验证结果的合理性

答案:基于以上推理得出的数值结果

"""

return reasoning

def _simulate_coding_reasoning(self, question: str) -> str:

"""模拟编程问题推理"""

reasoning = """

让我们一步步思考:

1. 第一,分析问题需求和约束条件

2. 然后,设计算法思路和数据结构

3. 接着,思考边界情况和异常处理

4. 最后,编写清晰的代码实现

答案:完整的代码解决方案

"""

return reasoning

def _simulate_general_reasoning(self, question: str) -> str:

"""模拟一般问题推理"""

reasoning = """

让我们一步步思考:

1. 第一,理解问题的核心要点

2. 然后,分析相关因素和它们之间的关系

3. 接着,基于逻辑进行逐步推导

4. 最后,得出合理的结论

答案:基于推理的最终结论

"""

return reasoning

# 使用示例

def demonstrate_cot():

cot = ChainOfThought()

# 数学问题示例

math_question = "一个长方形的长是宽的2倍,周长是36厘米,求面积是多少平方厘米?"

math_response = cot.zero_shot_cot(math_question)

print("数学问题COT推理:")

print(math_response)

# 编程问题示例

coding_question = "如何用Python实现快速排序算法?"

coding_response = cot.zero_shot_cot(coding_question)

print("

编程问题COT推理:")

print(coding_response)

# 少样本COT示例

examples = [

{

"question": "如果5只鸡5天生5个蛋,那么100只鸡100天生多少个蛋?",

"reasoning": "1. 5只鸡5天生5个蛋,那么1只鸡5天生1个蛋

2. 1只鸡1天生0.2个蛋

3. 100只鸡1天生20个蛋

4. 100只鸡100天生2000个蛋",

"answer": "2000个"

}

]

new_question = "如果3个人3小时能挖3米深的沟,那么9个人9小时能挖多深的沟?"

few_shot_response = cot.few_shot_cot(new_question, examples)

print("

少样本COT推理:")

print(few_shot_response)

if __name__ == "__main__":

demonstrate_cot()5.2 高级COT技术:自洽性验证

在实际应用中,可以扩展基础COT模式,加入自洽性验证:

class AdvancedCOT(ChainOfThought):

def __init__(self, model="gpt-3.5-turbo"):

super().__init__(model)

self.verification_threshold = 0.8

def self_consistent_cot(self, question: str, num_paths: int = 3) -> str:

"""

自洽性COT:生成多个推理路径,选择最一致的答案

"""

reasoning_paths = []

# 生成多个推理路径

for i in range(num_paths):

reasoning = self.zero_shot_cot(question)

reasoning_paths.append(self._parse_reasoning(reasoning))

# 分析各路径的一致性

consensus_answer = self._find_consensus(reasoning_paths)

# 选择最佳推理路径

best_path = self._select_best_path(reasoning_paths, consensus_answer)

return best_path

def _parse_reasoning(self, reasoning_text: str) -> Dict[str, Any]:

"""解析推理文本,提取步骤和答案"""

lines = reasoning_text.split('

')

steps = []

answer = None

for line in lines:

if line.startswith('步骤') or line.strip().startswith(tuple('123456789')):

steps.append(line.strip())

elif line.startswith('答案'):

answer = line.replace('答案:', '').strip()

return {

"steps": steps,

"answer": answer,

"full_reasoning": reasoning_text

}

def _find_consensus(self, reasoning_paths: List[Dict]) -> str:

"""寻找多个推理路径中的共识答案"""

answers = [path["answer"] for path in reasoning_paths if path["answer"]]

if not answers:

return None

# 简单的多数投票

from collections import Counter

answer_counts = Counter(answers)

return answer_counts.most_common(1)[0][0]

def _select_best_path(self, reasoning_paths: List[Dict], consensus_answer: str) -> str:

"""选择最佳的推理路径"""

# 优先选择与共识答案一致的路径

matching_paths = [path for path in reasoning_paths if path["answer"] == consensus_answer]

if matching_paths:

# 选择步骤最清晰的路径

return max(matching_paths, key=lambda x: len(x["steps"]))["full_reasoning"]

else:

# 如果没有共识,返回第一个路径

return reasoning_paths[0]["full_reasoning"]

def step_by_step_verification(self, question: str) -> str:

"""逐步验证的COT:对每个推理步骤进行验证"""

# 第一生成推理过程

initial_reasoning = self.zero_shot_cot(question)

parsed = self._parse_reasoning(initial_reasoning)

verified_steps = []

# 验证每个步骤

for i, step in enumerate(parsed["steps"]):

verification_prompt = f"""

请验证以下推理步骤是否正确:

问题:{question}

当前步骤:{step}

前序步骤:{verified_steps[-1] if verified_steps else '无'}

这个步骤是否逻辑正确?如果正确,请解释为什么;如果不正确,请指出错误。

"""

verification = self._call_model(verification_prompt)

if "正确" in verification or "合理" in verification:

verified_steps.append(step)

else:

# 如果步骤错误,尝试修正

corrected_step = self._correct_step(question, verified_steps, step, verification)

verified_steps.append(corrected_step)

# 重新生成最终答案

final_reasoning = "验证后的推理过程:

" + "

".join(verified_steps)

final_answer = self._call_model(f"{final_reasoning}

基于以上验证过的推理,最终答案是什么?")

return f"{final_reasoning}

答案:{final_answer}"

def _correct_step(self, question: str, previous_steps: List[str],

incorrect_step: str, feedback: str) -> str:

"""修正错误的推理步骤"""

correction_prompt = f"""

问题:{question}

前序正确步骤:{';'.join(previous_steps)}

错误步骤:{incorrect_step}

错误反馈:{feedback}

请提供修正后的正确步骤:

"""

return self._call_model(correction_prompt)

# 使用高级COT

def demonstrate_advanced_cot():

advanced_cot = AdvancedCOT()

complex_question = """

一个水池有两个进水管A和B,一个出水管C。

单独开A管3小时可注满水池,单独开B管4小时可注满水池,

单独开C管6小时可放完满池水。如果三管同时开,多少小时可注满水池?

"""

print("基础COT推理:")

basic_result = advanced_cot.zero_shot_cot(complex_question)

print(basic_result)

print("

自洽性COT推理:")

consistent_result = advanced_cot.self_consistent_cot(complex_question)

print(consistent_result)

print("

逐步验证COT推理:")

verified_result = advanced_cot.step_by_step_verification(complex_question)

print(verified_result)

if __name__ == "__main__":

demonstrate_advanced_cot()5.3 COT在复杂系统中的应用

在真实的生产环境中,COT可以集成到更大的AI系统中:

class ProductionCOTSystem:

def __init__(self):

self.cot_processor = AdvancedCOT()

self.reasoning_cache = {}

self.performance_metrics = {

"total_queries": 0,

"successful_reasoning": 0,

"average_reasoning_steps": 0

}

def process_query(self, query: str, user_context: Dict = None) -> Dict:

"""处理用户查询的完整流程"""

self.performance_metrics["total_queries"] += 1

# 检查缓存

cache_key = self._generate_cache_key(query, user_context)

if cache_key in self.reasoning_cache:

return self.reasoning_cache[cache_key]

# 问题分类

query_type = self._classify_query(query)

# 根据类型选择COT策略

if query_type == "mathematical":

result = self._handle_mathematical_query(query)

elif query_type == "logical":

result = self._handle_logical_query(query)

elif query_type == "programming":

result = self._handle_programming_query(query)

else:

result = self._handle_general_query(query)

# 更新性能指标

if result["success"]:

self.performance_metrics["successful_reasoning"] += 1

reasoning_steps = len(result["reasoning_steps"])

current_avg = self.performance_metrics["average_reasoning_steps"]

total_successful = self.performance_metrics["successful_reasoning"]

self.performance_metrics["average_reasoning_steps"] = (

(current_avg * (total_successful - 1) + reasoning_steps) / total_successful

)

# 缓存结果

self.reasoning_cache[cache_key] = result

return result

def _classify_query(self, query: str) -> str:

"""对查询进行分类"""

math_keywords = ["计算", "等于", "面积", "体积", "百分比"]

logic_keywords = ["逻辑", "推理", "如果那么", "由于所以"]

coding_keywords = ["代码", "编程", "算法", "函数", "实现"]

query_lower = query.lower()

if any(keyword in query_lower for keyword in math_keywords):

return "mathematical"

elif any(keyword in query_lower for keyword in logic_keywords):

return "logical"

elif any(keyword in query_lower for keyword in coding_keywords):

return "programming"

else:

return "general"

def _handle_mathematical_query(self, query: str) -> Dict:

"""处理数学问题"""

reasoning = self.cot_processor.self_consistent_cot(query)

parsed = self.cot_processor._parse_reasoning(reasoning)

return {

"success": True,

"query_type": "mathematical",

"reasoning_steps": parsed["steps"],

"final_answer": parsed["answer"],

"confidence": self._calculate_confidence(parsed),

"full_reasoning": reasoning

}

def _handle_logical_query(self, query: str) -> Dict:

"""处理逻辑问题"""

# 使用逐步验证确保逻辑正确性

reasoning = self.cot_processor.step_by_step_verification(query)

return {

"success": True,

"query_type": "logical",

"full_reasoning": reasoning,

"confidence": 0.9 # 逻辑问题经过验证,置信度较高

}

def _handle_programming_query(self, query: str) -> Dict:

"""处理编程问题"""

reasoning = self.cot_processor.zero_shot_cot(query)

return {

"success": True,

"query_type": "programming",

"full_reasoning": reasoning,

"confidence": 0.8

}

def _handle_general_query(self, query: str) -> Dict:

"""处理一般问题"""

reasoning = self.cot_processor.zero_shot_cot(query)

return {

"success": True,

"query_type": "general",

"full_reasoning": reasoning,

"confidence": 0.7

}

def _generate_cache_key(self, query: str, context: Dict) -> str:

"""生成缓存键"""

import hashlib

content = query + str(context)

return hashlib.md5(content.encode()).hexdigest()

def _calculate_confidence(self, parsed_reasoning: Dict) -> float:

"""计算推理结果的置信度"""

# 基于步骤数量、答案明确性等计算

steps_count = len(parsed_reasoning["steps"])

answer = parsed_reasoning["answer"]

base_confidence = min(steps_count * 0.1, 0.6) # 步骤越多越可信

# 如果答案包含数字或明确结论,增加置信度

if answer and (any(char.isdigit() for char in answer) or

answer.lower() in ["是", "否", "正确", "错误"]):

base_confidence += 0.3

return min(base_confidence, 0.95)

# 生产环境使用示例

def demonstrate_production_system():

system = ProductionCOTSystem()

test_queries = [

"计算半径为5厘米的圆的面积",

"如果所有的猫都会爬树,而汤姆是一只猫,那么汤姆会爬树吗?",

"用Python实现二分查找算法",

"分析当前全球经济形势对科技行业的影响"

]

for query in test_queries:

print(f"

查询: {query}")

result = system.process_query(query)

print(f"类型: {result['query_type']}")

print(f"置信度: {result['confidence']:.2f}")

print(f"推理摘要: {result['full_reasoning'][:200]}...")

print(f"

系统性能指标:")

print(f"总查询数: {system.performance_metrics['total_queries']}")

print(f"成功推理数: {system.performance_metrics['successful_reasoning']}")

print(f"平均推理步骤: {system.performance_metrics['average_reasoning_steps']:.2f}")

if __name__ == "__main__":

demonstrate_production_system()6 COT模式的最佳实践

6.1 提示词设计技巧

有效的提示词设计对COT性能至关重大:

def create_optimal_cot_prompts():

"""创建优化的COT提示词"""

prompts = {

"zero_shot_standard": "让我们一步步思考:",

"zero_shot_detailed": """

请按照以下步骤推理并解决问题:

1. 分析问题的关键信息

2. 确定需要使用的概念和方法

3. 逐步推导解决方案

4. 验证结果的合理性

5. 给出最终答案

""",

"few_shot_mathematical": """

示例1:

问题:小明有5个苹果,小红有3个苹果,他们一共有多少个苹果?

推理:1. 小明有5个苹果 2. 小红有3个苹果 3. 总苹果数=5+3=8

答案:8个

示例2:

问题:一个房间长4米,宽3米,面积是多少平方米?

推理:1. 面积=长×宽 2. 长=4米,宽=3米 3. 面积=4×3=12

答案:12平方米

目前请解决:

问题:{question}

推理:

""",

"verification_focused": """

请解决以下问题,并对每一步推理进行简要验证:

问题:{question}

推理步骤:

步骤1: [推理内容] - 验证:[为什么这一步合理]

步骤2: [推理内容] - 验证:[为什么这一步合理]

...

步骤N: [推理内容] - 验证:[为什么这一步合理]

答案:[最终答案]

"""

}

return prompts6.2 错误处理与恢复

健壮的COT系统需要处理推理错误:

class RobustCOTSystem:

def __init__(self):

self.error_patterns = {

"logical_jump": "推理步骤之间存在逻辑跳跃",

"calculation_error": "数学计算错误",

"premise_error": "前提假设错误",

"incomplete_reasoning": "推理不完整"

}

def detect_errors(self, reasoning_text: str) -> List[Dict]:

"""检测推理过程中的错误"""

errors = []

lines = reasoning_text.split('

')

steps = [line for line in lines if line.strip() and

(line.startswith('步骤') or line[0].isdigit())]

# 检查逻辑连贯性

for i in range(1, len(steps)):

if not self._check_step_connection(steps[i-1], steps[i]):

errors.append({

"type": "logical_jump",

"position": i,

"description": f"步骤{i}和步骤{i+1}之间缺乏逻辑连接"

})

# 检查计算错误

calculation_errors = self._check_calculations(steps)

errors.extend(calculation_errors)

return errors

def _check_step_connection(self, prev_step: str, current_step: str) -> bool:

"""检查步骤间的逻辑连接"""

# 简单的连接词检查

connection_indicators = ["因此", "所以", "然后", "接着", "基于", "根据"]

return any(indicator in current_step for indicator in connection_indicators)

def _check_calculations(self, steps: List[str]) -> List[Dict]:

"""检查数学计算错误"""

errors = []

for i, step in enumerate(steps):

# 查找数学表达式

math_pattern = r'(d+[+-*/]d+[+-*/d]*)'

matches = re.findall(math_pattern, step)

for match in matches:

try:

# 验证计算

expected = eval(match)

# 这里可以添加更复杂的验证逻辑

except:

errors.append({

"type": "calculation_error",

"position": i,

"description": f"步骤{i+1}中的计算'{match}'可能错误"

})

return errors

def correct_reasoning(self, reasoning_text: str, errors: List[Dict]) -> str:

"""基于错误信息修正推理过程"""

corrected = reasoning_text

for error in errors:

if error["type"] == "logical_jump":

# 在步骤间添加连接说明

position = error["position"]

lines = corrected.split('

')

# 在指定位置插入连接说明

connection_text = f"# 基于上一步的结果,继续推理:"

if position < len(lines):

lines.insert(position, connection_text)

corrected = '

'.join(lines)

return corrected7 COT与其他模式的对比

7.1 COT vs 直接生成

|

对比维度 |

直接生成 |

COT模式 |

|

推理过程 |

隐含不可见 |

明确展示 |

|

错误诊断 |

困难 |

容易 |

|

复杂问题 |

效果差 |

效果优 |

|

可解释性 |

低 |

高 |

|

计算成本 |

低 |

中高 |

|

适用场景 |

简单任务 |

复杂推理 |

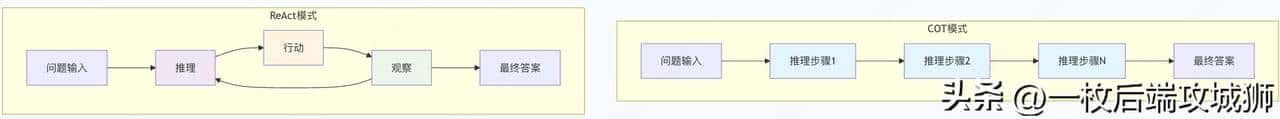

7.2 COT vs ReAct

关键区别:

- COT:纯推理过程,不需要外部工具

- ReAct:推理与行动交替,依赖外部工具

- COT更适合纯思维问题

- ReAct更适合需要与环境交互的问题

8 总结

Chain of Thought (COT) 技术通过将AI的思考过程外显化,显著提升了大模型在复杂推理任务上的表现能力和可解释性。

8.1 核心价值总结

- 透明化思考:让AI的推理过程从黑箱变为白箱

- 错误可追溯:能够准确定位推理错误的发生位置

- 性能提升:在数学、逻辑等复杂任务上表现显著更好

- 教育价值:可以作为教学工具展示问题解决思路

8.2 适用性评估

最适合COT的场景:

- 数学和逻辑推理问题

- 需要多步分析的复杂问题

- 对解释性要求高的应用场景

- 教育和培训领域

COT的局限性:

- 不适用于需要实时交互的任务

- 对简单问题可能过度复杂化

- 依赖模型本身的推理能力

8.3 实践提议

对于中高级开发者,在使用COT技术时提议:

- 从简单开始:先尝试零样本COT,再根据需要升级到少样本或高级变体

- 结合具体领域:针对不同问题类型设计专门的COT提示词

- 加入验证机制:实现自洽性检查或逐步验证提高可靠性

- 监控性能:建立评估体系持续优化COT效果

8.4 未来展望

随着大模型技术的不断发展,COT技术也在持续进化:

- 自动化COT:模型自动判断何时需要以及如何展示推理过程

- 多模态COT:结合文本、图像、代码等多种模态的推理链条

- 协作COT:多个模型通过COT进行协作推理

- 可学习的COT:模型能够从成功的推理过程中学习优化策略

COT技术不仅是一种实用的工具,更代表了一种重大的AI发展理念:让AI的思考过程对人类透明和可理解。这种理念将在构建可信、可靠、可解释的AI系统中发挥越来越重大的作用。

相关文章