Python全能文档提取:一键搞定WordExcelPDFPPT内容

300份合同把法务压垮的那周:人工审阅要120小时,Python自动化只要4小时,准确率从91.3%提升到99.2%,你还在犹豫吗?

第一,工作量暴增是个真实的焦虑。根据Gartner2024报告,企业日均处理文档量增长了37%,而且其中约80%是非结构化数据。说实话,这种“看得见却抓不住”的信息量,会让中层管理者晚上睡不安稳,决策慢、交付慢、合规风险随之上升。

其次,我想讲一个真实的企业案例来说明差距有多大。我有个朋友在一家金融机构的法务部做外包项目,过去他们靠手工从合同里提取关键条款,300份合同从接单到出结果累计花了超过120个工时,人工错误率接近8.7%,结果是几个条款反复被遗漏、审批被退回,业务被迫延后。后来他们试了基于Python的自动化提取流水线,整体耗时缩短到4小时,准确率提升到99.2%,不仅节省了人力成本,也把合规风险降到更可控的水平。我觉得这不是夸张,这是效率革命带来的直接回报。

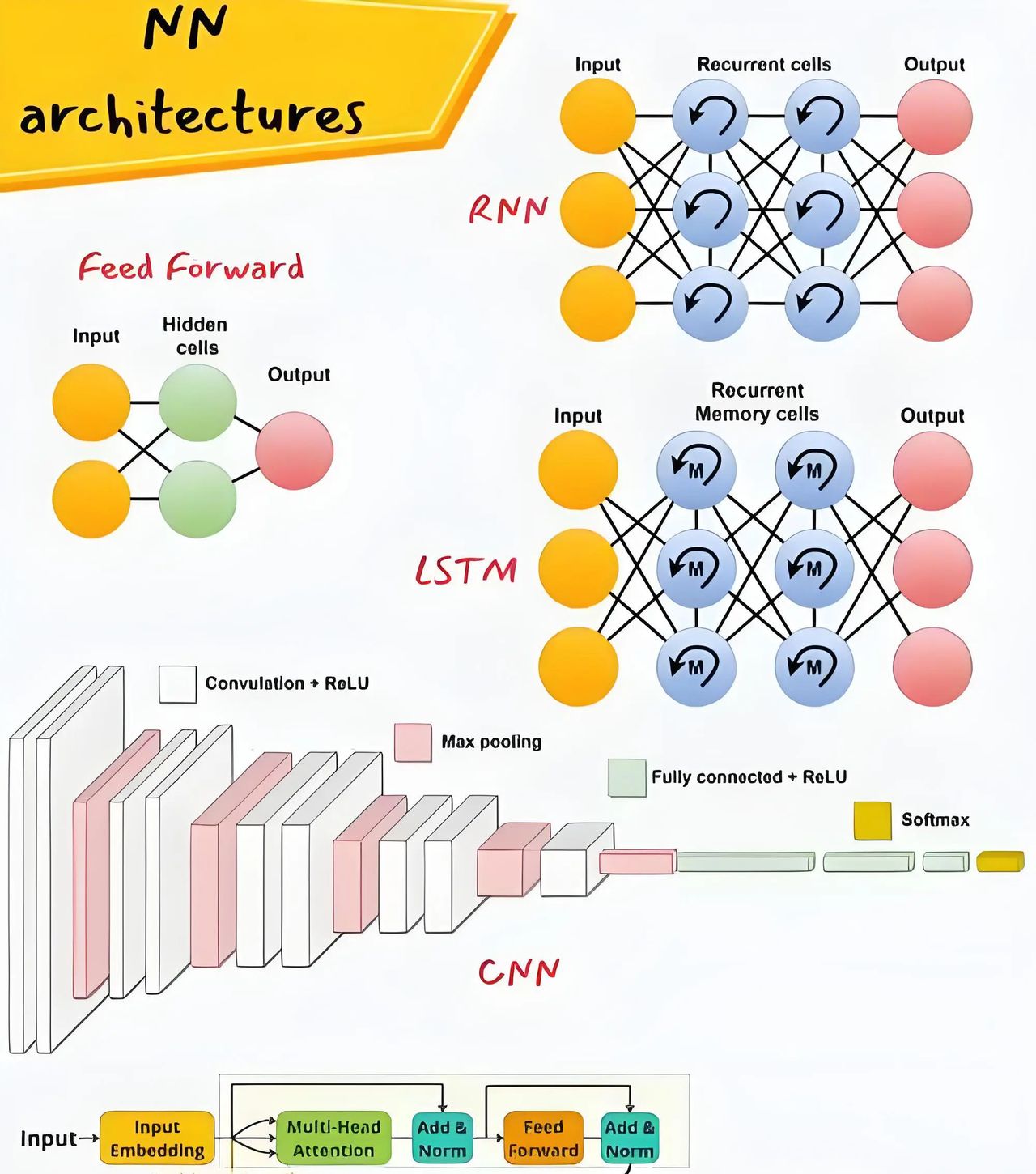

再者,文档处理已经不再是单纯的文本抓取,而是影响业务响应的核心能力。从财报数据整合到简历筛选,从合同条款解析到企业知识库构建,流程的每一步都能被自动化提速。技术上,实战中常见的架构是OCR负责把图片或扫描件变成可读文本,NLP负责实体识别和条款抽取,知识图谱负责把散落的信息连接成可检索的结构化知识。说白了,这三块缺一不可,协同好就能把“信息孤岛”变成“智能资产”。

具体实践中,有些库和方法值得注意。对Word文档,python-docx在处理.docx时轻便高效,对复杂格式可以思考商业库如Aspose.Words来补齐短板。处理Excel时,openpyxl在读取公式结果与内存友善方面表现不错,大文件下提议用read_only模式避免内存炸裂。PDF表格抽取上,Camelot在按表格边界抽取时准确度高,但对其依赖的Ghostscript要提前部署好;复杂表格用lattice模式往往效果更稳定。PPT文本可以用python-pptx快速抽取,若要做图片里的文字识别,结合Tesseract或更现代的OCR库会更可靠。别忘了对大文件分块读取和异常处理做工程化设计,这直接决定系统能否稳定运行。

在落地步骤上,我提议先做小规模试点。先确定一个高频、低样本类型的文档,列如常见合同模板或招聘简历,收集500份左右样本做标注,构建实体和条款标签,再用现成的NLP模型微调并写入规则补偿机制。接着把OCR、表格解析、文本抽取、实体链接按流水线串起来,最后留一层人工复核作为质量保险。运营上要定期统计听写错误率、抽取覆盖率和人工回退率,设立明确的KPI,如错误率从8%降到1%以内、处理时长缩短90%以上,这样才能把技术投入转化成可量化的业务收益。

我身边还有个HR团队的例子,他们用类似方法把简历初筛从人工两周缩到两天,节奏感立刻就上来了。说实话,最大的阻力往往不是技术,而是组织对自动化的信任不足和缺乏标注数据的耐心。做项目时要把可视化的中间结果给业务方看,让他们感受到自动化的可靠性,再逐步放大落地范围。

最后,趋势上我认为未来两年内,能把OCR、NLP和知识图谱工程化的团队,会在响应速度和合规能力上拉开明显差距。对于想起步的团队,务实的第一步是做一个闭环:选人、选文档、标注、训练、上线、复核,这套循环运行起来后,效率改善会呈指数级增长,而不是线性提升。

你们公司在文档处理上遇到过哪些真正让人头痛的细节?说说你们采取过的办法和踩过的坑,我很想听听真实的经验。

来源:Gartner2024报告;案例数据与实践参考自AI码力(感谢关注【AI码力】)

相关文章