前言

随着人工智能技术的快速发展,越来越多的开发者希望将AI集成到他们的工作流程中。然而,许多基于云的AI服务可能会带来隐私和数据安全风险、高昂的使用成本、对互联网连接的依赖以及有限的定制选项等问题。因此,在本地安装和运行DeepSeek可以让开发者利用AI的强大能力来提高开发效率,同时保护隐私。

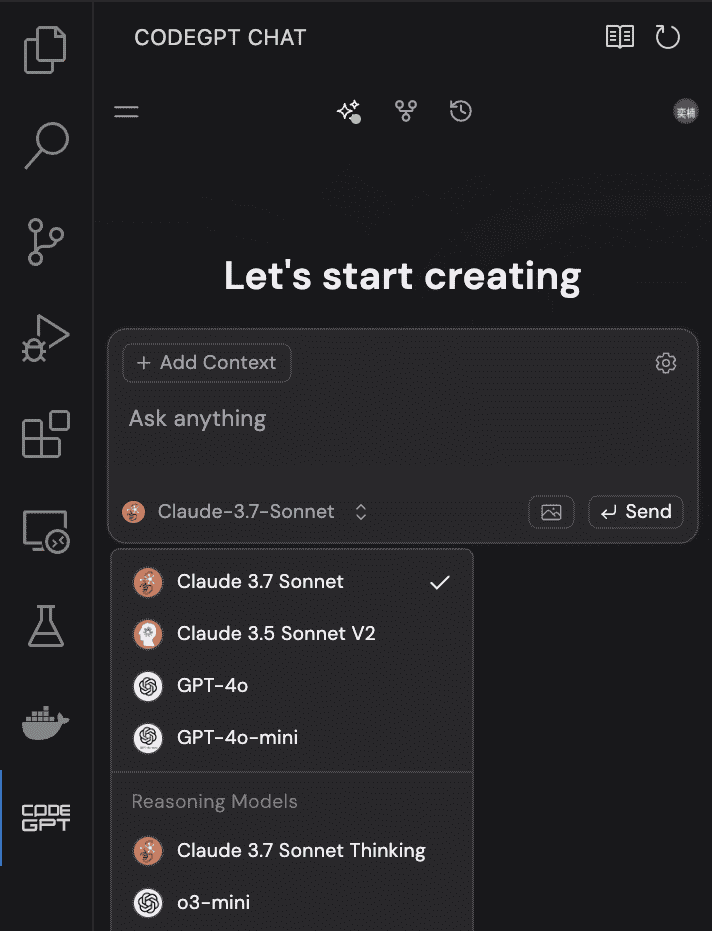

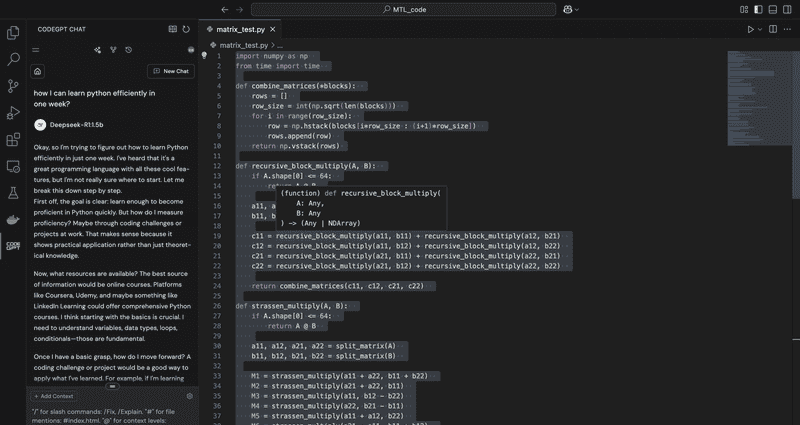

CodeGPT是一款基于GPT技术的AI工具,专为软件开发人员设计。它可以协助完成代码生成、优化、调试、文档创建等任务,并根据上下文提供精确的建议。通过将CodeGPT与DeepSeek集成,您可以在本地环境中实现高效的AI辅助开发,而无需依赖外部云服务。

以下是帮助您在本地安装和运行 DeepSeek 以及配置 CodeGPT 以增强您的开发工作流程的分步指南:

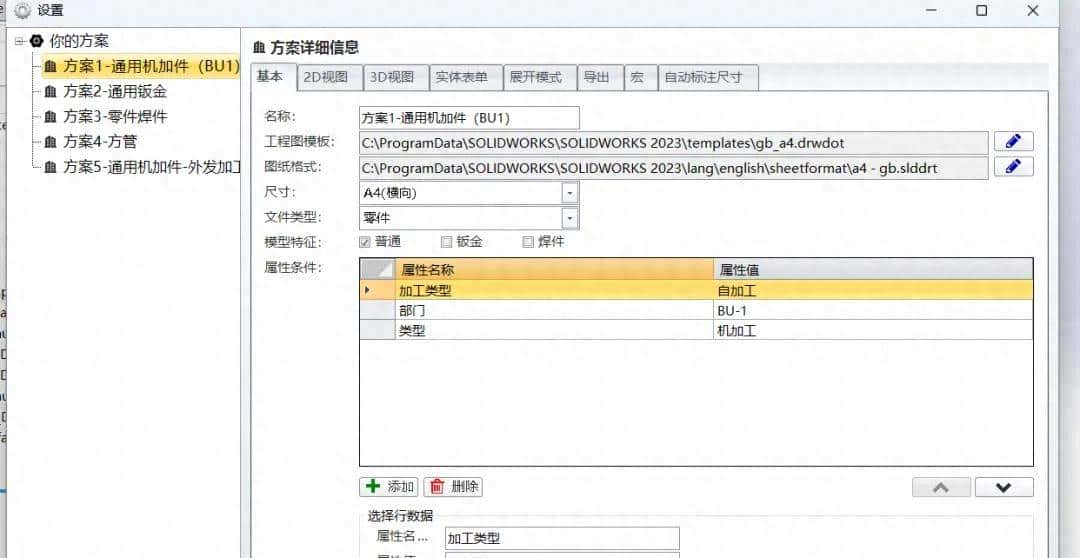

第 1 步:在 VSCode 中安装 Ollama 和 CodeGPT

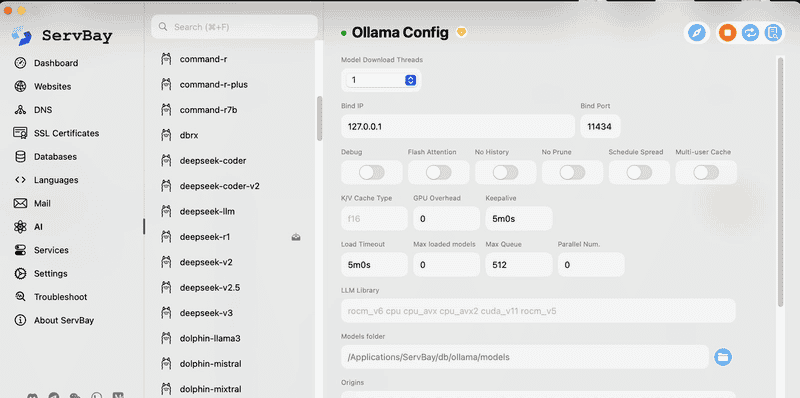

要在本地运行 DeepSeek,我们首先需要安装 Ollama,它允许我们在机器上运行大型语言模型 (LLM),以及 CodeGPT,这是一个集成这些模型以提供编码帮助的 VSCode 扩展。直接使用 Ollama 可能会因为必须使用命令行下载模型、下载速度不稳定等问题而带来不便。因此,我决定使用一种名为 ServBay 的新集成工具。

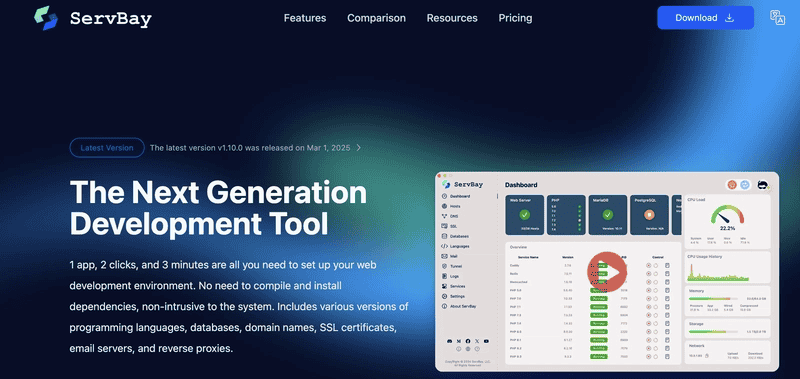

ServBay 简介

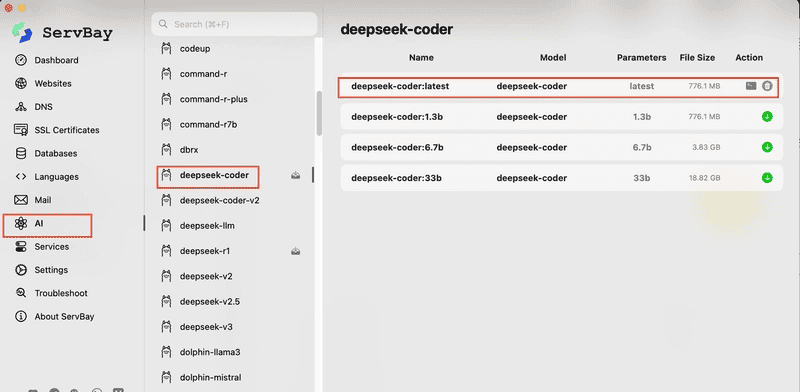

Ollama 是一个轻量级平台,使本地 LLM 的运行变得简单。另一方面,ServBay 是 Ollama 更用户友好的集成工具。它提供直观的图形界面和一键安装。ServBay是一个全面的图形化本地Web开发环境,专为Web开发人员、Python开发人员、AI开发人员和PHP开发人员设计,特别适合 macOS.It 集成了一套常用的Web开发工具和软件,包括Web服务器、数据库、开发语言、邮件服务器、队列服务等,旨在为开发人员提供便捷、高效的、 和统一的开发环境。以下是 ServBay 当前支持的工具和软件包列表。

下载 ServBay

访问官方网站: ServBay

下载适用于 macOS 的安装程序。目前,仅支持 macOS。

在安装过程中,您可以自动选择安装 Ollama 的选项。

进入界面后,可以直接安装DeepSeek。

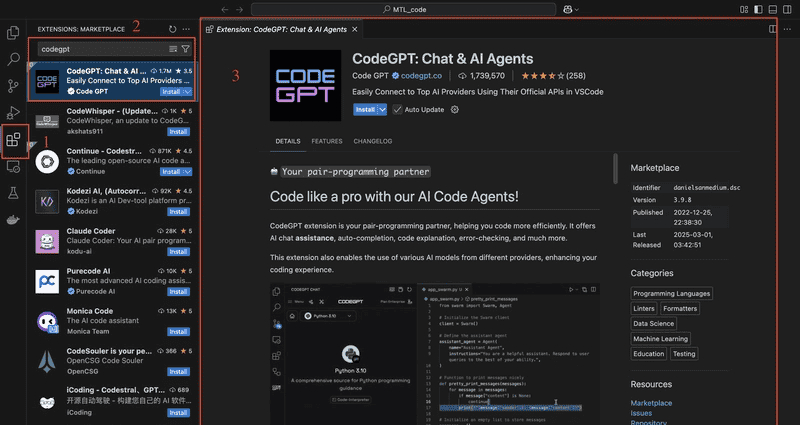

在 Visual Studio Code 中安装 CodeGPT

打开 VSCode 并导航到扩展市场(在 macOS 上,按 Ctrl + Shift + X 或 Cmd + Shift + X)。

搜索“CodeGPT”并单击安装。

或者,您可以在以下位置创建一个免费帐户:https://codegpt.co。

安装 Ollama 和 CodeGPT 后,您现在可以下载并配置 DeepSeek,以开始在本地使用 AI 进行编码。🚀

第 2 步:准备模型

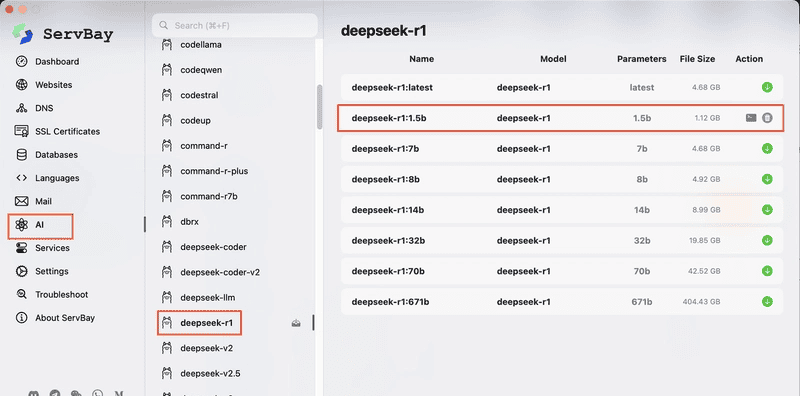

现在您已经成功安装了 ServBay 和 CodeGPT,是时候下载您将在本地使用的模型了。

聊天模型:deepseek-r1:1.5b,针对较小的环境进行了优化,能够在大多数计算机上流畅运行。

自动补全模型:deepseek-coder:1.3b,利用中间填充(FIM)技术。这允许它在您编写代码时提出智能自动完成建议,预测和建议函数或方法的中间部分,而不仅仅是开头或结尾。

下载聊天模型(deepseek-r1:1.5b)

按照界面中的步骤作,只需点击即可下载。

要开始使用聊天模型:

1、在 VSCode 中打开 CodeGPT。

2、导航到侧边栏中的本地 LLM 部分。

1、从可用选项中,选择 Ollama 作为本地 LLM 提供商。

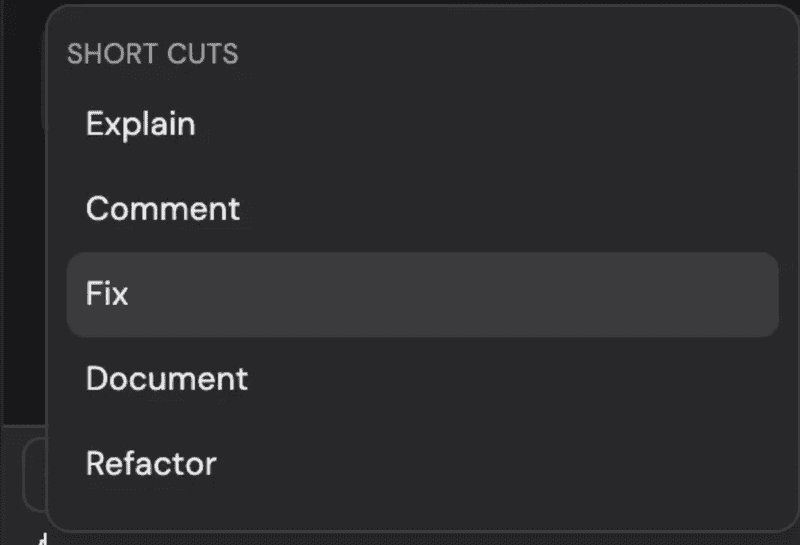

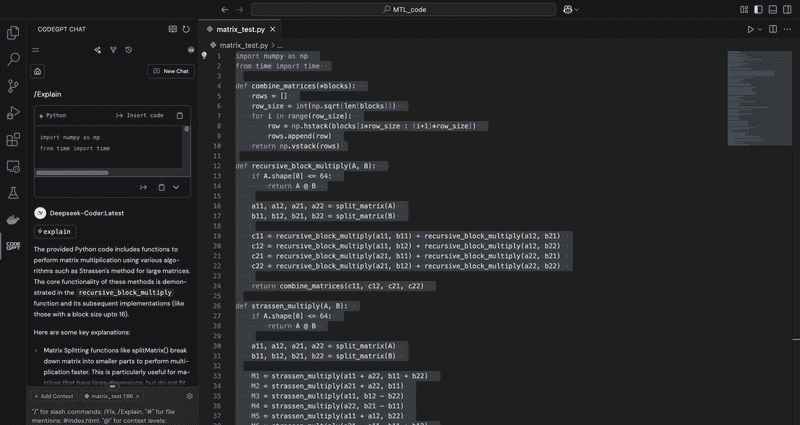

2、选择模型 deepseek-r1: 1.5b。 现在,您可以毫不费力地向模型查询有关代码的信息。只需突出显示编辑器中的任何代码,使用 # 符号向查询添加额外的文件,并利用强大的命令快捷方式,例如:

1、/fix — 用于修复代码中的错误或提出改进建议。

2、/refactor — 用于清理和改进代码的结构。

3、/explain — 获取任何代码片段的详细说明。 此聊天模型非常适合协助解决特定问题或接收有关代码的建议。

下载自动补全模型(deepseek-coder:最新)

从可用模型列表中,选择 deepseek-coder: latest。

选择

后,您可以开始编码。当您键入时,模型将开始提供实时代码建议,帮助您轻松完成函数、方法甚至整个代码块。

第 3 步:享受无缝、本地和私密的人工智能驱动编码

设置模型后,您现在可以充分享受这些强大工具的好处,而无需依赖外部 API。通过在计算机上本地运行所有内容,您可以确保完全隐私并控制编码环境。请放心,没有数据离开您的计算机,一切都保持安全和私密。 👏

如果您喜欢这篇文章👏 👏 👏,请鼓掌。

相关文章