简介

Redis

key-value

NoSQL

基于内存存储,读写性能高适合存储热点数据,例如访问量大的数据

Redis

I/O

IO

Redis

IO

I/O

用户空间和内核空间:

Linux

用户空间只能执行受限的命令(

Ring3

Ring0

Linux

IO

写数据时,要把用户缓冲数据拷贝到内核缓冲区,然后写入设备读数据时,要从设备读取数据到内核缓冲区,然后拷贝到用户缓冲区

阻塞

IO

- 阶段一: * 用户进程尝试读取数据(比如网卡数据) * 此时数据尚未到达,内核需要等待数据 * 此时用户进程也处于阻塞状态 - 阶段二: * 数据到达并拷贝到内核缓冲区,代表已就绪 * 将内核数据拷贝到用户缓冲区 * 拷贝过程中,用户进程依然阻塞等待 * 拷贝完成,用户进程解除阻塞,处理数据 - 在阻塞IO模型中,用户进程在两个阶段都是阻塞状态12345678910

非阻塞

IO

IO

recvfrom

- 阶段一: * 用户进程尝试读取数据(比如网卡数据)此时数据尚未到达,内核需要等待数据 * 返回异常给用户进程 * 用户进程拿到error后,再次尝试读取 * 循环往复,直到数据就绪 - 阶段二: * 将内核数据拷贝到用户缓冲区 * 拷贝过程中,用户进程依然阻塞等待 * 拷贝完成,用户进程解除阻塞,处理数据 - 非阻塞IO模型中,用户进程在第一个阶段是非阻塞,第二个阶段是阻塞状态。虽然是非阻塞,但性能并没有得到提高。而且忙等机制会导致CPU空转,CPU使用率暴增。12345678910

IO

Socket

Socket

CPU

- 阶段一: * 用户进程调用select,指定要监听的Socket集合内核,监听对应的多个socket * 任意一个或多个socket数据就绪则返回readable * 此过程中用户进程阻塞 - 阶段二: * 用户进程找到就绪的socket * 依次调用recvfrom读取数据 * 内核将数据拷贝到用户空间 * 用户进程处理数据 - IO多路复用是利用单个线程来同时监听多个Socket,并在某个Socket可读、可写时得到通知,从而避免无效的等待充分利用CPU资源。不过监听Socket的方式、通知的方式又有多种实现,常见的有:select、poll、epoll * select和poIl只会通知用户进程有Socket就绪,但不确定具体是哪个Socket,需要用户进程逐个遍历Socket来确认 * epoll则会在通知用户进程Socket就绪的同时,把已就绪的Socket写入用户空间123456789101112

Redis

Redis

IO

数据类型

Redis

key-value

key

String

value

字符串String

字符串(

String

Redis

key-value

不用

C

O(n)

Redis

SDS

SDS

len

SDS

O(1)

SDS

API

SDS

存储

若字符串对象保存整数值,且可以用

long

ptr

int

32

SDS

embstr

32

SDS

raw

常用命令

SET key value

key

可以用于在分布式的情况下存储

Session

GET key

key

SETEX key seconds value

key

key

seconds

SETNX key value

key

key

可以用该命令实现分布式锁,若

key

key

Lua

MSET key1 value1 key2 value2

String

MGET key1 key2 key3

key

String

value

INCR key

key

value

1

INCRBY key num

key

value

num

INCRBYFLOAT key num

和

SET: 如果

GET不存在则是新增,如果存在则是修改

key

哈希(Hash)

哈希(

hash

Java

HashMap

value

Redis

如果哈希类型的元素个数小于阈值(默认

512

64

在

中,压缩列表数据结构已经废弃,交由

Redis 7.0数据结构来实现

listpack

常用命令

HSET key field value

key

field

value

HGET key field

HDEL key field

HKEYS key

field

HVALS key

value

HMSET key field1 value1 field2 value2

hash

key

field

HMGET key field1 field2

hash

key

field

HGETALL key

key

hash

field

value

HINCRBY key field num

hash

filed

num

HSETNX key field value

hash

field

field

链表(List)

链表(

list

Java

LinkedList

底层实现是双向链表或压缩列表

如果列表的元素个数小于阈值(默认

512

64

在

版本后,

Redis 3.2数据类型底层数据结构只由

List实现了,替代了双向链表和压缩列表。

quicklist

常用命令

LPUSH key value1 [value2]

RPUSH key value1 [value2]

LRANGE key start stop

RPOP key

LPOP key

null

LLEN key

BLPOP和BRPOP

LPOP

RPOP

可以用于实现消息队列,其满足以下几点

满足消息保序需求重复消息:通过设置消息

ID

ID

BRPOPLPUSH

List

Redis

List

List

不支持多个消费者消费同一条消息,一旦消费者拉取一条消息后,这条消息就从

List中删除

List

集合(Set)

集合(

set

Java

Hashset

如果集合中的元素都是整数且元素个数小于 阈值(默认

512

Redis

Set

Set

常用命令

SADD key member1[member2]

可以用于点赞等唯一操作

SMEMBERS key

SCARD key

SINTER key1 [key2]

可以用于获取沟通关注等

SUNION key1 [key2]

SDIFF key1 [key2]

key1

key2

SREM key member1 [member2]

SISMEMBER key member

set

有序集合(Zset)

有序集合(

sorted set/zset

score

set

如果有序集合的元素个数小于

128

64

Redis

Zset

在 Redis 7.0 中,压缩列表数据结构已经废弃了,交由

数据结构来实现

listpack

常用命令

ZADD key score1 member1 [score2 member2]

ZREM key member [member ...]

ZRANGE key start stop [WITHSCORES]

ZINCRBY key increment member

increment

ZSCORE key member

sorted set

score

ZRANK key member

sorted set

ZCARD key

sorted set

ZCOUNT key min max

score

ZDIFF.ZINTER.ZUNION

所有的排名默认都是升序,如果要降序则在命令的Z后面添加REV即可

位图(bitMap)

位图是利用数据中每一个bit位作为一种状态映射,可以利用极小的空间来实现大量数据的表示。

例如,可以用位图来记录用户一个月的签到情况。

Redis

String

BitMap

512M

bit

2^32

bit

String

Redis

Bitmap

bit

常用命令

SETBIT key offset value

offset

0

1

GETBIT key offset

offset

bit

BITCOUNT key start end

BitMap

1

bit

BITOP

BitMap

BITPOS

bit

0

1

BITFIELD

BitMap

bit

offset

BITFIELD_RO

BitMap

bit

GEO地理数据结构

GEO

Sorted Set

GEO

GeoHash

Sorted Set

Sorted Set

常用命令

GEOADD

longitude

latitude

member

GEODIST

GEOHASH

member

hash

GEOPOS

member

GEORADIUS

member

6.

GEOSEARCH

member

6.2

GEOSEARCHSTORE

GEOSEARCH

key

Stream

Redis

ID

ack

常用命令

XADD

ID

XLEN

XREAD

ID

XDEL

ID

DEL

Stream

XRANGE

XREADGROUP

XPENDING

XACK

XPENDING

XACK

层级储存

Redis

MySQL

Table

Redis

key

:

一旦我们向

Redis

Redis

Redis

Redis缓存

缓存模型与思想

标准的操作方式就是查询数据库之前先查询缓存,如果缓存数据存在,则直接从缓存中返回,如果缓存数据不存在,再查询数据库,然后将数据存入

Redis

缓存淘汰

当

Redis

Redis

key

Redis

noeviction

key

volatile-ttl

TTL

key

key

TTL

TTL

allkeys-random

key

volatile-random

TTL

key

allkeys-lru

key

LRU

volatile-lru

TTL

key

LRU

allkeys-lfu

key

LFU

volatile-lfu

TTL

key

LFU

优先使用

策略。充分利用

alkeys-lru算法的优势,把最近最常访问的数据留在缓存中。如果业务有明显的冷热数据区分,建议使用如果业务中数据访问频率差别不大,没有明显冷热数据区分,建议使用

LRU,随机选择淘汰如果业务中有置顶的需求,可以使用

alkeys-random策略,同时置顶数据不设置过期时间,这些数据就一直不被删除,会淘汰其他设置过期时间的数据。如果业务中有短时高频访问的数据,可以使用

volatile-lru或

allkeys-lfu策略

volatile-lfu

先进先出

FIFO

LRU

key

key

LFU

缓存更新策略(双写一致性)

由于缓存的数据源来自于数据库,而数据库的数据是会发生变化的,因此,如果当数据库中数据发生变化,而缓存却没有同步,此时就会有一致性问题存在

双写一致性:当修改了数据库的数据也要同时更新缓存的数据,缓存和数据库的数据要保持一致

删除缓存还是更新缓存?

更新数据库时让缓存失效,查询时再更新缓存

先操作缓存还是先操作数据库?

先操作缓存,再操作数据库,会有脏数据的情况,缓存和数据库不一致

- 先操作数据库,再删除缓存,也会有脏数据的情况,缓存和数据库不一致

1

- 因此采用延时双删策略,待数据库修改完成后,延时一段时间,再删除一次缓存

1

如何保证缓存与数据库的双写一致

采用分布式锁的方式,每一个线程获取锁来操作完整个缓存的更新,但性能低下。可以通过读写锁来提高性能,只适用于强一致的业务采用异步通知保证数据的最终一致性,但需要保证

MQ

缓存过期删除

惰性删除:设置该

key

key

key

优点:对

友好,只会在使用该

CPU时才会进行过期检查,对于很多用不到的

key不用浪费时间进行检查

key缺点:对内存不友好,如果一个

已经过期,但是一直没有使用,那么该

key就会一直存在内存中

key

定期删除:每隔一段时间,对一些

key

key

key

key

SLOW

10hz

25ms

redis.conf

FAST

2ms

1ms

优点:可以通过限制删除操作执行的时长和频率来减少删除操作对 CPU 的影响。另外定期删除,也能有效释放过期键占用的内存。

缺点:难以确定删除操作执行的时长和频率。

缓存穿透

缓存穿透是指客户端请求的数据在缓存中和数据库中都不存在,这样缓存永远不会生效,这些请求都会打到数据库。因此恶意请求可以通过请求不存在的数据,一直请求到数据库进行攻击。

缓存空对象

即使数据库返回空对象,仍将空对象缓存至

Redis

Redis

- <font>优点:实现简单,维护方便</font>

- <font>缺点:</font>

* <font>额外的内存消耗</font>

* <font>可能造成短期的不一致</font>

1234布隆过滤

布隆过滤器其实采用的是哈希思想来解决这个问题,通过一个庞大的二进制数组,走哈希思想去判断当前这个要查询的这个数据是否存在,若布隆过滤器判断存在,则放行,这个请求会去访问

Redis

Redis

Redis

bitmap

bit

0

1

1

数组越小误判率就越大,数组越大误判率就越小,但同时带来的更多的内存消耗

缓存击穿

缓存击穿问题也叫热点

Key

key

假设线程

1

1

1

2

3

4

互斥锁

因为锁能实现互斥性。假设线程过来,只能单一来访问数据库,从而避免对于数据库访问压力过大,但这也会影响查询的性能,因为此时会让查询性能从并行变成了串行,我们可以采用

tryLock

double check

强一致性,但性能差

代码

利用

Redis

setnx

Redis

key

1

stringRedisTemplate

true

key

0

stringRedisTemplate

false

true

false

private boolean tryLock(String key) {

Boolean flag = stringRedisTemplate.opsForValue().setIfAbsent(key, "1", 10, TimeUnit.SECONDS);

return BooleanUtil.isTrue(flag);

}

private void unlock(String key) {

stringRedisTemplate.delete(key);

}

java

运行12345678// 获取锁 String lockKey = "lock:shop:" + id; Shop shop = null; try { boolean isLock = tryLock(lockKey); // 判断否获取成功 if(!isLock){ //4.3 失败,则休眠重试 Thread.sleep(50); return queryWithMutex(id); } // 成功,根据id查询数据库 shop = getById(id); // 不存在,返回错误 if(shop == null){ // 将空值写入redis stringRedisTemplate.opsForValue().set(key,"",CACHE_NULL_TTL,TimeUnit.MINUTES); // 返回错误信息 return null; } // 写入redis stringRedisTemplate.opsForValue().set(key,JSONUtil.toJsonStr(shop),CACHE_NULL_TTL,TimeUnit.MINUTES); }catch (Exception e){ throw new RuntimeException(e); } finally { //7.释放互斥锁 unlock(lockKey); }java 运行123456789101112131415161718192021222324252627282930

逻辑过期

之所以会出现缓存击穿,原因是对

key

redis

value

value

巧妙在于,异步的构建缓存,缺点在于在构建完缓存之前,返回的都是脏数据。

高可用,性能优,但会出现脏数据

缓存雪崩

缓存雪崩指在同一时段大量的缓存

key

Redis

给不同的

key

TTL

Redis

Redis持久化

AOF持久化

AOF日志

AOF

Append Only File

Redis

AOF

Redis

AOF

可以避免额外的检查开销,不用检查语法,因为命令执行成功后才会写入到

AOF

AOF

写回策略

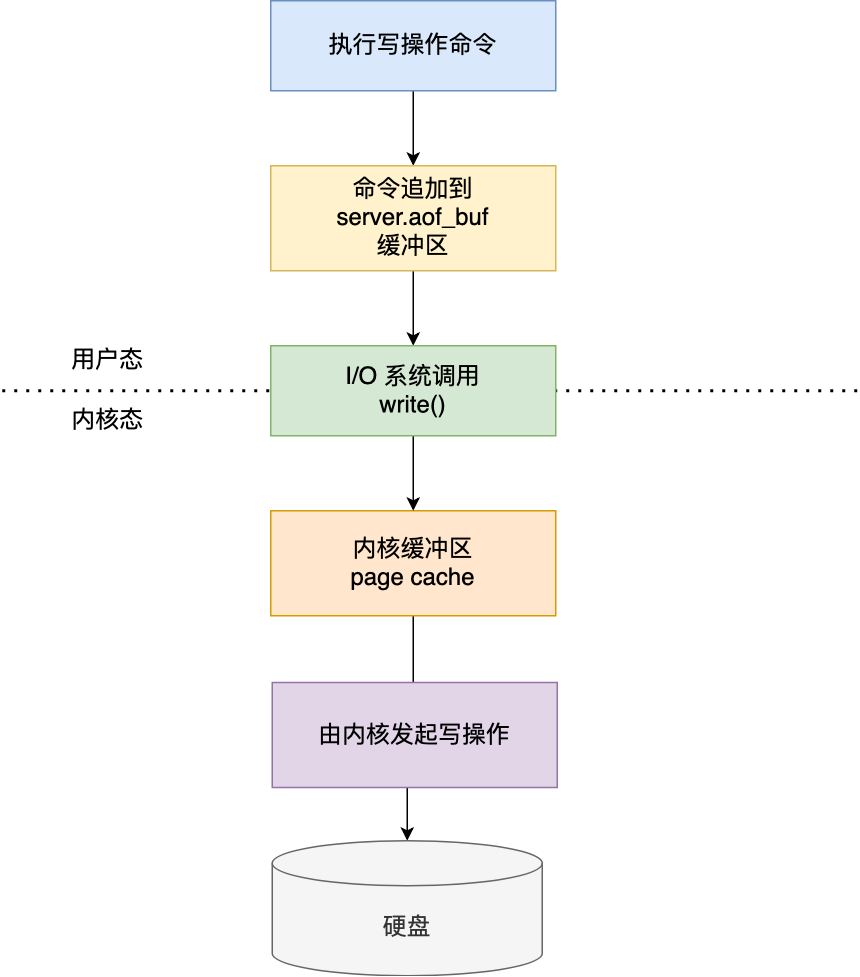

Redis

server.aof_buf

write()

aof_buf

AOF

page cache

redis.conf

appendfsync

Always

AOF

Everysec

AOF

No

AOF

重写机制

AOF

AOF

Redis

AOF

AOF

AOF

AOF

AOF

AOF

AOF

AOF

AOF

后台重写

Redis

AOF

bgrewriteaof

子进程进行

AOF

在子进程重写

AOF

key-value

key-value

Redis

AOF

bgrewriteaof

AOF

Redis

AOF

AOF

子进程完成重写工作后,会向主进程发送一条信号,主进程收到该信号后,会调用一个信号处理函数

将

AOF

AOF

AOF

AOF

RDB持久化

RDB

Redis Database Backup file

Redis

Redis

Redis

RDB

RDB

RDB

执行

save

save

RDB

bgsave

RDB

bgsave

fork

fork

RDB

Redis

Redis

save

RDB

RDB

Redis

RDB

redis.conf

写时复制(Copy-On-Write,COW)

在执行

bgsave

RDB

bgsave

fork()

AOF

当主线程(父进程)要修改共享数据里的某一块数据(比如键值对

A

A

A

bgsave

A

RDB

RDB

RBD和AOF合体使用

Redis4.0

AOF

RBD

AOF

在混合持久化下,在

AOF

fork

RDB

AOF

AOF

AOF

RDB

AOF

AOF

AOF

AOF

RDB

AOF

Redis

AOF

Redis分布式

主从复制

主从复制(高并发):单点

Redis

Redis

所有的数据修改只在主服务器上进行,然后将最新的数据同步给从服务器,以使得数据一致

第一次同步-主从全量同步

Replication ld

replid

id

master

replid

slave

master

replid

offset

repl_baklog

slave

offset

slave

offset

master

offset

slave

master

1. 从节点执行replicaof命令,发生psync命令请求主节点同步数据(replication id、offset) 2. 主节点判断是否是第一次请求,第一次就与从节点同步版本信息(replication id和offset) 3. 主节点执行bgsave(不阻塞主线程),生成RDB文件后,发送从节点执行,从节点收到RDB文件后,清空当前数据,载入RDB文件 + 但是在生成RDB文件时新增的数据不会同步,因此主服务器在下面这三个时间间隙中将收到的写操作命令,写入到replication buffer缓冲区里 - 主服务器生成RDB文件期间 - 主服务器发送RDB文件给从服务器期间 - 从服务器加载RDB文件期间 4. 把生成之后的命令日志文件发送给从节点进行同步 5. 最后,主服务器将replication buffer缓冲区里所记录的写操作命令发送给从服务器,从服务器执行后,主从服务器数据同步成功123456789

命令传播

主从服务器完成第一次同步后,双方就会维护一个

TCP

TCP

主从增量同步(

slave

1. 从节点请求主节点同步数据,主节点判断不是第一次请求,不是就获取从节点的offset值

2. 主节点从命令日志中获取</font>`<font>offset</font>`<font>值之后的数据,发送给从节点进行数据同步</font>

1. repl_backlog_buffer,是一个环形缓冲区,用于主从服务器断连后,从中找到差异的数据(如果 offset 已经“掉出窗口”(被环形缓冲区覆盖了),主库无法做部分重同步,此时就会做全量同步)

2. replication offset,标记上面那个缓冲区的同步进度,主从服务器都有各自的偏移量,主服务器使用master_repl_offset记录写到的位置,从服务器使用slave_repl_offset记录读到的位置。

1234在主服务器进行命令传播时,不仅将写命令发送给从服务器,还将写命令写入

repl_backlog_buffer

哨兵

在主从架构中,由于主从模式是读写分离,若主节点(

master

slave

Redis

Sentinel

监控:

Sentinel

master

slave

Sentinel

1

ping

主观下线:如果某

sentinel

quorum

sentinel

quorum

Sentinel

自动故障恢复:如果

master

Sentinel

slave

master

master

首先判断主与从节点断开时间长短,如超过指定值就排除该从节点(此节点不会作为主节点)然后判断从节点的

slave-priority

slave-prority

slave

offset

slave

id

脑裂问题:主节点与从节点以及哨兵在不同的网络分区下,哨兵与主节点的网络连接断开,此时,哨兵就会在从节点中选取一个主节点。但此时客户端与之前的主节点还连接着,往内写入数据,却不会同步到从结点中。之后网络恢复,此时之前主节点和断开的从节点连接在一起,但此时有两个主节点,而之前的主节点会被降级回从节点,之前写入的数据会被刷掉,此时数据丢失

解决方案:

redis

min-replicas-to-write 1

salve

1

min-replicas-max-lag 5

5

通知:

Sentinel

Redis

Redis

集群

集群中有多个

master

master

master

slave

master

ping

数据读写:

Redis

Redis

16384

key

CRC16

16384

Hash

key

hash

Redis 允许对 key 的一部分进行哈希计算(称为 hash tag)。

写法是把 key 的一部分放在大括号

{}

- user:{1001}:name

- user:{1001}:age

12这样 CRC16 时,只会对

{1001}

redis使用

redis安装与启动

安装

安装后重点文件说明:

/usr/local/redis-4.0.0/src/redis-server

Redis

/usr/local/redis-4.0.0/src/redis-cli

Redis

/usr/local/redis-4.0.0/redis.conf

Redis

启动

**服务端启动命令**

redis-server.exe redis.windows.conf

shell

1

Redis

6379

Ctrl + C

Redis

Redis

客户端连接命令

redis-cli.exe

shell

1通过

redis-cli.exe

redis

-h ip地址

-p 端口号

-a 密码

修改

Redis

设置

Redis

redis.windows.conf

requirepass 123456

shell

1修改密码后需要重启

服务才能生效

Redis

Jedis

导入依赖

<dependency>

<groupId>org.junit.jupiter</groupId>

<artifactId>junit-jupiter-api</artifactId>

<version>5.10.2</version>

<scope>test</scope>

</dependency>

xml

123456线程池建立连接

public class JedisConnectionFactory{ private static final JedisPool jedisPool; static { JedisPoolConfig jedisPoolconfig = new JedisPoolconfig(); // 最大连接 jedisPoolConfig.setMaxTotal(8); // 最大空闲连接 jedisPoolConfig.setMaxIdle(8); // 最小空闲连接 jedisPoolconfig.setMinIdle(0); // 设置最长等待时间,ms jedisPoolConfig.setMaxWaitMillis(200); jedisPool = new JedisPool(jedisPoolconfig,"192.168.150.101",6379,1000,“123321); } // 获取Jedis对象 public static Jedis getJedis() { return jedisPool.getResource(); } }java 运行1234567891011121314151617181920

使用Jedis

String result = jedis.set("hello", "world");

String name = jedis.get("hello");

java

运行12`SpringDataRedis`

配置

`maven`坐标

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

xml

1234配置`Redis`数据源

spring: redis: host: 192.168.150.101 port: 6379 password: 123321 lettuce: pool: max-active: 8 #最大连接 max-idle: 8 #最大空闲连接 min-idle: 0 #最小空闲连接 max-wait: 100ms #连接等待时间yaml1234567891011

编写配置类

@Configuration @slf4j public class RedisConfiguration{ @Bean public RedisTemplate redisTemplate(RedisconnectionFactory redisConnectionfactory) { // 创建RedisTemplate对象 RedisTemplate<String, Object> template = new RedisTemplate<>(); // 设置连接工厂 template.setConnectionFactory(connectionFactory); // 创建JSON序列化工具 GenericJackson2JsonRedisSerializer jsonRedisSerializer = new GenericJackson2JsonRedisSerializer(); // 设置Key的序列化 template.setKeySerializer(RedisSerializer.string()); template.setHashKeySerializer(RedisSerializer.string()); // 设置Value的序列化 template.setValueSerializer(jsonRedisSerializer); template.setHashValueSerializer(jsonRedisSerializer); // 返回 return template; } }java 运行12345678910111213141516171819202122

`Java`中操作`Redis`

`String`类型

public void testString(){ //SET key value 设置指定key的值 redisTemplate.opsForValue().set("city","北京"); //GET key 获取指定key的值 String city =(String) redisTemplate.opsForValue().get("city"); //SETEX key seconds value 设置指定key的值,并将key的过期时间设为seconds秒或分钟 redisTemplate.opsForValue().set("code", "1234", 3, TimeUnit.MINUTES); //SETNX key value 只有在key不存在时设置key的值 redisTemplate.opsForValue().setIfAbsent("city","北京"); }java 运行12345678910111213

`Hash`类型

public void testHash(){ HashOperations hashOperations = redisTemplate.opsForHash(); //HSET key field value 将哈希表 key 中的字段 field 的值设为 value hashOperations.put("100", "name","tom"); hashOperations.put("100", "age","20"); //HGET key field 获取存储在哈希表中指定字段的值 String name = (String) hashOperations.get("100", "name"); //HKEYS key 获取哈希表中所有字段 Set keys = hashOperations.keys("100"); //HVALS key 获取哈希表中所有值 List values = hashOperations.values("100"); //HDEL key field 删除存储在哈希表中的指定字段 hashOperations.delete("100","age"); }java 运行1234567891011121314151617181920

`List`类型

public void testList(){ //lpush lrane rpop llen ListOperations listOperations =redisTemplate.opsForList(); //LPUSH key value1 [value2] 将一个或多个值插入到列表头部 listOperations.leftPushAll("mylist","a","b","c"); listOperations.leftPush("mylist","d"); //LRANGE key start stop 获取列表指定范围内的元素 List mylist= listOperations.range("mylist",0,-1); //RPOP key 移除并获取列表最后一个元素 listOperations.rightPop("mylist"); //LLEN key 获取列表长度 Long size = listOperations.size("mylist"); }java 运行123456789101112131415161718

`Set`类型

public void testset(){ SetOperations setOperations = redisTemplate.opsForset(); //SADD key member1[member2] 向集合添加一个或多个成员 setOperations.add("set1","a","b","c","d"); setOperations.add("set2","a","b","x","y"); //SMEMBERS key 返回集合中的所有成员 Set members =setOperations.members("set1"); //SCARD key 获取集合的成员数 Long size = setOperations.size("set1"); //SINTER key1 [key2]. 返回给定所有集合的交集 Set intersect = setOperations.intersect("set1","set2"); //SUNION key1 [key2]。 返回所有给定集合的并集公 Set union = setOperations.union("set1","set2"); //SREM key member1 [member2] 删除集合中一个或多个成员 setOperations.remove("set1","a","b"); }java 运行1234567891011121314151617181920212223

有序集类型

public void testzset(){ ZSetOperations zSetOperations =redisTemplate.opsForZset(); //ZADD key score1 member1 [score2 member2] 向有序集合添加一个或多个成员 zSetOperations.add("zset1","a",10); zSetOperations.add("zset1","b",12); zSetOperations.add("zset1","c",9); //ZRANGE key start stop [WITHSCORES] 通过索引区间返回有序集合中指定区间内的成员 Set zset1 = zSetOperations.range("zset1",0,-1); //ZINCRBY key increment member 有序集合中对指定成员分数加上增加increment zSetOperations.incrementscore("zset1","c",10); //ZREM key member [member ...] 移除有序集合中的一个或多个成员 zSetOperations.remove("zset1","a","b"); }java 运行123456789101112131415161718

通用命令

public void testCommon(){ //KEYS pattern 查找所有符合给定模式( pattern)的 key Set keys = redisTemplate.keys("*");System.out.println(keys); //EXISTS key 检查给定 key 是否存在 Boolean name =redisTemplate.hasKey("name"); Boolean set1=redisTemplate.hasKey("set1"); //TYPE key 返回 key 所储存的值的类型 for(object key : keys){ forDataType type = redisTemplate.type(key); } //DEL key 该命令用于在 key 存在时删除 key redisTemplate.delete( key:"mylist"); }java 运行1234567891011121314151617

通用功能

全局`ID`生成

一种在分布式系统下用来生成全局唯一

ID

通过

Redis

ID

为了增加

ID

Redis

符号位:

1bit

0

31bit

69

32bit

2^32

ID

@Component public class RedisIdWorker { /** * 开始时间戳 */ private static final long BEGIN_TIMESTAMP = 1640995200L; /** * 序列号的位数 */ private static final int COUNT_BITS = 32; private StringRedisTemplate stringRedisTemplate; public RedisIdWorker(StringRedisTemplate stringRedisTemplate) { this.stringRedisTemplate = stringRedisTemplate; } public long nextId(String keyPrefix) { // 1.生成时间戳 LocalDateTime now = LocalDateTime.now(); long nowSecond = now.toEpochSecond(ZoneOffset.UTC); long timestamp = nowSecond - BEGIN_TIMESTAMP; // 2.生成序列号 // 2.1.获取当前日期,精确到天 String date = now.format(DateTimeFormatter.ofPattern("yyyy:MM:dd")); // 2.2.自增长 long count = stringRedisTemplate.opsForValue().increment("icr:" + keyPrefix + ":" + date); // 3.拼接并返回 return timestamp << COUNT_BITS | count; } }java 运行123456789101112131415161718192021222324252627282930313233

线程锁

多线程安全问题,可以用两种锁来解决

悲观锁:

悲观锁可以实现对于数据的串行化执行,比如

syn

lock

乐观锁:

有一个版本号,每次操作数据会对版本号

+1

1

1

也可以直接用库存量作为版本号

boolean success = seckillVoucherService.update()

.setSql("stock = stock -1") //set stock = stock -1

.eq("voucher_id", voucherId).eq("stock",voucher.getStock()).update();

//where id = ? and stock = ?

java

运行1234分布式锁

Redis获取锁

互斥:确保只能有一个线程获取锁,利用

SETNX

true

false

SET lock thread

expire lock 10 // 设置超时时间 避免未释放锁就宕机情况

//合为一条 NX是互斥 EX是设置超时时间

set lock thread NX EX 10

// 释放锁

DEL key

shell

12345678代码实现

public boolean tryLock(long timeoutSec) {

// 获取线程标示

String threadId = ID_PREFIX + Thread.currentThread().getId();

// 获取锁

Boolean success = stringRedisTemplate.opsForValue()

.setIfAbsent(KEY_PREFIX + name, threadId, timeoutSec, TimeUnit.SECONDS);

return Boolean.TRUE.equals(success);

}

java

运行12345678Redis释放锁

手动释放超时释放:获取锁时添加一个时间

DEL lock

shell

1但是在释放锁的情况下,有可能出现误删情况

持有锁的线程在锁的内部出现了阻塞,导致他的锁自动释放,这时其他线程,线程

2

2

1

1

2

解决方法:在获取锁时存入线程标示(可以用UUID表示) 在释放锁时先获取锁中的线程标示,判断是否与当前线程标示一致

public void unlock() { // 获取线程标示 String threadId = ID_PREFIX + Thread.currentThread().getId(); // 获取锁中的标示 String id = stringRedisTemplate.opsForValue().get(KEY_PREFIX + name); // 判断标示是否一致 if(threadId.equals(id)) { // 释放锁 stringRedisTemplate.delete(KEY_PREFIX + name); } }java 运行1234567891011

但是由于线程的拿锁,比锁和删锁操作并不是原子性操作,仍然会有失败可能。

Redis

Lua

Redis

redis.call('命令名称', 'key', '其它参数', ...) # 执行 set name jack redis.call('set', 'name', 'jack') # 先执行 set name jack redis.call('set', 'name', 'Rose') # 再执行 get name local name = redis.call('get', 'name') # 返回 return namelua 运行1234567891011

-- 这里的 KEYS[1] 就是锁的key,这里的ARGV[1] 就是当前线程标示

-- 获取锁中的标示,判断是否与当前线程标示一致

if (redis.call('GET', KEYS[1]) == ARGV[1]) then

-- 一致,则删除锁

return redis.call('DEL', KEYS[1])

end

-- 不一致,则直接返回

return 0

lua

运行12345678private static final DefaultRedisScript<Long> UNLOCK_SCRIPT; static { UNLOCK_SCRIPT = new DefaultRedisScript<>(); UNLOCK_SCRIPT.setLocation(new ClassPathResource("unlock.lua")); UNLOCK_SCRIPT.setResultType(Long.class); } public void unlock() { // 调用lua脚本 stringRedisTemplate.execute( UNLOCK_SCRIPT, Collections.singletonList(KEY_PREFIX + name), ID_PREFIX + Thread.currentThread().getId()); }java 运行1234567891011121314

分布式锁-Redission

基于

setnx

不可重入问题:重入问题是指获得锁的线程可以再次进入到获取相同的锁的代码块中,可重入锁的意义在于防止死锁,比如

HashTable

synchronized

synchronized

Lock

Redis

Redission

Redission

Lua

Redission

Watch dog

Redission

Redission

利用

Hash

id

为了保证主从一致性,可以采用

RedLock

redis

redis

(n/2+1)

Zookeeper

引入依赖

<dependency>

<groupId>org.redisson</groupId>

<artifactId>redisson</artifactId>

<version>3.13.6</version>

</dependency>

xml

12345配置Redisson客户端

@Configuration public class RedissonConfig { @Bean public RedissonClient redissonClient(){ // 配置 Config config = new Config(); // 添加redis地址,这里添加单点地址,也可以使用config.useClusterServers()添加集群地址 config.useSingleServer().setAddress("redis://192.168.150.101:6379") .setPassword("123321"); // 创建RedissonClient对象 return Redisson.create(config); } }java 运行123456789101112131415

使用Redission的分布式锁

消息x@Resource private RedissionClient redissonClient; @Test void testRedisson() throws Exception{ //获取锁(可重入),指定锁的名称 RLock lock = redissonClient.getLock("anyLock"); //尝试获取锁,参数分别是:获取锁的最大等待时间(期间会重试),锁自动释放时间,时间单位 boolean isLock = lock.tryLock(10,10,TimeUnit.SECONDS); //判断获取锁成功 if(isLock){ try{ System.out.println("执行业务"); }finally{ //释放锁 lock.unlock(); } } }java 运行12345678910111213141516171819

`Redis`消息队列

存放消息的队列。最简单的消息队列模型包括3个角色:

消息队列:存储和管理消息,也被称为消息代理(

Message Broker

基于List实现消息队列

Redis

list

通过

BRPOP

BLPOP

优点:

利用

Redis

JVM

Redis

缺点:

无法避免消息丢失只支持单消费者

基于PubSub的消息队列

消费者可以订阅一个或多个`channel`,生产者向对应`channel`发送消息后,所有订阅者都能收到相关消息。

SUBSCRIBE channel [channel]

PUBLISH channel msg

PSUBSCRIBE pattern[pattern]

pattern

h?1lo** subscribes to **hello**, **hallo** and **hxllo**

**h*llo** subscribes to **hllo** and **heeeello**

**h[ae]llo** subscribes to **hello** and **hallo**, but not hillo

优点:

采用发布订阅模型,支持多生产、多消费

缺点:

不支持数据持久化无法避免消息丢失消息堆积有上限,超出时数据丢失

基于Stream的消息队列

`Stream`是`Redis 5.0`引入的一种新数据类型,可以实现一个功能非常完善的消息队列。

# 发送消息 XADD key [NOMKSTREAM][MAXLEN|MINID [=|~] threshold [LIMIT count]] *|ID field vlaue [field vlaue] # [NOMKSTREAM]: 如果队列不存在 是否自动创建队列 默认是自动创建 # [MAXLEN|MINID [=|~] threshold [LIMIT count]]: 设置消息队列的最大消息数量 # *|ID:消息的唯一id,*代表由Redis自动生成。格式是"时间-递增数字",例如"1644804662707-0" # field vlaue:发送到队列中的消息,称为Entry。格式就是多个key-value键值对 # 创建名为 users 的队列,并向其中发送一个消息,内容是:{name=jack,age=21},并且使用Redis自动生成ID XADD users * name jack age 21 # 读取消息 XREAD [COUNT count][BLOCK milliseconds] STREAMS key [key ...] ID [ID ...] # [COUNT count]: 每次读取消息的最大数量 # [BLOCK milliseconds]: 当没有消息的时候 是否阻塞 阻塞时长 # STREAMS key:要从哪个队列读取消息,key是队列名 # ID: 起始id,只返回大于该ID的消息 0:代表从第一个消息开始 $:代表从最新的消息开始 # 使用XREAD读取第一个消息 XREAD COUNT 1 STREAMS users 0 # XREAD阻塞方式,读取最新的消息 XREAD COUNT 1 BLOCK 1000 STREAMS users $shell123456789101112131415161718192021

在业务开发中,可以循环的调用

XREAD

while(true){

//尝试读取队列中的消息,最多阳塞2秒

Object msg = redis.execute("XREAD COUNT I BLOCK 2000 STREAMS users $");

if(msg == null) {

continue;

}

// 处理消息

handleMessage(msg);

}

java

运行123456789当指定起始

ID

$

1

STREAM

XREAD

消息可回溯一个消息可以被多个消费者读取可以阻塞读取有消息漏读的风险

消费者组

消费者组(

Consumer Group

消息分流:队列中的消息会分流给组内的不同消费者,而不是重复消费,从而加快消息处理的消息标示:消费者组会维护一个标示,记录最后一个被处理的消息,哪怕消费者宕机重启,还会从标示之后读取消息。确保每一个消息都会被消费消息确认:消费者获取消息后,消息处于

pending

pending-list

XACK

pending-list

# 创建消费者组 XGROUP CREATE key groupName ID [MKSTREAM] # key: 队列名称 # groupName:消费者组名称 # ID:起始ID标示,$代表队列中最后一个消息,0则代表队列中第一个消息 # MKSTREAM:队列不存在时自动创建队列 # 删除指定的消费者组 XGROUP DESTORY key groupName # 给指定的消费者组添加消费者 XGROUP CREATECONSUMER key groupname consumername # 删除消费者组中的指定消费者 XGROUP DELCONSUMER key groupname consumername # 从消费者组读取消息 XREADGROUP GROUP group consumer [COUNT count] [BLOCK milliseconds] [NOACK] STREAMS key [key ...] ID [ID ...] # group:消费组名称 # consumer:消费者名称,如果消费者不存在,会自动创建一个消费者 # count:本次查询的最大数量 # BLOCK milliseconds:当没有消息时最长等待时间 # NOACK:无需手动ACK,获取到消息后自动确认 # STREAMS key:指定队列名称 # ID:获取消息的起始ID: # ">":从下一个未消费的消息开始 # 其它:根据指定id从pending-list中获取已消费但未确认的消息,例如0,是从pending-list中的第一个消息开始 # 确认消息已处理 XACK key group ID [ID ...] # 查看pending-list XPENDING key group[[lDLE min-idie-timel start endcount [consumer]]shell123456789101112131415161718192021222324252627282930313233

消费者监听消息的基本思路

while(true){ //尝试监听队列,使用阻塞模式,最长等待 2000毫秒 Object msg = redis.call("XREADGROUP GROUP gI CI COUNT 1 BLOCK 2000 STREAMS S1>"); if(msg == null){ // null说明没有消息,继续下一次 continue; } try { //处理消息,完成后一定要ACK handleMessage(msg); }catch(Exception e){ while(true){ // 在pending-listr中取数据来处理 Object msg = redis.calL("XREADGROUP GROUP gI C1 COUNT 1 STREAMS S1 @"); if(msg == null){ // null说明没有异常消息,所有消息都已确认,结束循环 break; } try { //说明有异常消息,再次处理 handleMessage(msg); }catch(Exception e){ //再次出现异常,记录日志,继续循环 continue; } } } }java 运行1234567891011121314151617181920212223242526

STREAM

XREADGROUP

消息可回溯可以多消费者争抢消息,加快消费速度可以阻塞读取没有消息漏读的风险有消息确认机制,保证消息至少被消费一次

例子:

private class VoucherOrderHandler implements Runnable { @Override public void run() { while (true) { try { // 1.获取消息队列中的订单信息 XREADGROUP GROUP g1 c1 COUNT 1 BLOCK 2000 STREAMS s1 > List<MapRecord<String, Object, Object>> list = stringRedisTemplate.opsForStream().read( Consumer.from("g1", "c1"), StreamReadOptions.empty().count(1).block(Duration.ofSeconds(2)), StreamOffset.create("stream.orders", ReadOffset.lastConsumed()) ); // 2.判断订单信息是否为空 if (list == null || list.isEmpty()) { // 如果为null,说明没有消息,继续下一次循环 continue; } // 解析数据 MapRecord<String, Object, Object> record = list.get(0); Map<Object, Object> value = record.getValue(); VoucherOrder voucherOrder = BeanUtil.fillBeanWithMap(value, new VoucherOrder(), true); // 3.创建订单 createVoucherOrder(voucherOrder); // 4.确认消息 XACK stringRedisTemplate.opsForStream().acknowledge("s1", "g1", record.getId()); } catch (Exception e) { log.error("处理订单异常", e); //处理异常消息 handlePendingList(); } } } private void handlePendingList() { while (true) { try { // 1.获取pending-list中的订单信息 XREADGROUP GROUP g1 c1 COUNT 1 BLOCK 2000 STREAMS s1 0 List<MapRecord<String, Object, Object>> list = stringRedisTemplate.opsForStream().read( Consumer.from("g1", "c1"), StreamReadOptions.empty().count(1), StreamOffset.create("stream.orders", ReadOffset.from("0")) ); // 2.判断订单信息是否为空 if (list == null || list.isEmpty()) { // 如果为null,说明没有异常消息,结束循环 break; } // 解析数据 MapRecord<String, Object, Object> record = list.get(0); Map<Object, Object> value = record.getValue(); VoucherOrder voucherOrder = BeanUtil.fillBeanWithMap(value, new VoucherOrder(), true); // 3.创建订单 createVoucherOrder(voucherOrder); // 4.确认消息 XACK stringRedisTemplate.opsForStream().acknowledge("s1", "g1", record.getId()); } catch (Exception e) { log.error("处理pendding订单异常", e); try{ Thread.sleep(20); }catch(Exception e){ e.printStackTrace(); } } } } }java 运行123456789101112131415161718192021222324252627282930313233343536373839404142434445464748495051525354555657585960616263646566

`Feed`流(`Redis`滚动分页)

Feed

Feed

Feed

Timeline

优点:信息全面,不会有缺失。并且实现也相对简单缺点:信息噪音较多,用户不一定感兴趣,内容获取效率低

智能排序:利用智能算法屏蔽掉违规的、用户不感兴趣的内容。推送用户感兴趣信息来吸引用户

优点:投喂用户感兴趣信息,用户粘度很高,容易沉迷缺点:如果算法不精准,可能起到反作用

Feed流的实现模式

拉模式(读扩散)

当张三和李四和王五发了消息后,都会保存在自己的邮箱中,假设赵六要读取信息,那么他会从读取他自己的收件箱,此时系统会从他关注的人群中,把他关注人的信息全部都进行拉取,然后在进行排序

- 优点:比较节约空间,因为赵六在读信息时,并没有重复读取,而且读取完之后可以把他的收件箱进行清楚。

- 缺点:比较延迟,当用户读取数据时才去关注的人里边去读取数据,假设用户关注了大量的用户,那么此时就会拉取海量的内容,对服务器压力巨大。

12

推模式(写扩散)

推模式是没有写邮箱的,当张三写了一个内容,此时会主动的把张三写的内容发送到他的粉丝收件箱中去,假设此时李四再来读取,就不用再去临时拉取了

- 优点:时效快,不用临时拉取

- 缺点:内存压力大,假设一个大V写信息,很多人关注他, 就会写很多分数据到粉丝那边去

12

推拉结合模式(读写混合)

推拉模式是一个折中的方案,站在发件人这一段,如果是个普通的人,那么我们采用写扩散的方式,直接把数据写入到他的粉丝中去,因为普通的人他的粉丝关注量比较小,所以这样做没有压力,如果是大V,那么他是直接将数据先写入到一份到发件箱里边去,然后再直接写一份到活跃粉丝收件箱里边去,现在站在收件人这端来看,如果是活跃粉丝,那么大V和普通的人发的都会直接写入到自己收件箱里边来,而如果是普通的粉丝,由于他们上线不是很频繁,所以等他们上线时,再从发件箱里边去拉信息。

滚动分页

传统了分页在

Feed

Feed

假设在

时刻,我们去读取第一页,此时

t1,

page = 1,那么我们拿到的就是

size = 5这几条记录,假设现在

10~6时候又发布了一条记录,此时

t2时刻,读取第二页,传入的参数是

t3,那么此时读取到的第二页实际上是从

page=2 ,size=5开始,然后是

6,那么我们就读取到了重复的数据,所以

6~2流的分页,不能采用原始方案来做。

feed

Feed

我们从

时刻开始,拿第一页数据,拿到了

t1,然后记录下当前最后一次拿取的记录,就是

10~6,

6时刻发布了新的记录,此时这个

t2放到最顶上,但是不会影响我们之前记录的

11,此时

6时刻来拿第二页,第二页这个时候拿数据,还是从

t3后一点的

6去拿,就拿到了

5的记录。我们可以采用

5-1来做,可以进行范围查询,并且还可以记录当前获取数据时间戳最小值,就可以实现滚动分页了

sortedSet

滚动分页查询参数

max

min

0

offset

0

count

@Override public Result queryBlogOfFollow(Long max, Integer offset) { // 1.获取当前用户 Long userId = UserHolder.getUser().getId(); // 2.查询收件箱 ZREVRANGEBYSCORE key Max Min LIMIT offset count String key = FEED_KEY + userId; Set<ZSetOperations.TypedTuple<String>> typedTuples = stringRedisTemplate.opsForZSet() .reverseRangeByScoreWithScores(key, 0, max, offset, 2); // 3.非空判断 if (typedTuples == null || typedTuples.isEmpty()) { return Result.ok(); } // 4.解析数据:blogId、minTime(时间戳)、offset List<Long> ids = new ArrayList<>(typedTuples.size()); long minTime = 0; // 2 int os = 1; // 最小值的个数 for (ZSetOperations.TypedTuple<String> tuple : typedTuples) { // 5 4 4 2 2 // 4.1.获取id ids.add(Long.valueOf(tuple.getValue())); // 4.2.获取分数(时间戳) long time = tuple.getScore().longValue(); if(time == minTime){ os++; }else{ minTime = time; os = 1; } } os = minTime == max ? os : os + offset; // 5.根据id查询blog String idStr = StrUtil.join(",", ids); List<Blog> blogs = query().in("id", ids).last("ORDER BY FIELD(id," + idStr + ")").list(); for (Blog blog : blogs) { // 5.1.查询blog有关的用户 queryBlogUser(blog); // 5.2.查询blog是否被点赞 isBlogLiked(blog); } // 6.封装并返回 ScrollResult r = new ScrollResult(); r.setList(blogs); r.setOffset(os); r.setMinTime(minTime); return Result.ok(r); }java 运行123456789101112131415161718192021222324252627282930313233343536373839404142434445464748

相关文章

12345678910

12345678910