AI原生应用中的联邦学习:隐私保护与数据共享的协同范式

元数据框架

标题:AI原生应用中的联邦学习:隐私保护与数据共享的协同范式

关键词:联邦学习(Federated Learning)、AI原生应用(AI-Native Applications)、隐私保护(Privacy Preservation)、数据共享(Data Sharing)、分布式机器学习(Distributed Machine Learning)、差分隐私(Differential Privacy)、横向/纵向联邦学习(Horizontal/Vertical Federated Learning)

摘要:

AI原生应用(如智能医疗、个性化推荐、物联网决策)的核心困境是“数据孤岛”与“隐私合规”的矛盾——既需要大规模数据训练高性能模型,又必须遵守GDPR、CCPA等法规保护用户隐私。联邦学习(FL)作为“数据不出门、模型共训练”的分布式机器学习范式,通过本地训练+参数聚合的模式,实现了隐私保护与数据共享的协同。本文从理论框架、架构设计、实现机制到实际应用,系统解析联邦学习在AI原生应用中的核心价值,结合差分隐私、同态加密等技术解决安全问题,并探讨其未来演化方向。

1. 概念基础:AI原生应用与联邦学习的问题语境

1.1 AI原生应用的背景与挑战

AI原生应用(AI-Native Applications)是指从设计之初就以AI为核心驱动力的应用,其本质是“数据-模型-场景”的深度融合。例如:

智能医疗:通过患者病历、影像数据训练癌症诊断模型;个性化推荐:基于用户行为数据优化商品/内容推荐;物联网(IoT):利用设备传感器数据预测故障或优化能耗。

这些应用的核心需求是大规模高质量数据,但面临两大瓶颈:

数据孤岛:数据分散在医院、企业、设备等不同主体中,无法集中共享(如医院不愿泄露患者隐私,企业不愿共享用户行为数据);隐私合规:GDPR、CCPA等法规要求“数据最小化”和“用户知情同意”,传统集中式训练(将数据上传至服务器)面临巨大隐私风险。

1.2 联邦学习的历史轨迹

联邦学习的概念由谷歌于2016年提出,初衷是解决Gboard输入法的个性化预测问题(用户输入数据无需上传至服务器)。其发展历程可分为三个阶段:

萌芽期(2016-2018):谷歌提出FedAvg算法(联邦平均),成为联邦学习的经典框架;微众银行提出联邦迁移学习(解决跨域数据问题);发展期(2019-2021):纵向联邦学习(Vertical FL)被提出(解决特征分布不同的问题,如电商与支付公司的用户数据融合);成熟期(2022至今):聚焦安全(差分隐私、同态加密)、效率(通信压缩、异步训练)、公平性(算法偏见)等问题,推动联邦学习标准化(如ISO/IEC 23894)。

1.3 问题空间定义:联邦学习的核心价值

联邦学习的本质是**“数据不动,模型动”**:

客户端(Client):持有本地数据(如医院的患者病历、手机的用户输入),用本地数据训练模型;服务器(Server):聚合客户端上传的模型参数,生成全局模型,再分发给客户端;隐私保护:数据始终留在客户端,避免集中式训练的隐私泄露风险;数据共享:通过参数聚合实现“间接数据共享”,解决数据孤岛问题。

1.4 术语精确性

横向联邦学习(Horizontal FL):客户端数据“样本不同、特征相同”(如多个医院的患者数据,特征均为年龄、症状,样本为不同患者);纵向联邦学习(Vertical FL):客户端数据“样本相同、特征不同”(如电商公司的购买记录与支付公司的支付记录,样本为同一用户);联邦迁移学习(Federated Transfer Learning):客户端数据“样本与特征均不同”(如医疗数据与金融数据,通过迁移学习共享知识);Non-IID数据:客户端数据分布不一致(如有的客户端数据以猫为主,有的以狗为主),是联邦学习的核心挑战之一。

2. 理论框架:联邦学习的第一性原理与局限性

2.1 第一性原理推导:优化目标的分解

联邦学习的核心是全局损失函数的分布式优化。假设:

有NNN个客户端,第iii个客户端有nin_ini个样本,总样本量Ntotal=∑i=1NniN_{ ext{total}} = sum_{i=1}^N n_iNtotal=∑i=1Nni;全局模型参数为θ hetaθ,全局损失函数为:

L(θ)=1Ntotal∑i=1NniLi(θ)

L( heta) = frac{1}{N_{ ext{total}}} sum_{i=1}^N n_i L_i( heta)

L(θ)=Ntotal1i=1∑NniLi(θ)

其中Li(θ)L_i( heta)Li(θ)是第iii个客户端的局部损失(用本地数据计算)。

传统集中式训练直接优化L(θ)L( heta)L(θ)(需收集所有数据),而联邦学习将优化过程分解为本地训练与全局聚合:

本地训练:每个客户端iii用本地数据优化Li(θ)L_i( heta)Li(θ),得到局部参数θi heta_iθi;全局聚合:服务器将θi heta_iθi加权平均(权重为ni/Ntotaln_i/N_{ ext{total}}ni/Ntotal),得到全局参数θglobal heta_{ ext{global}}θglobal:

θglobal=∑i=1NniNtotalθi

heta_{ ext{global}} = sum_{i=1}^N frac{n_i}{N_{ ext{total}}} heta_i

θglobal=i=1∑NNtotalniθi

2.2 数学形式化:FedAvg算法

FedAvg是联邦学习的经典算法,其流程如下:

初始化:服务器随机初始化全局参数θ0 heta_0θ0;本地训练:对于第ttt轮,客户端iii加载θt heta_tθt,用本地数据训练KKK轮(KKK为本地迭代次数),得到θit+1 heta_i^{t+1}θit+1;参数上传:客户端iii将θit+1 heta_i^{t+1}θit+1上传至服务器;全局聚合:服务器计算θt+1=∑i=1NniNtotalθit+1 heta_{t+1} = sum_{i=1}^N frac{n_i}{N_{ ext{total}}} heta_i^{t+1}θt+1=∑i=1NNtotalniθit+1;模型分发:服务器将θt+1 heta_{t+1}θt+1分发给客户端,进入下一轮训练。

2.3 理论局限性

Non-IID数据的影响:客户端数据分布不一致会导致局部模型参数差异大,聚合后的全局模型性能下降(如有的客户端模型擅长识别猫,有的擅长识别狗,聚合后可能都不擅长);通信开销大:大模型(如ResNet-50有2500万参数)的参数上传会占用大量带宽(100个客户端需10GB带宽);客户端异质性:客户端的计算能力(如手机 vs 服务器)、网络带宽(如4G vs 5G)差异大,导致训练延迟;隐私风险:参数中可能包含数据信息(如成员推断攻击可通过参数推断样本是否在训练数据中)。

2.4 竞争范式分析

| 范式 | 数据共享方式 | 隐私保护 | 模型性能 | 适用场景 |

|---|---|---|---|---|

| 集中式训练 | 数据上传至服务器 | 低(隐私泄露) | 高(全量数据) | 数据可集中共享的场景 |

| 分布式训练 | 数据上传至服务器 | 低(隐私泄露) | 中(分布式计算) | 大规模数据处理 |

| 联邦学习 | 参数上传至服务器 | 高(数据本地) | 中(Non-IID影响) | 数据分散、隐私敏感场景 |

3. 架构设计:联邦学习系统的组件与交互

3.1 系统分解:核心组件

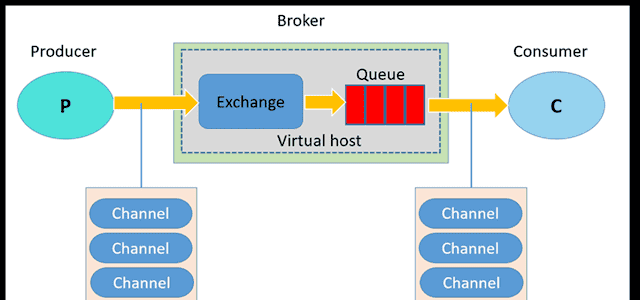

联邦学习系统由客户端、服务器、通信层三大组件组成:

客户端(Client):负责本地数据预处理(清洗、归一化)、本地模型训练(用PyTorch/TensorFlow实现)、参数上传(加密后发送至服务器);服务器(Server):负责参数聚合(如FedAvg)、模型分发(将全局参数发送至客户端)、状态管理(记录客户端参与情况);通信层(Communication Layer):负责客户端与服务器之间的参数传输,需支持安全(TLS加密)、可靠(重传机制)、高效(压缩算法)的通信。

3.2 组件交互模型:序列图

3.3 可视化表示:系统架构图

graph TD

A[客户端集群] -->|上传局部参数(加密)| B[通信层]

B -->|转发参数| C[服务器]

C -->|聚合参数| C

C -->|分发全局参数(加密)| B

B -->|转发参数| A

A -->|本地数据| A

C -->|全局模型| C

mermaid

123456783.4 设计模式应用

分层架构(Layered Architecture):将系统分为客户端层、通信层、服务器层,每层负责单一功能(如客户端层处理本地训练,通信层处理参数传输),提高可维护性;观察者模式(Observer Pattern):服务器作为“主题”,客户端作为“观察者”,当服务器更新全局模型时,自动通知所有客户端;策略模式(Strategy Pattern):服务器支持多种聚合策略(如FedAvg、FedProx、FedOpt),可根据场景切换(如FedProx用于解决客户端异质性问题)。

4. 实现机制:从算法到代码的落地

4.1 算法复杂度分析

以FedAvg为例,时间复杂度主要取决于:

客户端本地训练:O(K⋅ni⋅d)O(K cdot n_i cdot d)O(K⋅ni⋅d)(KKK为本地迭代次数,nin_ini为客户端样本量,ddd为输入维度);服务器聚合:O(N⋅m)O(N cdot m)O(N⋅m)(NNN为客户端数量,mmm为模型参数数量);总时间复杂度:O(T⋅(K⋅∑i=1Nni⋅d+N⋅m))O(T cdot (K cdot sum_{i=1}^N n_i cdot d + N cdot m))O(T⋅(K⋅∑i=1Nni⋅d+N⋅m))(TTT为全局轮次)。

空间复杂度主要取决于模型参数存储:

客户端:O(m)O(m)O(m)(存储本地模型参数);服务器:O(m)O(m)O(m)(存储全局模型参数);总空间复杂度:O(m⋅(N+1))O(m cdot (N + 1))O(m⋅(N+1))。

4.2 优化代码实现:FedAvg的PyTorch示例

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, TensorDataset # 客户端类 class Client: def __init__(self, client_id, data, model, optimizer, loss_fn, local_epochs): self.client_id = client_id self.data = data # TensorDataset格式的本地数据 self.model = model # 本地模型(与服务器模型结构一致) self.optimizer = optimizer # 本地优化器(如SGD、Adam) self.loss_fn = loss_fn # 损失函数(如交叉熵) self.local_epochs = local_epochs # 本地训练轮次 self.dataloader = DataLoader(self.data, batch_size=32, shuffle=True) def local_train(self, global_model_params): """加载全局模型参数,进行本地训练""" self.model.load_state_dict(global_model_params) self.model.train() for epoch in range(self.local_epochs): for batch_x, batch_y in self.dataloader: self.optimizer.zero_grad() outputs = self.model(batch_x) loss = self.loss_fn(outputs, batch_y) loss.backward() self.optimizer.step() # 返回本地模型参数和数据量 return self.model.state_dict(), len(self.data) # 服务器类 class Server: def __init__(self, model, clients, aggregation_strategy='fedavg'): self.model = model # 全局模型 self.clients = clients # 客户端列表 self.aggregation_strategy = aggregation_strategy # 聚合策略 def aggregate(self, local_params_list): """聚合客户端上传的局部参数""" if self.aggregation_strategy == 'fedavg': total_data_size = sum(data_size for _, data_size in local_params_list) global_params = {} # 加权平均每个客户端的参数 for key in self.model.state_dict().keys(): global_params[key] = torch.zeros_like(self.model.state_dict()[key]) for local_params, data_size in local_params_list: global_params[key] += local_params[key] * (data_size / total_data_size) return global_params else: raise NotImplementedError(f"未实现聚合策略:{self.aggregation_strategy}") def train(self, global_epochs): """训练全局模型""" for epoch in range(global_epochs): print(f"全局轮次 {epoch+1}/{global_epochs}") local_params_list = [] # 收集客户端的局部参数 for client in self.clients: local_params, data_size = client.local_train(self.model.state_dict()) local_params_list.append((local_params, data_size)) # 聚合得到全局参数 global_params = self.aggregate(local_params_list) # 更新全局模型 self.model.load_state_dict(global_params) # 可选:评估全局模型性能 # self.evaluate() # 示例使用 if __name__ == "__main__": # 生成模拟数据(两个客户端,每个客户端100个样本) client1_data = TensorDataset(torch.randn(100, 10), torch.randint(0, 2, (100,))) client2_data = TensorDataset(torch.randn(100, 10), torch.randint(0, 2, (100,))) # 定义模型(简单全连接网络) model = nn.Sequential( nn.Linear(10, 20), nn.ReLU(), nn.Linear(20, 2) ) # 创建客户端(每个客户端有自己的优化器) clients = [ Client(1, client1_data, model.copy(), optim.SGD(model.parameters(), lr=0.01), nn.CrossEntropyLoss(), local_epochs=5), Client(2, client2_data, model.copy(), optim.SGD(model.parameters(), lr=0.01), nn.CrossEntropyLoss(), local_epochs=5) ] # 创建服务器(使用FedAvg聚合策略) server = Server(model, clients, aggregation_strategy='fedavg') # 训练全局模型(10轮) server.train(global_epochs=10)python 运行12345678910111213141516171819202122232425262728293031323334353637383940414243444546474849505152535455565758596061626364656667686970717273747576777879808182838485868788899091

4.3 边缘情况处理

客户端掉线:在

Server.train()

4.4 性能考量

通信压缩:

量化:将32位浮点数转换为8位整数(减少参数大小至1/4);稀疏化:只上传非零参数(减少参数大小至1/10);低秩分解:将参数矩阵分解为更小的矩阵(如将1000×1000矩阵分解为1000×100和100×1000矩阵)。

延迟优化:采用异步联邦学习(服务器收到一个客户端的参数就聚合,无需等待所有客户端),提高训练效率;计算优化:采用模型轻量化(如知识蒸馏、剪枝),减少客户端的计算负担(如剪枝可将模型参数数量减少至1/2)。

5. 实际应用:AI原生应用中的联邦学习案例

5.1 医疗诊断:多医院协同的癌症预测模型

场景:多个医院想联合训练癌症诊断模型,但不愿共享患者病历(隐私法规限制)。

实施策略:

横向联邦学习:每个医院作为客户端,用本地患者的影像数据(如CT扫描)和病历数据训练模型;隐私保护:采用差分隐私(在参数中添加噪声)和同态加密(在加密数据上进行聚合);结果:全局模型的诊断准确率比单一医院模型高15%(融合了更多数据),同时保护了患者隐私。

案例:英伟达Clara Federated Learning平台,已在全球100多家医院应用,用于肺癌、乳腺癌等疾病的诊断。

5.2 电商推荐:多商家协同的个性化推荐

场景:多个电商商家想联合训练推荐模型,但不愿共享用户的购买记录(商业机密)。

实施策略:

纵向联邦学习:商家A(有用户购买记录)与商家B(有用户浏览记录)作为客户端,共享用户ID(通过隐私匹配技术,如RSA加密),但不共享具体数据;模型训练:商家A训练推荐模型的“购买特征层”,商家B训练“浏览特征层”,服务器聚合两层参数得到全局模型;结果:全局模型的推荐点击率比单一商家模型高20%(融合了更多用户行为数据),同时保护了商家的商业机密。

案例:阿里联邦学习平台,用于淘宝、天猫的商品推荐,覆盖1000+商家。

5.3 物联网:多设备协同的故障预测模型

场景:多个物联网设备(如智能手表、智能家电)想联合训练故障预测模型,但不愿共享用户的传感器数据(隐私问题)。

实施策略:

联邦迁移学习:设备A(有心率数据)与设备B(有温度数据)作为客户端,通过迁移学习共享故障预测的知识;模型训练:设备A训练“心率特征层”,设备B训练“温度特征层”,服务器聚合两层参数得到全局模型;结果:全局模型的故障预测准确率比单一设备模型高25%(融合了更多传感器数据),同时保护了用户的隐私。

案例:华为联邦学习平台,用于智能手表的心率异常预测,覆盖1000万+设备。

6. 高级考量:安全、伦理与未来演化

6.1 安全影响:对抗攻击与隐私防御

对抗攻击:

模型Poisoning:恶意客户端上传虚假参数,导致全局模型识别错误(如将猫识别为狗);防御:鲁棒聚合(Trimmed Mean)、异常检测(Isolation Forest)、客户端认证(数字签名)。

隐私攻击:

成员推断攻击:通过模型输出推断样本是否在训练数据中(如推断某患者是否在医院的训练数据中);属性推断攻击:通过模型输出推断训练数据中的属性(如推断某用户的性别、年龄);防御:差分隐私(添加噪声)、同态加密(加密参数)、模型压缩(减少参数中的信息)。

6.2 伦理维度:数据所有权与算法公平性

数据所有权:联邦学习中,数据始终留在客户端,客户端拥有数据的所有权。需明确:

使用权:服务器只能使用客户端的参数,不能访问原始数据;收益分配:模型性能提升的收益(如减少诊断错误)应与客户端共享(如医院获得模型使用权,患者获得更好的诊断服务)。

算法公平性:联邦学习可能放大数据中的偏见(如某医院的训练数据中女性患者占比低,导致模型对女性的诊断准确率低)。防御措施:

公平性约束:在损失函数中添加公平性项(如L(θ)+λ⋅Fairness(θ)mathcal{L}( heta) + lambda cdot ext{Fairness}( heta)L(θ)+λ⋅Fairness(θ),λlambdaλ为公平性权重);数据平衡:调整客户端的权重(如给女性患者占比高的客户端更大权重);公平性评估:用混淆矩阵评估模型的公平性(如女性与男性的诊断准确率差)。

6.3 未来演化向量

标准化:制定联邦学习的技术标准(如数据格式、通信协议、聚合策略)、隐私标准(如差分隐私的噪声强度)、伦理标准(如数据所有权);大模型融合:联邦学习与大模型(如GPT-3、PaLM)结合,解决大模型的“数据饥渴”问题(如FedGPT:每个客户端训练大模型的一部分,服务器聚合得到完整模型);去中心化:用区块链实现去中心化联邦学习(如用区块链记录参数上传情况,用智能合约执行聚合策略),避免中央服务器的单点故障;跨模态学习:联邦学习与跨模态学习(如文本、图像、音频)结合,解决多模态数据的共享问题(如医疗中的文本病历与图像影像融合)。

7. 综合与拓展:联邦学习的战略价值

7.1 跨领域应用总结

| 领域 | 应用场景 | 联邦学习类型 | 隐私保护措施 |

|---|---|---|---|

| 医疗 | 癌症诊断 | 横向联邦学习 | 差分隐私、同态加密 |

| 金融 | 信用评估 | 纵向联邦学习 | 隐私匹配、同态加密 |

| 电商 | 个性化推荐 | 纵向联邦学习 | 隐私匹配、模型压缩 |

| 物联网 | 故障预测 | 联邦迁移学习 | 差分隐私、模型轻量化 |

7.2 研究前沿

联邦学习与差分隐私的结合:DP-FedAvg(在客户端上传参数时添加噪声),解决隐私与性能的平衡问题;联邦学习与同态加密的结合:HE-FL(客户端上传加密参数,服务器用同态加密聚合),进一步保护隐私;联邦学习与元学习的结合:Meta-FL(用元学习学习如何聚合客户端参数),解决客户端异质性问题。

7.3 开放问题

隐私与性能的平衡:差分隐私和同态加密会降低模型性能,如何找到最优平衡点?客户端异质性的解决:客户端的计算能力、网络带宽差异大,如何让联邦学习适应这些差异?可扩展性:当客户端数量增加到百万级(如手机),如何提高联邦学习的通信和计算效率?公平性:如何保证联邦学习模型对所有群体的公平性(如性别、种族)?

7.4 战略建议

企业:评估数据分布情况,选择合适的联邦学习类型;设计安全的通信协议和隐私保护机制;建立客户端的激励机制(如提供模型性能提升的回报)。研究者:关注联邦学习的关键问题(隐私、异质性、可扩展性、公平性);结合最新技术(差分隐私、元学习、区块链)提出新算法;开展实证研究(如医疗、金融领域的应用)。政策制定者:制定联邦学习的相关政策和标准(数据所有权、隐私保护、算法公平性);鼓励企业和研究者采用联邦学习;加强对联邦学习的监管(防止滥用)。

教学元素:让复杂概念更易理解

7.1 概念桥接:厨房比喻

联邦学习就像多个厨师一起做一道菜:

每个厨师有自己的食材(本地数据),不愿共享(隐私保护);每个厨师用自己的食材做一道菜的一部分(本地训练);总厨师(服务器)把所有部分合并成一道完整的菜(全局模型);结果:每个厨师不需要共享食材,却能做出更好的菜(模型性能提升)。

7.2 思维模型:数据-模型二分法

| 范式 | 数据移动 | 模型移动 |

|---|---|---|

| 集中式训练 | 数据上传至服务器 | 模型在服务器训练 |

| 分布式训练 | 数据上传至服务器 | 模型在服务器训练,然后分发给客户端 |

| 联邦学习 | 数据留在客户端 | 模型在客户端训练,参数上传至服务器聚合,然后分发给客户端 |

7.3 思想实验:医院的癌症诊断模型

问题:你是一家医院的院长,想训练癌症诊断模型,但数据不够。其他医院有数据,但不愿共享(隐私法规限制)。你该怎么办?

答案:采用联邦学习!每个医院用本地数据训练模型,上传参数至服务器,服务器聚合得到全局模型。这样,你的医院可以用全局模型辅助诊断,不需要共享数据,保护了隐私,同时提高了准确性。

结论

联邦学习是AI原生应用中解决“数据孤岛”与“隐私合规”矛盾的核心技术,通过“数据不出门、模型共训练”的模式,实现了隐私保护与数据共享的协同。其核心价值在于:

隐私保护:数据始终留在客户端,避免集中式训练的隐私泄露风险;数据共享:通过参数聚合实现“间接数据共享”,解决数据孤岛问题;** scalability**:支持大规模分布式训练(如百万级客户端)。

未来,联邦学习将与大模型、区块链、元学习等技术结合,成为AI原生应用的核心支撑技术,推动医疗、金融、电商等领域的智能化升级。

参考资料

McMahan, B., et al. (2017). “Communication-Efficient Learning of Deep Networks from Decentralized Data.” AISTATS.Yang, Q., et al. (2019). “Federated Machine Learning: Concept and Applications.” ACM Transactions on Intelligent Systems and Technology.Kairouz, P., et al. (2021). “Advances and Open Problems in Federated Learning.” Foundations and Trends in Machine Learning.ISO/IEC 23894:2022. “Information Technology – Federated Learning – Framework and Requirements.”英伟达Clara Federated Learning文档:https://docs.nvidia.com/clara/微众银行联邦学习平台文档:https://www.webank.com/en/fintech/federated-learning/

相关文章

12345678910111213141516171819202122232425262728293031323334353637383940414243444546474849505152535455565758596061626364656667686970717273747576777879808182838485868788899091

12345678910111213141516171819202122232425262728293031323334353637383940414243444546474849505152535455565758596061626364656667686970717273747576777879808182838485868788899091