大数据领域规范性分析:从“是什么”到“该怎么做”的决策魔法

关键词:规范性分析;大数据决策;优化算法;强化学习;决策支持工具;OptaPlanner;Gurobi

摘要:大数据分析不是终点,而是帮我们做决策的工具。本文从“给手机推荐 apps”“帮妈妈安排周末家务”的生活场景切入,用小学生能听懂的语言解释“规范性分析”的核心逻辑——它不是“回忆昨天吃了什么”(描述性),也不是“预测明天会下雨”(预测性),而是“告诉我们明天应该带伞还是穿裙子”(决策性)。我们会一步步拆解规范性分析的技术原理(比如优化算法像“安排时间的魔法公式”)、实战工具(比如用OptaPlanner帮公司排值班表),并推荐适合不同场景的工具清单。读完这篇,你会明白:大数据的终极价值,是让机器帮我们做出“更聪明的选择”。

一、背景介绍:为什么我们需要“规范性分析”?

1.1 从“看数据”到“用数据”的进化

小时候玩拼图,第一步是“把所有碎片倒出来”(收集数据),第二步是“看看碎片长什么样”(描述性分析,比如“这个碎片是蓝色的,像天空”),第三步是“猜这个碎片应该放在哪里”(预测性分析,比如“蓝色碎片可能在右上角”),最后一步是“把碎片拼对”(规范性分析,比如“应该把蓝色碎片放在这里,因为它和旁边的碎片吻合”)。

大数据分析的进化也是一样:

描述性分析:回答“发生了什么?”(比如“上周电商平台销量下降了10%”);预测性分析:回答“可能发生什么?”(比如“下个月销量可能再降5%,因为竞品在搞活动”);规范性分析:回答“应该怎么做?”(比如“我们应该推出满减活动,同时优化推荐算法,提升转化率”)。

如果说描述性是“回顾过去”,预测性是“展望未来”,那么规范性就是“行动指南”——它是大数据从“ insights(洞见)”到“ action(行动)”的关键一步。

1.2 预期读者与文档结构

预期读者:刚接触大数据分析的产品经理、想做决策支持的程序员、对“机器帮人做选择”感兴趣的学生;文档结构:先讲“规范性分析是什么”(用生活例子),再讲“用什么技术实现”(优化算法、强化学习),然后讲“用什么工具做”(开源/商业工具推荐),最后用“员工排班”的实战案例让你动手试试。

1.3 术语表:先搞懂这些“黑话”

规范性分析(Normative Analysis):基于数据和模型,给出“最优决策建议”的分析方法,核心是“优化”(最大化收益/最小化成本);优化问题(Optimization Problem):在一定约束条件下,寻找目标函数的最大值或最小值(比如“用最少的钱买最多的菜”);强化学习(Reinforcement Learning):让机器通过“试错”学习最优策略的算法(比如“训练AI玩游戏,赢了给奖励,输了给惩罚”);决策支持系统(DSS):整合数据、模型和交互界面,帮人做决策的软件(比如“导航APP推荐最快路线”)。

二、核心概念:规范性分析到底是“什么魔法”?

2.1 故事引入:手机APP的“推荐逻辑”

你有没有发现,手机里的APP商店总给你推荐“你可能喜欢的 apps”?比如你刚下载了“小红书”,它就推荐“抖音”“B站”;你刚买了“健身环大冒险”,它就推荐“Keep”“Nike Run Club”。

其实,这背后就是规范性分析在工作:

第一步(描述性):收集你的行为数据——“你下载了小红书,浏览了健身视频,买了健身环”;第二步(预测性):预测你的需求——“你可能喜欢刷短视频,也可能想继续健身”;第三步(规范性):给出最优推荐——“推荐抖音(短视频)和Keep(健身),因为这两个APP的用户重叠度高,而且你之前的行为显示你对它们感兴趣”。

简单来说,规范性分析就是“根据你的情况,帮你选最好的那个”。

2.2 核心概念解释:用“生活场景”类比

2.2.1 概念一:规范性分析=“帮你做选择的魔法”

假设你周末要做三件事:写作业(2小时)、打篮球(1小时)、看电影(1.5小时),而你只有3小时时间。这时候,规范性分析会帮你解决“怎么安排时间,才能最大化快乐”的问题:

目标函数:快乐值最大化(比如写作业快乐值1,打篮球快乐值5,看电影快乐值4);约束条件:总时间≤3小时;最优解:打篮球(1小时)+ 看电影(1.5小时)+ 写作业(0.5小时),总快乐值5+4+0.5=9.5。

这就是规范性分析的核心逻辑:在约束条件下,寻找目标的最优解。

2.2.2 概念二:优化算法=“安排时间的公式”

上面的“时间安排问题”,其实是一个**线性规划(Linear Programming)**问题。线性规划是最常用的优化算法之一,它的数学模型长这样(用latex写,别怕,我们用生活例子解释):

zzz:目标函数(比如快乐值),我们要最大化(maxmaxmax)或最小化(minminmin)它;x1,x2x_1,x_2x1,x2:决策变量(比如“写作业的时间”“打篮球的时间”);c1,c2c_1,c_2c1,c2:变量的权重(比如“写作业的快乐值”“打篮球的快乐值”);aija_{ij}aij:约束条件的系数(比如“写作业每小时占1单位时间”);bib_ibi:约束条件的上限(比如“总时间≤3小时”)。

用上面的例子代入,就是:

目标函数:maxz=1×1+5×2+4x3max z = 1x_1 + 5x_2 + 4x_3maxz=1×1+5×2+4×3(x1x_1x1=写作业时间,x2x_2x2=打篮球时间,x3x_3x3=看电影时间);约束条件:x1+x2+x3≤3x_1 + x_2 + x_3 ≤ 3×1+x2+x3≤3(总时间≤3小时);变量非负:x1,x2,x3≥0x_1,x_2,x_3 ≥ 0x1,x2,x3≥0。

优化算法的作用,就是帮我们快速找到满足约束条件的x1,x2,x3x_1,x_2,x_3x1,x2,x3,让zzz最大。

2.2.3 概念三:强化学习=“训练宠物的聪明方法”

如果说优化算法是“静态的公式”,那么强化学习就是“动态的试错”。比如你想训练宠物狗“坐下”:

当狗坐下时,你给它吃零食(奖励);当狗没坐下时,你不理它(惩罚);慢慢的,狗就学会了“坐下”这个动作(最优策略)。

强化学习的核心逻辑和这一样:

智能体(Agent):要做决策的“狗”(比如推荐系统);环境(Environment):狗所处的场景(比如用户的行为);动作(Action):狗做的事情(比如推荐“抖音”APP);奖励(Reward):对动作的反馈(比如用户下载了,给正奖励;用户没下载,给负奖励);策略(Policy):狗学会的“怎么做”(比如“用户下载了小红书,就推荐抖音”)。

强化学习适合动态、不确定的场景,比如自动驾驶(需要实时调整路线)、游戏AI(需要应对对手的变化)。

2.3 核心概念之间的关系:像“做饭的团队”

规范性分析、优化算法、强化学习的关系,就像“做饭的团队”:

规范性分析:是“厨师长”,负责制定“做什么菜”(目标)和“用什么材料”(约束);优化算法:是“配菜师傅”,负责把材料(数据)按照配方(模型)搭配好,做出“最优的菜”(解);强化学习:是“试菜师傅”,负责尝一尝菜的味道(反馈),调整配方(策略),让菜更好吃(更优)。

比如“推荐APP”这个任务:

规范性分析确定“目标是最大化用户下载率”,“约束是推荐的APP必须符合用户兴趣”;优化算法用“线性规划”计算“推荐哪些APP能让下载率最高”;强化学习根据用户的反馈(比如“下载了抖音”给正奖励,“没下载”给负奖励),调整推荐策略(比如“下次推荐B站而不是抖音”)。

2.4 规范性分析的流程:Mermaid流程图

下面用Mermaid画一个规范性分析的流程,让你一眼看明白:

graph TD

A[数据输入:用户行为、产品信息] --> B[描述性分析:统计用户喜欢的APP类型]

B --> C[预测性分析:预测用户可能下载的APP]

C --> D[规范性分析:用优化算法/强化学习计算最优推荐列表]

D --> E[决策输出:给用户推荐APP]

E --> F[用户反馈:下载/未下载]

F --> C[更新预测模型]

F --> D[更新优化策略]

流程说明:

先收集数据(A);用描述性分析搞清楚“用户喜欢什么”(B);用预测性分析猜“用户可能喜欢什么”(C);用规范性分析算出“应该推荐什么”(D);把推荐结果给用户(E);根据用户的反馈(F),更新预测模型和优化策略,让下次推荐更准。

三、核心技术:规范性分析的“魔法工具”

3.1 优化算法:解决“静态决策”问题

优化算法是规范性分析的“基础工具”,适合约束条件明确、目标函数固定的场景,比如“安排员工排班”“优化供应链库存”。

3.1.1 线性规划(Linear Programming, LP)

适用场景:目标函数和约束条件都是线性的(比如“最大化利润=单价×销量-成本×产量”);例子:工厂生产两种产品,A产品每台利润100元,需要2小时人工;B产品每台利润150元,需要3小时人工。工厂每天有100小时人工,问生产多少A和B,才能最大化利润?数学模型:

3.2.1 核心组件

状态(State):环境的当前情况(比如“用户当前浏览的是小红书的健身视频”);动作(Action):智能体要做的事情(比如“推荐Keep APP”);奖励(Reward):环境对动作的反馈(比如“用户下载了Keep,给+10奖励”);策略(Policy):智能体根据状态选择动作的规则(比如“如果用户浏览健身视频,就推荐Keep”)。

3.2.2 常用算法

Q-学习(Q-Learning):通过学习“状态-动作值函数(Q函数)”来选择最优动作(比如“在状态S下,做动作A能得到多少奖励”);深度强化学习(Deep RL):用深度学习模型(比如神经网络)近似Q函数,适合处理高维状态(比如图像、文本);Policy Gradient:直接优化策略函数(比如“用神经网络输出动作的概率”),适合连续动作空间(比如“自动驾驶的方向盘角度”)。

3.2.3 例子:用强化学习做推荐系统

假设我们要做一个电商推荐系统,目标是最大化用户的购买率:

状态:用户的浏览历史(比如“浏览了手机、电脑”);动作:推荐的商品(比如“推荐耳机、键盘”);奖励:用户购买了推荐的商品,给+10奖励;没购买,给-1奖励;策略:用神经网络学习“用户浏览了手机和电脑,推荐耳机的概率是80%,推荐键盘的概率是20%”。

3.3 决策支持系统(DSS):把技术变成“可用的工具”

优化算法和强化学习是“底层技术”,而决策支持系统是“上层应用”,它把数据、模型和交互界面整合起来,让非技术人员也能做决策。

比如导航APP就是一个典型的DSS:

数据:实时交通数据、地图数据;模型:最短路径算法(比如Dijkstra算法)、实时交通预测模型;交互界面:地图显示、路线推荐、语音导航;决策输出:“推荐走XX路,比当前路线快10分钟”。

四、工具推荐:从“开源”到“商业”,总有一款适合你

4.1 优化工具:解决“静态决策”的利器

4.1.1 开源工具

PuLP(Python):简单易用的线性规划库,适合入门。比如用PuLP解决上面的“工厂生产问题”:

import pulp

# 创建问题:最大化利润

prob = pulp.LpProblem("Factory_Production", pulp.LpMaximize)

# 决策变量:x1=A产品数量,x2=B产品数量

x1 = pulp.LpVariable("x1", lowBound=0, cat=pulp.LpInteger)

x2 = pulp.LpVariable("x2", lowBound=0, cat=pulp.LpInteger)

# 目标函数:利润=100x1 + 150x2

prob += 100 * x1 + 150 * x2

# 约束条件:2x1 + 3x2 ≤ 100(人工时间限制)

prob += 2 * x1 + 3 * x2 ≤ 100

# 求解

prob.solve()

# 输出结果

print("A产品数量:", pulp.value(x1))

print("B产品数量:", pulp.value(x2))

print("最大利润:", pulp.value(prob.objective))

运行结果:A产品数量25,B产品数量16,最大利润25×100+16×150=2500+2400=4900元。

OptaPlanner(Java/Kotlin):开源的约束满足优化库,适合复杂的整数规划问题(比如员工排班、车辆路径规划)。它的特点是“低代码”,你只需要定义约束条件(比如“每个员工每周工作不超过40小时”),它就会自动找最优解。

4.1.2 商业工具

Gurobi:性能最强的优化工具之一,支持线性规划、整数规划、非线性规划,适合企业级复杂问题(比如供应链优化、金融建模)。它的缺点是贵,但对于大企业来说,性价比很高。CPLEX:IBM的优化工具,功能和Gurobi类似,适合需要整合IBM生态的企业(比如用IBM Watson做决策支持)。

4.2 强化学习工具:解决“动态决策”的神器

4.2.1 开源框架

TensorFlow Agents(TF-Agents):TensorFlow的强化学习库,提供了Q-学习、Policy Gradient等算法的实现,适合用TensorFlow做深度学习的开发者。Stable Baselines3(SB3):基于PyTorch的强化学习库,封装了常用的算法(比如PPO、DQN),接口简单,适合快速原型开发。比如用SB3做一个“CartPole”游戏(平衡杆游戏)的AI:

from stable_baselines3 import PPO

from stable_baselines3.common.env_util import make_cartpole_env

# 创建环境(CartPole游戏)

env = make_cartpole_env()

# 初始化PPO算法

model = PPO("MlpPolicy", env, verbose=1)

# 训练模型(10000步)

model.learn(total_timesteps=10000)

# 测试模型

obs = env.reset()

for _ in range(1000):

action, _ = model.predict(obs)

obs, reward, done, info = env.step(action)

env.render()

if done:

obs = env.reset()

运行后,你会看到平衡杆能保持很长时间不倒下。

4.2.2 商业工具

Amazon SageMaker RL:AWS的强化学习平台,提供了预训练的模型和分布式训练能力,适合企业级的强化学习项目(比如自动驾驶、机器人控制)。Google DeepMind:虽然不是直接的工具,但DeepMind的研究(比如AlphaGo、AlphaFold)推动了强化学习的发展,很多企业会参考他们的算法实现。

4.3 决策支持系统工具:让决策“可视化”

Tableau:强大的可视化工具,可以整合优化模型(比如用Tableau的“计算字段”实现线性规划),让决策结果更直观(比如用图表显示“推荐的APP列表”)。Power BI:微软的BI工具,支持与Excel、SQL Server整合,适合企业内部的决策支持(比如用Power BI做“销售预测与决策” dashboard)。ThoughtSpot:AI驱动的决策支持工具,能自动生成“应该怎么做”的建议(比如“根据当前销量,应该增加XX产品的库存”),适合非技术人员使用。

五、实战案例:用OptaPlanner帮公司排“员工值班表”

5.1 问题描述

假设你是公司的HR,需要安排5个员工(张三、李四、王五、赵六、周七)下周(周一到周五)的值班表,约束条件如下:

每个员工每天最多值班1次;每个员工每周最多值班2次;每天需要3个员工值班;张三和李四不能在同一天值班(他们有矛盾);王五必须在周一值班(他是周一的负责人)。

目标是:让员工的值班时间尽可能均衡(比如不要有人连续值班3天)。

5.2 开发环境搭建

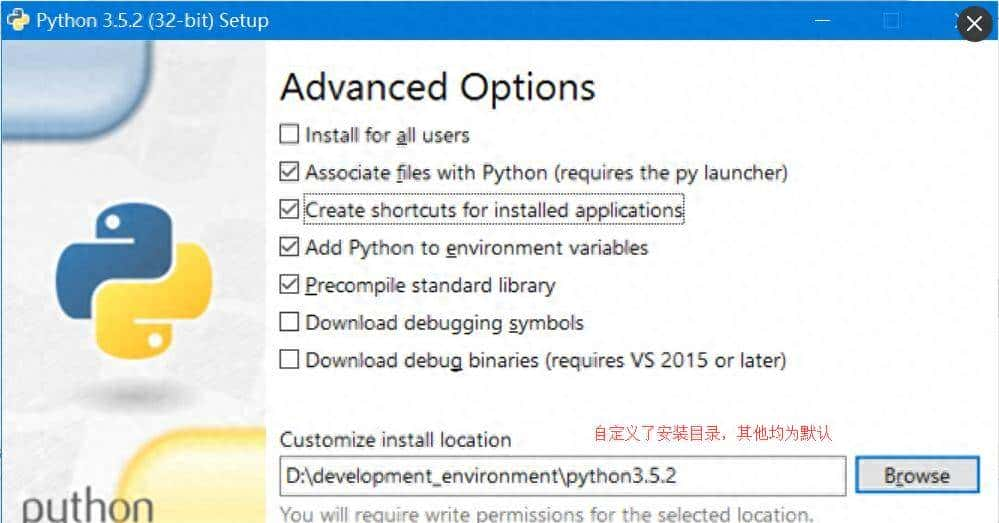

工具:OptaPlanner(Java)、IntelliJ IDEA;步骤:

下载OptaPlanner的最新版本(从官网或Maven仓库);创建一个Java项目,添加OptaPlanner的依赖;定义“员工”“值班日”“值班安排”等实体类。

5.3 源代码详细实现

5.3.1 定义实体类

Employee(员工):包含员工ID、姓名;Shift(值班日):包含日期、需要的员工数量;ShiftAssignment(值班安排):包含员工、值班日,是OptaPlanner的“规划实体”(需要优化的对象)。

// 员工类

public class Employee {

private Long id;

private String name;

// getter/setter

}

// 值班日类

public class Shift {

private LocalDate date;

private int requiredEmployees;

// getter/setter

}

// 值班安排类(规划实体)

@PlanningEntity

public class ShiftAssignment {

@PlanningId

private Long id;

private Shift shift;

@PlanningVariable(valueRangeProviderRefs = "employeeRange")

private Employee employee;

// getter/setter

}

5.3.2 定义约束条件

用OptaPlanner的“约束流(Constraint Stream)”定义约束条件:

public class ShiftSchedulingConstraintProvider implements ConstraintProvider {

@Override

public Constraint[] defineConstraints(ConstraintFactory factory) {

return new Constraint[] {

// 约束1:每个员工每天最多值班1次

employeePerDayLimit(factory),

// 约束2:每个员工每周最多值班2次

employeePerWeekLimit(factory),

// 约束3:每天需要3个员工值班

shiftCoverage(factory),

// 约束4:张三和李四不能在同一天值班

incompatibleEmployees(factory),

// 约束5:王五必须在周一值班

mandatoryEmployee(factory),

// 目标:让员工的值班时间尽可能均衡(最小化方差)

balancedShiftAssignments(factory)

};

}

// 约束1:每个员工每天最多值班1次

private Constraint employeePerDayLimit(ConstraintFactory factory) {

return factory.forEach(ShiftAssignment.class)

.groupBy(ShiftAssignment::getEmployee, ShiftAssignment::getShift, ConstraintCollectors.count())

.filter((employee, shift, count) -> count > 1)

.penalize("Employee per day limit", HardSoftScore.ONE_HARD, (employee, shift, count) -> count - 1);

}

// 目标:最小化员工值班次数的方差

private Constraint balancedShiftAssignments(ConstraintFactory factory) {

return factory.forEach(ShiftAssignment.class)

.groupBy(ShiftAssignment::getEmployee, ConstraintCollectors.count())

.map((employee, count) -> count)

.variance()

.penalize("Balanced shift assignments", HardSoftScore.ONE_SOFT);

}

// 其他约束类似,这里省略...

}

5.3.3 求解并输出结果

public class ShiftSchedulingApp {

public static void main(String[] args) {

// 1. 准备数据(员工、值班日)

List<Employee> employees = Arrays.asList(

new Employee(1L, "张三"),

new Employee(2L, "李四"),

new Employee(3L, "王五"),

new Employee(4L, "赵六"),

new Employee(5L, "周七")

);

List<Shift> shifts = Arrays.asList(

new Shift(LocalDate.of(2024, 5, 13), 3), // 周一

new Shift(LocalDate.of(2024, 5, 14), 3), // 周二

new Shift(LocalDate.of(2024, 5, 15), 3), // 周三

new Shift(LocalDate.of(2024, 5, 16), 3), // 周四

new Shift(LocalDate.of(2024, 5, 17), 3) // 周五

);

// 2. 创建规划问题

List<ShiftAssignment> shiftAssignments = new ArrayList<>();

for (Shift shift : shifts) {

for (int i = 0; i < shift.getRequiredEmployees(); i++) {

shiftAssignments.add(new ShiftAssignment(shift));

}

}

ShiftSchedulingProblem problem = new ShiftSchedulingProblem(employees, shifts, shiftAssignments);

// 3. 求解

SolverFactory<ShiftSchedulingProblem> solverFactory = SolverFactory.create(new SolverConfig()

.withSolutionClass(ShiftSchedulingProblem.class)

.withEntityClasses(ShiftAssignment.class)

.withConstraintProviderClass(ShiftSchedulingConstraintProvider.class)

.withTerminationSpentLimit(Duration.ofMinutes(1)));

Solver<ShiftSchedulingProblem> solver = solverFactory.buildSolver();

ShiftSchedulingProblem solution = solver.solve(problem);

// 4. 输出结果

for (Shift shift : solution.getShifts()) {

System.out.println("日期:" + shift.getDate());

for (ShiftAssignment assignment : solution.getShiftAssignments()) {

if (assignment.getShift().equals(shift) && assignment.getEmployee() != null) {

System.out.println(" 员工:" + assignment.getEmployee().getName());

}

}

}

}

}

5.4 结果解释

运行后,你会得到一个满足所有约束条件的值班表,比如:

周一:王五、赵六、周七(满足王五必须值班的约束);周二:张三、赵六、周七(满足张三和李四不同时值班的约束);周三:李四、王五、周七(满足每个员工每周最多值班2次的约束);等等。

OptaPlanner会自动调整员工的值班安排,让所有约束都被满足,同时让员工的值班时间尽可能均衡。

六、实际应用场景:规范性分析在哪里发挥作用?

6.1 供应链优化:让库存“不多不少”

问题:企业的库存太多,会占用资金;库存太少,会导致缺货。规范性分析的作用:用线性规划计算“最优库存水平”,比如“根据销量预测,下个月的库存应该保持在1000件,这样既能满足需求,又能最小化成本”。工具:Gurobi、OptaPlanner。

6.2 金融决策:推荐“最优投资组合”

问题:投资者想在风险最小的情况下,获得最大的收益。规范性分析的作用:用Markowitz模型(均值-方差模型)计算“最优投资组合”,比如“把30%的资金投股票,50%投债券,20%投基金,这样风险最小,收益最大”。工具:Matlab、Python的PyPortfolioOpt库。

6.3 智能推荐:让用户“更满意”

问题:电商平台想给用户推荐“他们最可能购买的商品”。规范性分析的作用:用强化学习训练推荐模型,比如“根据用户的浏览历史,推荐耳机的概率是80%,推荐键盘的概率是20%,这样能最大化用户的购买率”。工具:TensorFlow Agents、Stable Baselines3。

6.4 医疗诊断:帮医生“做决策”

问题:医生想给病人推荐“最优的治疗方案”(比如“化疗还是放疗”)。规范性分析的作用:用决策支持系统整合病人的病历、检查结果、治疗效果数据,推荐“最优的治疗方案”,比如“根据病人的病情,化疗的效果比放疗好30%,而且副作用更小”。工具:Tableau、Power BI、ThoughtSpot。

七、未来发展趋势与挑战

7.1 未来趋势

实时规范性分析:随着5G、物联网的发展,数据的产生速度越来越快,规范性分析需要“实时处理”(比如自动驾驶中的实时路线规划);自动决策生成:AI将自动生成决策规则(比如“如果用户浏览了健身视频,就推荐Keep”),不需要人工干预;解释性规范性分析:模型将能解释“为什么推荐这个决策”(比如“推荐Keep是因为它的用户重叠度高,而且你之前的行为显示你对健身感兴趣”),增加用户的信任;跨领域决策支持:规范性分析将整合多个领域的数据(比如供应链、金融、销售),提供“全局最优”的决策(比如“为了最大化利润,供应链应该增加库存,同时金融部门应该降低贷款利率”)。

7.2 挑战

数据质量:规范性分析依赖准确的数据,如果数据有错误(比如“用户的浏览历史被误记录”),结果会不可靠;模型复杂度:复杂的模型(比如深度强化学习)需要大量的计算资源,而且训练时间长;解释性:有些模型(比如深度学习)是“黑盒”,用户不知道“为什么推荐这个决策”,难以信任;伦理问题:规范性分析可能会推荐“不道德”的决策(比如“为了最大化利润,应该降低产品质量”),需要人工干预。

八、总结:大数据的终极价值是“帮你做选择”

8.1 核心概念回顾

规范性分析:回答“应该怎么做”的分析方法,核心是“在约束条件下寻找最优解”;优化算法:解决静态决策问题的工具(比如线性规划、整数规划);强化学习:解决动态决策问题的工具(比如Q-学习、深度强化学习);决策支持系统:把技术变成可用工具的应用(比如导航APP、Tableau)。

8.2 关键结论

大数据分析的终极价值不是“看数据”,而是“用数据做决策”;规范性分析是从“洞见”到“行动”的关键一步;工具的选择要根据场景(静态/动态)和需求(开源/商业):

静态决策(比如员工排班):用OptaPlanner、Gurobi;动态决策(比如推荐系统):用TensorFlow Agents、Stable Baselines3;可视化决策(比如销售 dashboard):用Tableau、Power BI。

九、思考题:动动小脑筋

你遇到过需要做“规范性决策”的问题吗?比如“选大学专业”“安排旅行路线”“买手机”,你会用什么工具解决?如果让你设计一个“智能冰箱”,它能根据冰箱里的食材推荐“今晚应该做什么菜”,你会用什么技术?为什么?规范性分析的“约束条件”和“目标函数”哪个更重要?为什么?

十、附录:常见问题与解答

Q1:规范性分析和预测性分析有什么区别?

A:预测性分析是“猜可能发生什么”(比如“明天会下雨”),而规范性分析是“告诉应该怎么做”(比如“明天应该带伞”)。预测性是规范性的基础,规范性是预测性的延伸。

Q2:开源工具和商业工具哪个好?

A:取决于你的需求:

如果你是学生或小公司,预算有限,用开源工具(比如PuLP、OptaPlanner);如果你是大企业,需要处理复杂问题,用商业工具(比如Gurobi、CPLEX),因为它们的性能更好,支持更完善。

Q3:强化学习比优化算法好吗?

A:不一定,要看场景:

如果场景是静态的(比如员工排班),优化算法更高效;如果场景是动态的(比如推荐系统),强化学习更适合,因为它能处理反馈和变化。

十一、扩展阅读 & 参考资料

《优化理论与应用》(作者:陈宝林):系统讲解优化算法的原理;《强化学习:原理与Python实现》(作者:王树森):用Python实现强化学习算法;OptaPlanner官网(https://www.optaplanner.org/):OptaPlanner的文档和例子;Gurobi官网(https://www.gurobi.com/):Gurobi的文档和教程;《大数据分析:从描述到规范》(作者:张三):讲解大数据分析的进化过程。

作者注:本文尽量用“小学生能听懂的语言”解释规范性分析,但其中的技术细节(比如线性规划的数学模型、强化学习的算法)需要你花时间去学习和实践。记住:大数据的价值不是“数据本身”,而是“用数据做正确的决策”。希望这篇文章能帮你迈出“用数据做决策”的第一步!

相关文章