有被这个Transformer 惊艳到!

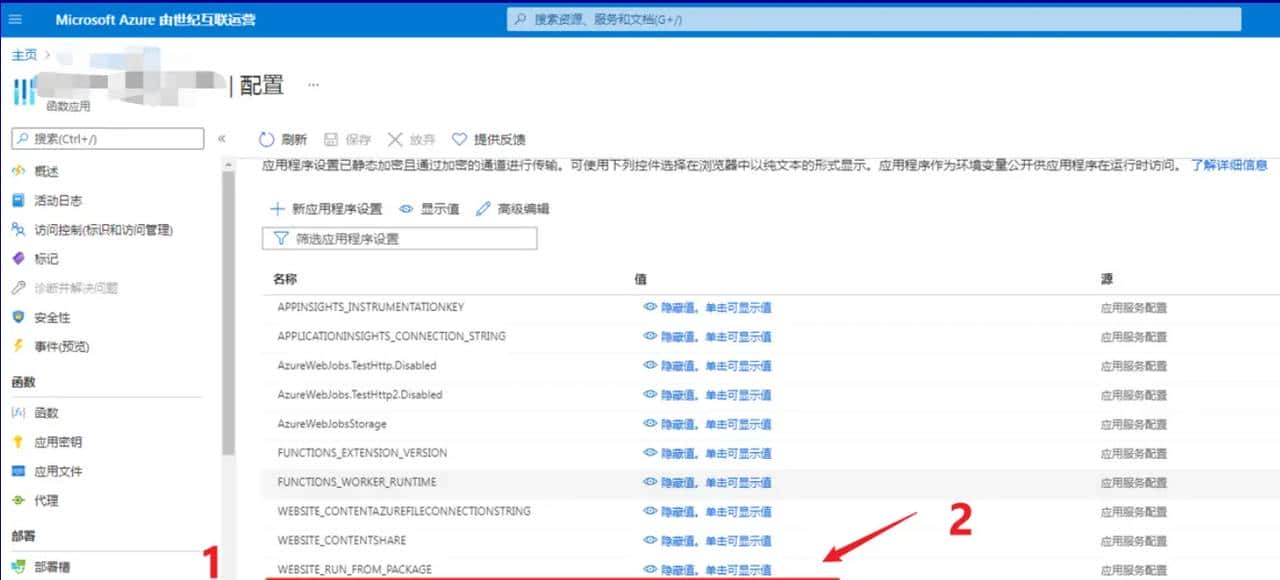

第一介绍四种不同类型的视觉语言预训练(VLP)模型,并归纳两种模态相互作用方式及三种视觉嵌入方式,最后探讨ViLT的设计思路。 视觉与语言模型分类:四种VLP模型的示意图中,各矩形的高度表明计算量的大小。VE、TE和MI分别代表视觉嵌入、文本嵌入和模态交互。模型的分类主要基于两个标准:一是两种模态在参数和计算上的平衡,二是两者在网络深层的交互程度。 VSE、VSE++和SCAN属于(a)类型,独立使用编码器处理图像和文本,其中图像占比更重,文本较轻,通过简单的点积或浅层注意力层计算特征类似性。CLIP则属于(b)类型,使用重型Transformer编码器处理每种模态,利用池化后的图像特征计算类似性。 ViLBERT、UNITER和Pixel-BERT属于(c)类型,这些模型在深层Transformer中实现交互,但因视觉嵌入仍依赖重型卷积网络,计算量较大。ViLT则是(d)类型的代表,首次将视觉嵌入设计得如文本嵌入一样轻量,主要计算聚焦于模态交互。 模态交互方式:模态交互可分为单流(single-stream)和双流(dual-stream)。ViLT选择单流交互方式,由于双流会引入额外计算开销。 视觉嵌入方式:现有VLP模型一般采用类BERT结构进行文本嵌入,而视觉嵌入则有所不同,主要有三类:区域特征、网格特征和切片投影。ViLT首次采用切片投影进行视觉嵌入。 ViLT模型概述:ViLT被认为是当前最简单的多模态Transformer。它利用预训练的ViT初始化交互Transformer,直接处理视觉特征,省去了额外视觉编码器的需求。 预训练目标:ViLT的预训练包含两个优化目标:图像文本匹配(ITM)和掩码语言建模(MLM)。在ITM中,随机将文本对应图像替换为其他图像,通过线性ITM头判断图像与文本是否匹配。MLM则通过上下文信息预测被掩码的文本标记,随机掩码15%的标记。 实验结果:ViLT在速度上相较于区域特征方法快60倍,较网格特征方法快4倍,同时在下游任务上展现出类似甚至更优的性能。

相关文章