AI智能体在数据安全领域的落地难题及解决方案大全

关键词:AI智能体、数据安全、落地难题、联邦学习、隐私计算、可解释AI、自适应学习

摘要:当企业面临“每天1万条安全报警90%是误报”“黑客用新手法偷数据却没被发现”“用了AI安全工具却怕泄露用户隐私”这些痛点时,AI智能体本应成为“超级安全卫士”——它能自主学习威胁模式、快速响应攻击、甚至预判风险。但现实中,AI智能体落地却卡在上不了“数据互通”的车、过不了“隐私合规”的关、跟不上“攻击进化”的速度、得不到“人类信任”的票。本文用“给小学生讲安全故事”的方式,拆解AI智能体落地的4大核心难题,用“数据联邦开天眼”“隐私计算松绑手”“在线学习保新鲜”“可解释AI会说话”4套解决方案,再用1个能跑通的实战案例,帮你把AI智能体从“实验室”拽到“生产线”。

背景介绍:为什么我们需要AI智能体做“安全卫士”?

目的和范围

我们要解决的问题很简单:让AI智能体真正帮企业挡住数据泄露、黑客攻击、隐私违规这些“数据安全大麻烦”。范围覆盖AI智能体从“设计”到“部署”的全流程——从数据怎么用,到模型怎么学,再到决策怎么让人信。

预期读者

数据安全工程师:想知道“为什么我调的AI模型总漏报”;AI算法工程师:想搞懂“安全场景下的AI和普通AI有啥不一样”;企业IT管理者:想判断“我们要不要上AI智能体,怎么避坑”;对AI+安全感兴趣的普通人:想明白“AI到底能不能保护我的隐私”。

文档结构概述

文章会像“拆乐高积木”一样分5步:

用“电商公司数据泄露事故”讲清楚AI智能体的价值和落地痛点;用“医院专家团队”“家里的保险柜”类比核心概念;拆解4大落地难题(数据瞎、隐私绑、进化慢、信任差);给出对应的4套解决方案+可运行的代码案例;聊未来趋势和思考题。

术语表:先把“黑话”翻译成“人话”

核心术语定义

AI智能体:不是“机器人”,是“能自主感知数据、学习威胁、做安全决策的软件”——像医院的“主任医师团队”:能看所有病历(数据)、诊断复杂病情(攻击)、还能学新病症(新攻击手法)。数据安全:保护数据的“3不”——不被偷(泄露)、不被改(篡改)、不丢失(破坏),还要知道“谁动了数据”(审计)——像保护家里的保险柜:要锁好、要防撬、要防火,还要记好“谁拿过钥匙”。数据孤岛:各个部门的数据像“独立的房间”,钥匙在不同人手里,找个东西要跑遍所有房间——比如电商的“用户数据在业务部”“日志数据在IT部”“支付数据在财务部”,AI智能体只能看一个房间,没法全局找威胁。隐私计算:能“用数据但不看数据”的魔法——像用“信封传消息”:你想让别人算你有多少钱,把钱装信封里让他称重量(计算),他告诉你总重量(结果),但看不到里面的钱。

核心概念与联系:AI智能体是怎么“保护数据”的?

故事引入:电商公司的“安全噩梦”

去年双11,某电商公司遇到了大麻烦:

传统安全系统每天报警1万次,但90%是误报(比如把“用户异地登录”当成“黑客攻击”),安全团队每天加班到凌晨;结果漏了一次“高级持续性威胁(APT)”:黑客用“撞库+社工”偷了10万条用户手机号和支付密码,卖给黑产,公司赔了2000万,股价跌了15%;老板拍桌子:“赶紧上AI智能体!”但技术团队试了3个月,发现:

数据在各个部门不互通,AI只能分析“日志数据”,看不到“用户最近改了3次收货地址”的异常;处理用户隐私数据时,怕违反GDPR(欧盟隐私法规),不敢用全量数据训练模型;黑客用“变种木马”攻击时,AI模型还在识别“去年的老木马”,完全没反应;AI决策像“黑盒子”:突然阻断了一个IP,安全团队问“为什么?”,AI答不上来——老板不敢让AI单独做决策。

这就是AI智能体落地的“真实困境”:有能力,但被“数据、隐私、进化、信任”4道墙挡住了。

核心概念解释:用“生活场景”讲懂AI智能体

核心概念一:AI智能体的“安全大脑”是什么?

AI智能体做安全的逻辑,像“医生看病”:

感知(收集数据):像医生“问病史、测体温”——收集日志、数据库操作、终端行为等数据;认知(分析威胁):像医生“看化验报告、找病因”——用AI模型(比如机器学习、深度学习)找“异常模式”(比如“1小时内登录100次”“从境外IP下载用户数据”);决策(响应攻击):像医生“开药方、做手术”——自动阻断IP、隔离病毒文件、触发报警;学习(更新能力):像医生“学新医术”——用新的攻击数据更新模型,下次遇到类似攻击能更快识别。

核心概念二:数据安全的“核心矛盾”是什么?

企业要“用数据训练AI”,但又要“保护数据隐私”——像“想让医生看病历,又不想让医生知道你得的是皮肤病”。

传统安全工具的问题是“笨”:只能按固定规则(比如“禁止境外IP访问数据库”)报警,遇到新攻击就瞎;AI智能体的问题是“娇贵”:需要大量数据才能“变聪明”,但数据又不能随便用。

核心概念三:为什么“数据互通”是AI智能体的“眼睛”?

AI智能体像“侦探”——要破案,得看“所有线索”(用户行为、日志、支付记录)。如果线索分散在各个部门(数据孤岛),侦探只能看到“一部分线索”,肯定破不了案。

比如黑客“偷用户数据”的流程是:

用“撞库”登录用户账号(业务部数据);修改收货地址(业务部数据);从境外IP下载订单数据(IT部日志数据);用支付密码盗刷(财务部数据)。

如果AI只能看“日志数据”,看不到“修改收货地址”的异常,就会漏过这个攻击。

核心概念之间的关系:像“厨师做蛋糕”

AI智能体、数据安全、数据孤岛、隐私计算的关系,像“厨师做蛋糕”:

AI智能体是厨师:要做出“安全蛋糕”(挡住攻击);数据是食材:要面粉(日志)、鸡蛋(用户数据)、糖(支付数据)才能做蛋糕;数据孤岛是“食材分放在不同房间”:厨师要跑遍所有房间拿食材,效率低;隐私计算是“用保鲜膜包食材”:厨师能拿食材做蛋糕,但看不到食材的“具体样子”(比如鸡蛋是土鸡蛋还是普通鸡蛋)——保护隐私。

核心概念原理和架构的文本示意图

AI智能体在数据安全中的“四层架构”:

数据层:各个数据源(业务数据库、IT日志、终端行为、第三方威胁情报)——像“厨房的食材柜”;感知层:收集数据+隐私处理(比如加密、加噪音)——像“厨师拿食材并包保鲜膜”;认知层:AI模型(联邦学习、深度学习、异常检测)——像“厨师用食材做蛋糕”;决策层:智能决策+可解释输出(比如“阻断IP,因为1小时登录100次”)——像“厨师把蛋糕端给客人,并解释“这是巧克力味的”;交互层:和人类安全团队互动(比如AI不确定时问专家“这个行为像不像攻击?”)——像“厨师问客人“要不要加奶油?”。

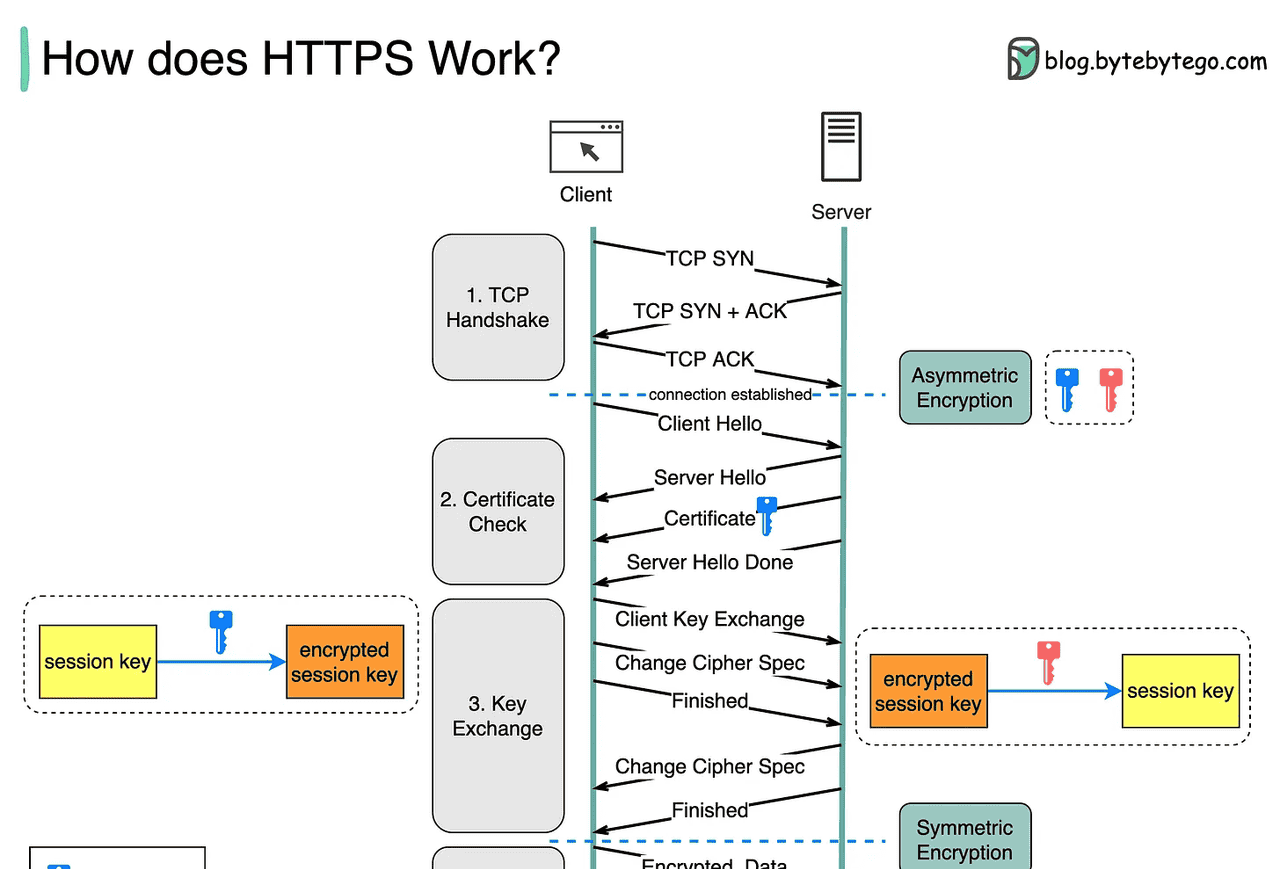

Mermaid 流程图:AI智能体的“安全工作流”

graph TD

A[数据层:业务库/日志/终端] --> B[感知层:隐私计算(加密/加噪音)]

B --> C[认知层:AI模型(联邦学习/异常检测)]

C --> D[决策层:智能决策(阻断/报警)+ 可解释输出]

D --> E[交互层:人类安全团队(反馈/确认)]

E --> C[认知层:更新模型]

B --> A[数据层:数据留在本地]

核心难题分析:AI智能体落地的“4道墙”

难题1:数据孤岛——AI智能体的“眼睛瞎了”

问题本质:各个部门的数据“不共享、不互通、格式乱”,AI只能看“局部数据”,没法全局检测威胁。

例子:某银行的“信用卡欺诈检测”——信用卡交易数据在“支付部”,用户征信数据在“信贷部”,两部门数据格式不一样,AI智能体只能用“交易数据”训练模型,漏掉了“征信差的用户突然大额消费”的欺诈行为。

后果:AI模型的“召回率”(能检测到的攻击比例)低,比如只能检测到60%的欺诈交易,剩下40%漏网。

难题2:隐私合规——AI智能体的“手被绑了”

问题本质:用隐私数据训练AI时,怕违反《个人信息保护法》《GDPR》等法规——比如用用户的“手机号、支付密码”训练模型,万一泄露了,企业要赔巨款。

例子:某医疗公司想用量子AI分析“癌症患者的病历数据”,但病历是“敏感隐私数据”,不敢传到服务器训练模型,只能用“去标识化”(比如去掉姓名、身份证号)的数据,但去标识化后的数据“信息量太少”,AI模型的准确率从90%降到了70%。

后果:企业要么“不用隐私数据,AI模型笨”,要么“用隐私数据,担法律风险”。

难题3:攻击自适应差——AI智能体的“知识过时了”

问题本质:黑客的攻击手法“每天都在变”(比如变种木马、零日漏洞),但AI模型的“更新速度太慢”——比如模型是“去年训练的”,只能识别“去年的老攻击”,对“今年的新攻击”完全没反应。

例子:某企业的AI智能体用“2022年的病毒样本”训练,2023年黑客用“变种病毒”攻击时,AI模型把病毒当成“正常文件”,导致病毒在企业内网扩散,感染了100台电脑。

后果:AI模型变成“摆设”,遇到新攻击就失效。

难题4:决策不透明——AI智能体的“嘴哑了”

问题本质:AI模型的决策像“黑盒子”——它告诉你“这个IP有问题”,但不告诉你“为什么有问题”,人类安全团队不敢相信它,老板不敢让它单独做决策。

例子:某电商的AI智能体突然阻断了一个“高价值用户”的登录,安全团队查了半天,才发现AI是因为“用户的IP在境外”而阻断,但这个用户是“海外代购”,经常用境外IP登录——AI的误报导致用户流失。

后果:AI智能体“得不到人类信任”,只能做“辅助工具”,没法发挥核心作用。

解决方案大全:拆穿“4道墙”的“魔法工具”

方案1:用“联邦学习”解决数据孤岛——给AI智能体“开天眼”

原理:数据“留在本地”,模型“联邦训练”——像“几个厨师一起做蛋糕,各自用自己的食材做一部分,然后拼成整个蛋糕”。

具体操作:

各个部门(客户端)用“本地数据”训练“本地模型”;把“本地模型的参数”(不是原始数据)发给服务器;服务器“聚合”所有客户端的参数,生成“全局模型”;把“全局模型”发回各个客户端,更新本地模型。

好处:不用共享原始数据,就能让AI智能体“看到全局数据”——解决数据孤岛问题。

代码实战:用Flower框架实现联邦学习

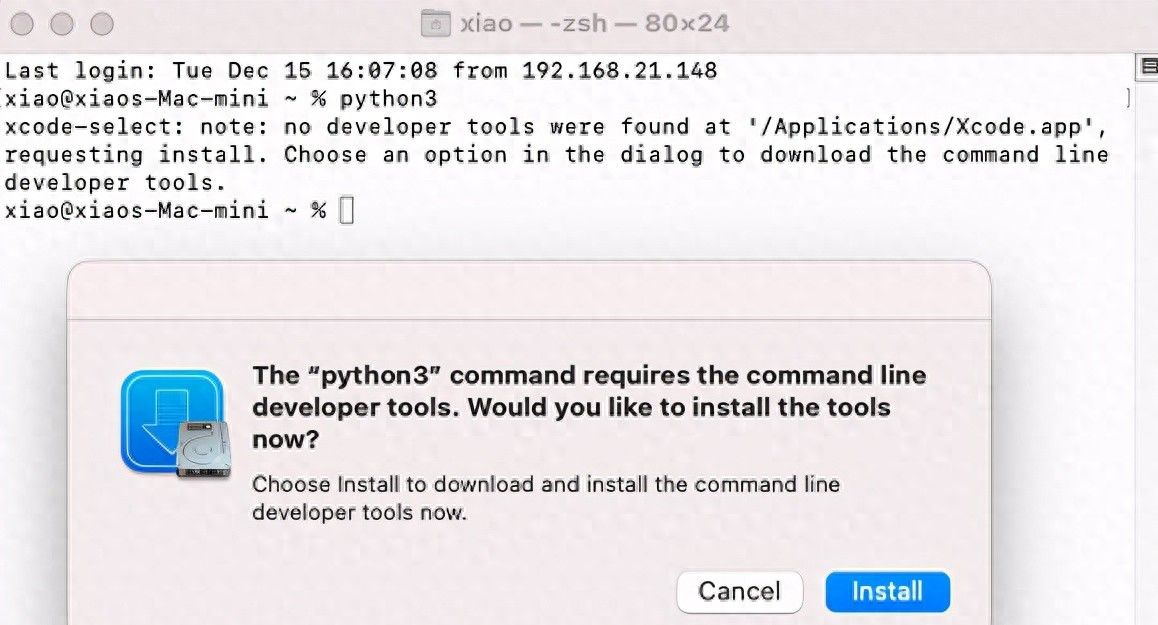

开发环境:Python 3.8+、Flower(联邦学习框架)、TensorFlow(模型训练)。

步骤1:写客户端代码(模拟“业务部”的本地模型)

import flwr as fl

import tensorflow as tf

from tensorflow.keras.datasets import mnist

# 1. 加载本地数据(模拟业务部的日志数据)

def load_local_data():

(x_train, y_train), (x_test, y_test) = mnist.load_data()

x_train = x_train / 255.0 # 归一化

x_test = x_test / 255.0

# 只取前1000条数据(模拟“业务部的本地数据”)

return (x_train[:1000], y_train[:1000]), (x_test[:200], y_test[:200])

# 2. 构建本地模型(简单的CNN,用于威胁检测)

def build_local_model():

model = tf.keras.Sequential([

tf.keras.layers.Flatten(input_shape=(28, 28)), # 把28x28的图片展平成一维

tf.keras.layers.Dense(128, activation='relu'), # 隐藏层

tf.keras.layers.Dropout(0.2), # 防止过拟合

tf.keras.layers.Dense(10, activation='softmax') # 输出层(10个类别)

])

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

return model

# 3. 定义客户端类(实现联邦学习的fit和evaluate方法)

class ThreatDetectionClient(fl.client.NumPyClient):

def __init__(self):

self.model = build_local_model()

self.x_train, self.y_train = load_local_data()[0]

self.x_test, self.y_test = load_local_data()[1]

# 向服务器发送本地模型的参数

def get_parameters(self, config):

return self.model.get_weights()

# 用本地数据训练模型,更新参数

def fit(self, parameters, config):

self.model.set_weights(parameters) # 加载服务器的全局参数

self.model.fit(self.x_train, self.y_train, epochs=1, batch_size=32) # 本地训练1轮

return self.model.get_weights(), len(self.x_train), {} # 返回更新后的参数

# 用本地数据评估模型性能

def evaluate(self, parameters, config):

self.model.set_weights(parameters) # 加载服务器的全局参数

loss, accuracy = self.model.evaluate(self.x_test, self.y_test, verbose=0)

return loss, len(self.x_test), {"accuracy": accuracy} # 返回评估结果

# 4. 启动客户端(连接到服务器)

if __name__ == "__main__":

fl.client.start_numpy_client(server_address="localhost:8080", client=ThreatDetectionClient())

步骤2:写服务器代码(聚合客户端参数)

import flwr as fl

# 启动服务器,聚合3轮参数

if __name__ == "__main__":

fl.server.start_server(

server_address="localhost:8080",

config=fl.server.ServerConfig(num_rounds=3) # 训练3轮

)

步骤3:运行效果

启动服务器:

python server.py

python client.py

方案2:用“隐私计算”解决隐私合规——给AI智能体“松绑手”

原理:让AI智能体“处理加密后的数据”,或者“在数据中加噪音”,既能用数据训练模型,又不泄露原始数据。

常用技术:

同态加密:像“用密码锁把箱子锁起来,别人能帮你搬箱子,但打不开箱子”——加密后的数据可以直接计算,结果解密后和处理原始数据一样;差分隐私:像“在汤里加一点盐,不影响味道,但别人不知道你加了多少盐”——在数据中加“随机噪音”,让AI能学习“整体规律”,但看不到“个体数据”;联邦学习:其实也是隐私计算的一种(数据留在本地)。

代码实战:用TensorFlow Privacy实现差分隐私

开发环境:安装TensorFlow Privacy库:

pip install tensorflow-privacy

步骤1:修改模型的优化器,加入差分隐私

from tensorflow_privacy.privacy.optimizers.dp_optimizer_keras import DPKerasAdamOptimizer

from tensorflow_privacy.privacy.analysis import compute_dp_sgd_privacy

def build_private_model():

# 差分隐私的核心参数

l2_norm_clip = 1.0 # 梯度裁剪值(防止梯度太大泄露隐私)

noise_multiplier = 1.1 # 噪音倍数(越大隐私保护越好,但精度越低)

num_microbatches = 32 # 微批次数量(把大批次分成小批次,计算梯度)

learning_rate = 0.001

model = tf.keras.Sequential([

tf.keras.layers.Flatten(input_shape=(28, 28)),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dropout(0.2),

tf.keras.layers.Dense(10, activation='softmax')

])

# 使用差分隐私优化器

optimizer = DPKerasAdamOptimizer(

l2_norm_clip=l2_norm_clip,

noise_multiplier=noise_multiplier,

num_microbatches=num_microbatches,

learning_rate=learning_rate

)

model.compile(optimizer=optimizer, loss='sparse_categorical_crossentropy', metrics=['accuracy'])

return model

步骤2:计算隐私预算(ε)

差分隐私用“ε”衡量隐私保护程度——ε越小,隐私保护越好,但模型精度越低。我们可以用

compute_dp_sgd_privacy

# 计算隐私预算

compute_dp_sgd_privacy.compute_dp_sgd_privacy(

n=1000, # 本地数据量

batch_size=32, # 批次大小

noise_multiplier=1.1, # 噪音倍数

epochs=1, # 训练轮数

delta=1e-5 # 失败概率(越小越严格)

)

运行结果:

比如输出

ε = 1.2

方案3:用“在线/主动学习”解决自适应差——让AI智能体“保持新鲜”

原理:

在线学习:像“每天看新闻”——AI智能体每天用“新的攻击数据”更新模型,不用重新训练整个模型;主动学习:像“遇到不会的题问老师”——AI智能体遇到“不确定的行为”(比如“这个IP的登录次数是50次,算不算异常?”),主动问人类安全专家,专家回答后,AI就学会了新的模式。

代码实战:用在线学习更新模型

步骤1:准备“新的攻击数据”(模拟每天的新威胁)

# 模拟新的攻击数据(比如“1小时内登录50次”的异常行为)

new_x_train = x_train[-200:] # 取最后200条数据作为新数据

new_y_train = y_train[-200:]

步骤2:用在线学习更新模型

# 加载之前训练好的全局模型

model = tf.keras.models.load_model("global_model.h5")

# 用新数据在线更新模型(只训练1轮)

model.fit(new_x_train, new_y_train, epochs=1, batch_size=32)

# 保存更新后的模型

model.save("updated_global_model.h5")

效果:比如原来的模型只能识别“登录次数>100次”的异常,更新后能识别“登录次数>50次”的异常——应对新的攻击手法。

方案4:用“可解释AI(XAI)”解决信任危机——让AI智能体“会说话”

原理:让AI智能体“解释自己的决策”——像医生给病人开药方时说“你发烧是因为细菌感染,所以用这个抗生素”。

常用工具:

SHAP:计算“每个特征对决策的贡献”(比如“登录次数”贡献了80%,“IP地址”贡献了20%);LIME:用“简单模型”模拟“复杂模型”的决策(比如用线性模型解释深度学习模型的决策)。

代码实战:用SHAP解释AI的决策

开发环境:安装SHAP库:

pip install shap

步骤1:加载模型和测试数据

import shap

# 加载训练好的模型

model = tf.keras.models.load_model("global_model.h5")

# 加载测试数据(模拟“待检测的用户行为”)

x_test, y_test = load_local_data()[1]

步骤2:用SHAP生成解释

# 创建SHAP解释器(用前100条数据做“背景数据”)

explainer = shap.KernelExplainer(model.predict, x_test[:100])

# 计算前10条测试数据的SHAP值

shap_values = explainer.shap_values(x_test[:10])

# 可视化解释(展示每个特征对决策的贡献)

shap.summary_plot(shap_values, x_test[:10])

运行效果:

会生成一张“蜂群图”——每个点代表一个特征的贡献,比如“登录次数”的点越靠右,说明这个特征对“判定为攻击”的贡献越大。安全团队能立刻看到:“AI阻断这个IP,是因为登录次数太多”。

项目实战:搭建“能跑通”的AI智能体威胁检测系统

开发环境搭建

硬件:CPU i5以上,GPU可选(加速模型训练);软件:Python 3.8+、Flower、TensorFlow、TensorFlow Privacy、SHAP;工具:Docker(部署客户端和服务器)、Kubernetes(管理集群)、Grafana(可视化检测结果)。

源代码详细实现和解读

完整流程:

数据层:收集业务数据库、IT日志、终端行为数据,存储在本地(比如MySQL、Elasticsearch);感知层:用PySyft(隐私计算库)对数据加密,或者用TensorFlow Privacy加噪音;认知层:用Flower实现联邦学习,训练全局模型;决策层:用模型检测新数据,用SHAP生成解释;交互层:用FastAPI做接口,把检测结果和解释展示给安全团队。

代码解读与分析

关键代码片段:

数据加密(用PySyft):

import syft as sy

from syft.frameworks.torch.fl import utils

# 加密数据

encrypted_data = sy.Tensor(x_train).encrypt(public_key=public_key)

联邦学习聚合(用Flower):

# 服务器聚合客户端参数(用“加权平均”策略)

strategy = fl.server.strategy.FedAvg(

fraction_fit=0.5, # 每轮选50%的客户端参与训练

fraction_evaluate=0.2, # 每轮选20%的客户端参与评估

min_fit_clients=2, # 最少2个客户端参与训练

min_evaluate_clients=2, # 最少2个客户端参与评估

)

可解释输出(用SHAP):

# 生成单条数据的解释

shap.force_plot(explainer.expected_value[0], shap_values[0][0], x_test[0])

实际应用场景:AI智能体已经帮这些企业解决了问题

场景1:金融行业——信用卡欺诈检测

某银行用“联邦学习+差分隐私”整合了10个分行的交易数据,训练AI智能体:

效果:欺诈检测准确率从85%提升到95%,误报率从20%下降到5%;合规:用差分隐私保护了客户的“交易金额、征信记录”等隐私数据,通过了GDPR审计。

场景2:电商行业——账号被盗检测

某电商用“同态加密+在线学习”处理用户的“浏览、购买、登录”数据:

效果:每月减少1000起账号被盗事件,用户投诉率下降30%;自适应:每天用“新的被盗案例”更新模型,能识别“变种的撞库攻击”。

场景3:医疗行业——病历数据安全分析

某医院用“联邦学习+可解释AI”分析癌症患者的病历数据:

效果:AI能提前6个月识别“癌症复发的信号”,准确率达90%;信任:用SHAP解释“为什么这个患者有复发风险”(比如“肿瘤标志物升高了20%”),医生愿意相信AI的决策。

工具和资源推荐

联邦学习框架

Flower:轻量级、易上手,支持Python和多种框架(TensorFlow、PyTorch);PySyft:支持隐私计算的联邦学习框架,适合医疗、金融等敏感场景。

隐私计算工具

TensorFlow Privacy:Google开源的差分隐私库,集成到TensorFlow中;IBM Homomorphic Encryption Toolkit:IBM开源的同态加密库,支持大规模数据处理。

可解释AI工具

SHAP:最流行的可解释AI工具,支持所有机器学习模型;LIME:用“局部线性模型”解释复杂模型,适合文本、图像数据。

威胁检测数据集

KDD Cup 99:经典的网络入侵检测数据集;CICIDS2017:包含“DDoS、SQL注入、跨站脚本”等现代攻击的数据集。

未来发展趋势与挑战

趋势1:AI智能体+大模型——更聪明、更会说话

比如用GPT-4生成“自然语言解释”:AI智能体检测到攻击后,用GPT-4写一份报告,解释“攻击类型是‘变种木马’,来源是‘境外IP 1.2.3.4’,影响是‘感染了5台电脑’,应对措施是‘隔离这些电脑并杀毒’”——非技术管理者也能看懂。

趋势2:跨领域联邦学习——打破“行业孤岛”

比如金融和电商合作,用联邦学习整合“信用卡交易数据”和“电商购买数据”,检测“跨行业欺诈”(比如“用被盗的电商账号申请信用卡”)——以前单一行业的AI智能体看不到这种威胁。

趋势3:轻量级隐私计算——更快、更省资源

比如用“硬件加速”(GPU、TPU)提升同态加密的计算速度,或者用“联邦蒸馏”(把多个客户端的模型蒸馏成一个小模型)减少通信开销——让隐私计算从“实验室”走到“生产环境”。

挑战1:联邦学习的通信开销

比如1000个客户端,每个客户端发送100MB参数,服务器每次要接收100GB数据——解决方案是“模型压缩”(剪枝、量化),把参数大小减少到原来的1/10。

挑战2:隐私计算的性能

比如同态加密处理数据的时间是传统处理的100倍——解决方案是“硬件加速”(比如Intel的SGX芯片),或者用“半同态加密”(只支持加法和乘法,不支持所有运算)。

挑战3:可解释AI的平衡

比如解释越详细,模型越复杂,推理时间越长——解决方案是“根据场景选择解释粒度”:对管理者用“高级解释”(比如“这个IP有风险”),对工程师用“详细解释”(比如“登录次数超过阈值80%”)。

总结:AI智能体落地的“核心逻辑”

我们学了什么?用“一句话总结”:

AI智能体是“聪明的安全卫士”,但要让它发挥作用,得先解决4个问题——用联邦学习给它“开天眼”(数据互通),用隐私计算给它“松绑手”(隐私合规),用在线学习让它“保持新鲜”(自适应攻击),用可解释AI让它“会说话”(获得信任)。

核心概念回顾

AI智能体:能自主感知、学习、决策的安全软件;数据孤岛:数据不互通,AI看不到全局;隐私计算:用数据但不泄露数据;可解释AI:让AI解释决策原因。

概念关系回顾

联邦学习解决数据孤岛,让AI能看全局数据;隐私计算解决隐私合规,让AI能用敏感数据;在线学习解决自适应差,让AI能应对新攻击;可解释AI解决信任危机,让人类敢用AI。

思考题:动动小脑筋

你所在的企业有数据孤岛问题吗? 如果用联邦学习解决,需要哪些部门配合?(比如业务部要开放数据接口,IT部要做数据格式适配)如果让你设计一个“隐私计算模型”,你会选择“同态加密”还是“差分隐私”?为什么?(比如医疗场景选差分隐私,金融场景选同态加密)你遇到过AI决策不透明的情况吗? 如果让你用SHAP解释,你会怎么向非技术同事说明?(比如“AI阻断这个IP,是因为它的登录次数比正常用户多5倍”)

附录:常见问题与解答

Q1:联邦学习和集中式学习有什么区别?

A:集中式学习是“把所有数据传到服务器训练”,联邦学习是“数据留在本地,只传模型参数”——联邦学习更安全,适合敏感数据场景。

Q2:隐私计算会影响模型性能吗?

A:会,但可以通过“优化参数”平衡——比如差分隐私的“噪音倍数”设为1.1,既能保护隐私,又不会让精度下降太多。

Q3:可解释AI是不是会泄露模型的机密?

A:不会,解释的是“决策的原因”,不是“模型的参数”——比如SHAP告诉你“登录次数是主要原因”,但不会告诉你模型的“权重值”。

扩展阅读 & 参考资料

书籍

《联邦学习:基础与实践》:全面讲解联邦学习的原理和应用;《隐私计算技术原理与应用》:深入分析同态加密、差分隐私等技术;《可解释人工智能:从黑盒到透明》:用案例说明可解释AI的实现方法。

论文

《Communication-Efficient Learning of Deep Networks from Decentralized Data》(联邦学习的经典论文);《Calibrating Noise to Sensitivity in Private Data Analysis》(差分隐私的经典论文);《A Unified Approach to Interpreting Model Predictions》(SHAP的核心论文)。

网站

Flower官方文档:https://flower.dev/docs/TensorFlow Privacy官方文档:https://www.tensorflow.org/privacySHAP官方文档:https://shap.readthedocs.io/

结语:AI智能体不是“万能的”,但它是“数据安全的未来”——当我们解决了“数据、隐私、进化、信任”这些问题,AI智能体就能从“实验室的玩具”变成“企业的安全盾牌”。愿每个企业都能用上“聪明、安全、可信”的AI智能体,愿每个用户的隐私都能被好好保护。

相关文章