大数据领域的分布式计算框架

关键词:大数据、分布式计算、MapReduce、Spark、Flink、Hadoop、数据处理

摘要:本文深入探讨大数据领域的分布式计算框架,从基础概念到核心原理,再到实际应用场景。我们将分析主流框架如Hadoop MapReduce、Spark和Flink的架构设计、性能特点和适用场景,并通过代码示例展示其使用方法。文章还将讨论分布式计算的数学模型、性能优化策略以及未来发展趋势,为读者提供全面的技术视角和实践指导。

1. 背景介绍

1.1 目的和范围

本文旨在全面解析大数据领域中分布式计算框架的技术原理、实现机制和应用实践。我们将重点关注以下几个方面:

分布式计算的基本概念和理论基础主流分布式计算框架的架构设计框架间的性能比较和适用场景分析实际应用案例和最佳实践未来技术发展趋势

1.2 预期读者

本文适合以下读者群体:

大数据工程师和架构师分布式系统开发人员数据科学家和分析师计算机科学相关专业的学生对大数据技术感兴趣的技术管理者

1.3 文档结构概述

本文采用从理论到实践的结构组织内容:

背景介绍:建立基本概念和知识框架核心概念:深入解析分布式计算原理主流框架分析:详细比较Hadoop、Spark和Flink数学模型:量化分析分布式计算性能实战案例:通过代码示例展示实际应用应用场景:探讨不同框架的适用领域工具资源:推荐学习和开发资源未来展望:探讨技术发展趋势

1.4 术语表

1.4.1 核心术语定义

大数据(Big Data):指传统数据处理应用软件无法处理的大规模、高增长率和多样化的信息资产分布式计算(Distributed Computing):将计算任务分解到多台计算机上并行执行的计算模式容错(Fault Tolerance):系统在部分组件发生故障时仍能继续正常运行的能力数据局部性(Data Locality):将计算任务调度到存储有所需数据的节点上执行的策略弹性(Elasticity):系统根据负载变化动态调整资源分配的能力

1.4.2 相关概念解释

批处理(Batch Processing):对大量静态数据进行一次性处理的计算模式流处理(Stream Processing):对连续不断产生的数据进行实时处理的计算模式有界数据(Bounded Data):有限、完整的数据集无界数据(Unbounded Data):无限、持续产生的数据流DAG(Directed Acyclic Graph):有向无环图,用于表示计算任务的依赖关系

1.4.3 缩略词列表

HDFS – Hadoop Distributed File SystemYARN – Yet Another Resource NegotiatorRDD – Resilient Distributed DatasetDAG – Directed Acyclic GraphAPI – Application Programming InterfaceSLA – Service Level AgreementRPC – Remote Procedure Call

2. 核心概念与联系

2.1 分布式计算的基本原理

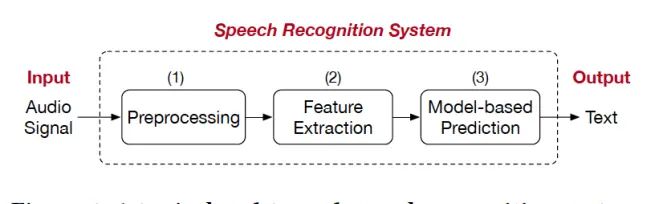

分布式计算框架的核心思想是将大规模计算任务分解为多个小任务,分配到多台计算机上并行执行,最后合并结果。这种模式解决了单机无法处理海量数据的问题。

2.2 主流框架架构对比

2.2.1 Hadoop MapReduce架构

2.2.2 Spark架构

2.2.3 Flink架构

2.3 计算模型比较

| 特性 | MapReduce | Spark | Flink |

|---|---|---|---|

| 计算模型 | 批处理 | 微批+流 | 真流处理 |

| 延迟 | 高 | 中 | 低 |

| 吞吐量 | 中 | 高 | 高 |

| 内存使用 | 低 | 高 | 中 |

| 状态管理 | 无 | 有限 | 完善 |

| 容错机制 | 任务重试 | RDD血统 | 检查点 |

| 迭代计算 | 差 | 优 | 优 |

| 机器学习支持 | 有限 | 丰富 | 丰富 |

3. 核心算法原理 & 具体操作步骤

3.1 MapReduce算法原理

MapReduce是最早的分布式计算模型之一,其核心思想是将计算过程分为Map和Reduce两个阶段。

# 伪代码示例

def map(key, value):

# 处理输入键值对,生成中间键值对

for word in value.split():

yield (word, 1)

def reduce(key, values):

# 合并相同键的值

yield (key, sum(values))

3.1.1 Map阶段

输入数据被分割成固定大小的块(通常64MB或128MB)每个数据块由一个Map任务处理Map函数处理输入键值对,生成中间键值对中间结果按key进行分区(partitioning)和排序(sorting)

3.1.2 Reduce阶段

从所有Map任务收集特定分区的数据对相同key的values进行归约操作输出最终结果到HDFS

3.2 Spark RDD操作原理

Spark的核心抽象是弹性分布式数据集(RDD),它代表一个不可变、可分区的元素集合。

# 创建RDD的两种方式

data = [1, 2, 3, 4, 5]

rdd1 = sc.parallelize(data) # 从内存集合创建

rdd2 = sc.textFile("hdfs://path/to/file") # 从外部存储创建

# 常见转换操作

mapped = rdd.map(lambda x: (x, 1))

filtered = rdd.filter(lambda x: x > 2)

reduced = rdd.reduce(lambda a, b: a + b)

# 行动操作触发计算

result = reduced.collect()

3.2.1 RDD特性

弹性(Resilient):通过血统(lineage)信息重建丢失的分区分布式(Distributed):数据分布在集群多个节点上数据集(Dataset):可以是任何类型的对象集合

3.2.2 RDD操作类型

转换(Transformations):从现有RDD创建新RDD(惰性执行)

map, filter, flatMap, groupBy, reduceByKey等

行动(Actions):触发实际计算并返回值

reduce, collect, count, saveAsTextFile等

3.3 Flink流处理原理

Flink采用基于操作符(operator)的流处理模型,支持事件时间和状态管理。

# Flink流处理示例

env = StreamExecutionEnvironment.get_execution_environment()

data_stream = env.add_source(KafkaSource(...)) # 从Kafka读取数据

# 定义处理逻辑

processed = data_stream

.map(lambda x: (x.user_id, 1))

.key_by(lambda x: x[0])

.window(TumblingEventTimeWindows.of(Time.seconds(5)))

.reduce(lambda a, b: (a[0], a[1] + b[1]))

# 输出结果

processed.add_sink(FileSink.for_row_format(...).build())

# 执行作业

env.execute("Flink Streaming Job")

3.3.1 Flink核心概念

时间语义:

事件时间(Event Time):数据产生的时间处理时间(Processing Time):系统处理数据的时间摄入时间(Ingestion Time):数据进入Flink的时间

状态管理:

算子状态(Operator State):与特定算子实例绑定的状态键控状态(Keyed State):与特定键绑定的状态状态后端(State Backend):管理状态的存储方式

容错机制:

检查点(Checkpoint):定期保存应用状态的快照保存点(Savepoint):手动触发的检查点,用于版本升级等场景

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 分布式计算性能模型

分布式计算系统的性能通常用以下指标衡量:

吞吐量(Throughput):单位时间内处理的数据量

延迟(Latency):从输入到输出所需时间

加速比(Speedup):相对于单机的性能提升

4.2 阿姆达尔定律(Amdahl’s Law)

阿姆达尔定律描述了并行计算中加速比的理论上限:

其中:

SSS是加速比PPP是可以并行化的部分比例NNN是处理器数量

示例:假设一个任务有60%可以并行(P=0.6P=0.6P=0.6),使用10个处理器(N=10N=10N=10):

4.3 数据局部性优化

数据局部性对分布式计算性能至关重要,考虑以下成本模型:

其中:

CcomputeC_{compute}Ccompute是计算成本CtransferC_{transfer}Ctransfer是数据传输成本

理想情况下,我们希望通过调度使CtransferC_{transfer}Ctransfer最小化:

4.4 CAP定理与一致性模型

分布式系统设计需要考虑CAP定理:

一致性(Consistency):所有节点看到相同数据可用性(Availability):每个请求都能获得响应分区容错性(Partition tolerance):网络分区时系统仍能工作

CAP定理指出,分布式系统最多只能同时满足其中两项。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

5.1.1 Hadoop环境配置

# 下载Hadoop

wget https://archive.apache.org/dist/hadoop/common/hadoop-3.3.1/hadoop-3.3.1.tar.gz

tar -xzf hadoop-3.3.1.tar.gz

cd hadoop-3.3.1

# 配置环境变量

export HADOOP_HOME=/path/to/hadoop-3.3.1

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

# 修改配置文件

vi etc/hadoop/core-site.xml

vi etc/hadoop/hdfs-site.xml

vi etc/hadoop/mapred-site.xml

vi etc/hadoop/yarn-site.xml

# 格式化HDFS

hdfs namenode -format

# 启动集群

start-dfs.sh

start-yarn.sh

5.1.2 Spark环境配置

# 下载Spark

wget https://archive.apache.org/dist/spark/spark-3.2.1/spark-3.2.1-bin-hadoop3.2.tgz

tar -xzf spark-3.2.1-bin-hadoop3.2.tgz

cd spark-3.2.1-bin-hadoop3.2

# 配置环境变量

export SPARK_HOME=/path/to/spark-3.2.1-bin-hadoop3.2

export PATH=$PATH:$SPARK_HOME/bin

# 启动Spark shell

spark-shell

5.1.3 Flink环境配置

# 下载Flink

wget https://archive.apache.org/dist/flink/flink-1.14.4/flink-1.14.4-bin-scala_2.12.tgz

tar -xzf flink-1.14.4-bin-scala_2.12.tgz

cd flink-1.14.4

# 配置环境变量

export FLINK_HOME=/path/to/flink-1.14.4

export PATH=$PATH:$FLINK_HOME/bin

# 启动本地集群

./bin/start-cluster.sh

5.2 源代码详细实现和代码解读

5.2.1 Hadoop WordCount示例

// WordCount.java

import java.io.IOException;

import java.util.StringTokenizer;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

public class WordCount {

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

public static class IntSumReducer

extends Reducer<Text,IntWritable,Text,IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "word count");

job.setJarByClass(WordCount.class);

job.setMapperClass(TokenizerMapper.class);

job.setCombinerClass(IntSumReducer.class);

job.setReducerClass(IntSumReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

5.2.2 Spark数据分析示例

# spark_analysis.py

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, count, desc

# 创建Spark会话

spark = SparkSession.builder

.appName("Data Analysis")

.getOrCreate()

# 读取数据

df = spark.read.csv("data/sales.csv", header=True, inferSchema=True)

# 数据清洗

cleaned_df = df.na.drop()

.filter((col("amount") > 0) & (col("quantity") > 0))

# 分析任务1: 按产品统计销售额

product_sales = cleaned_df.groupBy("product_id")

.agg({"amount": "sum"})

.withColumnRenamed("sum(amount)", "total_sales")

.orderBy(desc("total_sales"))

# 分析任务2: 按地区统计客户数量

customer_count = cleaned_df.groupBy("region")

.agg(count("customer_id").alias("customer_count"))

.orderBy(desc("customer_count"))

# 输出结果

product_sales.show()

customer_count.show()

# 保存结果

product_sales.write.csv("output/product_sales")

customer_count.write.csv("output/customer_count")

# 停止Spark会话

spark.stop()

5.2.3 Flink流处理示例

// FraudDetectionJob.java

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.KeyedProcessFunction;

import org.apache.flink.util.Collector;

import org.apache.flink.walkthrough.common.entity.Alert;

import org.apache.flink.walkthrough.common.entity.Transaction;

import org.apache.flink.walkthrough.common.source.TransactionSource;

public class FraudDetectionJob {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 创建交易数据流

DataStream<Transaction> transactions = env

.addSource(new TransactionSource())

.name("transactions");

// 按账户ID分组处理

DataStream<Alert> alerts = transactions

.keyBy(Transaction::getAccountId)

.process(new FraudDetector())

.name("fraud-detector");

// 输出警报

alerts

.addSink(new AlertSink())

.name("send-alerts");

env.execute("Fraud Detection");

}

public static class FraudDetector extends KeyedProcessFunction<Long, Transaction, Alert> {

private static final long serialVersionUID = 1L;

private static final double SMALL_AMOUNT = 1.00;

private static final double LARGE_AMOUNT = 500.00;

private static final long ONE_MINUTE = 60 * 1000;

@Override

public void processElement(

Transaction transaction,

Context context,

Collector<Alert> collector) throws Exception {

// 检测欺诈模式: 小额交易后立即大额交易

if (transaction.getAmount() < SMALL_AMOUNT) {

// 记录小额交易时间

context.timerService().registerProcessingTimeTimer(context.timestamp() + ONE_MINUTE);

} else if (transaction.getAmount() > LARGE_AMOUNT) {

// 检查是否在1分钟内有小额交易

Alert alert = new Alert();

alert.setId(transaction.getAccountId());

collector.collect(alert);

}

}

@Override

public void onTimer(long timestamp, OnTimerContext ctx, Collector<Alert> out) {

// 定时器触发时清除状态

}

}

}

5.3 代码解读与分析

5.3.1 Hadoop代码分析

Mapper类:

继承

Mapper<Object, Text, Text, IntWritable>

map

StringTokenizer

(word, 1)

Reducer类:

继承

Reducer<Text, IntWritable, Text, IntWritable>

reduce

Job配置:

设置Mapper、Combiner和Reducer类指定输入输出路径提交作业到集群执行

5.3.2 Spark代码分析

SparkSession:

应用程序的入口点配置应用名称和运行模式提供读取数据的API

DataFrame操作:

na.drop()

filter()

groupBy()

agg()

orderBy()

执行流程:

惰性执行:转换操作不立即执行行动操作触发实际计算结果可以显示或保存到存储系统

5.3.3 Flink代码分析

执行环境:

StreamExecutionEnvironment

关键概念:

KeyedProcessFunction

欺诈检测逻辑:

小额交易注册定时器大额交易检查是否在窗口期内满足条件生成警报

6. 实际应用场景

6.1 批处理场景 – Hadoop MapReduce

应用案例:日志分析系统

需求:分析TB级别的web服务器日志,统计:

每个URL的访问次数每个IP的请求分布高峰时段的流量模式

解决方案:

使用HDFS存储原始日志编写多个MapReduce作业处理不同分析任务使用Hive或Pig进行高层查询

优势:

处理超大规模数据高容错性成熟的生态系统

6.2 交互式分析 – Spark

应用案例:电商用户行为分析

需求:

实时查询用户行为模式快速迭代分析算法支持机器学习模型训练

解决方案:

使用Spark SQL进行交互式查询Spark MLlib构建推荐模型内存计算加速迭代过程

优势:

亚秒级响应时间支持复杂分析工作流与Python生态良好集成

6.3 实时流处理 – Flink

应用案例:金融交易监控

需求:

实时检测异常交易模式毫秒级延迟要求精确一次处理语义

解决方案:

Flink流处理作业消费交易数据流基于事件时间的窗口计算状态管理跟踪用户行为

优势:

低延迟处理强大的状态管理端到端一致性保证

6.4 混合场景 – Lambda架构

应用案例:物联网数据分析

需求:

实时监控设备状态历史数据分析统一查询接口

解决方案:

速度层:Flink处理实时数据批处理层:Spark分析历史数据服务层:合并查询结果

优势:

兼顾实时性和准确性灵活应对不同需求可扩展性强

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《Hadoop权威指南》- Tom White《Spark快速大数据分析》- Holden Karau等《Stream Processing with Apache Flink》- Fabian Hueske等《Designing Data-Intensive Applications》- Martin Kleppmann《大数据日知录》- 张俊林

7.1.2 在线课程

大数据专项课程(Coursera – 加州大学圣地亚哥分校)Apache Spark官方培训(Databricks)Flink官方培训(Ververica)Hadoop管理与开发实战(Udemy)大数据处理技术(edX – 清华大学)

7.1.3 技术博客和网站

Apache项目官方文档Cloudera Engineering BlogDatabricks BlogFlink中文社区美团技术团队博客

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

IntelliJ IDEA(Java/Scala开发)PyCharm(Python开发)VS Code(轻量级多语言支持)Jupyter Notebook(交互式数据分析)Zeppelin Notebook(大数据可视化)

7.2.2 调试和性能分析工具

Spark UI(监控Spark作业)Flink Web Dashboard(监控Flink作业)YARN ResourceManager UI(监控集群资源)JVM Profiler(分析内存和CPU使用)Ganglia/Prometheus(集群监控)

7.2.3 相关框架和库

Apache Kafka(消息队列)Apache HBase(分布式数据库)Apache Hive(数据仓库)Apache Beam(统一批流API)TensorFlow/PyTorch(机器学习)

7.3 相关论文著作推荐

7.3.1 经典论文

“MapReduce: Simplified Data Processing on Large Clusters” – Google“Resilient Distributed Datasets: A Fault-Tolerant Abstraction for In-Memory Cluster Computing” – UC Berkeley“Apache Flink: Stream and Batch Processing in a Single Engine” – TU Berlin“The Dataflow Model: A Practical Approach to Balancing Correctness, Latency, and Cost in Massive-Scale, Unbounded, Out-of-Order Data Processing” – Google“Spark SQL: Relational Data Processing in Spark” – Databricks

7.3.2 最新研究成果

“State Management for Apache Flink’s Savepoints” – VLDB 2022“Adaptive Query Execution in Spark SQL” – SIGMOD 2021“Real-time Machine Learning with Flink” – DEBS 2022“Optimizing Shuffle Performance in Spark” – USENIX ATC 2023“Energy-Efficient Big Data Processing” – IEEE TPDS 2023

7.3.3 应用案例分析

“Scaling Apache Spark at Facebook” – Facebook Engineering“Real-time Analytics at Alibaba with Flink” – Alibaba Tech“Hadoop Optimization at Yahoo” – Yahoo Research“Uber’s Big Data Platform” – Uber Engineering“Netflix’s Data Pipeline Evolution” – Netflix TechBlog

8. 总结:未来发展趋势与挑战

8.1 技术发展趋势

批流一体化:

框架趋向统一批处理和流处理模型如Spark Structured Streaming和Flink的批流统一API减少技术栈复杂度,提高开发效率

云原生架构:

容器化部署(Kubernetes集成)弹性伸缩和按需资源分配与云存储服务的深度集成

AI与大数据融合:

分布式框架原生支持机器学习自动特征工程和模型部署联邦学习等隐私保护技术

性能优化创新:

基于GPU/TPU的加速计算更智能的查询优化器自适应执行计划

边缘计算集成:

边缘设备与中心集群协同计算低延迟的本地处理分层的数据处理架构

8.2 面临挑战

数据治理难题:

数据质量、血缘和元数据管理合规性和隐私保护要求多租户环境下的资源隔离

复杂性管理:

分布式系统调试难度大性能瓶颈定位困难配置参数调优复杂

技能缺口:

同时精通分布式系统和领域知识的专家稀缺新技术的学习曲线陡峭理论与实践结合的挑战

成本控制:

集群资源利用率优化存储计算分离架构的成本平衡云环境下的成本预测和管理

技术选型困境:

多种框架并存,选择困难技术锁定风险迁移和集成的成本

8.3 建议与展望

技术选型原则:

根据数据特征(大小、速度、多样性)选择框架优先考虑团队熟悉度和社区支持评估长期维护成本而非短期便利

架构设计建议:

采用模块化设计,保持组件可替换性考虑混合架构应对不同场景需求预留扩展能力应对数据增长

人才培养策略:

建立持续学习机制鼓励参与开源社区理论与实践结合的培训计划

未来展望:

更智能的自动化运维工具无服务器(Serverless)大数据处理量子计算对分布式算法的潜在影响数据网格(Data Mesh)等新型架构范式

9. 附录:常见问题与解答

Q1: Hadoop、Spark和Flink应该如何选择?

A1: 选择取决于具体需求:

Hadoop MapReduce适合:

超大规模批处理对延迟不敏感的离线作业需要成熟稳定解决方案的场景

Spark适合:

需要交互式查询或迭代计算批处理和准实时处理混合场景机器学习工作流集成

Flink适合:

低延迟流处理需求需要精确一次语义的场景复杂事件处理和状态管理

Q2: 分布式计算框架的性能调优有哪些通用原则?

A2: 通用调优原则包括:

数据局部性:

尽量让计算靠近数据合理设置数据分片大小

资源分配:

根据作业需求调整executor/container数量平衡CPU、内存和I/O资源

并行度优化:

设置合适的任务并行度避免数据倾斜

内存管理:

调整JVM参数合理使用堆外内存控制shuffle缓冲区大小

I/O优化:

使用列式存储格式(Parquet/ORC)压缩中间数据合理设置副本因子

Q3: 如何处理数据倾斜问题?

A3: 数据倾斜的常见解决方案:

预处理:

采样识别热点key提前分离热点数据

技术手段:

增加随机前缀/后缀分散热点使用两阶段聚合自定义分区器

框架特性:

Spark的

repartition

coalesce

rebalance

rescale

TotalOrderPartitioner

算法优化:

使用sketch算法(如Bloom Filter)近似计算替代精确计算分治策略处理大key

Q4: 如何保证分布式计算的一致性?

A4: 一致性保证策略:

处理语义:

至少一次(At-least-once):通过重试保证至多一次(At-most-once):不重试精确一次(Exactly-once):需要检查点机制

实现方式:

幂等写入事务性输出两阶段提交(2PC)

框架支持:

Spark的WAL和checkpointFlink的分布式快照Kafka的事务消息

Q5: 分布式计算框架如何与机器学习集成?

A5: 集成方式包括:

原生支持:

Spark MLlibFlink ML

扩展库:

TensorFlowOnSparkHorovod on Spark

流水线架构:

使用框架进行特征工程分布式训练模型模型部署和服务化

新兴技术:

联邦学习框架自动机器学习(AutoML)集成深度学习与图计算结合

10. 扩展阅读 & 参考资料

Apache Hadoop官方文档: https://hadoop.apache.org/docs/current/Apache Spark官方文档: https://spark.apache.org/docs/latest/Apache Flink官方文档: https://flink.apache.org/《Designing Data-Intensive Applications》- Martin Kleppmann (O’Reilly)《Big Data: Principles and best practices of scalable realtime data systems》- Nathan Marz (Manning)Google MapReduce论文: https://research.google/pubs/pub62/Spark RDD论文: https://www.usenix.org/system/files/conference/nsdi12/nsdi12-final138.pdfFlink架构论文: https://dl.acm.org/doi/10.1145/2723372.2742796数据流模型论文: https://research.google/pubs/pub43864/分布式系统理论: https://www.cs.yale.edu/homes/aspnes/classes/465/notes.pdf

相关文章