高并发系统设计:负载均衡策略的最佳实践与避坑指南

一、引言:为什么你的系统在高并发下会“翻车”?

1. 一个真实的“双11惨案”

2022年双11零点,某垂直电商平台的服务器突然集体“罢工”:用户打不开商品页、购物车清空、支付失败,短短10分钟内损失了近2000万订单。事后复盘发现,问题根源不是后端服务器性能不足,而是负载均衡策略选反了——他们给所有服务器配置了“轮询”策略,但其中两台服务器是刚扩容的低配机型(4核8G),和原有高配机型(8核16G)混在一起。结果零点流量涌入时,低配服务器瞬间被压垮,进而拖垮了整个集群。

这不是个例。我见过太多团队把“负载均衡”当成“配置一下就行”的工具,却忽略了策略选择的底层逻辑——它不是“均分请求”的工具,而是“让正确的请求到正确的服务器”的调度器。

2. 负载均衡:高并发系统的“交通指挥中心”

在高并发场景下,单台服务器的处理能力(比如每秒处理1000请求)永远无法满足需求(比如每秒10万请求)。负载均衡的核心作用,就是将海量请求“合理分发”到多台服务器上,解决三个关键问题:

避免单点故障:某台服务器宕机时,自动将请求转移到其他服务器;提高资源利用率:不让高配服务器“闲得慌”,也不让低配服务器“累到死”;降低系统延迟:让请求优先到响应最快的服务器,提升用户体验。

换句话说,负载均衡是高并发系统的“第一道防线”——它没做好,后面的缓存、数据库优化都是“空中楼阁”。

3. 本文能给你带来什么?

如果你是:

刚接触高并发的后端工程师,想搞懂“负载均衡到底怎么选”;正在优化系统的架构师,想解决“负载不均”“会话丢失”等痛点;负责运维的同学,想避免“负载均衡器自己成为瓶颈”;

那么这篇文章会帮你:

搞懂8种常见负载均衡策略的原理、适用场景和优缺点;掌握5个实战最佳实践(分层架构、健康检查、动态调整等);避开7个新手常踩的陷阱(比如忽略服务器性能差异);学会根据场景选择策略(比如微服务用什么?电商用什么?)。

二、基础知识:先搞懂负载均衡的“底层逻辑”

在讲策略前,我们需要先统一认知——负载均衡的核心概念和分类。

1. 负载均衡的核心概念

负载均衡器(LoadBalancer):负责分发请求的“调度中心”,比如Nginx、LVS、AWS ALB;后端服务器(Backend Servers):接收并处理请求的服务器集群,比如Web服务器、API服务器;上游(Upstream):负载均衡器配置中的后端服务器组(比如Nginx的

upstream

2. 负载均衡的三大分类

(1)按“实现方式”分:硬件vs软件

硬件负载均衡:比如F5 BIG-IP,是专用的硬件设备,性能极强(每秒处理百万级请求),但价格昂贵(一台几十万),适合大型企业核心系统;软件负载均衡:比如Nginx、LVS、HAProxy,是运行在通用服务器上的软件,成本低、灵活,适合中小企业或云原生场景。

(2)按“OSI层级”分:四层vs七层

OSI模型将网络通信分为7层,负载均衡主要作用在四层(传输层)和七层(应用层):

四层负载均衡:基于IP和端口转发(比如TCP/UDP),不解析应用层数据(比如HTTP头、URL)。优点是性能高(不需要处理应用层逻辑),缺点是不够灵活(无法根据内容路由)。典型代表:LVS、AWS NLB;七层负载均衡:基于应用层协议转发(比如HTTP、HTTPS),可以解析请求的URL、Header、参数。优点是灵活(比如根据URL路由到不同服务),缺点是性能稍低(需要解析应用层数据)。典型代表:Nginx、HAProxy、AWS ALB。

举个通俗的例子:

四层负载均衡像“快递分拣中心”——只看快递上的“收件人地址(IP+端口)”,不打开快递;

七层负载均衡像“超市导购员”——不仅看你要去的“楼层(IP+端口)”,还看你要买“零食还是日用品(URL/Header)”,然后带你去对应的货架。

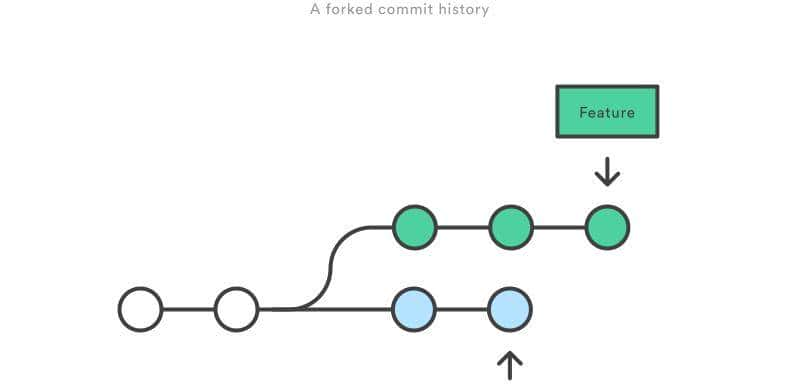

(3)按“策略类型”分:静态vs动态

静态策略:根据固定规则分发请求,不考虑服务器实时状态(比如轮询、IP哈希);动态策略:根据服务器实时状态(比如连接数、CPU利用率、响应时间)调整策略(比如最少连接、最快响应时间)。

三、核心内容:8种负载均衡策略详解

这部分是文章的“重头戏”——我们逐个拆解常见策略,告诉你什么时候用、怎么用、不用的后果。

策略1:轮询(Round Robin)——最简单但最容易“翻车”

原理

按顺序将请求分发到后端服务器,比如服务器A→B→C→A→B→C…循环。

适用场景

后端服务器配置完全一致(比如都是8核16G);请求处理时间短且均匀(比如静态文件服务)。

优缺点

| 优点 | 缺点 |

|---|---|

| 实现简单,无需配置 | 不考虑服务器性能差异,容易导致负载不均 |

| 适用于同构集群 | 无法处理会话一致性(同一用户请求可能到不同服务器) |

实战配置(Nginx)

upstream backend {

server 192.168.1.101:80; # 服务器A

server 192.168.1.102:80; # 服务器B

server 192.168.1.103:80; # 服务器C

}

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://backend; # 转发到upstream

}

}

踩坑提醒

如果后端服务器配置不一致(比如A是8核,B是4核),用轮询会导致B服务器过载——永远不要对异构集群用轮询!

策略2:加权轮询(Weighted Round Robin)——解决“性能差异”的神器

原理

给每台服务器分配一个“权重”,权重越高,接收的请求越多。比如服务器A权重3、B权重2、C权重1,那么请求比例是3:2:1。

适用场景

后端服务器配置不同(比如高配、中配、低配混合);需要按性能分配请求(比如让高配服务器处理更多请求)。

优缺点

| 优点 | 缺点 |

|---|---|

| 适配异构集群 | 权重需要手动调整,无法动态适应流量变化 |

| 实现简单 | 不考虑服务器实时负载(比如某台服务器突然变卡) |

实战配置(Nginx)

upstream backend {

server 192.168.1.101:80 weight=3; # 高配,权重3

server 192.168.1.102:80 weight=2; # 中配,权重2

server 192.168.1.103:80 weight=1; # 低配,权重1

}

实战案例

某短视频平台的转码服务:高配服务器(16核32G)权重5,中配(8核16G)权重3,低配(4核8G)权重1。这样转码任务会优先分配给高配服务器,避免低配服务器“扛不住”。

策略3:IP哈希(IP Hash)——解决“会话一致性”的入门方案

原理

将用户的IP地址进行哈希计算,得到一个数值,然后映射到对应的服务器。同一IP的请求永远落到同一台服务器,保证会话一致性(比如购物车数据存在服务器内存中时,不会丢失)。

适用场景

需要会话粘滞(Session Sticky)的场景(比如传统的PHP会话、Java Session);用户IP分布较均匀(比如全国用户访问)。

优缺点

| 优点 | 缺点 |

|---|---|

| 保证会话一致性 | IP分布不均会导致负载不均(比如某地区用户集中) |

| 实现简单 | 服务器宕机时,该IP的会话会丢失(需要会话迁移) |

实战配置(Nginx)

upstream backend {

ip_hash; # 开启IP哈希

server 192.168.1.101:80;

server 192.168.1.102:80;

server 192.168.1.103:80;

}

踩坑提醒

不要用IP哈希处理“大量同一IP”的场景(比如公司内网用户用同一个出口IP),会导致某台服务器被“压爆”;必须配合分布式会话(比如Redis存储Session)——否则服务器宕机时,用户会话会丢失。

策略4:最少连接(Least Connections)——应对“长连接”的利器

原理

将请求分发到当前连接数最少的服务器。连接数是指服务器正在处理的请求数(比如TCP连接数、HTTP请求数)。

适用场景

请求处理时间长且波动大(比如文件上传、数据库查询);连接数是主要负载指标(比如数据库代理服务)。

优缺点

| 优点 | 缺点 |

|---|---|

| 动态适应服务器负载 | 需要实时统计连接数,对负载均衡器性能有要求 |

| 避免服务器过载 | 不考虑服务器性能差异(比如高配服务器连接数多但仍有能力处理) |

实战配置(Nginx)

Nginx默认不支持最少连接,需要安装

ngx_http_upstream_module

upstream backend {

least_conn; # 开启最少连接

server 192.168.1.101:80;

server 192.168.1.102:80;

server 192.168.1.103:80;

}

实战案例

某在线教育平台的直播服务:直播是长连接(每个用户连接持续几十分钟),用最少连接策略可以避免某台服务器连接数过多导致卡顿。

策略5:加权最少连接(Weighted Least Connections)——更灵活的“最少连接”

原理

在最少连接的基础上,给服务器加权重——比如高配服务器权重3,那么它的“有效连接数”是实际连接数/3,负载均衡器会选择“有效连接数最少”的服务器。

适用场景

后端服务器配置不同,且请求处理时间波动大;需要兼顾性能和负载(比如API服务器集群)。

优缺点

| 优点 | 缺点 |

|---|---|

| 适配异构集群 | 配置稍复杂(需要同时设置权重和最少连接) |

| 动态调整负载 | 依赖实时连接数统计 |

实战配置(HAProxy)

HAProxy原生支持加权最少连接:

backend backend

balance leastconn # 最少连接

server s1 192.168.1.101:80 weight 3

server s2 192.168.1.102:80 weight 2

server s3 192.168.1.103:80 weight 1

策略6:最快响应时间(Fastest Response Time)——对延迟敏感场景的首选

原理

将请求分发到最近一次响应时间最快的服务器。负载均衡器会记录每台服务器的响应时间(比如处理上一个请求用了10ms),然后选择最快的那个。

适用场景

对延迟敏感的场景(比如实时视频、在线游戏、金融交易);服务器分布在不同地域(比如跨机房、跨云)。

优缺点

| 优点 | 缺点 |

|---|---|

| 最低延迟 | 需要实时收集响应时间,有一定延迟 |

| 提升用户体验 | 可能导致“热门服务器”负载过高(比如某台服务器响应一直很快,请求都涌过去) |

实战配置(HAProxy)

HAProxy支持最快响应时间策略:

backend backend

balance roundrobin # 基础策略

server s1 192.168.1.101:80 check inter 5000 rise 2 fall 3

server s2 192.168.1.102:80 check inter 5000 rise 2 fall 3

server s3 192.168.1.103:80 check inter 5000 rise 2 fall 3

balance leastconn # 或者用leastconn结合响应时间

# 开启响应时间统计

option httpchk GET /health

http-check expect status 200

策略7:URL哈希(URL Hash)——静态资源缓存的“黄金搭档”

原理

将请求的URL进行哈希计算,映射到对应的服务器。同一URL的请求永远落到同一台服务器,这样服务器可以缓存该URL的资源(比如图片、CSS、JS),减少回源次数。

适用场景

静态资源服务(比如CDN节点、图片服务器);需要缓存命中率的场景(比如电商的商品图片)。

优缺点

| 优点 | 缺点 |

|---|---|

| 提高缓存命中率 | URL分布不均会导致负载不均(比如某张热门图片的URL哈希到某台服务器) |

| 减轻后端压力 | 无法处理动态内容(比如API请求) |

实战配置(Nginx)

需要安装

ngx_http_upstream_hash_module

upstream backend {

hash $request_uri consistent; # 按URL哈希,consistent是一致性哈希(避免服务器变动导致哈希重新计算)

server 192.168.1.101:80;

server 192.168.1.102:80;

server 192.168.1.103:80;

}

实战案例

某图片托管平台:用户上传的图片URL是

https://img.example.com/abc123.jpg

策略8:基于内容的路由(Content-Based Routing)——微服务架构的“必备技能”

原理

根据请求的内容(比如URL路径、HTTP头、参数)分发到不同的后端服务。比如:

/api/user

/api/order

/static

适用场景

微服务架构(将不同功能的服务拆分,按需路由);需要细粒度控制的场景(比如将支付请求路由到高安全级别的服务器)。

优缺点

| 优点 | 缺点 |

|---|---|

| 高度灵活 | 配置复杂(需要解析应用层数据) |

| 适配微服务 | 性能比四层负载均衡低 |

实战配置(Nginx)

# 用户服务上游

upstream user_service {

server 192.168.1.201:8080 weight=3;

server 192.168.1.202:8080 weight=2;

}

# 订单服务上游

upstream order_service {

server 192.168.1.301:8081;

server 192.168.1.302:8081;

}

# 静态资源上游

upstream static_service {

server 192.168.1.401:80;

server 192.168.1.402:80;

}

server {

listen 80;

server_name example.com;

# 用户服务路由

location /api/user {

proxy_pass http://user_service;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

}

# 订单服务路由

location /api/order {

proxy_pass http://order_service;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

}

# 静态资源路由(缓存7天)

location /static {

proxy_pass http://static_service;

expires 7d;

}

}

实战案例

某电商平台的微服务架构:

用户登录请求

/api/user/login

/api/order/create

/static/img/product

策略9:动态负载均衡(Dynamic Load Balancing)——云原生时代的“终极方案”

原理

结合实时监控数据(CPU利用率、内存 usage、磁盘IO、网络带宽、响应时间)动态调整负载均衡策略。比如:

当某台服务器CPU利用率超过80%,自动降低其权重;当流量高峰到来时,自动切换到“最快响应时间”策略;当新服务器扩容时,自动将其加入负载均衡集群。

适用场景

云原生/容器化环境(比如Kubernetes集群,Pod动态扩缩容);流量波动大的场景(比如电商大促、直播带货);需要自动化运维的场景(减少手动操作)。

实现方式

动态负载均衡需要三个组件配合:

监控系统:收集服务器实时 metrics(比如Prometheus、Grafana);决策引擎:根据metrics生成负载均衡策略(比如Kubernetes的kube-proxy、Istio);执行器:将策略应用到负载均衡器(比如Nginx的动态配置、云服务商的API)。

实战案例(Kubernetes + Istio)

Istio是云原生时代的服务网格,支持动态负载均衡:

监控:Istio收集每个Pod的metrics(响应时间、错误率、QPS);策略:配置“基于权重的流量分割”(比如将10%的流量转发到新版本Pod,验证稳定性);执行:Istio的Sidecar代理(Envoy)自动执行负载均衡策略。

Istio的动态负载均衡配置示例:

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: backend

spec:

hosts:

- backend

http:

- route:

- destination:

host: backend

subset: v1

weight: 90 # 90%流量到v1版本

- destination:

host: backend

subset: v2

weight: 10 # 10%流量到v2版本

四、进阶探讨:负载均衡的最佳实践与避坑指南

掌握了策略还不够——实战中90%的问题,是因为没做好“配套措施”。这部分我们讲5个最佳实践,帮你把负载均衡“用对”。

最佳实践1:分层负载均衡——从“单节点”到“全局调度”

为什么要分层?

单台负载均衡器无法处理超大规模流量(比如每秒100万请求),而且容易成为单点故障。分层负载均衡的核心是将流量分阶段处理,每一层解决一个问题:

典型分层架构(从用户到后端)

第一层:DNS负载均衡(全局调度)

将域名解析到多个地域的负载均衡器(比如把

example.com

实现方式:DNS轮询、GeoDNS(根据用户地理位置解析)。

第二层:四层负载均衡(性能层)

用LVS或云服务商的四层负载均衡(比如AWS NLB)处理TCP请求,解决“高并发性能”问题(四层负载均衡每秒能处理百万级请求)。

第三层:七层负载均衡(灵活层)

用Nginx或HAProxy处理HTTP请求,解决“内容路由”问题(比如根据URL转发到不同服务)。

第四层:服务内负载均衡(微服务层)

用服务网格(比如Istio)或RPC框架(比如Dubbo)处理微服务间的请求,解决“动态Pod调度”问题(Kubernetes Pod扩缩容时自动更新负载均衡列表)。

实战案例(阿里云电商架构)

DNS → 阿里云DNS(GeoDNS解析到最近的地域);四层负载均衡 → 阿里云SLB(四层模式,处理TCP请求);七层负载均衡 → Nginx集群(处理HTTP路由);服务内负载均衡 → Istio(处理微服务间的动态调度)。

最佳实践2:会话一致性——别再用“IP哈希”当“银弹”

问题:IP哈希的局限性

IP哈希能保证会话一致性,但有两个致命问题:

IP分布不均:比如某公司内网用户用同一个出口IP,会导致某台服务器过载;服务器宕机:当某台服务器宕机时,该IP的会话会丢失(除非用分布式会话)。

更好的解决方案:“分布式会话”+“无状态服务”

第一步:将会话存储到分布式缓存(比如Redis),让所有服务器都能读取会话数据。这样即使请求到不同服务器,也能拿到用户的会话信息;第二步:将服务改成“无状态”(比如用JWT令牌代替Session)。JWT令牌存储在用户浏览器中,包含用户信息,服务器不需要存储会话——这样负载均衡策略可以随便选(比如加权轮询、动态策略),彻底解决会话一致性问题。

实战案例(JWT代替Session)

用户登录时,服务器生成JWT令牌(包含用户ID、过期时间),返回给浏览器;浏览器每次请求时,在Header中携带

Authorization: Bearer <JWT>

最佳实践3:健康检查——避免“把请求发给死服务器”

问题:为什么需要健康检查?

如果后端服务器宕机(比如进程崩溃、网络断开),负载均衡器还在分发请求,会导致用户看到“502 Bad Gateway”错误。健康检查的作用,就是定期“心跳检测”后端服务器,剔除故障节点。

健康检查的核心配置

健康检查需要设置四个参数:

检查间隔:多久检查一次(比如5秒);超时时间:超过多久没响应算失败(比如2秒);不健康阈值:连续失败多少次算“死”(比如3次);健康阈值:连续成功多少次算“活”(比如2次)。

实战配置(Nginx健康检查)

Nginx需要安装

ngx_http_health_check_module

upstream backend {

server 192.168.1.101:80;

server 192.168.1.102:80;

server 192.168.1.103:80;

# 健康检查配置:每5秒检查一次,失败3次剔除,成功2次恢复

health_check interval=5s fails=3 passes=2;

# 检查路径(后端服务器需要提供/health接口,返回200 OK)

health_check_uri /health;

}

实战配置(AWS ALB健康检查)

AWS Application Load Balancer的健康检查配置:

协议:HTTP;路径:/health;端口:8080;间隔:10秒;超时:5秒;不健康阈值:3次;健康阈值:2次。

最佳实践4:动态调整——让负载均衡“自动适应”流量变化

问题:静态策略的局限性

静态策略(比如轮询、加权轮询)无法适应动态流量(比如大促时流量突然涨10倍,或者某台服务器突然变卡)。动态调整的核心是用监控数据驱动策略变化。

实现步骤

收集metrics:用Prometheus收集服务器的CPU、内存、响应时间、QPS等数据;设定阈值:比如当CPU利用率超过80%时,降低该服务器的权重;当响应时间超过2秒时,暂时剔除该服务器;自动执行:用自动化工具(比如Ansible、Kubernetes Operator)修改负载均衡配置(比如Nginx的upstream权重)。

实战案例(Prometheus + Ansible动态调整权重)

监控:Prometheus收集服务器的CPU利用率(metric名称:

node_cpu_seconds_total

最佳实践5:避免单点故障——负载均衡器本身要“高可用”

问题:负载均衡器也会“挂掉”

如果负载均衡器是单节点,那么它本身就是单点故障——一旦挂掉,整个系统都无法访问。解决方法是将负载均衡器做成高可用集群。

高可用的两种模式

主备模式(Active-Passive):

一台主负载均衡器处理流量,另一台备负载均衡器处于“待命”状态。当主节点宕机时,备节点自动接管(通过VRRP协议,比如Keepalived)。

优点:实现简单;缺点:备节点资源闲置。

集群模式(Active-Active):

多台负载均衡器同时处理流量,通过负载均衡协议(比如LVS的DR模式、Nginx的集群)分担请求。

优点:资源利用率高;缺点:实现复杂(需要同步配置)。

实战配置(Nginx主备模式)

用Keepalived实现Nginx主备:

主Nginx:IP 192.168.1.100,Keepalived配置

state MASTER

priority 100

state BACKUP

priority 90

避坑指南:7个新手常踩的陷阱

陷阱1:对异构集群用轮询

→ 后果:低配服务器过载,响应变慢;

→ 解决:用加权轮询或加权最少连接。

陷阱2:用IP哈希处理“同一出口IP”的场景

→ 后果:某台服务器被压爆;

→ 解决:用分布式会话或JWT。

陷阱3:健康检查配置不当

→ 后果:故障服务器没被剔除,用户看到502;

→ 解决:设置合理的间隔、超时、阈值,检查正确的路径(比如/health)。

陷阱4:负载均衡器成为性能瓶颈

→ 后果:单台Nginx处理10万并发时卡顿;

→ 解决:用四层负载均衡(LVS)或集群模式(Nginx集群)。

陷阱5:忽略动态扩容的同步

→ 后果:新扩容的服务器没被负载均衡器发现,资源闲置;

→ 解决:用动态负载均衡(比如Kubernetes的Service、Istio)。

陷阱6:用七层负载均衡处理“纯TCP流量”

→ 后果:性能浪费(七层需要解析HTTP头);

→ 解决:用四层负载均衡(比如LVS、AWS NLB)。

陷阱7:没有备份负载均衡配置

→ 后果:负载均衡器宕机后,配置丢失,无法恢复;

→ 解决:用配置管理工具(比如Ansible、SaltStack)备份配置,或者用云服务商的“配置快照”。

五、结论:负载均衡的“本质”是“匹配”

1. 核心要点回顾

负载均衡的作用:分发请求、避免单点、提高利用率;策略选择的关键:匹配场景(比如静态资源用URL哈希,微服用内容路由);最佳实践:分层架构、分布式会话、健康检查、动态调整、高可用。

2. 未来趋势:从“规则驱动”到“AI驱动”

未来的负载均衡会向智能化方向发展:

AI预测:通过机器学习模型预测流量变化(比如双11零点的流量峰值),提前调整策略;边缘负载均衡:将负载均衡节点部署在靠近用户的边缘(比如CDN节点),减少回源延迟;自适应策略:根据实时metrics自动切换策略(比如流量高峰时用最快响应时间,低峰时用加权轮询)。

3. 行动号召:现在就去优化你的负载均衡!

检查当前策略:你的系统用的是哪种策略?是否匹配场景?添加健康检查:如果还没配置健康检查,现在就去加(比如Nginx的

health_check

最后:负载均衡不是“一劳永逸”的配置,而是持续优化的过程。随着系统规模的扩大,你可能需要从“软件负载均衡”升级到“分层架构”,从“静态策略”升级到“AI驱动”——但核心永远是:让正确的请求到正确的服务器。

如果你觉得这篇文章有用,欢迎转发给你的同事——毕竟,高并发系统的稳定,从来不是一个人的事。

相关文章