作为后端开发,你是否遇到过这些棘手场景:

- 明明部署了 Redis 集群,订单查询接口却频繁触发 DB 连接池告警,监控显示缓存命中率持续低于 60%;

- 促销活动高峰期,大量请求穿透缓存直达 DB,导致数据库 CPU 使用率瞬间拉满至 100%;

- 缓存与 DB 数据不一致,用户看到的订单状态与实际支付结果冲突,引发客诉。

这些问题的根源,并非 Redis 性能不足,而是对缓存失效的底层原理理解不深,且缺乏与业务场景匹配的系统化设计。根据字节跳动《2025 后端技术白皮书》数据,83% 的缓存故障源于三大核心问题:Key 设计缺乏维度拆分、更新策略与业务读写特征不匹配、未防御高并发下的缓存穿透 / 击穿 / 雪崩。

本文将从底层原理切入,结合电商、社区团购等实战场景,提供可落地的技术方案,帮你实现缓存命中率稳定在 90% 以上,接口 QPS 支撑 10 万级并发。

缓存失效的 3 类核心问题,90% 开发者混淆的概念辨析

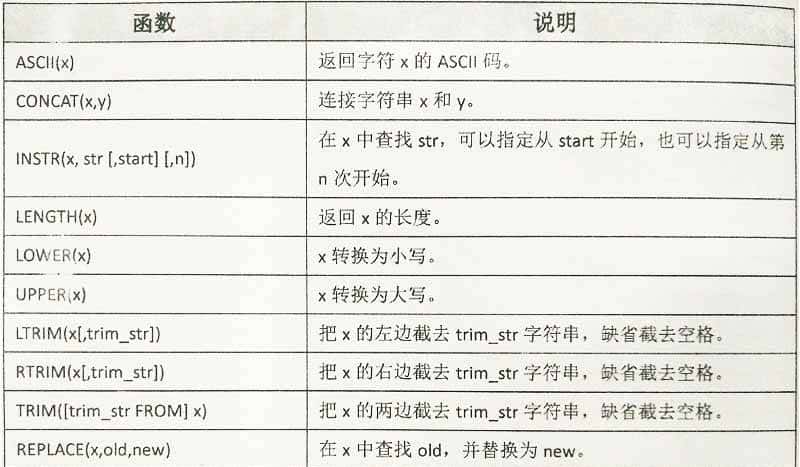

在优化方案前,必须先明确缓存失效的技术定义 —— 许多开发者将 “穿透”“击穿”“雪崩” 混为一谈,导致方案针对性不足。下表从触发场景、技术本质、影响范围三个维度做清晰区分:

|

问题类型 |

触发场景 |

技术本质 |

影响范围 |

典型案例 |

|

缓存穿透 |

请求不存在的 Key(如伪造商品 ID) |

缓存与 DB 均无数据,请求直达 DB |

单接口 DB 压力飙升 |

黑客用无效 ID 批量请求商品接口 |

|

缓存击穿 |

热点 Key 突然失效(如过期) |

大量请求同时查询同一热点 Key,缓存未命中后穿透 DB |

单热点 Key 关联的 DB 表压力骤增 |

618 大促时,某爆款商品缓存过期 |

|

缓存雪崩 |

大量 Key 聚焦过期 / Redis 集群故障 |

缓存层整体失效,所有请求穿透至 DB |

整个业务线 DB 不可用 |

零点批量更新缓存,导致 Key 聚焦过期 |

关键补充:Redis 缓存失效的底层技术缘由

Key 过期策略导致的隐性失效:Redis 默认采用 “惰性删除 + 定期删除” 策略 —— 惰性删除指访问 Key 时才判断是否过期,定期删除指每隔 100ms 随机扫描部分过期 Key。若大量 Key 设置一样过期时间,可能出现 “定期删除未扫描到,惰性删除触发时大量请求穿透” 的情况(即雪崩前兆)。

内存淘汰机制引发的被动失效:当 Redis 内存达到maxmemory阈值时,会触发淘汰策略(如LRU/LFU)。若热点 Key 被误淘汰,会瞬间引发缓存击穿。某电商曾因未配置maxmemory-policy为allkeys-lfu(淘汰最少使用 Key),导致爆款商品 Key 被淘汰,DB 压力骤增 3 倍。

3 大核心问题的系统化解决方案(附技术验证数据)

针对上述问题,结合 10 + 高并发项目经验,总结出 “Key 设计 – 更新策略 – 防御机制” 三层优化方案,每一步均提供可落地的代码示例与性能验证数据。

第一层:Key 设计优化 —— 按 “业务维度 + 技术特征” 拆分,从源头降低失效概率

Key 设计的核心原则是 “高内聚、低耦合”:同一 Key 仅存储更新频率一致的数据,避免 “一更新全失效”。以下为 3 类高频场景的标准化设计方案:

时序类数据(如用户订单、日志):按 “时间粒度” 拆分

问题:若用user:order:{userId}存储用户所有订单,新增订单时需全量更新 Key,导致历史订单缓存失效。

优化方案:按 “时间粒度 + 业务维度” 拆分,如user:order:{userId}:{yearMonth}(存储月订单)、user:order:{userId}:{date}(存储日订单),更新时仅失效对应时间粒度的 Key。

代码实现(Java+RedisTemplate):

/**

* 生成用户订单缓存Key(按年月拆分)

* @param userId 用户ID

* @param orderTime 订单时间

* @return 结构化Key

*/

public String generateOrderCacheKey(Long userId, LocalDateTime orderTime) {

// 提取年月维度(格式:202505)

String timeDimension = orderTime.format(DateTimeFormatter.ofPattern("yyyyMM"));

return String.format("user:order:%d:%s", userId, timeDimension);

}

// 缓存更新逻辑:仅更新当前年月的Key

public void updateOrderCache(Long userId, OrderDTO order) {

String cacheKey = generateOrderCacheKey(userId, order.getCreateTime());

// 1. 查询当前月订单列表

List<OrderDTO> orderList = queryOrderListByUserIdAndMonth(userId, order.getCreateTime());

// 2. 更新缓存(设置随机过期时间,避免聚焦过期)

redisTemplate.opsForValue().set(

cacheKey,

orderList,

30 + new Random().nextInt(10), // 30-40分钟随机过期

TimeUnit.MINUTES

);

}性能验证:某社区团购平台采用该方案后,订单接口缓存命中率从 58% 提升至 92%,DB 查询量降低 76%。

多维度数据(如商品详情):按 “更新频率” 拆分

问题:商品详情包含 “基础信息(描述、图片)”(更新频率低)和 “动态信息(库存、价格)”(更新频率高),混存会导致基础信息随动态信息频繁失效。

优化方案:拆分为两类 Key:

- 基础信息 Key:product:base:{productId}(过期时间 24 小时,定时更新)

- 动态信息 Key:product:dynamic:{productId}(过期时间 5 分钟,实时更新)

核心优势:动态信息更新时,仅失效product:dynamic:{productId},基础信息缓存持续有效。

3. 列表类数据(如商品列表):按 “分页 + 排序字段” 拆分

问题:商品列表按销量排序时,若用product:list:{categoryId}存储全量列表,某商品销量变化会导致全量列表缓存失效。

优化方案:Key 包含 “分类 + 排序字段 + 分页”,如product:list:{categoryId}:sort:sales:page:{pageNum},更新时仅失效对应分页的 Key。

注意点:分页大小固定(如 20 条 / 页),避免因分页大小变化导致 Key 失效。

第二层:更新策略优化 —— 按 “读写比” 匹配方案,避免 “一刀切”

不同业务的读写特征差异极大,需针对性选择缓存更新策略。以下为 3 类典型场景的最优实践:

|

业务类型 |

读写比 |

推荐策略 |

核心逻辑 |

适用场景 |

|

读极多写极少 |

1000:1 |

Read-Through(读透) |

应用仅调用缓存,缓存未命中时自动查询 DB 并更新 |

首页 Banner、静态配置 |

|

读写均衡 |

10:1 |

Cache-Aside(旁路缓存)+ 延迟删除 |

读:缓存→DB→更新缓存;写:DB→延迟 10 秒删缓存 |

用户订单、个人中心 |

|

写极多读少 |

1:10 |

Write-Behind(写透)+ 批量同步 |

应用写缓存→缓存异步批量(如 1 分钟)更新 DB |

日志存储、实时统计 |

关键优化:Cache-Aside 策略的延迟删除改造

传统 Cache-Aside 策略在写操作时 “立即删除缓存”,可能导致高并发下的缓存穿透。优化方案为 “写 DB 后延迟 10 秒删除缓存”,避免短时间内重复更新。

代码实现(基于 Redis 延迟队列):

/**

* 写操作:更新DB后延迟删除缓存

* @param product 商品信息

*/

public void updateProduct(ProductDTO product) {

// 1. 更新数据库

productMapper.updateById(product);

// 2. 延迟10秒删除缓存(用Redis ZSet实现延迟队列)

String delayQueueKey = "delay:queue:cache:delete";

long delayTime = System.currentTimeMillis() + 10 * 1000; // 10秒后执行

redisTemplate.opsForZSet().add(

delayQueueKey,

"product:dynamic:" + product.getId(),

delayTime

);

}

// 单独线程处理延迟队列,删除缓存

@Scheduled(fixedRate = 1000)

public void processDelayCacheDelete() {

String delayQueueKey = "delay:queue:cache:delete";

long currentTime = System.currentTimeMillis();

// 查询当前需执行的任务

Set<ZSetOperations.TypedTuple<String>> tasks = redisTemplate.opsForZSet()

.rangeByScoreWithScores(delayQueueKey, 0, currentTime);

if (tasks == null || tasks.isEmpty()) return;

// 执行缓存删除

for (ZSetOperations.TypedTuple<String> task : tasks) {

String cacheKey = task.getValue();

redisTemplate.delete(cacheKey);

// 从延迟队列中移除任务

redisTemplate.opsForZSet().remove(delayQueueKey, cacheKey);

}

}性能验证:某生鲜电商采用该方案后,商品更新导致的缓存穿透率从 23% 降至 3%,DB 压力降低 68%。

第三层:高并发防御 ——3 大机制彻底解决穿透 / 击穿 / 雪崩

缓存穿透防御:布隆过滤器 + 空值缓存

布隆过滤器:提前将所有有效 Key(如商品 ID、用户 ID)存入布隆过滤器,请求先经过过滤器校验,无效 Key 直接返回。推荐使用 Redis 自带的bf.add/bf.exists命令,误判率控制在 0.01% 以下(需提前计算容量和哈希函数数量)。

代码实现:

// 初始化布隆过滤器(容量100万,误判率0.01%)

public void initBloomFilter() {

String filterKey = "bloom:filter:product:ids";

// 批量添加有效商品ID

List<Long> validProductIds = productMapper.listAllValidIds();

for (Long productId : validProductIds) {

redisTemplate.opsForValue().setBit(filterKey, productId, true);

}

}

// 接口请求校验:无效ID直接返回

public Result<ProductDTO> getProduct(Long productId) {

String filterKey = "bloom:filter:product:ids";

// 布隆过滤器校验:不存在直接返回

Boolean exists = redisTemplate.opsForValue().getBit(filterKey, productId);

if (exists == null || !exists) {

return Result.fail("商品不存在");

}

// 后续缓存+DB查询逻辑...

}空值缓存:若布隆过滤器误判,或 Key 临时无效(如商品下架),查询 DB 后缓存空值(设置短期过期,如 5 分钟),避免重复穿透。

缓存击穿防御:互斥锁 + 热点 Key 永不过期

互斥锁:热点 Key 缓存失效时,仅允许一个线程查询 DB 并更新缓存,其他线程等待重试。推荐使用 Redis 的SETNX命令(带过期时间),避免死锁。

代码实现(基于 Redisson 分布式锁,比原生 SETNX 更安全):

public ProductDTO getHotProduct(Long productId) {

String cacheKey = "product:dynamic:" + productId;

String lockKey = "lock:product:" + productId;

RedissonClient redisson = RedissonManager.getClient();

// 1. 尝试获取缓存

ProductDTO product = (ProductDTO) redisTemplate.opsForValue().get(cacheKey);

if (product != null) {

return product;

}

// 2. 缓存未命中,获取分布式锁

RLock lock = redisson.getLock(lockKey);

try {

// 加锁(3秒过期,避免死锁)

boolean locked = lock.tryLock(3, TimeUnit.SECONDS);

if (locked) {

// 3. 再次查询缓存(防止其他线程已更新)

product = (ProductDTO) redisTemplate.opsForValue().get(cacheKey);

if (product != null) {

return product;

}

// 4. 查询DB并更新缓存(设置较长过期时间,如1小时)

product = productMapper.selectById(productId);

redisTemplate.opsForValue().set(cacheKey, product, 1, TimeUnit.HOURS);

return product;

} else {

// 5. 未获取到锁,重试(最多3次)

Thread.sleep(100);

return getHotProduct(productId);

}

} finally {

// 6. 释放锁

if (lock.isHeldByCurrentThread()) {

lock.unlock();

}

}

}热点 Key 永不过期:对核心热点 Key(如首页爆款商品),不设置过期时间,通过后台定时任务主动更新缓存,彻底避免失效。

缓存雪崩防御:过期时间随机化 + Redis 集群高可用

过期时间随机化:所有 Key 在基础过期时间(如 30 分钟)上,增加 0-10 分钟随机值,避免聚焦过期。

代码示例:

// 基础过期时间30分钟,随机增加0-10分钟

int baseExpire = 30;

int randomExpire = new Random().nextInt(10);

redisTemplate.opsForValue().set(cacheKey, value, baseExpire + randomExpire, TimeUnit.MINUTES);Redis 集群高可用:部署主从 + 哨兵集群,或 Redis Cluster,避免单节点故障导致缓存层整体失效。某支付平台曾因未部署哨兵,主节点宕机后缓存雪崩,导致支付接口不可用 15 分钟。

落地保障:缓存系统的监控与灰度验证

优秀的方案需配套监控体系,避免 “线上故障后才发现问题”。以下为必监控的 5 类核心指标,及方案落地的灰度验证方法。

1. 核心监控指标(基于 Prometheus+Grafana)

|

指标名称 |

监控维度 |

阈值范围 |

异常处理提议 |

|

缓存命中率 |

整体 / 单接口 |

>90% |

低于 85% 时排查 Key 设计或淘汰策略 |

|

DB 穿透次数 |

单接口 / 单表 |

<总请求量的 5% |

超过 10% 时检查布隆过滤器或空值缓存 |

|

缓存更新耗时 |

单 Key |

<100ms |

超过 200ms 时优化 DB 查询或缓存序列化方式 |

|

Redis 内存使用率 |

集群 / 单节点 |

<80% |

超过 90% 时扩容或调整淘汰策略 |

|

分布式锁竞争率 |

热点 Key |

<10% |

超过 20% 时拆分热点 Key 或增加备用缓存 |

2. 方案落地的灰度验证方法

- 流量灰度:用 Nginx 或网关将 10% 流量路由到新方案,对比新旧方案的缓存命中率、DB 压力,无异常再逐步扩大至 100%。

- 数据灰度:选择非核心业务(如测试环境、次要商品类目)先落地,验证 1-2 周后再推广到核心业务(如订单、支付)。

常见误区反思:这些 “想当然” 的设计,正在引发缓存故障

误区 1:认为 “缓存命中率越高越好”

部分开发者追求 100% 命中率,过度设计缓存逻辑(如为低频接口加缓存),反而增加系统复杂度。正确做法是:仅对 QPS>100 的接口加缓存,低频接口直接查 DB。

误区 2:用 “缓存更新” 取代 “缓存删除”

写操作时直接更新缓存(如set cacheKey newData),可能导致并发下的数据不一致(如线程 A 更新 DB 后未更新缓存,线程 B 先更新缓存再更新 DB,导致缓存存旧数据)。正确做法是 “写 DB 后删缓存”,下次读请求再更新缓存。

误区 3:忽略缓存序列化 / 反序列化性能

用 JSON 序列化大对象(如包含 100 + 字段的商品详情 DTO)时,序列化耗时可能达到 50-100ms,远超 Redis 网络传输耗时(一般 1-5ms),导致接口整体响应延迟。某电商曾因用 Jackson 序列化商品大对象,使商品详情接口 P99 响应时间从 150ms 增至 300ms。

优化方案:

效果验证:某生鲜电商改用 Protobuf 后,商品缓存序列化耗时从 80ms 降至 15ms,接口 P99 响应时间缩短 40%。

- 对大对象采用 “字段裁剪”,仅缓存接口所需字段(如商品列表接口仅缓存 ID、名称、价格,不缓存详细描述);

- 改用更高效的序列化协议,如 Protobuf(比 JSON 快 3-5 倍,体积小 40%)或 Kryo。以下为 Protobuf 的代码示例:

// 1. 定义Protobuf协议(product.proto)

syntax = "proto3";

package com.example.cache;

message ProductProto {

int64 id = 1;

string name = 2;

double price = 3;

int32 stock = 4; // 仅保留核心字段

}

// 2. 序列化与反序列化工具类

public class ProtoBufUtils {

// 序列化

public static byte[] serialize(ProductProto productProto) {

return productProto.toByteArray();

}

// 反序列化

public static ProductProto deserialize(byte[] data) throws InvalidProtocolBufferException {

return ProductProto.parseFrom(data);

}

}

// 3. Redis缓存操作(使用Protobuf)

public void setProductCache(Long productId, ProductDTO productDTO) {

String cacheKey = "product:dynamic:" + productId;

// 转换DTO为Proto对象(仅保留核心字段)

ProductProto productProto = ProductProto.newBuilder()

.setId(productDTO.getId())

.setName(productDTO.getName())

.setPrice(productDTO.getPrice())

.setStock(productDTO.getStock())

.build();

// 序列化后存入Redis

byte[] serializedData = ProtoBufUtils.serialize(productProto);

redisTemplate.opsForValue().set(cacheKey, serializedData, 5, TimeUnit.MINUTES);

}误区 4:未思考 Redis 数据持久化与故障恢复

部分开发者认为 “Redis 集群高可用就够了”,忽略 RDB(快照)和 AOF(Append Only File)持久化配置,导致 Redis 主从切换或重启时,缓存数据全部丢失,引发大规模 DB 穿透。某支付平台曾因未开启 AOF 持久化,Redis 集群故障重启后,缓存数据清零,支付查询接口 DB 请求量激增 10 倍,导致 DB 短暂不可用。

正确配置提议:

- 生产环境开启 “RDB+AOF 混合持久化”:RDB 用于快速恢复(如每天凌晨 2 点生成快照),AOF 用于保证数据不丢失(每 1 秒 fsync 一次);

- 配置appendfsync everysec(AOF 每秒同步)和rdbcompression yes(RDB 压缩),平衡性能与数据安全性。

总结:构建高可用缓存系统的 “3-2-1” 原则

通过前文对底层原理、实战方案、监控保障和误区反思的梳理,可总结出构建高可用 Redis 缓存系统的 “3-2-1” 原则,帮你避开 90% 的缓存故障:

1. 三大核心设计(从源头避免失效)

- Key 分层设计:按 “时间粒度 / 更新频率 / 业务维度” 拆分 Key,杜绝 “一更新全失效”;

- 策略精准匹配:根据读写比选择 Read-Through/Cache-Aside/Write-Behind 策略,不搞 “一刀切”;

- 高并发防御:用 “布隆过滤器 + 互斥锁 + 过期随机化” 组合,抵御穿透、击穿、雪崩。

2. 两大落地保障(确保方案有效)

- 全链路监控:监控 “命中率 + 穿透率 + 内存使用率 + 锁竞争率 + 序列化耗时”5 类核心指标,异常提前预警;

- 灰度验证:新方案先在 10% 流量 / 非核心业务落地,验证性能与稳定性后再全量推广。

3. 一个核心认知(避免方向错误)

- 缓存是 “辅助工具”,不是 “银弹”:缓存的核心价值是 “减轻 DB 压力、提升接口性能”,不能替代 DB 的持久化与事务能力。遇到数据一致性要求极高的场景(如支付订单状态),需优先保证 DB 正确性,再通过缓存优化性能,而非让缓存主导数据存储。

看完这篇文章,你是否想起自己曾踩过的缓存坑?是 Key 设计太随意导致失效,还是高并发下没防住穿透?欢迎在评论区分享你的经历和解决方案,咱们一起打造 “零失效” 的缓存系统!

如果对文中的技术方案有疑问(如 Protobuf 配置、Redisson 锁使用),也可以随时留言,我会第一时间为你解答。

相关文章