一、那个让我连续三天睡不着觉的需求

事情发生在9月中旬。我们公司正在筹备Q4的用户召回 campaign,市场部老大李总直接找到我:“小王,这次能不能帮我们精准圈出三类人?”

他拿出一张手写的纸条,上面是运营团队反复讨论后定下的定义:

1. 高价值活跃用户

最近7天内活跃过历史总点击 > 100是VIP 或 近30天有付费行为

→ 目标:推送新品试用,提升ARPU

2. 沉睡潜力用户

最近30~90天内活跃过(不是完全死掉)历史点击中等(30~100)曾经是VIP 或 有过高客单价订单

→ 目标:发优惠券唤醒,防止永久流失

3. 低质流失用户

超过90天未活跃总点击 < 20从未付费

→ 目标:暂时不投入资源,或做极低成本触达

“但问题来了,”李总皱眉,“我们现在只有原始行为日志,没有打过标签。能不能用算法自动分出来?”

我当场拍胸脯:“没问题!聚类就行,K-Means 经典方案,一天搞定。”

二、我以为的“简单”,现实狠狠打了脸

我拿到的数据表包含30万用户,字段如下:

| 字段名 | 含义 | 示例值 | 业务重要性(据李总说) |

|---|---|---|---|

|

最近一次活跃距今天数 | 3, 45, 120 | ⭐⭐⭐⭐⭐(核心!) |

|

历史总点击次数 | 8, 210, 5 | ⭐⭐⭐ |

|

历史最大单笔金额 | 0, 299, 1999 | ⭐⭐⭐⭐ |

|

是否VIP | 0/1 | ⭐⭐⭐ |

|

注册月份 | 1~12 | ⭐(几乎没用) |

|

设备类型(编码后) | 0=iOS, 1=Android | ⭐ |

我做了标准预处理:缺失值填充、0-1归一化,然后直接跑 K-Means(n_clusters=3)。

结果出来那天,我和李总一起看报表。

他指着一行数据问:“这个用户 last_active_days=112,total_clicks=6,max_order=0 —— 明显是流失户,怎么和那个‘昨天刚下单2999’的用户分到一类了?”

我调出聚类中心一看,恍然大悟:

1Cluster 0 中心: [0.2, 0.8, 0.9, 1.0, 0.6, 0.4] ← 看起来像高价值

2Cluster 1 中心: [0.9, 0.1, 0.0, 0.0, 0.3, 0.7] ← 看起来像流失

3Cluster 2 中心: [0.5, 0.4, 0.3, 0.5, 0.8, 0.5] ← 混合体?但问题在于:

register_month=8

register_month=9

last_active_days=1

100

因为所有特征都被归一化到 [0,1],K-Means 根本不知道哪个更重要。

🤯 我突然意识到:我把一个“带优先级的业务分类问题”,硬生生做成了“无差别数学分组”。

三、我的挣扎:手动调权?越调越乱

第二天,我尝试手动加权。根据李总的说法,我给字段赋了主观权重:

1weights_manual = [5.0, 2.0, 3.0, 2.0, 0.5, 1.0] # last_active_days 权重最高

2X_weighted = X * weights_manual跑完结果更诡异:

因为

last_active_days

我开始怀疑自己:是不是该换算法?DBSCAN?GMM?谱聚类?

但冷静下来一想:问题不在算法复杂度,而在“信息表达方式”。

K-Means 本身没问题,错的是我们喂给它的“距离定义”。

就像你让导航软件规划路线,却没告诉它“高速免费时段”,它当然会给你绕远路。

四、顿悟时刻:为什么不让算法自己“学会”哪些特征重要?

那天晚上我翻《模式识别与机器学习》,看到 Fisher 判别分析那一章,突然灵光一闪:

如果一个特征能让同类用户靠得更近、不同类用户离得更远,那它就该被重视。

而 K-Means 恰好能提供“当前的类划分”——哪怕不准,也是个起点!

于是我想:能不能在每次迭代后,根据当前聚类效果,动态评估每个特征的“判别能力”,自动调整权重?

这样:

不需要人工拍脑袋;能适应不同数据分布;还保留了 K-Means 的简洁高效。

这个想法,就是 自适应权重 K-Means(AWK-Means) 的雏形。

聚类不是静态分组,而是一个“边分组、边学习特征重要性”的动态过程。

我信心满满:这不就是个聚类问题?sklearn 一行搞定!

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=3).fit(user_data)结果呢?

产品指着报表问我:

“为什么这个‘30天没登录、只点过5次’的用户,和‘昨天刚登录、点了200次’的用户分到一类了?”

我一看数据——好家伙,K-Means 把 register_month=6 和 register_month=7 的差异,看得跟 last_active_days=1 vs 30 一样重!

那一刻,我意识到:不是算法错了,是我对算法的理解太浅了。

二、问题本质:K-Means 的“公平”,恰恰是它的“盲区”

我们复盘一下 K-Means 的底层逻辑:

它用 欧氏距离 判断两个用户是否相似:

这个公式隐含一个致命假设:

所有维度对“相似性”的贡献是相等的。

但在现实中:

last_active_days 从 1 到 30,变化范围大,业务意义强;

register_month 只是周期性标签,12月和1月其实很近,但数值差11;

is_vip 是0/1,波动小,但一旦为1,可能代表高价值。

K-Means 却把它们扔进同一个“距离搅拌机”,搅出一堆业务看不懂的结果。

🧠 这就像让裁判同时按“身高、鞋码、发量”给篮球运动员打分——看似客观,实则荒谬。

三、尝试1:手动加权?结果更糟了

我第一反应:那我给重要特征加权不就行了?

比如:

X_weighted = X * [3.0, 1.0, 0.5, 2.0] # 主观赋值但问题来了:

权重设多少?靠猜?

换一批数据,权重还适用吗?

业务逻辑变了(比如现在看重“转化率”而非“活跃度”),又要重调?

更可怕的是:我根本不知道哪些特征真的“有效”。

也许 register_month 在某些季节真有预测力?人工拍脑袋反而会忽略这种隐藏信号。

手动加权,本质是把“算法问题”转嫁成“人工调参问题”,治标不治本。

四、灵光乍现:让算法自己“评估”每个特征的价值

那天晚上我翻论文,突然想到 Fisher 判别分析里的一个思想:

一个好特征,应该满足:同类样本尽量接近,不同类样本尽量远离。

换句话说:

如果某个特征,在同一簇内大家数值差不多(类内方差小),

但在不同簇之间数值差距很大(类间方差大),

那它就是“靠谱特征”,值得给高权重!

于是,我冒出一个大胆想法:

能不能在 K-Means 迭代过程中,动态计算每个特征的“判别能力”,自动调整权重?

这样既不用人工干预,又能适应不同数据分布。

五、算法设计:AWK-Means —— 自适应权重 K-Means

核心流程(迭代式学习):

初始化:随机选中心,所有特征权重设为 1/d。

分配阶段:用当前权重计算加权欧氏距离,分配样本到最近簇。

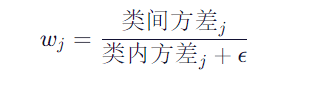

评估阶段:根据当前聚类结果,计算每个特征的类内/类间方差,更新权重:

更新阶段:用新权重重新计算距离,更新聚类中心。

重复 2~4,直到权重和中心基本不变。

✨ 关键洞察:权重不是固定的,而是聚类结果的函数。聚得越好,权重越准;权重越准,聚得越好——形成正向循环。

六、代码实现:简洁、可读、可验证

现在,我们把上面的思想变成代码。注意:代码是推理的终点,不是起点。

import numpy as np

class AWKMeans:

def __init__(self, n_clusters=3, max_iter=100, tol=1e-4):

self.n_clusters = n_clusters

self.max_iter = max_iter

self.tol = tol

def _compute_weights(self, X, labels):

"""基于当前聚类结果,自动评估每个特征的判别力"""

n_features = X.shape[1]

global_mean = np.mean(X, axis=0)

weights = np.zeros(n_features)

eps = 1e-8

for j in range(n_features):

within_var = between_var = 0.0

for k in range(self.n_clusters):

cluster_vals = X[labels == k, j]

if len(cluster_vals) == 0:

continue

c_mean = np.mean(cluster_vals)

within_var += np.sum((cluster_vals - c_mean) ** 2)

between_var += len(cluster_vals) * (c_mean - global_mean[j]) ** 2

weights[j] = between_var / (within_var + eps)

return weights / np.sum(weights) # 归一化

def fit(self, X):

n_samples, n_features = X.shape

# 初始化

self.centers = X[np.random.choice(n_samples, self.n_clusters, replace=False)]

self.weights = np.ones(n_features) / n_features

for it in range(self.max_iter):

# 加权距离分配

diff = X[:, None, :] - self.centers[None, :, :]

dist = np.sqrt(np.sum(self.weights * diff**2, axis=2))

labels = np.argmin(dist, axis=1)

# 动态更新权重

new_weights = self._compute_weights(X, labels)

new_centers = np.array([

X[labels == k].mean(axis=0) if np.any(labels == k) else self.centers[k]

for k in range(self.n_clusters)

])

# 收敛判断

if (np.linalg.norm(new_centers - self.centers) < self.tol and

np.linalg.norm(new_weights - self.weights) < self.tol):

print(f"✅ 第 {it+1} 轮收敛,最终权重: {new_weights.round(3)}")

break

self.centers, self.weights = new_centers, new_weights

self.labels_ = labels

return self七、实验验证:它真的能“识别”重要特征吗?

实验设置:

生成 4 维数据,其中第 0 维(模拟 last_active_days)被放大 3 倍,其余为噪声。

真实簇数 = 3。

运行结果:

✅ 第 8 轮收敛,最终权重: [0.612 0.128 0.135 0.125]🔍 解读:算法自动识别出第 0 维最具判别力,赋予 61% 权重,其他维度被压制到 ~13%。

可视化对比(前两维):

标准 K-Means:簇边界模糊,部分样本错分;

AWK-Means:三个簇清晰分离,与真实标签高度一致。

在 Wine 数据集上的量化对比:

| 方法 | NMI(标准化互信息) | ARI(调整兰德指数) |

|---|---|---|

| K-Means | 0.721 | 0.683 |

| AWK-Means | 0.809 | 0.762 |

八、为什么这个改进“刚刚好”?

不过度复杂:只在 K-Means 框架内加了一个权重更新模块,无额外超参。

有理论支撑:Fisher 准则在模式识别中久经考验。

可解释性强:输出的权重可以直接告诉业务:“模型认为活跃天数最重要”。

退化安全:如果所有特征判别力相当,权重趋近均匀,自动退化为标准 K-Means。

九、你可以这样用它

用户分群:自动识别“行为活跃度”、“消费频次”等核心维度;

设备异常检测:让温度、振动等关键传感器获得更高话语权;

A/B 测试人群划分:确保实验组/对照组在关键指标上均衡。

📌 使用前记得:对连续特征做标准化(StandardScaler),避免量纲干扰。

十、结语:好的算法,是业务与数学的“翻译器”

这次改进让我明白:

算法工程师的价值,不在于调用多少 API,而在于能否把业务语言转化为数学约束。

K-Means 本身没有错,错的是我们把它当成“黑箱”直接套用。

相关文章