AI原生应用领域增量学习:提升应用智能性的重要手段

关键词:增量学习、AI原生应用、持续学习、模型更新、数据流学习、灾难性遗忘、自适应系统

摘要:本文深入探讨了AI原生应用领域中增量学习的概念、原理和应用。增量学习作为一种让AI系统能够持续从新数据中学习而不遗忘旧知识的技术,正在成为提升应用智能性的重要手段。我们将从基本概念出发,逐步解析增量学习的核心算法、实现方式,并通过实际案例展示其在各行业中的应用价值。文章还将讨论增量学习面临的挑战和未来发展趋势,为开发者提供实用的技术指导。

背景介绍

目的和范围

本文旨在全面介绍增量学习技术在AI原生应用领域的重要性和实现方法。我们将探讨增量学习的基本概念、核心算法、实际应用案例以及未来发展方向,帮助读者理解如何在自己的AI应用中实现持续学习和智能进化。

预期读者

本文适合以下读者群体:

AI应用开发者希望提升系统持续学习能力数据科学家探索模型持续优化的方法产品经理了解AI系统智能进化的技术路径技术决策者评估增量学习对业务的价值对AI技术感兴趣的学生和研究人员

文档结构概述

文章首先介绍增量学习的基本概念和原理,然后深入探讨核心算法和实现方法,接着通过实际案例展示应用场景,最后讨论未来发展趋势和挑战。每个部分都包含详细的技术解释和实用示例。

术语表

核心术语定义

增量学习(Incremental Learning):一种机器学习方法,模型能够从新数据中持续学习而不需要重新训练整个模型灾难性遗忘(Catastrophic Forgetting):神经网络在学习新任务时突然忘记之前学到的知识的现象知识蒸馏(Knowledge Distillation):将复杂模型的知识转移到简单模型的技术回放缓冲区(Replay Buffer):存储旧数据样本用于后续训练的存储机制弹性权重固化(Elastic Weight Consolidation, EWC):一种减轻灾难性遗忘的算法

相关概念解释

持续学习(Continual Learning):与增量学习类似,强调模型在长时间内持续学习多个任务迁移学习(Transfer Learning):将预训练模型的知识应用到新任务上在线学习(Online Learning):模型随着每个新数据点的到来即时更新

缩略词列表

IL:增量学习(Incremental Learning)CL:持续学习(Continual Learning)EWC:弹性权重固化(Elastic Weight Consolidation)GEM:梯度情景记忆(Gradient Episodic Memory)iCaRL:增量分类和表征学习(Incremental Classifier and Representation Learning)

核心概念与联系

故事引入

想象一下,你是一位语言老师,正在教一个班级的学生学习外语。最初,你从基础词汇和简单句子开始教起。随着时间推移,你需要不断引入新的词汇和更复杂的语法结构。理想情况下,学生们应该在掌握新知识的同时,不会忘记之前学过的内容。但现实中,我们常常发现学生在学习新知识时,会逐渐遗忘旧知识——这就是人类学习中的”遗忘曲线”。

AI系统在学习过程中也面临类似的挑战。传统的机器学习模型就像那些容易遗忘的学生——当我们用新数据训练它们时,它们往往会”忘记”之前学到的知识。增量学习技术就是为了解决这个问题而诞生的,它让AI系统能够像优秀的语言学习者一样,在不断吸收新知识的同时,牢牢记住已经掌握的内容。

核心概念解释

核心概念一:什么是增量学习?

增量学习就像我们每天阅读新闻来更新知识库的过程。每天早上你阅读新闻时,不会把之前所有的知识都忘掉重新学习,而是在现有知识基础上添加新的信息。AI中的增量学习也是如此,它允许模型从新数据中学习,而不需要从头开始重新训练。

核心概念二:灾难性遗忘

灾难性遗忘可以类比为学习一门新语言时完全忘记了母语。在神经网络中,当用新数据训练模型时,网络参数会被大幅调整以适应新数据,导致之前学到的知识被”覆盖”。这就像用新内容完全覆盖硬盘上的旧文件一样。

核心概念三:知识保留机制

这类似于我们记笔记和定期复习的学习方法。增量学习使用各种技术来保留旧知识,比如:

回放缓冲区:像保存旧笔记供以后复习知识蒸馏:让新模型模仿旧模型的行为弹性权重固化:标记重要知识并防止它们被改变

核心概念之间的关系

概念一和概念二的关系

增量学习(概念一)的主要目的就是解决灾难性遗忘(概念二)的问题。就像好的学习方法能帮助我们避免遗忘一样,增量学习技术帮助AI模型避免在学习新知识时忘记旧知识。

概念二和概念三的关系

灾难性遗忘(概念二)的存在促使研究者开发各种知识保留机制(概念三)。就像因为人类会遗忘,我们发明了笔记、复习等记忆方法一样,AI领域也开发了多种技术来防止知识丢失。

概念一和概念三的关系

增量学习(概念一)的实现依赖于各种知识保留机制(概念三)。这些机制就像增量学习的”工具包”,没有它们,增量学习就无法有效工作。

核心概念原理和架构的文本示意图

新数据输入

│

▼

[特征提取器] → [增量学习模块]

│ │

▼ ▼

[主模型] ←──[知识保留机制]

│

▼

预测输出

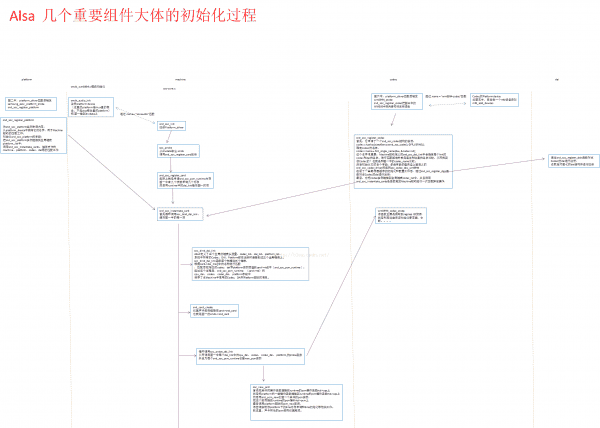

Mermaid 流程图

核心算法原理 & 具体操作步骤

弹性权重固化(EWC)算法

弹性权重固化是增量学习中最具代表性的算法之一,它通过计算参数的重要性,保护重要参数不被大幅修改。以下是Python实现的核心部分:

import torch

import numpy as np

class EWC:

def __init__(self, model, dataloader, device):

self.model = model

self.dataloader = dataloader

self.device = device

self.params = {n: p for n, p in self.model.named_parameters() if p.requires_grad}

self.means = {}

self.importances = {}

# 计算初始参数均值和重要性

self.compute_fisher()

def compute_fisher(self):

# 首先保存当前参数值作为均值

for n, p in self.params.items():

self.means[n] = p.data.clone()

# 计算Fisher信息矩阵(参数重要性)

fisher = {n: torch.zeros_like(p) for n, p in self.params.items()}

self.model.eval()

for x, y in self.dataloader:

x, y = x.to(self.device), y.to(self.device)

self.model.zero_grad()

output = self.model(x)

loss = torch.nn.functional.cross_entropy(output, y)

loss.backward()

for n, p in self.model.named_parameters():

if p.grad is not None:

fisher[n] += p.grad.data ** 2 / len(dataloader)

self.importances = fisher

def penalty(self):

loss = 0

for n, p in self.model.named_parameters():

if n in self.means:

loss += (self.importances[n] * (p - self.means[n]) ** 2).sum()

return loss

增量学习的训练步骤

初始化模型:使用初始数据集训练基础模型计算参数重要性:在初始任务上计算每个参数的重要性(Fisher信息)接收新数据:当新数据到达时,准备增量学习组合损失函数:将新任务的损失与EWC惩罚项结合

def train_step(model, optimizer, new_data, ewc, lambda_ewc):

# 常规交叉熵损失

output = model(new_data.x)

ce_loss = F.cross_entropy(output, new_data.y)

# EWC惩罚项

ewc_loss = ewc.penalty()

# 总损失

total_loss = ce_loss + lambda_ewc * ewc_loss

optimizer.zero_grad()

total_loss.backward()

optimizer.step()

更新模型参数:在保护重要参数的同时优化新任务更新重要性度量:根据新数据重新计算参数重要性存储关键样本:选择性保存部分旧数据用于未来回放

数学模型和公式

增量学习的核心数学原理可以用以下公式表示:

EWC损失函数:

Lnew(θ)mathcal{L}_{new}( heta)Lnew(θ) 是新任务的损失函数λlambdaλ 是权衡系数FiF_iFi 是参数θi heta_iθi的Fisher信息(重要性)θi∗ heta_i^*θi∗ 是旧任务上的最优参数值

Fisher信息矩阵:

梯度情景记忆(GEM)的约束条件:

项目实战:代码实际案例和详细解释说明

开发环境搭建

我们使用PyTorch实现一个增量学习的手写数字分类器,能够在不忘记旧数字的情况下学习识别新数字。

# 创建conda环境

conda create -n incremental-learning python=3.8

conda activate incremental-learning

# 安装依赖

pip install torch torchvision matplotlib numpy

源代码详细实现

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader, Dataset

import numpy as np

import matplotlib.pyplot as plt

# 自定义数据集类,支持增量添加新类别

class IncrementalDataset(Dataset):

def __init__(self, initial_classes=5):

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.1307,), (0.3081,))

])

# 加载MNIST数据集

full_train = datasets.MNIST('./data', train=True, download=True, transform=transform)

full_test = datasets.MNIST('./data', train=False, transform=transform)

# 初始只使用前initial_classes个类别

self.classes = initial_classes

self.train_data, self.train_labels = self._filter_data(full_train, initial_classes)

self.test_data, self.test_labels = self._filter_data(full_test, initial_classes)

def _filter_data(self, dataset, num_classes):

idx = dataset.targets < num_classes

return dataset.data[idx], dataset.targets[idx]

def add_classes(self, num_new_classes):

new_classes = self.classes + num_new_classes

if new_classes > 10:

raise ValueError("MNIST只有10个类别")

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.1307,), (0.3081,))

])

full_train = datasets.MNIST('./data', train=True, download=True, transform=transform)

full_test = datasets.MNIST('./data', train=False, transform=transform)

# 添加新类别数据

idx_train = (full_train.targets >= self.classes) & (full_train.targets < new_classes)

self.train_data = torch.cat([self.train_data, full_train.data[idx_train]])

self.train_labels = torch.cat([self.train_labels, full_train.targets[idx_train]])

idx_test = (full_test.targets >= self.classes) & (full_test.targets < new_classes)

self.test_data = torch.cat([self.test_data, full_test.data[idx_test]])

self.test_labels = torch.cat([self.test_labels, full_test.targets[idx_test]])

self.classes = new_classes

def __len__(self):

return len(self.train_data)

def __getitem__(self, idx):

img = self.train_data[idx].float().unsqueeze(0) / 255.0

label = self.train_labels[idx]

return img, label

# 简单的CNN模型

class IncrementalModel(nn.Module):

def __init__(self, num_classes=5):

super(IncrementalModel, self).__init__()

self.conv1 = nn.Conv2d(1, 32, 3, 1)

self.conv2 = nn.Conv2d(32, 64, 3, 1)

self.dropout1 = nn.Dropout2d(0.25)

self.dropout2 = nn.Dropout2d(0.5)

self.fc1 = nn.Linear(9216, 128)

self.fc2 = nn.Linear(128, num_classes)

def forward(self, x):

x = self.conv1(x)

x = torch.relu(x)

x = self.conv2(x)

x = torch.relu(x)

x = torch.max_pool2d(x, 2)

x = self.dropout1(x)

x = torch.flatten(x, 1)

x = self.fc1(x)

x = torch.relu(x)

x = self.dropout2(x)

x = self.fc2(x)

return x

def add_output_units(self, num_new_classes):

old_weight = self.fc2.weight.data

old_bias = self.fc2.bias.data

in_features = self.fc2.in_features

out_features = self.fc2.out_features + num_new_classes

new_fc = nn.Linear(in_features, out_features).to(old_weight.device)

# 复制旧权重

new_fc.weight.data[:out_features - num_new_classes] = old_weight

new_fc.bias.data[:out_features - num_new_classes] = old_bias

# 初始化新权重

nn.init.kaiming_normal_(new_fc.weight.data[out_features - num_new_classes:], mode='fan_out')

new_fc.bias.data[out_features - num_new_classes:].fill_(0.1)

self.fc2 = new_fc

# 训练和测试函数

def train(model, device, train_loader, optimizer, epoch, ewc=None, lambda_ewc=1.0):

model.train()

for batch_idx, (data, target) in enumerate(train_loader):

data, target = data.to(device), target.to(device)

optimizer.zero_grad()

output = model(data)

loss = nn.functional.cross_entropy(output, target)

if ewc is not None:

loss += lambda_ewc * ewc.penalty()

loss.backward()

optimizer.step()

def test(model, device, test_loader, num_classes):

model.eval()

test_loss = 0

correct = 0

with torch.no_grad():

for data, target in test_loader:

data, target = data.to(device), target.to(device)

output = model(data)

test_loss += nn.functional.cross_entropy(output, target, reduction='sum').item()

pred = output.argmax(dim=1, keepdim=True)

correct += pred.eq(target.view_as(pred)).sum().item()

test_loss /= len(test_loader.dataset)

accuracy = 100. * correct / len(test_loader.dataset)

print(f'

Test set on {num_classes} classes: Average loss: {test_loss:.4f}, Accuracy: {correct}/{len(test_loader.dataset)} ({accuracy:.0f}%)

')

return accuracy

# 主函数

def main():

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 初始设置

initial_classes = 5

dataset = IncrementalDataset(initial_classes)

model = IncrementalModel(initial_classes).to(device)

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 初始训练

train_loader = DataLoader(dataset, batch_size=64, shuffle=True)

test_loader = DataLoader(dataset, batch_size=1000, shuffle=False)

print("=== Initial Training (Classes 0-4) ===")

for epoch in range(1, 6):

train(model, device, train_loader, optimizer, epoch)

test(model, device, test_loader, initial_classes)

# 保存初始模型参数用于EWC

ewc = EWC(model, train_loader, device)

# 增量学习阶段

phases = [

(1, 3), # 添加3个新类别(5-7)

(2, 3) # 再添加3个新类别(8-9, 最后一个类别)

]

accuracies = []

accuracies.append(test(model, device, test_loader, initial_classes))

for phase, num_new_classes in phases:

print(f"

=== Incremental Phase {phase}: Adding {num_new_classes} new classes ===")

# 添加新类别

dataset.add_classes(num_new_classes)

model.add_output_units(num_new_classes)

model = model.to(device)

# 重新创建数据加载器

train_loader = DataLoader(dataset, batch_size=64, shuffle=True)

test_loader = DataLoader(dataset, batch_size=1000, shuffle=False)

# 重新创建优化器

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 增量训练

for epoch in range(1, 6):

train(model, device, train_loader, optimizer, epoch, ewc=ewc, lambda_ewc=1.0)

current_classes = initial_classes + sum(n for _, n in phases[:phase])

test(model, device, test_loader, current_classes)

# 更新EWC参数

ewc = EWC(model, train_loader, device)

# 记录准确率

accuracies.append(test(model, device, test_loader, current_classes))

# 绘制准确率变化图

plt.plot([5, 8, 10], accuracies, marker='o')

plt.xlabel('Number of Classes')

plt.ylabel('Accuracy (%)')

plt.title('Incremental Learning Performance')

plt.grid()

plt.show()

if __name__ == '__main__':

main()

代码解读与分析

这个实现展示了增量学习的完整流程:

数据集处理:

IncrementalDataset

模型设计:

IncrementalModel

add_output_units

EWC实现:通过计算Fisher信息矩阵来评估参数重要性,并在损失函数中加入惩罚项,防止重要参数被大幅修改。

训练流程:

初始训练基础模型(类别0-4)保存初始模型参数用于EWC分阶段添加新类别并增量训练每个阶段后更新EWC参数

评估:测试模型在所有已学习类别上的表现,绘制准确率随类别增加的变化曲线。

这个实现展示了增量学习的核心挑战:如何在添加新能力(识别新数字)的同时,保持原有能力(正确识别旧数字)。EWC等技术通过约束重要参数的更新幅度来解决这个问题。

实际应用场景

1. 智能客服系统

应用描述:

智能客服系统需要不断学习新的产品信息和用户咨询方式。通过增量学习,系统可以在不中断服务的情况下持续改进:

学习新产品知识而不忘记旧产品适应用户新的表达方式根据用户反馈调整回答策略

实现要点:

使用回放缓冲区保存典型用户问答对领域特定参数应用更强的EWC约束定期评估新旧知识的保留情况

2. 医疗诊断AI

应用描述:

医疗诊断系统需要持续学习新的病例和医学发现:

添加对新疾病的认识吸收最新的医学研究成果适应不同人群的生理特征

技术挑战:

医疗数据隐私限制数据存储诊断准确性要求极高需要解释模型决策过程

解决方案:

使用生成对抗网络(GAN)生成合成数据用于回放采用模块化架构,不同疾病对应不同子网络结合注意力机制提高可解释性

3. 工业设备预测性维护

应用描述:

工厂设备监控系统需要适应:

新型号的设备设备老化带来的特征变化新的故障模式

实现方案:

class IndustrialIncrementalLearner:

def __init__(self):

self.base_model = load_pretrained_model()

self.ewc = EWC(self.base_model)

self.replay_buffer = ReplayBuffer(capacity=1000)

def update(self, new_data):

# 存储关键样本

self.replay_buffer.add(select_key_samples(new_data))

# 组合新数据和回放数据

train_data = combine(new_data, self.replay_buffer.sample())

# 增量训练

train_with_ewc(self.base_model, train_data, self.ewc)

# 更新EWC参数

self.ewc.update_fisher()

4. 个性化推荐系统

应用描述:

推荐系统需要持续适应用户变化的口味和新加入的商品:

新用户的行为模式新上架的商品特征季节性偏好变化流行趋势演变

技术实现:

用户和商品使用分离的嵌入空间对用户长期偏好参数应用强约束对短期兴趣参数允许更大调整使用元学习快速适应新用户

工具和资源推荐

开源框架

Avalanche:专为持续学习设计的PyTorch库

from avalanche.models import SimpleMLP

from avalanche.training import EWC

model = SimpleMLP(num_classes=10)

strategy = EWC(model, optimizer, ewc_lambda=0.4)

Continual Learning Baselines:包含多种增量学习算法的实现

git clone https://github.com/ContinualAI/continual-learning-baselines

PyTorch Lightning Bolts:提供增量学习模块

from pl_bolts.models import LitIncrementalLearner

数据集

CORe50:专为增量学习设计的视频数据集MNIST Split:将MNIST分成多个任务的变体CIFAR-100 Split:将CIFAR-100分成20个任务的版本

云服务

AWS SageMaker Incremental Training:支持模型的增量更新Google Vertex AI Continuous Learning:自动化模型再训练Azure ML Incremental Learning Pipelines:构建增量学习流水线

学习资源

书籍:《Continual Learning with Deep Architectures》课程:Coursera《Advanced Deep Learning with TensorFlow》论文:《Three Types of Incremental Learning》社区:ContinualAI论坛和Slack频道

未来发展趋势与挑战

发展趋势

更高效的记忆机制:

神经压缩存储稀疏记忆访问基于检索的记忆增强

跨模态增量学习:

class CrossModalIncrementalLearner:

def learn_visual_concept(self, images):

# 学习视觉概念

pass

def learn_textual_concept(self, text):

# 学习文本概念

pass

def align_modalities(self):

# 对齐不同模态的表征

pass

边缘设备上的增量学习:

轻量级算法联邦增量学习隐私保护技术

与大型语言模型结合:

基于提示的增量学习参数高效微调知识编辑技术

主要挑战

灾难性遗忘的彻底解决:

现有方法只能缓解,不能完全消除需要更深入理解神经网络的记忆机制

可扩展性问题:

随着任务数量增加,记忆需求线性增长计算复杂度上升

评估标准不统一:

准确率与遗忘率的权衡前向迁移与后向迁移的平衡缺乏标准化的评估协议

实际部署障碍:

生产环境中的稳定性问题与现有MLOps管道的集成监管和合规要求

总结:学到了什么?

核心概念回顾

增量学习:让AI系统能够持续学习新知识而不遗忘旧知识的技术,就像人类不断学习新事物而不忘记基本技能一样。

灾难性遗忘:神经网络在学习新任务时突然忘记之前学到的知识的现象,类似于学习新语言时忘记母语。

知识保留机制:防止遗忘的技术,包括回放缓冲区、弹性权重固化和知识蒸馏等,就像我们做笔记和定期复习的学习方法。

概念关系回顾

增量学习的核心挑战是克服灾难性遗忘,而各种知识保留机制就是解决这个问题的工具。三者之间的关系就像”目标-问题-解决方案”:

目标:实现增量学习问题:灾难性遗忘解决方案:知识保留机制

技术要点总结

算法选择:根据应用场景选择适合的增量学习算法,EWC适合参数重要性明确的任务,回放方法适合可以存储数据的场景。

实现关键:

平衡新旧知识的学习动态调整模型容量持续评估模型表现

应用价值:

减少重新训练成本实现AI系统的持续进化适应真实世界的变化

思考题:动动小脑筋

思考题一:如果你要设计一个智能家居系统的增量学习模块,需要考虑哪些特殊因素?如何解决?

可能的思考方向:

设备多样性问题用户隐私保护低功耗要求非均匀的数据流

思考题二:如何将增量学习与迁移学习结合,解决跨领域知识迁移的问题?

可能的思路:

识别可迁移的通用特征领域特定参数的弹性约束渐进式领域适应策略

思考题三:在自动驾驶系统中,哪些组件最适合采用增量学习?为什么?

考虑点:

交通标志识别驾驶行为预测路径规划策略异常情况处理

附录:常见问题与解答

Q1:增量学习与在线学习有什么区别?

A1:在线学习强调对数据流的即时响应,通常不考虑多任务或灾难性遗忘问题。增量学习则明确关注在学习新知识时保留旧知识,通常涉及更明显的任务或分布变化。

Q2:如何选择EWC中的λ参数?

A2:λ控制新旧知识的平衡,通常通过验证集调整:

在保留验证集上测试不同λ值选择在新旧任务表现都较好的值可以动态调整,初期较小,随着任务增加而增大

Q3:增量学习需要多少旧数据?

A3:取决于具体方法:

EWC等参数方法不需要旧数据回放方法通常需要5-20%的旧数据生成回放可以完全不用存储真实数据

Q4:如何处理类别不平衡的增量学习?

A4:几种策略:

动态调整分类器阈值重采样回放数据损失函数中加入类别权重分离表征学习和分类器学习

扩展阅读 & 参考资料

基础论文:

Kirkpatrick et al. “Overcoming catastrophic forgetting in neural networks” (EWC原论文)Lopez-Paz & Ranzato “Gradient Episodic Memory for Continual Learning”

进阶研究:

“Continual Learning in Neural Networks” 综述文章“Three Types of Incremental Learning” 分类研究

实践指南:

PyTorch官方增量学习教程AWS白皮书《Productionizing Incremental Learning》

相关领域:

元学习与增量学习的结合神经架构搜索在增量学习中的应用增量学习中的隐私保护技术

相关文章