一、Camera HAL层核心概念:定位与价值

1.1 什么是Camera HAL层

HAL(Hardware Abstraction Layer,硬件抽象层)是Android系统架构中连接Framework层与硬件驱动层的关键中间层,而Camera HAL层则是专门针对相机硬件的抽象实现。它通过标准化的接口封装不同厂商的相机硬件细节,向上为Framework层提供统一的相机操作接口,向下与相机驱动(Kernel Driver)及硬件模块(如传感器、ISP等)进行交互。

核心本质:解耦上层软件与底层硬件。无论底层采用何种品牌的相机传感器(如索尼IMX系列、三星GN系列)或ISP芯片,Framework层都能通过HAL层提供的标准接口完成相机调用,无需关注硬件实现差异。

1.2 HAL层在相机系统中的位置

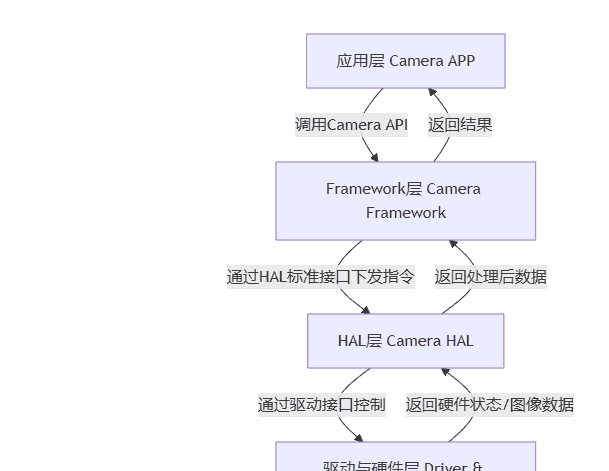

Android相机系统从上到下分为四层,HAL层处于核心枢纽位置,各层职责如下:

应用层(Application):如相机APP,通过调用Framework层API发起拍照、录像等请求;

Framework层(Camera Framework):提供Camera API(如Camera1/Camera2/CameraX),封装业务逻辑,将应用请求转化为HAL层可识别的指令;

HAL层(Camera HAL):接收Framework层指令,通过厂商自定义实现转化为驱动层可执行的硬件操作,同时将硬件状态、图像数据回传给Framework层;

驱动与硬件层(Driver & Hardware):相机驱动(如Linux V4L2驱动)直接控制硬件模块(传感器、ISP、闪光灯等)完成物理操作。

关键价值:HAL层的存在使Android系统具备跨硬件平台的兼容性,同时为厂商提供了硬件差异化定制的灵活空间(如自研ISP算法集成)。

二、Camera HAL层架构体系:分层与组件

2.1 整体架构分层

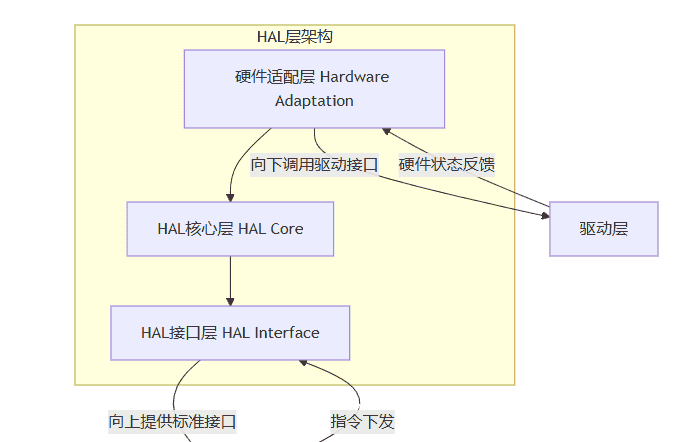

Camera HAL层采用“标准化接口+厂商实现”的架构模式,从逻辑上可分为三层,自上而下依次为:

HAL接口层(HAL Interface):由Google定义的标准化接口,是Framework层与HAL层交互的“契约”,核心为

camera_common.h

camera_device.h

HAL核心层(HAL Core):厂商自定义的核心实现层,是HAL层的“大脑”。负责解析Framework层请求、调度硬件资源、集成图像算法(如降噪、HDR)、管理数据流等核心逻辑,不同厂商的差异化能力主要体现在这一层。

硬件适配层(Hardware Adaptation):HAL层与驱动层的桥梁,负责将HAL核心层的指令转化为驱动层可识别的命令(如通过V4L2接口与传感器通信),同时接收驱动层上报的硬件状态和原始图像数据。

// HAL接口层核心结构体示例(camera_device.h)

typedef struct camera_device {

// 基础设备结构体

hw_device_t common;

// 设备操作函数指针(厂商需实现)

const struct camera_device_ops *ops;

// 设备私有数据

void *priv;

} camera_device_t;

// 相机设备操作函数集(核心接口)

typedef struct camera_device_ops {

// 打开相机流

int (*open_stream)(struct camera_device *dev,

const struct camera_stream_ops *stream_ops);

// 处理捕获请求

int (*process_capture_request)(struct camera_device *dev,

const struct camera_capture_request *request);

// 关闭相机

void (*close)(struct camera_device *dev);

} camera_device_ops_t;2.2 核心组件与模块

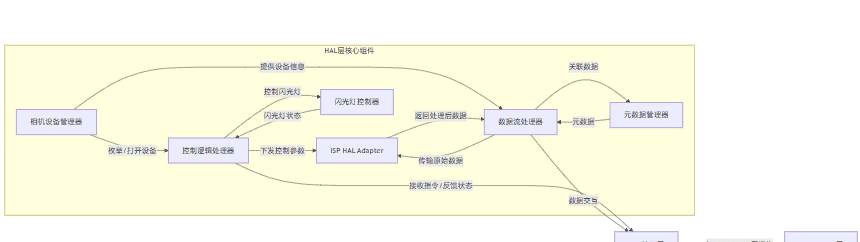

HAL层通过多个功能模块协同工作实现完整相机能力,核心组件包括:

相机设备管理器(Camera Device Manager):核心组件之一,负责枚举系统中所有可用相机设备(如后置主摄、超广角、前置摄像头),维护设备信息(如设备ID、支持的分辨率、帧率),并响应Framework层的设备打开/关闭请求。

数据流处理器(Stream Processor):管理相机的数据流传输,是HAL层的“数据中枢”。相机运行时会产生多种数据流(如预览流、拍照流、录像流),该模块负责为不同数据流分配缓冲区(Buffer),控制数据的采集、传输、格式转换(如将传感器输出的RAW格式转换为YUV格式),并将处理后的数据传递给Framework层或存储模块。

控制逻辑处理器(Control Processor):处理相机的控制指令,是HAL层的“控制中枢”。接收Framework层下发的控制参数(如对焦距离、曝光时间、ISO、白平衡模式),将其转化为硬件可识别的指令并下发给驱动层,同时监听硬件状态(如对焦是否完成、曝光是否稳定),并将状态反馈给Framework层。

图像信号处理器(ISP HAL Adapter):对接硬件ISP(Image Signal Processor),集成图像优化算法。ISP是相机成像质量的核心硬件,该模块负责配置ISP的参数(如降噪强度、锐化程度、色彩饱和度),调用ISP执行图像优化处理(如去马赛克、降噪、HDR合成、自动对焦算法计算),部分厂商会在此处集成自研的图像算法以提升成像效果。

闪光灯控制器(Flash Controller):专门管理闪光灯硬件,响应Framework层的闪光灯控制请求(如开启/关闭、调节亮度、闪光灯模式切换,如自动闪光、强制闪光),同时监测闪光灯状态(如温度是否过高、电量是否充足),避免硬件损坏。

元数据管理器(Metadata Manager):管理相机的元数据信息,是相机“信息载体”。元数据包括相机设备信息(如传感器型号、焦距)、拍摄参数(如曝光时间、ISO、白平衡值)、图像信息(如分辨率、格式)等,该模块负责元数据的采集、存储、更新和传递,确保Framework层和应用层能获取到完整的拍摄信息。

三、Camera HAL层关键子系统:功能拆解与实现

3.1 预览子系统:实时画面展示的核心

预览功能是相机最基础的功能之一,核心目标是将相机采集的实时画面高效地展示在屏幕上,要求低延迟、高帧率(通常需达到30fps以上)。其工作流程如下:

Framework层通过HAL接口向HAL层发送预览启动请求,携带预览参数(如预览分辨率1920×1080、帧率30fps、格式YUV420_888);

相机设备管理器打开指定相机设备(如后置主摄),数据流处理器通过

buffer_queue_create

控制逻辑处理器通过V4L2协议配置传感器(如设置分辨率1920×1080、帧率30fps)和ISP基础参数(如默认降噪强度),调用

sensor_start_stream

传感器通过MIPI CSI-2协议传输RAW数据至ISP,ISP执行去马赛克、基础降噪,将RAW转换为YUV420_888格式;

数据流处理器通过

buffer_queue_enqueue

on_buffer_available

SurfaceFlinger调用GPU渲染缓冲区数据至屏幕,形成预览画面。

关键优化点:为降低预览延迟,通常采用“缓冲区循环复用”机制,即提前分配多个缓冲区交替使用,避免数据传输等待;同时通过硬件加速(如GPU参与格式转换)提升数据处理效率。

3.2 拍照子系统:静态图像捕获的全流程

拍照子系统负责捕获静态图像并存储为指定格式(如JPEG、RAW),核心要求是成像质量高、捕获延迟低。其工作流程相比预览更复杂,涉及多帧数据处理和图像编码:

应用层触发拍照请求,Framework层将拍照参数(如输出分辨率、图像格式、质量等级)传递给HAL层;

控制逻辑处理器收到请求后,执行“拍照准备”操作:调整传感器和ISP参数(如提高曝光精度、切换到高分辨率模式),确保成像质量;

向传感器发送“捕获指令”,传感器采集一帧或多帧原始图像数据(如HDR拍照需采集不同曝光度的3-5帧数据);

多帧数据传输至ISP,ISP执行高级图像处理:HDR合成(融合不同曝光帧)、降噪、锐化、色彩校准等;

数据流处理器将处理后的图像数据传递给编码模块,编码模块将RAW/YUV数据编码为JPEG格式(或保留RAW格式供专业模式使用);

元数据管理器将拍摄参数(如曝光时间、ISO)写入图像文件的元数据区,数据流处理器将编码后的图像数据存储到指定路径,同时将拍摄完成信号反馈给Framework层。

关键技术点:拍照延迟的控制是核心难点,通常通过“预缓存”机制优化——预览过程中提前缓存几帧图像数据,拍照时直接使用缓存数据进行处理,减少传感器重新采集的等待时间。

3.3 录像子系统:动态视频录制的核心能力

录像子系统负责捕获连续的图像帧并编码为视频文件(如MP4),核心要求是帧率稳定(如30fps、60fps)、画面流畅、音视频同步。其工作流程如下:

应用层启动录像,Framework层传递录像参数(如分辨率、帧率、码率、视频编码格式(H.264/H.265)、音频采样率);

Camera HAL层与Audio HAL层协同工作:Camera HAL启动视频流采集,Audio HAL启动音频采集;

传感器以指定帧率连续采集图像数据,ISP实时处理每帧数据(如降噪、色彩调整),数据流处理器将YUV数据传递给视频编码模块;

视频编码模块(如基于硬件编码器H.265)将YUV数据编码为视频码流,音频编码模块将音频数据编码为音频码流;

音视频码流传递给封装模块,封装为MP4等容器格式(确保音视频同步,通过时间戳对齐);

实时将封装后的视频数据写入存储设备,录像结束后完成文件收尾,关闭音视频流。

关键挑战:帧率稳定性控制。若传感器采集速度或ISP处理速度跟不上指定帧率,会导致视频卡顿。通常通过“帧率自适应”机制优化——实时监测硬件处理能力,动态调整帧率或分辨率,确保流畅性。

3.4 对焦与曝光子系统:成像质量的核心保障

对焦(AF)和曝光(AE)是决定成像清晰度和亮度的关键技术,两者协同工作,由控制逻辑处理器和ISP HAL Adapter共同实现:

自动对焦(AF)子系统: 工作原理:通过ISP分析图像的对比度(对比度对焦,Contrast AF)或利用激光/相位传感器(相位对焦,PDAF;激光对焦,Laser AF)获取距离信息,计算出最佳对焦位置;

工作流程:Framework层下发对焦请求(如自动对焦、触摸对焦),控制逻辑处理器启动AF算法,ISP分析图像数据生成对焦评价函数(对比度值),根据评价函数调整镜头马达位置(驱动层控制马达移动),反复迭代直至对比度达到峰值(对焦成功),并反馈对焦状态;

常见模式:单次对焦(拍照时触发一次)、连续对焦(录像时实时跟踪对焦)、触摸对焦(聚焦于屏幕指定区域)。

自动曝光(AE)子系统: 工作原理:通过传感器采集画面亮度信息,ISP计算画面的平均亮度或关键区域亮度(如人脸识别后的人脸区域),结合ISO和快门速度的对应关系,调整曝光参数,使画面亮度适中;

工作流程:Framework层设置曝光模式(如自动、手动、夜景模式),控制逻辑处理器启动AE算法,ISP分析图像亮度数据,计算目标曝光值,动态调整传感器的快门时间(曝光时长)和ISO(感光度),同时兼顾画面噪点(高ISO会增加噪点),达到亮度与画质的平衡;

关联参数:曝光时间(越长画面越亮,易模糊)、ISO(越高画面越亮,噪点越多)、曝光补偿(手动调整画面明暗)。

四、Camera HAL层关键模式与交互机制

4.1 核心工作模式:从HAL1到HAL3的演进

Android相机HAL层经历了多个版本迭代,核心演进方向是“解耦控制与数据,提升硬件控制灵活性”,主要分为HAL1和HAL3两个关键版本:

|

对比维度 |

Camera HAL1 |

Camera HAL3(主流版本) |

|---|---|---|

|

架构模式 |

“控制-数据”耦合模式,采用“状态机”管理相机状态 |

“请求-响应”解耦模式,基于“相机请求(Camera Request)”驱动 |

|

控制粒度 |

粗粒度控制,Framework层只能控制整体状态(如预览/拍照切换),无法精细控制单帧参数 |

细粒度控制,支持为每帧图像单独设置参数(如单帧曝光时间、ISO),支持多帧不同参数采集(如HDR) |

|

数据流管理 |

单一流模式,预览和拍照共享同一数据流,切换时需重启流,延迟高 |

多流并行模式,预览、拍照、录像流可同时运行,独立管理,切换无延迟 |

|

硬件能力发挥 |

无法充分利用多核ISP、高帧率传感器等硬件能力,限制成像效果 |

支持硬件多请求并行处理,可充分发挥ISP、传感器的高性能,支持HDR、夜景等高级功能 |

|

兼容性 |

早期设备支持,Android 5.0后逐渐被HAL3替代 |

Android 5.0(API 21)及以上主流版本,是当前厂商实现的标准 |

4.2 核心交互机制:请求-响应模型(HAL3核心)

HAL3采用“请求-响应”(Request-Result)模型作为核心交互机制,彻底解耦Framework层与HAL层的交互,提升控制灵活性。其核心流程如下:

请求构建(Framework层):Framework层根据应用需求构建“相机请求”(CameraRequest),每个请求包含两部分核心信息:① 控制参数(如对焦模式、曝光时间、ISO、目标数据流);② 输出缓冲区(用于接收HAL层返回的图像数据)。

请求下发(接口调用):Framework层通过HAL3标准接口(如

process_capture_request

请求处理(HAL层):HAL层的控制逻辑处理器解析请求参数,调度传感器、ISP等硬件执行对应操作,采集并处理图像数据,将处理后的图像数据写入请求中的输出缓冲区,同时收集该帧的元数据(如实际曝光时间、对焦状态)。

结果返回(响应):HAL层通过回调接口(如

notify_capture_result

结果处理(Framework层):Framework层从结果中提取图像数据和元数据,传递给应用层展示或存储。

该机制的核心优势:支持“每帧独立控制”,Framework层可针对不同场景动态调整每帧的参数,例如在录像过程中突然触发拍照时,可临时下发一个高分辨率、高曝光精度的请求,而不影响录像流的正常运行。

4.3 缓冲区管理机制:数据高效传输的核心

相机数据流的传输依赖缓冲区(Buffer)管理,HAL层采用“缓冲区池+循环复用”机制确保数据高效传输,避免内存频繁分配释放导致的性能损耗。其核心设计如下:

缓冲区池(Buffer Pool):HAL层在初始化时,根据数据流的需求(如预览流分辨率、帧率)提前创建一批缓冲区,形成“缓冲区池”,缓冲区的数量通常为3-5个(兼顾性能与内存占用)。

循环复用:数据流传输时,缓冲区在“空闲-使用-回收”三个状态间循环:① 空闲缓冲区被分配给传感器,用于存储采集的原始数据;② 数据处理完成后,缓冲区被传递给Framework层使用(如预览渲染);③ Framework层使用完毕后,通过接口将缓冲区归还给HAL层的缓冲区池,重新进入空闲状态等待复用。

缓冲区格式统一:HAL层定义了标准化的缓冲区格式(如YUV420_888、RAW16),确保不同硬件和软件模块间的数据兼容性。对于需要格式转换的场景(如RAW转YUV),由数据流处理器通过硬件加速(如ISP或GPU)完成,避免软件转换导致的性能损耗。

五、Camera HAL层性能优化:关键指标与优化策略

5.1 核心性能指标

衡量Camera HAL层性能的核心指标的核心指标包括以下几项,直接影响用户体验和成像质量:

启动时间(Camera Startup Time):从应用发起相机启动请求到预览画面稳定显示的时间,理想值需控制在500ms以内。启动时间过长会导致用户等待感强烈,是优化的重点指标。

预览帧率(Preview Frame Rate):预览画面每秒刷新的帧数,主流要求30fps以上,高端设备支持60fps。帧率过低会导致预览画面卡顿、不流畅。

拍照延迟(Capture Latency):从用户点击拍照按钮到拍摄完成并反馈的时间,理想值需控制在300ms以内。延迟过高会导致“拍虚”(移动场景下)或“错过拍摄时机”。

录像帧率稳定性(Video Frame Rate Stability):录像过程中帧率的波动范围,要求波动不超过±2fps。帧率波动会导致视频画面卡顿、掉帧。

图像处理耗时(ISP Processing Time):ISP处理单帧图像的时间,直接影响拍照和录像的帧率。耗时过长会导致帧率下降或延迟增加。

5.2 关键优化策略

5.2.1 启动时间优化

预初始化机制:在系统启动或相机APP后台驻留时,提前初始化HAL层的核心模块(如相机设备管理器、缓冲区池),避免启动时重复初始化;同时提前加载常用的ISP算法和参数配置,减少算法加载时间。

异步初始化:将非关键初始化步骤(如闪光灯控制器初始化、次要相机设备枚举)改为异步执行,优先完成预览相关的核心初始化(如主摄设备打开、预览流配置),确保预览画面快速显示。

参数预配置:提前缓存常用的预览参数(如默认分辨率、帧率),启动时直接使用缓存参数配置硬件,避免重新读取和计算参数。

5.2.2 帧率与延迟优化

硬件加速:充分利用硬件模块的加速能力,如采用硬件ISP替代软件图像处理、使用GPU进行图像格式转换、采用DMA(直接内存访问)技术实现缓冲区数据的直接传输(避免CPU干预)。

数据流优化:优化缓冲区池大小,根据帧率需求动态调整缓冲区数量(如60fps预览时增加缓冲区数量);采用“零拷贝”技术(如使用GraphicBuffer直接渲染),减少数据在内存中的拷贝次数。

算法优化:简化或裁剪非必要的ISP算法(如预览时降低锐化强度、关闭部分降噪算法),优先保证帧率;采用轻量化算法替代传统复杂算法(如用快速对比度对焦替代高精度对焦算法)。

5.2.3 稳定性优化

帧率自适应调节:实时监测硬件负载(如ISP占用率、CPU使用率),当负载过高时,动态降低分辨率或帧率(如从60fps降至30fps),避免帧率骤降;负载降低后再恢复高帧率。

资源调度优先级提升:将HAL层的核心线程(如数据流处理线程、控制逻辑线程)设置为高优先级,确保在系统资源紧张时,相机相关线程能优先获取CPU和内存资源。

异常处理机制:增加硬件异常监测(如传感器采集失败、ISP处理超时),当出现异常时,快速切换到备用参数(如降低分辨率)或重启部分模块,避免整体崩溃。

六、Camera HAL层关键参数与配置

6.1 核心配置文件

Camera HAL层的配置通过XML或JSON格式的配置文件实现,厂商通过修改配置文件适配不同硬件,无需修改代码。核心配置文件包括:

camera_config.xml:核心配置文件,定义相机设备的基础信息,如设备ID、传感器型号、支持的分辨率、帧率、图像格式、ISP参数默认值等。例如,通过该文件配置主摄支持的拍照分辨率为4000×3000,预览帧率为30/60fps。

isp_config.xml:ISP专属配置文件,定义ISP的算法参数,如降噪强度、锐化系数、色彩矩阵、HDR合成参数等。不同传感器型号对应不同的ISP配置,以匹配传感器的特性。

flash_config.xml:闪光灯配置文件,定义闪光灯的型号、支持的亮度等级、闪光模式、温度阈值等。例如,配置闪光灯的最大亮度为1000lm,温度超过60℃时自动关闭。

6.2 关键可配置参数

|

参数类别 |

关键参数 |

作用说明 |

|---|---|---|

|

设备基础参数 |

device_id、sensor_model、lens_model |

标识相机设备ID、传感器型号、镜头型号,用于设备枚举和硬件适配 |

|

图像格式参数 |

preview_format、capture_format、video_format |

配置预览、拍照、录像的图像格式(如YUV420_888、RAW16、JPEG) |

|

分辨率与帧率参数 |

preview_resolutions、capture_resolutions、video_fps |

配置各场景支持的分辨率(如预览1920×1080)和帧率(如录像60fps) |

|

ISP算法参数 |

denoise_strength、sharpen_strength、hdr_level |

配置降噪强度、锐化强度、HDR等级,影响成像质量 |

|

对焦与曝光参数 |

af_mode、ae_range、iso_range、shutter_speed_range |

配置对焦模式(如PDAF)、曝光范围、ISO范围、快门速度范围 |

|

闪光灯参数 |

flash_brightness_levels、flash_modes、temp_threshold |

配置闪光灯亮度等级、支持的模式、温度阈值 |

七、Camera HAL层常见问题与排查思路

7.1 常见问题分类

设备枚举失败:Framework层无法识别相机设备,表现为相机APP显示“无可用相机”。

预览黑屏/花屏:预览画面黑屏、卡顿或显示异常色彩(如全绿、全红)。

拍照/录像失败:点击拍照无反应、拍照后无图像文件、录像无法启动或录制后文件损坏。

帧率过低/延迟过高:预览卡顿、拍照延迟长、录像掉帧。

成像质量问题:照片偏色、噪点多、模糊、HDR效果不佳。

7.2 核心排查思路

日志定位法(核心手段):通过精准抓取分层日志定位问题边界,关键命令与日志维度如下: – HAL层日志:

logcat -s CameraHal:V ISPAdapter:V StreamProc:V

dmesg | grep video0

硬件连通性校验:使用V4L2工具集直接与驱动交互,排除HAL层干扰,核心命令: – 枚举设备能力:

v4l2-ctl --list-formats-ext

v4l2-ctl --stream-mmap --stream-count=5 --stream-to=raw.raw

v4l2-ctl --set-ctrl=exposure_time_absolute=10000

重点接口调试:针对核心接口编写单测用例,验证HAL层实现正确性,代码如下:

// 调试HAL3核心接口process_capture_request的单测示例

void test_process_request(camera_device_t *dev) {

// 1. 构造测试请求(预览帧参数)

camera_capture_request req = {0};

req.request_id = 1001;

req.metadata.exposure_time = 10000; // 10ms

req.metadata.iso = 100;

req.stream_id = dev->priv->preview_stream.id;

// 分配输出缓冲区

req.output_buffer = buffer_alloc(dev->priv->preview_stream.width,

dev->priv->preview_stream.height,

PIXEL_FORMAT_YUV420);

// 2. 调用HAL接口

int ret = dev->ops->process_capture_request(dev, &req);

if (ret != 0) {

LOGE("process_capture_request failed, ret=%d", ret);

return;

}

// 3. 验证结果

if (req.output_buffer->data == NULL || req.output_buffer->size == 0) {

LOGE("output buffer is empty");

} else {

LOGI("request processed success, buffer size=%d", req.output_buffer->size);

// 保存数据用于分析

file_write("test_yuv.yuv", req.output_buffer->data, req.output_buffer->size);

}

buffer_free(req.output_buffer);

}参数与配置校验:通过解析配置文件和运行时参数对比,定位不匹配问题: – 配置文件校验:使用

xmllint --format camera_config.xml

camera_debug --get-isp-param

性能瓶颈分析:使用Android原生工具定位帧率、延迟问题: – 帧率测试:

systrace --time=10 -o trace.html gfx camera

perf record -p [hal_pid] -g

相关文章