AI人工智能加持,人脸识别精准度飙升:从模糊到清晰的技术革命

关键词

人脸识别、深度学习、神经网络、精准度优化、计算机视觉、特征提取、面部识别算法

摘要

想象一下,在一个拥挤的火车站,系统能在瞬间从数千人中准确识别出需要关注的个体;或者你的手机仅通过一瞥就能认出你,甚至在你戴着口罩时也能做到。这不是科幻电影的场景,而是当下AI驱动的人脸识别技术的真实能力。本文将深入探讨人工智能如何彻底改变人脸识别领域,从早期简单的几何特征匹配到如今的深度神经网络模型,揭秘精准度飙升背后的关键技术突破。我们将一步步解析人脸识别的工作原理,探索卷积神经网络、迁移学习等AI技术如何攻克姿态、光照、表情变化等传统难题,并通过实际案例和代码示例展示这些技术如何落地应用。无论你是技术爱好者、开发者还是只是对AI世界充满好奇的读者,这篇文章都将带你领略人脸识别技术的过去、现在与未来,以及它如何重塑我们的安全、便捷与隐私边界。

1. 背景介绍:人脸识别的进化之路

1.1 从人工识别到机器智能

在探讨AI如何提升人脸识别精准度之前,让我们先回顾一段简短的历史。人脸识别的概念并非新鲜事物,人类自古以来就在通过面部特征识别彼此——我们的大脑中甚至有专门负责面孔识别的区域(梭状回面孔区)。然而,让机器具备这种能力却是一个漫长而充满挑战的旅程。

早期的人脸识别系统(20世纪60-90年代)采用极其简单的方法:工程师们手动设计特征提取规则,如测量两眼距离、鼻子长度、下颌轮廓等几何特征,然后通过简单算法进行比对。这些系统就像一个需要严格按照公式做题的学生,只能在理想条件下勉强工作,一旦光照变化、姿态改变或出现表情,识别准确率就会大幅下降。

里程碑事件:

1966年:Woody Bledsoe开发了首个半自动化人脸识别系统,需要人工标记面部特征点1991年:Lawrence Roberts提出基于特征脸(Eigenface)的识别方法,开启了自动人脸识别时代2001年:Viola-Jones算法实现了实时人脸检测,广泛应用于数码相机2014年:DeepFace系统将人脸识别准确率提升至97.35%,首次超越人类水平(97.53%)2020年至今:先进模型在LFW数据集上准确率超过99.8%,接近完美识别

1.2 为何精准度如此重要?

人脸识别精准度的提升不仅仅是一个技术指标的改进,它直接关系到这项技术能否安全、可靠地应用于现实世界。想象以下场景:

安全领域:如果一个安防系统的识别准确率为99%,看似不错,但在每天处理100万人的大型机场,这意味着可能有1000人被错误识别——要么是危险人物逃脱,要么是无辜者被误拦。金融支付:支付验证系统的任何错误都可能导致经济损失或用户信任危机。司法公正:在法律场景中,错误的人脸识别可能导致无辜者被错误指认。

因此,精准度的每一个百分点提升都具有巨大的实际价值。从95%到99%的提升看似只有4个百分点,但错误率却降低了80%;从99%到99.9%的提升,错误率又降低了90%。这就是为什么研究者们不断追求小数点后更多位数的准确率提升。

1.3 目标读者与阅读收获

本文主要面向三类读者:

技术爱好者:希望了解人脸识别技术背后原理的读者开发人员:计划集成或开发人脸识别系统的工程师行业观察者:关注AI技术发展趋势及其社会影响的人士

通过阅读本文,你将能够:

理解人脸识别系统的基本工作原理和核心挑战掌握AI,特别是深度学习提升识别精准度的关键技术了解不同应用场景下的人脸识别解决方案认识到人脸识别技术的发展趋势和潜在挑战

1.4 核心挑战:是什么阻碍了精准度提升?

在AI技术广泛应用之前,人脸识别面临着诸多难以逾越的障碍,这些障碍也是精准度提升的主要瓶颈:

1. 类内差异大:同一个人的面部图像在不同条件下可能差异很大

姿态变化:正面、侧面、抬头、低头等光照条件:强光、弱光、背光、不同色温光源表情变化:微笑、皱眉、惊讶等各种表情年龄增长:面部特征随时间自然变化遮挡:眼镜、口罩、头发、围巾等遮挡物

2. 类间相似性高:不同人的面部可能非常相似

双胞胎或亲属之间的高度相似性不同人之间的偶然相似

3. 图像质量问题:

分辨率不足或模糊噪声干扰压缩失真

4. 环境干扰:

复杂背景动态场景中的运动模糊摄像头角度和距离变化

传统方法面对这些挑战时显得力不从心,就像试图用一把尺子精确测量不断变化的物体。而AI,特别是深度学习技术的出现,为解决这些问题提供了全新的思路和强大的工具。

2. 核心概念解析:人脸识别的”ABC”

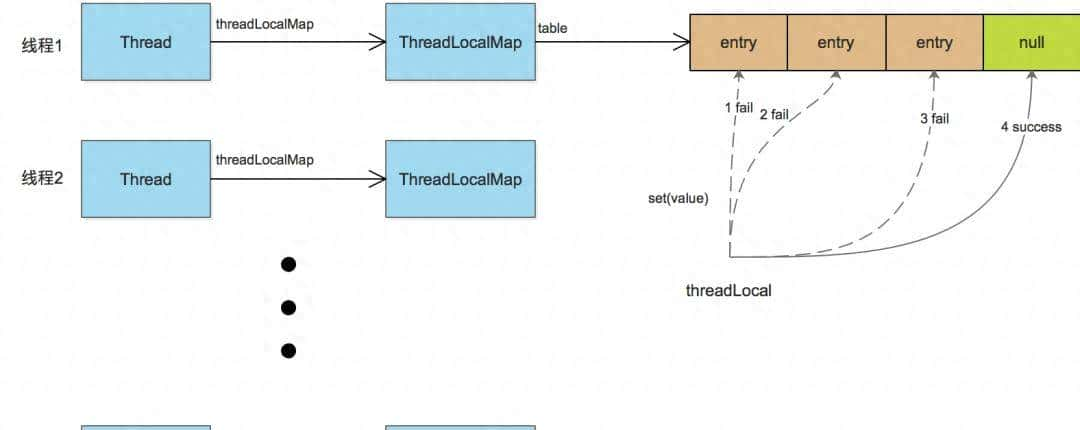

2.1 人脸识别系统的基本框架

让我们先建立一个基本认知:一个完整的人脸识别系统通常包含四个主要步骤,就像工厂的生产线一样,每个环节都至关重要。

1. 图像采集:通过摄像头等设备获取原始图像或视频流。这一步就像我们用眼睛看东西,是整个过程的起点。

2. 人脸检测:从图像中定位并提取出人脸区域。想象在一张合影中,系统需要先”找到”谁是人脸,谁是背景、树木或其他物体。输出通常是人脸的边界框坐标。

3. 特征提取:将人脸图像转换为计算机可理解的数学表示(通常是一个高维向量)。这一步相当于为每个人脸创建一个”数字身份证”。

4. 特征比对:将待识别的人脸特征与数据库中的已知特征进行比较,计算相似度。如果相似度超过设定阈值,则认为是同一个人。

AI技术在这四个步骤中都发挥着重要作用,但对精准度提升影响最大的是特征提取环节。正是在这个环节,深度学习带来了革命性的突破。

2.2 从”手工特征”到”学习特征”:AI带来的范式转变

传统人脸识别技术与AI驱动的人脸识别技术最根本的区别在于特征提取方式的不同。

传统方法(非AI):工程师手动设计特征提取规则,如:

几何特征:测量眼睛、鼻子、嘴巴等器官的位置和距离纹理特征:分析面部皮肤的纹理模式模板匹配:将人脸与预定义模板进行比较

这就像一位侦探根据手册上的特征描述来寻找嫌疑人:”身高175cm,戴眼镜,短发…”这种方法的缺点是:

特征设计依赖人工经验,难以覆盖所有变化情况对光照、姿态等变化非常敏感无法捕捉人脸图像中复杂的非线性特征

AI方法(特别是深度学习):让计算机通过大量数据自动学习应该提取哪些特征。这相当于侦探不再依赖固定手册,而是通过分析成千上万的案例,自己总结出识别不同人的最佳方法。

深度学习模型能够自动学习从低级特征(边缘、纹理)到高级特征(眼睛、鼻子、面部整体结构)的层次化表示,这种能力是传统方法无法比拟的。

2.3 人脸识别的”精准度”到底是什么?

在深入技术细节之前,我们需要明确”精准度”的具体含义。人脸识别系统的性能评估涉及多个指标:

1. 准确率(Accuracy):正确识别的样本数占总样本数的比例

TP(True Positive):正确识别出目标个体TN(True Negative):正确排除非目标个体FP(False Positive):错误地将某人识别为目标个体(误识)FN(False Negative):未能识别出目标个体(拒识)

2. 错误接受率(FAR, False Acceptance Rate):将陌生人错误识别为已知人员的概率

3. 错误拒绝率(FRR, False Rejection Rate):将已知人员错误拒绝的概率

4. 等错误率(EER, Equal Error Rate):当FAR和FRR相等时的错误率,是衡量系统整体性能的重要指标。EER越低,系统性能越好。

生动比喻:想象人脸识别系统是一个门卫。FAR高意味着门卫经常错误地让陌生人进入(安全隐患),FRR高则意味着门卫经常不让合法人员进入(使用不便)。系统设计往往需要在FAR和FRR之间找到平衡,就像调整天平的两端。

2.4 神经网络如何”看见”人脸?

要理解AI如何提升人脸识别精准度,我们需要先了解神经网络如何”看见”和”理解”人脸。这可以通过一个生动的比喻来说明:

人脸识别神经网络就像一个面部特征专家团队:

第一层专家:只关注最基础的特征,如边缘、线条和颜色变化。他们就像负责观察”这里有一条水平线”、”那里有一个曲线”的初级侦探。

中间层专家:将第一层发现的基础特征组合起来,识别出更复杂的组件,如眼睛、鼻子、嘴巴等面部器官的局部形状。他们就像负责识别”这是一只眼睛”、”那是一个鼻子”的中级侦探。

高层专家:综合所有中层专家的报告,形成对整个人脸的整体理解,包括各个器官之间的关系和整体特征。他们就像负责综合所有线索,形成最终判断的高级侦探。

最终决策者:将高层专家的描述与数据库中的已知人脸进行比对,做出最终识别判断。

这个团队通过处理成千上万张人脸图像,不断学习和优化各自的判断标准,从而逐渐提高识别能力。

2.5 什么是”人脸嵌入”(Face Embedding)?

人脸嵌入是现代人脸识别系统的核心概念,也是AI提升精准度的关键技术之一。

简单来说:人脸嵌入是将一张人脸图像转换为一个固定长度的数字向量的过程。这个向量就像人脸的”数字指纹”,包含了区分不同人脸的关键信息。

比喻解释:想象每个人脸都有一个独特的”身份证号码”,这个号码由数百个数字组成。相似的人脸,其”身份证号码”也比较相似;不同的人脸,其号码差异较大。人脸嵌入就是为每个人脸生成这样一个”身份证号码”。

技术解释:通过深度神经网络处理人脸图像,最终在全连接层输出一个固定维度(如128维、256维或512维)的向量。这个向量具有良好的”可区分性”和”度量性”:

同一个人的不同图像会生成相似的向量(小距离)不同人的图像会生成差异较大的向量(大距离)

这种特性使得我们可以通过简单计算两个向量之间的距离(如欧氏距离、余弦相似度)来判断它们是否属于同一个人。

graph LR

A[人脸图像A] -->|神经网络| B[向量A: [0.2, 0.5, 0.1, ..., 0.8]]

C[人脸图像B(同一人)] -->|神经网络| D[向量B: [0.3, 0.4, 0.2, ..., 0.7]]

E[人脸图像C(不同人)] -->|神经网络| F[向量C: [0.8, 0.1, 0.9, ..., 0.2]]

B ---|距离小| D

B ---|距离大| F

3. 技术原理与实现:AI如何攻克精准度难关

3.1 卷积神经网络(CNN):人脸识别的”火眼金睛”

卷积神经网络(CNN)是现代人脸识别系统的核心技术,正是它的出现使得人脸识别精准度实现了质的飞跃。那么CNN究竟是什么,它为什么如此适合处理图像识别任务?

CNN的核心思想:模拟人类视觉系统的工作方式,通过层级化的特征提取和学习,自动发现图像中的关键模式。

关键组件解析:

卷积层(Convolutional Layer)

作用:提取局部特征,如边缘、纹理、形状等工作原理:使用卷积核对输入图像进行滑动窗口计算,每个卷积核专注于检测特定特征比喻:就像用不同的滤镜观察同一张照片,每个滤镜突出显示照片的不同特征(如边缘检测滤镜、模糊滤镜等)数学表示:对于输入图像XXX和卷积核WWW,输出特征图YYY计算如下:

作用:降低特征图维度,提高计算效率,增强平移不变性常见类型:最大池化(Max Pooling)、平均池化(Average Pooling)比喻:就像将一张高分辨率图片缩小,虽然细节减少,但整体特征仍然保留

激活函数(Activation Function)

作用:引入非线性变换,使网络能够学习复杂模式常见类型:ReLU, Sigmoid, Tanh比喻:就像神经元是否被激活传递信号,只有当特征足够明显时才会激活下一层

全连接层(Fully Connected Layer)

作用:将卷积层提取的特征映射到样本标记空间在人脸识别中的特殊作用:通常作为嵌入层,输出人脸的特征向量

CNN在人脸识别中的优势:

局部感知:关注局部特征及其空间关系权值共享:减少参数数量,提高学习效率层级特征学习:自动学习从低级到高级的特征表示平移不变性:对输入图像的微小位移不敏感

3.2 里程碑模型:从LeNet到FaceNet

人脸识别领域的精准度提升离不开一系列里程碑式的模型创新。让我们沿着历史脉络,了解这些关键模型如何一步步推动技术边界:

1. LeNet-5 (1998)

贡献:首个成功的CNN模型,开创了深度学习在图像识别中的应用结构:包含2个卷积层、2个池化层和2个全连接层局限性:网络规模小,表达能力有限,未专门针对人脸优化

2. VGG-Face (2015)

贡献:使用更深的网络结构(16-19层)和更小的卷积核(3×3),显著提升特征提取能力性能:在LFW数据集上达到98.95%的准确率创新点:采用连续的3×3卷积核代替大卷积核,在减少参数的同时提高表达能力

3. FaceNet (2015, Google)

贡献:提出了”三元组损失”(Triplet Loss)函数,直接优化人脸嵌入空间性能:LFW准确率达到99.63%,首次接近人类水平核心思想:学习将人脸映射到欧氏空间的嵌入,使得同一个人的不同图像在空间中距离很近,不同人的图像距离很远

三元组损失公式:

d(a,p)d(a,p)d(a,p):Anchor人脸与Positive人脸的距离d(a,n)d(a,n)d(a,n):Anchor人脸与Negative人脸的距离αalphaα:边界值,确保同一人与不同人之间有足够区分度

4. ArcFace (2018)

贡献:提出”角度损失”(Additive Angular Margin Loss),进一步提升嵌入特征的判别性性能:在LFW上准确率提升至99.83%核心思想:在特征空间中直接优化类别间的角度边界,增强类间区分度和类内紧凑度

5. 最新进展:

EfficientFace:在保持高精度的同时大幅减少计算量MaskedFaceNet:针对戴口罩场景优化的人脸识别模型跨模态人脸识别:如可见光与红外图像的跨模态匹配

3.3 迁移学习:站在巨人肩膀上的精准度提升

训练一个高性能的人脸识别模型通常需要海量数据和巨大的计算资源,这对大多数开发者来说是难以企及的。迁移学习技术的出现,让我们能够”站在巨人的肩膀上”,显著降低了开发门槛。

迁移学习的基本概念:将从一个任务(如大规模人脸分类)中学到的知识应用到另一个相关任务(如特定场景的人脸识别)中。

比喻解释:想象你已经是一位熟练的钢琴演奏者,现在想学小提琴。虽然乐器不同,但你已经掌握的音乐理论、节奏感和手指协调能力都可以迁移过来,大大加快学习过程。

迁移学习在人脸识别中的应用方式:

特征提取器:

使用在大规模数据集上预训练的模型(如VGG-Face、FaceNet)作为固定特征提取器只训练最后几层或新的分类器优势:需要数据少,训练快,泛化能力强

微调(Fine-tuning):

加载预训练模型权重使用新的数据集继续训练整个网络或部分层优势:能够适应新数据的特点,保持原有知识的同时学习新知识

模型融合:

结合多个预训练模型的输出,综合判断优势:降低单一模型的偏差,提高鲁棒性

迁移学习为何能提升精准度:

预训练模型已经学习了人脸的通用特征,如边缘、纹理、基本器官结构等避免从零开始训练导致的过拟合问题,特别是在数据有限时加速收敛,减少训练时间和资源需求

3.4 数据增强:用智慧弥补数据不足

高质量、多样化的训练数据是提升人脸识别精准度的关键。然而,获取大规模标注数据往往成本高昂且耗时。数据增强技术通过智能地变换现有数据,创造出”新”的训练样本,有效解决了数据不足的问题。

数据增强的核心思想:通过对原始图像进行各种合理变换,生成保持标签不变的新样本,增加训练数据的多样性,提高模型的泛化能力。

人脸识别中常用的数据增强技术:

基础几何变换:

随机裁剪和缩放随机旋转(±15°以内,避免过度旋转导致面部结构变形)水平翻转(需注意某些场景下翻转会改变身份信息)

光照和颜色变换:

随机亮度、对比度调整随机添加高斯噪声颜色抖动(轻微调整RGB通道值)模拟不同光照条件(如左侧光照、右侧光照、顶光等)

高级增强技术:

Mixup:将两张图像按比例混合,标签也相应混合CutMix:将一张图像的部分区域替换为另一张图像的对应区域风格迁移:保持人脸身份特征不变,改变图像风格(如从照片风格变为素描风格)

人脸特定增强:

随机遮挡(模拟戴眼镜、口罩等场景)表情变化模拟姿态调整(使用3D人脸模型生成不同姿态)

数据增强效果:就像一位武术大师通过在各种地形(平地、山地、雨天、雪天)练习来提升实战能力,模型通过在各种”变换”数据上训练,能够更好地应对真实世界中的各种变化。

代码示例:使用Python和OpenCV实现基本人脸数据增强

import cv2

import numpy as np

import random

def face_augmentation(image):

"""

对人脸图像进行随机数据增强

参数:

image: 输入人脸图像 (numpy数组)

返回:

augmented_image: 增强后的人脸图像

"""

augmented_image = image.copy()

# 随机水平翻转 (50%概率)

if random.random() > 0.5:

augmented_image = cv2.flip(augmented_image, 1)

# 随机旋转 (-15° 到 15°)

angle = random.uniform(-15, 15)

rows, cols = augmented_image.shape[:2]

M = cv2.getRotationMatrix2D((cols/2, rows/2), angle, 1)

augmented_image = cv2.warpAffine(augmented_image, M, (cols, rows), borderMode=cv2.BORDER_CONSTANT, borderValue=(128,128,128))

# 随机亮度调整

brightness_factor = random.uniform(0.7, 1.3)

hsv = cv2.cvtColor(augmented_image, cv2.COLOR_BGR2HSV)

hsv[:,:,2] = np.clip(hsv[:,:,2] * brightness_factor, 0, 255)

augmented_image = cv2.cvtColor(hsv, cv2.COLOR_BGR2RGB)

# 随机添加高斯噪声

if random.random() > 0.5:

mean = 0

sigma = random.uniform(5, 15)

gauss = np.random.normal(mean, sigma, (rows, cols, 3))

noisy_image = np.clip(augmented_image + gauss, 0, 255).astype(np.uint8)

augmented_image = noisy_image

# 随机遮挡 (模拟戴口罩等)

if random.random() > 0.7:

# 在鼻子和嘴巴区域添加矩形遮挡

遮挡高度 = random.randint(rows//4, rows//3)

遮挡宽度 = cols//2

start_y = rows//2 - rows//10

cv2.rectangle(augmented_image,

(cols//2 - 遮挡宽度//2, start_y),

(cols//2 + 遮挡宽度//2, start_y + 遮挡高度),

(random.randint(0,255), random.randint(0,255), random.randint(0,255)),

-1)

return augmented_image

3.5 优化策略:从训练到部署的全流程优化

要实现人脸识别精准度的最大化,需要从模型训练到部署的全流程进行优化。这些优化策略相互配合,共同提升系统性能。

1. 损失函数优化:

Softmax Loss:传统分类损失函数Triplet Loss:优化特征空间距离ArcFace Loss:优化特征空间角度边界CosFace Loss:优化余弦相似度边界对比损失(Contrastive Loss):同时优化正负样本对

2. 网络结构优化:

深度与宽度平衡:更深的网络能学习更复杂特征,但需要更多数据防止过拟合注意力机制:让网络自动关注面部关键区域(如眼睛、鼻子等)多尺度特征融合:结合不同层级的特征,兼顾细节和整体信息轻量级网络设计:如MobileNet、EfficientNet等,在保持精度的同时减少计算量

3. 训练策略优化:

学习率调度:动态调整学习率,如余弦退火、循环学习率等早停策略:在验证集性能不再提升时停止训练,防止过拟合正则化:Dropout、L1/L2正则化、批量归一化(Batch Normalization)梯度裁剪:防止梯度爆炸,提高训练稳定性

4. 后处理优化:

特征归一化:将特征向量归一化到单位球面上,提高距离度量的一致性分数校准:对模型输出的相似度分数进行校准,提高阈值设置的可靠性集成方法:结合多个模型的预测结果,如投票、堆叠等人脸质量评估:对输入人脸图像质量进行评估,低质量图像可要求重拍或提高阈值

5. 部署优化:

模型量化:将浮点模型转换为定点模型(如FP16、INT8),减少计算量和内存占用模型剪枝:移除冗余参数和连接,减小模型大小知识蒸馏:将复杂模型(教师)的知识转移到简单模型(学生)硬件加速:利用GPU、TPU或专用AI芯片加速推理

优化效果展示:

| 优化策略 | 在LFW数据集上的准确率 | 模型大小 | 推理速度 |

|---|---|---|---|

| 基础CNN模型 | 96.5% | 256MB | 100ms/张 |

| + Triplet Loss | 98.3% | 256MB | 100ms/张 |

| + 迁移学习 | 99.1% | 256MB | 100ms/张 |

| + 数据增强 | 99.4% | 256MB | 100ms/张 |

| + ArcFace Loss | 99.65% | 256MB | 100ms/张 |

| + 轻量级网络设计 | 99.55% | 32MB | 20ms/张 |

| + 模型量化 | 99.5% | 8MB | 5ms/张 |

3.6 代码实现:构建一个基础人脸识别系统

下面我们将实现一个基于预训练模型的人脸识别系统,展示AI技术如何实际应用于人脸识别任务。我们将使用PyTorch框架和预训练的FaceNet模型。

步骤1:环境准备

# 安装必要的库

!pip install torch torchvision opencv-python numpy matplotlib scikit-learn

import torch

import torch.nn as nn

import torchvision.transforms as transforms

import cv2

import numpy as np

import matplotlib.pyplot as plt

from PIL import Image

from sklearn.metrics.pairwise import cosine_similarity

import os

步骤2:加载预训练模型

# 我们使用一个预训练的FaceNet模型

# 注意:在实际应用中,你可能需要使用更先进的模型如ArcFace

class FaceNet(nn.Module):

"""简化版FaceNet模型定义"""

def __init__(self, embedding_dim=128):

super(FaceNet, self).__init__()

# 使用预训练的ResNet50作为基础模型

self.base_model = torch.hub.load('pytorch/vision:v0.10.0', 'resnet50', pretrained=True)

# 替换最后一层,输出嵌入向量

in_features = self.base_model.fc.in_features

self.base_model.fc = nn.Linear(in_features, embedding_dim)

def forward(self, x):

return self.base_model(x)

# 初始化模型

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

model = FaceNet(embedding_dim=128).to(device)

model.eval() # 设置为评估模式

# 定义图像预处理

preprocess = transforms.Compose([

transforms.Resize((160, 160)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.5, 0.5, 0.5], std=[0.5, 0.5, 0.5]),

])

步骤3:人脸检测与预处理

def detect_face(image_path, detector=None):

"""

从图像中检测并提取人脸区域

参数:

image_path: 图像路径或图像数组

detector: 人脸检测器,默认为OpenCV的Haar级联分类器

返回:

face_image: 提取的人脸图像 (PIL格式)

bounding_box: 人脸边界框 (x, y, w, h)

"""

if isinstance(image_path, str):

image = cv2.imread(image_path)

else:

image = image_path.copy()

if image is None:

raise ValueError("无法加载图像")

# 转换为灰度图进行检测

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 使用默认的Haar级联分类器

if detector is None:

detector = cv2.CascadeClassifier(cv2.data.haarcascades + 'haarcascade_frontalface_default.xml')

# 检测人脸

faces = detector.detectMultiScale(gray, scaleFactor=1.1, minNeighbors=5, minSize=(100, 100))

if len(faces) == 0:

return None, None # 未检测到人脸

# 取最大的人脸(假设图像中只有一个主要人脸)

x, y, w, h = max(faces, key=lambda rect: rect[2] * rect[3])

# 提取人脸区域

face_img = image[y:y+h, x:x+w]

# 转换为RGB格式 (OpenCV默认是BGR)

face_img = cv2.cvtColor(face_img, cv2.COLOR_BGR2RGB)

# 转换为PIL图像

face_img = Image.fromarray(face_img)

return face_img, (x, y, w, h)

步骤4:人脸特征提取

def extract_face_embedding(image_path, model, preprocess, device):

"""

从人脸图像中提取嵌入特征

参数:

image_path: 图像路径

model: 预训练的人脸识别模型

preprocess: 图像预处理管道

device: 计算设备 (CPU/GPU)

返回:

embedding: 人脸嵌入特征向量

"""

# 检测人脸

face_img, _ = detect_face(image_path)

if face_img is None:

return None

# 预处理图像

img_tensor = preprocess(face_img).unsqueeze(0).to(device)

# 提取特征

with torch.no_grad(): # 禁用梯度计算

embedding = model(img_tensor)

# 归一化特征向量

embedding = embedding.cpu().numpy()

embedding = embedding / np.linalg.norm(embedding)

return embedding

步骤5:人脸识别与比对

class FaceRecognizer:

"""人脸识别器类"""

def __init__(self, model, preprocess, device, threshold=0.6):

self.model = model

self.preprocess = preprocess

self.device = device

self.threshold = threshold # 相似度阈值

self.database = {} # 存储已知人脸的嵌入 {"name": embedding}

def add_face_to_database(self, name, image_path):

"""添加人脸到数据库"""

embedding = extract_face_embedding(image_path, self.model, self.preprocess, self.device)

if embedding is not None:

self.database[name] = embedding

return True

return False

def recognize_face(self, image_path):

"""识别人脸"""

# 提取待识别人脸的嵌入

unknown_embedding = extract_face_embedding(image_path, self.model, self.preprocess, self.device)

if unknown_embedding is None:

return None, 0.0

# 与数据库中的所有人脸比对

max_similarity = -1

best_match = None

for name, embedding in self.database.items():

# 计算余弦相似度

similarity = cosine_similarity(unknown_embedding, embedding)[0][0]

# 更新最佳匹配

if similarity > max_similarity:

max_similarity = similarity

best_match = name

# 判断是否匹配成功

if max_similarity >= self.threshold:

return best_match, max_similarity

else:

return "Unknown", max_similarity

def verify_face(self, image_path1, image_path2):

"""验证两张图像是否属于同一个人"""

embedding1 = extract_face_embedding(image_path1, self.model, self.preprocess, self.device)

embedding2 = extract_face_embedding(image_path2, self.model, self.preprocess, self.device)

if embedding1 is None or embedding2 is None:

return False, 0.0

# 计算余弦相似度

similarity = cosine_similarity(embedding1, embedding2)[0][0]

return similarity >= self.threshold, similarity

步骤6:使用示例

# 创建人脸识别器实例

recognizer = FaceRecognizer(model, preprocess, device, threshold=0.55)

# 假设我们有一个人脸数据库,包含几个人的照片

# 添加人脸到数据库

# recognizer.add_face_to_database("person1", "person1_photo.jpg")

# recognizer.add_face_to_database("person2", "person2_photo.jpg")

# recognizer.add_face_to_database("person3", "person3_photo.jpg")

# 识别人脸示例

# name, score = recognizer.recognize_face("unknown_photo.jpg")

# print(f"识别结果: {name}, 相似度: {score:.2f}")

# 验证人脸示例

# is_same, score = recognizer.verify_face("photo1.jpg", "photo2.jpg")

# print(f"是否为同一人: {is_same}, 相似度: {score:.2f}")

print("人脸识别系统已准备就绪!")

注意:这个代码示例提供了一个基础框架。在实际应用中,为了获得更高的精准度,你可能需要:

使用更先进的预训练模型(如ArcFace、InsightFace等)进行模型微调以适应特定场景优化人脸检测算法(如使用MTCNN代替Haar级联分类器)增加更多的错误处理和边缘情况处理

4. 实际应用:从实验室到真实世界

4.1 应用场景全景图

AI加持的高精度人脸识别技术已经从实验室走向了广阔的应用领域,深刻改变着我们的生活方式和工作模式。让我们探索一些最具代表性的应用场景:

1. 安全与安防

视频监控:智能分析摄像头流,实时识别可疑人员门禁系统:替代传统钥匙和门禁卡,提高安全性和便捷性边境控制:自动化通关检查,提高效率同时增强国家安全犯罪侦查:快速匹配嫌疑人,缩短破案时间

2. 金融服务

身份验证:开户、贷款等业务中的远程身份核验支付授权:人脸支付,替代密码和指纹反欺诈:检测账户异常登录和交易行为智能客服:结合人脸识别的个性化服务

3. 智能设备与移动应用

设备解锁:智能手机、电脑等设备的人脸解锁相机应用:智能美颜、表情识别、合影优化社交娱乐:照片标签、人脸特效、虚拟形象

4. 交通出行

智慧机场:刷脸值机、安检、登机一体化流程智能交通:驾驶员身份识别、疲劳驾驶检测共享出行:人脸验证租车/共享单车用户身份

5. 零售与营销

智能导购:识别回头客,提供个性化推荐无人商店:刷脸进出、自动结算客户分析:分析顾客年龄、性别、情绪等特征

6. 医疗健康

患者身份识别:准确匹配患者与病历信息远程医疗:远程问诊中的身份验证疾病诊断:某些遗传性疾病和罕见病的辅助诊断

7. 教育与办公

智能考勤:自动记录学生/员工出勤情况专注度分析:课堂或会议中的注意力监测考试防作弊:考生身份核验和行为监测

8. 公共服务

政务办理:社保、身份证等政务服务的自助办理智慧城市:图书馆、博物馆等公共场所的智能服务寻人服务:帮助寻找失踪人口,特别是儿童和老人

4.2 案例分析1:智能手机中的人脸识别

智能手机是人脸识别技术最普及的应用场景之一。让我们以苹果的Face ID为例,深入了解其工作原理和精准度保障措施。

Face ID的技术原理:

硬件:TrueDepth摄像头系统,包含红外摄像头、泛光感应元件、点阵投影器工作流程:

点阵投影器投射30,000多个肉眼不可见的红外点到用户脸上红外摄像头捕获面部深度信息,创建精确的3D面部模型A12及以上仿生芯片中的神经网络引擎处理面部数据与安全隔区中存储的面部数据进行比对,完成验证

精准度与安全性设计:

错误率:官方宣称误识率仅为百万分之一,远低于Touch ID的五万分之一活体检测:通过红外成像和深度信息防止照片、面具等欺骗手段动态更新:系统会自动学习用户面部的变化(如留胡须、戴眼镜等)安全隔离:面部数据存储在安全隔区(Secure Enclave),不会上传到云端

技术挑战与解决方案:

低光环境:红外成像技术不受可见光影响面部变化:持续学习机制适应发型、妆容、年龄等变化速度要求:专用硬件加速确保识别过程在几百毫秒内完成姿态变化:3D建模技术支持不同角度的面部识别

用户体验与精准度的平衡:

Face ID在设计中面临着”安全与便捷”的平衡挑战。过于严格的验证会提高安全性但降低用户体验,过于宽松则反之。苹果通过先进的AI算法和专用硬件,在保持极高安全性的同时,实现了流畅的用户体验。

4.3 案例分析2:疫情下的戴口罩人脸识别

2020年以来的新冠疫情使得口罩成为日常生活的必需品,这给传统人脸识别系统带来了巨大挑战——系统突然”失明”了,因为口罩遮挡了面部30-50%的关键特征。

挑战分析:

传统模型严重依赖嘴巴、鼻子等下部面部特征口罩遮挡导致特征缺失,识别准确率大幅下降(某些系统准确率从99%降至60%以下)既要准确识别,又要保障公共健康安全

技术解决方案:

算法优化:

专注可见特征:增强对眼睛、眉毛等可见区域的特征提取多模态融合:结合红外、热成像等其他模态数据迁移学习:使用戴口罩人脸数据微调现有模型

数据增强:

合成大量戴口罩人脸数据用于训练模拟不同口罩类型、颜色和佩戴方式

新型网络设计:

遮挡感知网络:自动检测遮挡区域,重点关注未遮挡部分注意力机制:引导模型关注可见的关键面部区域

代码示例:遮挡感知人脸识别模型的注意力机制

import torch

import torch.nn as nn

import torch.nn.functional as F

class MaskAwareFaceNet(nn.Module):

def __init__(self, embedding_dim=128):

super(MaskAwareFaceNet, self).__init__()

# 基础特征提取网络

self.base_cnn = nn.Sequential(

nn.Conv2d(3, 64, kernel_size=3, padding=1),

nn.ReLU(),

nn.MaxPool2d(2, 2),

nn.Conv2d(64, 128, kernel_size=3, padding=1),

nn.ReLU(),

nn.MaxPool2d(2, 2),

nn.Conv2d(128, 256, kernel_size=3, padding=1),

nn.ReLU(),

nn.MaxPool2d(2, 2),

)

# 遮挡检测分支

self.mask_detector = nn.Sequential(

nn.Conv2d(256, 128, kernel_size=3, padding=1),

nn.ReLU(),

nn.Conv2d(128, 1, kernel_size=1), # 输出遮挡概率图

nn.Sigmoid()

)

# 注意力机制

self.attention = nn.Sequential(

nn.Conv2d(256, 256, kernel_size=3, padding=1),

nn.Softmax(dim=1) # 计算通道注意力权重

)

# 特征融合与嵌入层

self.fc = nn.Sequential(

nn.Linear(256 * 20 * 20, 1024),

nn.ReLU(),

nn.Dropout(0.5),

nn.Linear(1024, embedding_dim)

)

def forward(self, x):

# 基础特征提取

features = self.base_cnn(x) # 输出形状: [batch, 256, 20, 20]

# 遮挡检测

mask = self.mask_detector(features) # 输出形状: [batch, 1, 20, 20]

# 生成注意力权重 - 关注未遮挡区域

attention

相关文章