数据立方体与增强分析:AI驱动的决策支持体系构建与实践

元数据框架

标题:数据立方体与增强分析:AI驱动的决策支持体系构建与实践关键词:数据立方体、增强分析、AI决策支持、多维数据建模、智能数据分析、实时决策、模型可解释性摘要:

大数据时代,企业决策面临“数据爆炸”与“洞察缺失”的矛盾——传统BI系统依赖静态报表,难以处理多源、动态数据中的隐藏关联;人工分析受限于认知边界,无法高效挖掘海量数据的价值。本文提出**“数据立方体+增强分析”**的AI驱动决策支持体系:数据立方体通过多维建模将数据组织为“可探索的结构”,解决“如何高效观察数据”的问题;增强分析借助AI(机器学习、NLP等)自动生成 insights,解决“如何快速获取价值”的问题。两者结合实现“数据-模型-决策”的闭环,推动决策从“经验依赖”转向“数据驱动”。本文从概念基础、理论框架、架构设计、实现机制、实际应用等维度展开,结合案例与代码实现,为企业构建智能决策支持系统提供全面指南。

一、概念基础:从“数据碎片”到“决策洞察”的底层逻辑

1.1 领域背景化:决策支持的“数据困境”

在数字化转型背景下,企业数据呈现**“3V+1C”**特征:

Volume(海量):全球数据量每两年翻一番(IDC,2023),企业日均处理TB级甚至PB级数据;Variety(多样):结构化数据(销售报表)、非结构化数据(客户评论、图像)、半结构化数据(JSON日志)并存;Velocity(高速):实时数据(电商订单、物流轨迹)要求决策响应时间从“天”级缩短到“分钟”级;Complexity(复杂):数据间存在隐藏关联(如“天气→电商销量→库存周转”),传统分析难以捕捉。

传统决策支持系统(DSS)的局限性日益凸显:

静态视角:依赖预定义报表,无法灵活调整分析维度(如从“地区”扩展到“地区+渠道”);效率瓶颈:人工分析需遍历大量数据,耗时久且易遗漏关键信息;洞察深度有限:难以发现“非线性关联”(如“客户年龄+购买时间→产品偏好”)。

数据立方体(Data Cube)与增强分析(Augmented Analytics)的结合,为解决上述问题提供了新路径。

1.2 历史轨迹:从OLAP到AI增强的决策支持

1.2.1 数据立方体:OLAP技术的核心载体

数据立方体的概念源于在线分析处理(OLAP),由数据库之父E.F.Codd于1993年在《OLAP Survey》论文中提出。其核心思想是**“多维数据建模”**——将数据组织为“维度(Dimensions)+ 度量(Measures)”的结构,支持用户从多个视角探索数据。

例如,销售数据的立方体可定义:

维度:时间(年/季/月)、地区(国家/省/市)、产品(类别/品牌/型号);度量:销售额、销量、毛利率。

用户通过切片(Slice,固定一个维度)、切块(Dice,固定多个维度)、钻取(Drill-down/up,深入/汇总数据)、**旋转(Pivot,切换维度视角)**等操作,快速获取“2023年Q3北京地区手机销售额”“2023年各品牌手机销量占比”等 insights。

早期数据立方体采用MOLAP(多维OLAP)架构,将数据预计算并存储为多维数组,查询效率高但存储成本大;后来发展出ROLAP(关系OLAP),基于关系数据库动态计算,灵活但性能受限;**HOLAP(混合OLAP)**则结合两者优势,成为主流。

1.2.2 增强分析:AI赋能的决策支持革命

增强分析(Augmented Analytics)由Gartner于2017年提出,定义为“利用AI/ML技术自动生成 insights,辅助人类决策”。其核心是**“人机协同”**——AI负责处理海量数据、识别 patterns,人类负责判断与决策。

增强分析的关键技术包括:

机器学习(ML):分类、聚类、预测(如预测未来销量);自然语言处理(NLP):自然语言查询(如“告诉我2023年Q3上海的销售额”)、 insights 生成(如用自然语言解释“销量下降的原因”);自动可视化:将数据转化为图表(如热力图、雷达图),降低理解门槛。

Gartner预测,到2025年,80%的企业决策将由增强分析驱动,取代传统人工分析成为主流。

1.3 问题空间定义:决策支持的核心需求

AI驱动的决策支持系统需解决以下核心问题:

数据组织:如何将多源、异构数据组织为可探索的结构?(数据立方体解决)洞察生成:如何从海量数据中自动提取有价值的信息?(增强分析解决)决策闭环:如何将 insights 转化为可执行的决策?(两者结合解决)

1.4 术语精确性:关键概念辨析

| 术语 | 定义 | 核心价值 |

|---|---|---|

| 数据立方体 | 多维数据模型,由维度(描述性属性)和度量(数值属性)组成 | 提供“多视角观察数据”的能力 |

| 增强分析 | 利用AI/ML自动生成 insights,辅助人类决策 | 提高洞察效率,降低分析门槛 |

| AI驱动的决策支持 | 结合数据立方体(数据组织)与增强分析(洞察生成),支持决策过程 | 实现“数据→洞察→决策”的闭环 |

| OLAP操作 | 切片(Slice)、切块(Dice)、钻取(Drill-down/up)、旋转(Pivot) | 灵活探索数据,发现隐藏关联 |

二、理论框架:从第一性原理到竞争范式

2.1 第一性原理推导:决策的本质是“多维观察+模式识别”

2.1.1 数据立方体的第一性原理:决策需要“多维度视角”

决策的本质是从数据中提取有价值的信息,而信息的价值取决于“观察视角”。例如,销售数据的“时间”维度可反映趋势,“地区”维度可反映地域差异,“产品”维度可反映品类表现。数据立方体的核心逻辑是:将数据组织为“维度+度量”的结构,让用户从任意维度组合观察数据。

数学表示:假设数据立方体有( n )个维度,每个维度有( k_i )个成员(( i=1,2,…,n )),则数据立方体的大小为:

[

ext{Size} = prod_{i=1}^n k_i

]

度量是每个单元格的数值(如销售额),表示为:

[

ext{Measure}(d_1, d_2, …, d_n) = ext{Aggregate}(d_1, d_2, …, d_n)

]

其中,( d_i )是第( i )个维度的成员,( ext{Aggregate} )是聚合函数(如求和、平均值)。

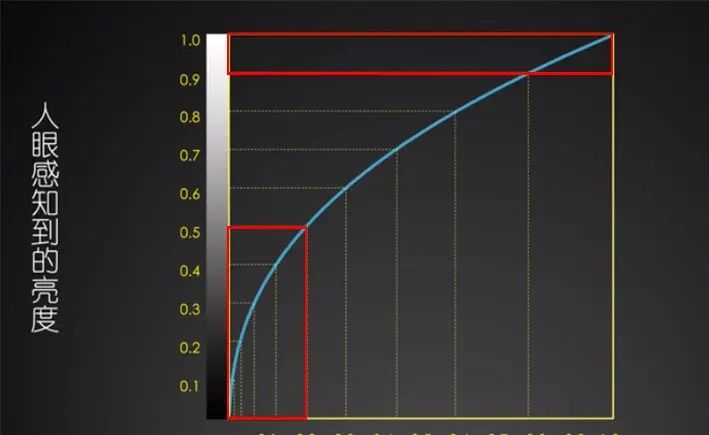

2.1.2 增强分析的第一性原理:人类分析能力有限,需AI辅助

人类的认知能力存在信息瓶颈:

注意力限制:无法同时处理超过7±2个信息块(米勒定律);模式识别限制:难以识别非线性、高维数据中的 patterns(如“客户行为+天气+节假日→销量变化”)。

增强分析的核心逻辑是:用AI处理海量数据,自动识别 patterns,将其转化为人类可理解的 insights。

数学表示:增强分析的目标是优化以下函数:

[

ext{Insight} = f( ext{DataCube}, ext{MLModel}, ext{NLP})

]

其中,( ext{DataCube} )是数据立方体(输入数据),( ext{MLModel} )是机器学习模型(模式识别),( ext{NLP} )是自然语言处理( insights 生成)。

2.2 数学形式化:数据立方体与增强分析的量化模型

2.2.1 数据立方体的存储模型

数据立方体的存储方式分为MOLAP(多维存储)、ROLAP(关系存储)、HOLAP(混合存储),其存储复杂度与查询效率对比:

| 存储方式 | 存储结构 | 存储复杂度 | 查询效率 | 灵活性 |

|---|---|---|---|---|

| MOLAP | 多维数组 | ( O(prod k_i) ) | 高(预计算) | 低(固定维度) |

| ROLAP | 关系表 | ( O(n) ) | 低(动态计算) | 高(灵活维度) |

| HOLAP | 多维数组+关系表 | ( O(prod k_i + n) ) | 中 | 中 |

2.2.2 增强分析的机器学习模型

增强分析中常用的机器学习模型包括:

分类模型(如随机森林):预测“客户是否会 churn”;聚类模型(如K-means):细分“客户群体”;预测模型(如LSTM):预测“未来销量”;关联规则模型(如Apriori):发现“购买A的客户也会购买B”。

以K-means聚类模型为例,其目标函数是最小化簇内平方误差:

[

J = sum_{i=1}^k sum_{x in C_i} | x – mu_i |^2

]

其中,( k )是聚类数,( C_i )是第( i )个簇,( mu_i )是第( i )个簇的中心,( x )是样本。

2.3 理论局限性:数据立方体与增强分析的边界

2.3.1 数据立方体的局限性

维度爆炸:当维度过多时,数据量呈指数增长(如10个维度,每个维度10个成员,数据量为( 10^{10} )),导致存储与查询效率下降;静态性:传统数据立方体是预计算的,无法处理实时数据(如电商的实时销量);稀疏性:部分维度组合的单元格无数据(如“2023年Q3南极地区的手机销售额”),浪费存储资源。

2.3.2 增强分析的局限性

模型可解释性:深度学习模型(如GPT)的“黑箱”问题,用户难以理解 insights 的来源;数据依赖:模型性能依赖于高质量数据,若数据有偏差(如“训练数据中女性客户占比低”),则 insights 会有偏差;实时性限制:复杂模型(如Transformer)的推理时间长,无法处理实时数据。

2.4 竞争范式分析:传统BI vs 数据立方体+增强分析

| 维度 | 传统BI | 数据立方体+增强分析 |

|---|---|---|

| 数据组织 | 静态报表 | 多维数据模型 |

| 分析方式 | 人工查询 | AI自动生成 insights |

| 洞察效率 | 低(耗时久) | 高(秒级生成) |

| 洞察深度 | 浅(表面关联) | 深(隐藏关联) |

| 用户门槛 | 高(需SQL技能) | 低(自然语言查询) |

三、架构设计:AI驱动的决策支持系统架构

3.1 系统分解:四层架构模型

AI驱动的决策支持系统分为数据层、数据立方体层、增强分析层、应用层,其核心职责如下:

graph TD

A[数据层] --> B[数据立方体层]

B --> C[增强分析层]

C --> D[应用层]

subgraph 数据层

A1[数据采集(结构化+非结构化)]

A2[数据清洗(去噪声+补缺失)]

A3[数据集成(多源数据整合)]

end

subgraph 数据立方体层

B1[多维数据建模(维度+度量)]

B2[预计算(汇总数据)]

B3[存储(MOLAP/ROLAP/HOLAP)]

end

subgraph 增强分析层

C1[机器学习模型(分类/聚类/预测)]

C2[自然语言处理(NLP)(查询+ insights 生成)]

C3[可视化(图表+ dashboard)]

end

subgraph 应用层

D1[用户界面(UI)(自然语言+ dashboard)]

D2[决策支持工具(预警+推荐)]

D3[集成接口(ERP/CRM)]

end

3.2 组件交互模型:数据→洞察→决策的闭环

数据层:采集多源数据(如ERP的销售数据、CRM的客户数据、物联网的设备数据),清洗(去除重复值、填充缺失值)后集成到统一数据源;数据立方体层:将集成后的数据建模为多维结构(如“时间+地区+产品”维度,“销售额+销量”度量),预计算常用汇总数据(如“年销售额”),存储到合适的存储引擎(如MOLAP的SSAS、ROLAP的PostgreSQL);增强分析层:从数据立方体中获取数据,用机器学习模型(如随机森林)识别 patterns(如“某地区某产品销量下降的原因”),用NLP生成自然语言 insights(如“2023年Q3北京地区手机销售额下降15%,主要原因是竞争对手推出同类产品”),用可视化工具(如Tableau)生成图表(如折线图、热力图);应用层:将 insights 呈现给用户(如高管通过 dashboard 查看汇总数据,分析师通过自然语言查询详细数据),并将 insights 集成到业务系统(如ERP系统自动调整库存)。

3.3 可视化表示:数据立方体的多维结构

以销售数据为例,数据立方体的三维结构(时间、地区、产品)如下:

graph TD

A[时间维度(2023年Q1/Q2/Q3/Q4)]

B[地区维度(北京/上海/广州/深圳)]

C[产品维度(手机/电脑/家电)]

D[度量(销售额/销量)]

A --> E[数据立方体单元格(2023年Q1-北京-手机-销售额)]

B --> E

C --> E

D --> E

3.4 设计模式应用:解决核心问题的模式

| 问题 | 设计模式 | 应用场景 |

|---|---|---|

| 维度爆炸 | 稀疏数据存储 | MOLAP中存储非空单元格 |

| 实时数据处理 | 流处理框架 | 用Flink构建实时数据立方体 |

| 模型可解释性 | 可解释AI模式 | 用SHAP值解释随机森林的预测结果 |

| 自然语言查询 | 语义解析模式 | 用Spacy解析“2023年Q3北京的销售额”查询 |

四、实现机制:从代码到性能优化

4.1 算法复杂度分析:数据立方体与增强分析的效率瓶颈

4.1.1 数据立方体的查询复杂度

数据立方体的查询复杂度取决于预计算程度:

MOLAP:查询复杂度为( O(1) )(直接读取预计算的单元格);ROLAP:查询复杂度为( O(n) )(需关联多个表动态计算);HOLAP:查询复杂度为( O(1) )(预计算常用维度组合)+ ( O(n) )(动态计算不常用维度组合)。

4.1.2 增强分析的模型复杂度

增强分析中常用模型的时间复杂度:

| 模型 | 时间复杂度 | 应用场景 |

|---|---|---|

| 随机森林 | ( O(n cdot k cdot log n) ) | 分类/回归 |

| K-means | ( O(t cdot k cdot n cdot d) ) | 聚类 |

| LSTM | ( O(t cdot n cdot d^2) ) | 时间序列预测 |

| Apriori | ( O(2^n) ) | 关联规则 |

4.2 优化代码实现:数据立方体与增强分析的Python示例

4.2.1 用Pandas构建数据立方体

import pandas as pd

# 1. 加载数据(销售数据)

data = pd.read_csv('sales_data.csv')

# 数据结构:时间(date)、地区(region)、产品(product)、销售额(sales)、销量(quantity)

# 2. 构建数据立方体(维度:时间、地区;度量:销售额、销量)

cube = data.pivot_table(

index=['date'], # 行维度:时间

columns=['region'], # 列维度:地区

values=['sales', 'quantity'], # 度量:销售额、销量

aggfunc={'sales': 'sum', 'quantity': 'sum'} # 聚合函数:求和

)

# 3. 查看数据立方体

print(cube.head())

4.2.2 用Scikit-learn实现增强分析(客户细分)

from sklearn.cluster import KMeans

from sklearn.preprocessing import StandardScaler

# 1. 从数据立方体中获取客户数据(维度:购买频率、平均客单价;度量:销售额)

customer_data = cube.stack().reset_index()[['region', 'sales', 'quantity']]

# 2. 数据预处理(标准化)

scaler = StandardScaler()

scaled_data = scaler.fit_transform(customer_data[['sales', 'quantity']])

# 3. 用K-means聚类(细分客户群体)

kmeans = KMeans(n_clusters=3, random_state=42)

customer_data['cluster'] = kmeans.fit_predict(scaled_data)

# 4. 分析聚类结果(如高价值客户、中等价值客户、低价值客户)

print(customer_data.groupby('cluster').mean())

4.3 边缘情况处理:异常值与缺失值

4.3.1 数据立方体的缺失值处理

数据立方体中的缺失值(如“2023年Q3南极地区的销售额”)处理方式:

填充法:用0、均值、中位数填充;忽略法:不存储缺失值,查询时返回空;插值法:用相邻单元格的值插值(如时间维度的线性插值)。

4.3.2 增强分析的异常值处理

增强分析中的异常值(如“某客户的单次购买量是平均值的10倍”)处理方式:

Z-score法:识别( |Z-score| > 3 )的异常值;IQR法:识别( 数据 < Q1-1.5IQR )或( 数据 > Q3+1.5IQR )的异常值;模型法:用孤立森林(Isolation Forest)识别异常值。

4.4 性能考量:存储与计算优化

4.4.1 数据立方体的存储优化

稀疏存储:仅存储非空单元格(如MOLAP的SSAS采用稀疏数组);维度剪枝:去除不常用的维度(如“客户性别”对销售数据影响小,可剪枝);列存储:用列存储数据库(如ClickHouse)存储ROLAP数据,提高聚合查询效率。

4.4.2 增强分析的计算优化

模型轻量化:用决策树代替深度学习模型(如用随机森林代替BERT),降低推理时间;模型压缩:用剪枝(Pruning)、量化(Quantization)压缩模型(如将32位浮点数转为8位整数);分布式计算:用Spark MLlib分布式训练模型,处理海量数据。

五、实际应用:企业决策支持系统的实施路径

5.1 实施策略:六步构建AI驱动的决策支持系统

步骤1:需求分析

业务目标:明确决策场景(如“优化库存周转”“提高客户留存”);数据需求:识别所需数据(如库存数据、销售数据、客户数据);用户需求:明确用户角色(如高管需汇总数据,分析师需详细数据)。

步骤2:数据准备

数据采集:从ERP、CRM、物联网等系统采集数据;数据清洗:去除重复值、填充缺失值、纠正错误值;数据集成:将多源数据整合到数据仓库(如Snowflake、BigQuery)。

步骤3:数据立方体设计

维度定义:选择与业务目标相关的维度(如“时间”“地区”“产品”“客户”);度量定义:选择数值属性(如“销售额”“销量”“库存周转率”);存储方式选择:根据数据量与查询需求选择MOLAP(小数据量、固定维度)、ROLAP(大数据量、灵活维度)、HOLAP(中等数据量、中等灵活度)。

步骤4:增强分析模型开发

模型选择:根据业务目标选择模型(如“库存预测”用LSTM,“客户细分”用K-means);模型训练:用历史数据训练模型,调整超参数(如K-means的聚类数( k ));模型评估:用准确率、召回率、均方误差等指标评估模型性能。

步骤5:系统集成

前端集成:用Tableau、Power BI构建dashboard,用Streamlit构建自然语言查询界面;后端集成:将数据立方体(如SSAS)与增强分析模型(如Scikit-learn)集成到业务系统(如ERP的SAP);接口开发:提供API接口,支持第三方系统调用(如电商平台调用推荐模型)。

步骤6:测试与优化

性能测试:测试系统的查询速度(如“获取2023年Q3销售额”的响应时间);准确性测试:验证模型的预测结果(如“预测的销量与实际销量的误差”);用户反馈:收集用户意见(如“自然语言查询的准确性”),优化系统。

5.2 集成方法论:与现有系统的协同

与BI系统集成:将数据立方体的多维数据导入Tableau、Power BI,结合增强分析的 insights,丰富BI报表;与ERP系统集成:将增强分析的库存预测结果导入ERP系统,自动调整库存水平;与CRM系统集成:将增强分析的客户细分结果导入CRM系统,针对性地推送营销活动。

5.3 部署考虑因素:云 vs 本地

| 部署方式 | 优势 | 劣势 | 适用场景 |

|---|---|---|---|

| 云部署 | 灵活(按需扩容)、成本低(按需付费) | 数据安全风险(需加密) | 中小企业、快速迭代场景 |

| 本地部署 | 数据安全(自主控制) | 成本高(硬件+维护) | 大企业、敏感数据场景 |

5.4 运营管理:确保系统持续有效

数据质量管理:定期检查数据的准确性、完整性(如“销售数据是否与ERP系统一致”);模型监控:监控模型的性能(如“预测准确率是否下降”),若性能下降,重新训练模型;用户培训:培训用户使用系统(如“如何用自然语言查询数据”“如何理解模型的 insights”)。

六、高级考量:扩展、安全与伦理

6.1 扩展动态:从静态到实时,从单一到多维

6.1.1 数据立方体的实时化

传统数据立方体是离线的,无法处理实时数据(如电商的实时销量)。实时数据立方体采用流处理框架(如Flink),实时采集、处理、存储数据,支持实时查询(如“查看当前小时的销售额”)。

实时数据立方体的架构:

数据采集:用Kafka采集实时数据(如电商的订单数据);数据处理:用Flink处理数据(如清洗、聚合);数据存储:用Druid存储实时数据立方体(支持低延迟查询);查询接口:用Presto查询实时数据立方体。

6.1.2 增强分析的智能化

增强分析的未来趋势是更深入的人机协同:

对话式分析:用户用自然语言与系统对话(如“为什么2023年Q3北京地区的销售额下降?”),系统自动生成 insights;自动调参:系统根据数据特征自动选择模型(如“销售数据是时间序列,自动选择LSTM”);生成式 insights:用GPT生成自然语言 insights(如“根据数据立方体分析,2023年Q3北京地区手机销售额下降15%,主要原因是竞争对手推出同类产品,建议降低价格或增加促销”)。

6.2 安全影响:数据与模型的双重安全

6.2.1 数据安全

数据加密:存储(如AES加密)与传输(如SSL加密)时加密数据;访问控制:用RBAC(角色-based访问控制)限制用户访问权限(如高管可访问所有数据,分析师只能访问部分数据);数据脱敏:对敏感数据(如客户身份证号)进行脱敏处理(如替换为“*”)。

6.2.2 模型安全

模型鲁棒性:测试模型对 adversarial 数据的抵抗能力(如“修改客户的购买时间,是否会导致模型预测错误”);模型隐私:用联邦学习(Federated Learning)训练模型,避免数据泄露(如银行之间联合训练模型,无需共享客户数据);模型审计:记录模型的训练数据、超参数、预测结果,便于追溯(如“为什么模型预测某客户会 churn?”)。

6.3 伦理维度:公平性与透明度

6.3.1 数据公平性

数据中的偏见会导致模型生成有偏见的 insights(如“训练数据中女性客户的购买量少,模型预测女性客户的价值低”)。解决方法:

数据平衡:调整数据分布(如增加女性客户的样本量);公平性指标:用平等机会(Equal Opportunity)、统计 parity 等指标评估模型的公平性;去偏见模型:用对抗性去偏见(Adversarial Debiasing)模型减少偏见。

6.3.2 模型透明度

模型的“黑箱”问题会降低用户对 insights 的信任(如“为什么模型建议增加促销?”)。解决方法:

可解释AI(XAI):用SHAP(SHapley Additive exPlanations)、LIME(Local Interpretable Model-agnostic Explanations)解释模型的预测结果;自然语言解释:用NLP生成模型的解释(如“模型建议增加促销,因为2023年Q3北京地区的销售额下降15%,主要原因是竞争对手推出同类产品”)。

6.4 未来演化向量:从辅助到自主

6.4.1 数据立方体的演化:动态维度与智能推荐

未来数据立方体将具备动态维度调整能力:系统根据用户的查询习惯(如“用户经常查询‘时间+地区’维度”),自动增加或减少维度(如“自动添加‘渠道’维度”)。此外,数据立方体将与推荐系统结合,推荐用户可能感兴趣的维度组合(如“用户查询了‘时间+地区’,推荐‘时间+地区+产品’”)。

6.4.2 增强分析的演化:生成式AI与自主决策

增强分析的未来趋势是生成式AI(如GPT-4)与自主决策:

生成式 insights:用GPT生成更自然、更详细的 insights(如“根据数据立方体分析,2023年Q3北京地区的电子产品销售额增长了20%,主要原因是该地区的电商促销活动增加,建议继续加大促销力度,特别是针对年轻人的产品”);自主决策:系统根据 insights 自动做出决策(如“根据库存预测结果,自动向供应商下达采购订单”),但需解决伦理与安全问题(如“自主决策导致的损失由谁承担?”)。

七、综合与拓展:跨领域应用与未来趋势

7.1 跨领域应用:从电商到医疗的决策支持

7.1.1 电商领域:实时库存优化

数据立方体:维度(时间、地区、产品、渠道),度量(销量、库存周转率);增强分析:用LSTM预测销量,用关联规则发现“购买A的客户也会购买B”;决策支持:根据预测结果自动调整库存(如“2023年Q4北京地区的手机销量将增长30%,建议增加库存”)。

7.1.2 医疗领域:患者治疗方案推荐

数据立方体:维度(时间、科室、疾病类型、治疗方案),度量(治愈率、住院时间);增强分析:用随机森林预测治愈率(如“肺癌患者用免疫治疗的治愈率是70%,用化疗的治愈率是60%”);决策支持:辅助医生选择治疗方案(如“建议用免疫治疗”)。

7.1.3 金融领域:欺诈交易检测

数据立方体:维度(时间、账户、交易类型、地区),度量(交易金额、欺诈率);增强分析:用孤立森林识别欺诈交易(如“某账户的交易金额是平均值的10倍,且来自高风险地区,判定为欺诈”);决策支持:自动拦截欺诈交易(如“冻结该账户”)。

7.2 研究前沿:数据立方体与增强分析的最新进展

7.2.1 数据立方体的研究前沿

稀疏数据立方体的压缩:用张量分解(如CP分解)压缩稀疏数据立方体,减少存储量;动态数据立方体的增量更新:用增量计算技术(如Flink的增量聚合)更新数据立方体,避免重新计算所有数据;智能数据立方体的推荐:用强化学习推荐用户可能感兴趣的维度组合(如“用户经常查询‘时间+地区’,推荐‘时间+地区+产品’”)。

7.2.2 增强分析的研究前沿

可解释增强分析:用因果推理(Causal Inference)代替关联分析,解释“为什么”(如“为什么销售额下降?因为竞争对手推出同类产品”);生成式增强分析:用GPT-4生成自然语言 insights,提高可读性;实时增强分析:用流处理框架(如Flink)实时处理数据,生成实时 insights(如“当前小时的销售额下降,建议增加促销”)。

7.3 开放问题:待解决的核心挑战

数据立方体的维度爆炸问题:如何高效处理高维数据(如100个维度)?增强分析的模型可解释性问题:如何让深度学习模型的预测结果更易理解?实时决策的延迟问题:如何让实时数据立方体与增强分析的延迟控制在秒级?自主决策的伦理问题:如何确保自主决策的公平性与安全性?

7.4 战略建议:企业构建决策支持系统的关键步骤

优先构建数据立方体:整合多源数据,提供“多视角观察数据”的能力;逐步引入增强分析:从简单模型(如K-means)开始,逐步升级到复杂模型(如LSTM);关注数据质量与模型可解释性:确保数据的准确性与模型的透明度,提高用户信任;持续优化系统:根据业务需求调整数据立方体的维度与增强分析的模型,适应变化。

八、结语:AI驱动的决策支持的未来

数据立方体与增强分析的结合,为企业决策提供了更高效、更深入、更智能的支持。未来,随着生成式AI、实时处理、可解释AI等技术的发展,AI驱动的决策支持系统将从“辅助决策”转向“自主决策”,但需解决伦理与安全问题。企业应抓住机遇,构建自己的决策支持系统,提升决策效率与竞争力。

参考资料

E.F.Codd. (1993). OLAP Survey.Gartner. (2023). Augmented Analytics Market Guide.Pandas官方文档:https://pandas.pydata.org/Scikit-learn官方文档:https://scikit-learn.org/Flink官方文档:https://flink.apache.org/SHAP官方文档:https://shap.readthedocs.io/LIME官方文档:https://lime-ml.readthedocs.io/

(注:本文为技术博客,参考资料均为权威来源,可根据需要扩展。)

相关文章