生成了一个约2.8秒、720p左右的AI短视频,画面风格稳定,帧数设为45、每秒16帧,输出为h264格式的mp4。

下面把整个过程按步骤、按工具、按坑位讲清楚,从准备到渲染全程都放在这儿,语言尽量接地气,好让你照着操作能跑起来。别想当然,数据和参数都照原样保留,只是把表达改成更容易懂的说法。

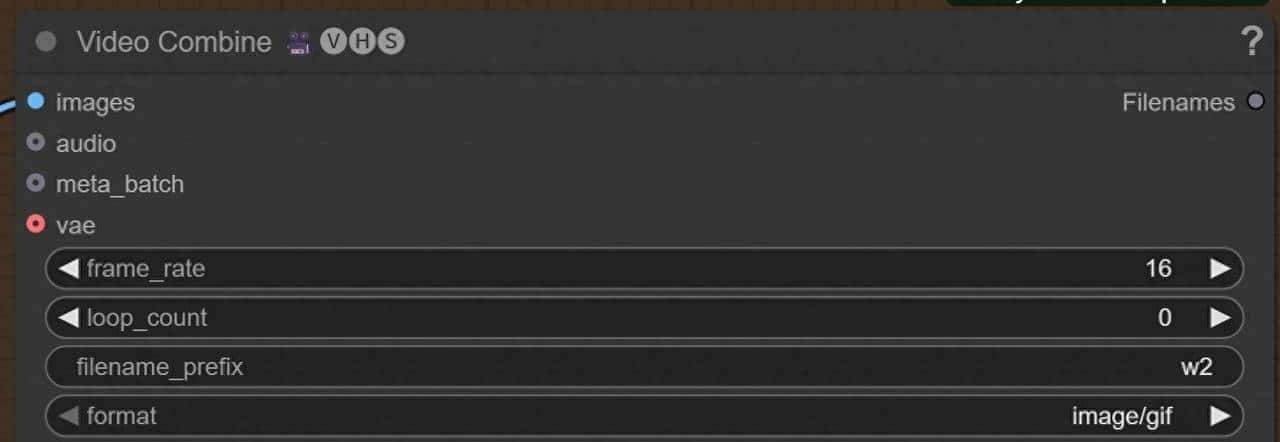

先说这次渲染的关键参数,都是实打实能直接用的:总帧数45,帧率16 fps,时长差不多2.8秒。批次(batch)设1,千万别想着开多帧并行,否则显存会立刻被吃光。输出格式我用了h264-mp4,想要动图也可以出gif。Tea Cache(可以把它理解成用少量实际渲染帧去推导中间帧的加速手段)能省时间,但代价是画质会下降。抽帧频率别设太激进,提议在0.1到0.2之间,抽帧起止时间要用总时长的相对位置去设。coefficients这个数在0到10之间,从1或者1.5起步调试最稳,当显存吃不消时逐步加,别一上来拉满。

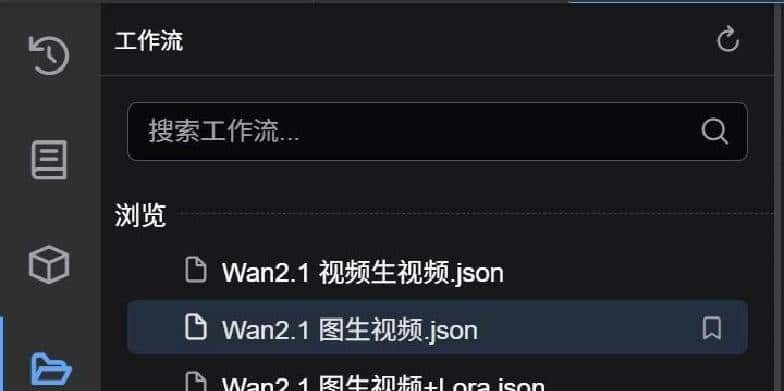

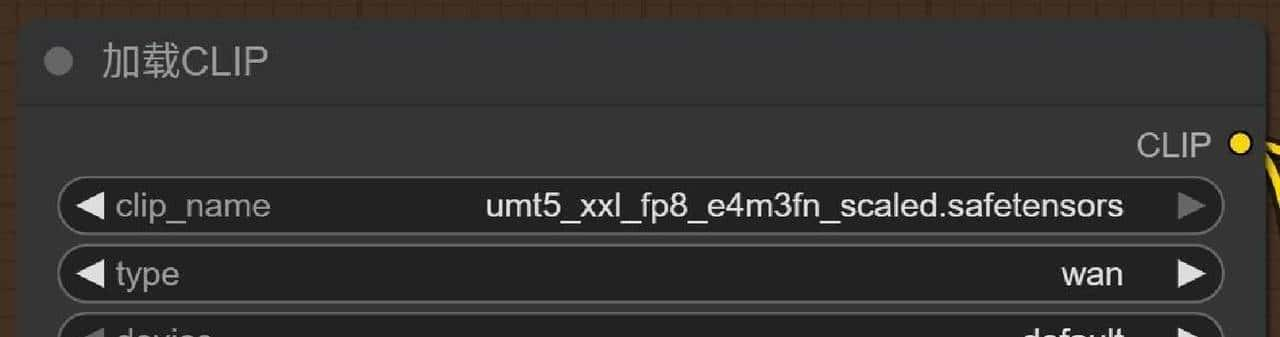

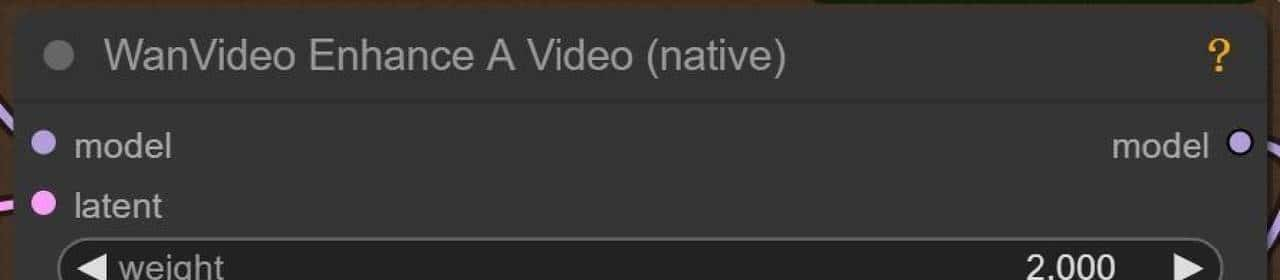

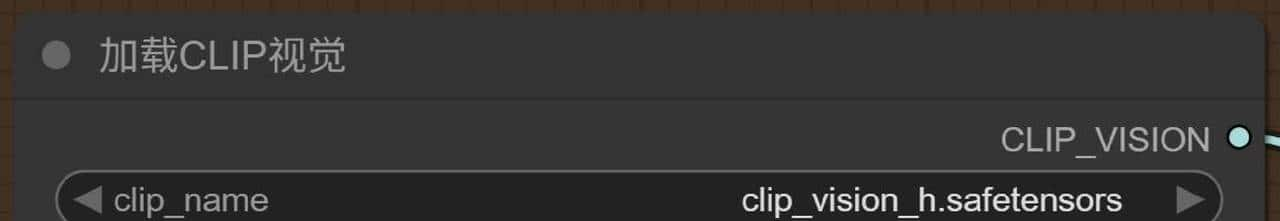

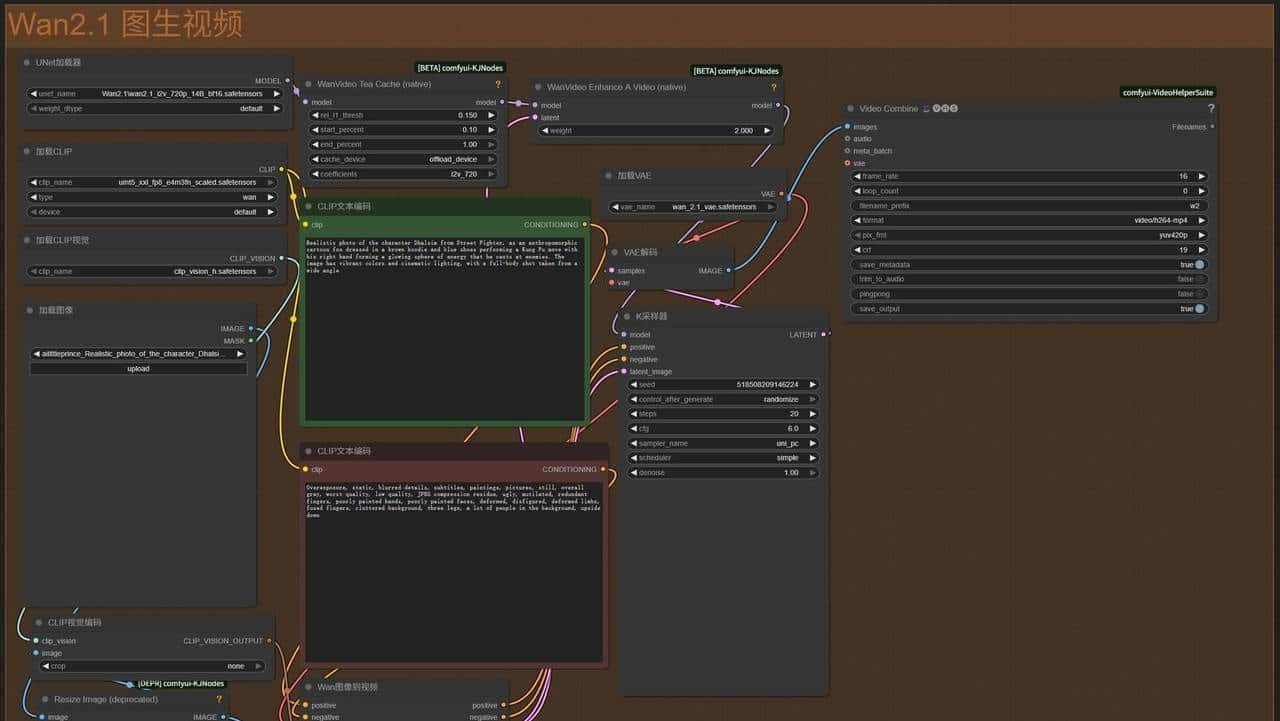

工具和模型这块要讲清楚。ComfyUI里选用的是Wan 2.1的i2v图生视频工作流。UNet加载器务必要对应你下的i2v模型,选错会直接报错。我们用的是720P_14B_FP8版本,分辨率高但慢。剪枝类型可以用默认,也行用FP8_e4m3fn。CLIP文本编码要配umt5_xxl_fp8,类型设成wan;视觉部分加载clip_vision_h;VAE选wan_2.1_vae。图像尺寸按模型来,720p就是1280×720,竖屏就是720×1280,但要提醒你,竖屏更耗显存,16GB以下玩竖屏要小心。渲染批次设1,帧数45,帧率16。提示词框里我把正提示用绿色、反提示用红色区分,工作流里这样看着清楚,反向提示直接用官方默认列表就行。

显存和模型选择得讲重点。模型一般分i2v(图生视频)和t2v(文生视频)。显卡显存低于10GB的话,别折腾i2v,选t2v 1.3B FP16这类轻量模型比较靠谱。显存超过12GB才有更多选择,像i2v 480p FP8或t2v 14B FP8能思考。FP8精度模型跑得快,但画质不必定比FP16差许多,实际上分辨率对效果影响更大。我的机器是RTX 5070 Ti 16GB,才敢直接跑720p_14B_FP8这种大模型。

把硬件参数简单列一下,方便你对号入座:iGame GeForce RTX 5070 Ti Advanced OC 16GB,8960 CUDA核心,16GB GDDR7显存,256bit位宽,带宽大约896 GB/s。算力方面FP16/FP32约43.94 TFLOPS,还带了280个第五代Tensor Core,官方标称能带来约1406 AI TOPS算力。显存越大越能跑高分辨率和复杂模型,这是最直观的影响。

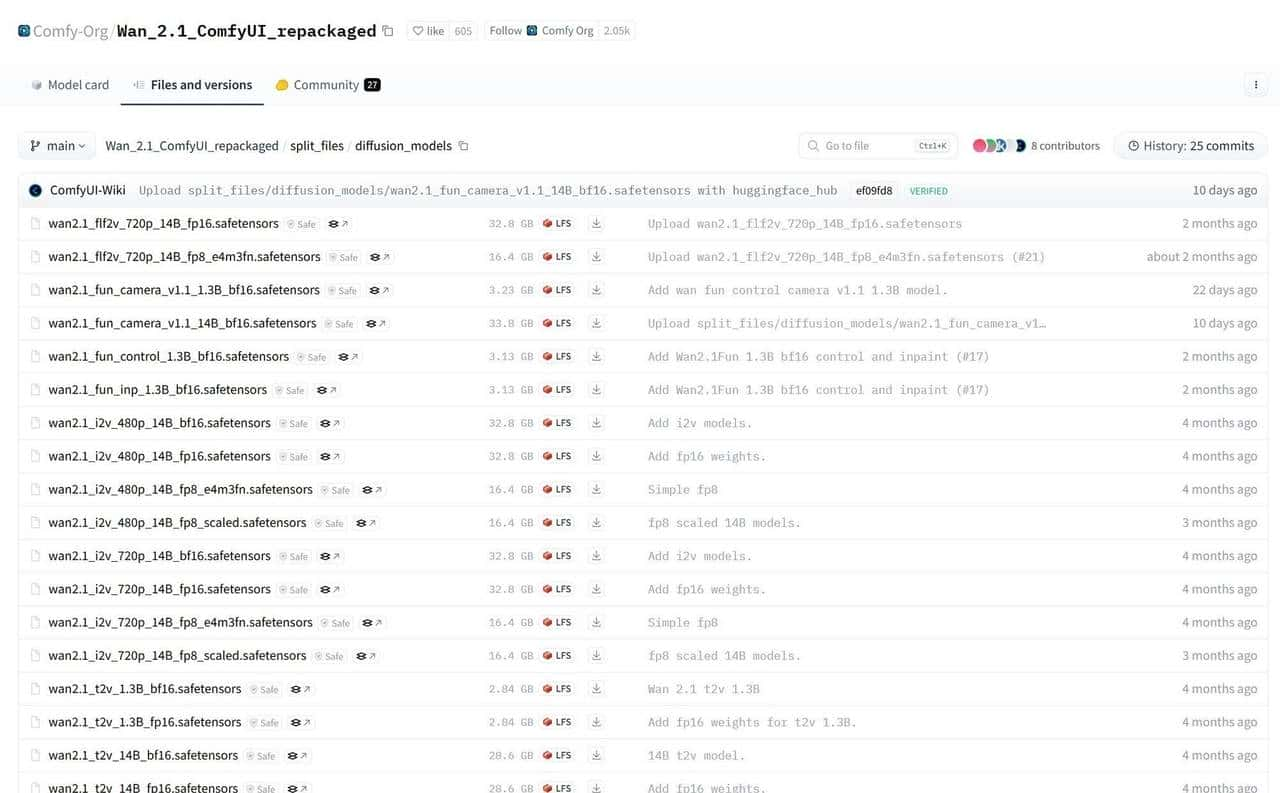

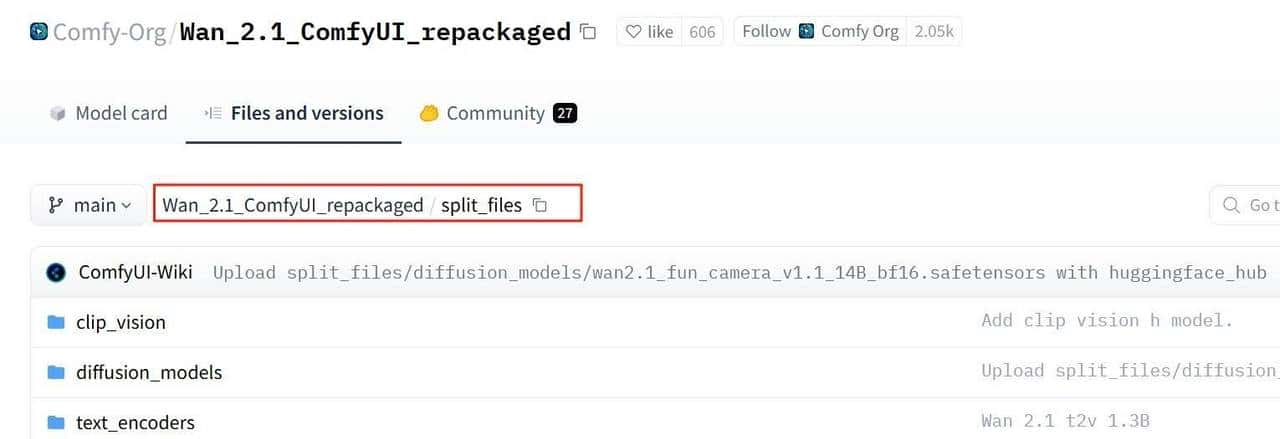

文件摆放、启动步骤务必按顺序走。先去 Hugging Face 下载 Wan 2.1 的模型包,包里面有diffusion_models目录,区分i2v和t2v两个子目录,还需要额外的Clip Vision、Text encoder、VAE等配套文件。按我的本地测试路径,把i2v放到 ComfyUI-aki-v1.6ComfyUImodelsdiffusion_modelsi2v 下面,其他模型也分别放到对应的根目录。启动器我用的是秋葉aaaki在B站分享的ComfyUI启动器(绘世启动器),一键启动省心省事。

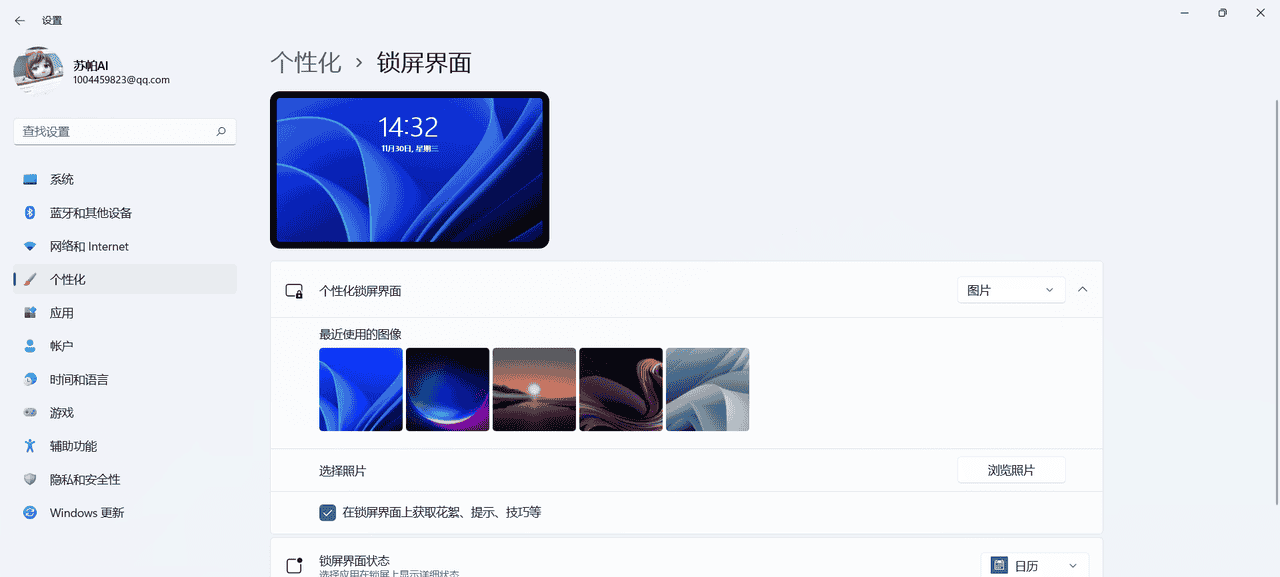

启动后来在界面里先去Manager把Stable切到Nightly,然后点“更新全部”。更新过程中界面会提示要重启,按照提示退出并重开启动器,更新就能完成。重启后在左侧工作流里选Wan2.1的图生视频模板,就能看到完整的节点布局和参数。

节点配置别马虎。有几处常见的坑要注意:UNet节点必须选对模型类型,i2v用于图生视频,t2v用于文生视频,两者不能混着用。CLIP要选umt5_xxl_fp8并把类型切为wan,视觉加载clip_vision_h,VAE选wan_2.1_vae。图像尺寸按模型设,720p设1280×720,480p是640×480。渲染批次是1,输出格式在视频输出节点里选h264-mp4。Tea Cache别随意把频率开太高,画质会被拉下去,只有在你真的很急、并且能接受质量损失时才用小幅抽帧。

调试过程里记录的实用经验,我把它当成改车的老手传授你几句顺口溜:显存不够别盲目加分辨率,先降分辨率或换FP16/FP8的小模型;提示词正反向要分清,工作流用颜色区分方便;CLIP错配会直接报错,遇报错先检查模型类型和路径;想提升细节可以在coefficients上慢慢加,从1开始别一次抬太高;批次和并行帧会爆显存,图生视频不能像图片渲染那样随手把batch开大。

画质与速度之间的取舍得靠你自己。要是只是玩短视频,配一套轻量t2v模型和中等分辨率就够了,兼顾速度和效果。要追求更清晰、更长的片段,那就需要更大显存和更高分辨率模型,时间和显存成本也会成正比。调试几回,你就会知道哪些设置对你显卡友善,哪些组合一开就把机器拖爆。

再说几个不能忽视的小细节:路径里文件夹命名不要随意改,模型文件多且敏感,出错时先看命名和路径。渲染前把日志开着,出问题能立刻看报错来源。保存输出时注意磁盘空间,MP4文件比想象中占空间大。渲染前做个小测试帧,别硬上整段,省时间也省心。

还有实践层面的提议:提示词写得清楚但别太复杂,正提示把你想要的画面元素写清,反提示把不想要的结果写好;如果想要细节更稳定,先在coefficients上从1试到1.5,再慢慢微调;若追求速度,把分辨率下调到480p或换轻量模型,是最省显存的办法。遇到内存不足,别急着删东西,先关掉并行渲染或把VAE换成更轻的版本。

过程里我碰到的常见报错和对应的排查顺序也分享给你:看报错是内存不够还是模型找不到;若是模型找不到,检查路径和文件名,CLIP与UNet是否匹配;若是内存不够,先减分辨率或换模型精度;若是提示某节点类型错,回到工作流把该节点的模型类型强制对上;总之先从模型匹配和显存两个方向排查。

渲染完后输出格式有两种常用选择:h264-mp4是兼容性最广的,编辑和上传都方便;gif更适合短循环但质量和文件大小常常不划算。记得渲染前在视频输出节点里选好编码器和容器,别跑完再去转格式,浪费时间。

操作顺序简要回顾下(照着做就行):下载模型→按目录放好文件→用绘世启动器一键启动ComfyUI→到Manager更新并重启→选择Wan2.1图生视频工作流→确认UNet/CLIP/VAE等节点对应模型→设分辨率1280×720、帧数45、fps16、batch1→调整Tea Cache和coefficients小步调试→输出h264-mp4→点渲染。接着就是等渲染完成,留意日志和显存占用,如果报错按上面排查方法处理。

相关文章