LoRA(Low-Rank Adaptation,低秩适配)之所以在大模型微调中成本比较低,主要缘由在于它的设计理念和工作方式超级高效。相比传统的全模型微调(Full Fine-Tuning),LoRA 在计算资源、存储空间和训练时间上都有显著优势。下面我用通俗的语言解释为什么 LoRA 成本低,并结合一些类比和细节来帮你理解。

为什么 LoRA 成本低?

1. 只调整一小部分参数,而不是全部

- 全模型微调:就像把整个大模型(想象成一栋大房子)从头到尾翻新一遍,墙壁、地板、家具全换,工作量巨大。大模型一般有几亿甚至几百亿个参数,每个参数都要调整,需要大量计算资源。

- LoRA 的方式:只在大模型旁边加几个“小插件”(就像在房子外加几个新插座或装饰品),不动原来的主体结构。LoRA 在模型的权重矩阵上加了一些低秩(low-rank)的调整矩阵,这些矩阵参数量超级少,一般只占原模型的千分之一甚至更低。

为什么成本低?

- 参数少 → 计算量少 → 不需要超级强劲的 GPU,一个普通电脑甚至笔记本就能跑。

- 列如:GPT-3 有 1750 亿参数,全微调要更新所有参数;而 LoRA 可能只加几百万参数,计算量直接下降好几个数量级。

2. 冻结原始模型,节省内存

- 全模型微调:需要加载整个模型到内存,还要为每个参数计算梯度(gradient),内存占用超级大。训练时可能需要多块高端 GPU(列如 A100),普通用户根本负担不起。

- LoRA 的方式:把原始模型“冻结”(就像锁住房子,只让插件动),不更新原来的参数,只训练那几个小插件。冻结的部分不需要计算梯度,内存占用大幅减少。

为什么成本低?

- 内存需求小 → 不需要昂贵的硬件支持。

- 列如:在 16GB 内存的笔记本上,LoRA 可以轻松微调一个 7B 参数的模型(像 LLaMA-7B),而全微调可能需要 80GB 显存。

3. 训练时间短,效率高

- 全模型微调:由于要调整所有参数,每次训练(epoch)都要遍历整个模型,耗时长,可能需要几天甚至几周。

- LoRA 的方式:只训练小插件,计算量少,每次迭代快得多。一般几小时就能完成微调,甚至在小数据集上几十分钟就够了。

为什么成本低?

- 时间短 → 节省电费和机器租用费用。

- 列如:微调一个对话任务,全模型微调可能跑 3 天,LoRA 可能只要 2 小时。

4. 存储成本低,模型复用性强

- 全模型微调:微调后要保存整个模型的参数,一个大模型可能占几十 GB 甚至上百 GB 存储空间。如果你有多个任务(列如中文对话、写诗、客服),每个任务都要存一份完整模型,硬盘很快就爆满。

- LoRA 的方式:微调后只保存那几个小插件的参数(几 MB 到几十 MB),原始模型保持不变。不同任务可以用同一个大模型,只切换不同的 LoRA 插件。

为什么成本低?

- 存储小 → 不需要买大硬盘,上传下载也快。

- 列如:一个 13B 参数模型全微调后可能占 26GB,而 LoRA 插件可能只有 10MB,差距上千倍。

5. 数据需求少,适合小规模场景

- 全模型微调:为了避免“过拟合”(模型死记硬背数据),需要大量数据支持,可能得准备几十万条样本。

- LoRA 的方式:由于只调整小部分参数,对数据量要求低,几千条甚至几百条数据就能有效微调。

为什么成本低?

- 数据少 → 收集和标注数据的成本大幅降低。

- 列如:用 1000 条中文对话就能让 LoRA 学会中文,而全微调可能需要 10 万条。

类比:装修房子 vs 加插件

- 全模型微调:像把老房子全部拆了重建,材料费、人工费、时间成本都高。

- LoRA:像在老房子上加个智能音箱或新灯泡,花点小钱就能升级功能。

LoRA 的核心思路是用最小的改动换取最大的效果,特别适合预算有限的个人开发者或小团队。

技术细节(简单版)

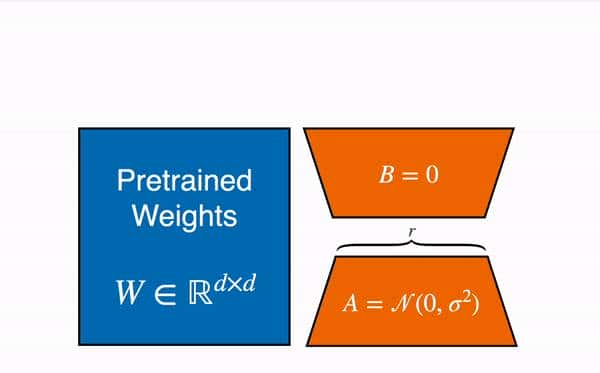

LoRA 的“低秩”指的是它假设模型权重的变化可以用低维矩阵表明。具体来说:

- 原始权重矩阵(列如 10000×10000 的参数)不动。

- 加两个小矩阵(列如 10000×8 和 8×10000),参数量从 1 亿降到几万。

- 训练时只更新这两个小矩阵,计算量和存储量都大大减少。

公式(不用深究):

原权重更新:W = W + ΔW

LoRA:ΔW = A × B(A 和 B 是小矩阵)。

实际例子

假设你有个 7B 参数的 LLaMA 模型:

- 全微调:需要 4 块 A100 GPU,跑 3 天,存 14GB 文件。

- LoRA:用 1 块 3060 GPU(甚至 CPU),跑 2 小时,存 20MB 文件。

- 任务是生成中文对话,LoRA 用 5000 条数据就能达到 90% 的全微调效果。

LoRA 成本低是由于它“机智地偷懒”:

- 只动小部分参数,算得少。

- 冻结大模型,省内存。

- 训练快,存得小,数据少也能用。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...