很小很强!国产最快对话模型

头条号 · 周生AI

[ AI聊天?要多快 , 有多快]

—— MiniCPM ——

点点关注●每日AI项目推荐

面壁小钢炮 MiniCPM

很小很能打

MiniCPM 是一系列端侧语言大模型,主体语言模型 MiniCPM-2B 具有 2.4B 的非词嵌入参数量。在综合性榜单上与 Mistral-7B 相近(中文、数学、代码能力更优),整体性能超越 Llama2-13B、MPT-30B等模型。在当前最接近用户体感的榜单 MTBench 上,MiniCPM-2B 也超越了 Llama2-70B-Chat、Vicuna-33B、Mistral-7B-Instruct-v0.1、Zephyr-7B-alpha 等众多代表性开源大模型,处于遥遥领先的地位。

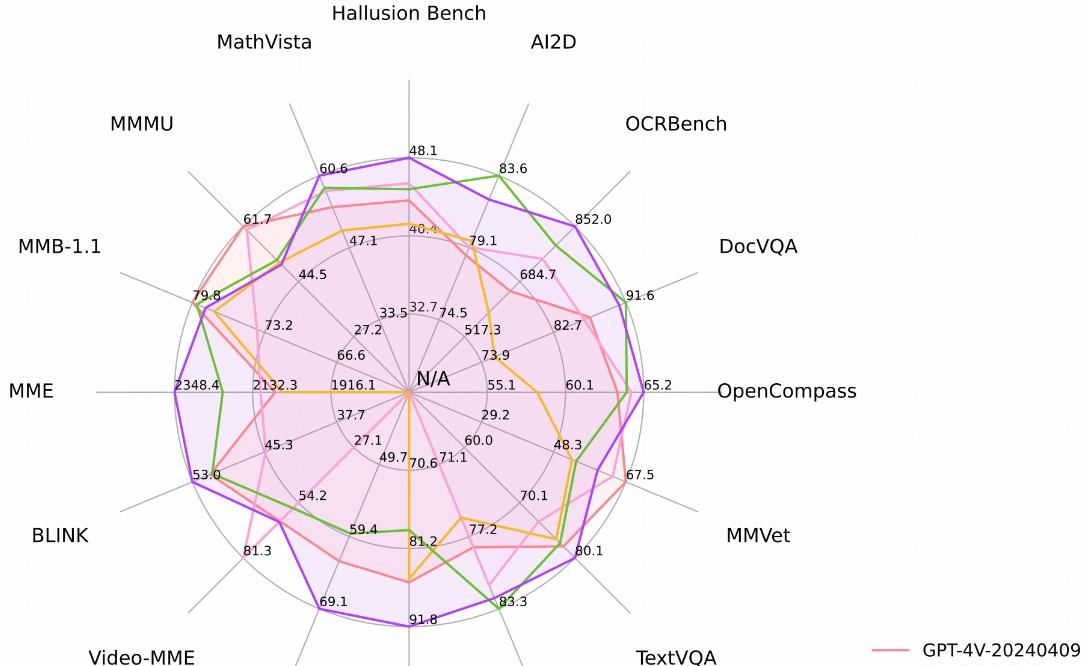

MiniCPM-V 2.6 与各大模型性能对比

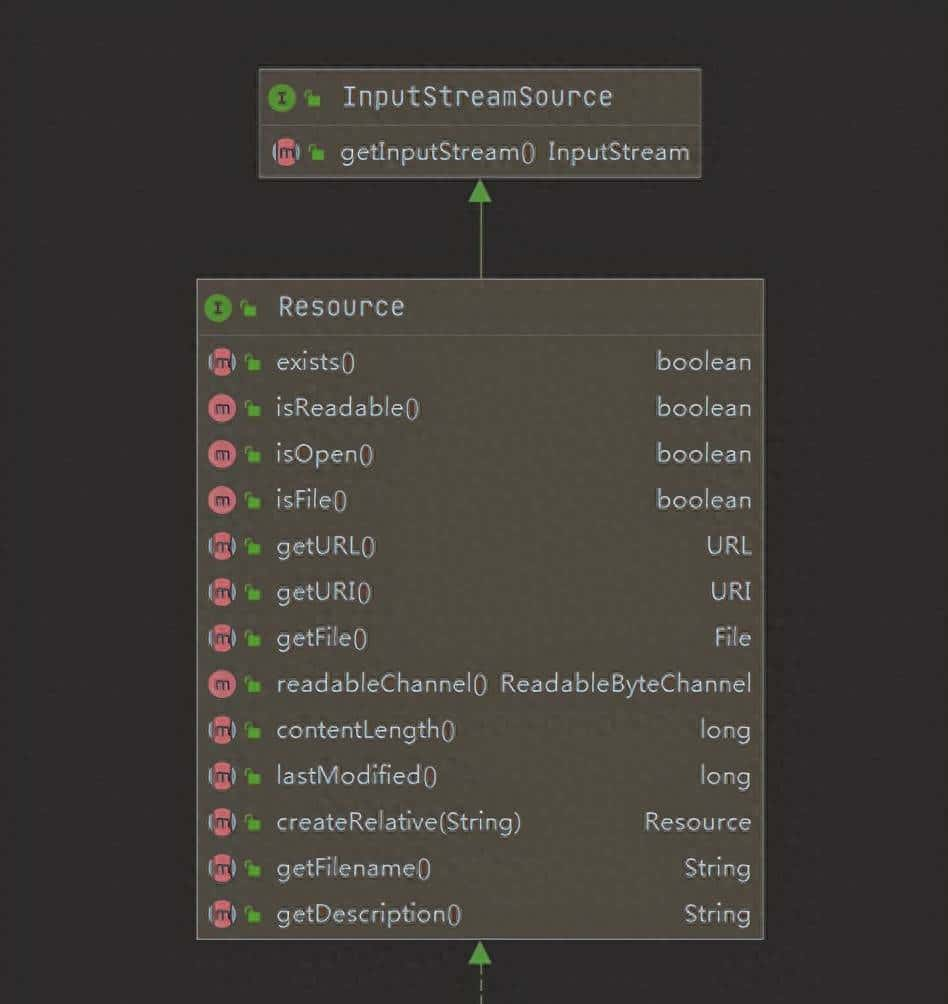

目前MiniCPM已经更新到MiniCPM-V2.6,为MiniCPM-V系列的最新、性能最佳的模型。总参数量 8B,在单图、多图和视频理解性能上甚至超越了 GPT-4V。在单图理解上,它优于 GPT-4o mini、Gemini 1.5 Pro 和 Claude 3.5 Sonnet等商用闭源模型,并进一步优化了 MiniCPM-Llama3-V 2.5 的 OCR、可信行为、多语言支持以及端侧部署等诸多特性。MiniCPM-V 2.6 成为了首个支持在 iPad 等端侧设备上进行实时视频理解的多模态大模型。

其中,MiniCPM-V 2.0:MiniCPM-V系列的最轻量级模型。总参数量仅有2B,多模态综合性能超越 Yi-VL 34B、CogVLM-Chat 17B、Qwen-VL-Chat 10B 等大参数规模的模型,可接受 180 万像素的任意长宽比图像输入,实现了和 Gemini Pro 相近的场景文字识别能力以及和 GPT-4V 相匹的低幻觉率。

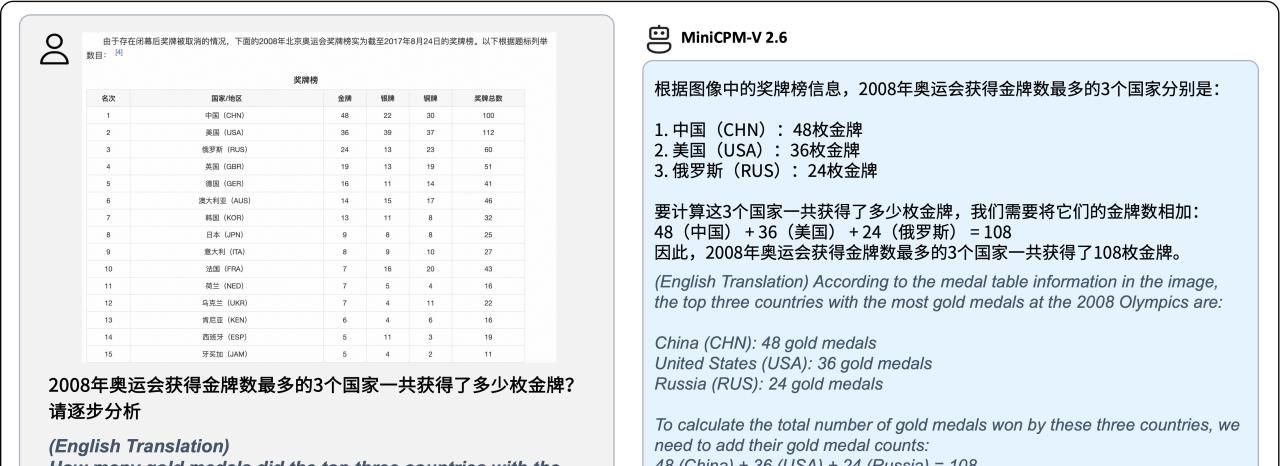

模型视觉demo效果

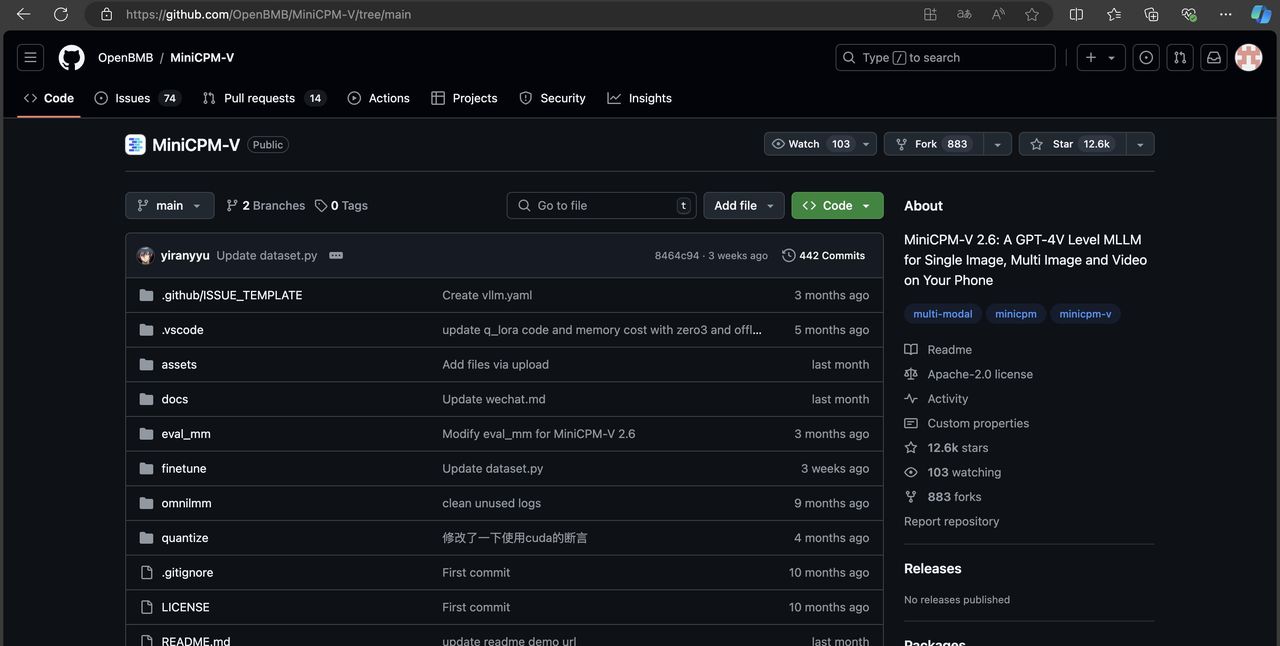

项目开源地址:

https://github.com/OpenBMB/MiniCPM-V/tree/main

总结

MiniCPM的确 是国产大模型厂家绝对拿得出手的一个作品,它足够小,足够快,足够好用,甚至谁都能用(移动端也能推理),单图、多图和视频理解性能十分出众,是多模态AI模型的不二选择。

灵感

MiniCPM很适用于本地搭建的知识库模型,由于他小,快,强。所以用起来真的就像“贾维斯”助理一样(亲测),并且对设备要求并不高。

若有微调需求的伙伴,该模型在一张1080/2080即可高效参数微调,一张3090/4090即可全参数微调,一台机器可持续训练 MiniCPM,二次开发成本超级低。

相关文章