第 1 节:根本性挑战:调和打印与 Web 范式

1.1 PDF 与 HTML 的二元性

将 PDF(便携式文档格式)转换为 HTML(超文本标记语言)的核心技术挑战源于两种格式截然不同的设计哲学。若不理解这一根本性差异,任何转换方案都注定无法达到高保真度的要求。

PDF 作为“数字纸张”格式

PDF 的设计初衷是为了在不同平台、设备和打印机上保持内容的一致性,本质上是一种“数字纸张” 1。其核心关注点是在一个固定尺寸的页面上,将字形、图像和图形等元素准确地放置在绝对坐标位置上 2。PDF 文件中的内容被“绘制”到页面上,用户看到的是最终的视觉渲染结果。因此,文档的逻辑结构(如段落、标题、列表)对于 PDF 格式本身而言是次要的,甚至可能是不存在的;其首要任务是确保无论在何处打开,视觉呈现都保持不变 4。

HTML 作为“流式”格式

与此相反,HTML 是一种为适应性而生的“流式”格式。它旨在让内容能够根据不同的屏幕尺寸和设备动态地重排(reflow) 3。HTML 的结构基于逻辑和语义,通过标签(如

<h1>、<p>、<table>)来定义内容的层次和意义,而非其准确的物理位置。这种语义结构使得内容具有良好的可访问性、搜索引擎友善性,并能适应响应式设计 6。

内在的冲突

这两种范式的根本性冲突意味着,从 PDF 到 HTML 的转换并非简单的格式切换,而是一个复杂的文档重构过程 2。直接的一对一映射是不可能的。一个追求固定布局的格式和一个追求动态流式布局的格式之间存在着天然的鸿沟。因此,要实现用户所要求的“保持布局不变”的高保真度,就必须采用一种能够模拟 PDF 固定布局特性的 Web 技术。

1.2 定义“高保真”:绝对定位作为必要策略

用户的核心需求是“高保真”(高保真),即视觉上的完美复刻。在 Web 技术中,唯一能够实现这种像素级精度布局控制的方法是使用 CSS 的绝对定位(absolute positioning) 7。

通过为每一个从 PDF 中提取的文本块、图像或图形元素创建一个独立的 HTML 容器(一般是 <div> 或 <span>),并为其设置 position: absolute 样式,同时指定准确的 top 和 left 坐标,我们可以将这些元素“钉”在页面上的特定位置,从而在浏览器中重现 PDF 的原始版面 9。

不过,这一选择带来了一个关键的技术权衡。绝对定位虽然能实现无与伦比的视觉保真度,但其产出的 HTML 代码是完全非语义化的。文本流被打散成无数个独立的定位块,这使得屏幕阅读器难以正确解析阅读顺序,搜索引擎无法理解内容的逻辑结构,并且页面完全丧失了响应式布局的能力 11。

因此,一个专业的技术方案不仅要能够实现基于绝对定位的高保真视觉转换,还必须正视并解决由此带来的可用性、可访问性和可维护性问题。本方案的设计思路正是在此基础上展开:第一通过绝对定位实现核心的视觉保真目标,然后通过一系列高级技术手段,为这个视觉完美的“外壳”注入语义和结构,从而在满足用户首要需求的同时,最大限度地弥补其固有的缺陷。

第 2 节:源文档解构:布局复杂性案例研究

为了制定一个稳健的技术方案,必须对目标文档的复杂性进行深入分析。本方案以用户提供的《普通高中教科书·地理必修 第一册》(12)作为案例,该文档是检验转换保真度的理想样本,其内部包含了多种典型的复杂布局元素 12。

2.1 教科书结构概述

该 PDF 文档是一本标准的教科书,内容图文并茂,排版紧凑且信息密度高。其页面布局并非单一的线性文本流,而是由多个功能各异的区块组合而成,对转换工具的布局分析能力提出了极高的要求。

2.2 高难度布局元素识别

通过对文档进行逐页分析,可以识别出以下几种对高保真转换构成重大挑战的布局元素:

- 多栏文本布局:文档正文普遍采用双栏排版(例如,第 7 页)。转换工具必须能够正确识别栏的边界,并按照从左至右、从上至下的阅读顺序重构文本流,而不是简单地将物理上邻近的文本块错误地拼接在一起。

- 复杂表格数据:文档中的表格远超简单的行列网格。例如,目录(第 4-5 页)和正文中的表格(如第 11 页的“行星轨道倾角与偏心率”表、第 35 页的“我国部分高原训练基地的地理坐标”表)包含了复杂的结构,如多级标题、不规则的单元格合并以及准确的文本对齐。简单的文本提取会丢失这些至关重大的结构信息。

- 侧边栏与插文框:文档中频繁出现格式独特的侧边栏,如“活动”、“自学窗”和“案例”等模块。这些模块在视觉上独立于主文本流,拥有自己的背景和边框。转换时必须将它们作为独立的布局单元进行处理,并准确定位,以防其内容与主栏文本混淆。

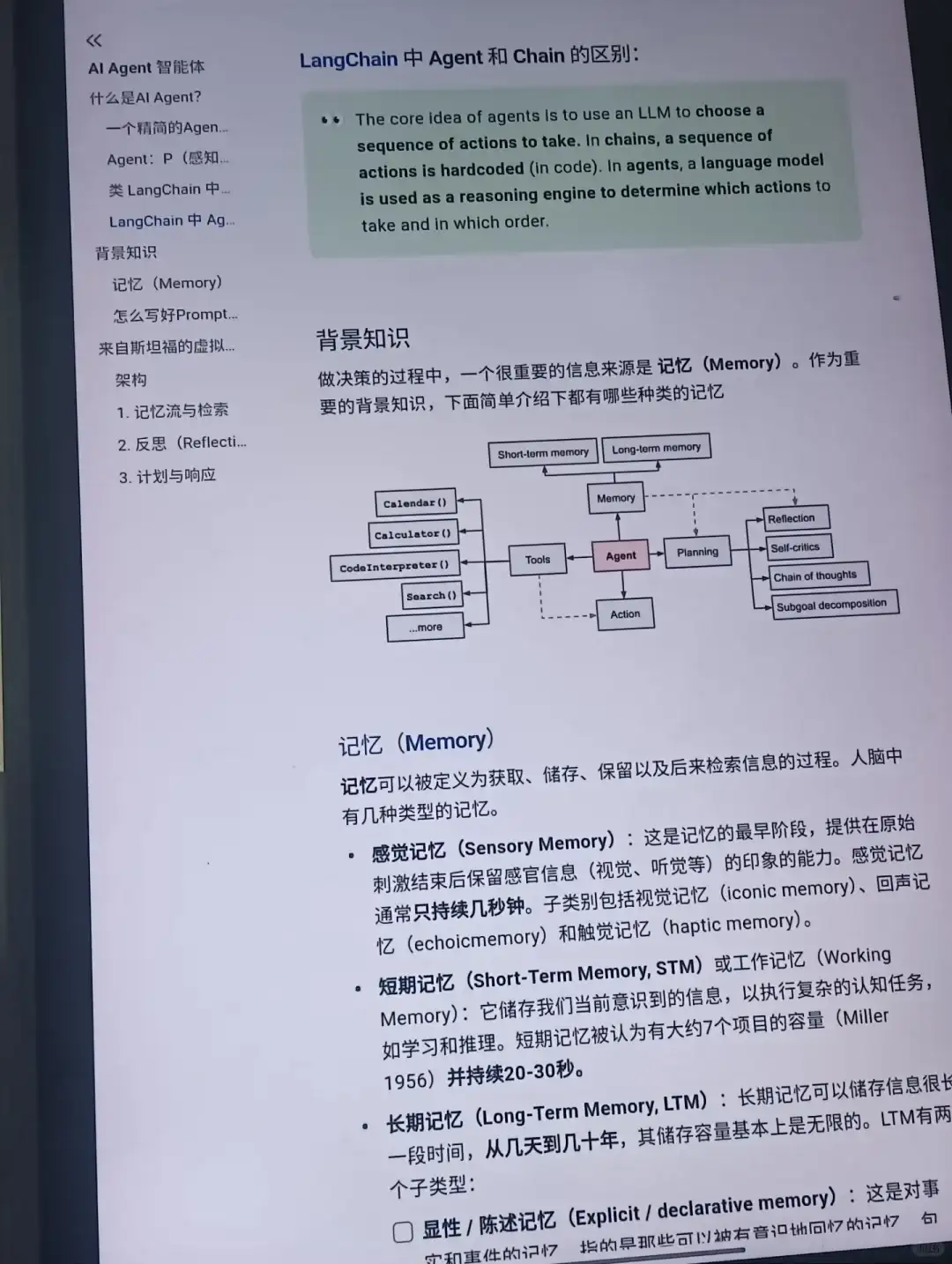

- 矢量图形与图表:PDF 包含了大量高质量的矢量图形,例如太阳系结构示意图(第 8 页)、大气垂直分层示意图(第 36 页)和大气受热过程示意图(第 39 页)。这些图形由线条、形状和嵌入的文本标签组成,而非单一的位图图像。为保证清晰度和可缩放性,必须将它们作为矢量资源(如 SVG)进行提取和渲染,而不是降级为光栅图像。

- 页眉、页脚与页码:每一页都包含一致的页眉(章节标题)和页脚(页码)。在转换过程中,需要能够准确识别这些重复性元素,并根据需求决定是将其保留在每页的 HTML 结构中,还是将其剥离以专注于核心内容。

对这些元素的分析揭示了一个核心实际:PDF 的每一页都不是一个单一的布局,而是一个由多个独立的“微布局”——页眉、页脚、主内容栏、侧边栏、图表等——组合而成的复合体。一个幼稚的转换方法会尝试将整页作为一个整体处理,这必然会导致元素归属和阅读顺序的混乱。因此,一个成功的技术方案必须采用分而治之的策略:第一进行文档布局分析(Document Layout Analysis, DLA),将页面分割成这些宏观的逻辑区块,然后再对每个区块内部的内容进行高保真转换。这一思路是构建本方案多阶段处理流水线的基础。

第 3 节:核心转换技术对比分析

选择正确的核心技术是项目成功的关键。本节对当前主流的 PDF 至 HTML 转换技术进行比较,涵盖开源库和商业服务,并最终为本项目提出明确的技术选型提议。

3.1 开源库:强劲的控制力与灵活性

开源库为开发者提供了最高程度的控制力和定制化能力,是构建复杂、专用转换流程的理想选择。

- PyMuPDF (fitz):这是一个基于 C 语言库 MuPDF 的高性能 Python 绑定。它以其卓越的速度、强劲的功能和活跃的开发维护而著称 13。PyMuPDF 不仅仅是一个转换工具,更是一个全面的 PDF 操作工具集。它提供了丰富的底层 API,允许开发者准确地提取文本、光栅图像、矢量图形、字体信息和元数据 19。其

- page.get_text(“html”) 方法能够生成基于绝对定位的高保真 HTML 片段,为实现视觉复刻提供了坚实的基础 10。其性能在多个基准测试中一般领先于其他纯 Python 库 20。

- pdf2htmlEX:这是一个专注于高保真转换的命令行工具,因其能够生成像素级准确的 HTML 输出而闻名 22。它通过将矢量图形和复杂背景渲染为背景图片,并将文本使用绝对定位准确覆盖于其上,实现了出色的视觉效果 22。不过,该项目近年来维护更新较少,存在一些已知问题,例如在某些 WebKit 内核的浏览器(如 Chrome)中可能出现连字(ligature)渲染错误 24。作为一个命令行工具,其程序化控制和集成能力远不如 PyMuPDF 灵活,更像一个“黑盒”解决方案 26。

- PDF.js:这是由 Mozilla 开发的一个 JavaScript 库,其主要目标是在 Web 浏览器中渲染和显示 PDF 文件,而非进行服务端的文件格式转换 27。其渲染架构一般涉及将 PDF 页面绘制到一个 HTML

- <canvas> 元素上,同时在其上方覆盖一个独立的、透明的 HTML 文本层以支持文本选择和搜索 28。这种分层渲染机制不适合生成一个独立的、自包含的高保真 HTML 文件。

3.2 商业 API 与 SDK:便捷性与成本的权衡

对于追求快速集成和商业支持的场景,市面上有多种成熟的商业解决方案。

- 商业 SDK:如 Aspose.PDF 33、

- Apryse (原 PDFTron) 38 和

- iText 41 等,这些是功能强劲的软件开发工具包。它们提供了封装良好的 API,能够处理复杂的转换任务,并一般附带专业的商业技术支持。

- 云服务 API:如 ConvertAPI 44、

- PDF.co 46 和

- Adobe PDF Services API 48 等,这些服务通过 REST API 提供文档转换功能。这是最简单的集成方式,开发者无需关心底层实现和环境依赖,只需通过网络请求即可完成转换。

不过,商业方案的主要缺点在于成本(一般是基于订阅或许可证的费用)、对第三方服务的依赖(网络延迟、服务可用性)以及潜在的数据隐私风险(需要将文档上传至外部服务器) 1。此外,其 API 提供的定制化程度一般低于底层库,对于本方案中需要实现的混合渲染等高级技术可能支持不足。

3.3 技术选型与理由

最终推荐:PyMuPDF

综合考量,PyMuPDF 是执行此项任务的最佳技术选择。

理由如下:

- 性能卓越:处理大型、复杂 PDF 文件的速度至关重大。PyMuPDF 的底层 C 核心确保了其在解析和渲染方面的高性能,远超许多纯 Python 实现 18。

- 保真度高:其 get_text(“html”) 方法已经提供了基于绝对定位的高质量视觉输出,为后续处理奠定了坚实基础。

- 控制力强:PyMuPDF 提供了对 PDF 内部结构的深度访问能力。这对于实现本方案中的高级技术——如混合式表格重构和 ARIA 语义层注入——是必不可少的。开发者可以准确地获取每个元素(文本、图像、路径)的坐标、字体、颜色等信息。

- 功能全面:它不仅能转换,还能提取所有必要的资产(图像、SVG、字体、表格数据),使整个处理流程可以在一个统一的库中完成,减少了外部依赖。

- 成本效益:作为一个开源库,它避免了商业 SDK 和 API 的高昂许可费用,同时提供了商业许可选项以满足不同需求 50。

下表直观地总结了主要技术方案的优劣势,进一步印证了 PyMuPDF 的选择。

表 3.1:高保真 PDF 至 HTML 转换技术对比矩阵

|

特性 |

PyMuPDF |

pdf2htmlEX |

商业云 API |

|

布局保真度(绝对定位) |

极高 |

极高 |

高(但可控性较低) |

|

字体处理 |

优秀(可提取、可子集化) |

良好(存在已知浏览器兼容问题) |

良好(一般为黑盒处理) |

|

矢量图形处理 |

优秀(可提取为 SVG) |

良好(支持 SVG 背景) |

良好 |

|

性能(处理大型文件) |

极高(速度快) |

中等到慢 |

可变(受网络和队列影响) |

|

维护与支持 |

优秀(积极开发) |

较差(社区维护) |

优秀(付费支持) |

|

成本 |

免费(AGPL/商业双许可) |

免费(GPL) |

订阅制 |

|

程序化控制与定制 |

极高 |

低(命令行工具) |

中等(API 参数限制) |

第 4 节:实施蓝图:基于 PyMuPDF 的转换流水线

本节将详细阐述一个完整、可操作的技术实施流程,该流程基于 PyMuPDF 构建,分为环境设置、资产提取、资产转换和 HTML 生成四个核心阶段。

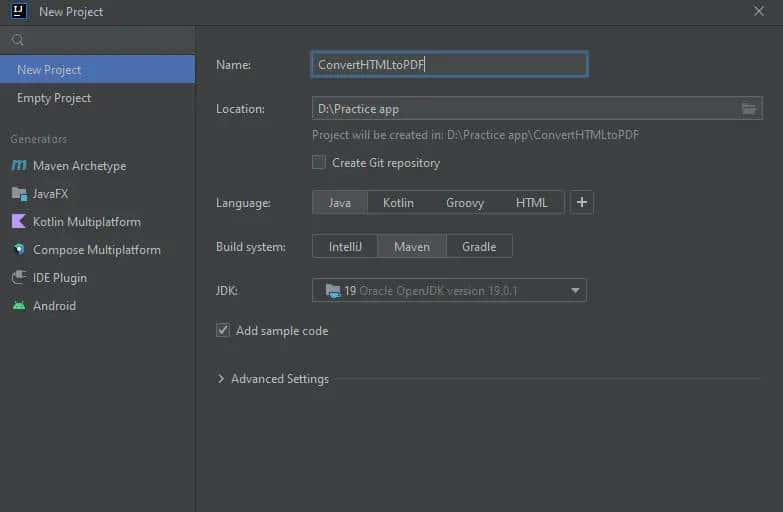

4.1 环境设置与依赖安装

为确保流程的顺利执行,需要搭建一个包含所有必要工具的 Python 环境。推荐使用虚拟环境以隔离项目依赖。

- 创建并激活 Python 虚拟环境:

- Bash

- python -m venv venv source venv/bin/activate # on Windows: venvScriptsactivate

- 安装核心 Python 库:

- PyMuPDF:用于处理 PDF 的核心引擎。

- pandas:用于处理从 PDF 中提取的结构化表格数据。

- PyMuPDF-Fonts:提供一组高质量的备用字体,用于处理 PDF 中未嵌入的字体或进行字体替换。

- Bash

- pip install pymupdf pandas pymupdf-fonts

- 安装 Node.js 和 SVGO:

- SVGO 是一个基于 Node.js 的工具,用于优化从 PDF 中提取的 SVG 文件。第一需要安装 Node.js,然后通过 npm(Node.js 包管理器)全局安装 SVGO。

- Bash

- # (Install Node.js from https://nodejs.org/) npm install -g svgo

4.2 阶段一:资产提取(解构阶段)

此阶段的目标是将 PDF 文件中的所有可重用组件——图像、矢量图形、字体和表格数据——提取并保存到结构化的目录中,为后续处理做好准备。

Python 脚本: extract_assets.py

Python

import fitz # PyMuPDF

import os

import pandas as pd

def extract_pdf_assets(pdf_path, base_output_dir):

"""

Extracts images, vector graphics (as SVG), and tables (as CSV) from a PDF.

"""

if not os.path.exists(base_output_dir):

os.makedirs(base_output_dir)

# Define output subdirectories

img_dir = os.path.join(base_output_dir, "images")

svg_dir = os.path.join(base_output_dir, "svg")

table_dir = os.path.join(base_output_dir, "tables")

os.makedirs(img_dir, exist_ok=True)

os.makedirs(svg_dir, exist_ok=True)

os.makedirs(table_dir, exist_ok=True)

doc = fitz.open(pdf_path)

for page_num in range(len(doc)):

page = doc.load_page(page_num)

# 1. Extract Raster Images [52, 53, 54]

image_list = page.get_images(full=True)

for img_index, img in enumerate(image_list):

xref = img

base_image = doc.extract_image(xref)

image_bytes = base_image["image"]

image_ext = base_image["ext"]

image_filename = f"page{page_num + 1}_img{img_index + 1}.{image_ext}"

with open(os.path.join(img_dir, image_filename), "wb") as img_file:

img_file.write(image_bytes)

# 2. Extract Vector Graphics as a single page SVG [13, 55]

svg_text = page.get_svg_image(matrix=fitz.Identity)

svg_filename = f"page{page_num + 1}.svg"

with open(os.path.join(svg_dir, svg_filename), "w", encoding="utf-8") as svg_file:

svg_file.write(svg_text)

# 3. Extract Tables into Pandas DataFrames and save as CSV [56, 57, 58]

tables = page.find_tables()

for i, table in enumerate(tables):

df = table.to_pandas()

table_filename = f"page{page_num + 1}_table{i + 1}.csv"

df.to_csv(os.path.join(table_dir, table_filename), index=False)

print(f"Asset extraction complete. Assets saved in '{base_output_dir}'.")

if __name__ == '__main__':

pdf_input_path = '普通高中教科书·地理必修 第一册.pdf'

output_directory = 'output_assets'

extract_pdf_assets(pdf_input_path, output_directory)

4.3 阶段二:资产转换与优化(准备阶段)

原始提取的资产需要经过处理才能在 Web 环境中高效、合规地使用。

1. 字体管理与转换

PDF 中嵌入的字体一般是 OTF 或 TTF 格式。直接在网页中使用这些格式不仅文件体积大,影响加载速度,还可能违反字体的使用许可协议 59。最佳实践是将其转换为专为 Web 设计的 WOFF2 格式,它提供了目前最优的压缩率 59。

- 工作流程:

- 使用 PyMuPDF 的 doc.get_page_fonts() 方法列出所有字体信息 62。

- 提取字体文件的二进制数据(buffer)。

- 使用专门的字体工具(如 fonttools 库或在线转换器)将字体 buffer 转换为 WOFF2 格式。

- 为每个转换后的 WOFF2 字体文件生成对应的 CSS @font-face 规则,并保存到一个单独的 CSS 文件中(例如 fonts.css)。

2. SVG 优化

从 PDF 中提取的 SVG 文件一般包含大量冗余信息,如编辑器元数据、不必要的 id、过高的坐标精度等。使用 SVGO 可以安全地移除这些内容,大幅减小文件体积,提升渲染性能 63。

- 工作流程:

- 在命令行中,对包含所有提取出的 SVG 文件的目录执行 SVGO 的批量优化命令。

- Bash

- svgo -rf./output_assets/svg -o./output_assets/svg_optimized

- 此命令会递归处理 svg 目录下的所有文件,并将优化后的版本输出到 svg_optimized 目录 64。

4.4 阶段三:HTML 生成与组装(重构阶段)

这是将所有处理好的资产和文本内容组合成最终 HTML 文件的核心步骤。我们将利用 PyMuPDF 生成的带有绝对定位的 HTML 片段,并将它们整合到一个完整的文档中。

Python 脚本: build_html.py

Python

import fitz # PyMuPDF

import os

import base64

def build_single_html(pdf_path, asset_dir):

"""

Builds a single HTML file from a PDF, embedding images and using extracted assets.

"""

doc = fitz.open(pdf_path)

# --- HTML and CSS Boilerplate ---

html_start = """

<!DOCTYPE html>

<html lang="zh-CN">

<head>

<meta charset="UTF-8">

<meta content="width=device-width, initial-scale=1.0">

<title>{title}</title>

<style>

body {{ margin: 0; background-color: #f0f0f0; }}

.page-container {{

position: relative;

margin: 20px auto;

box-shadow: 0 0 10px rgba(0,0,0,0.5);

background-color: white;

}}

/* Add font-face rules from fonts.css here */

</style>

</head>

<body>

"""

html_end = "</body></html>"

# Placeholder for all page content

all_pages_html =

# --- Iterate through pages and generate HTML --- [55, 68]

for page_num in range(len(doc)):

page = doc.load_page(page_num)

# Get HTML with embedded images and absolute positioning

# The 'html' format creates a full visual version of the page

page_html = page.get_text("html")

# Wrap page content in a container div

page_width = int(page.rect.width)

page_height = int(page.rect.height)

container_html = f'<div id="page-{page_num + 1}"hljs-subst">{page_width}px; height:{page_height}px;">{page_html}</div>'

all_pages_html.append(container_html)

# --- Assemble the final HTML ---

final_html = html_start.format(title=os.path.basename(pdf_path))

final_html += "

".join(all_pages_html)

final_html += html_end

# Save the final HTML file

output_html_path = os.path.splitext(pdf_path) + ".html"

with open(output_html_path, "w", encoding="utf-8") as f:

f.write(final_html)

print(f"Successfully created high-fidelity HTML: {output_html_path}")

if __name__ == '__main__':

pdf_input_path = '普通高中教科书·地理必修 第一册.pdf'

asset_directory = 'output_assets' # Assumes assets have been extracted

build_single_html(pdf_input_path, asset_directory)

注意:上述 build_html.py 脚本是一个基础版本。page.get_text(“html”) 会将页面背景(包括矢量图形)渲染成一个位图并作为 background-image 嵌入。为了使用我们优化过的 SVG,需要对生成的 HTML 片段进行后处理,将其中的 background-image URL 替换为指向优化后 SVG 文件的路径。

第 5 节:生产级输出的高级技术

基础流水线能够生成视觉上高度保真的 HTML,但为了达到生产级质量,还需要解决其在语义、可访问性和可维护性方面的不足。本节介绍三种高级技术,旨在将输出从一个静态的视觉复制品提升为一个更健壮、更智能的 Web 文档。

5.1 混合方法处理表格:融合视觉保真度与语义结构

page.get_text(“html”) 方法生成的表格在视觉上是完美的,但其内部是由大量绝对定位的 <div> 构成的,完全没有 <table>、<tr>、<td> 等语义标签。另一方面,page.find_tables() 方法能提取出纯净的、结构化的表格数据(例如,Pandas DataFrame),但丢失了所有样式信息 56。一种创新的混合方法可以将二者的优点结合起来。

这种方法的核心在于,我们既拥有表格的准确位置和尺寸(来自 find_tables() 的边界框),也拥有其结构化内容(来自 DataFrame)。通过编程方式,可以在 HTML 生成阶段执行以下操作:

- 识别并移除视觉表格:在 page.get_text(“html”) 生成的 HTML 片段中,利用 find_tables() 提供的表格边界框(bounding box)坐标,定位并移除所有构成该表格视觉效果的 <div> 元素。

- 生成语义化表格:使用从 DataFrame 中读取的数据,动态生成一个标准的、语义化的 HTML <table>。

- 准确定位语义表格:将这个新生成的 <table> 包裹在一个 <div> 容器中,并利用之前获取的边界框坐标,通过绝对定位将这个容器准确地放置在原始表格所在的位置。

通过这种方式,最终的 HTML 文档在视觉上与 PDF 别无二致,同时其表格部分又是完全语义化的,既便于机器解析,也对屏幕阅读器等辅助技术友善,实现了视觉保真度与数据可用性的统一。

5.2 通过 ARIA 覆盖层增强可访问性

绝对定位布局对可访问性构成了严重障碍。为了弥补这一缺陷,可以引入一个语义覆盖层。这需要利用文档布局分析(DLA)技术来推断内容的逻辑结构 69。

- 结构推断:PyMuPDF 的 get_text(“dict”) 方法或其扩展库 pymupdf4llm 50 能够根据文本的字体大小、粗细、位置等特征,识别出标题、段落、列表等逻辑元素。学术研究也表明,结合视觉和文本特征的深度学习模型能够实现高精度的文档语义结构提取 73。

- 注入 ARIA 角色:在生成基础 HTML 后,可以利用 Python 的 HTML 解析库(如 BeautifulSoup)进行二次处理。根据 DLA 的分析结果,为对应的 <div> 或 <span> 元素动态添加 WAI-ARIA(无障碍丰富互联网应用)角色属性 76。例如:

- 被识别为一级标题的文本块,其容器 <div> 可以被添加 role=”heading” 和 aria-level=”1″ 属性。

- 被识别为列表项的文本块,其容器可以被添加 role=”listitem”。

这种方法在不改变任何视觉布局的前提下,为非语义化的 HTML 结构提供了一个并行的语义层,极大地改善了屏幕阅读器等辅助技术的用户体验 78。

5.3 使用 Docker 实现自动化与部署

为了确保整个转换流程的可移植性、可复现性和易于部署,强烈提议将其容器化。Docker 提供了一个理想的解决方案。

1. Dockerfile 编写

创建一个 Dockerfile,它定义了一个包含所有必要依赖的标准化环境:

Dockerfile

# 使用一个包含 Python 和 Node.js 的基础镜像

FROM python:3.9-slim

# 设置工作目录

WORKDIR /app

# 安装系统依赖,包括 pdf2htmlEX 所需的库(作为备用或比较)

RUN apt-get update && apt-get install -y

build-essential

libpoppler-cpp-dev

pkg-config

libfontforge-dev

nodejs

npm

&& rm -rf /var/lib/apt/lists/*

# 安装 SVGO

RUN npm install -g svgo

# 复制项目需求文件并安装 Python 依赖

COPY requirements.txt.

RUN pip install --no-cache-dir -r requirements.txt

# 复制所有项目脚本

COPY..

# 定义容器启动时执行的命令

CMD ["bash", "run_conversion.sh"]

2. 自动化脚本 run_conversion.sh

创建一个 shell 脚本来按顺序执行整个流水线:

Bash

#!/bin/bash

PDF_FILE=$1

OUTPUT_DIR="output"

echo "Starting conversion for $PDF_FILE..."

# 阶段一:提取资产

python extract_assets.py "$PDF_FILE" "$OUTPUT_DIR/assets"

# 阶段二:优化资产

echo "Optimizing SVG assets..."

svgo -rf "$OUTPUT_DIR/assets/svg" -o "$OUTPUT_DIR/assets/svg_optimized"

# (此处添加字体转换步骤)

# 阶段三:构建最终 HTML

echo "Building final HTML..."

python build_html.py "$PDF_FILE" "$OUTPUT_DIR/assets"

echo "Conversion finished. Output is in the '$OUTPUT_DIR' directory."

3. 执行转换

通过一个简单的 docker run 命令,即可在任何支持 Docker 的环境中执行整个转换流程,实现了与主机环境的完全解耦 80:

Bash

# 构建 Docker 镜像

docker build -t pdf-converter.

# 运行转换流程

docker run --rm -v "$(pwd)/input:/app/input" -v "$(pwd)/output:/app/output" pdf-converter "input/your_document.pdf"

此命令将本地的 input 目录挂载到容器内,将容器内的 output 目录挂载回本地,实现了文件的输入和输出,整个过程干净、独立且高度自动化。

第 6 节:结论与战略提议

本技术实施方案详细阐述了一个旨在实现从复杂 PDF 到高保真 HTML 的多阶段、可扩展的转换流程。通过对 PDF 与 HTML 两种格式根本差异的深刻理解,方案确立了以 CSS 绝对定位为核心的视觉保真策略,并围绕这一核心,设计了一套完整的技术实现路径。

方案核心总结

整个流程可以概括为三个主要步骤:

- 解构(Deconstruction):利用 PyMuPDF 强劲的底层能力,将 PDF 文件中的文本、光栅图像、矢量图形、字体和表格数据等所有核心资产进行原子化提取。

- 转换(Transformation):对提取出的原始资产进行针对 Web 环境的优化,包括将字体转换为高效的 WOFF2 格式,以及使用 SVGO 等工具大幅压缩矢量图形文件,确保最终产出的性能。

- 重构(Reconstruction):将经过优化的资产与通过 PyMuPDF 生成的、基于绝对定位的 HTML 文本层进行组装。更进一步,通过混合方法注入语义化的 <table> 标签,并通过 DLA 和 ARIA 角色为非语义化布局添加可访问性层。

技术选型的重大性

方案的核心是战略性地选择了 PyMuPDF 作为主要技术栈。这一选择并非仅仅由于它是一个功能强劲的转换器,更重大的是,它是一个提供了深度程序化控制能力的综合性工具包。正是这种控制力,使得本方案能够超越简单的“所见即所得”转换,实现如混合表格生成和 ARIA 语义增强等高级功能。这些功能将最终产出从一个静态的视觉复制品,提升为一个兼具保真度、数据可用性和基本可访问性的现代化 Web 文档。

未来展望与扩展

本方案构建了一个坚实的基础,能够应对如用户提供的教科书这类高度复杂的文档。基于此框架,未来可以进一步扩展以应对更具挑战性的场景:

- 处理扫描版 PDF:对于由图像构成的扫描版 PDF,可以在流水线的最前端集成一个 OCR(光学字符识别)处理阶段。PyMuPDF 本身也提供了与 Tesseract OCR 引擎的集成接口,可以无缝地将 OCR 提取的文本及其坐标信息输入到现有的布局分析和 HTML 生成流程中。

- 处理交互式表单:对于包含 AcroForms 或 XFA 表单的 PDF,可以利用 PyMuPDF 的表单处理功能,将静态的表单字段转换为可交互的 HTML <input>、<select> 等元素,并在重构阶段将其准确定位。

- 性能优化:对于超大型文档(数千页),可以将单体 HTML 输出模式切换为按需加载模式,即为每一页生成一个独立的 HTML 文件,并通过 JavaScript 动态加载,从而显著改善初始加载时间和浏览器性能。

综上所述,该方案提供了一条从理论分析到代码实现,再到生产部署的完整路径,能够可靠地满足将复杂 PDF 高保真转换为功能性 HTML 的技术需求。

相关文章